只需训练一次,即可生成3D新场景!谷歌「光场神经渲染」进化史

视图合成(view synthesis)是计算机视觉和计算机图形学交叉领域的一个重点难题,指的是从一个场景的多张图片中创建该场景的新视图。

要准确地合成一个场景的新视图,一个模型需要从一小部分参考图片中捕捉多种类型的信息,比如详细的三维结构、材料和光照等。

自2020年研究人员提出神经辐射场(NeRF)模型以来,这个问题也受到了越来越多的关注,大大推动了新视图合成的性能。

其中一个超级大玩家就是Google,在NeRF领域也发表了诸多论文,本文将为大家介绍两篇Google发表在CVPR 2022和ECCV 2022上的论文,讲述光场神经渲染模型的进化。

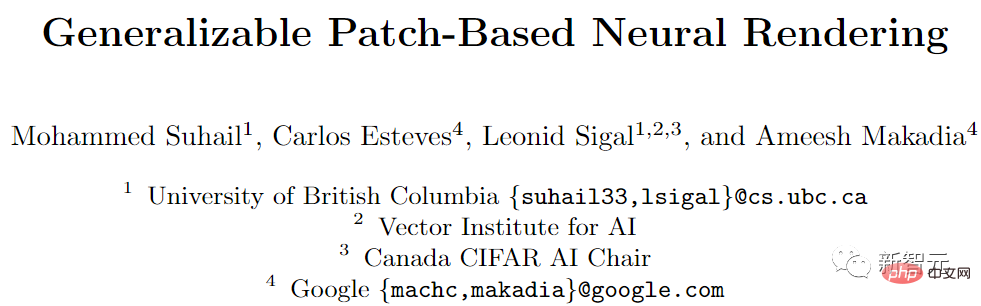

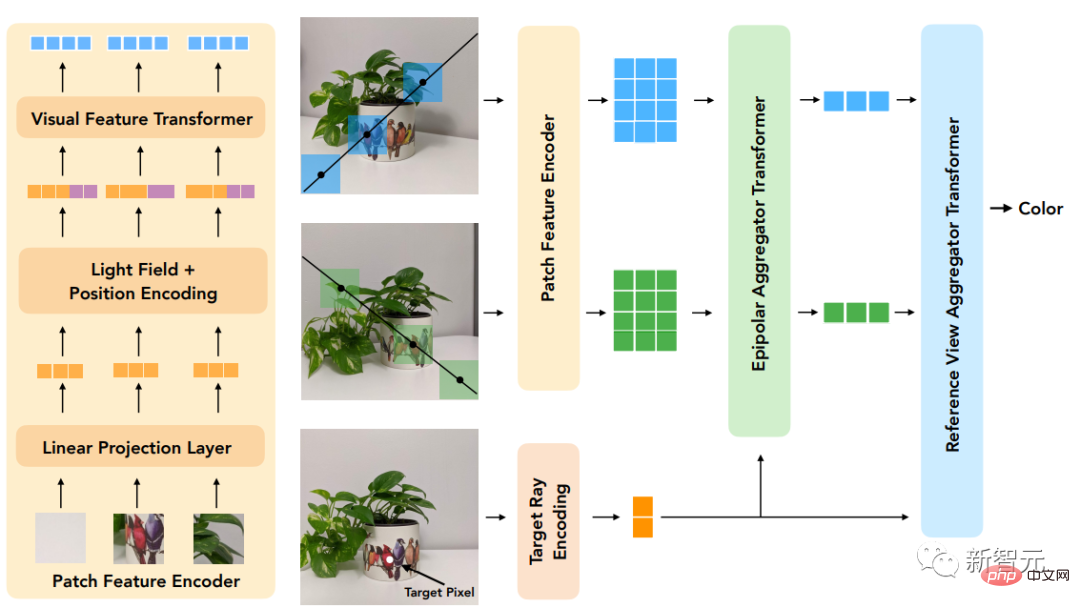

第一篇论文提出一个基于Transformer的两阶段模型来学习组合参考像素颜色,首先获得沿对极线(epipolar lines)的特征,然后获得沿参考视图的特征以产生目标射线的颜色,极大提升了视图重现的准确率。

论文链接:https://arxiv.org/pdf/2112.09687.pdf

经典光场渲染(Light Field Rendering)可以准确地再现与视图有关的效应,如反射、折射和半透明,但需要对场景进行密集的视图采样。基于几何重建的方法只需要稀疏的视图,但不能准确地模拟non-Lambertian效应,即非理想散射。

文中提出的新模型结合了这两个方向的优势并缓解了其局限性,通过对光场的四维表示进行操作,模型可以学会准确地表示与视图有关的效应。通过在训练和推理过程中强制执行几何约束,场景几何被隐含地从一组稀疏的视图中学习。

该模型在多个正向和360°数据集上的表现优于最先进的模型,并且在具有严重的视线依赖性变化的场景上有较大的余地。

另一篇论文通过使用具有规范化(canonicalized)位置编码的Transformer序列来解决合成未见过的场景的泛化性问题。模型在一组场景上训练后就可以用来合成新场景的视图。

论文链接:https://arxiv.org/pdf/2207.10662.pdf

文中提出了一个不同的范式,不需要深度特征和类似NeRF的体积渲染,该方法只需从场景中取样patch集合就能直接预测新场景中目标射线的颜色。

首先利用对极几何学,沿着每个参考视图的对极线提取patch,并将每个patch都线性地投射到一个一维特征向量中,然后由一系列的Transformer处理这个集合。

对于位置编码,研究人员采用和光场表示方法类似的方式对射线进行参数化,区别在于坐标是相对于目标射线的规范化,也使得该方法独立于参考框架并提高了通用性。

模型的创新点在于,它是进行基于图像的渲染,结合参考图像的颜色和特征来渲染新的视图,而且纯粹是基于Transformer的,在图像patch集上操作。并且它们利用4D光场表示来进行位置编码,有助于模拟与视图相关的效果。

最后实验结果表明,该方法在未见过的场景的新视图合成方面优于其他方法,即使在用比少得多的数据进行训练时也是如此。

光场神经渲染

模型的输入包括一组参考图像、相应的相机参数(焦距、位置和空间方向),以及用户想要确定其颜色的目标射线的坐标。

为了生成一个新的图像,我们需要从输入图像的相机参数开始,先获得目标射线的坐标(每一个都对应一个像素),并为每一个坐标进行模型查询。

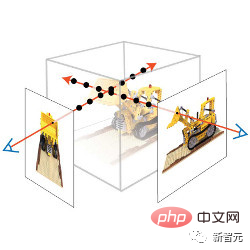

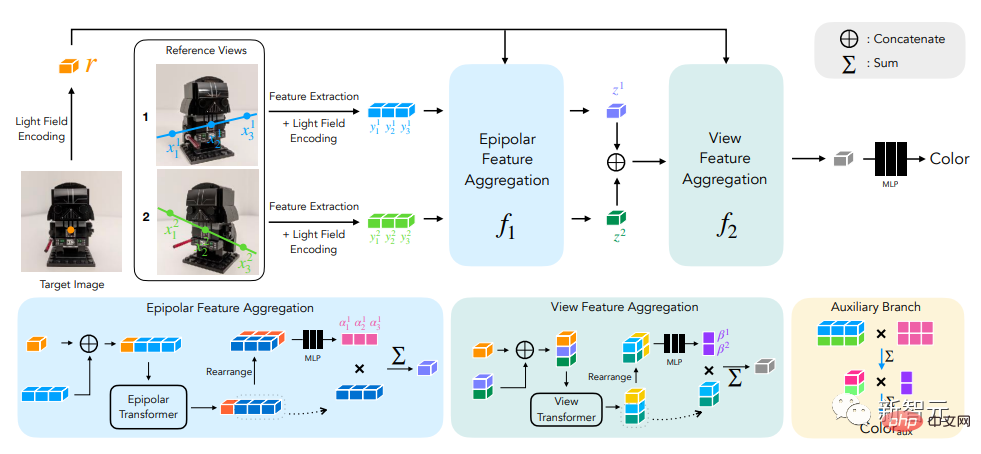

研究人员的解决方法是,不完全处理每张参考图像,而只看可能影响目标像素的区域。这些区域可以通过对极几何学确定,将每个目标像素映射到每个参考框架上的一条线。

为了稳妥起见,需要在对极线上的一些点周围选取小区域,从而形成将被模型实际处理的patch集合,然后将Transformer作用于这组patch上以获得目标像素的颜色。

Transformer在这种情况下特别有用,因为其中的自注意力机制可以自然地将patch集合作为输入,注意力权重本身就可以用来结合参考视图颜色和特征来预测输出像素的颜色。

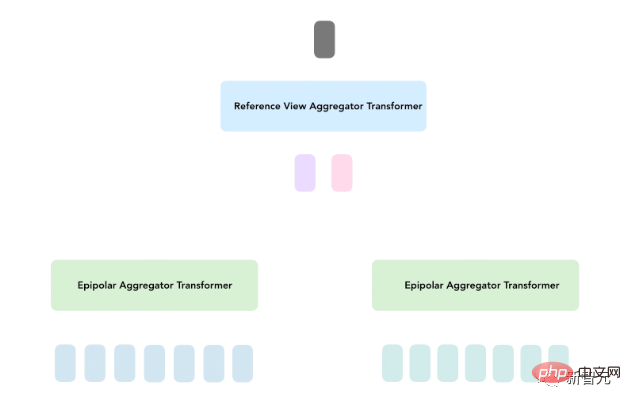

在光场神经渲染(LFNR)中,研究人员使用两个Transformer序列将patch集合映射到目标像素颜色。

第一个Transformer沿着每条对极线聚合信息,第二个Transformer沿着每张参考图像聚合信息。

这种方法可以把第一个Transformer解释为在每个参考帧上寻找目标像素的潜在对应关系,而第二个Transformer则是对遮挡和视线依赖效应的推理,这也是基于图像的渲染的常见难题。

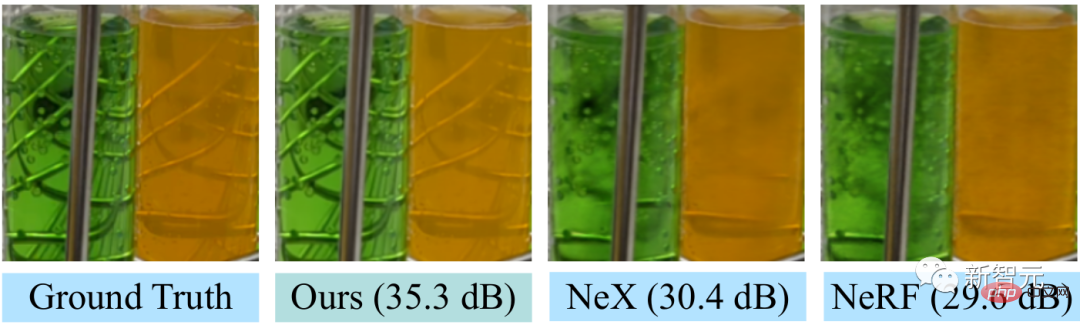

LFNR在最流行的视图合成基准(NeRF的Blender和Real Forward-Facing场景以及NeX的Shiny)上相比sota模型在峰值信噪比(PSNR)的提升幅度高达5dB,相当于将像素级的误差减少了1.8倍。

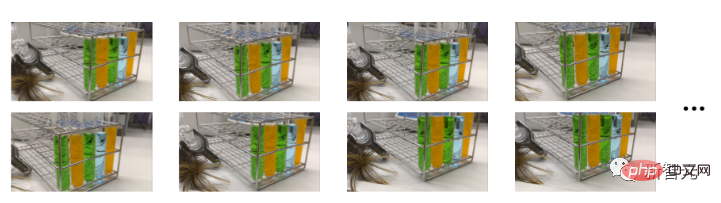

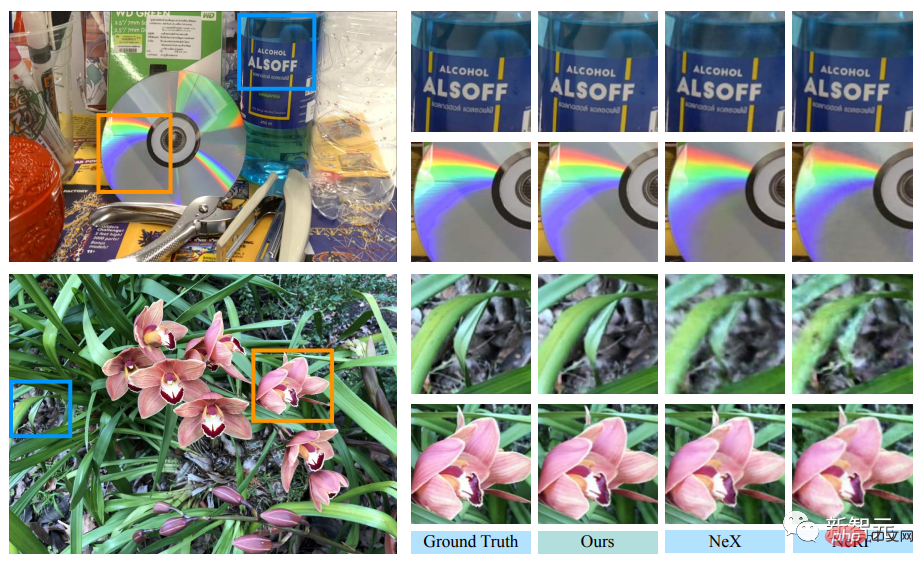

LFNR可以重现一些NeX/Shiny数据集中比较难的视线依赖性效果,比如CD上的彩虹和反射,瓶子上的反射、折射和半透明。

与之前的方法如NeX和NeRF相比,它们就没办法重现与视线相关的效果,如NeX/Shiny数据集中的实验室场景中的试管的半透明性和折射率。

一次训练,泛化新场景

但LFNR也有局限性。

第一个Transformer对每个参考图像独立地沿每条对极线折叠信息,这也意味着模型只能根据每个参考图像的输出射线坐标和patch来决定要保留哪些信息,这在单一场景的训练中效果很好(和大多数神经渲染方法一样),但它无法泛化到不同场景中。

可通用的模型很重要,因为可以直接应用于新的场景而不需要重新训练。

研究人员提出可通用的基于patch的神经渲染(GPNR)模型解决了LFNR的这个缺陷。

通过在模型中增加一个Transfomre,使其在其他两个Transformer之前运行,并在所有参考图像的相同深度的点之间交换信息。

GPNR由三个Transformer序列组成,这些Transformer将沿对极线提取的一组patch映射为像素颜色。图像patch通过线性投影层被映射到初始特征,然后这些特征被模型连续细化和聚合,最终形成特征和颜色。

举个例子,第一个Transformer从「公园长椅」上提取出patch序列后,新模型可以使用在两个视图中出现在相应深度的「花」这样的线索,表明存在潜在的匹配。

这项工作的另一个关键idea就是根据目标射线将位置编码规范化,因为想要在不同的场景中进行泛化,就必须以相对而非绝对的参照系来表示quantities

为了评估模型的泛化性能,研究人员在一组场景上训练GPNR,并在新场景上进行测试。

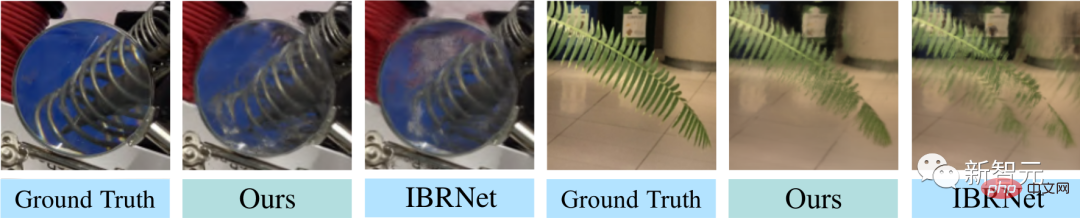

GPNR在几个基准(遵照IBRNet和MVSNeRF协议)上平均提高了0.5-1.0 dB,尤其是在IBRNet基准上,GPNR 在只使用11%的训练场景的情况下,就超过了基线模型。

GPNR在NeX/Shiny和LLFF的保持场景上生成的视图细节,没有进行任何微调。与IBRNet相比,GPNR可以更准确地再现叶片上的细节和通过镜头的折射。

以上是只需训练一次,即可生成3D新场景!谷歌「光场神经渲染」进化史的详细内容。更多信息请关注PHP中文网其他相关文章!

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

Video Face Swap

使用我们完全免费的人工智能换脸工具轻松在任何视频中换脸!

热门文章

热工具

记事本++7.3.1

好用且免费的代码编辑器

SublimeText3汉化版

中文版,非常好用

禅工作室 13.0.1

功能强大的PHP集成开发环境

Dreamweaver CS6

视觉化网页开发工具

SublimeText3 Mac版

神级代码编辑软件(SublimeText3)

抛弃编码器-解码器架构,用扩散模型做边缘检测效果更好,国防科大提出DiffusionEdge

Feb 07, 2024 pm 10:12 PM

抛弃编码器-解码器架构,用扩散模型做边缘检测效果更好,国防科大提出DiffusionEdge

Feb 07, 2024 pm 10:12 PM

当前的深度边缘检测网络通常采用编码器-解码器架构,其中包含上下采样模块,以更好地提取多层次的特征。然而,这种结构限制了网络输出准确且细致的边缘检测结果。针对这一问题,一篇AAAI2024上的论文给出了新的解决方案。论文题目:DiffusionEdge:DiffusionProbabilisticModelforCrispEdgeDetection作者:叶云帆(国防科技大学),徐凯(国防科技大学),黄雨行(国防科技大学),易任娇(国防科技大学),蔡志平(国防科技大学)论文链接:https://ar

开源!超越ZoeDepth! DepthFM:快速且精确的单目深度估计!

Apr 03, 2024 pm 12:04 PM

开源!超越ZoeDepth! DepthFM:快速且精确的单目深度估计!

Apr 03, 2024 pm 12:04 PM

0.这篇文章干了啥?提出了DepthFM:一个多功能且快速的最先进的生成式单目深度估计模型。除了传统的深度估计任务外,DepthFM还展示了在深度修复等下游任务中的最先进能力。DepthFM效率高,可以在少数推理步骤内合成深度图。下面一起来阅读一下这项工作~1.论文信息标题:DepthFM:FastMonocularDepthEstimationwithFlowMatching作者:MingGui,JohannesS.Fischer,UlrichPrestel,PingchuanMa,Dmytr

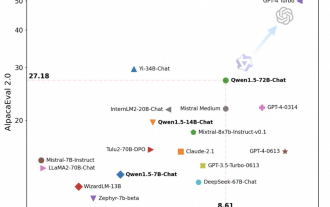

通义千问再开源,Qwen1.5带来六种体量模型,性能超越GPT3.5

Feb 07, 2024 pm 10:15 PM

通义千问再开源,Qwen1.5带来六种体量模型,性能超越GPT3.5

Feb 07, 2024 pm 10:15 PM

赶在春节前,通义千问大模型(Qwen)的1.5版上线了。今天上午,新版本的消息引发了AI社区关注。新版大模型包括六个型号尺寸:0.5B、1.8B、4B、7B、14B和72B。其中,最强版本的性能超越了GPT3.5和Mistral-Medium。该版本包含Base模型和Chat模型,并提供多语言支持。阿里通义千问团队表示,相关技术也已经上线到了通义千问官网和通义千问App。除此以外,今天Qwen1.5的发布还有如下一些重点:支持32K上下文长度;开放了Base+Chat模型的checkpoint;

你好,电动Atlas!波士顿动力机器人复活,180度诡异动作吓坏马斯克

Apr 18, 2024 pm 07:58 PM

你好,电动Atlas!波士顿动力机器人复活,180度诡异动作吓坏马斯克

Apr 18, 2024 pm 07:58 PM

波士顿动力Atlas,正式进入电动机器人时代!昨天,液压Atlas刚刚「含泪」退出历史舞台,今天波士顿动力就宣布:电动Atlas上岗。看来,在商用人形机器人领域,波士顿动力是下定决心要和特斯拉硬刚一把了。新视频放出后,短短十几小时内,就已经有一百多万观看。旧人离去,新角色登场,这是历史的必然。毫无疑问,今年是人形机器人的爆发年。网友锐评:机器人的进步,让今年看起来像人类的开幕式动作、自由度远超人类,但这真不是恐怖片?视频一开始,Atlas平静地躺在地上,看起来应该是仰面朝天。接下来,让人惊掉下巴

CLIP-BEVFormer:显式监督BEVFormer结构,提升长尾检测性能

Mar 26, 2024 pm 12:41 PM

CLIP-BEVFormer:显式监督BEVFormer结构,提升长尾检测性能

Mar 26, 2024 pm 12:41 PM

写在前面&笔者的个人理解目前,在整个自动驾驶系统当中,感知模块扮演了其中至关重要的角色,行驶在道路上的自动驾驶车辆只有通过感知模块获得到准确的感知结果后,才能让自动驾驶系统中的下游规控模块做出及时、正确的判断和行为决策。目前,具备自动驾驶功能的汽车中通常会配备包括环视相机传感器、激光雷达传感器以及毫米波雷达传感器在内的多种数据信息传感器来收集不同模态的信息,用于实现准确的感知任务。基于纯视觉的BEV感知算法因其较低的硬件成本和易于部署的特点,以及其输出结果能便捷地应用于各种下游任务,因此受到工业

超级智能体生命力觉醒!可自我更新的AI来了,妈妈再也不用担心数据瓶颈难题

Apr 29, 2024 pm 06:55 PM

超级智能体生命力觉醒!可自我更新的AI来了,妈妈再也不用担心数据瓶颈难题

Apr 29, 2024 pm 06:55 PM

哭死啊,全球狂炼大模型,一互联网的数据不够用,根本不够用。训练模型搞得跟《饥饿游戏》似的,全球AI研究者,都在苦恼怎么才能喂饱这群数据大胃王。尤其在多模态任务中,这一问题尤为突出。一筹莫展之际,来自人大系的初创团队,用自家的新模型,率先在国内把“模型生成数据自己喂自己”变成了现实。而且还是理解侧和生成侧双管齐下,两侧都能生成高质量、多模态的新数据,对模型本身进行数据反哺。模型是啥?中关村论坛上刚刚露面的多模态大模型Awaker1.0。团队是谁?智子引擎。由人大高瓴人工智能学院博士生高一钊创立,高

快手版Sora「可灵」开放测试:生成超120s视频,更懂物理,复杂运动也能精准建模

Jun 11, 2024 am 09:51 AM

快手版Sora「可灵」开放测试:生成超120s视频,更懂物理,复杂运动也能精准建模

Jun 11, 2024 am 09:51 AM

什么?疯狂动物城被国产AI搬进现实了?与视频一同曝光的,是一款名为「可灵」全新国产视频生成大模型。Sora利用了相似的技术路线,结合多项自研技术创新,生产的视频不仅运动幅度大且合理,还能模拟物理世界特性,具备强大的概念组合能力和想象力。数据上看,可灵支持生成长达2分钟的30fps的超长视频,分辨率高达1080p,且支持多种宽高比。另外再划个重点,可灵不是实验室放出的Demo或者视频结果演示,而是短视频领域头部玩家快手推出的产品级应用。而且主打一个务实,不开空头支票、发布即上线,可灵大模型已在快影

牛津大学最新!Mickey:3D中的2D图像匹配SOTA!(CVPR\'24)

Apr 23, 2024 pm 01:20 PM

牛津大学最新!Mickey:3D中的2D图像匹配SOTA!(CVPR\'24)

Apr 23, 2024 pm 01:20 PM

写在前面项目链接:https://nianticlabs.github.io/mickey/给定两张图片,可以通过建立图片之间的对应关系来估计它们之间的相机姿态。通常,这些对应关系是二维到二维的,而我们估计的姿态在尺度上是不确定的。一些应用,例如随时随地实现即时增强现实,需要尺度度量的姿态估计,因此它们依赖于外部的深度估计器来恢复尺度。本文提出了MicKey,这是一个关键点匹配流程,能够够预测三维相机空间中的度量对应关系。通过学习跨图像的三维坐标匹配,我们能够在没有深度测试的情况下推断出度量相对