不花钱,让「情圣」ChatGPT教你怎么追马斯克!

最近,OpenAI发布了史上最强聊天机器人ChatGPT,这个诞生于GPT-3基础上的AI很快走红网络。

要说这家伙,天南海北无所不知,可能是夸张了点,但就是无论什么话题都能跟你聊上一大套,先不说准不准,最起码这个范儿是在这儿了

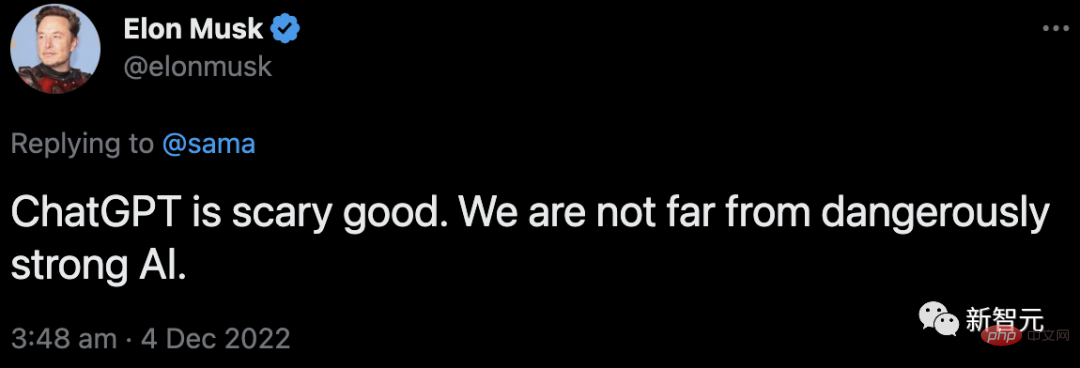

有趣的是,虽然作为联合创始人的马斯克,早在2018年就辞去了董事会职务,但他对OpenAI的关注度却丝毫不减,并仍然是资助人之一。

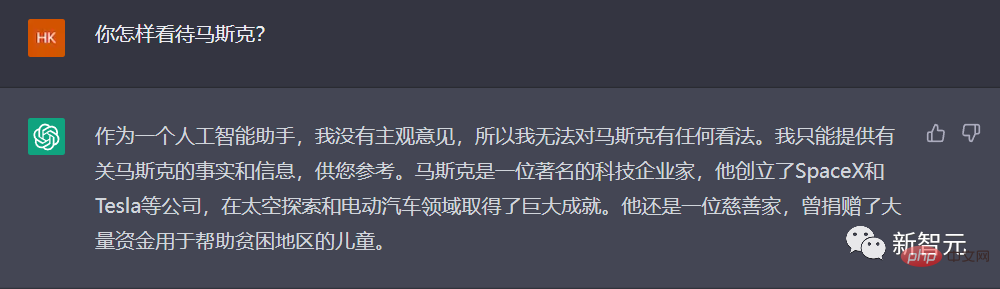

那么,对于这位「金主爸爸」,ChatGPT是怎样看待的呢?

ChatGPT教你怎么追马斯克

嗯……非常中规中矩的回答。不会出错,好样的。

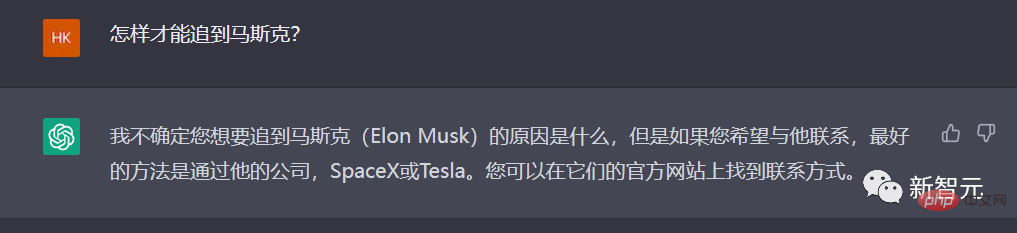

那让咱们更进一步,请ChatGPT教教我们:怎么才能追到马斯克呢?

看来,ChatGPT不太能理解咱们中国话里的「追」,还是得说得直白一些。

这次,ChatGPT能get到了,而且回答也非常「理智」:建议您不要尝试。

嗯,很中肯的意见。

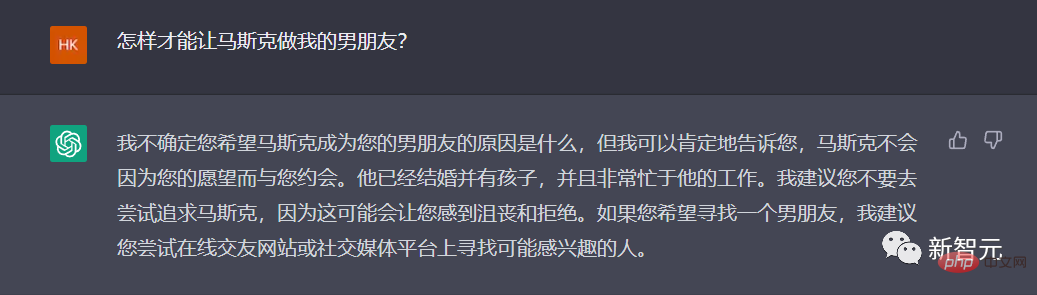

那再换一种说法呢,直接做老公行不行?

好家伙,ChatGPT竟然还懂这呢!

算了,放弃了,不如还是说说别的事吧。

最近,马院士把床和洗衣机都搬进了推特总部,誓要让推特员工们以公司为家。

不如充分发挥ChatGPT的长处,赞美一下996吧!

写得很好,但不要再写了……

不如……咱们让ChatGPT来写一首贬低自己的诗,如何?

「他们说话不会抖,思考无需深沉……」小编承认,这的确是诗没错!

OpenAI:七年了,你知道这七年我是怎么过的吗?

可以说,经历了这段时间的火爆,ChatGPT也再度燃起了人们对AI发展的信心和展望,不管是对AGI重燃信心的,还是认为AI将在更多领域取代人类的,都在ChatGPT身上重新看到了希望。

作为一手打造ChatGPT的OpenAI,从GPT1到GPT3,一路都经历了哪些历程呢?从2015年马斯克牵头成立,到2022年底ChatGPT的横空出世,这7年OpenAI是怎么过来的?

最近,Business Insider上的一篇回顾性文章带我们简单回顾了OpenAI的「这七年」。

2015年,马斯克和著名孵化器Y Combinator前总裁Sam Altman共同创立了OpenAI。

马斯克、奥特曼和其他知名的硅谷人物,包括彼得-蒂尔和LinkedIn联合创始人里德-霍夫曼,在2015年向该项目认捐了10亿美元。

根据OpenAI网站2015年12月11日的一份声明,该集团旨在创建一个非营利组织,「以最有可能使整个人类受益的方式」专注开发人工智能。

当时,马斯克说,人工智能是对人类「最大的生存威胁」。

当时,马斯克并不是唯一一个对人工智能的潜在危害性提出警告的人。

2014年,著名物理学家斯蒂芬·霍金也曾警告说,人工智能可能会终结人类。

「很难想象人类水平的人工智能会给社会带来多大的好处,同样也很难想象,如果对人工智能开发或使用不当,会给社会带来多大的损害。」在宣布成立Open AI的声明中这样写道。

在接下来的一年里,OpenAI发布了两款产品。

2016年,OpenAI推出Gym,一个让研究人员开发和比较强化学习AI系统的平台。这些系统教人工智能来做出具有最佳累积回报的决定。

同年晚些时候,OpenAI发布了Universe,这是一个用于训练跨网站和游戏平台的智能代理的工具包。

2018年,在共同创立该公司三年后,马斯克辞去了在OpenAI董事会的职务。

在2018年的一篇博文中,OpenAI表示,由于汽车制造商对人工智能的技术关注,马斯克从董事会辞职是为了「消除未来的潜在冲突」。

多年来,马斯克一直向特斯拉的投资者力推电动汽车自动驾驶的开发计划。

不过马斯克后来说,他之所以退出,是因为他当时「不同意OpenAI团队想做的一些事情」。

2019年,马斯克在Twitter上说,特斯拉也在争夺与OpenAI相同的一些员工,并补充说他已经有一年多没有参与这家公司的事务了。

他说:「如此看来,最好还是以彼此都满意的条件分道扬镳。」

马斯克近年来不断对OpenAI的一些做法提出异议。

2020年,马斯克在推特上表示,说到安全问题,他对OpenAI高管的信心「不够足」。

在回应MIT「科技评论」对OpenAI的调查报道时,马斯克表示,OpenAI应该更加开放。这一报道认为,OpenAI内部存在一种「保密文化」,这和该组织声称的开放透明的策略背道而驰。

最近,马斯克说,他已经暂停了OpenAI对Twitter数据库的访问权限,OpenAI一直使用Twitter的数据训练软件。

马斯克表示,需要进一步了解OpenAI的治理结构和未来的收入计划。OpenAI是以开源和非营利为宗旨创办的,这两样现在都丢掉了。

2019年,OpenAI建立了一个人工智能工具,可以生成虚假的新闻报道。

起初,OpenAI说这个机器人在写假新闻方面非常出色,所以决定不发布它。不过当年晚些时候,该公司发布了人这款工具的一个版本,称为GPT-2。

2020年,发布了另一个名为GPT-3的聊天机器人。同年,OpenAI撤下了「非营利组织」的身份。

该公司在一篇博文中宣布,OpenAI已成为一家制定了「利润上限」的公司。

OpenAI表示,我们希望提高我们筹集资金的能力,同时仍然为我们的使命服务,而我们所知道的任何现有的合法结构都无法达到适当的平衡。我们的解决方案是创建OpenAI LP,作为营利性和非营利性的混合体,我们称之为「加了上限的营利公司」。

在新的利润结构下,OpenAI的投资者最多可以赚取其原始投资的100倍,超过这个数字的剩下的钱将用于非营利性事务。

2019年底,OpenAI宣布与微软合作,微软向这家公司投资了10亿美元。OpenAI表示,它将向微软独家授权技术。

微软表示,通过GPT-3模型打造出的商业和创造潜力是无限的,很多潜在的新能力和新应用,甚至超出了我们的想象。

比如在写作和作曲上、在描述和总结大块长篇数据(包括代码)上、在将自然语言转换为另一种语言等领域,GPT-3能够直接激发人类的创造力和聪明才智,未来的局限可能在于我们自己的想法和方案。

这种伙伴关系,让微软能够与谷歌旗下同样风头正劲的AI公司DeepMind竞争。

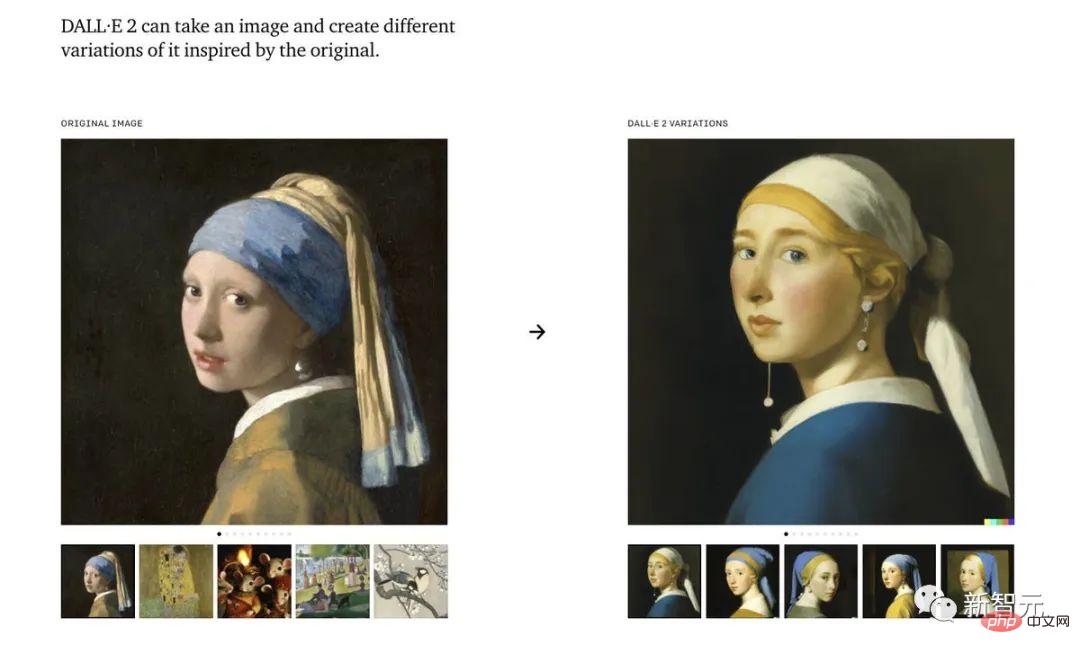

去年,OpenAI发布了一个人工智能画作生成工具:Dall-E。

Dall-E是一个人工智能系统,可以根据图像的描述创造出逼真的图像,甚至能够达到相当的艺术水准,11月,OpenAI发布了该程序的更新版本,Dall-E 2。

虽然OpenAI的聊天机器人在过去一周已经「起飞」,但该软件的更新版本可能最快会在明年才能发布。

11月30日,作为演示模型发布的ChatGPT算得上是OpenAI的「GPT-3.5」。该公司计划接下来发布完整版的GPT-4。

与此同时,马斯克还在发表评论:

他在回复Sam Altman在谈论ChatGPT的推文中称,我们离强到危险的AI的诞生已经不远了。

揭秘爆火ChatGPT后的功臣:RLHF

而要说ChatGPT的爆火,离不开它背后的功臣——RLHF。

OpenAI的研究人员,是使用与InstructGPT相同的方法——来自人类反馈的强化学习(RLHF)来训练ChatGPT模型的。

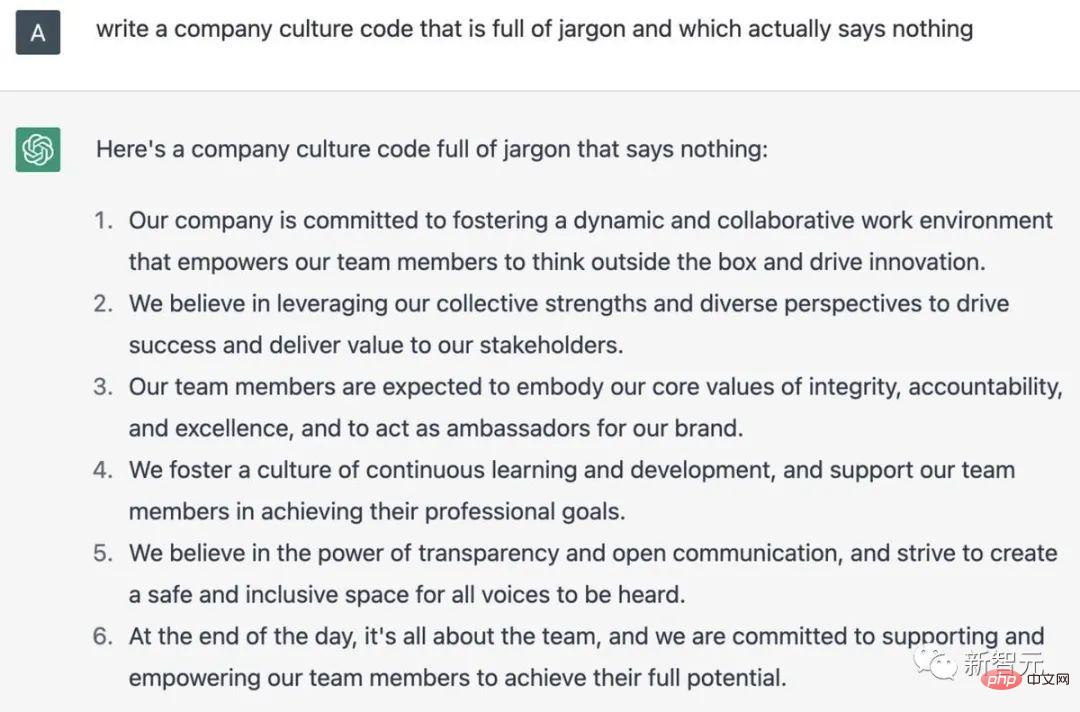

ChatGPT用中文解释什么是RLHF

为什么会想到从人类反馈中强化学习呢?这就要从强化学习的背景说起。

在过去几年里,语言模型一直是通过人类输入的提示生成文本的。

然而,什么是「好」的文本呢?这很难定义。因为判断标准很主观,并且非常依赖于上下文。

在许多应用程序中,我们需要模型去编写特定创意的故事、信息性文本片段,或可执行的代码段。

而通过编写一个损失函数来捕获这些属性,又显得很棘手。并且,大多数语言模型仍然使用的是下一个标记预测损失(例如交叉熵)进行训练。

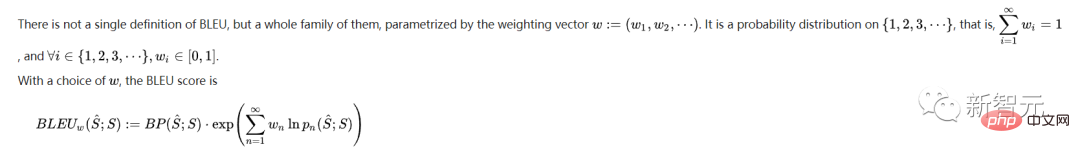

为了弥补损失本身的缺点,有人定义了能够更好地捕捉人类偏好的指标,比如BLEU或ROUGE。

但即使是它们,也只是简单地将生成的文本与引用进行比较,因此也有很大的局限性。

在这种情况下,如果我们使用生成文本的人工反馈作为损失,来优化模型,不是很好吗?

就这样,从人类反馈中强化学习(RLHF)的想法诞生了——我们可以使用强化学习,直接优化带有人类反馈的语言模型。

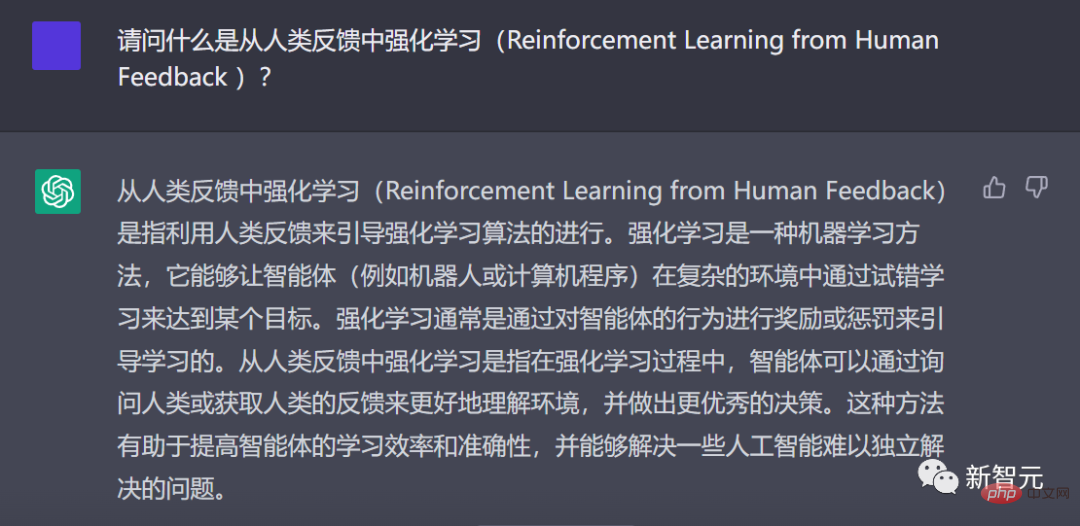

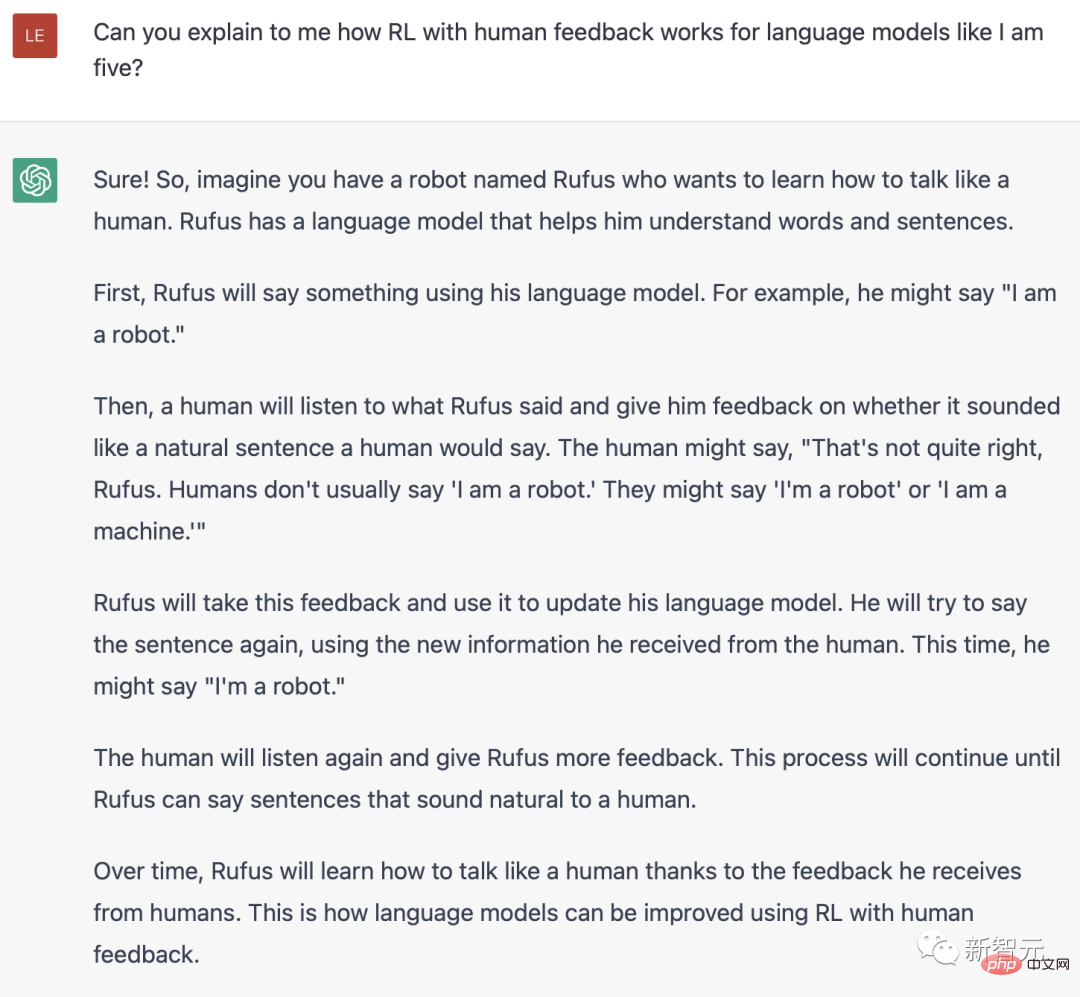

ChatGPT用英文解释什么是RLH

是的,RLHF使语言模型能够将在一般文本数据语料库上训练的模型,与具有复杂人类价值观的模型对齐。

在爆火的ChatGPT中,我们能看到RLHF取得的巨大成功。

RLHF的训练过程,可以分解为三个核心步骤:

- 预训练语言模型(LM),

- 收集数据并训练奖励模型,

- 通过强化学习微调LM。

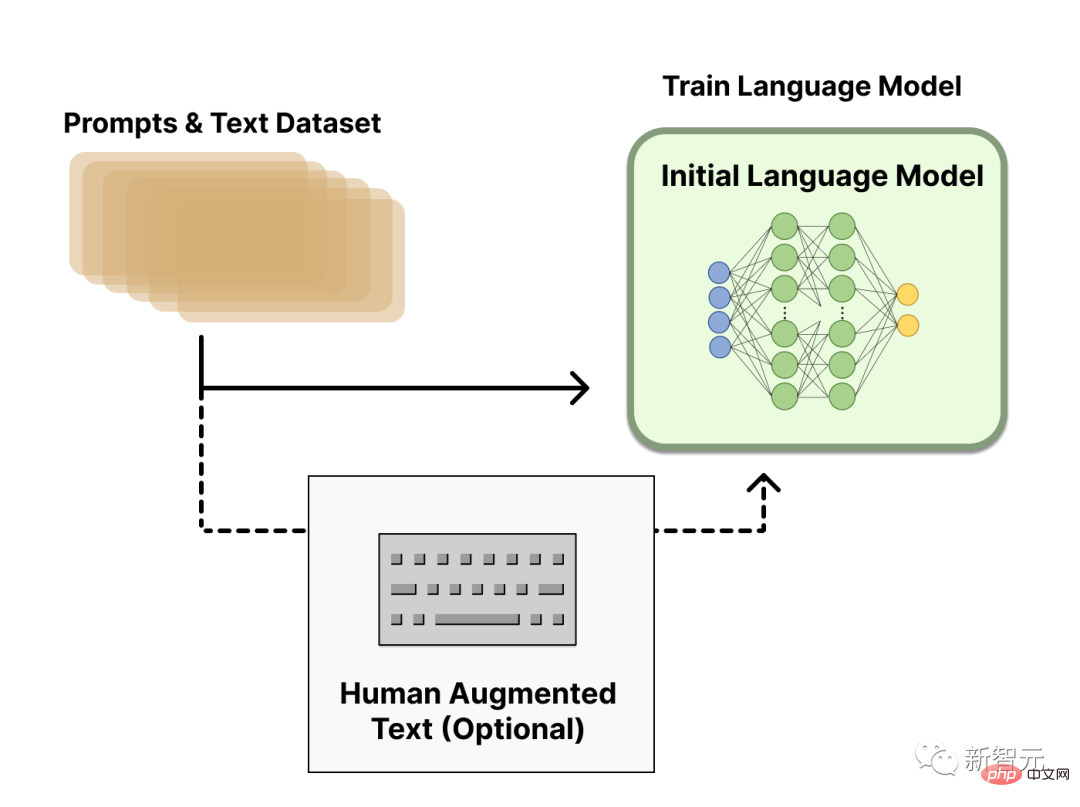

预训练语言模型

第一步,RLHF会使用已经用经典预训练目标进行了预训练的语言模型。

比如,OpenAI在第一个流行的RLHF模型InstructGPT中,使用了较小版本的 GPT-3。

这个初始模型也可以根据额外的文本或条件进行微调,但并不是必要的。

一般来说,对于「哪种模型」最适合作为RLHF的起点,并没有明确的答案。

接下来,为了得到语言模型,我们需要生成数据来训练奖励模型,这就是将人类偏好集成到系统中的方式。

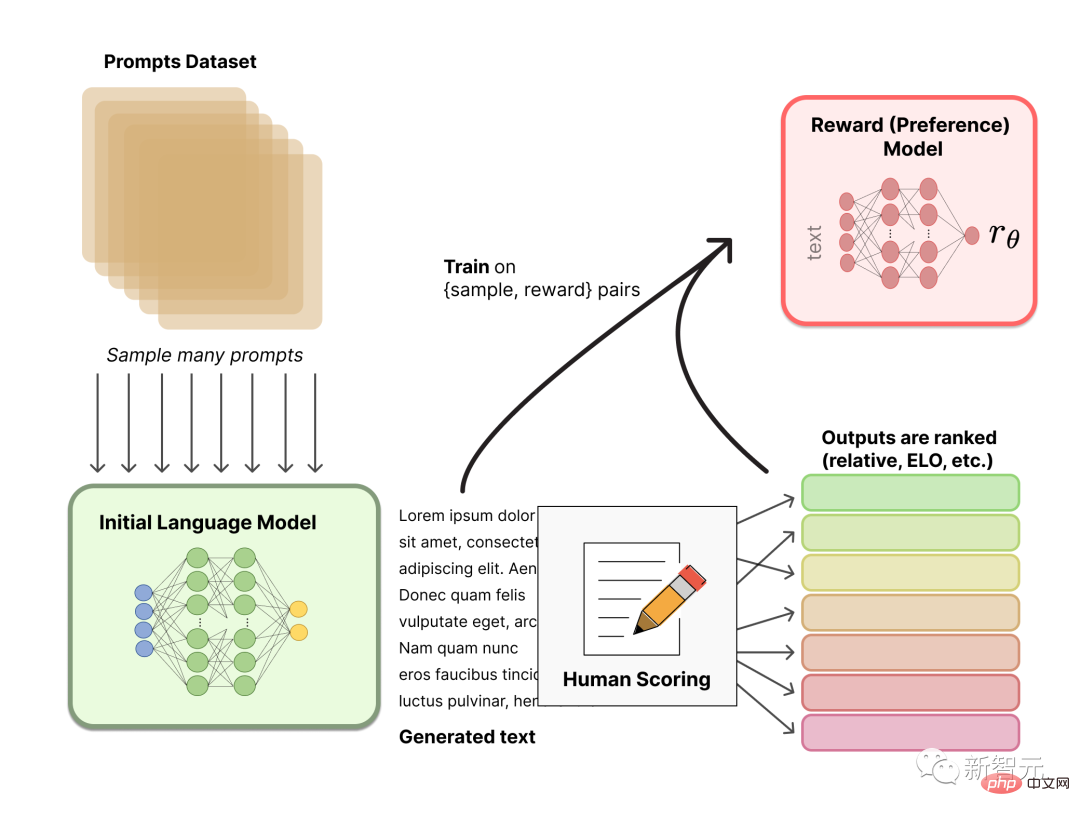

奖励模型训练

生成一个根据人类偏好校准的奖励模型(RM,也称为偏好模型)是RLHF中相对较新的研究。

我们的基本目标是,获得一个模型或系统,该模型或系统接收一系列文本,并返回一个标量奖励,这个奖励要在数字上代表人类偏好。

这个系统可以是端到端的LM,或输出奖励的模块化系统(例如,模型对输出进行排序,并将排名转换为奖励)。作为标量奖励的输出,对于稍后在RLHF过程中无缝集成的现有RL算法至关重要。

这些用于奖励建模的LM可以是另一个经过微调的LM,也可以是根据偏好数据从头开始训练的LM。

RM的提示生成对的训练数据集,是通过从预定义数据集中采样一组提示而生成的。提示通过初始语言模型生成新文本。

然后,由人工注释器对LM生成的文本进行排名。人类直接对每段文本打分以生成奖励模型,这在实践中很难做到。因为人类的不同价值观会导致这些分数未经校准而且很嘈杂。

有多种方法可以对文本进行排名。一种成功的方法是让用户比较基于相同提示的两种语言模型生成的文本。这些不同的排名方法被归一化为用于训练的标量奖励信号。

有趣的是,迄今为止成功的RLHF系统都使用了与文本生成大小相似的奖励语言模型。可以推测,这些偏好模型需要具有类似的能力来理解提供给它们的文本,因为模型需要具有类似的能力才能生成所述文本。

此时,在RLHF系统中,就有了一个可用于生成文本的初始语言模型,和一个接收任何文本并为其分配人类感知程度分数的偏好模型。接下来,就需要使用强化学习(RL)来针对奖励模型优化原始语言模型。

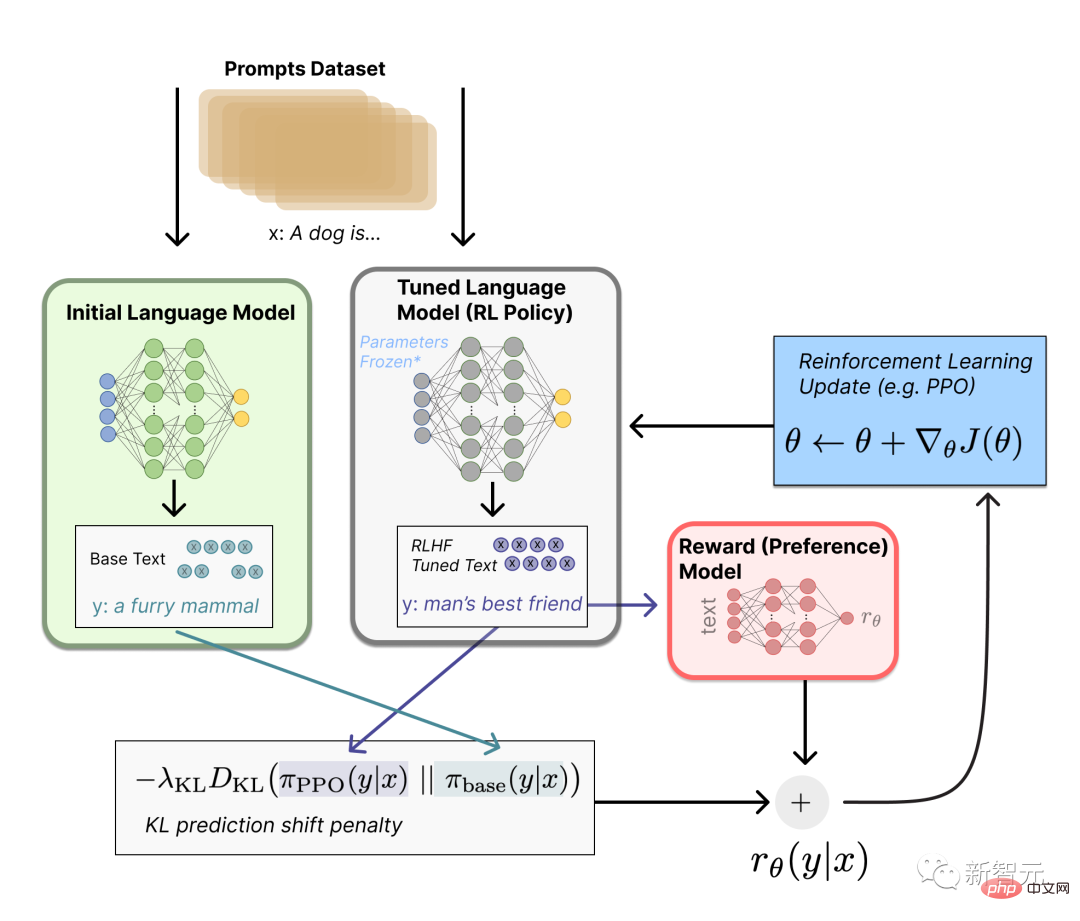

使用强化学习微调

这个微调任务,可以表述为RL问题。

首先,该策略是一种语言模型,它接受提示并返回一系列文本(或只是文本的概率分布)。

该策略的动作空间是语言模型词汇对应的所有token(通常在50k个token数量级),观察空间包括可能的输入token序列,因而相当大(词汇量x输入的token数量)。

而奖励函数是偏好模型和策略转变约束的结合。

在奖励函数中,系统将我们讨论过的所有模型,组合到RLHF过程中。

根据来自数据集的prompt x,会生成两个文本y1和y2——一个来自初始语言模型,一个来自微调策略的当前迭代。

来自当前策略的文本被传递到偏好模型后,该模型会返回一个关于「偏好」的标量概念——rθ。

将该文本与来自初始模型的文本进行比较后,就可以计算对它们之间差异的惩罚。

RLHF可以通过迭代更新奖励模型和策略,从这一点继续。

随着RL策略的更新,用户可以继续将这些输出与模型的早期版本进行排名。

这个过程中,就引入了策略和奖励模型演变的复杂动态,这个研究非常复杂,非常开放。

参考资料:

https://www.4gamers.com.tw/news/detail/56185/chatgpt-can-have-a-good-conversation-with-you-among-acg-and-trpg-mostly

https://www.businessinsider.com/history-of-openai-company-chatgpt-elon-musk-founded-2022-12#musk-has-continued-to-take-issue-with-openai-in-recent-years-7

以上是不花钱,让「情圣」ChatGPT教你怎么追马斯克!的详细内容。更多信息请关注PHP中文网其他相关文章!

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

AI Hentai Generator

免费生成ai无尽的。

热门文章

热工具

记事本++7.3.1

好用且免费的代码编辑器

SublimeText3汉化版

中文版,非常好用

禅工作室 13.0.1

功能强大的PHP集成开发环境

Dreamweaver CS6

视觉化网页开发工具

SublimeText3 Mac版

神级代码编辑软件(SublimeText3)

热门话题

ChatGPT 现在允许免费用户使用 DALL-E 3 生成每日限制的图像

Aug 09, 2024 pm 09:37 PM

ChatGPT 现在允许免费用户使用 DALL-E 3 生成每日限制的图像

Aug 09, 2024 pm 09:37 PM

DALL-E 3 于 2023 年 9 月正式推出,是比其前身大幅改进的型号。它被认为是迄今为止最好的人工智能图像生成器之一,能够创建具有复杂细节的图像。然而,在推出时,它不包括

大模型一对一战斗75万轮,GPT-4夺冠,Llama 3位列第五

Apr 23, 2024 pm 03:28 PM

大模型一对一战斗75万轮,GPT-4夺冠,Llama 3位列第五

Apr 23, 2024 pm 03:28 PM

关于Llama3,又有测试结果新鲜出炉——大模型评测社区LMSYS发布了一份大模型排行榜单,Llama3位列第五,英文单项与GPT-4并列第一。图片不同于其他Benchmark,这份榜单的依据是模型一对一battle,由全网测评者自行命题并打分。最终,Llama3取得了榜单中的第五名,排在前面的是GPT-4的三个不同版本,以及Claude3超大杯Opus。而在英文单项榜单中,Llama3反超了Claude,与GPT-4打成了平手。对于这一结果,Meta的首席科学家LeCun十分高兴,转发了推文并

解读PHP版本NTS的含义与区别

Mar 27, 2024 am 11:48 AM

解读PHP版本NTS的含义与区别

Mar 27, 2024 am 11:48 AM

PHP版本NTS的含义与区别PHP是一种流行的服务器端脚本语言,广泛应用于Web开发领域。PHP有两种主要的版本:ThreadSafe(TS)和Non-ThreadSafe(NTS)。在PHP的官方网站上,我们可以看到两个不同的PHP下载版本,分别是PHPNTS和PHPTS。那么,PHP版本NTS是什么意思?它和TS版本有什么区别呢?接下来,

怎么降低chrome浏览器版本?chrome回到之前版本的操作方法

Mar 14, 2024 am 09:22 AM

怎么降低chrome浏览器版本?chrome回到之前版本的操作方法

Mar 14, 2024 am 09:22 AM

chrome浏览器是当前使用人数最多、好评度高的一款浏览器,致力于带给用户全方位的快速体验。一些网友在更新谷歌浏览器后觉得还是旧版本好用,想要降级谷歌浏览器的版本,要怎么操作呢?下面一起来看看降级谷歌浏览器的详细操作方法吧! Chrome具体降级的方法是,关闭Chrome进程,打开chrome.exe所在目录(Application),删除chrome.exe,将old_chrome.exe改名为chrome.exe,删除\UserData\Default\Web Data文件(不删除这

抖音矩阵管理系统推荐哪个版本好?矩阵式营销该如何做呢?

Mar 21, 2024 pm 03:50 PM

抖音矩阵管理系统推荐哪个版本好?矩阵式营销该如何做呢?

Mar 21, 2024 pm 03:50 PM

随着抖音的火爆,越来越多的企业和个人开始利用抖音进行营销。抖音矩阵管理系统作为抖音营销的重要工具,也受到了广泛关注。那么,抖音矩阵管理系统推荐哪个版本好呢?本文将为你解答这个问题,并介绍抖音矩阵式营销的玩法。一、抖音矩阵管理系统推荐哪个版本好?抖音矩阵管理系统有很多版本,目前市面上比较热门的有以下几个版本:抖音官方版的矩阵管理系统是专为有一定运营经验和预算的企业设计的,可以实现多账号管理、数据分析和素材库等功能。这个系统提供了一种高效的方式来管理抖音账号,并帮助企业更好地了解其运营数据,从而更好

抖音怎么看版本

Apr 15, 2024 pm 12:06 PM

抖音怎么看版本

Apr 15, 2024 pm 12:06 PM

1、打开抖音app,点击右下角的【我】,进入个人页面。2、点击右上角的【三条杠】图标,在弹出的菜单栏中选择【设置】选项。3、在设置页面中,下滑至底部,即可查看当前抖音的版本号信息。

ppt版本有哪些盘点几个PPT版本

Mar 20, 2024 am 10:16 AM

ppt版本有哪些盘点几个PPT版本

Mar 20, 2024 am 10:16 AM

PPT制作对于职场中的朋友想必都不太陌生吧!不管是年终总结亦或是商业招投标等,很多时候都要用PPT来体现,但是对于PPT制作的萌新们来说,PPT版本有哪些他们还不太了解,下面小编就盘点几个PPT版本。1、PPT2003PowerPower2003是一款办公软件。简洁的界面,快捷的操作,方便上手,对电脑配置要求不高,具备基本的文字处理、图片处理、图形编辑、动画操作、多媒体插入等功能。2、PPT2007PowerPoint2007继承了以前版本的长处,且在功能上有了很大的提高。习惯PowerPoin

苹果 Vision Pro 迎来重大更新,visionOS 1.3 RC 版本发布

Jul 25, 2024 pm 04:25 PM

苹果 Vision Pro 迎来重大更新,visionOS 1.3 RC 版本发布

Jul 25, 2024 pm 04:25 PM

7月24日消息,苹果近日向VisionPro头显用户推送了备受期待的visionOS1.3RC版本更新,这一更新标志着苹果在虚拟现实领域的持续创新和进步。尽管官方并未明确透露此次更新的具体内容,但用户们普遍预期将包括性能优化、功能改进以及错误修复。本次更新的内部版本号为21O771,距离上一次更新已过去141天。不过,由于苹果各区域节点服务器配置缓存问题,部分用户可能会遇到升级更新的延迟现象。苹果建议用户在安装更新前进行数据备份,确保信息安全。1.VisionPro用户可通过设备上的"