LeCun领导下的Meta AI,押注自监督

自监督学习真的是通往 AGI 的关键一步?

Meta 的 AI 首席科学家 Yann LeCun 在谈到「此时此刻要采取的具体措施」时,也没有忘记远期的目标。他在一次采访时说:「我们想要构建像动物和人类一样学习的智能机器。」

近几年,Meta 发表了一系列关于 AI 系统自监督学习(SSL)的论文。LeCun 坚定地认为,SSL 是 AI 系统的必要前提,它可以帮助 AI 系统构建世界模型,以获得类似人类的能力,如理性、常识,以及将技能和知识从一个环境迁移到另一个环境的能力。

他们的新论文展示了一种被称为掩蔽自编码器(MAE)的自监督系统如何学会从非常零散、不完整的数据中重建图像、视频甚至音频。虽然 MAE 并不是一个新的想法,但 Meta 已经将这项工作扩展到了新的领域。

LeCun 说,通过研究如何预测丢失的数据,无论是静态图像还是视频或音频序列,MAE 系统都是在构建一个世界模型。他说:「如果它能预测视频中即将发生的事情,它必须明白世界是三维的,有些物体是无生命的,它们自己不会移动,其他物体是有生命的,很难预测,一直到预测有生命的人的复杂行为。」一旦 AI 系统有了一个精确的世界模型,它就可以使用这个模型来计划行动。

LeCun 说,「智能的本质是学会预测。」虽然他并没有声称 Meta 的 MAE 系统接近于通用人工智能,但他认为这是通往通用人工智能的重要一步。

但并非所有人都同意 Meta 的研究人员走在通往通用人工智能的正确道路上。Yoshua Bengio 有时会与 LeCun 就 AI 领域的重大想法进行友好的辩论。在给 IEEE Spectrum 的一封电子邮件中,Bengio 阐述了他们在目标上的一些不同和相似之处。

Bengio 写道:「我真的不认为我们目前的方法(无论是不是自监督)足以弥合人工与人类智能水平的差距。」他说,该领域需要取得「质的进步」,才能真正推动技术向人类规模的人工智能靠拢。

对于 LeCun 的「对世界的推理能力是智能的核心要素」这一观点,Bengio 表示赞同,但他的团队并没有把重点放在能够预测的模型上,而是放在了能够以自然语言的形式呈现知识的模型上。他指出,这样的模型将允许我们将这些知识片段结合起来,以解决新问题,进行反事实模拟,或研究可能的未来。Bengio 的团队开发了一种新的神经网络框架,它比致力于端到端学习的 LeCun 所青睐的框架更具模块化的性质。

大火的 Transformer

Meta 的 MAE 建立在一种名为 Transformer 的神经网络架构基础之上。这种架构最初在自然语言处理领域走红,之后扩展到计算机视觉等多个领域。

当然,Meta 并不是第一个成功将 Transformer 用到视觉任务中的团队。Meta AI 的研究者 Ross Girshick 介绍说,谷歌在视觉 Transformer(ViT)上的研究启发了 Meta 的团队,「ViT 架构的采用帮助(我们)消除了试验过程中遇到的一些障碍」。

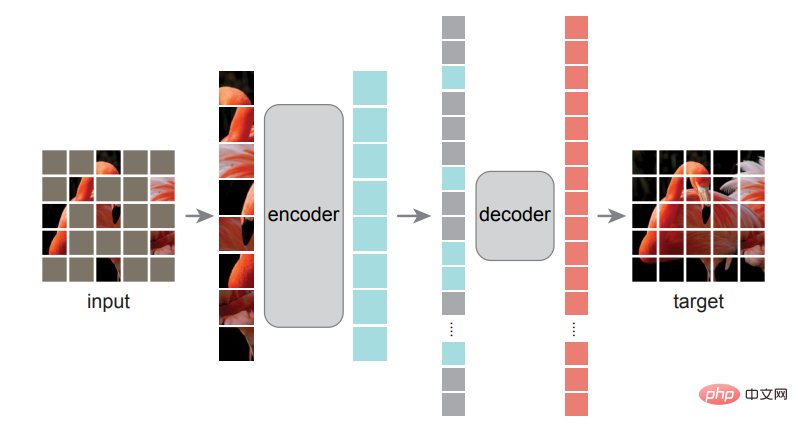

Girshick 是 Meta 第一篇 MAE 系统论文的作者之一,这篇论文的一作是何恺明,他们论述了一种非常简单的方法:掩蔽输入图像的随机区块并重建丢失的像素。

这种模型的训练类似于 BERT 以及其他一些基于 Transformer 的语言模型,研究人员会向它们展示巨大的文本数据库,但有些词是缺失的,或者说被「掩蔽」了。模型需要自己预测出缺失的词,然后被掩蔽的词会被揭开,这样模型就能检查自己的工作并更新自己的参数。这一过程会一直重复下去。Girshick 解释说,为了在视觉上做类似的事情,研究小组将图像分解成 patch,然后掩蔽一些 patch 并要求 MAE 系统预测图像缺失的部分。

该团队的突破之一是意识到,掩蔽大部分图像会获得最好的结果,这与语言 transformer 有着关键区别,后者可能只会掩蔽 15% 的单词。「语言是一种极其密集和高效的交流系统,每个符号都包含很多含义,」Girshick 说,「但是图像——这些来自自然世界的信号——并不是为了消除冗余而构建的。所以我们才能在创建 JPG 图像时很好地压缩内容。」

Meta AI 的研究人员试验需要掩蔽多少图像获得最佳效果。

Girshick 解释说,通过掩蔽图像中超过 75% 的 patch,他们消除了图像中的冗余,否则会使任务变得过于琐碎,不适合训练。他们那个由两部分组成的 MAE 系统首先使用一个编码器,通过训练数据集学习像素之间的关系,然后一个解码器尽最大努力从掩蔽图像中重建原始图像。在此训练方案完成后,编码器还可以进行微调,用于分类和目标检测等视觉任务。

Girshick 说,「最终让我们兴奋的点在于,我们看到了这个模型在下游任务中的结果。」当使用编码器完成目标识别等任务时,「我们看到的收益非常可观。」他指出,继续增大模型可以获得更好的性能,这对未来的模型来说是一个有潜力的方向,因为 SSL「具有使用大量数据而不需要手动注释的潜力」。

全力以赴地学习海量的未经筛选的数据集可能是 Meta 提高 SSL 结果的策略,但也是一个越来越有争议的方法。Timnit Gebru 等人工智能伦理研究人员已经呼吁大家注意大型语言模型学习的未经整理的数据集固有的偏见,这些偏见有时会导致灾难性的结果。

视频和音频的自监督学习

在视频 MAE 系统中,掩蔽物遮蔽了每个视频帧的 95%,因为帧之间的相似性意味着视频信号比静态图像有更多的冗余。Meta 研究人员 Christoph Feichtenhofer 说,就视频而言,MAE 方法的一大优势是视频通常需要大量计算,而 MAE 通过屏蔽每帧高达 95% 的内容,减少了高达 95% 的计算成本。

这些实验中使用的视频片段只有几秒钟,但 Feichtenhofer 表示,用较长的视频训练人工智能系统是一个非常活跃的研究课题。想象一下,你有一个虚拟助理,他有你家的视频,可以告诉你一个小时之前你把钥匙放在哪里了。

更直接地说,我们可以想象图像和视频系统对 Facebook 和 Instagram 上的内容审核所需的分类任务都很有用,Feichtenhofer 说,「integrity」是一种可能的应用,「我们正在与产品团队沟通,但这是非常新的,我们还没有任何具体的项目。」

对于音频 MAE 工作,Meta AI 的团队表示他们将很快将研究成果发布在 arXiv 上。他们发现了一个巧妙的方法来应用掩蔽技术。他们将声音文件转化为声谱图,即信号中频率频谱的视觉表征,然后将部分图像掩蔽起来进行训练。重建的音频令人印象深刻,尽管该模型目前只能处理几秒钟的片段。

该音频系统的研究人员 Bernie Huang 说,这项研究的潜在应用包括分类任务,通过填充数据包被 drop 时丢失的音频来辅助基于 IP 的语音传输(VoIP),或者找到更有效的压缩音频文件的方法。

Meta 一直在进行开源 AI 方面的研究,如这些 MAE 模型,还为人工智能社区提供了一个预训练的大型语言模型。但批评人士指出,尽管在研究方面如此开放,但 Meta 还没有把它的核心商业算法开放出来供大家研究,即那些控制新闻推送、推荐和广告植入的算法。

以上是LeCun领导下的Meta AI,押注自监督的详细内容。更多信息请关注PHP中文网其他相关文章!

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

AI Hentai Generator

免费生成ai无尽的。

热门文章

热工具

记事本++7.3.1

好用且免费的代码编辑器

SublimeText3汉化版

中文版,非常好用

禅工作室 13.0.1

功能强大的PHP集成开发环境

Dreamweaver CS6

视觉化网页开发工具

SublimeText3 Mac版

神级代码编辑软件(SublimeText3)

热门话题

新款经济实惠的 Meta Quest 3S VR 耳机出现在 FCC 上,暗示即将推出

Sep 04, 2024 am 06:51 AM

新款经济实惠的 Meta Quest 3S VR 耳机出现在 FCC 上,暗示即将推出

Sep 04, 2024 am 06:51 AM

Meta Connect 2024 活动定于 9 月 25 日至 26 日举行,在本次活动中,该公司预计将推出一款价格实惠的新型虚拟现实耳机。据传这款 VR 耳机是 Meta Quest 3S,它似乎已经出现在 FCC 清单上。这个建议

首个超越GPT4o级开源模型!Llama 3.1泄密:4050亿参数,下载链接、模型卡都有了

Jul 23, 2024 pm 08:51 PM

首个超越GPT4o级开源模型!Llama 3.1泄密:4050亿参数,下载链接、模型卡都有了

Jul 23, 2024 pm 08:51 PM

快准备好你的GPU!Llama3.1终于现身了,不过出处却不是Meta官方。今日,Reddit上新版Llama大模型泄露的消息遭到了疯传,除了基础模型,还包括8B、70B和最大参数的405B的基准测试结果。下图为Llama3.1各版本与OpenAIGPT-4o、Llama38B/70B的比较结果。可以看到,即使是70B的版本,也在多项基准上超过了GPT-4o。图源:https://x.com/mattshumer_/status/1815444612414087294显然,3.1版本的8B和70

六年种方式快速体验最新发布的 Llama 3!

Apr 19, 2024 pm 12:16 PM

六年种方式快速体验最新发布的 Llama 3!

Apr 19, 2024 pm 12:16 PM

昨晚Meta发布了Llama38B和70B模型,Llama3指令调整模型针对对话/聊天用例进行了微调和优化,在常见基准测试中优于许多现有的开源聊天模型。比如,Gemma7B和Mistral7B。Llama+3模型对数据和规模进行了提升,达到了新的高度。它是在Meta最近发布的两个定制的24KGPU集群上,对超过15Ttoken的数据进行训练的。这个训练数据集比Llama2大7倍,包含多4倍的代码。这使得Llama模型的能力达到了目前的最高水平,它支持8K以上的文本长度,是Llama2的两倍。下面

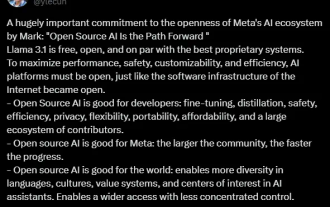

最强模型Llama 3.1 405B正式发布,扎克伯格:开源引领新时代

Jul 24, 2024 pm 08:23 PM

最强模型Llama 3.1 405B正式发布,扎克伯格:开源引领新时代

Jul 24, 2024 pm 08:23 PM

刚刚,大家期待已久的Llama3.1官方正式发布了!Meta官方发出了「开源引领新时代」的声音。在官方博客中,Meta表示:「直到今天,开源大语言模型在功能和性能方面大多落后于封闭模型。现在,我们正在迎来一个开源引领的新时代。我们公开发布MetaLlama3.1405B,我们认为这是世界上最大、功能最强大的开源基础模型。迄今为止,所有Llama版本的总下载量已超过3亿次,我们才刚刚开始。」Meta创始人、CEO扎克伯格也亲自写了篇长文《OpenSourceAIIsthePathForward》,

META是什么意思

Mar 05, 2024 pm 12:18 PM

META是什么意思

Mar 05, 2024 pm 12:18 PM

META通常指代一个名为Meta宇宙(Metaverse)的虚拟世界或平台。meta元宇宙,是人类运用数字技术构建的,由现实世界映射或超越现实世界,可与现实世界交互的虚拟世界 ,具备新型社会体系的数字生活空间。

Llama3突然来袭!开源社区再次沸腾:GPT4级模型自由访问时代到来

Apr 19, 2024 pm 12:43 PM

Llama3突然来袭!开源社区再次沸腾:GPT4级模型自由访问时代到来

Apr 19, 2024 pm 12:43 PM

Llama3来了!就在刚刚,Meta官网上新,官宣了Llama380亿和700亿参数版本。并且推出即为开源SOTA:Meta官方数据显示,Llama38B和70B版本在各自参数规模上超越一众对手。8B模型在MMLU、GPQA、HumanEval等多项基准上均胜过Gemma7B和Mistral7BInstruct。而70B模型则超越了闭源的当红炸子鸡Claude3Sonnet,和谷歌的GeminiPro1.5打得有来有回。Huggingface链接一出,开源社区再次沸腾。眼尖的盲生们还第一时间发现

预计2024年,Meta计划推出名为'Orion'的革命性AR眼镜原型

Jan 04, 2024 pm 09:35 PM

预计2024年,Meta计划推出名为'Orion'的革命性AR眼镜原型

Jan 04, 2024 pm 09:35 PM

12月24日消息,meta,一家在社交媒体界有着巨大影响力的科技企业,现正将其雄厚的期望寄托于增强现实(AR)眼镜,一种被认为是下一代计算平台的技术。近期,meta的技术主管安德鲁・博斯沃思(AndrewBosworth)在一次采访中透露,该公司有望在2024年推出一款代号为“Orion”的先进AR眼镜原型。长期以来,meta在AR技术上的投入丝毫不亚于其他领域,他们投入了巨额资金,达数十亿美元,旨在打造一款能与iPhone相媲美的革命性产品。尽管去年他们宣布终止Orion眼镜的大规模生产计划,

分析师讨论传闻中的 Meta Quest 3S VR 耳机的发布定价

Aug 27, 2024 pm 09:35 PM

分析师讨论传闻中的 Meta Quest 3S VR 耳机的发布定价

Aug 27, 2024 pm 09:35 PM

自 Meta 首次发布 Quest 3(亚马逊售价 499.99 美元)以来,已经过去一年多了。此后,苹果推出了价格昂贵得多的 Vision Pro,而字节跳动现在在中国推出了 Pico 4 Ultra。然而,有