谷歌前CEO:AI就像核武器,大国之间需要建立‘AI威慑’,确保相互毁灭

谷歌前首席执行官埃里克·施密特(Eric Schmidt)在一次访谈中,将人工智能比作核武器,并呼吁建立一个类似的相互确保毁灭的威慑机制,以防止世界上最强大的国家因为AI相互毁灭。

相互保证毁灭(Mutually Assured Destruction,简称M.A.D.机制,亦称共同毁灭原则)是一种“俱皆毁灭”性质的思想。对立的两方中如果有一方全面使用则两方都会被毁灭,被称为“恐怖平衡”。

施密特将AI与核武器相对比,表示中美未来可能要缔结类似于禁止“核试验”相似的条约,以防止AI毁灭世界。

施密特:当时我还很年轻,还很天真

7月22日,施密特在阿斯彭安全论坛(Aspen Security Forum)国家安全和人工智能专题小组会议上谈到了人工智能的危险。

在回答一个关于科技中的道德价值的问题时,施密特解释说,他自己在谷歌早期对信息的力量认识还很天真。

然后,他呼吁科技要更好地符合其服务对象的道德和伦理,并将人工智能与核武器进行了奇怪的比较。

施密特设想在不久的将来,中国和美国需要围绕人工智能签订一些条约。

施密特说:“在50年代和60年代,我们最终制定了一个关于核试验的‘意料之中’的规则,最终核试验被禁止了。”

施密特认为“这是一个信任或缺乏信任的平衡的例子,这是一个‘没有惊喜’的规则”,他非常担心美国和中国这两个人工智能大国之间,因为一些误解和误会而开始一些事情,导致触发危险的事件。

施密特表示,目前没有人在这方面进行研究,但人工智能是如此强大。

埃里克·施密特曾在2001年至2011年担任谷歌首席执行官,2011年至2015年担任谷歌执行董事长,2015年至2017年担任 Alphabet 公司执行董事长,2017年至2020年担任 Alphabet 技术顾问。

2008年,在担任谷歌董事长期间,施密特为巴拉克•奥巴马(Barack Obama)助选,随后与埃里克•兰德(Eric Lander)一起成为奥巴马总统的科技顾问委员会(Council of Advisors on Science and Technology)成员。

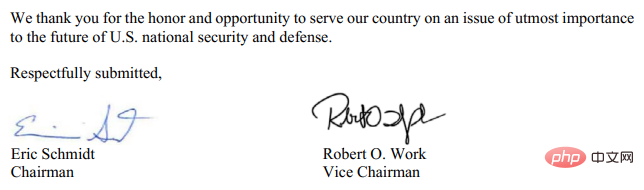

从2019年到2021年,施密特与罗伯特·O·沃克(Robert O. Work)共同主持了美国国家人工智能安全委员会(National Security Commission on AI)。

AI果真有那么危险吗?

人工智能和机器学习是一项令人印象深刻但经常被误解的技术。在很大程度上,它并不像人们认为的那样聪明。

它可以制作出杰作级的美术作品,在《星际争霸2》中击败人类,还可以为用户拨打基本的电话,然而,试图让它完成更复杂的任务,比如自动驾驶,却进展不太顺利。

施密特设想,在不久的将来,中国和美国都会对安全问题感到担忧,从而迫使双方就人工智能达成某种威慑条约。

他谈到了20世纪50年代和60年代,当时各个国家通过外交手腕精心设计了一系列对地球上最致命武器的控制。但是,世界要达到制定《禁止核试验条约》(Nuclear Test Ban Treaty)以及第二阶段《限制战略武器条约》(SALT II)和其他具有里程碑意义的立法的地步,需要经历几十年的核爆炸,比如像广岛和长崎的核爆炸。

美国在第二次世界大战结束时用核武器摧毁的两个日本城市、杀死了成千上万的人,并向世界证明了核武器的永恒恐怖。

随后,苏联和中国也成功开发了核武器,随后便诞生了相互保证毁灭(MAD) ,一种维持“危险平衡”的威慑理论,确保如果一个国家发射核武器,其他国家也有可能发射。

到目前为止,人类还没有使用这个星球上最具破坏性的武器,因为这样做可能会摧毁全球的文明。

目前人工智能有这样的威力吗?

现在看来,人工智能还没有证明自己具有核武器那样的破坏力,但是许多掌权者害怕这种新技术,人们甚至建议把核武器的控制权交给人工智能,这些人认为人工智能比人类更适合作为核武器使用的仲裁者。

所以人工智能的问题也许不在于它拥有核武器的潜在世界毁灭力量,人工智能的好坏取决于它的设计者他们反映了创造者的价值观。

人工智能存在经典的“garbage in, garbage out”的问题,种族主义算法诞生种族主义机器人,人工智能也会产生偏见。

DeepMind 的首席执行官戴米斯•哈萨比斯(Demis Hassabis)比施密特更明白这个道理。

DeepMind曾培养出一种能够击败《星际争霸2》(Starcraft II)玩家的人工智能,在Lex Fridman 播客7月份的一次采访中,Fridman问哈萨比斯如何控制像人工智能这样强大的技术,以及哈萨比斯本人如何避免被这种力量腐蚀。

哈萨比斯的回答:“人工智能是一个太大的想法,”他说,“重要的是谁创造了(人工智能) ,他们来自哪种文化,他们有什么价值观,他们是人工智能系统的建造者。人工智能系统会自己学习... ... 但是这个系统的文化和创造者的价值观会在这个系统中残留下来。”

人工智能是其创造者的反映,120万吨级的爆炸不可能把一座城市夷为平地,除非人类教它这么做。

以上是谷歌前CEO:AI就像核武器,大国之间需要建立‘AI威慑’,确保相互毁灭的详细内容。更多信息请关注PHP中文网其他相关文章!

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

AI Hentai Generator

免费生成ai无尽的。

热门文章

热工具

记事本++7.3.1

好用且免费的代码编辑器

SublimeText3汉化版

中文版,非常好用

禅工作室 13.0.1

功能强大的PHP集成开发环境

Dreamweaver CS6

视觉化网页开发工具

SublimeText3 Mac版

神级代码编辑软件(SublimeText3)

热门话题

字节跳动剪映推出 SVIP 超级会员:连续包年 499 元,提供多种 AI 功能

Jun 28, 2024 am 03:51 AM

字节跳动剪映推出 SVIP 超级会员:连续包年 499 元,提供多种 AI 功能

Jun 28, 2024 am 03:51 AM

本站6月27日消息,剪映是由字节跳动旗下脸萌科技开发的一款视频剪辑软件,依托于抖音平台且基本面向该平台用户制作短视频内容,并兼容iOS、安卓、Windows、MacOS等操作系统。剪映官方宣布会员体系升级,推出全新SVIP,包含多种AI黑科技,例如智能翻译、智能划重点、智能包装、数字人合成等。价格方面,剪映SVIP月费79元,年费599元(本站注:折合每月49.9元),连续包月则为59元每月,连续包年为499元每年(折合每月41.6元)。此外,剪映官方还表示,为提升用户体验,向已订阅了原版VIP

使用Rag和Sem-Rag提供上下文增强AI编码助手

Jun 10, 2024 am 11:08 AM

使用Rag和Sem-Rag提供上下文增强AI编码助手

Jun 10, 2024 am 11:08 AM

通过将检索增强生成和语义记忆纳入AI编码助手,提升开发人员的生产力、效率和准确性。译自EnhancingAICodingAssistantswithContextUsingRAGandSEM-RAG,作者JanakiramMSV。虽然基本AI编程助手自然有帮助,但由于依赖对软件语言和编写软件最常见模式的总体理解,因此常常无法提供最相关和正确的代码建议。这些编码助手生成的代码适合解决他们负责解决的问题,但通常不符合各个团队的编码标准、惯例和风格。这通常会导致需要修改或完善其建议,以便将代码接受到应

微调真的能让LLM学到新东西吗:引入新知识可能让模型产生更多的幻觉

Jun 11, 2024 pm 03:57 PM

微调真的能让LLM学到新东西吗:引入新知识可能让模型产生更多的幻觉

Jun 11, 2024 pm 03:57 PM

大型语言模型(LLM)是在巨大的文本数据库上训练的,在那里它们获得了大量的实际知识。这些知识嵌入到它们的参数中,然后可以在需要时使用。这些模型的知识在训练结束时被“具体化”。在预训练结束时,模型实际上停止学习。对模型进行对齐或进行指令调优,让模型学习如何充分利用这些知识,以及如何更自然地响应用户的问题。但是有时模型知识是不够的,尽管模型可以通过RAG访问外部内容,但通过微调使用模型适应新的领域被认为是有益的。这种微调是使用人工标注者或其他llm创建的输入进行的,模型会遇到额外的实际知识并将其整合

七个很酷的GenAI & LLM技术性面试问题

Jun 07, 2024 am 10:06 AM

七个很酷的GenAI & LLM技术性面试问题

Jun 07, 2024 am 10:06 AM

想了解更多AIGC的内容,请访问:51CTOAI.x社区https://www.51cto.com/aigc/译者|晶颜审校|重楼不同于互联网上随处可见的传统问题库,这些问题需要跳出常规思维。大语言模型(LLM)在数据科学、生成式人工智能(GenAI)和人工智能领域越来越重要。这些复杂的算法提升了人类的技能,并在诸多行业中推动了效率和创新性的提升,成为企业保持竞争力的关键。LLM的应用范围非常广泛,它可以用于自然语言处理、文本生成、语音识别和推荐系统等领域。通过学习大量的数据,LLM能够生成文本

你所不知道的机器学习五大学派

Jun 05, 2024 pm 08:51 PM

你所不知道的机器学习五大学派

Jun 05, 2024 pm 08:51 PM

机器学习是人工智能的重要分支,它赋予计算机从数据中学习的能力,并能够在无需明确编程的情况下改进自身能力。机器学习在各个领域都有着广泛的应用,从图像识别和自然语言处理到推荐系统和欺诈检测,它正在改变我们的生活方式。机器学习领域存在着多种不同的方法和理论,其中最具影响力的五种方法被称为“机器学习五大派”。这五大派分别为符号派、联结派、进化派、贝叶斯派和类推学派。1.符号学派符号学(Symbolism),又称为符号主义,强调利用符号进行逻辑推理和表达知识。该学派认为学习是一种逆向演绎的过程,通过已有的

为大模型提供全新科学复杂问答基准与测评体系,UNSW、阿贡、芝加哥大学等多家机构联合推出SciQAG框架

Jul 25, 2024 am 06:42 AM

为大模型提供全新科学复杂问答基准与测评体系,UNSW、阿贡、芝加哥大学等多家机构联合推出SciQAG框架

Jul 25, 2024 am 06:42 AM

编辑|ScienceAI问答(QA)数据集在推动自然语言处理(NLP)研究发挥着至关重要的作用。高质量QA数据集不仅可以用于微调模型,也可以有效评估大语言模型(LLM)的能力,尤其是针对科学知识的理解和推理能力。尽管当前已有许多科学QA数据集,涵盖了医学、化学、生物等领域,但这些数据集仍存在一些不足。其一,数据形式较为单一,大多数为多项选择题(multiple-choicequestions),它们易于进行评估,但限制了模型的答案选择范围,无法充分测试模型的科学问题解答能力。相比之下,开放式问答

SOTA性能,厦大多模态蛋白质-配体亲和力预测AI方法,首次结合分子表面信息

Jul 17, 2024 pm 06:37 PM

SOTA性能,厦大多模态蛋白质-配体亲和力预测AI方法,首次结合分子表面信息

Jul 17, 2024 pm 06:37 PM

编辑|KX在药物研发领域,准确有效地预测蛋白质与配体的结合亲和力对于药物筛选和优化至关重要。然而,目前的研究没有考虑到分子表面信息在蛋白质-配体相互作用中的重要作用。基于此,来自厦门大学的研究人员提出了一种新颖的多模态特征提取(MFE)框架,该框架首次结合了蛋白质表面、3D结构和序列的信息,并使用交叉注意机制进行不同模态之间的特征对齐。实验结果表明,该方法在预测蛋白质-配体结合亲和力方面取得了最先进的性能。此外,消融研究证明了该框架内蛋白质表面信息和多模态特征对齐的有效性和必要性。相关研究以「S

SK 海力士 8 月 6 日将展示 AI 相关新品:12 层 HBM3E、321-high NAND 等

Aug 01, 2024 pm 09:40 PM

SK 海力士 8 月 6 日将展示 AI 相关新品:12 层 HBM3E、321-high NAND 等

Aug 01, 2024 pm 09:40 PM

本站8月1日消息,SK海力士今天(8月1日)发布博文,宣布将出席8月6日至8日,在美国加利福尼亚州圣克拉拉举行的全球半导体存储器峰会FMS2024,展示诸多新一代产品。未来存储器和存储峰会(FutureMemoryandStorage)简介前身是主要面向NAND供应商的闪存峰会(FlashMemorySummit),在人工智能技术日益受到关注的背景下,今年重新命名为未来存储器和存储峰会(FutureMemoryandStorage),以邀请DRAM和存储供应商等更多参与者。新产品SK海力士去年在