从视音角度看多模态学习的过去与未来

视觉和听觉在人类的沟通和场景理解中至关重要。为了模仿人类的感知能力,旨在探索视音模态的视音学习在近些年来已成为一个蓬勃发展的领域。本文是对由中国人民大学高瓴人工智能学院GeWu-Lab联合德克萨斯州大学达拉斯分校以及西北工业大学共同发布的最新视音学习综述《Learning in Audio-visual Context: A Review, Analysis, and New Perspective》的解读。

该综述首先分析了视音模态的认知科学基础,进而对近来的视音学习工作(近三百篇相关文献)进行了系统性的分析总结。最后,为了纵观当前的视音学习领域,该综述从视音场景理解的角度重新回顾了近年的视音学习进展,并探讨了该领域潜在的发展方向。

arXiv链接:https://arxiv.org/abs/2208.09579

项目主页:https://gewu-lab.github.io/audio-visual-learning/

awesome-list链接:https://gewu-lab.github.io/awesome-audiovisual-learning/

1 引言

视觉和听觉信息是人类感知外部世界的主要信息来源。人类的大脑通过整合异质的多模态的信息获得对周遭环境的整体认知。例如,在具有多个说话人的鸡尾酒会场景中,我们能够借助唇形的变化加强接收到的感兴趣的说话人的语音。因此,视音学习对于类人机器感知能力的探索是不可或缺的。相比于其他模态,视音模态的特性使其与众不同:

1)认知基础。作为研究最广泛的两种感官,视觉和听觉的整合遍布在人类的神经系统中。一方面,这两种感官在人类感知中的重要性为基于视音数据的机器感知研究提供了认知基础,另一方面,视觉和听觉在神经系统中的交互与整合能够作为促进视音学习的依据。

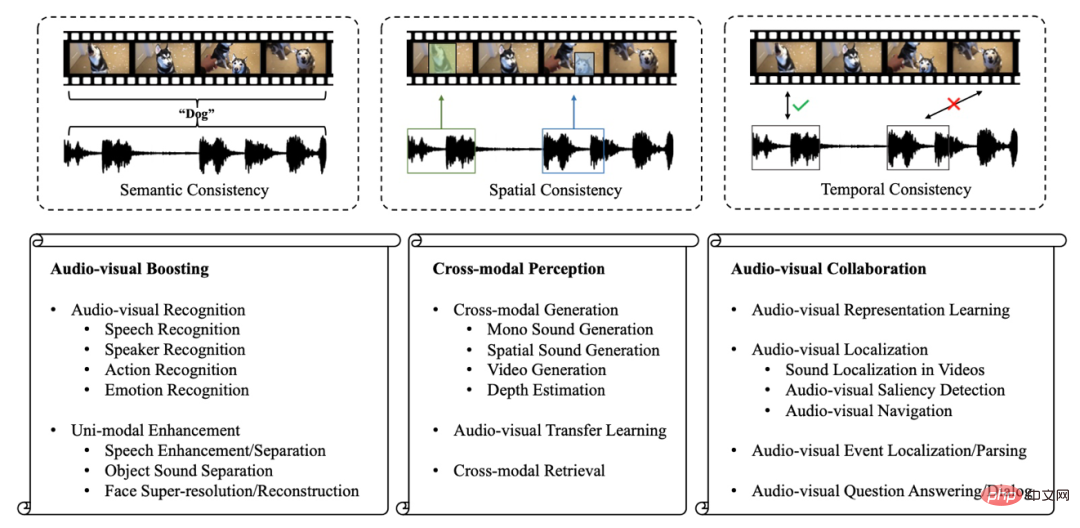

2)多重一致性。在我们的日常生活中,视觉和听觉紧密关联。如图1所示,狗的叫声和它的外表都能让我们与“狗”这一概念联系起来(语义一致性)。同时,我们可以借助听到的声音或视觉来确定狗的确切空间位置(空间一致性)。而当听到狗叫时,我们通常可以同时在视觉上看到狗(时序一致性)。视觉和听觉之间的多重一致性是视音学习的研究基础。

3)丰富的数据支持。移动终端和互联网的快速发展促使越来越多的人在公共平台上分享视频,这使得收集视频的成本降低。这些丰富的公开视频缓解了数据获取的障碍,为视音学习提供了数据支持。

视音模态的这些特点自然而然促使了视音学习领域的诞生。近年来,这一领域已经取得了蓬勃发展,研究者们已经不满足于简单地将额外模态引入原有的单模态任务,开始探索并解决新的问题和挑战。

但是,现有的视音学习工作通常是任务导向的。在这些工作中,他们关注于特定的视音任务。当前仍然缺乏能够系统性回顾和分析视音学习领域发展的综述性工作。因此,该文章对目前的视音学习领域进行了总结,然后进一步展望了其潜在的发展方向。

由于视音学习和人类感知能力之间存在着紧密的联系,该文章首先总结了视觉和听觉模态的的认知基础,进而在此基础上,将现有的视音学习研究分为三类:

1)视音提升(Audio-visual Boosting)。视觉和音频数据各自已经有很长的研究历史和广泛的应用。尽管这些单模态方法已经取得了相当有效的结果,但是他们仅仅利用了所关注事物的部分信息,单模态方法的表现是受限的,并且容易受到单模态噪声的影响。因此,研究者们将额外模态引入这些音频或视觉任务中,不仅通过整合互补信息提升了模型效果,而且促进了模型的鲁棒性。

2)跨模态感知(Cross-modal Perception)。人类听到声音就能联想到相关的画面,看到画面也可以想起与之匹配的声音,这是因为视觉和听觉信息具有一致性。该一致性为机器进行跨模态知识迁移或根据某一模态信息生成对应的另一模态数据提供了基础。因此,很多研究致力于跨模态感知能力的探索,并取得了显著成果。

3)视音协作(Audio-visual Collaboration)。除了融合不同模态的信号之外,在人脑的皮质区域存在更高级的模态间交互,以达到更深层次的场景理解。因此,类人感知能力需要对视音模态的协作进行探索。为了达到这一目标,近年来很多研究提出了更具挑战性的场景理解问题,获得了广泛关注。

图1:视音一致性与视音学习领域概览

视音模态之间涵盖语义,空间和时序的一致性为以上视音研究提供了可行性。因此,本文在总结了近来的视音研究之后,对视音的多重一致性进行了分析。此外,本文从视音场景理解的新视角,再次回顾了视音学习领域的进展。

2 视音认知基础

视觉和听觉是人类场景理解的两个核心感官。这一章节总结了认知神经科学中视觉和听觉感官的神经通路及视音模态的整合,为接下来对视音学习领域研究的讨论奠定基础。

2.1 视觉和听觉的神经通路

视觉是研究最广泛的感官,有些观点甚至认为它主导了人类的感知。相应地,视觉的神经通路也比较复杂。来自物体的反射光包含视觉信息,它激活了视网膜上众多的光感受器(约2.6亿个)。光感受器的输出被送到神经节细胞中(约200万个)。这一过程压缩了视觉信息。而后,经过外侧膝状核细胞的处理,视觉信息最终到达大脑皮层的视觉相关区域。视觉皮层是一个具有功能差异的不同区域的组合,其视觉神经元具有偏好性。例如,V4和V5的神经元分别对颜色和运动敏感。

除了视觉,听觉也是观察周围环境的一个重要感官。它不仅能提醒人类规避风险(例如当听到野兽的叫声时,人类会主动采取行动),也是人们相互交流的基础。声波在耳膜上被转化为神经元信号。然后,听觉信息被输送到脑干的下丘和耳蜗核。经过丘脑内侧膝状核的处理,声音最终在初级听觉皮层被编码。大脑获取听觉信息,然后利用其中蕴含的声音线索,如频率和音色,来确定声源的身份。同时,两只耳朵之间的强度和听觉间的时间差异为声音的位置提供线索,这被称为双耳效应。在实践中,人类的感知可以结合多种感官,尤其是听觉和视觉,这被称为多通道知觉。

2.2 认知神经科学中的视音整合

每种感官都提供关于周围环境的独特信息。尽管多种感官接收的信息是不同的,但由此产生的环境表征是统一的体验,而非互不相干的感觉。

一个代表性的例子是麦格克效应:语义不同的视觉信号和听觉信号得到了单一语义的信息。这些现象表明在人类的感知中,来自多种感官的信号通常被整合。其中,听觉和视觉的神经通路的交叉结合了人类两种重要感官的信息,促进了知觉的敏感性和准确性,例如,与声音有关的视觉信息能够提高听觉空间的搜索效率。

这些结合多种感官信息的感知现象在认知神经科学领域引起了人们的关注。人类的神经系统中一个被充分研究的多通道感知区域是上丘。上丘的许多神经元具有多感官特性,可以被来自视觉、听觉、甚至触觉的信息激活。这种多感官反应往往比单一的反应更强。皮质中的颞上沟是另一个代表性区域。

根据对猴子的研究,它被观察到与多种感官的连接,包括视觉、听觉和体感。更多的大脑区域,包括顶叶、额叶和海马体,都表现出类似的多通道知觉现象。根据对于多通道知觉现象的研究,我们可以观察到几个关键发现:

1)多模态提升。如上所述,许多神经元可以对多种感官的融合信号作出反应,当单一感官的刺激较弱时,这种增强的反应比单模态的反应更可靠。

2)跨模态可塑性。这种现象是指剥夺一种感官能够影响其对应的皮质区域的发展。例如,聋人的听觉相关皮层有可能被视觉刺激所激活。

3)多模态协作。不同感官的信号在皮层区域有更复杂的整合。研究人员发现,大脑皮层存在具有以协作方式整合多感官信息能力的模块,以建立意识和认知。

受人类认知的启发,研究人员已经开始研究如何实现类人的视音感知能力,更多的视音研究在近些年逐渐涌现。

3 视音提升

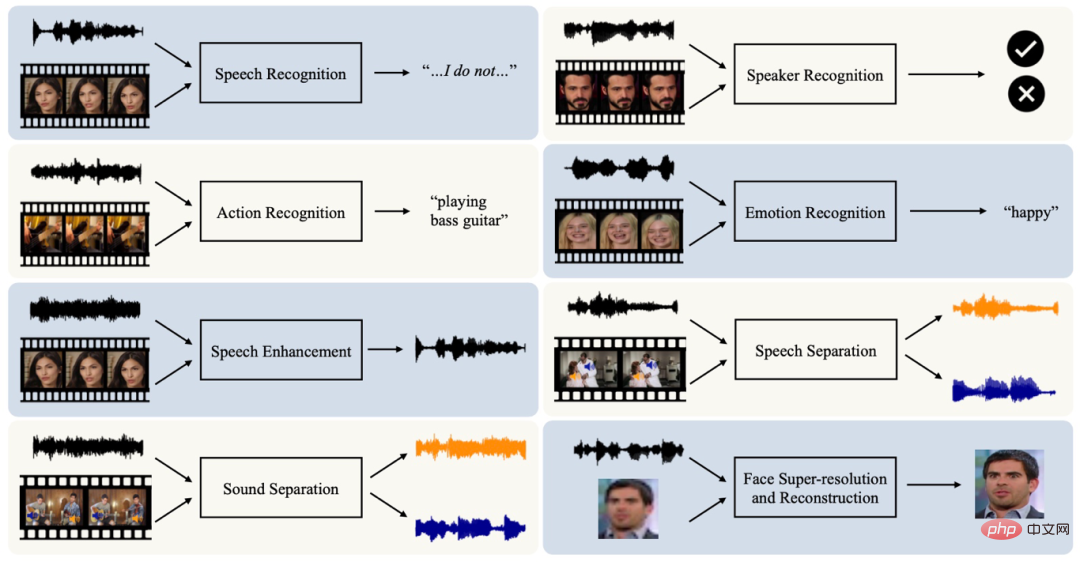

尽管各个模态本身已经有较为充分的可供学习的信息,并且已经存在许多基于单模态数据的任务,但是单模态数据只提供了局部信息,并且对单模态噪声较为敏感(例如,视觉信息受光照,视角等因素影响)。因此,受人类认知中多模态提升现象的启发,一些研究者在原有的单模态任务中引入额外的视觉(或音频)数据,以增进任务表现。我们将相关任务分为识别和增强两大部分。

单模态识别任务在过去已经被广泛研究,例如基于音频的语音识别以及基于视觉的动作识别。但是,单模态数据只观察到了事物的部分信息,并且易受单模态噪声影响。因而,整合多模态数据以促进模型的能力和鲁棒性的视音识别任务在近年来引起了关注,并涵盖了语音识别、说话人识别、动作识别和情感识别等多个方面。

视音模态的一致性不仅为多模态识别任务提供了基础,还使得用借助某一模态增强另一模态信号成为可能。例如,多个说话人在视觉上是分离的,因此说话人的视觉信息可以用于辅助语音分离。此外,音频信息能够为重建被遮盖或缺失的说话人面部信息提供性别、年龄等身份信息。这些现象已经启发研究者借助其他模态的信息进行去噪或增强,例如语音增强,声源分离及面部超分重建。

图2:视音提升任务

4 跨模态感知

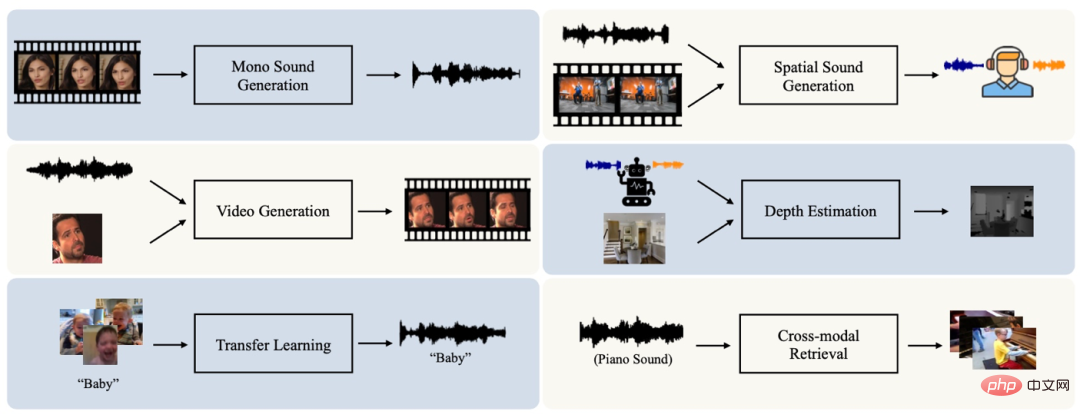

认知神经科学中的跨模态可塑性现象以及视音模态之间的一致性促进了跨模态感知的研究,其目的在于学习并建立音频和视觉模态之间的关联,促使了跨模态生成、迁移和检索等任务的产生。

人类具有在已知模态的指导下预测另一种模态对应的信息的能力。例如,在听不到声音的情况下,只要看到嘴唇运动的视觉信息,我们就能大致推断出这个人在说什么。音频和视觉之间在语义,空间和时序多方面的一致性为机器拥有类人的跨模态生成能力提供了可能。跨模态生成任务目前已经涵盖了包括单通道音频生成、立体声生成、视频/图像生成以及深度估计在内的多个方面。

除跨模态生成以外,视音之间在语义上的一致性表明,一种模态的学习有望得到来自另一模态的语义信息的帮助。这也是视音迁移任务的目标。另外,视音的语义一致性也促进了跨模态信息检索任务发展。

图3:跨模态感知相关任务

5 视音协作

人脑会对接收到的场景的视听信息进行整合,使之相互协作、互为补充,从而提升对场景的理解能力。因此,机器有必要通过探索视听协作来追求类似人类的感知,而不仅仅是融合或预测多模态信息。为了这一目标,研究者们在视音学习领域引入了包括视音成分分析和视音推理在内的多种新的挑战。

在进行视音协作之初,如何在没有人类注释的情况下有效地从视音模态中提取表征,是一个重要的课题。这是因为高质量的表征可以为各种下游任务做出贡献。对于视听数据来说,它们之间在语义,空间以及时序上的一致性,为以自监督方式学习视音表征提供了天然的信号。

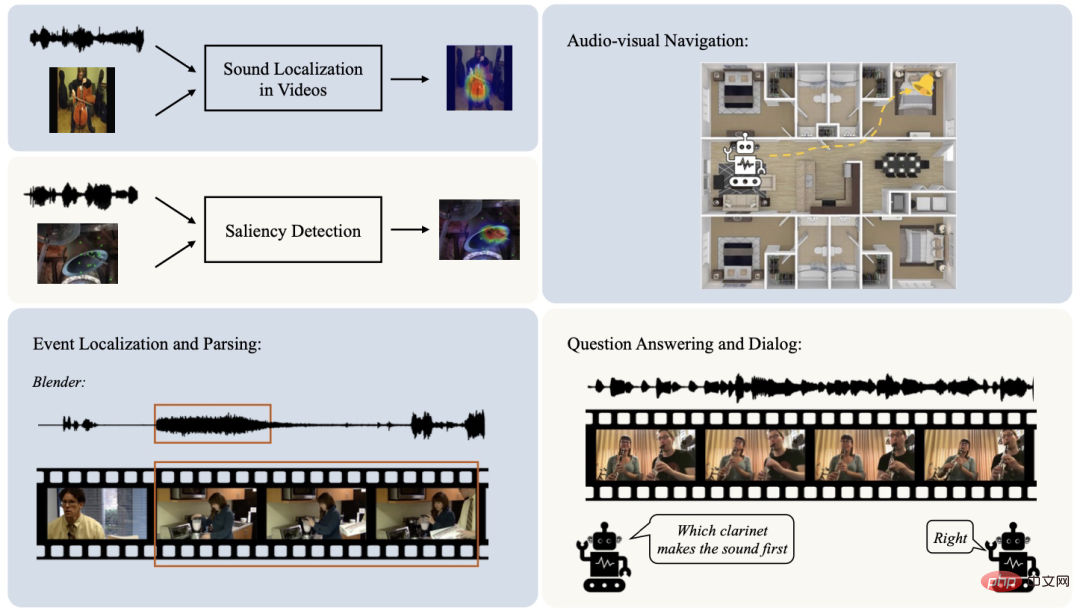

除了表征学习外,视音模态之间的协作主要聚焦在场景理解方面。一些研究者聚焦于对场景中视音成分的解析与定位,包括声源定位,视音显著性检测,视音导航等。这类任务建立了细粒度的视音模态之间的联系。

除此之外,在许多视音任务中,我们往往假定整个视频中的视音内容在时间上一直是匹配的,也就是说,在视频的每个时刻,画面和声音均具有一致性。但实际上,这一假设并非能够时刻成立。例如,在“打篮球”的样本中,摄像机有时会拍摄观众席等和“打篮球”这一标签无关的场景。因此,视音事件定位与解析这一类任务被提出以在时序上进一步对场景中的视音成分进行剥离。

人类在视音场景中能够在感知之外进一步进行推断。虽然以上的视音协作任务逐步达到了对视音场景细粒度的理解,却并未进行对视音成分的进行推理分析。近来,随着视音学习领域的发展,一些研究者开始进一步关注视音推理,例如视音问答和对话任务。这些任务旨在通过对视音场景进行跨模态时空推理,回答与场景有关的问题,或者就所观察到的视音场景生成对话。

图4:视音协作相关任务

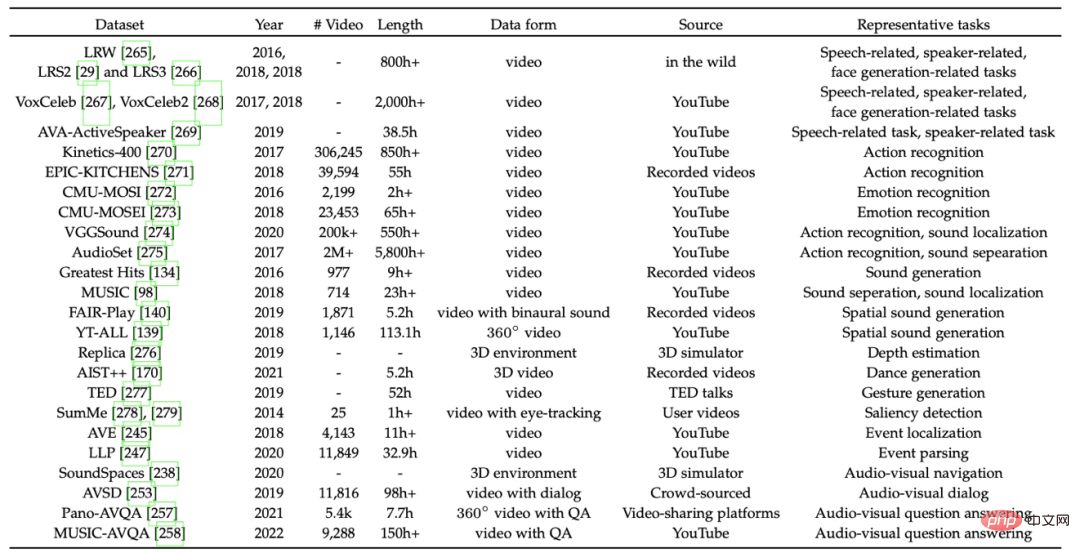

6 代表性数据集

本部分梳理讨论了视音学习领域的一些具有代表性的数据集。

7 趋势和新视角

7.1 语义,空间和时序一致性

尽管视音模态具有异质的数据形式,它们的内在一致性涵盖了语义,空间和时序多个方面,为视音研究奠定了基础。

首先,视觉和音频模态从不同的角度描绘了所关注的事物。因此,视音数据的语义被认为是语义一致的。在视音学习中,语义一致性在大多数任务中起着重要作用。例如,这种一致性使得结合视音信息以获得更好的视音识别和单模态增强效果成为可能。此外,视音模态之间的语义一致性在跨模态检索和迁移学习中也起着重要作用。

其次,视觉和音频都可以帮助确定发声对象的确切空间位置。这种空间上的对应关系也有广泛的应用。例如,在声源定位任务中,这种一致性被用来在输入音频的指导下确定发声物体的视觉位置。在立体声情况下,能够基于双耳音频估计视觉深度信息或利用视觉信息为辅助生成立体声音频。

最后,视觉内容和其产生的声音通常在时序上是一致的。这种一致性在大多数视音学习研究中也被广泛利用,比如在视音识别或生成任务中融合或预测多模态信息。

在实践中,这些不同的视音一致性不是孤立的,而是经常共同出现在视音场景中。因此,它们往往在相关任务中被共同利用。语义和时序一致性的结合是最常见的情况。

在简单场景下,处于相同时间戳的视音片段被认为在语义和时序上都是一致的。然而,这种较强的假设可能会失败,例如,视频画面和同一时间戳的背景音并非语义一致。这些假阳性对训练带来了干扰。

最近,研究人员已经开始关注这些情况以提高场景理解的质量。此外,语义和空间一致性的结合也很常见。例如,视频中声源定位的成功依赖于语义一致性以根据输入的声音探索对应的视觉上的空间位置。此外,在视音导航任务的早期阶段,发声目标会产生一个稳定的重复的声音。虽然空间一致性得到了满足,但视觉和音频中的语义内容是不相关的。随后,声音和发声位置的语义一致性被引入,以提高视音导航的质量。

总的来说,视音模态的语义,空间以及时序上的一致性足为视音学习的研究提供了坚实的支撑。对这些一致性的分析和利用不仅提高了现有视音任务的性能,并且有助于更好地理解视音场景。

7.2 关于场景理解的新视角

本文总结了视音模态的认知基础,并分析了人类的多通道感知的现象,在此基础上,将目前的视音学习研究分为三类:视音提升(Audio-visual Boosting)、跨模态感知(Cross-modal Perception)和视音协作(Audio-visual Collaboration)。为了从更宏观的角度回顾目前视音学习领域的发展,文章进一步提出了关于视音场景理解的新视角:

1)基础场景理解(Basic Scene Understanding)。视音提升和跨模态感知的任务通常侧重于融合或预测一致的视音信息。这些任务的核心是对视音场景的基础理解(例如,对输入视频的进行动作分类。)或对跨模态信息进行预测(例如,基于无声视频生成对应的音频。) 然而,自然场景中的视频通常包含多种多样的视音成分,超出了这些基础场景理解任务的范畴。

2)细粒度场景理解(Fine-grained Scene Understanding)。如上所述,视音场景通常具有丰富的不同模态的成分。因此,研究者们提出了一些剥离目标成分的任务。例如,声源定位任务旨在标记出视觉中的目标发声物体所在的区域。视音事件定位与解析任务则在时序上确定目标可听事件或可见事件。这些任务将视音成分剥离出来,对视音场景进行解耦,与上一阶段相比,对场景有更细粒度的理解。

3)因果交互场景理解(Causal Scene Understanding)。 在视音场景中,人类不仅能感知周围感兴趣的事物,还能推断出它们之间的交互。这一阶段场景理解的目标更接近于追求类人感知。目前,只有很少的任务在这一阶段进行探索。视音问答和对话任务是代表性的工作。这些任务试图探索视频中视音成分的关联,并进行时空推理。

总的来说,对这三个阶段的探索是不平衡的。从基础场景理解到因果交互场景理解,相关研究的多样性和丰富性逐渐降低,特别是因果交互场景理解仍然处于起步阶段。这暗示了视音学习存在的一些潜在发展方向:

1)任务整合。视音领域的大多数研究是任务导向的。这些单独的任务只模拟和学习视音场景的特定方面。然而,视音场景的理解和感知并不是孤立的。例如,声源定位任务强调视觉中与声音相关的对象,而事件定位和解析任务则在时序上确定目标事件。这两个任务有望被整合以促进对视音场景的精细化理解。多个视音学习任务的整合是在未来值得探索的方向。

2)更深入的因果交互场景理解。目前,对涉及推理的场景理解的研究的多样性仍然有限。现有的任务,包括视音问答和对话,大多集中在基于视频中的事件进行对话。更深入的推理类型,如根据预览的场景预测接下来可能发生的音频或视觉事件,值得在未来进一步研究。

为了更好地呈现文章内容,该综述同时配备了持续更新的项目主页,以图片、视频等更多形式展示了不同视音任务的目标与发展,供读者快速了解视音学习领域。

以上是从视音角度看多模态学习的过去与未来的详细内容。更多信息请关注PHP中文网其他相关文章!

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

Video Face Swap

使用我们完全免费的人工智能换脸工具轻松在任何视频中换脸!

热门文章

热工具

记事本++7.3.1

好用且免费的代码编辑器

SublimeText3汉化版

中文版,非常好用

禅工作室 13.0.1

功能强大的PHP集成开发环境

Dreamweaver CS6

视觉化网页开发工具

SublimeText3 Mac版

神级代码编辑软件(SublimeText3)

学会彻底卸载pip,使用Python更加高效

Jan 16, 2024 am 09:01 AM

学会彻底卸载pip,使用Python更加高效

Jan 16, 2024 am 09:01 AM

不再需要pip?快来学习如何有效卸载pip!引言:pip是Python的包管理工具之一,它可以方便地安装、升级和卸载Python包。然而,有时候我们可能需要卸载pip,可能是因为我们希望使用其他的包管理工具,或者因为我们需要完全清除Python环境。本文将介绍如何有效地卸载pip,并提供具体的代码示例。一、卸载pip的方法下面将介绍两种常见的卸载pip的方法

深入研究matplotlib的色彩映射表

Jan 09, 2024 pm 03:51 PM

深入研究matplotlib的色彩映射表

Jan 09, 2024 pm 03:51 PM

深入学习matplotlib颜色表,需要具体代码示例一、引言matplotlib是一个功能强大的Python绘图库,它提供了丰富的绘图函数和工具,可以用于创建各种类型的图表。而颜色表(colormap)是matplotlib中一个重要的概念,它决定了图表的配色方案。深入学习matplotlib颜色表,将帮助我们更好地掌握matplotlib的绘图功能,使绘

Pygame入门指南:全面安装和配置教程

Feb 19, 2024 pm 10:10 PM

Pygame入门指南:全面安装和配置教程

Feb 19, 2024 pm 10:10 PM

从零开始学习Pygame:完整的安装和配置教程,需要具体代码示例引言:Pygame是一个使用Python编程语言开发的开源游戏开发库,它提供了丰富的功能和工具,使得开发者可以轻松创建各种类型的游戏。本文将带您从零开始学习Pygame,并提供完整的安装和配置教程,以及具体的代码示例,让您快速入门。第一部分:安装Python和Pygame首先,确保您的计算机上已

一起学习word根号输入办法

Mar 19, 2024 pm 08:52 PM

一起学习word根号输入办法

Mar 19, 2024 pm 08:52 PM

在word中编辑文字内容时,有时会需要输入公式符号。有的小伙们不知道在word根号输入的方法,小面就让小编跟小伙伴们一起分享下word根号输入的方法教程。希望对小伙伴们有所帮助。首先,打开电脑上的Word软件,然后打开要编辑的文件,并将光标移动到需要插入根号的位置,参考下方的图片示例。2.选择【插入】,再选择符号里的【公式】。如下方的图片红色圈中部分内容所示:3.接着选择下方的【插入新公式】。如下方的图片红色圈中部分内容所示:4.选择【根式】,再选择合适的根号。如下方的图片红色圈中部分内容所示:

揭秘C语言的吸引力: 发掘程序员的潜质

Feb 24, 2024 pm 11:21 PM

揭秘C语言的吸引力: 发掘程序员的潜质

Feb 24, 2024 pm 11:21 PM

学习C语言的魅力:解锁程序员的潜力随着科技的不断发展,计算机编程已经成为了一个备受关注的领域。在众多编程语言中,C语言一直以来都备受程序员的喜爱。它的简单、高效以及广泛应用的特点,使得学习C语言成为了许多人进入编程领域的第一步。本文将讨论学习C语言的魅力,以及如何通过学习C语言来解锁程序员的潜力。首先,学习C语言的魅力在于其简洁性。相比其他编程语言而言,C语

从零开始学习Go语言中的main函数

Mar 27, 2024 pm 05:03 PM

从零开始学习Go语言中的main函数

Mar 27, 2024 pm 05:03 PM

标题:从零开始学习Go语言中的main函数Go语言作为一种简洁、高效的编程语言,备受开发者青睐。在Go语言中,main函数是一个入口函数,每个Go程序都必须包含main函数作为程序的入口点。本文将从零开始介绍如何学习Go语言中的main函数,并提供具体的代码示例。一、首先,我们需要安装Go语言的开发环境。可以前往官方网站(https://golang.org

学习Go语言文档中的strconv.Atoi函数实现字符串转整数

Nov 03, 2023 am 08:55 AM

学习Go语言文档中的strconv.Atoi函数实现字符串转整数

Nov 03, 2023 am 08:55 AM

学习Go语言文档中的strconv.Atoi函数实现字符串转整数Go语言是一门强大而灵活的编程语言,其标准库中的strconv包提供了字符串转换的功能。在这篇文章中,我们将学习如何使用strconv.Atoi函数将字符串转换为整数。首先,我们需要了解strconv.Atoi函数的用途和声明。文档中对函数的描述如下:funcAtoi(sstring)(i

快速学会pip安装,从零开始掌握技巧

Jan 16, 2024 am 10:30 AM

快速学会pip安装,从零开始掌握技巧

Jan 16, 2024 am 10:30 AM

从零开始学习pip安装,快速掌握技巧,需要具体代码示例概述:pip是Python包管理工具,能够方便地安装、升级和管理Python包。对于Python开发者来说,掌握pip的使用技巧是非常重要的。本文将从零开始介绍pip的安装方法,并给出一些实用的技巧和具体的代码示例,帮助读者快速掌握pip的使用。一、安装pip在使用pip之前,首先需要安装pip。pip的