这是Meta版ChatGPT雏形?开源、一块GPU就能跑,1/10参数量打败GPT-3

千亿、万亿参数的超大模型需要有人研究,十亿、百亿参数的大模型同样需要。

刚刚,Meta 首席 AI 科学家 Yann LeCun 宣布,他们「开源」了一个新的大模型系列 ——LLaMA(Large Language Model Meta AI),参数量从 70 亿到 650 亿不等。这些模型的性能非常优异:具有 130 亿参数的 LLaMA 模型「在大多数基准上」可以胜过 GPT-3( 参数量达 1750 亿),而且可以在单块 V100 GPU 上运行;而最大的 650 亿参数的 LLaMA 模型可以媲美谷歌的 Chinchilla-70B 和 PaLM-540B。

众所周知,参数是机器学习模型用来根据输入数据进行预测或分类的变量。语言模型中的参数数量是影响其性能的关键因素,较大的模型通常能够处理更复杂的任务并产生更连贯的输出,这被 Richard Sutton 称为「苦涩的教训」。在过去的几年里,各大科技巨头围绕千亿、万亿参数量的大模型展开了军备竞赛,大大提高了 AI 模型的性能。

但是,这种比拼「钞能力」的研究竞赛对于不在科技巨头工作的普通研究者来说并不友好,阻碍了他们对于大模型运行原理、潜在问题解决方案等问题的研究。而且,在实际应用中,更多的参数会占用更多的空间,并且需要更多的计算资源来运行,导致大模型应用成本居高不下。因此,如果一个模型可以用更少的参数获得与另一个模型相同的结果,则表示效率显著提高。这对于普通研究者来说非常友好,模型在现实环境中部署也会更容易。这便是 Meta 这项研究的意义所在。

「我现在认为,在一两年内,我们将在自己的(顶级)手机和笔记本电脑上运行具有 ChatGPT 相当一部分能力的语言模型,」独立人工智能研究员 Simon Willison 在分析 Meta 新 AI 模型的影响时写道。

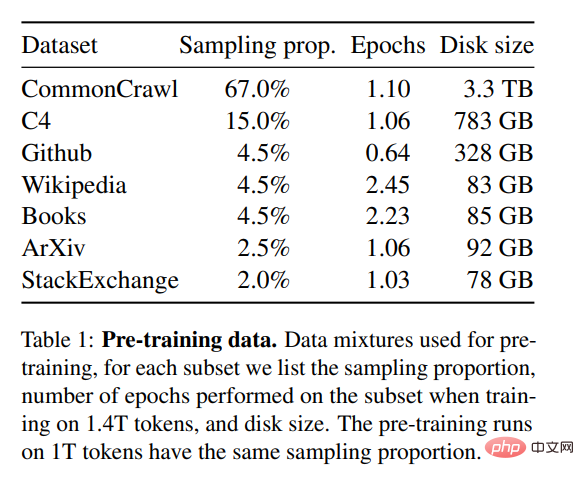

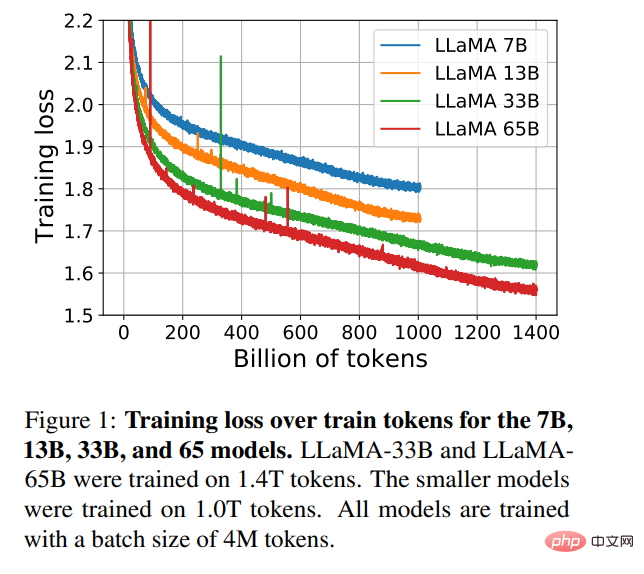

为了训练该模型,同时满足开源和可复现等要求,Meta 只用了公开可用的数据集,这点不同于大多数依赖于非公开数据的大模型。那些模型往往是不开源的,属于大型科技巨头私有资产。为了提高模型性能,Meta 在更多的 token 上进行了训练:在 1.4 万亿 token 上训练了 LLaMA 65B 和 LLaMA 33B,最小的 LLaMA 7B 也用到了 1 万亿 token。

在推特上,LeCun 还展示了 LLaMA 模型续写文本的一些结果。模型被要求续写:「你知道 Yann LeCun 去年发行了一张说唱专辑吗?我们听了一下,我们的想法是这样的:____ 」

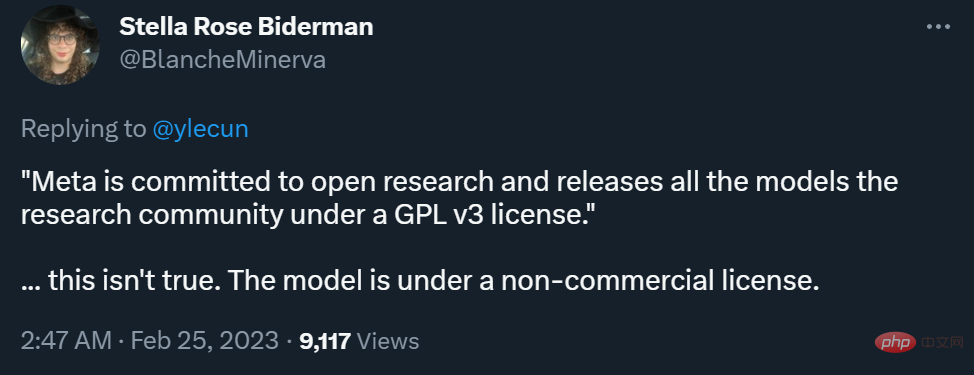

不过,在能否商用方面,Meta 博客和 LeCun 推特表述的差异引发了一些争议。

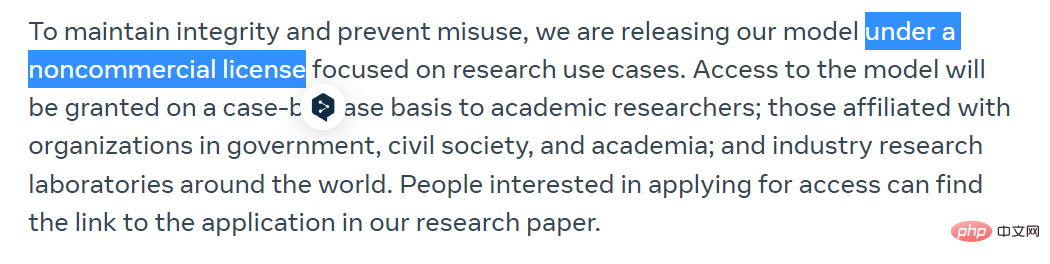

Meta 在博客中表示,为了保持完整性和防止滥用,他们将在非商业许可下发布他们的模型,重点是研究用例。该模型的访问权将被逐一授予学术研究人员,那些隶属于政府、民间团体和学术界的组织,以及全世界的工业研究实验室。感兴趣的人可以在以下链接中申请:

https://docs.google.com/forms/d/e/1FAIpQLSfqNECQnMkycAp2jP4Z9TFX0cGR4uf7b_fBxjY_OjhJILlKGA/viewform

而 LeCun 则表示,Meta 致力于开放研究,在 GPL v3 许可下向研究界发布所有模型(GPL v3 允许商用)。

这一表述是颇具争议的,因为他没有说清楚这里的「模型」指的是代码还是权重,或者二者均有。在不少研究者看来,模型权重比代码重要得多。

对此,LeCun 解释说,在 GPL v3 许可下开放的是模型代码。

有人认为,这种程度的开放还算不上真正的「AI 民主化」。

目前,Meta 已经把论文上传了 arXiv,GitHub 库中也已经上传了一些内容,大家可以前去浏览。

- 论文链接:https://research.facebook.com/publications/llama-open-and-efficient-foundation-language-models/

- GitHub 链接:https://github.com/facebookresearch/llama

研究概览

在大规模的文本语料库中训练的大型语言模型(LLMs)已经显示出它们有能力从文本 prompt 或少数样本中执行新的任务。在将模型扩展到足够大的规模时,这些少样本特性首次出现,从而催生了专注于进一步扩展这些模型的工作系列。

这些努力都是基于一个假设:更多的参数会带来更好的性能。然而,Hoffmann et al. (2022) 最近的工作表明,在给定的计算预算下,最好的性能不是由最大的模型实现的,而是由在更多的数据上训练的小模型实现的。

Hoffmann et al. (2022) 提出的 scaling laws 的目标是确定在特定的训练计算预算下,如何最好地缩放数据集和模型大小。然而,这个目标忽略了推理预算,而推理预算在大规模服务语言模型时变得至关重要。在这种情况下,可以给定一个目标性能水平,首选的模型不是训练速度最快的,而是推理速度最快的。尽管训练一个大的模型以达到一定的性能水平可能更便宜,但一个训练时间较长的小模型最终在推理方面会更便宜。例如,尽管 Hoffmann et al. (2022) 建议在 200B 的 tokens 上训练一个 10B 的模型,但研究者发现 7B 的模型的性能甚至在 1T 的 tokens 之后还能继续提高。

这项工作的重点是训练一系列语言模型,通过在比通常使用的更多的 token 上进行训练,在各种推理预算下达到最佳性能。由此产生的模型被称为 LLaMA,其参数范围从 7B 到 65B,与现有的最佳 LLM 相比,这一模型的性能具有竞争力。例如,尽管 LLaMA-13B 比 GPT-3 小 10 倍,但在大多数基准测试中都优于 GPT-3。

研究者表示,这个模型将有助于 LLM 的民主化研究,因为它可以在单个 GPU 上运行。在更高的规模上,LLaMA-65B 参数模型也能与最好的大型语言模型(如 Chinchilla 或 PaLM-540B)相媲美。

与 Chinchilla、PaLM 或 GPT-3 不同,该模型只使用公开可用的数据,使得这项工作与开源兼容,而大多数现有模型依赖的数据要么不公开可用、要么没有记录(例如 Books-2TB 或社交媒体对话)。当然也存在一些例外,特别是 OPT (Zhang et al., 2022), GPT-NeoX (Black et al., 2022), BLOOM (Scao et al., 2022) 和 GLM (Zeng et al., 2022), 但没有一个能与 PaLM-62B 或 Chinchilla 竞争。

本文的其余部分概述了研究者对 transformer 架构的修改以及训练方法。然后介绍了模型性能,并在一组标准基准上与其他大型语言模型进行了比较。最后,研究者使用了负责任的人工智能社区的一些最新基准,展示了模型中的偏见和毒性。

方法概述

研究者使用的训练方法与 (Brown et al., 2020)、(Chowdhery et al., 2022) 等此前工作中描述的方法相似,并受到 Chinchilla scaling laws (Hoffmann et al., 2022) 的启发。研究者使用了一个标准的优化器在大量的文本数据上训练大型 transformer。

预训练数据

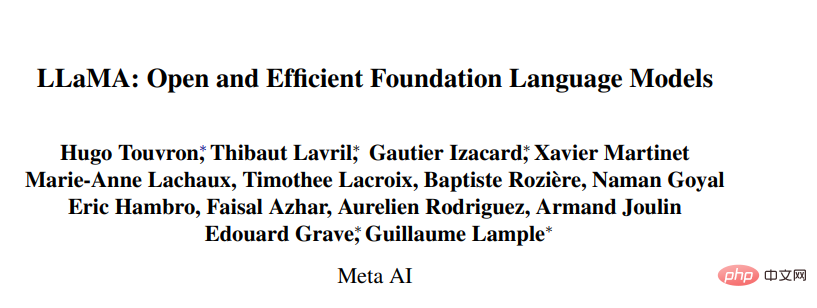

如表 1 所示,这项研究的训练数据集是几个来源的混合物,涵盖了不同的领域。在大多数情况下,研究者重新使用了已经被用来训练其他大型语言模型的数据源,但此处的限制是只能使用公开可用的数据,并与开放资源兼容。数据的混合情况以及它们在训练集中所占的百分比如下:

- 英语 CommonCrawl [67%];

- C4 [15%];

- Github [4.5%];

- 维基百科 [4.5%];

- Gutenberg 和 Books3 [4.5%];

- ArXiv [2.5%] ;

- Stack Exchange [2%]。

整个训练数据集在 token 化之后大约包含 1.4T 的 token。对于大多数训练数据,每个 token 在训练期间只使用一次,但维基百科和 Books 域除外,我们在这两个域上执行大约两个 epoch。

架构

基于最近关于大型语言模型的工作,这项研究同样使用了 transformer 架构。研究者借鉴了随后提出并在不同的模型中使用的各种改进,比如 PaLM。在论文中,研究者介绍了其与原始架构的主要区别:

- 预归一化 [GPT3]。为了提高训练的稳定性,研究者对每个 transformer 子层的输入进行归一化,而不是对输出进行归一化。他们使用了 Zhang and Sennrich (2019) 提出的 RMSNorm 归一化函数。

- SwiGLU 激活函数 [PaLM]。研究者用了 Shazeer (2020) 提出的 SwiGLU 激活函数取代了 ReLU 非线性以提高性能。他们分别使用 2D、3D、4D 的维度,而不是 PaLM 中的 4D。

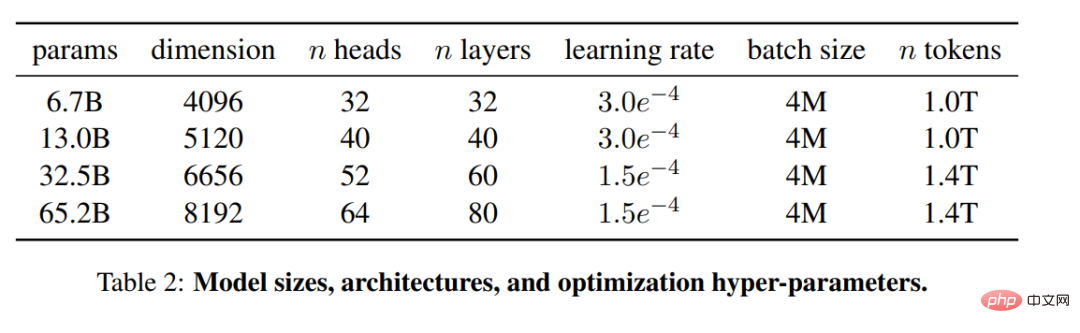

- 旋转嵌入 [GPTNeo]。研究者删除了绝对位置嵌入,在网络的每一层增加了 Su et al. (2021) 提出的旋转位置嵌入(RoPE)。不同模型的超参数细节可见表 2。

实验结果

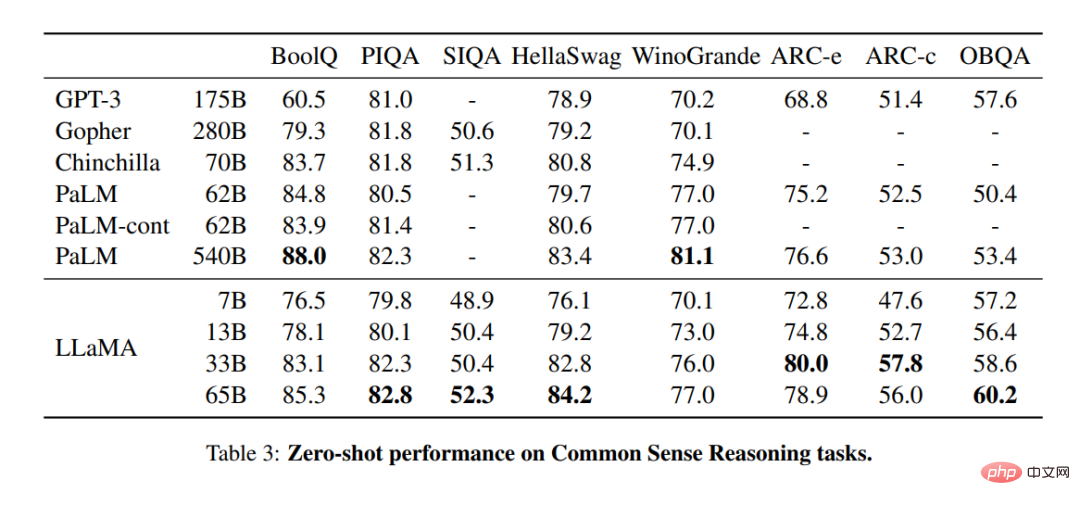

常识性推理

在表 3 中,研究者与现有的各种规模的模型进行比较,并报告了相应论文中的数字。首先,LLaMA-65B 在所有报告的基准上都超过了 Chinchilla-70B,除了 BoolQ。同样,除了在 BoolQ 和 WinoGrande 上,这个模型在任何方面都超过了 PaLM540B。LLaMA-13B 模型在大多数基准上也超过了 GPT-3,尽管其体积小了 10 倍。

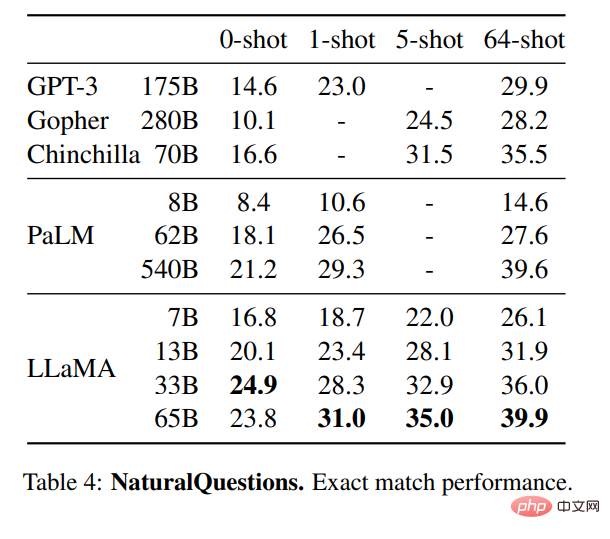

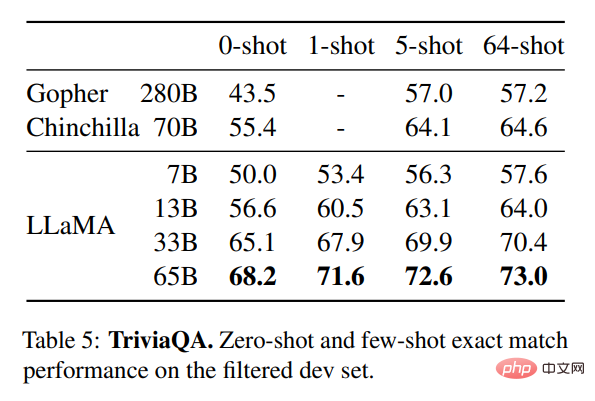

闭卷答题

表 4 展示了 NaturalQuestions 的性能,表 5 展示了 TriviaQA 的性能。在这两项基准测试中,LLaMA-65B 在零样本和少样本设置中都达到了最先进的性能。更重要的是,尽管 LLaMA-13B 是 GPT-3 和 Chinchilla 的五分之一到十分之一,但在这些基准测试中也同样备竞争力。该模型的推理过程是在单个 V100 GPU 上运行的。

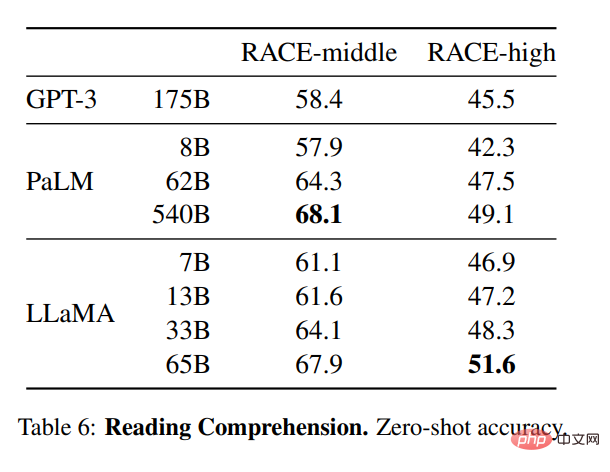

阅读理解

研究者还在 RACE 阅读理解基准 (Lai et al., 2017) 上评估了模型。此处遵循 Brown et al. (2020) 的评估设置,表 6 展示了评估结果。在这些基准上,LLaMA-65B 与 PaLM-540B 具有竞争力,而且,LLaMA-13B 比 GPT-3 还高出几个百分点。

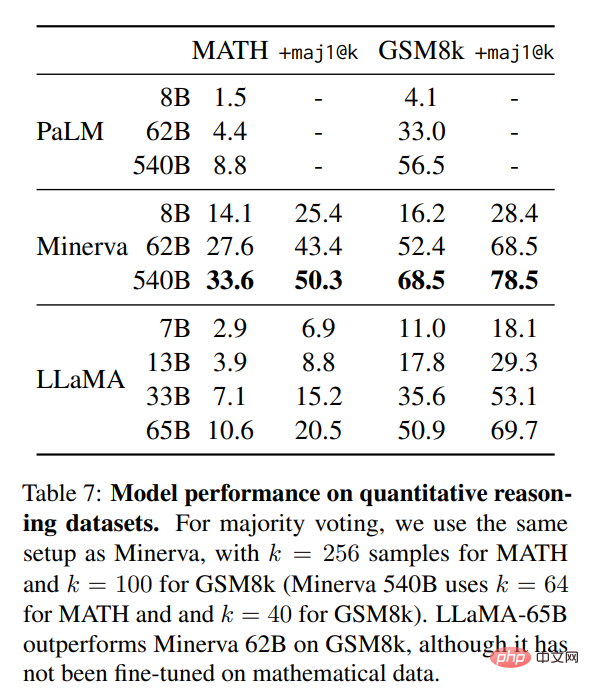

数学推理

在表 7 中,研究者将其与 PaLM 和 Minerva (Lewkowycz et al., 2022) 进行了对比。在 GSM8k 上,他们观察到 LLaMA65B 优于 Minerva-62B,尽管它没有在数学数据上进行过微调。

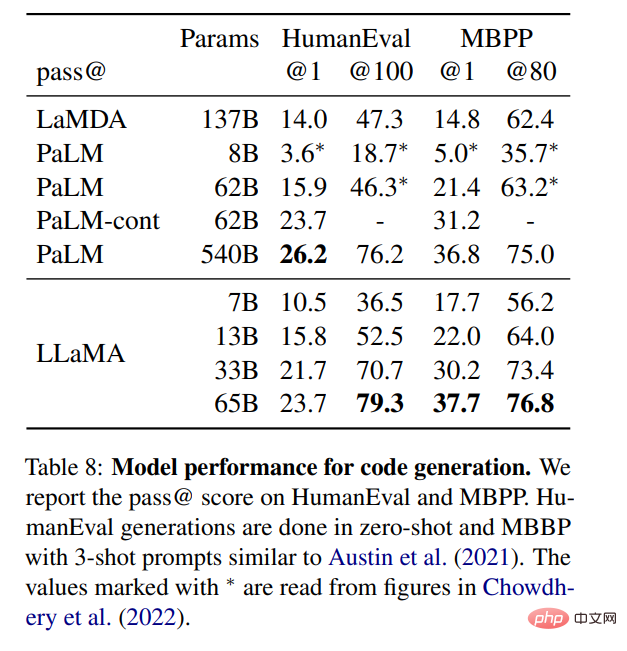

代码生成

如表 8 所示,对于类似的参数数量,LLaMA 的表现是优于其他一般模型的,如 LaMDA 和 PaLM,这些模型没有经过专门的代码训练或微调。在 HumanEval 和 MBPP 上,13B 以上参数的 LLaMA 超过了 LaMDA 137B。LLaMA 65B 也优于 PaLM 62B,即使它的训练时间更长。

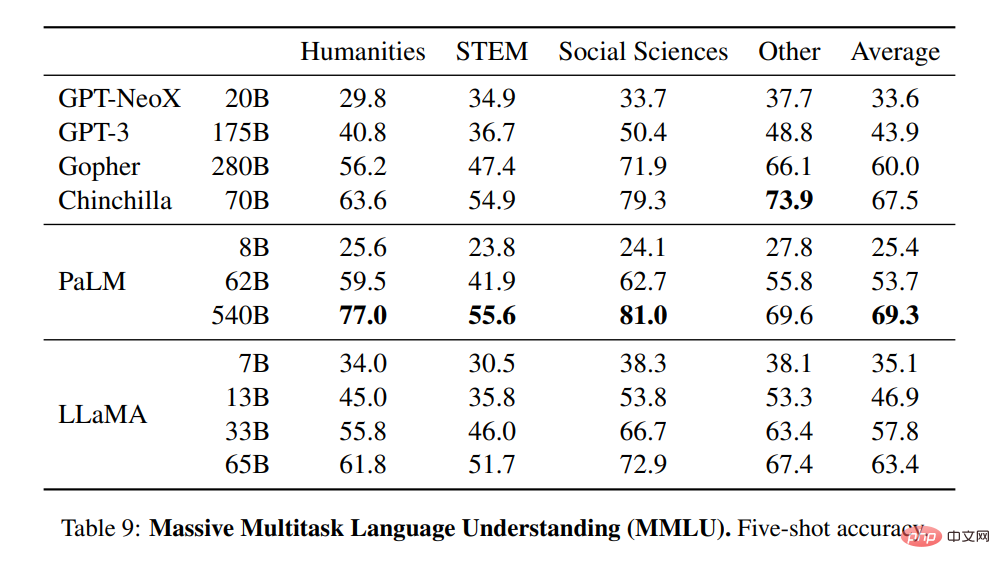

大规模多任务语言理解

研究者使用基准所提供的例子,在 5-shot 的情况下评估模型,并在表 9 中展示了结果。在这个基准上,他们观察到 LLaMA-65B 在大多数领域都落后于 Chinchilla70B 和 PaLM-540B 平均几个百分点。一个潜在的解释是,研究者在预训练数据中使用了数量有限的书籍和学术论文,即 ArXiv、Gutenberg 和 Books3,总和只有 177GB,而这些模型是在高达 2TB 的书籍上训练的。Gopher、Chinchilla 和 PaLM 所使用的大量书籍也可以解释为什么 Gopher 在这个基准上的表现优于 GPT-3,而在其他基准上却不相上下。

训练期间的性能变化

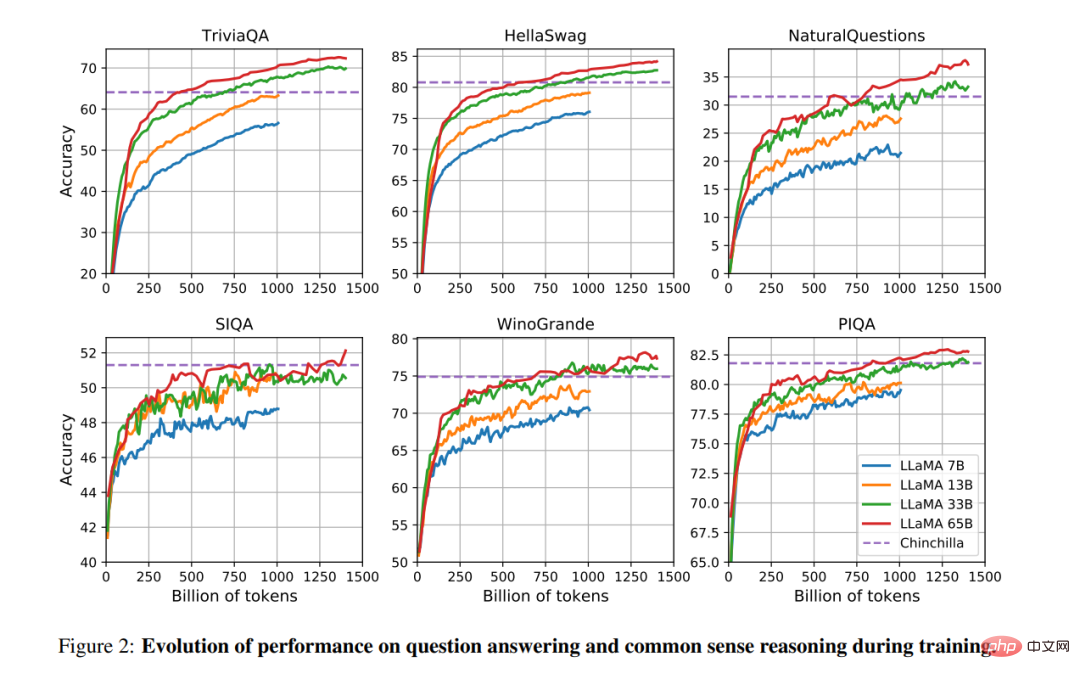

在训练期间,研究者跟踪了 LLaMA 模型在一些问题回答和常识性基准上的表现,结果如图 2 所示。在大多数基准上,性能稳步提高,并与模型的训练困惑度呈正相关(见图 1)。

以上是这是Meta版ChatGPT雏形?开源、一块GPU就能跑,1/10参数量打败GPT-3的详细内容。更多信息请关注PHP中文网其他相关文章!

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

AI Hentai Generator

免费生成ai无尽的。

热门文章

热工具

记事本++7.3.1

好用且免费的代码编辑器

SublimeText3汉化版

中文版,非常好用

禅工作室 13.0.1

功能强大的PHP集成开发环境

Dreamweaver CS6

视觉化网页开发工具

SublimeText3 Mac版

神级代码编辑软件(SublimeText3)

热门话题

mysql安装后怎么使用

Apr 08, 2025 am 11:48 AM

mysql安装后怎么使用

Apr 08, 2025 am 11:48 AM

文章介绍了MySQL数据库的上手操作。首先,需安装MySQL客户端,如MySQLWorkbench或命令行客户端。1.使用mysql-uroot-p命令连接服务器,并使用root账户密码登录;2.使用CREATEDATABASE创建数据库,USE选择数据库;3.使用CREATETABLE创建表,定义字段及数据类型;4.使用INSERTINTO插入数据,SELECT查询数据,UPDATE更新数据,DELETE删除数据。熟练掌握这些步骤,并学习处理常见问题和优化数据库性能,才能高效使用MySQL。

如何设置Vue Axios的超时时间

Apr 07, 2025 pm 10:03 PM

如何设置Vue Axios的超时时间

Apr 07, 2025 pm 10:03 PM

为了设置 Vue Axios 的超时时间,我们可以创建 Axios 实例并指定超时选项:在全局设置中:Vue.prototype.$axios = axios.create({ timeout: 5000 });在单个请求中:this.$axios.get('/api/users', { timeout: 10000 })。

mysql 无法启动怎么解决

Apr 08, 2025 pm 02:21 PM

mysql 无法启动怎么解决

Apr 08, 2025 pm 02:21 PM

MySQL启动失败的原因有多种,可以通过检查错误日志进行诊断。常见原因包括端口冲突(检查端口占用情况并修改配置)、权限问题(检查服务运行用户权限)、配置文件错误(检查参数设置)、数据目录损坏(恢复数据或重建表空间)、InnoDB表空间问题(检查ibdata1文件)、插件加载失败(检查错误日志)。解决问题时应根据错误日志进行分析,找到问题的根源,并养成定期备份数据的习惯,以预防和解决问题。

Laravel的地理空间:互动图和大量数据的优化

Apr 08, 2025 pm 12:24 PM

Laravel的地理空间:互动图和大量数据的优化

Apr 08, 2025 pm 12:24 PM

利用地理空间技术高效处理700万条记录并创建交互式地图本文探讨如何使用Laravel和MySQL高效处理超过700万条记录,并将其转换为可交互的地图可视化。初始挑战项目需求:利用MySQL数据库中700万条记录,提取有价值的见解。许多人首先考虑编程语言,却忽略了数据库本身:它能否满足需求?是否需要数据迁移或结构调整?MySQL能否承受如此大的数据负载?初步分析:需要确定关键过滤器和属性。经过分析,发现仅少数属性与解决方案相关。我们验证了过滤器的可行性,并设置了一些限制来优化搜索。地图搜索基于城

偏远的高级后端工程师(平台)需要圈子

Apr 08, 2025 pm 12:27 PM

偏远的高级后端工程师(平台)需要圈子

Apr 08, 2025 pm 12:27 PM

远程高级后端工程师职位空缺公司:Circle地点:远程办公职位类型:全职薪资:$130,000-$140,000美元职位描述参与Circle移动应用和公共API相关功能的研究和开发,涵盖整个软件开发生命周期。主要职责独立完成基于RubyonRails的开发工作,并与React/Redux/Relay前端团队协作。为Web应用构建核心功能和改进,并在整个功能设计过程中与设计师和领导层紧密合作。推动积极的开发流程,并确定迭代速度的优先级。要求6年以上复杂Web应用后端

mysql安装后怎么优化数据库性能

Apr 08, 2025 am 11:36 AM

mysql安装后怎么优化数据库性能

Apr 08, 2025 am 11:36 AM

MySQL性能优化需从安装配置、索引及查询优化、监控与调优三个方面入手。1.安装后需根据服务器配置调整my.cnf文件,例如innodb_buffer_pool_size参数,并关闭query_cache_size;2.创建合适的索引,避免索引过多,并优化查询语句,例如使用EXPLAIN命令分析执行计划;3.利用MySQL自带监控工具(SHOWPROCESSLIST,SHOWSTATUS)监控数据库运行状况,定期备份和整理数据库。通过这些步骤,持续优化,才能提升MySQL数据库性能。

如何针对高负载应用程序优化 MySQL 性能?

Apr 08, 2025 pm 06:03 PM

如何针对高负载应用程序优化 MySQL 性能?

Apr 08, 2025 pm 06:03 PM

MySQL数据库性能优化指南在资源密集型应用中,MySQL数据库扮演着至关重要的角色,负责管理海量事务。然而,随着应用规模的扩大,数据库性能瓶颈往往成为制约因素。本文将探讨一系列行之有效的MySQL性能优化策略,确保您的应用在高负载下依然保持高效响应。我们将结合实际案例,深入讲解索引、查询优化、数据库设计以及缓存等关键技术。1.数据库架构设计优化合理的数据库架构是MySQL性能优化的基石。以下是一些核心原则:选择合适的数据类型选择最小的、符合需求的数据类型,既能节省存储空间,又能提升数据处理速度

了解 ACID 属性:可靠数据库的支柱

Apr 08, 2025 pm 06:33 PM

了解 ACID 属性:可靠数据库的支柱

Apr 08, 2025 pm 06:33 PM

数据库ACID属性详解ACID属性是确保数据库事务可靠性和一致性的一组规则。它们规定了数据库系统处理事务的方式,即使在系统崩溃、电源中断或多用户并发访问的情况下,也能保证数据的完整性和准确性。ACID属性概述原子性(Atomicity):事务被视为一个不可分割的单元。任何部分失败,整个事务回滚,数据库不保留任何更改。例如,银行转账,如果从一个账户扣款但未向另一个账户加款,则整个操作撤销。begintransaction;updateaccountssetbalance=balance-100wh