IBM开发云原生AI超级计算机Vela 可灵活部署并训练数百亿参数模型

ChatGPT红遍网络,其背后的AI模型训练也广受关注。IBM研究部门日前宣布,其开发的云原生超级计算机Vela可以快速部署并用于训练基础AI模型。自2022年5月以来,该公司数十名研究人员一直在使用这款超级计算机训练具有数百亿参数的AI模型。

基础模型是基于大量未标记数据训练的AI模型,它们的通用性意味着只需微调就可以用于一系列不同的任务。它们的规模非常庞大,需要大量且成本高昂的计算能力。因此正如专家表示,计算能力将成为开发下一代大规模基础模型的最大瓶颈,训练它们需要花费大量算力和时间。

训练可以运行数百亿个或数千亿个参数的模型,需要采用高性能的计算硬件,包括网络、并行文件系统和裸机节点等。这些硬件很难部署,运行成本也很高。微软于2020年5月为OpenAI建造了AI超级计算机,并托管在Azure云平台中。但IBM表示,它们是由硬件驱动的,这增加了成本,并限制了灵活性。

云端AI超级计算机

因此,IBM创建了名为Vela的“专门专注于大规模AI”的系统。

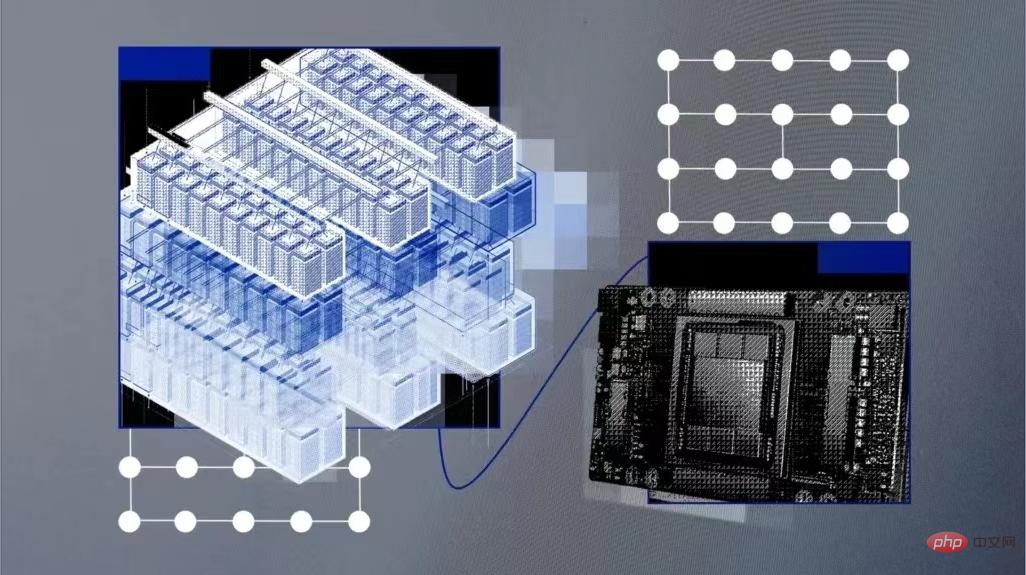

Vela可以根据需要部署到IBM的任何一个云数据中心中,它本身就是一个“虚拟云”。与构建物理的超级计算机相比,虽然这种方法在计算能力方面有所下降,但创造了一个更灵活的解决方案。云计算解决方案通过API接口为工程师提供资源,更方便地访问广泛的IBM云生态系统以进行更深入的集成,并能够根据需要扩展性能。

IBM工程师解释说,Vela能够访问IBM云对象存储上的数据集,而不是构建自定义存储后端。以往这些基础设施必须单独构建到超级计算机中。

任何AI超级计算机的关键组成部分都是大量的GPU以及连接它们的节点。Vela其实是将每个节点配置为虚拟机(而不是裸机),这是最常见的方法,也被广泛认为是AI训练最理想的方法。

Vela是如何构建的?

云端虚拟计算机的弊病之一是性能不能保证。为了解决性能下降问题,并在虚拟机内部提供裸机性能,IBM工程师找到了一种释放全部节点性能(包括GPU、CPU、网络和存储),并将负载损耗降低到5%以下的方法。

这涉及到为虚拟化配置裸机主机,支持虚拟机扩展、大型页面和单根IO虚拟化,以及真实地表示虚拟机内的所有设备和连接;还包括网卡与CPU和GPU匹配,以及它们彼此之间如何桥接起来。完成这些工作后,他们发现虚拟机节点的性能“接近裸机”。

此外,他们还致力于设计具有大型GPU内存和大量本地存储的AI节点,用于缓存AI训练数据、模型和成品。在使用PyTorch的测试中,他们发现通过优化工作负载通信模式,与超级计算中使用的类似Infiniband的更快的网络相比,他们还能够弥补以太网网络相对较慢的瓶颈。

配置方面,每个Vela都采用了8个80GB A100 GPU、两个第二代Intel Xeon可扩展处理器、1.5TB内存和四个3.2TB NVMe硬盘驱动器,并能够以任何规模部署到IBM在全球的任何一个云数据中心。

IBM的工程师表示:“拥有合适的工具和基础设施是提高研发效率的关键因素。许多团队选择遵循为AI构建传统超级计算机的可靠路径……我们一直在研究一种更好的解决方案,以提供高性能计算和高端用户生产力的双重好处。”

以上是IBM开发云原生AI超级计算机Vela 可灵活部署并训练数百亿参数模型的详细内容。更多信息请关注PHP中文网其他相关文章!

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

AI Hentai Generator

免费生成ai无尽的。

热门文章

热工具

记事本++7.3.1

好用且免费的代码编辑器

SublimeText3汉化版

中文版,非常好用

禅工作室 13.0.1

功能强大的PHP集成开发环境

Dreamweaver CS6

视觉化网页开发工具

SublimeText3 Mac版

神级代码编辑软件(SublimeText3)

热门话题

SQL 如何添加新列

Apr 09, 2025 pm 02:09 PM

SQL 如何添加新列

Apr 09, 2025 pm 02:09 PM

SQL 中通过使用 ALTER TABLE 语句为现有表添加新列。具体步骤包括:确定表名称和列信息、编写 ALTER TABLE 语句、执行语句。例如,为 Customers 表添加 email 列(VARCHAR(50)):ALTER TABLE Customers ADD email VARCHAR(50);

SQL 添加列的语法是什么

Apr 09, 2025 pm 02:51 PM

SQL 添加列的语法是什么

Apr 09, 2025 pm 02:51 PM

SQL 中添加列的语法为 ALTER TABLE table_name ADD column_name data_type [NOT NULL] [DEFAULT default_value]; 其中,table_name 是表名,column_name 是新列名,data_type 是数据类型,NOT NULL 指定是否允许空值,DEFAULT default_value 指定默认值。

SQL 清空表:性能优化技巧

Apr 09, 2025 pm 02:54 PM

SQL 清空表:性能优化技巧

Apr 09, 2025 pm 02:54 PM

提高 SQL 清空表性能的技巧:使用 TRUNCATE TABLE 代替 DELETE,释放空间并重置标识列。禁用外键约束,防止级联删除。使用事务封装操作,保证数据一致性。批量删除大数据,通过 LIMIT 限制行数。清空后重建索引,提高查询效率。

SQL 添加列时如何设置默认值

Apr 09, 2025 pm 02:45 PM

SQL 添加列时如何设置默认值

Apr 09, 2025 pm 02:45 PM

为新添加的列设置默认值,使用 ALTER TABLE 语句:指定添加列并设置默认值:ALTER TABLE table_name ADD column_name data_type DEFAULT default_value;使用 CONSTRAINT 子句指定默认值:ALTER TABLE table_name ADD COLUMN column_name data_type CONSTRAINT default_constraint DEFAULT default_value;

使用 DELETE 语句清空 SQL 表

Apr 09, 2025 pm 03:00 PM

使用 DELETE 语句清空 SQL 表

Apr 09, 2025 pm 03:00 PM

是的,DELETE 语句可用于清空 SQL 表,步骤如下:使用 DELETE 语句:DELETE FROM table_name;替换 table_name 为要清空的表的名称。

Redis内存碎片如何处理?

Apr 10, 2025 pm 02:24 PM

Redis内存碎片如何处理?

Apr 10, 2025 pm 02:24 PM

Redis内存碎片是指分配的内存中存在无法再分配的小块空闲区域。应对策略包括:重启Redis:彻底清空内存,但会中断服务。优化数据结构:使用更适合Redis的结构,减少内存分配和释放次数。调整配置参数:使用策略淘汰最近最少使用的键值对。使用持久化机制:定期备份数据,重启Redis清理碎片。监控内存使用情况:及时发现问题并采取措施。

phpmyadmin建立数据表

Apr 10, 2025 pm 11:00 PM

phpmyadmin建立数据表

Apr 10, 2025 pm 11:00 PM

要使用 phpMyAdmin 创建数据表,以下步骤必不可少:连接到数据库并单击“新建”标签。为表命名并选择存储引擎(推荐 InnoDB)。通过单击“添加列”按钮添加列详细信息,包括列名、数据类型、是否允许空值以及其他属性。选择一个或多个列作为主键。单击“保存”按钮创建表和列。

使用 Redis Exporter 服务监控 Redis Droplet

Apr 10, 2025 pm 01:36 PM

使用 Redis Exporter 服务监控 Redis Droplet

Apr 10, 2025 pm 01:36 PM

有效监控 Redis 数据库对于保持最佳性能、识别潜在瓶颈和确保整体系统可靠性至关重要。 Redis Exporter Service 是一个强大的实用程序,旨在使用 Prometheus 监控 Redis 数据库。 本教程将指导您完成 Redis Exporter Service 的完整设置和配置,确保您无缝建立监控解决方案。通过学习本教程,您将实现完全可操作的监控设置