多模态再次统一!Meta发布自监督算法data2vec 2.0:训练效率最高提升16倍!

近几年人工智能领域的突破大多由自监督学习推动,比如BERT中提出的MLM (Masked Language Model) ,通过将文本中的部分单词遮盖后重新预测,使得海量无标记文本数据也能用来训练模型,自此开启了大规模预训练模型的新时代。但自监督学习算法也有明显的局限性,通常只适用于单一模态(如图像、文本、语音等)的数据,并且需要大量的算力从海量数据中进行学习。相比之下,人类的学习效率要显著高于当前的AI模型,并且可以从不同类型的数据中进行学习。

2022年1月,Meta AI发布了自监督学习框架data2vec,将三个模态的数据(语音、视觉和文本)通过一个框架整合起来,大有一统多模态的趋势。最近Meta AI发布了data2cec 2.0版本,主要在性能方面对上一代进行了改进:在精度相同的情况下,训练速度相比其他算法最高提升了16倍!

论文链接:https://ai.facebook.com/research/publications/efficient-self-supervised-learning-with-contextualized-target-representations-for-vision-speech-and-language

代码链接:https://github.com/facebookresearch/fairseq/tree/main/examples/data2vec

data2vec 1.0

目前来说,大部分机器学习模型仍然是基于有监督学习的模式,需要有专门的标注人员对目标数据打标签,但对于某些任务来说(比如地球上的几千种人类语言),收集标注数据是不可行的。

相比之下,自监督学习不需要告诉模型正确和错误,而是让机器通过观察世界来学习图像、语音和文本的结构。相关的研究成果促进了语音(如,wave2vec 2.0)、计算机视觉(例如,掩码自编码器)和自然语言处理(例如,BERT)等领域的发展。

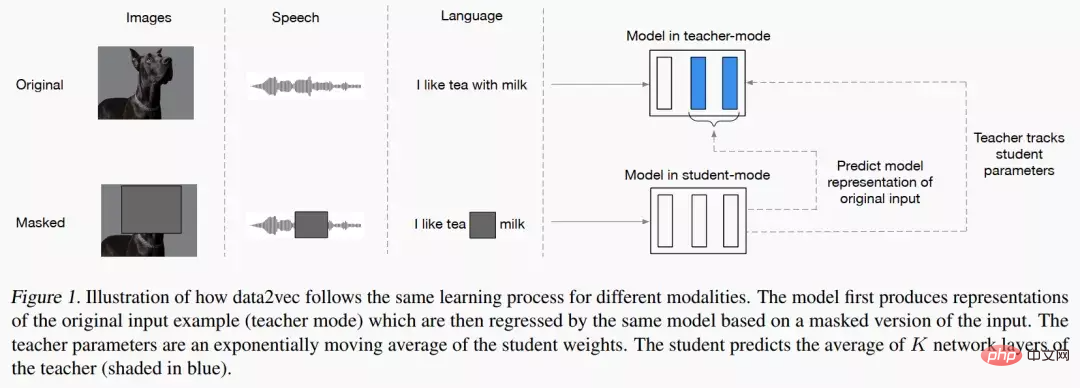

data2vec的主要思路就是先建立一个教师网络,首先计算来自图像、文本或语音的目标表征。然后对数据进行掩码遮盖掉部分输入,并用一个学生网络重复该过程预测教师模型得到的表征。

也就是说,学生模型只能在接受「不完整输入信息」的同时预测「完整输入数据」的表示。为了保证两个模型的一致性,二者的参数时共享的,但在训练初期会让Teacher模型的参数更新更快。在实验结果上,data2vec在语音、视觉、文本等任务上对比baseline模型性能提升明显。

data2vec 2.0

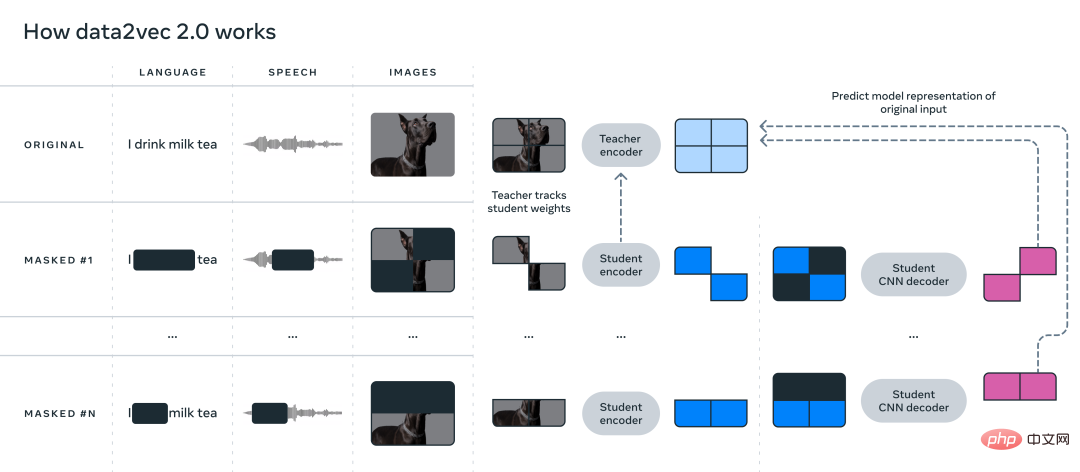

data2vec提出了一个通用的自监督学习框架统一了语音、视觉和语言三个模态数据的学习,而data2vec2.0主要解决的痛点就是构建自监督模型需要大量的GPU做算力支撑才能完成训练。与最初的 data2vec 算法类似,data2vec 2.0预测数据的上下文化的表征(contextualized representations),或是神经网络的层次,而非预测图像的像素、文本段中的词或语音。

与常见的其他算法不同,这些所谓的目标表征是上下文化的,这意味着算法需要将整个训练示例考虑在内。

比如说,模型学习单词 bank 的表征是基于包含bank的整个句子,从而更容易推算出单词的正确含义,比如区分具体指代「金融机构」还是「河边的土地」。研究人员认为上下文化的目标会促进更丰富的学习任务,并使 data2vec 2.0比其他算法学习得更快。

data2vec 2.0通过以下三种方式提高了原始 data2vec 算法的效率:

1、为特定训练样例构建目标表征,并将该表征重用在掩码版本上。在掩码版本中,训练样例中的不同部分会被随机隐藏。随后两个版本学到的表征都会输入到学生模型中,为不同的掩码版本预测相同的上下文化的目标表征,从而有效地分摊了创建目标表征所需的计算量。

2、类似于掩码自编码器(masked autoencoder, MAE),学生模型中的编码器网络并不运训练样例中的空白部分(blanked out)。在图像实验中,大约80%的部分都是空白,从而显著节省了计算周期。

3、使用了一个更有效的解码器模型,不再依赖于Transformer网络,而是依赖于一个多层卷积网络。

实验部分

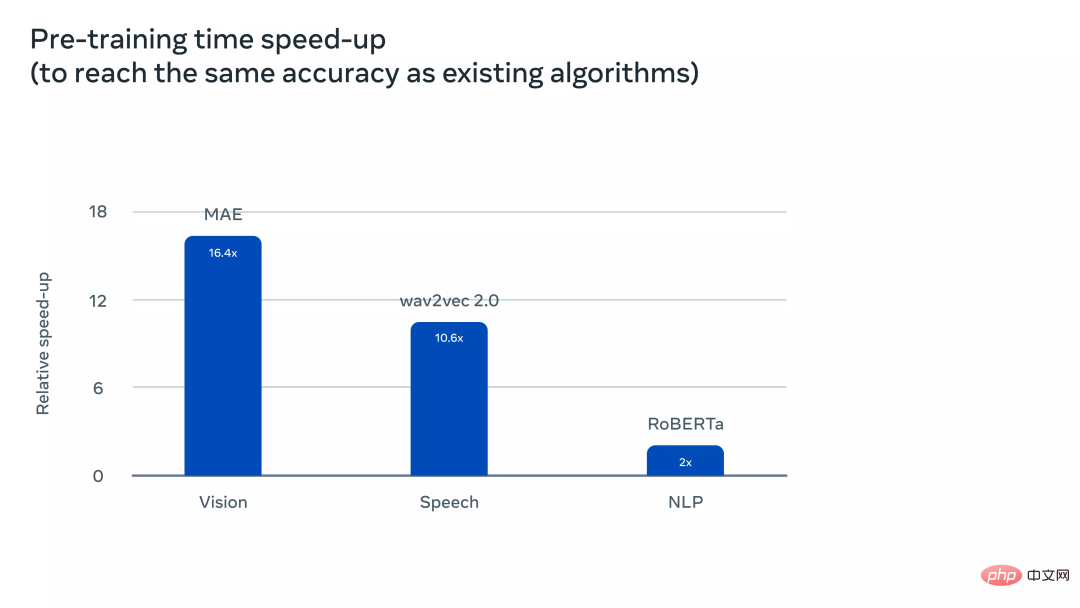

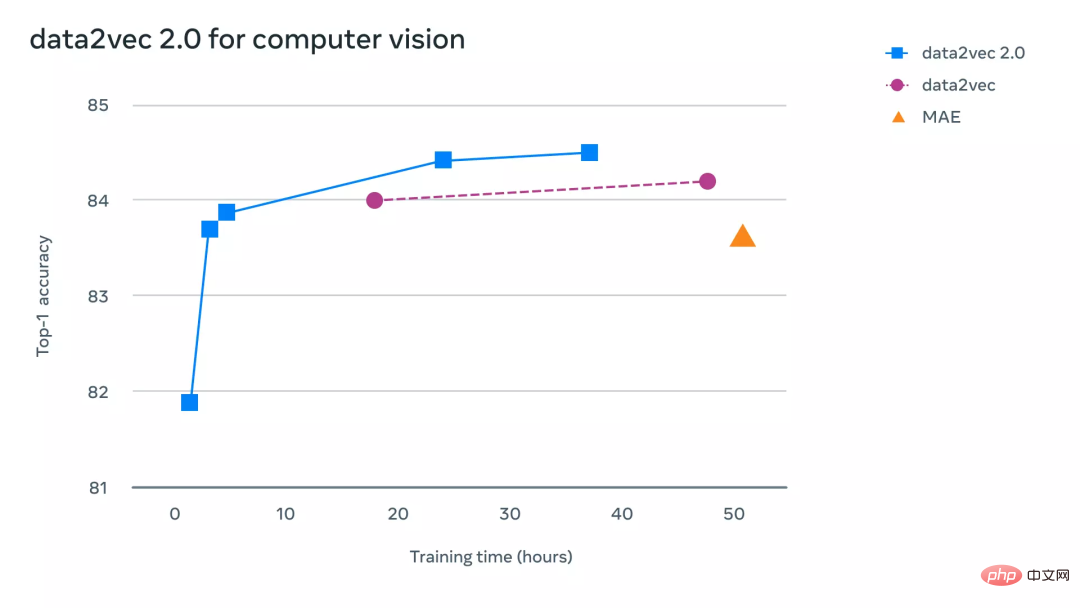

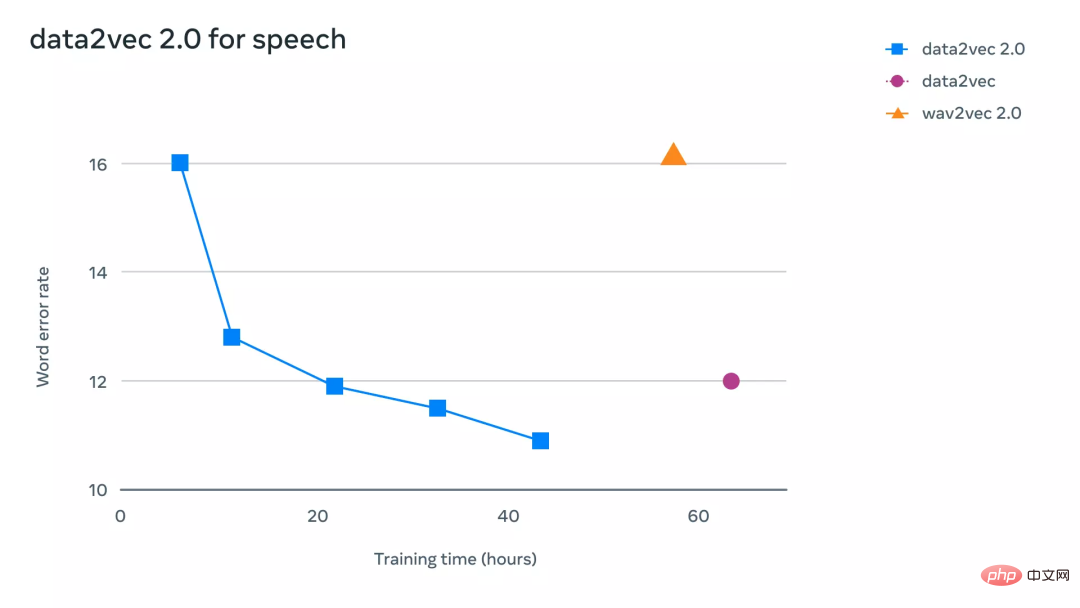

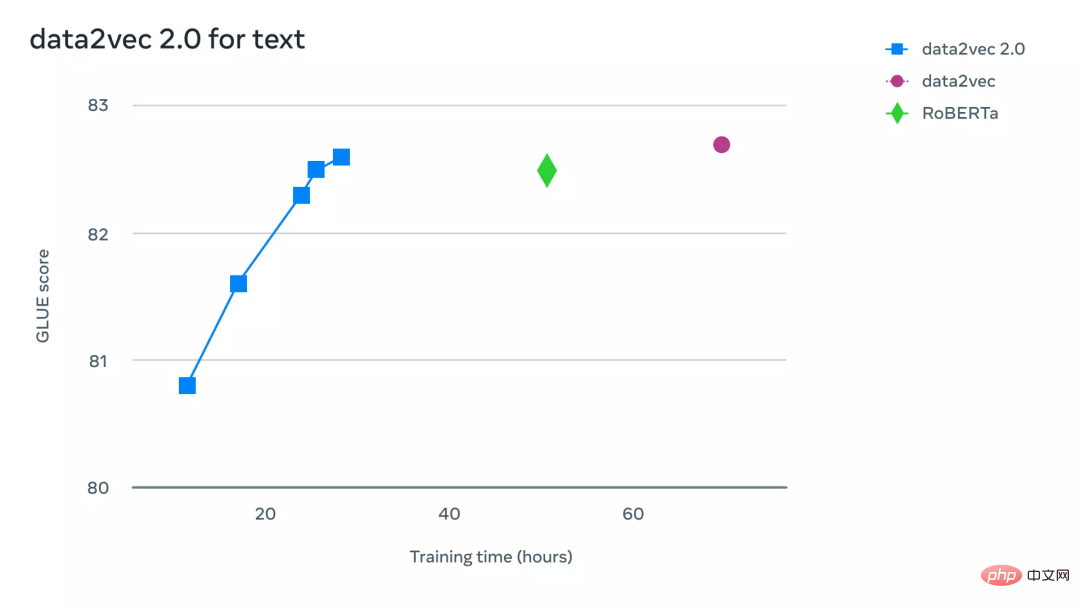

为了更直观地理解 data2vec 2.0 比 data2vec 和其他同类算法的效率要高多少,研究人员在计算机视觉、语音和文本任务相关的基准测试中进行了广泛的实验。实验中主要考虑最终的精确度以及预训练模型所需的时间,实验环境都是在相同的硬件上(GPU 的型号、数量等)来测量算法的运行速度。

在计算机视觉任务上,研究人员在标准 ImageNet-1K 图像分类基准上评估了 data2vec 2.0,模型通过该数据集可以学习图像表征。实验结果显示,data2vec 2.0可以等同于掩码自编码器(MAE)的准确性,但是速度要快16倍。

如果继续给data2vec 2.0算法更多的运行时间,它可以达到更高的精度,并且仍然会比MAE的速度快。

在语音任务上,研究人员在 LibriLanguage 语音识别基准上进行了测试,它的准确性是 wave2vec 2.0的11倍以上。

对于自然语言处理任务,研究人员在通用语言理解评估(GLUE)基准上评估了 data2vec 2.0,仅需一半的训练时间即可达到与 BERT 的重新实现 RoBERTa 相同的精度。

以上是多模态再次统一!Meta发布自监督算法data2vec 2.0:训练效率最高提升16倍!的详细内容。更多信息请关注PHP中文网其他相关文章!

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

Video Face Swap

使用我们完全免费的人工智能换脸工具轻松在任何视频中换脸!

热门文章

热工具

记事本++7.3.1

好用且免费的代码编辑器

SublimeText3汉化版

中文版,非常好用

禅工作室 13.0.1

功能强大的PHP集成开发环境

Dreamweaver CS6

视觉化网页开发工具

SublimeText3 Mac版

神级代码编辑软件(SublimeText3)

币圈行情实时数据免费平台推荐前十名发布

Apr 22, 2025 am 08:12 AM

币圈行情实时数据免费平台推荐前十名发布

Apr 22, 2025 am 08:12 AM

适合新手的加密货币数据平台有CoinMarketCap和非小号。1. CoinMarketCap提供全球加密货币实时价格、市值、交易量排名,适合新手与基础分析需求。2. 非小号提供中文友好界面,适合中文用户快速筛选低风险潜力项目。

okx在线 okx交易所官网在线

Apr 22, 2025 am 06:45 AM

okx在线 okx交易所官网在线

Apr 22, 2025 am 06:45 AM

OKX 交易所的详细介绍如下:1) 发展历程:2017 年创办,2022 年更名为 OKX;2) 总部位于塞舌尔;3) 业务范围涵盖多种交易产品,支持 350 多种加密货币;4) 用户遍布 200 余个国家,千万级用户量;5) 采用多重安全措施保障用户资产;6) 交易费用基于做市商模式,费率随交易量增加而降低;7) 曾获多项荣誉,如“年度加密货币交易所”等。

各大虚拟货币交易平台的特色服务一览

Apr 22, 2025 am 08:09 AM

各大虚拟货币交易平台的特色服务一览

Apr 22, 2025 am 08:09 AM

机构投资者应选择Coinbase Pro和Genesis Trading等合规平台,关注冷存储比例与审计透明度;散户投资者应选择币安和火币等大平台,注重用户体验与安全;合规敏感地区的用户可通过Circle Trade和Huobi Global进行法币交易,中国大陆用户需通过合规场外渠道。

大宗交易的虚拟货币交易平台排行榜top10最新发布

Apr 22, 2025 am 08:18 AM

大宗交易的虚拟货币交易平台排行榜top10最新发布

Apr 22, 2025 am 08:18 AM

选择大宗交易平台时应考虑以下因素:1. 流动性:优先选择日均交易量超50亿美元的平台。2. 合规性:查看平台是否持有美国FinCEN、欧盟MiCA等牌照。3. 安全性:冷钱包存储比例和保险机制是关键指标。4. 服务能力:是否提供专属客户经理和定制化交易工具。

支持多种币种的虚拟货币交易平台推荐前十名一览

Apr 22, 2025 am 08:15 AM

支持多种币种的虚拟货币交易平台推荐前十名一览

Apr 22, 2025 am 08:15 AM

优先选择合规平台如OKX和Coinbase,启用多重验证,资产自托管可减少依赖:1. 选择有监管牌照的交易所;2. 开启2FA和提币白名单;3. 使用硬件钱包或支持自托管的平台。

数字货币交易app容易上手的推荐top10(025年最新排名)

Apr 22, 2025 am 07:45 AM

数字货币交易app容易上手的推荐top10(025年最新排名)

Apr 22, 2025 am 07:45 AM

gate.io(全球版)核心优势是界面极简,支持中文,法币交易流程直观;币安(简版)核心优势是全球交易量第一,简版模式仅保留现货交易;OKX(香港版)核心优势是界面简洁,支持粤语/普通话,衍生品交易门槛低;火币全球站(香港版)核心优势是老牌交易所,推出元宇宙交易终端;KuCoin(中文社区版)核心优势是支持800 币种,界面采用微信式交互;Kraken(香港版)核心优势是美国老牌交易所,持有香港SVF牌照,界面简洁;HashKey Exchange(香港持牌)核心优势是香港知名持牌交易所,支持法

币圈十大行情网站的使用技巧与推荐2025

Apr 22, 2025 am 08:03 AM

币圈十大行情网站的使用技巧与推荐2025

Apr 22, 2025 am 08:03 AM

国内用户适配方案包括合规渠道和本地化工具。1. 合规渠道:通过OTC平台如Circle Trade进行法币兑换,境内需通过香港或海外平台。2. 本地化工具:使用币圈网获取中文资讯,火币全球站提供元宇宙交易终端。

数字货币交易所App前十名苹果版下载入口汇总

Apr 22, 2025 am 09:27 AM

数字货币交易所App前十名苹果版下载入口汇总

Apr 22, 2025 am 09:27 AM

提供各种复杂的交易工具和市场分析。覆盖 100 多个国家,日均衍生品交易量超 300 亿美元,支持 300 多个交易对与 200 倍杠杆,技术实力强大,拥有庞大的全球用户基础,提供专业的交易平台、安全存储解决方案以及丰富的交易对。