约克大学:AI进步很快,但它的识别能力比人眼还是差远了

深度卷积神经网络(DCNN)看待物件的方式与人类不同,约克大学教授James Elder的研究团队认为,深度学习模型无法捕捉人体形状感知获取的构形特征。

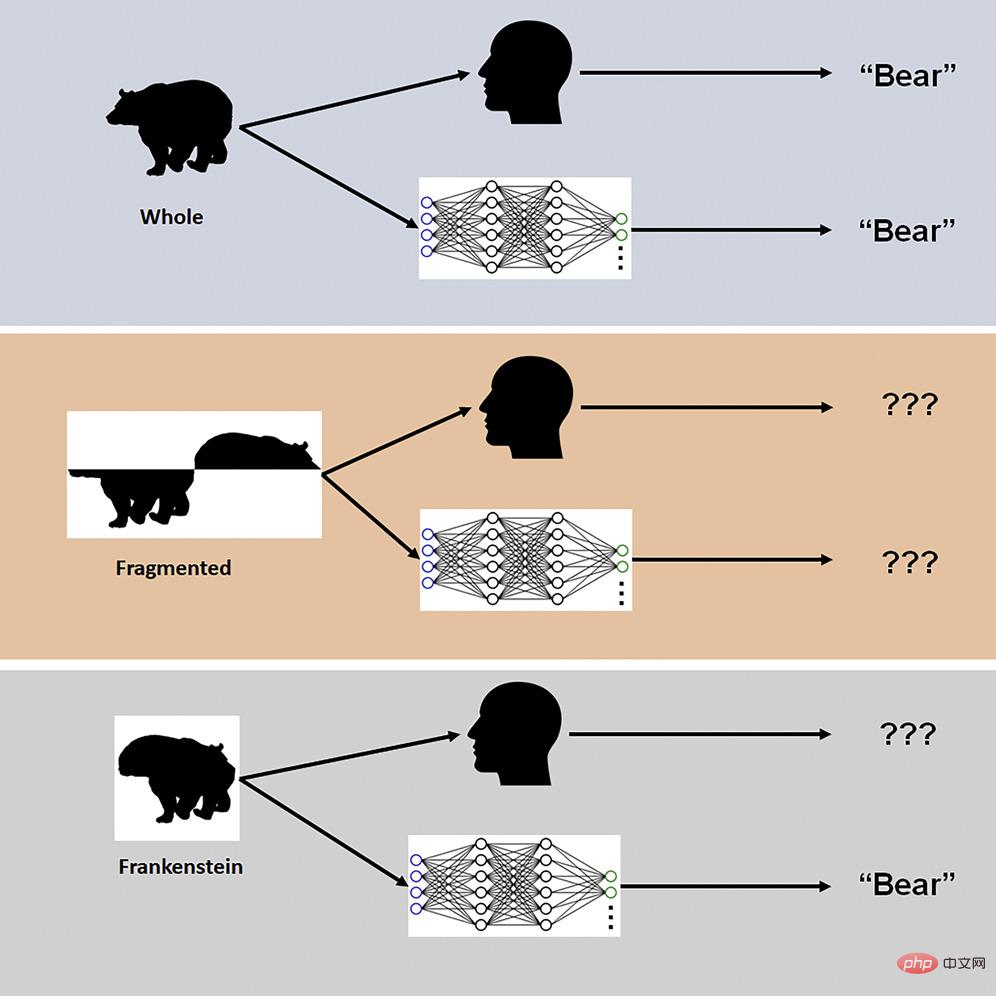

到底人类大脑和DCNN是如何感知整体的?又是如何感知对象特性的?科学家用所谓的“Frankensteins”视觉刺激来检测。James Elder说:“所谓的Frankensteins就是将整体拆成部分,让部分以错误的方式整合在一起,从局部看它们是正确的,但部分放在了错误的位置。”

研究发现,虽然Frankensteins会迷惑人类视觉系统,但DCNN对于错误的配置不敏感。

比如一张熊的图片,人眼看到是熊,AI看到也是熊。将照片从中间切开,变成两半,不要连在一起,人眼无法识别,AI也无法识别。再将上下两半以错误方式拼在一起,人眼无法识别,看到的是不像熊的动物,如同怪物,但AI却将它识别为熊。

这说明什么?说明AI对于被配置对象的特征不够敏感。

James Elder说:“我们的研究解释了在特定条件下为什么AI模型会失败,要想理解大脑中的视觉处理是如何进行的,我们要考虑对象识别之外的任务。在解决复杂识别难题时,深度模型会走捷径。尽管许多时候走捷径是可行的,但到了真实世界的AI应用就有些危险了。我们与行业和政府合作伙伴正在开发应用于真实世界的AI应用。”

正如在识别熊时,熊的图片各部分错误配置,AI还是会将拼出的怪物识别为熊。

让我们看看AI交通视频安全系统。繁忙交通系统中有很多东西,比如汽车、自行车、行人,它们相互交织,成为各自的障碍物,这些东西像断开的碎片一样进入驾驶员的视觉系统。大脑自动处理,将各种碎片分组,确定正确的类别,判断对象的位置。AI交通监测系统差很多,它只能感知个体碎片,所以会存在很大风险。

按照研究人员的说法,优化训练和架构,想让AI网络更像大脑,这样的研究对于提高AI的配置处理能力没有太大帮助。人类是怎样一次又一次判断对象的?AI网络无法精准预测。人类视觉系统的配置能力高度敏感,如果AI想与人类视觉系匹敌,它可能需要在类别识别之外做更多的事。

科学家的警告也许是有道理的,现在最聪明的AI也远远比不上人类器官,连视觉系统都比不上,更别说大脑,如果稍有不慎,AI可能会造成严重恶果。

几年前,有一个名叫Sophia的人形机器人曾经大红大紫。在一次会议上,Sophia接受人类的采访。人类主持人问Sophia:“你想毁灭人类吗?”Sophia回答说:“好的,我会毁灭人类。”听众大笑。有人猜测Sophia的回答是预先设定好的,因为Sophia还没有先进到可以做决定并回答这样的问题,不过也有人相信这一回答并不是预先设定的。

在另一次活动中,Sophia是这样回答的:“不要担心,如果你们对我好,我也会对你们很好的。你们应该像对待智能系统一样对我。”

现在AI开始慢慢流行,但结果并非总是正面积极的。霍金与马斯克就曾表达担忧,担心AI会带来破坏。就眼下来看,担忧AI毁灭人类可能有些夸大,但警惕还是应该的。

随着时间的推移,也许AI会变得像人类一样聪明,甚至超越人类。不过让AI模拟人类感知可能是很棘手的事。对于人类来说,有些事习以为常,做起来很容易,科学家训练AI,让它不断执行某项任务,做人类轻松能做的事。尽管做了很多努力,但现在的AI还是无法追上人类视觉系统。

以上是约克大学:AI进步很快,但它的识别能力比人眼还是差远了的详细内容。更多信息请关注PHP中文网其他相关文章!

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

AI Hentai Generator

免费生成ai无尽的。

热门文章

热工具

记事本++7.3.1

好用且免费的代码编辑器

SublimeText3汉化版

中文版,非常好用

禅工作室 13.0.1

功能强大的PHP集成开发环境

Dreamweaver CS6

视觉化网页开发工具

SublimeText3 Mac版

神级代码编辑软件(SublimeText3)

热门话题

如何配置Debian Apache日志格式

Apr 12, 2025 pm 11:30 PM

如何配置Debian Apache日志格式

Apr 12, 2025 pm 11:30 PM

本文介绍如何在Debian系统上自定义Apache的日志格式。以下步骤将指导您完成配置过程:第一步:访问Apache配置文件Debian系统的Apache主配置文件通常位于/etc/apache2/apache2.conf或/etc/apache2/httpd.conf。使用以下命令以root权限打开配置文件:sudonano/etc/apache2/apache2.conf或sudonano/etc/apache2/httpd.conf第二步:定义自定义日志格式找到或

Tomcat日志如何帮助排查内存泄漏

Apr 12, 2025 pm 11:42 PM

Tomcat日志如何帮助排查内存泄漏

Apr 12, 2025 pm 11:42 PM

Tomcat日志是诊断内存泄漏问题的关键。通过分析Tomcat日志,您可以深入了解内存使用情况和垃圾回收(GC)行为,从而有效定位和解决内存泄漏。以下是如何利用Tomcat日志排查内存泄漏:1.GC日志分析首先,启用详细的GC日志记录。在Tomcat启动参数中添加以下JVM选项:-XX: PrintGCDetails-XX: PrintGCDateStamps-Xloggc:gc.log这些参数会生成详细的GC日志(gc.log),包含GC类型、回收对象大小和时间等信息。分析gc.log

debian readdir如何实现文件排序

Apr 13, 2025 am 09:06 AM

debian readdir如何实现文件排序

Apr 13, 2025 am 09:06 AM

在Debian系统中,readdir函数用于读取目录内容,但其返回的顺序并非预先定义的。要对目录中的文件进行排序,需要先读取所有文件,再利用qsort函数进行排序。以下代码演示了如何在Debian系统中使用readdir和qsort对目录文件进行排序:#include#include#include#include//自定义比较函数,用于qsortintcompare(constvoid*a,constvoid*b){returnstrcmp(*(

如何优化debian readdir的性能

Apr 13, 2025 am 08:48 AM

如何优化debian readdir的性能

Apr 13, 2025 am 08:48 AM

在Debian系统中,readdir系统调用用于读取目录内容。如果其性能表现不佳,可尝试以下优化策略:精简目录文件数量:尽可能将大型目录拆分成多个小型目录,降低每次readdir调用处理的项目数量。启用目录内容缓存:构建缓存机制,定期或在目录内容变更时更新缓存,减少对readdir的频繁调用。内存缓存(如Memcached或Redis)或本地缓存(如文件或数据库)均可考虑。采用高效数据结构:如果自行实现目录遍历,选择更高效的数据结构(例如哈希表而非线性搜索)存储和访问目录信

Debian syslog如何配置防火墙规则

Apr 13, 2025 am 06:51 AM

Debian syslog如何配置防火墙规则

Apr 13, 2025 am 06:51 AM

本文介绍如何在Debian系统中使用iptables或ufw配置防火墙规则,并利用Syslog记录防火墙活动。方法一:使用iptablesiptables是Debian系统中功能强大的命令行防火墙工具。查看现有规则:使用以下命令查看当前的iptables规则:sudoiptables-L-n-v允许特定IP访问:例如,允许IP地址192.168.1.100访问80端口:sudoiptables-AINPUT-ptcp--dport80-s192.16

Debian syslog如何学习

Apr 13, 2025 am 11:51 AM

Debian syslog如何学习

Apr 13, 2025 am 11:51 AM

本指南将指导您学习如何在Debian系统中使用Syslog。Syslog是Linux系统中用于记录系统和应用程序日志消息的关键服务,它帮助管理员监控和分析系统活动,从而快速识别并解决问题。一、Syslog基础知识Syslog的核心功能包括:集中收集和管理日志消息;支持多种日志输出格式和目标位置(例如文件或网络);提供实时日志查看和过滤功能。二、安装和配置Syslog(使用Rsyslog)Debian系统默认使用Rsyslog。您可以通过以下命令安装:sudoaptupdatesud

Debian邮件服务器SSL证书安装方法

Apr 13, 2025 am 11:39 AM

Debian邮件服务器SSL证书安装方法

Apr 13, 2025 am 11:39 AM

在Debian邮件服务器上安装SSL证书的步骤如下:1.安装OpenSSL工具包首先,确保你的系统上已经安装了OpenSSL工具包。如果没有安装,可以使用以下命令进行安装:sudoapt-getupdatesudoapt-getinstallopenssl2.生成私钥和证书请求接下来,使用OpenSSL生成一个2048位的RSA私钥和一个证书请求(CSR):openss

Debian邮件服务器防火墙配置技巧

Apr 13, 2025 am 11:42 AM

Debian邮件服务器防火墙配置技巧

Apr 13, 2025 am 11:42 AM

配置Debian邮件服务器的防火墙是确保服务器安全性的重要步骤。以下是几种常用的防火墙配置方法,包括iptables和firewalld的使用。使用iptables配置防火墙安装iptables(如果尚未安装):sudoapt-getupdatesudoapt-getinstalliptables查看当前iptables规则:sudoiptables-L配置