Meta公司创新SOTA模型,能够根据一句话生成惊人视频,引爆网络热潮!

给你一段话,让你做个视频,你能行吗?

Meta表示,我可以啊。

你没听错:使用AI,你也可以变成电影人了!

近日,Meta推出了新的AI模型,名字起得也是非常直接:做个视频(Make-A-Video)。

这个模型强大到什么程度?

一句话,就能实现「三马奔腾」的场景。

就连LeCun都说,该来的总是会来的。

视觉效果超炫

话不多说,咱们直接看效果。

俩袋鼠在厨房忙着做饭(做出来能不能吃另说)

近景:画师在画布上作画

大雨中漫步的二人世界(步伐整齐划一)

马在喝水

芭蕾舞女孩在摩天大楼跳舞

美丽的夏日热带海滩上,一只金毛在吃冰激凌(爪子已进化)

猫主子拿着遥控器在看电视(爪子已进化)

一只泰迪熊给自己画自画像

意料之外但情理之中的是,狗拿冰淇淋、猫拿遥控器以及泰迪熊画画的「手」,果然都「进化」得和人一样啊!(战术后仰)

当然,Make-A-Video除了可以把文本变成视频之外,也可以把静态图变成Gif。

输入:

输出:

输入:

输出:(亮的似乎有点不是地方)

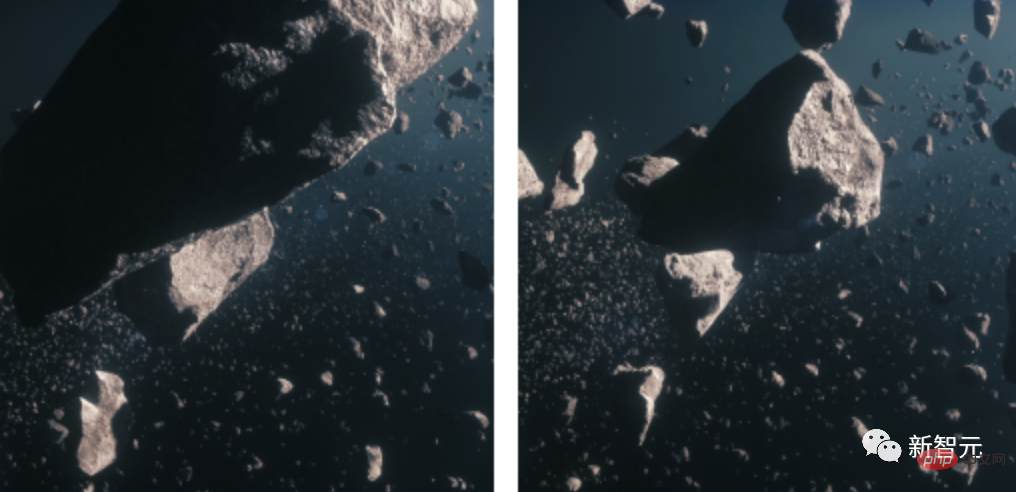

2张静图变GIF,输入陨石图

输出:

以及,把视频,变成视频?

输入:

输出:

输入:

输出:

技术原理

今天,Meta放出了自己的最新研究MAKE-A-VIDEO: TEXT-TO-VIDEO GENERATION WITHOUT TEXT-VIDEO DATA。

论文地址:https://makeavideo.studio/Make-A-Video.pdf

在这个模型出现之前,我们已经有了Stable Diffusion。

聪明的科学家已经让AI用一句话生成图像了,下一步他们会做什么呢?

很显然,是生成视频。

一只穿着红色斗篷的超级英雄狗在天空中飞翔

比起生成图像来,生成视频可难多了。我们不仅需要生成相同主题和场景的多个帧,还必须让它们及时、连贯。

这就增加了图像生成任务的复杂性——我们不可能就简单地使用DALLE生成60张图像,然后把它们拼成一个视频。它的效果会很差,很不真实。

因此,我们需要一个能够以更强大的方式理解世界的模型,并且让它按照这种理解水平来生成一系列连贯的图像。只有这样,这些图像才可以天衣无缝地融合在一起。

也就是说,我们的诉求是模拟一个世界,然后再模拟它的记录。该怎么做到呢?

按照以前的思路,研究人员会用大量的文本-视频对来训练模型,但在现在的这种情况下,这种处理方法并不现实。因为这些数据很难获得,并且训练成本非常昂贵。

因此,研究人员开了脑洞,采用了一种全新的方式。

他们选择开发一个文本到图像的模型,然后把它应用于视频。

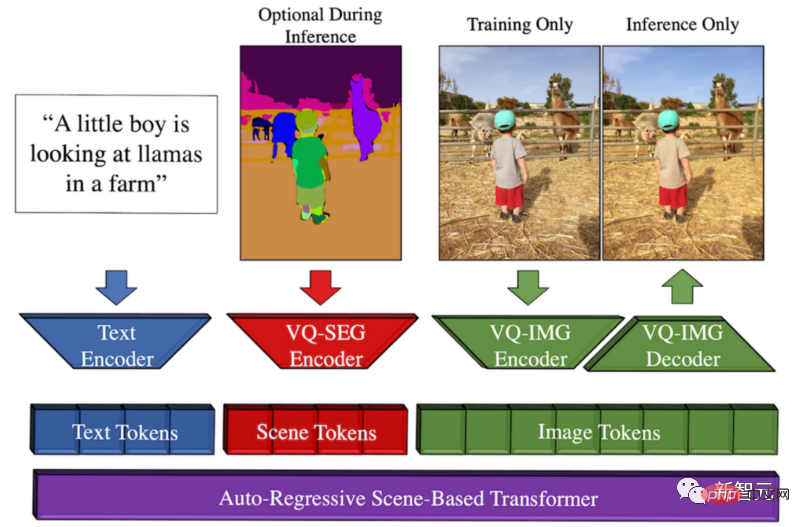

巧了,前段时间,Meta就曾开发过这么一个从文本到图像的模型Make-A-Scene。

Make-A-Scene的方法概述

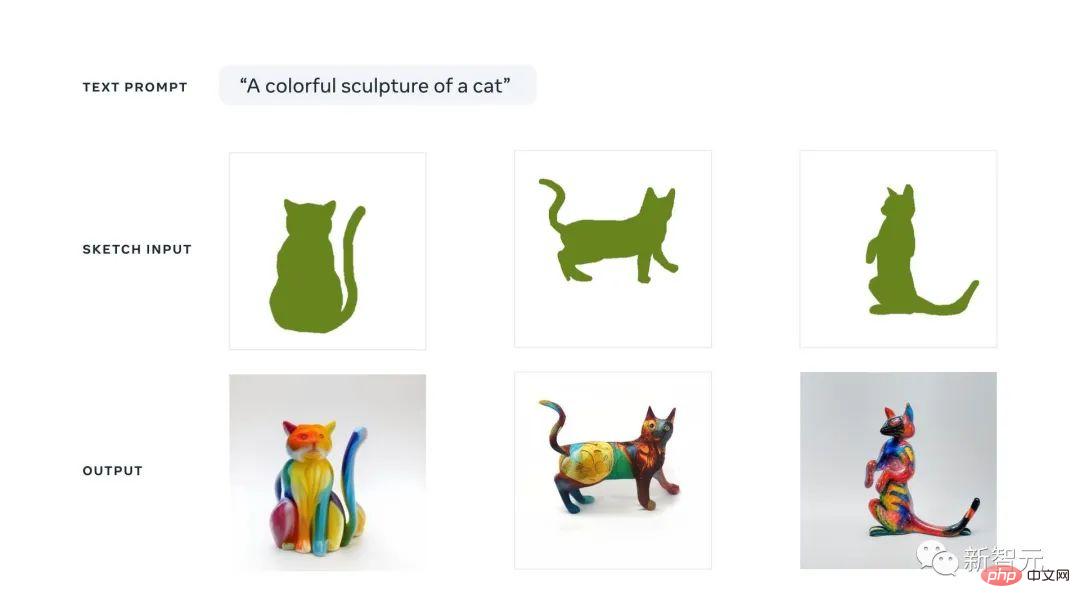

这个模型产生的契机是,Meta希望推动创意表达,将这种文本到图像的趋势与以前的草图到图像模型相结合,从而产生文本和以草图为条件的图像生成之间的奇妙融合。

这意味着我们可以快速勾勒出一只猫,写出自己想要什么样的图像。遵循草图和文本的指导,这个模型会在几秒钟内,生成我们想要的完美插图。

你可以把这种多模态生成AI方法看作是一个对生成有更多控制的Dall-E模型,因为它还可以将快速草图作为输入。

之所以称它为多模态,是因为它可以将多种模态作为输入,比如文本和图像。相比之下,Dall-E只能从文本生成图像。

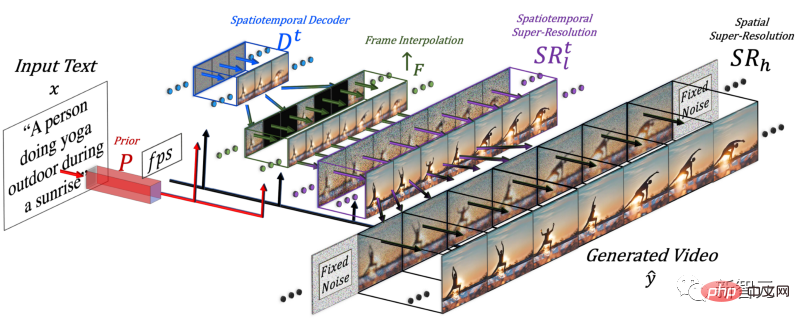

为了生成视频,就需要加入时间的维度,因此研究人员在Make-A-Scene模型中添加了时空管道。

加入时间维度后,这个模型就不是只生成一张图片,而是生成16张低分辨率的图片,以创建一个连贯的短视频。

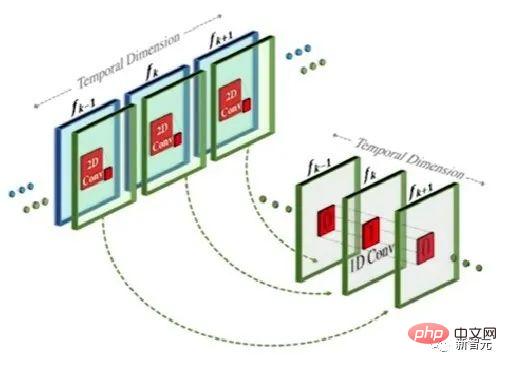

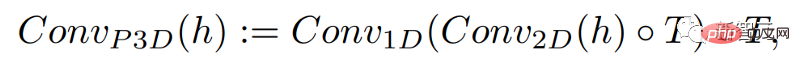

这个方法其实与文本到图像模型类似,但不同之处在于:在常规的二维卷积的基础上,它增加一维卷积。

只是简单地增加了一维卷积,研究人员就能保持预先训练的二维卷积不变的同时,增加一个时间维度。然后,研究人员就可以从头开始训练,重新使用Make-A-Scene图像模型的大部分代码和参数。

同时,研究人员还想用文本输入来指导这个模型,这将与使用CLIP嵌入的图像模型非常相似。

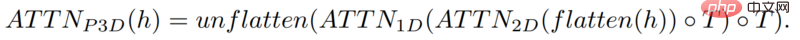

在这种情况下,研究人员是在将文本特征与图像特征混合时,增加空间维度,方法同上:保留Make-A-Scene模型中的注意力模块,并为时间增加一个一维注意力模块——复制粘贴图像生成器模型,为多一个维度重复生成模块,来获得16个初始帧。

但是只靠这16个初始帧,还不能生成视频。

研究人员需要从这16个主帧中,制作一个高清晰度的视频。他们采用的方法是:访问之前和未来的帧,并同时在时间和空间维度上对它们进行迭代插值。

就这样,他们在这16个初始帧之间,根据前后的帧生成了新的、更大的帧,这样就使运动变得连贯,整体视频变得流畅了。

这是通过一个帧插值网络完成的,它可以采取已有的图像来填补空白,生成中间的信息。在空间维度上,它会做同样的事情:放大图像,填补像素的空白,使图像更加高清。

总而言之,为了生成视频,研究人员微调了一个文本到图像的模型。他们采用了一个已经训练好的强大模型,对它进行调整和训练,让它适应视频。

因为添加了空间和时间模块,只要简单地让模型适应这些新数据就可以了,而不必重新训练它,这就节省了大量的成本。

这种重新训练使用的是未标记的视频,只需要教模型理解视频和视频帧的一致性就可以了,这就可以更简单地建立数据集。

最后,研究人员再次使用了图像优化模型,提高了空间分辨率,并使用了帧插值组件增加了更多的帧,使视频变得流畅。

当然,目前Make-A-Video的结果还存在缺点,就如同文本到图像的模型一样。但我们都知道,AI领域的进展是多么神速。

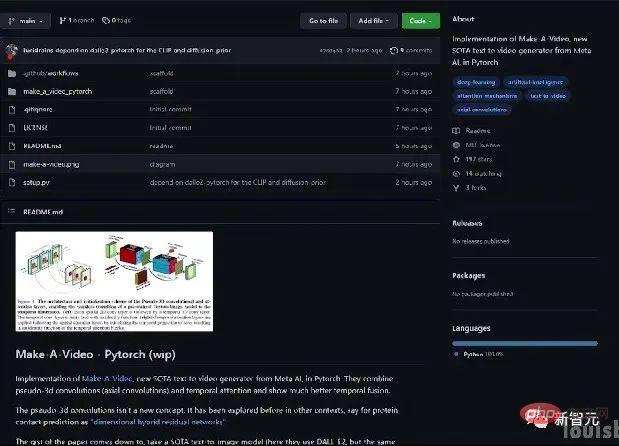

如果你想进一步了解,可以参考链接中Meta AI的论文。社区也正在开发一个PyTorch的实现,如果你想自己实现它,请继续关注。

作者介绍

这篇论文中有多位华人研究人员参与:殷希、安捷、张宋扬、Qiyuan Hu。

殷希,FAIR研究科学家。此前曾供职微软,任Microsoft Cloud and AI 的高级应用科学家。在密歇根州立大学计算机科学与工程系获博士学位,2013年毕业于武汉大学电气工程专业,获学士学位。主要研究领域为多模态理解、大规模目标检测、人脸推理等。

安捷,罗切斯特大学计算机科学系博士生。师从罗杰波教授。此前于 2016 年和 2019 年在北京大学获得学士和硕士学位。研究兴趣包括计算机视觉、深度生成模型和AI 艺术。作为实习生参与了Make-A-Video研究。

张宋扬,罗切斯特大学计算机科学系博士生,师从罗杰波教授。在东南大学获得学士学位,在浙江大学获得硕士学位。研究兴趣包括自然语言矩定位、无监督语法归纳、基于骨架的动作识别等。作为实习生参与了Make-A-Video研究。

Qiyuan Hu,时任FAIR的AI Resident,从事提高人类创造力的多模态生成模型的研究。她在芝加哥大学获得医学物理学博士学位,曾从事AI辅助的医学图像分析工作。现已供职Tempus Labs,任机器学习科学家。

网友大受震撼

前段时间,谷歌等大厂纷纷放出自家的文本到图像模型,如Parti,等等。

有人甚至认为文本到视频生成模型还有一段时间才能到来。

没想到,Meta这次投了一颗重磅炸弹。

其实,同在今天,还有一个文本到视频生成模型Phenaki,目前已提交到ICLR 2023,由于还处于盲审阶段,作者机构还是未知。

网友称,从DALLE到Stable Diffuson再到Make-A-Video,一切来得太快。

以上是Meta公司创新SOTA模型,能够根据一句话生成惊人视频,引爆网络热潮!的详细内容。更多信息请关注PHP中文网其他相关文章!

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

AI Hentai Generator

免费生成ai无尽的。

热门文章

热工具

记事本++7.3.1

好用且免费的代码编辑器

SublimeText3汉化版

中文版,非常好用

禅工作室 13.0.1

功能强大的PHP集成开发环境

Dreamweaver CS6

视觉化网页开发工具

SublimeText3 Mac版

神级代码编辑软件(SublimeText3)

热门话题

如何检查CentOS HDFS配置

Apr 14, 2025 pm 07:21 PM

如何检查CentOS HDFS配置

Apr 14, 2025 pm 07:21 PM

检查CentOS系统中HDFS配置的完整指南本文将指导您如何有效地检查CentOS系统上HDFS的配置和运行状态。以下步骤将帮助您全面了解HDFS的设置和运行情况。验证Hadoop环境变量:首先,确认Hadoop环境变量已正确设置。在终端执行以下命令,验证Hadoop是否已正确安装并配置:hadoopversion检查HDFS配置文件:HDFS的核心配置文件位于/etc/hadoop/conf/目录下,其中core-site.xml和hdfs-site.xml至关重要。使用

centos关机命令行

Apr 14, 2025 pm 09:12 PM

centos关机命令行

Apr 14, 2025 pm 09:12 PM

CentOS 关机命令为 shutdown,语法为 shutdown [选项] 时间 [信息]。选项包括:-h 立即停止系统;-P 关机后关电源;-r 重新启动;-t 等待时间。时间可指定为立即 (now)、分钟数 ( minutes) 或特定时间 (hh:mm)。可添加信息在系统消息中显示。

CentOS上GitLab的备份方法有哪些

Apr 14, 2025 pm 05:33 PM

CentOS上GitLab的备份方法有哪些

Apr 14, 2025 pm 05:33 PM

CentOS系统下GitLab的备份与恢复策略为了保障数据安全和可恢复性,CentOS上的GitLab提供了多种备份方法。本文将详细介绍几种常见的备份方法、配置参数以及恢复流程,帮助您建立完善的GitLab备份与恢复策略。一、手动备份利用gitlab-rakegitlab:backup:create命令即可执行手动备份。此命令会备份GitLab仓库、数据库、用户、用户组、密钥和权限等关键信息。默认备份文件存储于/var/opt/gitlab/backups目录,您可通过修改/etc/gitlab

centos安装mysql

Apr 14, 2025 pm 08:09 PM

centos安装mysql

Apr 14, 2025 pm 08:09 PM

在 CentOS 上安装 MySQL 涉及以下步骤:添加合适的 MySQL yum 源。执行 yum install mysql-server 命令以安装 MySQL 服务器。使用 mysql_secure_installation 命令进行安全设置,例如设置 root 用户密码。根据需要自定义 MySQL 配置文件。调整 MySQL 参数和优化数据库以提升性能。

CentOS上PyTorch的GPU支持情况如何

Apr 14, 2025 pm 06:48 PM

CentOS上PyTorch的GPU支持情况如何

Apr 14, 2025 pm 06:48 PM

在CentOS系统上启用PyTorchGPU加速,需要安装CUDA、cuDNN以及PyTorch的GPU版本。以下步骤将引导您完成这一过程:CUDA和cuDNN安装确定CUDA版本兼容性:使用nvidia-smi命令查看您的NVIDIA显卡支持的CUDA版本。例如,您的MX450显卡可能支持CUDA11.1或更高版本。下载并安装CUDAToolkit:访问NVIDIACUDAToolkit官网,根据您显卡支持的最高CUDA版本下载并安装相应的版本。安装cuDNN库:前

docker原理详解

Apr 14, 2025 pm 11:57 PM

docker原理详解

Apr 14, 2025 pm 11:57 PM

Docker利用Linux内核特性,提供高效、隔离的应用运行环境。其工作原理如下:1. 镜像作为只读模板,包含运行应用所需的一切;2. 联合文件系统(UnionFS)层叠多个文件系统,只存储差异部分,节省空间并加快速度;3. 守护进程管理镜像和容器,客户端用于交互;4. Namespaces和cgroups实现容器隔离和资源限制;5. 多种网络模式支持容器互联。理解这些核心概念,才能更好地利用Docker。

CentOS中GitLab的数据库如何选择

Apr 14, 2025 pm 05:39 PM

CentOS中GitLab的数据库如何选择

Apr 14, 2025 pm 05:39 PM

在CentOS系统上安装和配置GitLab时,数据库的选择至关重要。GitLab兼容多种数据库,但PostgreSQL和MySQL(或MariaDB)最为常用。本文将分析数据库选择因素,并提供详细的安装和配置步骤。数据库选择指南选择数据库需要考虑以下因素:PostgreSQL:GitLab的默认数据库,功能强大,可扩展性高,支持复杂查询和事务处理,适合大型应用场景。MySQL/MariaDB:广泛应用于Web应用的流行关系型数据库,性能稳定可靠。MongoDB:NoSQL数据库,擅长处

CentOS下GitLab的日志如何查看

Apr 14, 2025 pm 06:18 PM

CentOS下GitLab的日志如何查看

Apr 14, 2025 pm 06:18 PM

CentOS系统下查看GitLab日志的完整指南本文将指导您如何查看CentOS系统中GitLab的各种日志,包括主要日志、异常日志以及其他相关日志。请注意,日志文件路径可能因GitLab版本和安装方式而异,若以下路径不存在,请检查GitLab安装目录及配置文件。一、查看GitLab主要日志使用以下命令查看GitLabRails应用程序的主要日志文件:命令:sudocat/var/log/gitlab/gitlab-rails/production.log此命令会显示produc