OpenAI编程语言加速Bert推理12倍,引擎备受关注

一行代码的威力到底有多大?今天我们要介绍的这个 Kernl 库,用户只需一行代码,在 GPU 上就能以快几倍的速度运行 Pytorch transformer 模型,从而极大的加快了模型的推理速度。

具体而言,有了 Kernl 的加持,Bert 的推理速度比 Hugging Face 基线快了 12 倍。这一成果主要得益于 Kernl 用新的 OpenAI 编程语言 Triton 和 TorchDynamo 编写了定制的 GPU 内核。项目作者来自 Lefebvre Sarrut。

GitHub 地址:https://github.com/ELS-RD/kernl/

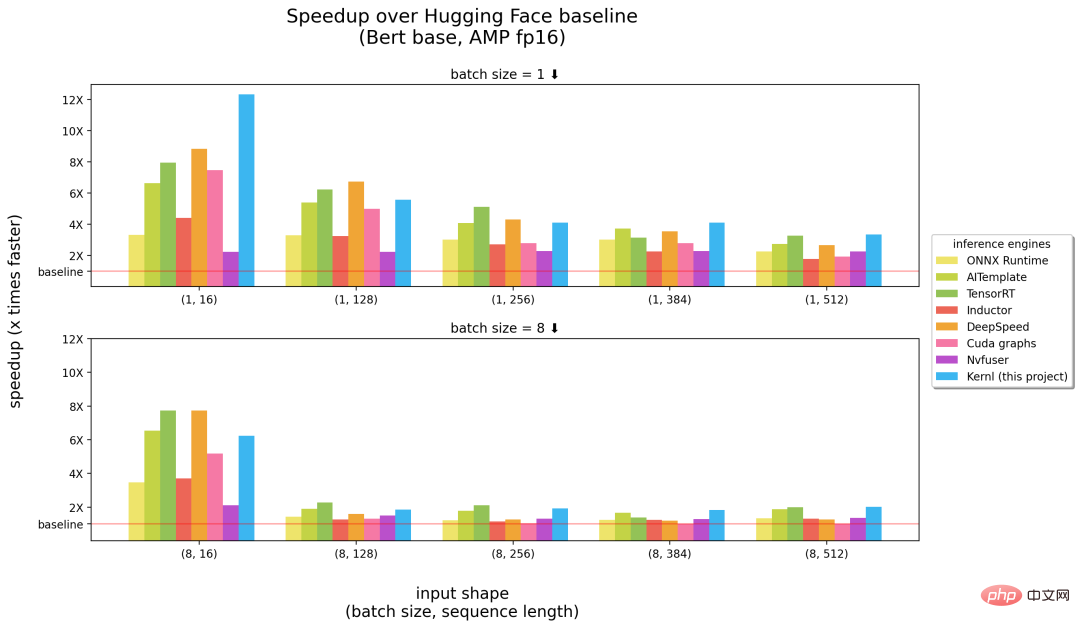

以下是 Kernl 与其他推理引擎的比较,横坐标中括号里的数字分别表示 batch size、序列长度,纵坐标为推理加速情况。

基准测试在 3090 RTX GPU 运行,以及 12 核 Intel CPU。

由上述结果可得,在长序列输入这一块,Kernl 可以说是最快的推理引擎(上图中的右半部分),在短输入序列上接近英伟达的 TensorRT(上图中的左半部分)。除此以外,Kernl 内核代码非常简短,易于理解和修改。该项目甚至添加了 Triton 调试器和工具 (基于 Fx) 来简化内核替换,因此不需要修改 PyTorch 模型源代码。

项目作者 Michaël Benesty 对这一研究进行了总结,他们发布的 Kernl 是一个用于加速 transformer 推理的库,速度非常快,有时会到达 SOTA 性能,可破解以匹配大多数 transformer 架构。

他们还在 T5 上做了测试,速度提高 6 倍,Benesty 表示这仅仅是个开始。

为什么创建 Kernl?

在 Lefebvre Sarrut,项目作者在生产中运行几个 transformers 模型,其中一些对延迟敏感,主要是搜索和 recsys。他们还在使用 OnnxRuntime 和 TensorRT,甚至创建了 transformer-deploy OSS 库来与社区分享知识。

最近,作者在测试生成语言,并努力加速它们。然而事实证明,使用传统工具做到这些非常困难。在他们看来,Onnx 是另一种有趣的格式,它是一种针对机器学习所设计的开放式文件格式,用于存储训练好的模型,具有广泛的硬件支持。

但是,当他们处理新的 LLM 架构时,Onnx 生态系统(主要是推理引擎)存在以下几种限制:

- 没有控制流的模型导出到 Onnx 很简单,这是因为可以依赖跟踪。但是动态行为更难获得;

- 与 PyTorch 不同,ONNX Runtime/TensorRT 还没有原生支持实现张量并行的多 GPU 任务;

- TensorRT 无法为具有相同配置文件的 transformer 模型管理 2 个动态轴。但由于通常希望能够提供不同长度的输入,因此需要每个批大小构建 1 个模型;

- 非常大的模型很常见,但 Onnx(作为 protobuff 文件)在文件大小方面有一些限制,需要将权重存储在模型之外来解决问题。

一个非常烦人的事实是新模型永远不会被加速,你需要等着其他人来为此编写自定义 CUDA 内核。现有解决方案并不是不好,OnnxRuntime 的一大优点是它的多硬件支持,TensorRT 则以非常快速著称。

所以,项目作者想要在 Python/PyTorch 上有像 TensorRT 一样快的优化器,这也是他们创建 Kernl 的原因。

如何做到?

内存带宽通常是深度学习的瓶颈,为了加速推理,减少内存访问往往是一个很好的策略。在短输入序列上,瓶颈通常与 CPU 开销有关,它必须被消除。项目作者主要利用了以下 3 项技术:

首先是 OpenAI Triton,它是一种编写 CUDA 等 GPU 内核的语言,不要将它与 Nvidia Triton 推理服务器混淆,它的效率更高。几个操作的融合实现了改进,使得他们不在 GPU 内存中保留中间结果的情况下链接计算。作者使用它重写注意力(由 Flash Attention 替换)、线性层和激活以及 Layernorm/Rmsnorm。

其次是 CUDA 图。在预热(warmup)步骤中,它将保存每个启动的内核及它们的参数。然后,项目作者重建了整个推理过程。

最后是 TorchDynamo,这个由 Meta 提出的原型机帮助项目作者应对动态行为。在预热步骤中,它会跟踪模型并提供一个 Fx 图(静态计算图)。他们使用自己的内核替换了 Fx 图的一些操作,并在 Python 中重新编译。

未来,项目路线图将涵盖更快的预热、ragged 推理(padding 中没有损失计算)、训练支持(长序列支持)、多 GPU 支持(多并行化模式)、量化(PTQ)、新 batch 的 Cutlass 内核测试以及提升硬件支持等。

更多详细内容请参阅原项目。

以上是OpenAI编程语言加速Bert推理12倍,引擎备受关注的详细内容。更多信息请关注PHP中文网其他相关文章!

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

AI Hentai Generator

免费生成ai无尽的。

热门文章

热工具

记事本++7.3.1

好用且免费的代码编辑器

SublimeText3汉化版

中文版,非常好用

禅工作室 13.0.1

功能强大的PHP集成开发环境

Dreamweaver CS6

视觉化网页开发工具

SublimeText3 Mac版

神级代码编辑软件(SublimeText3)

热门话题

Debian邮件服务器防火墙配置技巧

Apr 13, 2025 am 11:42 AM

Debian邮件服务器防火墙配置技巧

Apr 13, 2025 am 11:42 AM

配置Debian邮件服务器的防火墙是确保服务器安全性的重要步骤。以下是几种常用的防火墙配置方法,包括iptables和firewalld的使用。使用iptables配置防火墙安装iptables(如果尚未安装):sudoapt-getupdatesudoapt-getinstalliptables查看当前iptables规则:sudoiptables-L配置

debian readdir如何与其他工具集成

Apr 13, 2025 am 09:42 AM

debian readdir如何与其他工具集成

Apr 13, 2025 am 09:42 AM

Debian系统中的readdir函数是用于读取目录内容的系统调用,常用于C语言编程。本文将介绍如何将readdir与其他工具集成,以增强其功能。方法一:C语言程序与管道结合首先,编写一个C程序调用readdir函数并输出结果:#include#include#includeintmain(intargc,char*argv[]){DIR*dir;structdirent*entry;if(argc!=2){

debian readdir如何实现文件排序

Apr 13, 2025 am 09:06 AM

debian readdir如何实现文件排序

Apr 13, 2025 am 09:06 AM

在Debian系统中,readdir函数用于读取目录内容,但其返回的顺序并非预先定义的。要对目录中的文件进行排序,需要先读取所有文件,再利用qsort函数进行排序。以下代码演示了如何在Debian系统中使用readdir和qsort对目录文件进行排序:#include#include#include#include//自定义比较函数,用于qsortintcompare(constvoid*a,constvoid*b){returnstrcmp(*(

Debian邮件服务器SSL证书安装方法

Apr 13, 2025 am 11:39 AM

Debian邮件服务器SSL证书安装方法

Apr 13, 2025 am 11:39 AM

在Debian邮件服务器上安装SSL证书的步骤如下:1.安装OpenSSL工具包首先,确保你的系统上已经安装了OpenSSL工具包。如果没有安装,可以使用以下命令进行安装:sudoapt-getupdatesudoapt-getinstallopenssl2.生成私钥和证书请求接下来,使用OpenSSL生成一个2048位的RSA私钥和一个证书请求(CSR):openss

Debian OpenSSL如何进行数字签名验证

Apr 13, 2025 am 11:09 AM

Debian OpenSSL如何进行数字签名验证

Apr 13, 2025 am 11:09 AM

在Debian系统上使用OpenSSL进行数字签名验证,可以按照以下步骤操作:准备工作安装OpenSSL:确保你的Debian系统已经安装了OpenSSL。如果没有安装,可以使用以下命令进行安装:sudoaptupdatesudoaptinstallopenssl获取公钥:数字签名验证需要使用签名者的公钥。通常,公钥会以文件的形式提供,例如public_key.pe

Debian OpenSSL如何防止中间人攻击

Apr 13, 2025 am 10:30 AM

Debian OpenSSL如何防止中间人攻击

Apr 13, 2025 am 10:30 AM

在Debian系统中,OpenSSL是一个重要的库,用于加密、解密和证书管理。为了防止中间人攻击(MITM),可以采取以下措施:使用HTTPS:确保所有网络请求使用HTTPS协议,而不是HTTP。HTTPS使用TLS(传输层安全协议)加密通信数据,确保数据在传输过程中不会被窃取或篡改。验证服务器证书:在客户端手动验证服务器证书,确保其可信。可以通过URLSession的委托方法来手动验证服务器

Debian Hadoop日志管理怎么做

Apr 13, 2025 am 10:45 AM

Debian Hadoop日志管理怎么做

Apr 13, 2025 am 10:45 AM

在Debian上管理Hadoop日志,可以遵循以下步骤和最佳实践:日志聚合启用日志聚合:在yarn-site.xml文件中设置yarn.log-aggregation-enable为true,以启用日志聚合功能。配置日志保留策略:设置yarn.log-aggregation.retain-seconds来定义日志的保留时间,例如保留172800秒(2天)。指定日志存储路径:通过yarn.n

centos关机命令行

Apr 14, 2025 pm 09:12 PM

centos关机命令行

Apr 14, 2025 pm 09:12 PM

CentOS 关机命令为 shutdown,语法为 shutdown [选项] 时间 [信息]。选项包括:-h 立即停止系统;-P 关机后关电源;-r 重新启动;-t 等待时间。时间可指定为立即 (now)、分钟数 ( minutes) 或特定时间 (hh:mm)。可添加信息在系统消息中显示。