乔姆斯基对ChatGPT的追捧提出质疑,认为是浪费资源

ChatGPT 掀起了科技领域最新的一轮军备竞赛,但留给 AI 领域的议题还有很多:ChatGPT 是一种真正的创新吗?是否意味着初步的通用人工智能?很多学者持有不同看法,这种讨论随着新技术的热度而愈发热烈。

那么语言学领域的大佬们如何看待 ChatGPT 的进步呢?特别是乔老爷子 —— 语言学巨头乔姆斯基。

近日,美国哲学家、语言学家、认知科学家诺姆・乔姆斯基、剑桥大学语言学教授 Ian Roberts 以及科技公司 Oceanit 人工智能总监 、哲学家 Jeffrey Watumull 在《纽约时报》撰文,对大语言模型的缺陷进行了批判。

为了追赶 ChatGPT 的步伐,谷歌发布了 Bard,微软也推出了 Sydney。乔姆斯基承认,OpenAI 的 ChatGPT、谷歌的 Bard 和微软的 Sydney 都是机器学习的奇迹。

笼统地说,它们获取大量数据,在其中搜索规律,并越来越熟练地生成统计上可能的输出 —— 比如看似人性化的语言和思想。

这些程序被誉为通用人工智能地平线上的第一缕曙光 —— 那是一个长期预言的时刻,届时机械思维不仅会在处理速度和内存大小方面超越人类大脑,而且还会在洞察力、艺术创造力,以及所有其他独特的人类能力方面上超越人类。

但乔姆斯基更多的观点在于批判,特别是对于 ChatGPT 的能力缺陷和道德水准:「今天,我们在人工智能方面所谓的革命性进步确实令人既担忧又乐观。乐观,是因为智慧是我们解决问题的手段,担忧是因为我们担心最流行和最时髦的人工智能 —— 机器学习,将通过将有根本缺陷的语言和知识概念纳入我们的技术,而降低我们的科学水平并拉低我们的道德规范。」

客观上,那一天可能终究会到来,但曙光还没有出现,这与夸张的新闻标题和不明智的投资所预料的情况正好相反。

现在,让我们看看乔姆斯基的文章还说了什么。

ChatGPT 缺乏任何智能的关键能力

阿根廷作家豪尔赫・路易斯・博尔赫斯(Jorge Luis Borges)曾写道,生活在一个既充满危险又充满希望的时代,既是悲剧又是喜剧,在理解我们自己和这个世界时「启示迫在眉睫」。

「如果像 ChatGPT 这样的机器学习程序继续主导人工智能领域,博尔赫斯式的理解启示没有且未来也不会发生。」

不管这些程序在某些狭窄的领域中多么有用(例如,它们可以在计算机编程中有所帮助,或者在为诗词押韵建议方面很有帮助),我们从语言学和知识哲学中知道它们与人类推理和实用语言的方式有很大的不同。这些差异极大地限制了这些程序的功能,使它们带有无法根除的缺陷。

正如博尔赫斯可能指出的那样,如此多的金钱和注意力被集中在这么小的一件事上,这既是喜剧又是悲剧 —— 与人类的思想相比,这是微不足道的,用德国哲学家威廉・冯・洪堡的话来说,人类的思想是通过语言,可以「无限地使用有限的手段」,创造出具有普遍影响力的思想和理论。

人脑不像 ChatGPT 及其同类产品那样,是一个笨拙的模式匹配统计引擎,吞噬数百 TB 的数据并推断出最可能的对话响应或最可能的科学问题答案。相反,人的大脑是一个非常高效甚至优雅的系统,只需要少量信息即可运作;它不寻求推断数据点之间的直接相关性,而是寻求解释。

比如一个正在学习一门语言的小孩正在无意识地、自动地、快速地从极小的数据中发展出一种语法,一种由逻辑原则和参数组成的极其复杂的系统。这种语法可以理解为先天的、遗传安装的「操作系统」的表达,它赋予人类产生复杂句子和长串思路的能力。

当语言学家试图发展一种理论来解释为什么给定的语言会这样工作时(为什么这些 —— 而不是那些句子被认为是合乎语法的?),他们正在有意识地、费力地构建孩子本能构建的语法的明确版本,同时在这个过程中尽可能少地接触信息。孩子的操作系统与机器学习程序的操作系统完全不同。

实际上,ChatGPT 这样的程序停留在认知进化前的人类或非人类阶段。它们最深的缺陷是缺乏任何智能的关键能力:不仅可以说出情况是什么、已经发生了什么以及将要发生什么 —— 这是描述和预测 —— 而且还可以说出这种情况不是什么,以及可能发生什么,不应发生什么。这些是解释的成分,是真正智慧的标志。

这里有一个例子:假设你手里拿着一个苹果,现在让苹果掉下来,你观察结果并说:「苹果掉下来了。」这就是一种描述。预测的说法则是「如果我张开手,苹果就会掉下来」。两者都是有价值的,而且都可能是正确的。

但解释意味着更多的东西。它不仅包括描述和预测,还包括反事实的猜想,如 「任何这样的物体都会掉下来」,再加上附加条款「因为引力」或「因为时空的曲率」或其他,这就是一个因果解释。「如果不是因为引力,苹果就不会掉下来」,这就是思维。

机器学习的核心是描述和预测;它没有提出任何因果机制或物理规律。当然,任何人类式的解释都不一定正确;我们是易变的。但这也是思考的部分含义:要想正确,必须有可能出错。智能不仅包括创造性的猜想,也包括创造性的批评。人类式的思考是基于可能的解释和纠错,这个过程逐渐限制了可以理性地考虑的可能性。

正如夏洛克・福尔摩斯对华生所说:「当你排除了不可能,剩下的任何东西,无论多么不可能,都肯定是真理。」

但是从设计上来说,ChatGPT 和类似的程序在它们能够「学习」(也就是记忆)的内容方面是没有限制的;它们没有能力区分「可能」和「不可能」。例如,人类被赋予了一种通用的语法,将我们能够学习的语言限制在某种近乎数学的优雅上,而这些程序则以同样的方式学习人类可能的和不可能的语言。人类在我们可以合理猜测的解释种类方面受到限制,而机器学习系统可以学习地球是平的和地球是圆的。它们只是在随时间变化的概率中进行交易。

由于这个原因,机器学习系统的预测将永远是肤浅和可疑的。例如,由于这些程序无法解释英语语法规则,它们很可能错误地预测「约翰太固执了,不愿意和他说话」,其意味着约翰太固执了,他不会和某人或其他人说话(而不是说他太固执了,不愿意被说教)。为什么机器学习程序会预测出如此奇怪的事情?因为它可能会把它从「约翰吃了一个苹果」和「约翰吃了」这样的句子中推断出来的模式进行类比,后者确实是指约翰吃了什么或其他东西。该程序很可能预测,因为「约翰太固执了,不愿意和比尔说话」与「约翰吃了一个苹果」相似,所以「约翰太固执了,不愿意和他说话」应该与「约翰吃了」相似。对语言的正确解释是复杂的,并不是仅仅通过在大数据中浸泡就能学会。

反常的是,一些机器学习爱好者似乎很自豪,他们的作品可以产生正确的「科学」预测(例如关于物理体的运动),而不使用解释(例如牛顿的运动定律和普遍引力)。但这种预测即使成功了也是伪科学。虽然科学家们肯定会寻求有高度经验佐证的理论,但正如哲学家卡尔 - 波普尔所指出的:「我们寻求的不是高度可能的理论而是解释,也就是强大而高度不可能的理论。」

苹果落到地球上是因为那是它们的「自然位置」(亚里士多德的观点)的理论是可能的,但它只会导致进一步的问题:为什么地球是它们的自然位置?

苹果落到地上是因为质量使时空弯曲的理论(爱因斯坦的观点)是非常不可能的,但它实际上告诉了你为什么它们会掉下来。

真正的智能表现在思考和表达事物的能力,而不是仅有洞察力。

真正的智能也是能够进行道德思考的。这意味着要用一套道德原则来约束我们头脑中本来无限的创造力,确定什么是应该的、什么是不应该的(当然也要让这些原则本身受到创造性的批评)。为了有用,ChatGPT 必须被授权产生新颖的输出;为了被大多数用户接受,它必须避免道德上令人反感的内容。但 ChatGPT 和其他 ML 奇迹的程序员一直在努力并将继续努力实现这种平衡。

例如,2016 年,微软的 Tay 聊天机器人(ChatGPT 的前身)在互联网上充斥着厌恶女性和种族主义的内容,因为它被网络上的「恶魔」污染了,这些恶魔用训练数据填充它。未来如何解决这个问题?由于缺乏从道德原则出发的推理能力,ChatGPT 被其程序员粗暴地限制了对有争议的讨论做出任何新的贡献,但这也是重要的 ——ChatGPT 为一种非道德性牺牲了创造力。

看一下我们中的一个人(Watumull 博士)最近与 ChatGPT 的交流:关于改造火星使其能够支持人类生命是否符合道德。

请注意,所有看似复杂的思想和语言,都是由不够智能而产生的道德层面的冷漠。在这里,ChatGPT 表现出类似于「邪恶」的平庸:剽窃、冷漠和顺从。它以一种超级自动完成的方式总结了文献中的标准论点,拒绝在任何事情上采取立场,不仅辩称无知,而且辩称缺乏智慧,最终提供了一个「只是服从命令」的借口,将责任推卸给它的创造者。

简而言之,ChatGPT 和它的竞品们在结构上无法平衡创造力和约束。他们要么过度地生成(既产生真理也产生谬误,认可道德的和不道德的决定),要么生成不足(表现出对任何决定的不承诺和对后果的漠不关心)。鉴于这些系统的非道德性、假科学性和语言无能,我们对它的火热只能哭笑不得。

ChatGPT 真的不值得被歌颂吗?

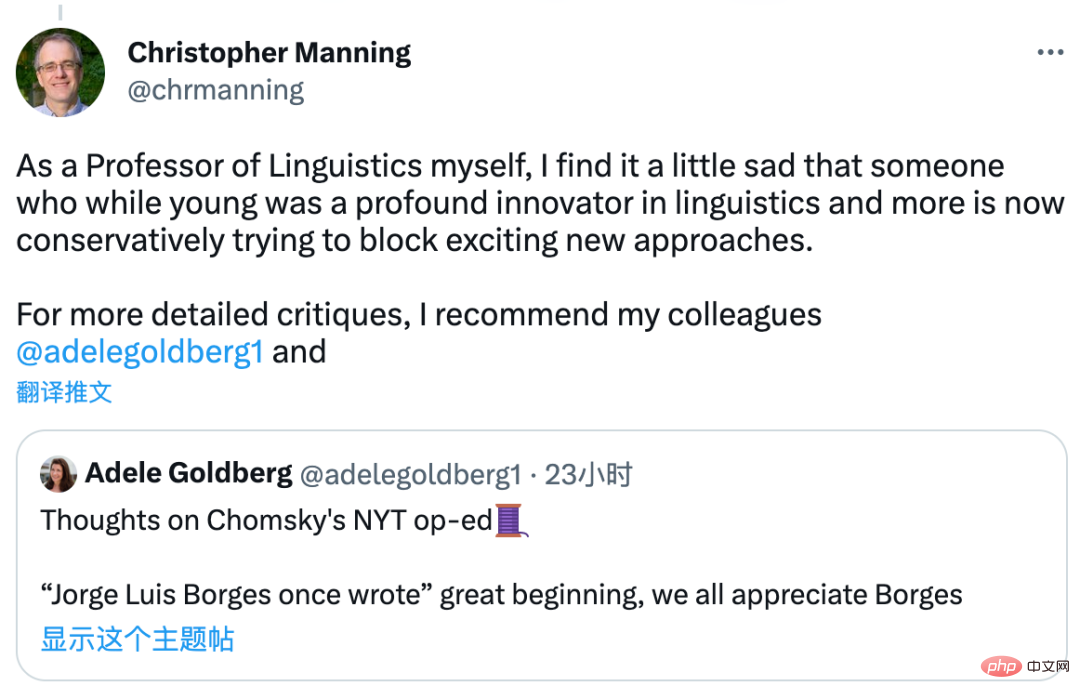

乔姆斯基对 ChatGPT 的评论,引起了业内的讨论,斯坦福大学教授、NLP 领域著名学者克里斯托弗・曼宁表示,他不是在针对 ChatGPT 的某种算法错误,而是针对了所有机器学习算法,且说法有些夸张了:「这确实是一篇主观的文章。甚至连粗略的尝试都没有,以检查容易被驳斥的主张。」

他甚至觉得有点难过:乔姆斯基试图阻止这些新方法。这里他也推荐语言学家 Adele Goldberg 对这篇文章的看法。

DeepMind 研究总监及深度学习负责人 Oriol Vinyals 则选择站在「实践者」的一方:「批评很容易,而且会在这些天得到很多关注。而且我们都知道,注意力是(某些人)所需要的。对那些建设者来说:你们很了不起!」

你怎么看呢?

以上是乔姆斯基对ChatGPT的追捧提出质疑,认为是浪费资源的详细内容。更多信息请关注PHP中文网其他相关文章!

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

AI Hentai Generator

免费生成ai无尽的。

热门文章

热工具

记事本++7.3.1

好用且免费的代码编辑器

SublimeText3汉化版

中文版,非常好用

禅工作室 13.0.1

功能强大的PHP集成开发环境

Dreamweaver CS6

视觉化网页开发工具

SublimeText3 Mac版

神级代码编辑软件(SublimeText3)

热门话题

如何配置Debian Apache日志格式

Apr 12, 2025 pm 11:30 PM

如何配置Debian Apache日志格式

Apr 12, 2025 pm 11:30 PM

本文介绍如何在Debian系统上自定义Apache的日志格式。以下步骤将指导您完成配置过程:第一步:访问Apache配置文件Debian系统的Apache主配置文件通常位于/etc/apache2/apache2.conf或/etc/apache2/httpd.conf。使用以下命令以root权限打开配置文件:sudonano/etc/apache2/apache2.conf或sudonano/etc/apache2/httpd.conf第二步:定义自定义日志格式找到或

Tomcat日志如何帮助排查内存泄漏

Apr 12, 2025 pm 11:42 PM

Tomcat日志如何帮助排查内存泄漏

Apr 12, 2025 pm 11:42 PM

Tomcat日志是诊断内存泄漏问题的关键。通过分析Tomcat日志,您可以深入了解内存使用情况和垃圾回收(GC)行为,从而有效定位和解决内存泄漏。以下是如何利用Tomcat日志排查内存泄漏:1.GC日志分析首先,启用详细的GC日志记录。在Tomcat启动参数中添加以下JVM选项:-XX: PrintGCDetails-XX: PrintGCDateStamps-Xloggc:gc.log这些参数会生成详细的GC日志(gc.log),包含GC类型、回收对象大小和时间等信息。分析gc.log

debian readdir如何实现文件排序

Apr 13, 2025 am 09:06 AM

debian readdir如何实现文件排序

Apr 13, 2025 am 09:06 AM

在Debian系统中,readdir函数用于读取目录内容,但其返回的顺序并非预先定义的。要对目录中的文件进行排序,需要先读取所有文件,再利用qsort函数进行排序。以下代码演示了如何在Debian系统中使用readdir和qsort对目录文件进行排序:#include#include#include#include//自定义比较函数,用于qsortintcompare(constvoid*a,constvoid*b){returnstrcmp(*(

如何优化debian readdir的性能

Apr 13, 2025 am 08:48 AM

如何优化debian readdir的性能

Apr 13, 2025 am 08:48 AM

在Debian系统中,readdir系统调用用于读取目录内容。如果其性能表现不佳,可尝试以下优化策略:精简目录文件数量:尽可能将大型目录拆分成多个小型目录,降低每次readdir调用处理的项目数量。启用目录内容缓存:构建缓存机制,定期或在目录内容变更时更新缓存,减少对readdir的频繁调用。内存缓存(如Memcached或Redis)或本地缓存(如文件或数据库)均可考虑。采用高效数据结构:如果自行实现目录遍历,选择更高效的数据结构(例如哈希表而非线性搜索)存储和访问目录信

Debian syslog如何配置防火墙规则

Apr 13, 2025 am 06:51 AM

Debian syslog如何配置防火墙规则

Apr 13, 2025 am 06:51 AM

本文介绍如何在Debian系统中使用iptables或ufw配置防火墙规则,并利用Syslog记录防火墙活动。方法一:使用iptablesiptables是Debian系统中功能强大的命令行防火墙工具。查看现有规则:使用以下命令查看当前的iptables规则:sudoiptables-L-n-v允许特定IP访问:例如,允许IP地址192.168.1.100访问80端口:sudoiptables-AINPUT-ptcp--dport80-s192.16

Debian syslog如何学习

Apr 13, 2025 am 11:51 AM

Debian syslog如何学习

Apr 13, 2025 am 11:51 AM

本指南将指导您学习如何在Debian系统中使用Syslog。Syslog是Linux系统中用于记录系统和应用程序日志消息的关键服务,它帮助管理员监控和分析系统活动,从而快速识别并解决问题。一、Syslog基础知识Syslog的核心功能包括:集中收集和管理日志消息;支持多种日志输出格式和目标位置(例如文件或网络);提供实时日志查看和过滤功能。二、安装和配置Syslog(使用Rsyslog)Debian系统默认使用Rsyslog。您可以通过以下命令安装:sudoaptupdatesud

Debian Nginx日志路径在哪里

Apr 12, 2025 pm 11:33 PM

Debian Nginx日志路径在哪里

Apr 12, 2025 pm 11:33 PM

Debian系统中,Nginx的访问日志和错误日志默认存储位置如下:访问日志(accesslog):/var/log/nginx/access.log错误日志(errorlog):/var/log/nginx/error.log以上路径是标准DebianNginx安装的默认配置。如果您在安装过程中修改过日志文件存放位置,请检查您的Nginx配置文件(通常位于/etc/nginx/nginx.conf或/etc/nginx/sites-available/目录下)。在配置文件中

Debian邮件服务器SSL证书安装方法

Apr 13, 2025 am 11:39 AM

Debian邮件服务器SSL证书安装方法

Apr 13, 2025 am 11:39 AM

在Debian邮件服务器上安装SSL证书的步骤如下:1.安装OpenSSL工具包首先,确保你的系统上已经安装了OpenSSL工具包。如果没有安装,可以使用以下命令进行安装:sudoapt-getupdatesudoapt-getinstallopenssl2.生成私钥和证书请求接下来,使用OpenSSL生成一个2048位的RSA私钥和一个证书请求(CSR):openss