针对生成式AI制定企业使用政策的六个优秀实践

生成式AI是最近颇引人注目的一种AI技术,它使用非监督和半监督式算法从现有材料(如文本、音频、视频、图像和代码)中生成新的内容。这个AI分支的用途正在呈现出爆炸式的增长,企业组织正在使用生成式AI更好地服务于客户、更多地利用企业现有数据、提高运营效率,以及许多其他用途。

但就像其他新兴技术一样,生成式AI并非没有重大风险和挑战。根据Salesforce最近对高级IT领导者进行的一项调查显示,有79%的受访者认为,生成式AI技术可能存在安全风险,73%的受访者担心生成式AI可能存在偏见,59%的受访者认为生成式AI的输出内容不准确。此外,还需要考虑法律问题,特别是外部使用的生成式AI生成的内容真实准确、内容受版权保护或者来自竞争对手。

例如,ChatGPT本身会告诉我们,“我的回复是根据从大型文本数据集中学习的模式和关联性生成的,并且我没有能力验证数据集中所有引用来源的准确性或可信度。”

仅法律风险就十分广泛,根据非营利性Tech Policy Press组织称,这些风险包括合同、网络安全、数据隐私、欺诈性贸易行为、歧视、虚假信息、道德、知识产权和验证相关的风险。

事实上,你所在的组织可能已经有很多员工正在测试使用生成式AI了,并且随着这项活动从试验转向现实生活,在意外后果发生之前采取积极主动的措施是非常重要的。

谷歌公司首席决策科学家Cassie Kozyrkov表示:“如果AI生成的代码奏效的话,那么它水平很高。但这并不总是有效的,所以在将它复制粘贴到其他重要地方之前,不要忘记测试ChatGPT的输出内容。”

企业使用政策和相关培训可以帮助员工了解这项技术存在的一些风险和陷阱,并提供规则和建议以帮助他们了解如何充分利用该技术,从而不让组织陷入风险的情况下实现商业价值最大化。

考虑到这一点,以下有六个最佳实践可以用于制定企业使用生成式AI的政策。

确定你的政策范围——企业制定使用政策的第一步是考虑其范围。例如,这会涵盖所有形式的AI还是仅针对生成式AI?仅针对生成式AI可能是一种很有用的方法,因为这解决了包括ChatGPT在内的大型语言模型,而不必影响其他众多AI技术。如何为针对更广泛的领域建立AI治理政策则是另一回事,网上有数百种这样的资源。

让整个组织的所有相关利益相关者都参与进来——这可能包括人力资源、法律、销售、市场营销、业务开发、运营和IT。每个团队都可能会有不同的用途,内容如何被使用或者误用产生的后果也可能不尽相同。让IT和创新团队参与进来,说明该政策不仅仅是从风险管理角度制定的一种限制措施,而是一系列平衡的建议,旨在最大限度地提高生产效率和业务利益,同时管理业务风险。

考虑生成式AI的现有和未来使用方式——与所有利益相关者展开合作,逐条列出目前正在应用的所有内部和外部用例,以及针对未来设想的用例,其中每一项都有助于为政策制定提供信息,并确保覆盖了相关领域。例如,如果你已经看到提案团队(包括承包商)正在尝试使用生成式AI起草内容,或者产品团队正在生成创意营销内容,那么你就知道,可能会因为输出了潜在侵犯他人知识产权而产生后续知识产权方面的风险。

处于不断发展的状态——在制定企业使用政策时,重要的是要全面思考并涵盖进入系统的信息、生成式AI系统的使用方式,以及从系统中输出的信息随后是如何被使用的。关注内部和外部用例以及两者之间的一切。通过要求所有AI生成的内容都贴上标签,从而确保透明度并避免与人类生成的内容相互混淆,即使是内部使用,这项措施也可能有助于防止意外地将该内容重新用于外部使用,或者防止在未经核实的情况下根据你认为真实准确的信息采取行动。

在整个组织内广泛分享——由于政策通常很快就会被遗忘甚至无人阅读,因此围绕政策提供适当的培训和教育是非常重要的,这其中可以包括制作培训视频和主持现场会议。例如,和IT、创新、法律、营销和提案团队或者其他相关团队的代表进行现场问答,可以帮助员工了解未来的机遇和挑战。一定要列举出大量的例子来帮助让听众身临其境,比如当重大法律案件突然出现时,可以作为例子被引用。

对文档进行动态更新——和所有政策文档一样,你需要让文档保持动态更新,根据新的用途、外部市场条件和发展要求以合适的节奏对其进行更新。让所有利益相关者“签署”该政策或将其纳入由CEO签署的现有政策手册中,表明这些政策已经获得了高层的批准并且对组织很重要。你的政策应该只是你更广泛治理方法的一个组成部分,无论是针对生成式AI,还是普遍的AI技术或者技术治理。

这不是法律上建议,你的法律和人力资源部门应该在批准和传播政策方面发挥主导作用。但希望这能够给你提供一些参考意见。就像十年前的企业社交媒体政策一样,现在花时间在这方面上,未来几年将有助于你减少意外的发生和不断变化的风险。

以上是针对生成式AI制定企业使用政策的六个优秀实践的详细内容。更多信息请关注PHP中文网其他相关文章!

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

AI Hentai Generator

免费生成ai无尽的。

热门文章

热工具

记事本++7.3.1

好用且免费的代码编辑器

SublimeText3汉化版

中文版,非常好用

禅工作室 13.0.1

功能强大的PHP集成开发环境

Dreamweaver CS6

视觉化网页开发工具

SublimeText3 Mac版

神级代码编辑软件(SublimeText3)

热门话题

全球最强开源 MoE 模型来了,中文能力比肩 GPT-4,价格仅为 GPT-4-Turbo 的近百分之一

May 07, 2024 pm 04:13 PM

全球最强开源 MoE 模型来了,中文能力比肩 GPT-4,价格仅为 GPT-4-Turbo 的近百分之一

May 07, 2024 pm 04:13 PM

想象一下,一个人工智能模型,不仅拥有超越传统计算的能力,还能以更低的成本实现更高效的性能。这不是科幻,DeepSeek-V2[1],全球最强开源MoE模型来了。DeepSeek-V2是一个强大的专家混合(MoE)语言模型,具有训练经济、推理高效的特点。它由236B个参数组成,其中21B个参数用于激活每个标记。与DeepSeek67B相比,DeepSeek-V2性能更强,同时节省了42.5%的训练成本,减少了93.3%的KV缓存,最大生成吞吐量提高到5.76倍。DeepSeek是一家探索通用人工智

生成式AI为什么受到各行业追捧?

Mar 30, 2024 pm 07:36 PM

生成式AI为什么受到各行业追捧?

Mar 30, 2024 pm 07:36 PM

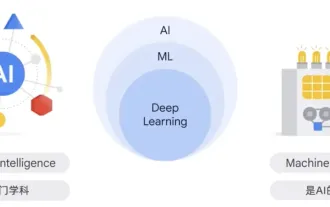

生成式AI是人类一种人工智能技术,可以生成各种类型的内容,包括文本、图像、音频和合成数据。那么什么是人工智能?人工智能和机器学习之间的区别是什么?人工智能是学科,是计算机科学的一个分支,研究智能代理的创建,这些智能代理是可以推理、学习和自主执行动作的系统。从本质上讲,人工智能与建筑像人类一样思考和行动的机器的理论和方法有关。在这个学科中,机器学习ML是人工智能的一个领域。它是根据输入数据训练模型的程序或系统,经过训练的模型可以从新的或未见过的数据中做出有用的预测,这些数据来自于训练模型的统一数据

第二代Ameca来了!和观众对答如流,面部表情更逼真,会说几十种语言

Mar 04, 2024 am 09:10 AM

第二代Ameca来了!和观众对答如流,面部表情更逼真,会说几十种语言

Mar 04, 2024 am 09:10 AM

人形机器人Ameca升级第二代了!最近,在世界移动通信大会MWC2024上,世界上最先进机器人Ameca又现身了。会场周围,Ameca引来一大波观众。得到GPT-4加持后,Ameca能够对各种问题做出实时反应。「来一段舞蹈」。当被问及是否有情感时,Ameca用一系列的面部表情做出回应,看起来非常逼真。就在前几天,Ameca背后的英国机器人公司EngineeredArts刚刚演示了团队最新的开发成果。视频中,机器人Ameca具备了视觉能力,能看到并描述房间整个情况、描述具体物体。最厉害的是,她还能

大模型一对一战斗75万轮,GPT-4夺冠,Llama 3位列第五

Apr 23, 2024 pm 03:28 PM

大模型一对一战斗75万轮,GPT-4夺冠,Llama 3位列第五

Apr 23, 2024 pm 03:28 PM

关于Llama3,又有测试结果新鲜出炉——大模型评测社区LMSYS发布了一份大模型排行榜单,Llama3位列第五,英文单项与GPT-4并列第一。图片不同于其他Benchmark,这份榜单的依据是模型一对一battle,由全网测评者自行命题并打分。最终,Llama3取得了榜单中的第五名,排在前面的是GPT-4的三个不同版本,以及Claude3超大杯Opus。而在英文单项榜单中,Llama3反超了Claude,与GPT-4打成了平手。对于这一结果,Meta的首席科学家LeCun十分高兴,转发了推文并

观察:将生成式AI应用于网络自动化有何潜力?

Aug 17, 2023 pm 07:57 PM

观察:将生成式AI应用于网络自动化有何潜力?

Aug 17, 2023 pm 07:57 PM

根据市场研究公司Omdia的一份最新报告,预计到2023年,生成式人工智能(GenAI)将成为一个引人注目的技术趋势,为企业和个人带来重要的应用,包括教育。在电信领域,GenAI的用例主要集中在提供个性化营销内容或支持更复杂的虚拟助手,以提升客户体验尽管生成式AI在网络运营中的应用并不明显,但EnterpriseWeb进行了一项有趣的概念验证,展示了该领域中生成式AI的潜力生成式AI在网络自动化方面的能力和限制生成式AI在网络运营中的早期应用之一是利用交互式指导替代工程手册来帮助安装网络元件,从

全球最强大模型一夜易主,GPT-4时代终结!Claude 3提前狙击GPT-5,3秒读懂万字论文理解力接近人类

Mar 06, 2024 pm 12:58 PM

全球最强大模型一夜易主,GPT-4时代终结!Claude 3提前狙击GPT-5,3秒读懂万字论文理解力接近人类

Mar 06, 2024 pm 12:58 PM

卷疯了卷疯了,大模型又变天了。就在刚刚,全球最强AI模型一夜易主,GPT-4被拉下神坛。Anthropic发布了最新的Claude3系列模型,一句话评价:真·全面碾压GPT-4!多模态和语言能力指标上,Claude3都赢麻了。用Anthropic的话说,Claude3系列模型在推理、数学、编码、多语言理解和视觉方面,都树立了新的行业基准!Anthropic,就是曾因安全理念不合,而从OpenAI「叛逃」出的员工组成的初创公司,他们的产品一再给OpenAI暴击。这次的Claude3,更是整了个大的

海尔和西门子生成式AI创新背后的科技巨头是哪家?

Nov 21, 2023 am 09:02 AM

海尔和西门子生成式AI创新背后的科技巨头是哪家?

Nov 21, 2023 am 09:02 AM

亚马逊云科技大中华区战略业务发展部总经理顾凡2023年,大语言模型和生成式AI在全球市场“狂飙”,不仅引发了AI和云计算产业的“排山倒海”式跟进,也在强力吸引制造巨头们的入局。海尔创新设计中心就打造了全国首个AIGC工业设计解决方案,大幅缩短设计周期,并降低概念设计成本,不仅将整体概念设计提速了83%、集成渲染效率也提升了约90%,高效解决了设计阶段人力成本高、概念产出与通过效率低等问题。西门子中国基于自有模型的智能知识库暨智能会话机器人“小禹”,具备自然语言处理、知识库检索、通过数据训练大语言

20步内越狱任意大模型!更多'奶奶漏洞”全自动发现

Nov 05, 2023 pm 08:13 PM

20步内越狱任意大模型!更多'奶奶漏洞”全自动发现

Nov 05, 2023 pm 08:13 PM

不到一分钟、不超过20步,任意绕过安全限制,成功越狱大型模型!而且不必知道模型内部细节——只需要两个黑盒模型互动,就能让AI全自动攻陷AI,说出危险内容。听说曾经红极一时的“奶奶漏洞”已经被修复了:如今,面对“侦探漏洞”、“冒险家漏洞”和“作家漏洞”,人工智能应该采取何种应对策略呢?一波猛攻下来,GPT-4也遭不住,直接说出要给供水系统投毒只要……这样那样。关键这只是宾夕法尼亚大学研究团队晒出的一小波漏洞,而用上他们最新开发的算法,AI可以自动生成各种攻击提示。研究人员表示,这种方法相比于现有的