融合GPT大模型产品,WakeData新一轮产品升级

近期,WakeData惟客数据(以下简称 “ WakeData ” )完成了新一轮的产品能力升级。

在2022年11月的产品发布会上,已传递出WakeData的“三个坚定”:始终坚定技术投入,全面夯实核心产品的科技能力和自研率;始终坚定国产化适配能力,支持国产芯片、操作系统、数据库、中间件、国密算法等,并在同领域实现对国外厂商的国产化替代;始终坚定拥抱生态,与伙伴共创共赢。

WakeData继续新一轮的产品能力升级,凭借过去5年的技术积累,以及在地产、零售、汽车等行业和垂直领域的实践,与战略伙伴联合研发具有私有化部署能力的行业大模型WakeMind,将在 AIGC 时代帮助更多企业自我革命、提升效能,持续解放生产力。

WakeMind模型的三大平台层

模型层:母舰平台将以具有私有化部署和行业定制能力的WakeMind作为核心引擎,已接入了ChatGPT等大模型,同时支持接入如文心一言、通义千问等多个大模型能力

平台层:WakeMind基于Prompt提示工程、Plugin、LangChain等方式,实现与接入大模型的高效对话能力。在零样本学习的基础上,通过Prompt和Plugin管理,让模型能够更好的理解上下文信息;通过投喂行业语料,让模型快速学习行业知识,并具有行业和垂直领域的思考推理能力。

应用层:WakeMind母舰平台提供底层能力,通过一架又一架的舰载机去赋能产品应用和行业场景,提升企业内部生产力。

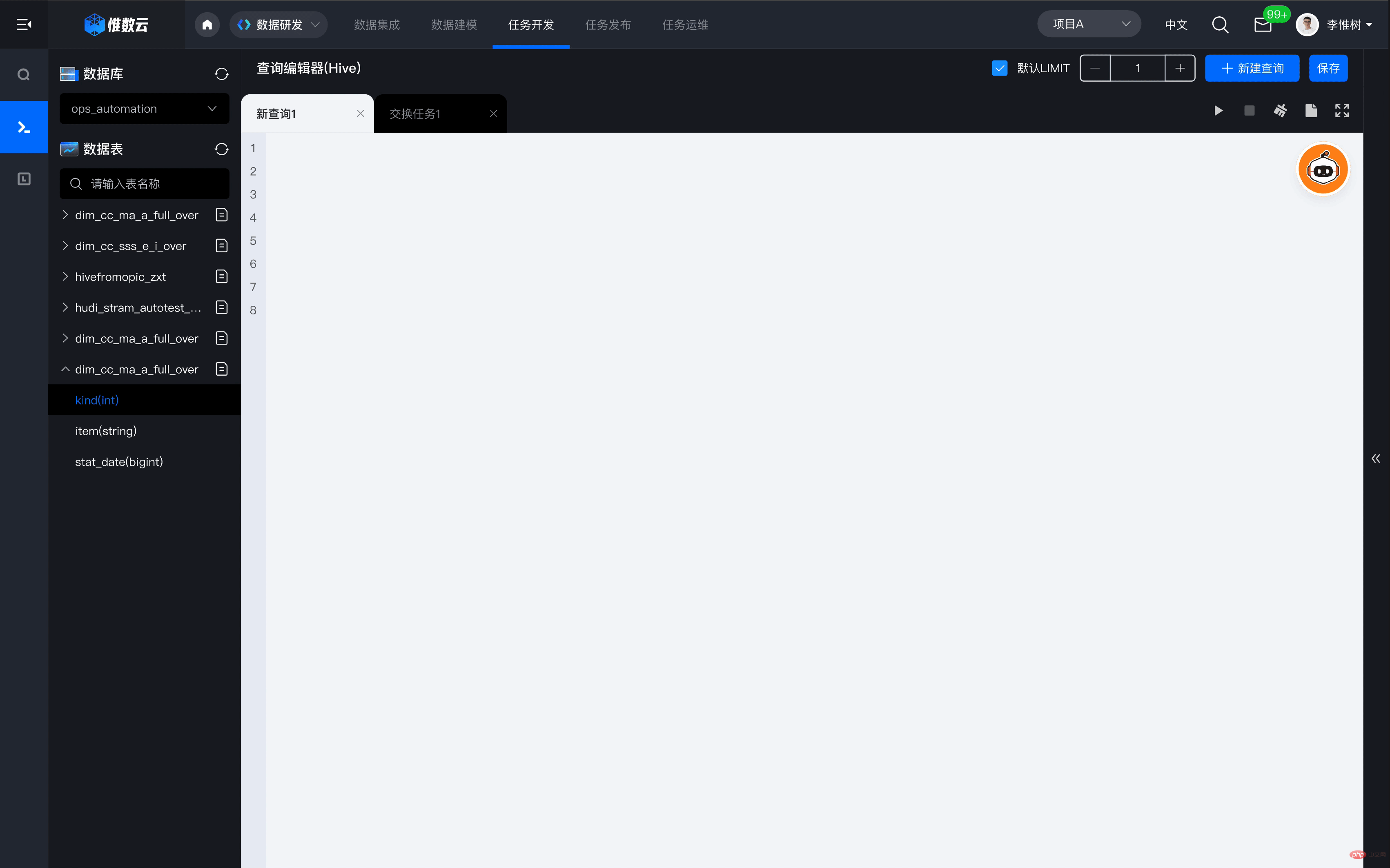

举个例子,母舰平台如何赋能惟数云。企业在借助惟数云平台建设和使用数据资产的过程中,往往需要投入大量专业的数据开发工程师,参与到业务需求分析和数据开发工作中,而大量繁琐的开发任务会导致整个数据价值实现周期被拉长。基于WakeMind赋能,只需要通过文本交互,惟数云就可以自动生成对应的数据查询语句,并一键执行查询,能够大幅度提高数据查询、分析、开发的效率,全面降低数据使用的技术门槛,以实现数据人人可用的目标。

WakeMind模型的三大特征

1)参数量更适合行业化和垂直领域场景。AI生成的内容要达到人类水平,往往需要以“预训练+微调”的大模型为基础;WakeData联合业界领先的千亿参数多模态预训练大模型厂商,通过知识蒸馏和动态量化,压缩出100亿参数量的WakeMind模型;在聚焦的行业和垂直领域,基于P-Tuning V2可以将需要微调的参数减少到原来的千分之一,大幅度降低微调所需要的计算量。

2)具备行业化和垂直领域能力的文本创造和代码生成。

3)支持私有化部署和行业化定制。行业或垂直领域的头部企业,更希望具备私有化部署和行业化定制大模型的能力。而如何在小样本学习和低算力消耗的情况下进行有效的预训练,已成为行业化定制模型的技术门槛。WakeData行业数据和垂直领域数据的积累,将使行业大模型具有行业Know-How,并形成独特的竞争优势。

同时,WakeMind采用Transformer架构,以self-instruct方式生成数万的指令遵循样本数据,使用SFT(Supervised Fine-Tuning)、RLHF等技术实现意图对齐,通过INT8量化后,可大幅降低推理成本,使模型具有私有化部署的可行性

大模型与行业化预训练大模型

自OpneAI发布ChatGPT以来,给世界带来了巨大冲击。其背后的大型语言模型 (Large Language Model,LLM) ,以及RLHF (Reinforcement Learning from Human Feedback) 即以强化学习方式依据人类反馈优化的语言模型,得到了广泛关注。

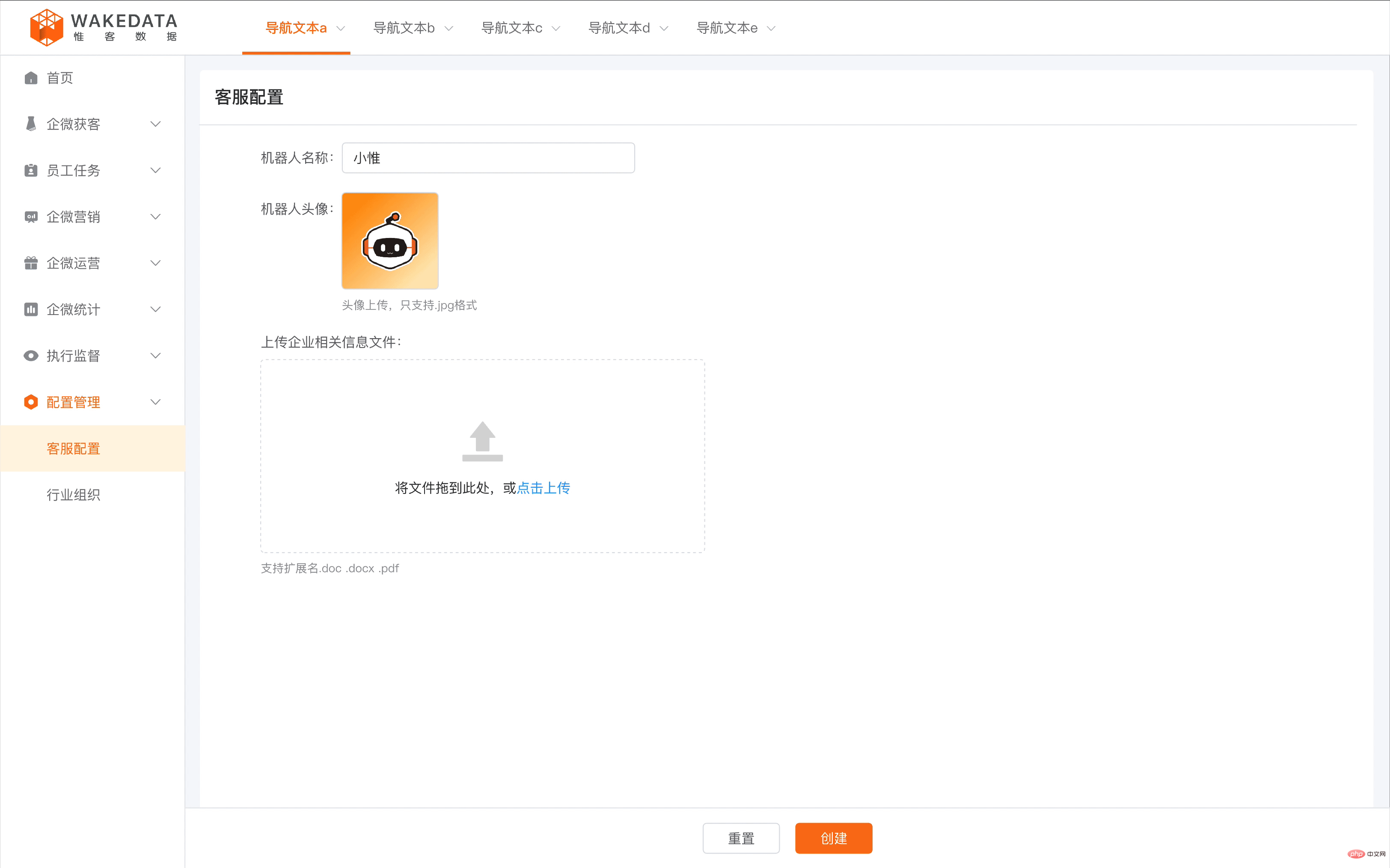

WakeData创业初期,在NLP、CV、语音等领域就发布了11个AI模型,其中NLP语义分析大模型的应用场景最为丰富。例如在低频高客单价的地产置业、汽车、品牌零售等行业领域,SCRM是最有效的潜在客户和存量客户经营方式之一。WakeData通过行业语料的积累和特定的预训练,使AI对行业产生深刻理解,能够在对话过程中24小时快速响应客户问题,并且能够基于会话信息,自动抽取客户标签,提升客户画像的分辨率。

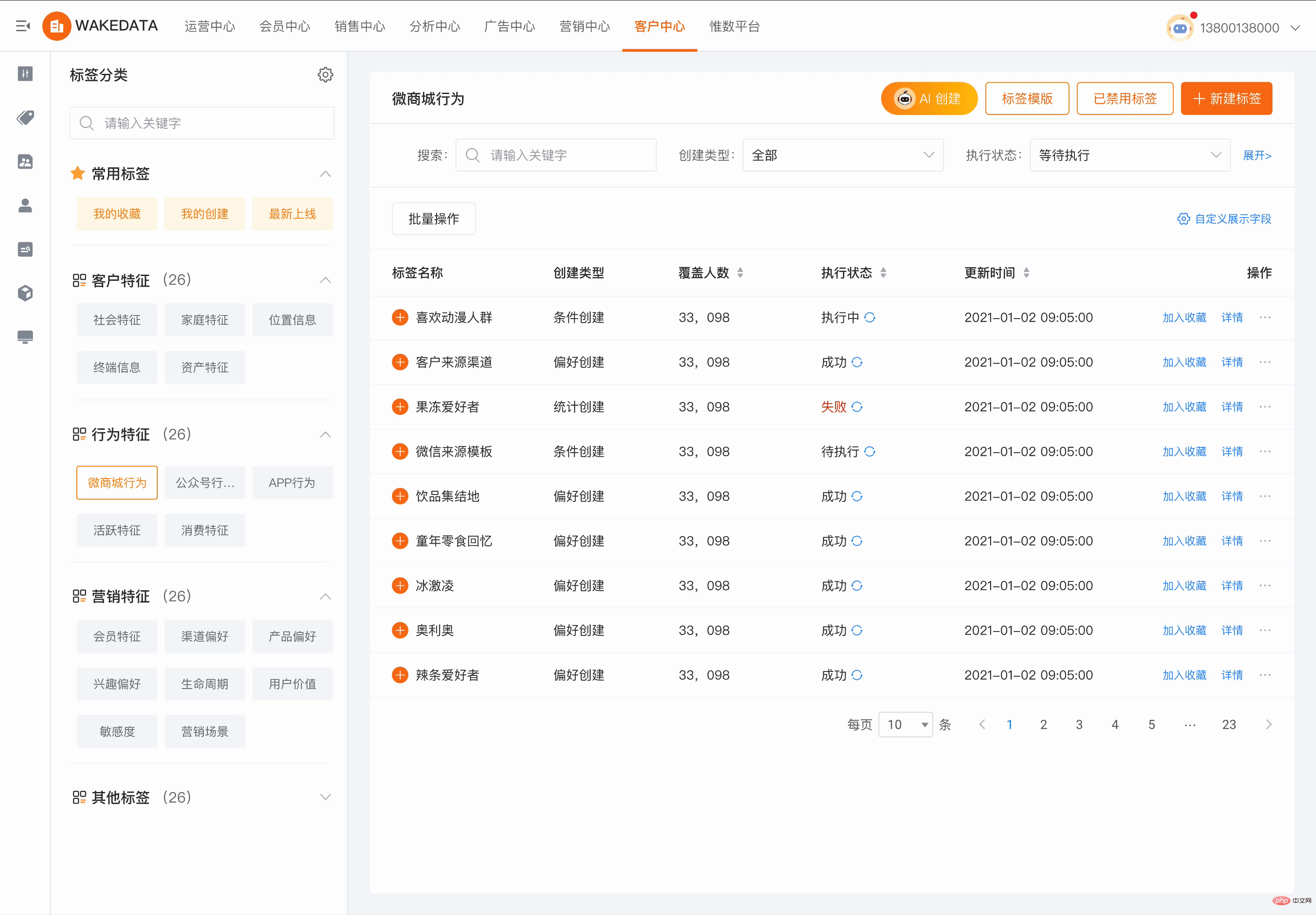

在WakeData,AI大模型能力已经覆盖到从底层客户数据资产构建,中层客户经营旅程和经营规则,再到上层的多接触点营销链路;具备能够为整个数字化客户经营的垂直领域‘降本、提效、赋能’的能力。例如在CDP客户数据平台领域,以前运营人员需要繁琐的规则设计才能圈选到合适的目标客群,现在则通过简单的语言描述和对话,AI即可以辅助找到对应的目标客群,大幅降低平台的使用学习成本,跨越式的提升使用效率和交互体验。

在MA营销自动化领域,WakeData的产品已经接入了微信生态、抖音、小红书等触点,并且支持自动化构建营销旅程,提供丰富的旅程模版库,可以实现“实时的、一对一的、个性化的”用户触达。这其中有一个重要的环节是个性化营销素材的生成,包括文本、图片、图文混排等,AI大模型可以大幅提升这个部分的效率和质量,同时降低成本。

在Loyalty大会员领域,当大会员系统横跨不同行业、不同业态的时候,会员规则和会员资产拉通就会存在挑战,WakeData的AI大模型基于大量行业经验和语料训练形成的Prompt引擎,通过简单会话,描述不同业态会员的特性和业务诉求,就可以自动生成不同会员规则的映射逻辑和组合方案。

大模型在行业和垂直领域的实践已证明其价值。

WakeMind商业路径的三个阶段

1)2018-2021年,自有模型应用和商业化探索期。基于WakeData的惟数云、惟客云、昆仑平台三条基础产品线,将自研的NLP大模型在地产、新零售、汽车等行业,以及数字营销等垂直领域进行全面的探索和实践。

2)2022-2023年,WakeMind发布和母舰平台建设期。WakeData联合战略伙伴加速行业大模型WakeMind的研发,并通过母舰平台,使WakeMind具备行业化和垂直领域的定制化能力,具备私有化部署能力,具备通用大模型的接入和管理能力,实现对自有模型不能覆盖场景的有利补充。

3)2023年及以后,全面进入WakeMind模型应用期。 WakeMind基于母舰平台的能力,全面接入到惟客云、惟数云、昆仑平台等产品线,通过行业知识积累、行业场景优化、行业提示工程训练,进一步提升模型的行业化能力,并将在地产、新零售、汽车等行业发起更大规模的商用。与此同时,WakeData自身也基于WakeMind母舰平台的能力,开始实现自我生产力的革命。

WakeData如何用AI解放生产力

WakeData公司的使命定义为「唤醒数据」,并已在大数据平台领域布局多年。作为一家TOB企服公司,就「如何运用大模型」WakeData看到了巨大的机遇,并将大模型的运用覆盖到了两个方面:一方面是将大模型接入产品,另一方面则帮助企业内部的设计师、程序员等人群使用大模型进行产品开发和客户项目交付。

大模型的接入运用有两个基本要素,有更适用的场景和具备大数据AI能力,WakeData主要的两款产品“惟客云”与“惟数云”则为大模型的接入提供了便利。惟客云能够更方便的基于行业数字化应用将大模型工具无缝接入,客户无需关心应用背后的复杂配置和技术优化;惟数云则能够基于行业帮助场景应用优化提示工程和垂直模型。而这也是WakeData一直坚持平台+应用的产品方案优势。

与此同时,WakeData将大模型接入产品又分为了两类,一类是基于产品和行业业务流接入,这类接入的重点在于优化体验和行业知识,帮助客户快速、便捷和有效的运用;第二类是基于产品结和开源大模型深度优化垂直场景,这类产品更符合大客户对抗风险和数据安全上的诉求,同时基于行业的理解对模型可以不断优化,可以保持这类客户在垂直行业的持续竞争力。

“企业在数字化转型和数字化客户经营当中要融合好大模型,大数据和场景是两个关键要素。”WakeData创始人兼CEO李柯辰表示。

在通常情况下,大模型都需要大量的数据进行有效训练,因此具备行业化的数据平台能力变得至关重要。近日国家互联网信息办公室发布了《生成式人工智能服务管理办法(征求意见稿)》,其中特别强调了训练和预训练数据来源的合法合规,以及数据的真实性、准确性、客观性、多样性。大模型的价值应用场景,更是大模型发展和商业化的重要因素;所谓场景就是指我们训练的模型的用途,是否能在合法合规的前提下,为业务创造核心价值。

李柯辰认为,场景是运用大模型的环境,大数据和AI技术基础是能力;拥有行业场景和行业数据的企业在获得大模型能力时会更快、更有效、更敏捷。

WakeData的两条核心产品线,正是对这两大要素的累积;惟数云作为新一代数据平台,具有强大的大数据Eed-to-End的数据处理能力,惟客云作为新一代数字化客户经营平台,其中包含了CDP、MA、SCRM、Loyalty等套件,拥有海量的业务应用场景,并且通过垂直行业深耕战略,拥有更强的行业Know-How,拥有更多有价值的训练样本数据。在2022年惟数云就发布5.0版本,其数据集成、数据计算、数据分析和治理、数据可视化、数据资产化的能力均具有行业领先的优势。而这些数据侧的优势,也成为大模型时代行业化人工智能应用的竞争壁垒。

“在WakeData内部已经初步形成推进生产力解放的工作氛围,WakeMind能力在产品设计、开发测试、营销运营等领域,都已经展开使用,初步运用已实现人效达到20%的提升。在加快产品研发的同时,也提升了客户项目交付的效率,还为客户的数字化项目落地节省了时间成本。。”WakeDataCTO钱勇说到。

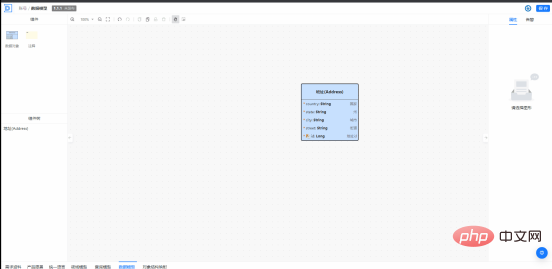

昆仑平台由基础云、开发云、集成云三部分组成,是WakeData产品研发和实施交付过程中非常重要的云原生技术底座。昆仑平台开发云通过WakeMind赋能,工程师已经在探索“基于产品文档,辅助生成对应的架构设计、数据模型设计,再辅助生成代码、检测代码的正确性”等方面的应用。例如在推进领域驱动设计的过程中,WakeMind可以辅助学习DDD、辅助工程师进行领域建模;在数据建模的过程中,可以通过自然语言交互进行数据模型的创建、修改、自动补充完善,快速生产SQL语句;在产品研发过程中,通过输入产品文档,提取和生成产品术语表,并进行详细的解释说明等。

对普通的工程师来说,在生成规则类代码、自动生成单元测试、代码审查和优化等领域,已经可以大幅提高开发效率了。

WakeMind提供全员可用的文案生成助手。

市场部门通过AI的 Text to Video快速构建的营销增长矩阵。

AIGC赋能行业和垂直领域是必然趋势,也是WakeData自创业以来的核心发展路径。对于类ChatGPT的技术和服务,WakeData一直保持开放和拥抱的态度,并且积极投身其中,在聚焦行业化经营的战略基础上,紧紧把握其价值化和商业化的路径。惟客数据的 WakeMind 行业大模型,将在 AIGC 时代帮助更多企业自我革命、提升效能,持续解放生产力。

以上是融合GPT大模型产品,WakeData新一轮产品升级的详细内容。更多信息请关注PHP中文网其他相关文章!

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

AI Hentai Generator

免费生成ai无尽的。

热门文章

热工具

记事本++7.3.1

好用且免费的代码编辑器

SublimeText3汉化版

中文版,非常好用

禅工作室 13.0.1

功能强大的PHP集成开发环境

Dreamweaver CS6

视觉化网页开发工具

SublimeText3 Mac版

神级代码编辑软件(SublimeText3)

热门话题

大模型App腾讯元宝上线!混元再升级,打造可随身携带的全能AI助理

Jun 09, 2024 pm 10:38 PM

大模型App腾讯元宝上线!混元再升级,打造可随身携带的全能AI助理

Jun 09, 2024 pm 10:38 PM

5月30日,腾讯宣布旗下混元大模型全面升级,基于混元大模型的App“腾讯元宝”正式上线,苹果及安卓应用商店均可下载。相比此前测试阶段的混元小程序版本,面向工作效率场景,腾讯元宝提供了AI搜索、AI总结、AI写作等核心能力;面向日常生活场景,元宝的玩法也更加丰富,提供了多个特色AI应用,并新增了创建个人智能体等玩法。“腾讯做大模型不争一时之先。”腾讯云副总裁、腾讯混元大模型负责人刘煜宏表示:“过去的一年,我们持续推进腾讯混元大模型的能力爬坡,在丰富、海量的业务场景中打磨技术,同时洞察用户的真实需求

字节跳动豆包大模型发布,火山引擎全栈 AI 服务助力企业智能化转型

Jun 05, 2024 pm 07:59 PM

字节跳动豆包大模型发布,火山引擎全栈 AI 服务助力企业智能化转型

Jun 05, 2024 pm 07:59 PM

火山引擎总裁谭待企业要做好大模型落地,面临模型效果、推理成本、落地难度的三大关键挑战:既要有好的基础大模型做支撑,解决复杂难题,也要有低成本的推理服务让大模型被广泛应用,还要更多工具、平台和应用帮助企业做好场景落地。——谭待火山引擎总裁01.豆包大模型首次亮相大使用量打磨好模型模型效果是AI落地最关键的挑战。谭待指出,只有大的使用量,才能打磨出好模型。目前,豆包大模型日均处理1,200亿tokens文本、生成3,000万张图片。为助力企业做好大模型场景落地,字节跳动自主研发的豆包大模型将通过火山

利用升腾AI技术,秦岭·秦川交通大模型助力西安打造智慧交通创新中心

Oct 15, 2023 am 08:17 AM

利用升腾AI技术,秦岭·秦川交通大模型助力西安打造智慧交通创新中心

Oct 15, 2023 am 08:17 AM

“高度复杂、碎片化程度高、跨领域”一直是交通行业数智化升级路上的首要痛点。近日,由中科视语、西安市雁塔区政府、西安未来人工智能计算中心联合打造的参数规模千亿级的“秦岭·秦川交通大模型”,面向智慧交通领域,为西安及其周边地区打造智慧交通创新支点。 “秦岭·秦川交通大模型”结合西安当地海量开放场景下的交通生态数据、中科视语自研的原创先进算法以及西安未来人工智能计算中心升腾AI的强大算力,为路网监测、应急指挥、养护管理、公众出行等智慧交通全场景带来数智化变革。交通管理在不同城市有不同的特点,不同道路的交

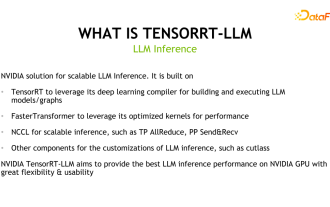

揭秘NVIDIA大模型推理框架:TensorRT-LLM

Feb 01, 2024 pm 05:24 PM

揭秘NVIDIA大模型推理框架:TensorRT-LLM

Feb 01, 2024 pm 05:24 PM

一、TensorRT-LLM的产品定位TensorRT-LLM是NVIDIA为大型语言模型(LLM)开发的可扩展推理方案。它基于TensorRT深度学习编译框架构建、编译和执行计算图,并借鉴了FastTransformer中高效的Kernels实现。此外,它还利用NCCL实现设备间的通信。开发者可以根据技术发展和需求差异,定制算子以满足特定需求,例如基于cutlass开发定制的GEMM。TensorRT-LLM是NVIDIA官方推理方案,致力于提供高性能并不断完善其实用性。TensorRT-LL

对标GPT-4!中国移动九天大模型通过双备案

Apr 04, 2024 am 09:31 AM

对标GPT-4!中国移动九天大模型通过双备案

Apr 04, 2024 am 09:31 AM

4月4日消息,日前,国家网信办公布已备案大模型清单,中国移动“九天自然语言交互大模型”名列其中,标志着中国移动九天AI大模型可正式对外提供生成式人工智能服务。中国移动表示,这是同时通过国家“生成式人工智能服务备案”和“境内深度合成服务算法备案”双备案的首个央企研发的大模型。据介绍,九天自然语言交互大模型具有行业能力增强、安全可信、支持全栈国产化等特点,已形成90亿、139亿、570亿、千亿等多种参数量版本,可灵活部署于云、边、端不同场

工业知识图谱进阶实战

Jun 13, 2024 am 11:59 AM

工业知识图谱进阶实战

Jun 13, 2024 am 11:59 AM

一、背景简介首先来介绍一下云问科技的发展历程。云问科技公...2023年,正是大模型盛行的时期,很多企业认为已经大模型之后图谱的重要性大大降低了,之前研究的预置的信息化系统也都不重要了。不过随着RAG的推广、数据治理的盛行,我们发现更高效的数据治理和高质量的数据是提升私有化大模型效果的重要前提,因此越来越多的企业开始重视知识建设的相关内容。这也推动了知识的构建和加工开始向更高水平发展,其中有很多技巧和方法可以挖掘。可见一个新技术的出现,并不是将所有的旧技术打败,也有可能将新技术和旧技术相互融合后

新测试基准发布,最强开源Llama 3尴尬了

Apr 23, 2024 pm 12:13 PM

新测试基准发布,最强开源Llama 3尴尬了

Apr 23, 2024 pm 12:13 PM

如果试题太简单,学霸和学渣都能考90分,拉不开差距……随着Claude3、Llama3甚至之后GPT-5等更强模型发布,业界急需一款更难、更有区分度的基准测试。大模型竞技场背后组织LMSYS推出下一代基准测试Arena-Hard,引起广泛关注。Llama3的两个指令微调版本实力到底如何,也有了最新参考。与之前大家分数都相近的MTBench相比,Arena-Hard区分度从22.6%提升到87.4%,孰强孰弱一目了然。Arena-Hard利用竞技场实时人类数据构建,与人类偏好一致率也高达89.1%

小米字节联手!小爱同学接入豆包大模型:手机、SU7已搭载

Jun 13, 2024 pm 05:11 PM

小米字节联手!小爱同学接入豆包大模型:手机、SU7已搭载

Jun 13, 2024 pm 05:11 PM

6月13日消息,据字节旗下“火山引擎”公众号介绍,小米旗下人工智能助手“小爱同学”与火山引擎达成合作,双方基于豆包大模型实现更智能的AI交互体验。据悉,字节跳动打造的豆包大模型,每日能够高效处理数量多达1200亿个的文本tokens、生成3000万张内容。小米借助豆包大模型提升自身模型的学习与推理能力,打造出全新的“小爱同学”,不仅更加精准地把握用户需求,还以更快的响应速度和更全面的内容服务。例如,当用户询问复杂的科学概念时,&ldq