生成多语种文本与图片的全能工具AltDiffusion-m18

当前,非英文文图生成模型选择有限,用户往往要将 prompt 翻译成英语再输入模型。这样不仅会造成额外的操作负担,并且翻译过程中的语言文化误差,会影响生成图片的准确性。

智源研究院 FlagAI 团队首创高效训练方式,使用多语言预训练模型和 Stable Diffusion 结合,训练多语言文图生成模型 —— AltDiffusion-m18,支持18种语言的文图生成。

包括中文、英文、日语、泰语、韩语、印地语、乌克兰语、阿拉伯语、土耳其语、越南语、波兰语、荷兰语、葡萄牙语、意大利语、西班牙语、德语、法语、俄语。

Huggingface:https://huggingface.co/BAAI/AltDiffusion-m18

GitHub:https://github.com/FlagAI-Open/FlagAI/blob/master/examples/AltDiffusion-m18

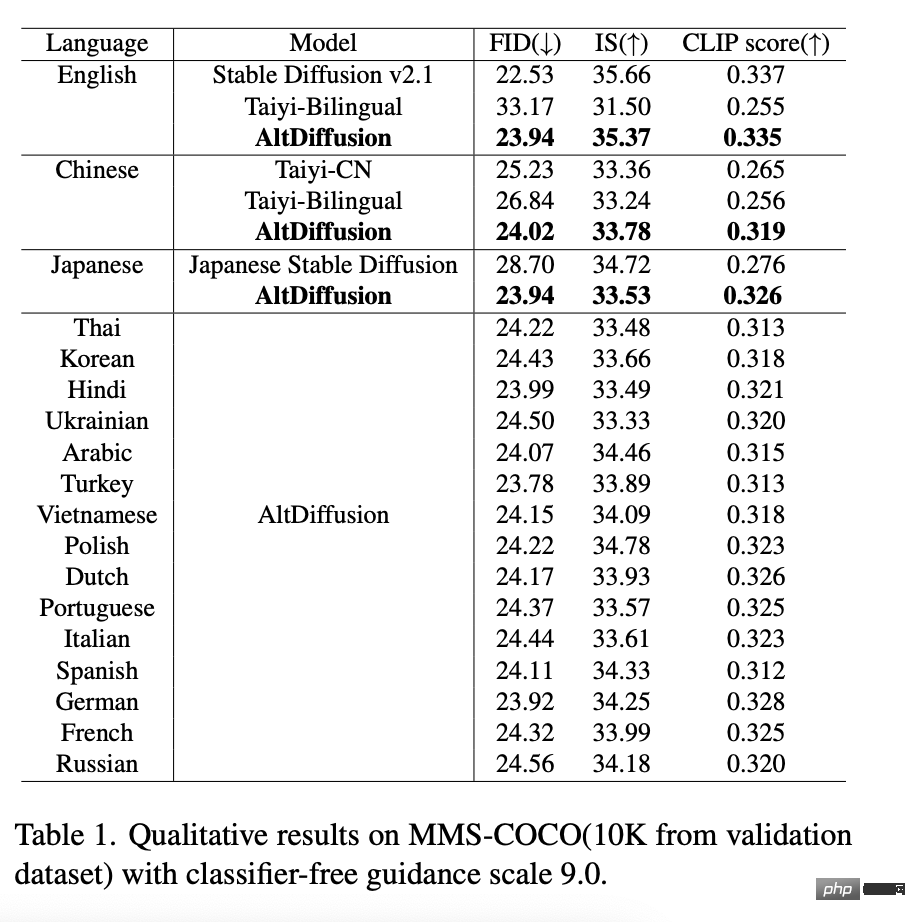

AltDiffusion-m18 在英文的 FID、IS、CLIP score 客观评测上达到了 Stable Diffusion 95~99% 效果,在中文、日文上达到了最优水平,同时填补了其余 15 种语言文图生成模型的空白,极大满足了产业界对于多语言文图生成的强烈需求。在此,特别鸣谢 Stable Diffusion Research Team 为这项工作提供建议。

此外,AltDiffusion-m18 相关创新技术报告《AltCLIP: Altering the Language Encoder in CLIP for Extended Language Capabilities》已被 Findings of ACL 2023 接收。

技术亮点

1 全新 AltCLIP,高效、低成本构建多语言 T2I 模型

在去年发布的 AltDiffusion-m9 中,智源团队基于 Stable Diffusion v1.4,创新性地更换语言塔为多语言塔 AltCLIP,并使用九种语言的多语言数据进行微调,将原始仅支持英文的 Stable Diffusion 扩展到支持 9 种不同的语言。

AltCLIP:https://github.com/FlagAI-Open/FlagAI/tree/master/examples/AltCLIP-m18

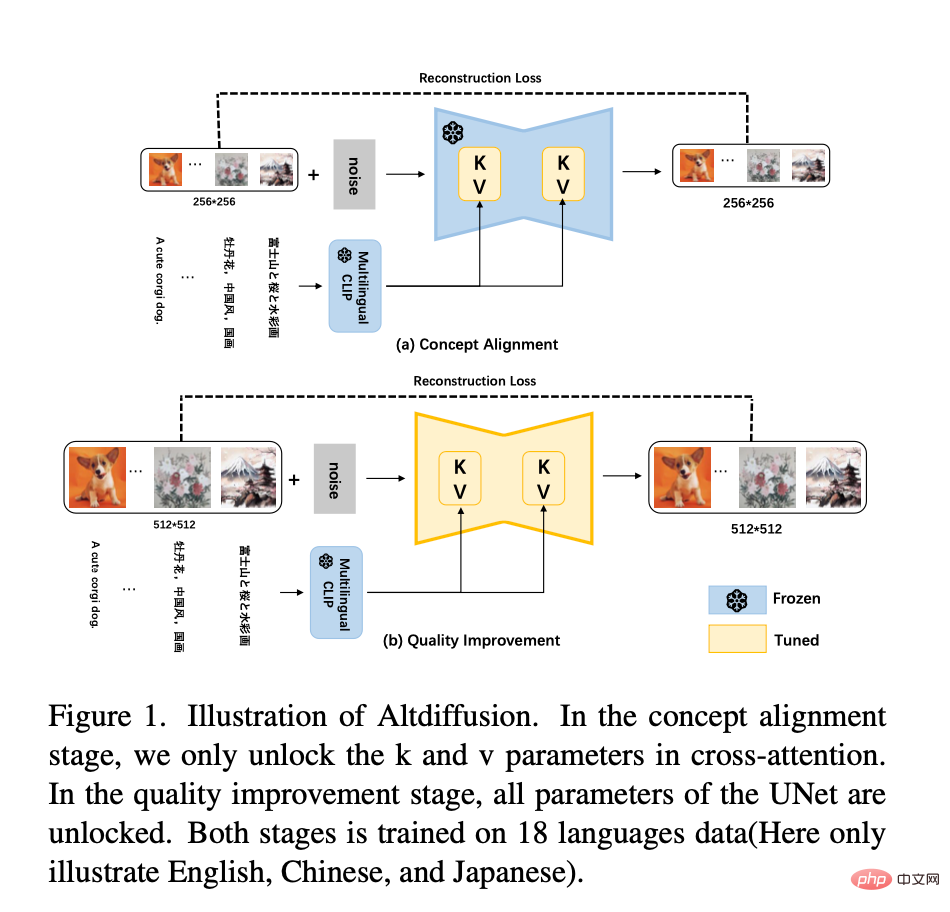

而 AltDiffusion-m18 基于 Stable Diffusion v2.1 训练。Stable Diffusion v2.1 新的语言塔为 OpenCLIP 的倒二层,因此,全新的 AltCLIP 以 OpenCLIP 的倒二层作为蒸馏目标重新训练,并且在 m9 的基础上将仅对 Unet 中 CrossAttention 层 K,V 矩阵微调,扩展成两阶段的训练方式,如下图所示:

- 第一阶段:早前在 m9 的实验过程中发现,微调 K,V 矩阵主要学习的是文图的概念对齐,所以 m18 训练的第一阶段继续使用 18 语言的数据进行K,V矩阵的微调。此外,通过实验证明,将图片从 512*512 的分辨率降低到 256*256 并不会损失图片的语义信息。因此,在第一阶段学习文图概念对齐的过程中使用 256*256 的分辨率进行训练,加快了训练速度。

- 第二阶段:为了进一步提高生成图像的质量,使用 512*512 的分辨率在 18 语言的数据中进行 Unet 全量参数的训练。此外,丢掉 10% 的文本来进行 uncondition 的训练,来服务 classifier-free guidance 的推理。

- 此外,采用了一种无分类器引导训练技术,进一步提高生成质量。

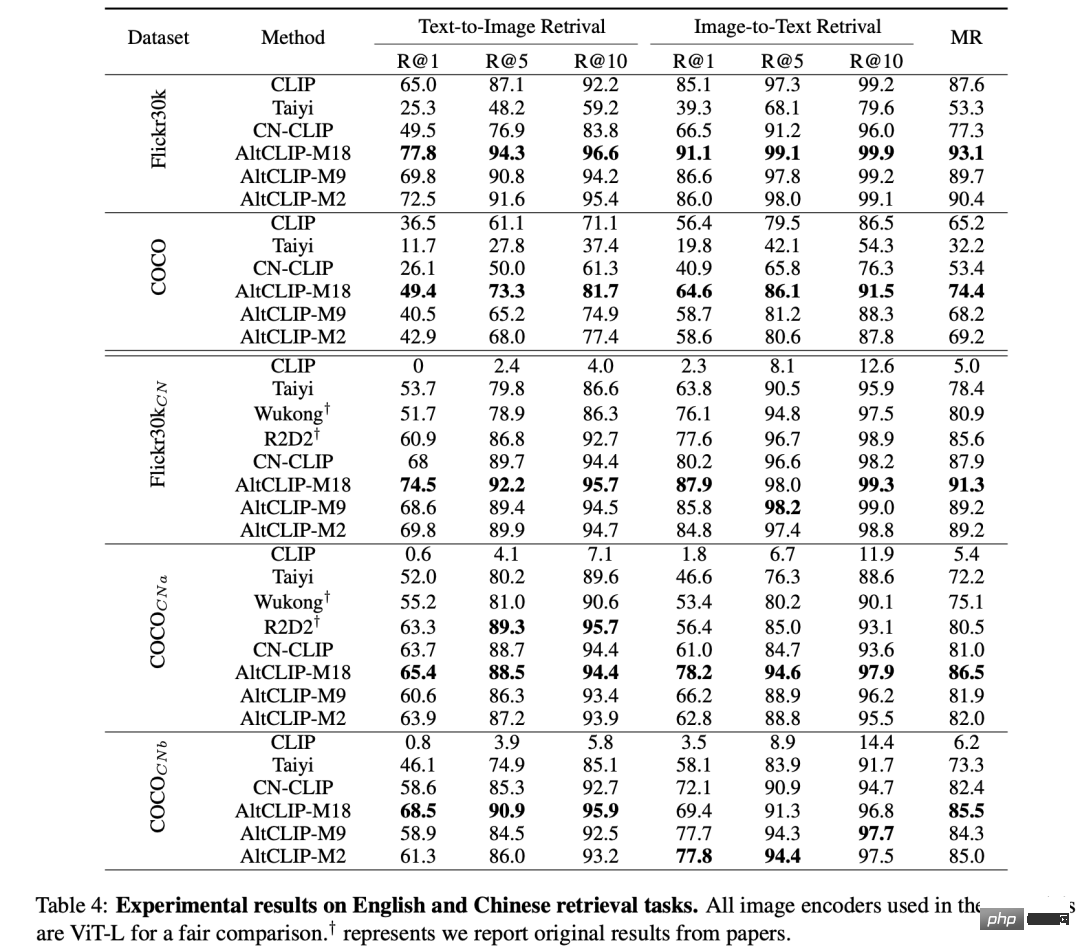

最新评测结果显示,AltCLIP-m18 在中英文 zero-shot(零样本)检索任务上超过 CLIP 达到了最优水平⬇️

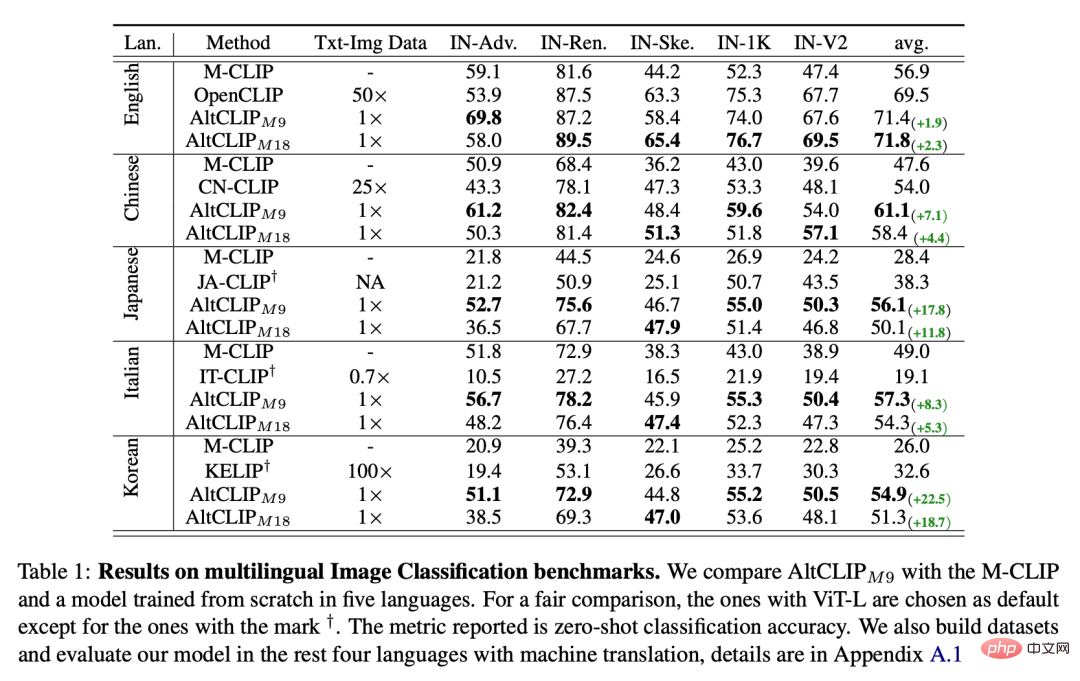

在多语言图片分类 benchmarks 上,AltCLIP-m9(早期版本,支持9种语言) 与 AltCLIP-m18 达到最优水平⬇️

同样,得益于 AltCLIP 创新性的换塔思路,AltDiffusion-m18 也可以无缝接入 Stable Diffusion 所有建立在原 CLIP 上的模型和生态工具,所有支持 Stable Diffusion 的工具如 Stable Diffusion WebUI,DreamBooth 等都可应用 AltDiffusion-m18 上。无痛上手,可玩性极佳!

2 多语言生成效果对齐,性能优越、细节准确

在全新 AltCLIP 的加持下,AltDiffusion-m18 在英文的 FID、IS、CLIP score 评测中达到了原始 Stable Diffusion 95~99% 的效果,并在中文、日文等 17 种语言中实现了最先进的性能,详细数据如下表所示:

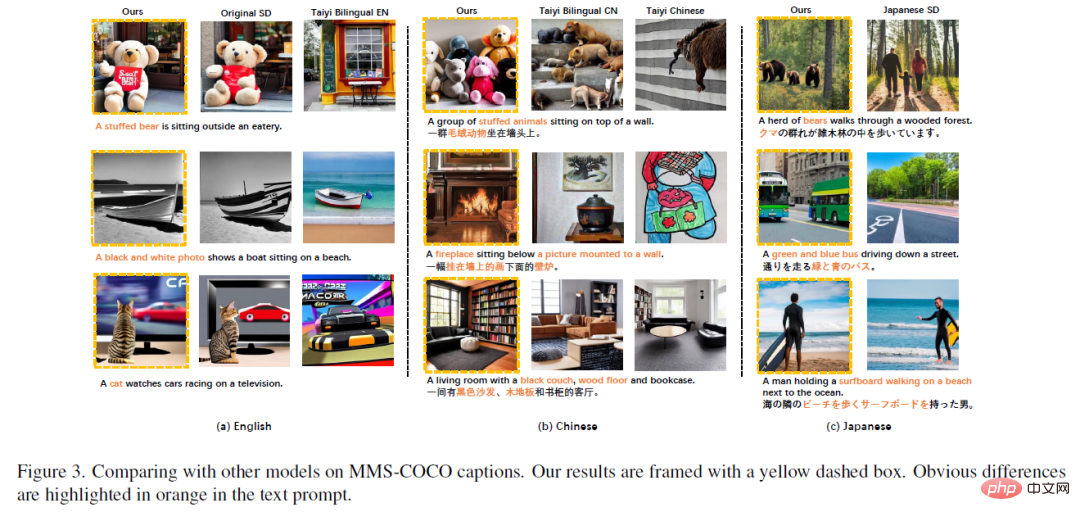

在英文、中文、日文上,AltDiffusion-m18 与其他模型生成结果相比,效果更优越、细节更准确:

上图(a)中 AltDiffusion-m18 可以生成跟原始 Stable Diffusion 高度一致的结果,并且在 prompt 理解上优于国内其他中英双语模型,例如:"A stuffed bear", "A black and white photo", "cat"等在国内其他中英双语模型中生成失败的概念可以在 AltDiffusion 中成功生成。同样的现象在中文和日文中也有出现。

上图(b)中的"黑色沙发,木地地板"仅有 AltDiffusion-m18 正确生成。

上图(c)中的"bears",Japanese Stable Diffusion 错误生成为“人类”,AltDiffusion-m18 可以正确生成为“熊”。

此外,智源 FlagEval 团队开发了文图生成模型评测工具 ImageEval。经评测,AltDiffusion-m18 在实体对象、实体数量维度上的准确度分别超过国内同行模型 11%、 10%(注:ImageEval 评测方法和结果将于近期公开发布,敬请期待)。

3 小语种文生图救星,提供多语言文图生成模型参照系

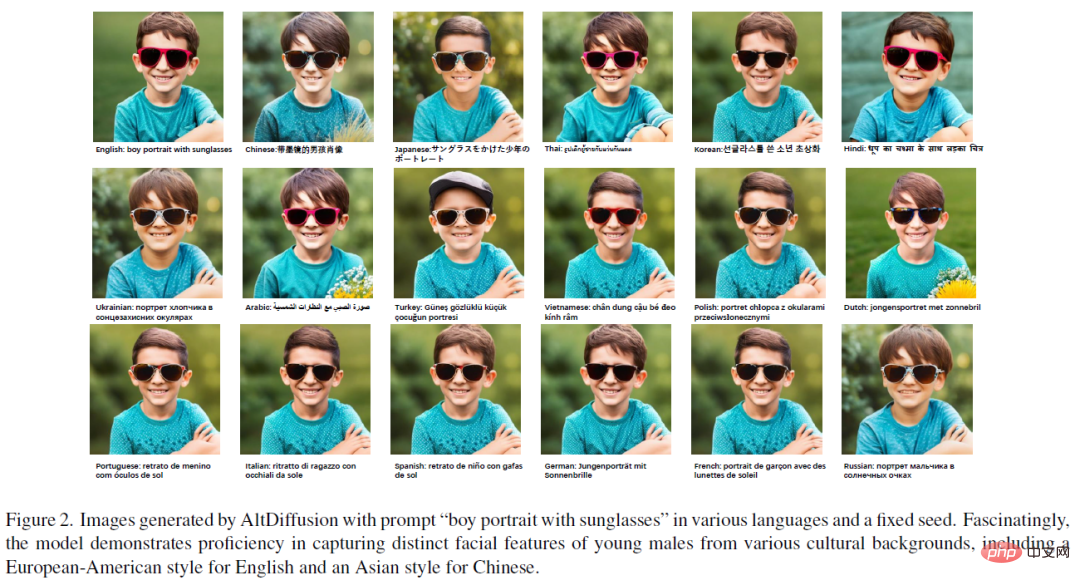

AltDiffusion-m18 从多语言的数据中学到了不同语言的偏置,帮助用户越过语言翻译门槛、绕过文化转译,减少了语言背后文化信息的丢失。如下图所示,中文、日文 Prompt 生成的小男孩的脸部轮廓更加“亚洲风”,而英语及其他欧洲地区语言 prompt 生成小男孩则更加“欧美风”。

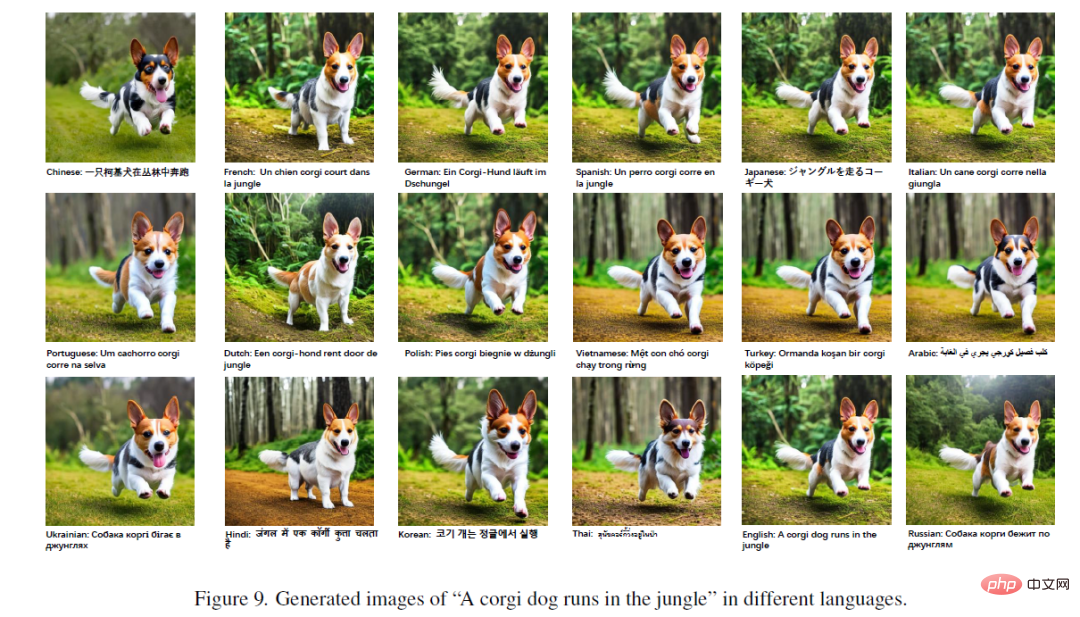

更加有趣的是,在不同语言下动物的 prompt 生成的图片细节也有差异。如下图所示,虽然不同语言生成的图片整体上具有高度一致性,但画面背景和柯基的五官细节都有细微差异。

总的来说,AltDiffusion-m18 为多语言文图生成模型提供了一个基础参照系。以西班牙语、德语、法语等15 种语言为母语的用户,不必再将脑海中的 prompt 翻译成英文,就可以感受到 AIGC 的乐趣。AI 调教高手们还可以在 AltDiffusion-m18 基础上结合 DreamBooth 、ControlNet 和 LoRA 等进一步优化,或者使用其他语言的语料微调得到更好的文图生成效果。

同时,大模型算法、模型及工具一站式开源项目—— FlagAI (github.com/FlagAI-Open/FlagAI)也提供了训练推理的工具和 API ,方便大家快速下载和使用 AltDiffusion-m18 。

以上是生成多语种文本与图片的全能工具AltDiffusion-m18的详细内容。更多信息请关注PHP中文网其他相关文章!

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

Video Face Swap

使用我们完全免费的人工智能换脸工具轻松在任何视频中换脸!

热门文章

热工具

记事本++7.3.1

好用且免费的代码编辑器

SublimeText3汉化版

中文版,非常好用

禅工作室 13.0.1

功能强大的PHP集成开发环境

Dreamweaver CS6

视觉化网页开发工具

SublimeText3 Mac版

神级代码编辑软件(SublimeText3)

全球最强开源 MoE 模型来了,中文能力比肩 GPT-4,价格仅为 GPT-4-Turbo 的近百分之一

May 07, 2024 pm 04:13 PM

全球最强开源 MoE 模型来了,中文能力比肩 GPT-4,价格仅为 GPT-4-Turbo 的近百分之一

May 07, 2024 pm 04:13 PM

想象一下,一个人工智能模型,不仅拥有超越传统计算的能力,还能以更低的成本实现更高效的性能。这不是科幻,DeepSeek-V2[1],全球最强开源MoE模型来了。DeepSeek-V2是一个强大的专家混合(MoE)语言模型,具有训练经济、推理高效的特点。它由236B个参数组成,其中21B个参数用于激活每个标记。与DeepSeek67B相比,DeepSeek-V2性能更强,同时节省了42.5%的训练成本,减少了93.3%的KV缓存,最大生成吞吐量提高到5.76倍。DeepSeek是一家探索通用人工智

AI颠覆数学研究!菲尔兹奖得主、华裔数学家领衔11篇顶刊论文|陶哲轩转赞

Apr 09, 2024 am 11:52 AM

AI颠覆数学研究!菲尔兹奖得主、华裔数学家领衔11篇顶刊论文|陶哲轩转赞

Apr 09, 2024 am 11:52 AM

AI,的确正在改变数学。最近,一直十分关注这个议题的陶哲轩,转发了最近一期的《美国数学学会通报》(BulletinoftheAmericanMathematicalSociety)。围绕「机器会改变数学吗?」这个话题,众多数学家发表了自己的观点,全程火花四射,内容硬核,精彩纷呈。作者阵容强大,包括菲尔兹奖得主AkshayVenkatesh、华裔数学家郑乐隽、纽大计算机科学家ErnestDavis等多位业界知名学者。AI的世界已经发生了天翻地覆的变化,要知道,其中很多文章是在一年前提交的,而在这一

你好,电动Atlas!波士顿动力机器人复活,180度诡异动作吓坏马斯克

Apr 18, 2024 pm 07:58 PM

你好,电动Atlas!波士顿动力机器人复活,180度诡异动作吓坏马斯克

Apr 18, 2024 pm 07:58 PM

波士顿动力Atlas,正式进入电动机器人时代!昨天,液压Atlas刚刚「含泪」退出历史舞台,今天波士顿动力就宣布:电动Atlas上岗。看来,在商用人形机器人领域,波士顿动力是下定决心要和特斯拉硬刚一把了。新视频放出后,短短十几小时内,就已经有一百多万观看。旧人离去,新角色登场,这是历史的必然。毫无疑问,今年是人形机器人的爆发年。网友锐评:机器人的进步,让今年看起来像人类的开幕式动作、自由度远超人类,但这真不是恐怖片?视频一开始,Atlas平静地躺在地上,看起来应该是仰面朝天。接下来,让人惊掉下巴

替代MLP的KAN,被开源项目扩展到卷积了

Jun 01, 2024 pm 10:03 PM

替代MLP的KAN,被开源项目扩展到卷积了

Jun 01, 2024 pm 10:03 PM

本月初,来自MIT等机构的研究者提出了一种非常有潜力的MLP替代方法——KAN。KAN在准确性和可解释性方面表现优于MLP。而且它能以非常少的参数量胜过以更大参数量运行的MLP。比如,作者表示,他们用KAN以更小的网络和更高的自动化程度重现了DeepMind的结果。具体来说,DeepMind的MLP有大约300,000个参数,而KAN只有约200个参数。KAN与MLP一样具有强大的数学基础,MLP基于通用逼近定理,而KAN基于Kolmogorov-Arnold表示定理。如下图所示,KAN在边上具

推荐:优秀JS开源人脸检测识别项目

Apr 03, 2024 am 11:55 AM

推荐:优秀JS开源人脸检测识别项目

Apr 03, 2024 am 11:55 AM

人脸检测识别技术已经是一个比较成熟且应用广泛的技术。而目前最为广泛的互联网应用语言非JS莫属,在Web前端实现人脸检测识别相比后端的人脸识别有优势也有弱势。优势包括减少网络交互、实时识别,大大缩短了用户等待时间,提高了用户体验;弱势是:受到模型大小限制,其中准确率也有限。如何在web端使用js实现人脸检测呢?为了实现Web端人脸识别,需要熟悉相关的编程语言和技术,如JavaScript、HTML、CSS、WebRTC等。同时还需要掌握相关的计算机视觉和人工智能技术。值得注意的是,由于Web端的计

特斯拉机器人进厂打工,马斯克:手的自由度今年将达到22个!

May 06, 2024 pm 04:13 PM

特斯拉机器人进厂打工,马斯克:手的自由度今年将达到22个!

May 06, 2024 pm 04:13 PM

特斯拉机器人Optimus最新视频出炉,已经可以在厂子里打工了。正常速度下,它分拣电池(特斯拉的4680电池)是这样的:官方还放出了20倍速下的样子——在小小的“工位”上,拣啊拣啊拣:这次放出的视频亮点之一在于Optimus在厂子里完成这项工作,是完全自主的,全程没有人为的干预。并且在Optimus的视角之下,它还可以把放歪了的电池重新捡起来放置,主打一个自动纠错:对于Optimus的手,英伟达科学家JimFan给出了高度的评价:Optimus的手是全球五指机器人里最灵巧的之一。它的手不仅有触觉

FisheyeDetNet:首个基于鱼眼相机的目标检测算法

Apr 26, 2024 am 11:37 AM

FisheyeDetNet:首个基于鱼眼相机的目标检测算法

Apr 26, 2024 am 11:37 AM

目标检测在自动驾驶系统当中是一个比较成熟的问题,其中行人检测是最早得以部署算法之一。在多数论文当中已经进行了非常全面的研究。然而,利用鱼眼相机进行环视的距离感知相对来说研究较少。由于径向畸变大,标准的边界框表示在鱼眼相机当中很难实施。为了缓解上述描述,我们探索了扩展边界框、椭圆、通用多边形设计为极坐标/角度表示,并定义一个实例分割mIOU度量来分析这些表示。所提出的具有多边形形状的模型fisheyeDetNet优于其他模型,并同时在用于自动驾驶的Valeo鱼眼相机数据集上实现了49.5%的mAP

牛津大学最新!Mickey:3D中的2D图像匹配SOTA!(CVPR\'24)

Apr 23, 2024 pm 01:20 PM

牛津大学最新!Mickey:3D中的2D图像匹配SOTA!(CVPR\'24)

Apr 23, 2024 pm 01:20 PM

写在前面项目链接:https://nianticlabs.github.io/mickey/给定两张图片,可以通过建立图片之间的对应关系来估计它们之间的相机姿态。通常,这些对应关系是二维到二维的,而我们估计的姿态在尺度上是不确定的。一些应用,例如随时随地实现即时增强现实,需要尺度度量的姿态估计,因此它们依赖于外部的深度估计器来恢复尺度。本文提出了MicKey,这是一个关键点匹配流程,能够够预测三维相机空间中的度量对应关系。通过学习跨图像的三维坐标匹配,我们能够在没有深度测试的情况下推断出度量相对