怎么使用Python写一个简单的JSONParser

JSON Tokenizer

JSON 的词法分析,我主要是参考上面这个截图里面的方式,自己写了一个简单的示例。写得比较简单,应该说它只能支持 JSON 的一个简单子集。

这里 TOKEN 的种类,参考了 https://json.org,不过它的 JSON 的语法格式是带 whitespace 的,我不习惯处理这个,所以没有参考它的语法。经过词法分析之后,过滤掉了 空格、换行、制表符,我这里就是简单的丢弃不处理。

json_tokenizer.py

使用正则表达式来进行 JSON 的词法分析。

import json

import re

from typing import Dict, List, Union

# TOKEN 的种类

LEFT_BRACE = "LEFT_BRACE" # {

RIGHT_BRACE = "RIGHT_BRACE" # }

LEFT_BRACKET = "LEFT_BRACKET" # ]

RIGHT_BRACKET = "RIGHT_BRACKET" # [

COLON = "COLON" # :

COMMA = "COMMA" # ,

NUMBER = "NUMBER" # ".*?"

STRING = "STRING" # [1-9]\d*

BOOL = "BOOL" # true/false

NULL = "NULL" # null

NEWLINE = "NEWLINE" # \n

SKIP = "SKIP" # ' ', '\t'

MISMATCH = "MISMATCH" # mismatch

# 处理 token 的正则

token_specification = [

('LEFT_BRACE', r'[{]'),

('RIGHT_BRACE', r'[}]'),

('LEFT_BRACKET', r'[\[]'),

('RIGHT_BRACKET', r'[\]]'),

('COLON', r'[:]'),

('COMMA', r'[,]'),

('NUMBER', r'-?[1-9]+[0-9]*'),

('STRING', r'".*?"'),

('BOOL', r'(true)|(false)'),

('NULL', r'null'),

('NEWLINE', r'\n'),

('SKIP', r'[ \t]'),

('MISMATCH', r'.')

]

tok_regex = '|'.join('(?P<%s>%s)' % pair for pair in token_specification)

print("Debug: ", tok_regex)

def process(kind: str, value: str) -> Dict[str, Union[str, bool, int, None]]:

"""

处理输入的 kind 和 value,并生成 Dict 对象,简单表示 token 对象

"""

if kind == STRING:

# 去掉外层的双引号,暂时没有比较好的方式

return {"kind": kind, "value": value[1:-1]}

if kind == NUMBER:

return {"kind": kind, "value": int(value)}

if kind == BOOL:

if value == "true":

return {"kind": kind, "value": True}

else:

return {"kind": kind, "value": False}

if kind == NULL:

return {"kind": kind, "value": None}

return {"kind": kind, "value": value}

def tokenizer(json_str: str) -> List[Dict[str, Union[str, bool, int, None]]]:

"""

tokenizer

"""

tokens = []

for m in re.finditer(tok_regex, json_str):

# 获取 token 的类型

kind = m.lastgroup

# 获取 token 的值

value = m.group()

if kind == MISMATCH:

raise Exception("json format is error")

if kind == NEWLINE:

continue

if kind == SKIP:

continue

token = process(kind=kind, value=value)

tokens.append(token)

return tokens

if __name__ == "__main__":

json_doc = open("./demo.json", "r", encoding="utf-8").read()

tokens = tokenizer(json_doc)

if tokens:

json.dump(tokens, open("./json_tokens.json", "w",

encoding="utf-8"), ensure_ascii=False)我这里把输入、输出数据全部放在文档里面了,下面我贴一下我输入数据和部分输出数据。

demo.json

{

"name": "小黑子",

"age": 3,

"gender": false,

"other_info": {

"friends": [

"嘎子",

"潘叔",

"狗"

],

"declaration": "练习时长两年半",

"hobbies": [

"唱",

"跳",

"rap",

"篮球????"

]

}

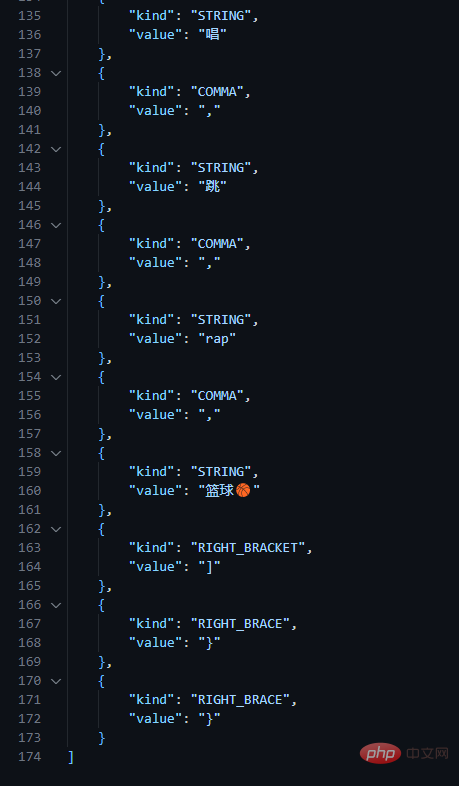

}json_token.json 部分数据,数据我格式化了,所以比较长,这里只截取一部分。

JSON Parser

json_parser.py

对上一步生成的 token 序列,进行 parser,生成 JSON 对应的 Dict 对象。parser 的实现参考了 antlr4 的 json 语法文件,它去掉了 whitespace,处理起来更简单一点。

import json

from typing import Dict, Union

# TOKEN 的种类

LEFT_BRACE = "LEFT_BRACE" # {

RIGHT_BRACE = "RIGHT_BRACE" # }

LEFT_BRACKET = "LEFT_BRACKET" # ]

RIGHT_BRACKET = "RIGHT_BRACKET" # [

COLON = "COLON" # :

COMMA = "COMMA" # ,

NUMBER = "NUMBER" # ".*?"

STRING = "STRING" # [1-9]\d*

BOOL = "BOOL" # true/false

NULL = "NULL" # null

class Token(object):

"""为了简单,就不创建这个了"""

class JSON_Parser(object):

"""

JSON_Parser the class aims parse input token sequence into a python object or array.

"""

def __init__(self, tokens) -> None:

self.index = 0

self.tokens = tokens

def get_token(self) -> Dict[str, Union[str, int, bool, None]]:

"""

get current's token

"""

if self.index < len(self.tokens):

return self.tokens[self.index]

else:

raise Exception("index out of range.")

def move_token(self) -> Dict[str, Union[str, int, bool, None]]:

"""

move to next token and return it

"""

if self.index + 1 < len(self.tokens):

self.index = self.index + 1

return self.tokens[self.index]

else:

raise Exception("index out of range.")

def parse(self):

"""

parse whole json

"""

token = self.get_token()

if token.get("kind") == LEFT_BRACE:

return self.parse_obj()

elif token.get("kind") == LEFT_BRACKET:

return self.parse_arr()

else:

raise Exception("error json, neither object or array.")

def parse_obj(self):

"""

parse object

"""

obj = {}

token = self.move_token()

kind = token.get("kind")

# '{' '}'

if kind == RIGHT_BRACE:

return obj

# '{' pair (',' pair)* '}'

name, val = self.parse_pair()

obj[name] = val

while self.index < len(self.tokens):

token = self.move_token()

kind = token.get("kind")

if kind == COMMA:

self.move_token()

name, val = self.parse_pair()

obj[name] = val

elif kind == RIGHT_BRACE:

return obj

else:

raise Exception("parse object encounter error")

def parse_arr(self):

"""

parse array

"""

arr = []

token = self.move_token()

kind = token.get("kind")

# '[' ']'

if kind == RIGHT_BRACE:

return arr

# '[' value (',' value)* ']'

val = self.parse_value()

arr.append(val)

while self.index < len(self.tokens):

token = self.move_token()

kind = token.get("kind")

if kind == COMMA:

self.move_token()

val = self.parse_value()

arr.append(val)

elif kind == RIGHT_BRACKET:

return arr

else:

raise Exception("parse array encounter error")

def parse_value(self):

"""

parse value

"""

token = self.get_token()

kind = token.get("kind")

if kind == LEFT_BRACE:

return self.parse_obj()

elif kind == LEFT_BRACKET:

return self.parse_arr()

elif kind == STRING or kind == NUMBER or kind == BOOL:

return token.get("value")

elif kind == NULL:

return

else:

raise Exception("encounter unexcepted token")

def parse_pair(self):

"""

parse pair

"""

token = self.get_token()

kind = token.get("kind")

name = token.get("value")

# STRING ':' value

if kind == STRING:

token = self.move_token()

kind = token.get("kind")

if kind == COLON:

token = self.move_token()

return name, self.parse_value()

raise Exception("parse pair encounter error")

if __name__ == "__main__":

# json token 文件路径

TOKEN_PATH = "./json_tokens.json"

# 读取 token 序列

input_tokens = [token for token in json.load(

open(TOKEN_PATH, "r", encoding="utf-8"))]

if not input_tokens:

raise Exception("input token sequence is empty")

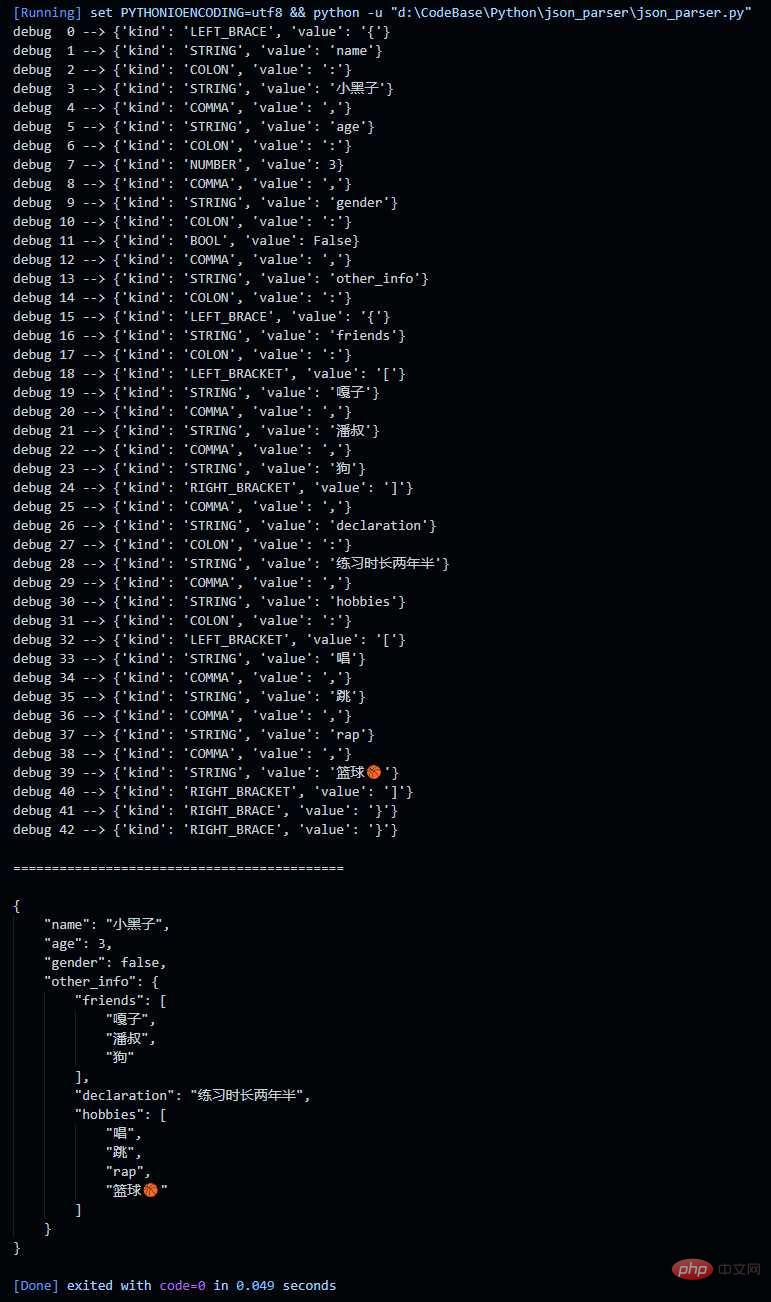

# 调试的时候,用来查表的,很方便定位到 index 走到哪一个 token 了

for i, tok in enumerate(input_tokens):

print(f"debug {i:2d} --> {tok}")

print("\n===========================================\n")

parser = JSON_Parser(tokens=input_tokens)

json_obj = parser.parse()

# 再将 object 转成 json 并格式化后输出

print(json.dumps(json_obj, ensure_ascii=False, indent=4))输出结果:

以上是怎么使用Python写一个简单的JSONParser的详细内容。更多信息请关注PHP中文网其他相关文章!

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

AI Hentai Generator

免费生成ai无尽的。

热门文章

热工具

记事本++7.3.1

好用且免费的代码编辑器

SublimeText3汉化版

中文版,非常好用

禅工作室 13.0.1

功能强大的PHP集成开发环境

Dreamweaver CS6

视觉化网页开发工具

SublimeText3 Mac版

神级代码编辑软件(SublimeText3)

热门话题

mysql安装后怎么使用

Apr 08, 2025 am 11:48 AM

mysql安装后怎么使用

Apr 08, 2025 am 11:48 AM

文章介绍了MySQL数据库的上手操作。首先,需安装MySQL客户端,如MySQLWorkbench或命令行客户端。1.使用mysql-uroot-p命令连接服务器,并使用root账户密码登录;2.使用CREATEDATABASE创建数据库,USE选择数据库;3.使用CREATETABLE创建表,定义字段及数据类型;4.使用INSERTINTO插入数据,SELECT查询数据,UPDATE更新数据,DELETE删除数据。熟练掌握这些步骤,并学习处理常见问题和优化数据库性能,才能高效使用MySQL。

PS羽化如何控制过渡的柔和度?

Apr 06, 2025 pm 07:33 PM

PS羽化如何控制过渡的柔和度?

Apr 06, 2025 pm 07:33 PM

羽化控制的关键在于理解其渐变本质。PS本身不提供直接控制渐变曲线的选项,但你可以通过多次羽化、配合蒙版、精细选区,灵活调整半径和渐变柔和度,实现自然过渡效果。

mysql 是否要付费

Apr 08, 2025 pm 05:36 PM

mysql 是否要付费

Apr 08, 2025 pm 05:36 PM

MySQL 有免费的社区版和收费的企业版。社区版可免费使用和修改,但支持有限,适合稳定性要求不高、技术能力强的应用。企业版提供全面商业支持,适合需要稳定可靠、高性能数据库且愿意为支持买单的应用。选择版本时考虑的因素包括应用关键性、预算和技术技能。没有完美的选项,只有最合适的方案,需根据具体情况谨慎选择。

PS羽化怎么设置?

Apr 06, 2025 pm 07:36 PM

PS羽化怎么设置?

Apr 06, 2025 pm 07:36 PM

PS羽化是一种图像边缘模糊效果,通过在边缘区域对像素加权平均实现。设置羽化半径可以控制模糊程度,数值越大越模糊。灵活调整半径可根据图像和需求优化效果,如处理人物照片时使用较小半径保持细节,处理艺术作品时使用较大半径营造朦胧感。但需注意,半径过大易丢失边缘细节,过小则效果不明显。羽化效果受图像分辨率影响,且需要根据图像理解和效果把握进行调整。

mysql安装后怎么优化数据库性能

Apr 08, 2025 am 11:36 AM

mysql安装后怎么优化数据库性能

Apr 08, 2025 am 11:36 AM

MySQL性能优化需从安装配置、索引及查询优化、监控与调优三个方面入手。1.安装后需根据服务器配置调整my.cnf文件,例如innodb_buffer_pool_size参数,并关闭query_cache_size;2.创建合适的索引,避免索引过多,并优化查询语句,例如使用EXPLAIN命令分析执行计划;3.利用MySQL自带监控工具(SHOWPROCESSLIST,SHOWSTATUS)监控数据库运行状况,定期备份和整理数据库。通过这些步骤,持续优化,才能提升MySQL数据库性能。

PS羽化对图像质量有什么影响?

Apr 06, 2025 pm 07:21 PM

PS羽化对图像质量有什么影响?

Apr 06, 2025 pm 07:21 PM

PS羽化会导致图像细节丢失、色彩饱和度降低和噪点增加。为了减少影响,建议使用较小的羽化半径,复制图层后再羽化,以及仔细对比羽化前后图像质量。此外,羽化并不适用于所有情况,有时蒙版等工具更适合处理图像边缘。

如何针对高负载应用程序优化 MySQL 性能?

Apr 08, 2025 pm 06:03 PM

如何针对高负载应用程序优化 MySQL 性能?

Apr 08, 2025 pm 06:03 PM

MySQL数据库性能优化指南在资源密集型应用中,MySQL数据库扮演着至关重要的角色,负责管理海量事务。然而,随着应用规模的扩大,数据库性能瓶颈往往成为制约因素。本文将探讨一系列行之有效的MySQL性能优化策略,确保您的应用在高负载下依然保持高效响应。我们将结合实际案例,深入讲解索引、查询优化、数据库设计以及缓存等关键技术。1.数据库架构设计优化合理的数据库架构是MySQL性能优化的基石。以下是一些核心原则:选择合适的数据类型选择最小的、符合需求的数据类型,既能节省存储空间,又能提升数据处理速度

Navicat查看MongoDB数据库密码的方法

Apr 08, 2025 pm 09:39 PM

Navicat查看MongoDB数据库密码的方法

Apr 08, 2025 pm 09:39 PM

直接通过 Navicat 查看 MongoDB 密码是不可能的,因为它以哈希值形式存储。取回丢失密码的方法:1. 重置密码;2. 检查配置文件(可能包含哈希值);3. 检查代码(可能硬编码密码)。