SpringBoot集成本地缓存性能之Caffeine实例分析

引言

使用缓存的目的就是提高性能,今天码哥带大家实践运用 spring-boot-starter-cache 抽象的缓存组件去集成本地缓存性能之王 Caffeine。

大家需要注意的是:in-memeory 缓存只适合在单体应用,不适合与分布式环境。

分布式环境的情况下需要将缓存修改同步到每个节点,需要一个同步机制保证每个节点缓存数据最终一致。

Spring Cache 是什么

不使用 Spring Cache 抽象的缓存接口,我们需要根据不同的缓存框架去实现缓存,需要在对应的代码里面去对应缓存加载、删除、更新等。

比如查询我们使用旁路缓存策略:先从缓存中查询数据,如果查不到则从数据库查询并写到缓存中。

伪代码如下:

public User getUser(long userId) {

// 从缓存查询

User user = cache.get(userId);

if (user != null) {

return user;

}

// 从数据库加载

User dbUser = loadDataFromDB(userId);

if (dbUser != null) {

// 设置到缓存中

cache.put(userId, dbUser)

}

return dbUser;

}我们需要写大量的这种繁琐代码,Spring Cache 则对缓存进行了抽象,提供了如下几个注解实现了缓存管理:

@Cacheable:触发缓存读取操作,用于查询方法上,如果缓存中找到则直接取出缓存并返回,否则执行目标方法并将结果缓存。

@CachePut:触发缓存更新的方法上,与 Cacheable 相比,该注解的方法始终都会被执行,并且使用方法返回的结果去更新缓存,适用于 insert 和 update 行为的方法上。

@CacheEvict:触发缓存失效,删除缓存项或者清空缓存,适用于 delete 方法上。

除此之外,抽象的 CacheManager 既能集成基于本地内存的单体应用,也能集成 EhCache、Redis 等缓存服务器。

最方便的是通过一些简单配置和注解就能接入不同的缓存框架,无需修改任何代码。

集成 Caffeine

码哥带大家使用注解方式完成缓存操作的方式来集成,完整的代码请访问 github:在 pom.xml 文件添加如下依赖:

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-cache</artifactId>

</dependency>

<dependency>

<groupId>com.github.ben-manes.caffeine</groupId>

<artifactId>caffeine</artifactId>

</dependency>使用 JavaConfig 方式配置 CacheManager:

@Slf4j

@EnableCaching

@Configuration

public class CacheConfig {

@Autowired

@Qualifier("cacheExecutor")

private Executor cacheExecutor;

@Bean

public Caffeine<Object, Object> caffeineCache() {

return Caffeine.newBuilder()

// 设置最后一次写入或访问后经过固定时间过期

.expireAfterAccess(7, TimeUnit.DAYS)

// 初始的缓存空间大小

.initialCapacity(500)

// 使用自定义线程池

.executor(cacheExecutor)

.removalListener(((key, value, cause) -> log.info("key:{} removed, removalCause:{}.", key, cause.name())))

// 缓存的最大条数

.maximumSize(1000);

}

@Bean

public CacheManager cacheManager() {

CaffeineCacheManager caffeineCacheManager = new CaffeineCacheManager();

caffeineCacheManager.setCaffeine(caffeineCache());

// 不缓存空值

caffeineCacheManager.setAllowNullValues(false);

return caffeineCacheManager;

}

}准备工作搞定,接下来就是如何使用了。

@Slf4j

@Service

public class AddressService {

public static final String CACHE_NAME = "caffeine:address";

private static final AtomicLong ID_CREATOR = new AtomicLong(0);

private Map<Long, AddressDTO> addressMap;

public AddressService() {

addressMap = new ConcurrentHashMap<>();

addressMap.put(ID_CREATOR.incrementAndGet(), AddressDTO.builder().customerId(ID_CREATOR.get()).address("地址1").build());

addressMap.put(ID_CREATOR.incrementAndGet(), AddressDTO.builder().customerId(ID_CREATOR.get()).address("地址2").build());

addressMap.put(ID_CREATOR.incrementAndGet(), AddressDTO.builder().customerId(ID_CREATOR.get()).address("地址3").build());

}

@Cacheable(cacheNames = {CACHE_NAME}, key = "#customerId")

public AddressDTO getAddress(long customerId) {

log.info("customerId:{} 没有走缓存,开始从数据库查询", customerId);

return addressMap.get(customerId);

}

@CachePut(cacheNames = {CACHE_NAME}, key = "#result.customerId")

public AddressDTO create(String address) {

long customerId = ID_CREATOR.incrementAndGet();

AddressDTO addressDTO = AddressDTO.builder().customerId(customerId).address(address).build();

addressMap.put(customerId, addressDTO);

return addressDTO;

}

@CachePut(cacheNames = {CACHE_NAME}, key = "#result.customerId")

public AddressDTO update(Long customerId, String address) {

AddressDTO addressDTO = addressMap.get(customerId);

if (addressDTO == null) {

throw new RuntimeException("没有 customerId = " + customerId + "的地址");

}

addressDTO.setAddress(address);

return addressDTO;

}

@CacheEvict(cacheNames = {CACHE_NAME}, key = "#customerId")

public boolean delete(long customerId) {

log.info("缓存 {} 被删除", customerId);

return true;

}

}使用 CacheName 隔离不同业务场景的缓存,每个 Cache 内部持有一个 map 结构存储数据,key 可用使用 Spring 的 Spel 表达式。

单元测试走起:

@RunWith(SpringRunner.class)

@SpringBootTest(classes = CaffeineApplication.class)

@Slf4j

public class CaffeineApplicationTests {

@Autowired

private AddressService addressService;

@Autowired

private CacheManager cacheManager;

@Test

public void testCache() {

// 插入缓存 和数据库

AddressDTO newInsert = addressService.create("南山大道");

// 要走缓存

AddressDTO address = addressService.getAddress(newInsert.getCustomerId());

long customerId = 2;

// 第一次未命中缓存,打印 customerId:{} 没有走缓存,开始从数据库查询

AddressDTO address2 = addressService.getAddress(customerId);

// 命中缓存

AddressDTO cacheAddress2 = addressService.getAddress(customerId);

// 更新数据库和缓存

addressService.update(customerId, "地址 2 被修改");

// 更新后查询,依然命中缓存

AddressDTO hitCache2 = addressService.getAddress(customerId);

Assert.assertEquals(hitCache2.getAddress(), "地址 2 被修改");

// 删除缓存

addressService.delete(customerId);

// 未命中缓存, 从数据库读取

AddressDTO hit = addressService.getAddress(customerId);

System.out.println(hit.getCustomerId());

}

}大家发现没,只需要在对应的方法上加上注解,就能愉快的使用缓存了。需要注意的是, 设置的 cacheNames 一定要对应,每个业务场景使用对应的 cacheNames。

另外 key 可以使用 spel 表达式,大家重点可以关注 @CachePut(cacheNames = {CACHE_NAME}, key = "#result.customerId"),result 表示接口返回结果,Spring 提供了几个元数据直接使用。

| 名称 | 地点 | 描述 | 例子 |

|---|---|---|---|

| methodName | 根对象 | 被调用的方法的名称 | #root.methodName |

| method | 根对象 | 被调用的方法 | #root.method.name |

| target | 根对象 | 被调用的目标对象 | #root.target |

| targetClass | 根对象 | 被调用的目标的类 | #root.targetClass |

| args | 根对象 | 用于调用目标的参数(作为数组) | #root.args[0] |

| caches | 根对象 | 运行当前方法的缓存集合 | #root.caches[0].name |

| 参数名称 | 评估上下文 | 任何方法参数的名称。如果名称不可用(可能是由于没有调试信息),则参数名称也可在#a<#arg> where#arg代表参数索引(从 开始0)下获得。 | #iban或#a0(您也可以使用#p0或#p<#arg>表示法作为别名)。 |

| result | 评估上下文 | 方法调用的结果(要缓存的值)。仅在unless 表达式、cache put表达式(计算key)或cache evict 表达式(when beforeInvocationis false)中可用。对于支持的包装器(例如 Optional),#result指的是实际对象,而不是包装器。 | #result |

核心原理

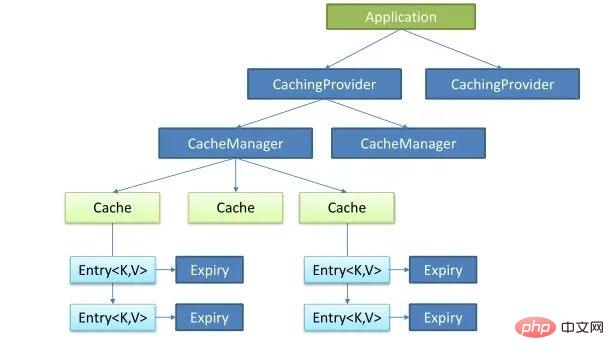

Java Caching定义了5个核心接口,分别是 CachingProvider, CacheManager, Cache, Entry 和 Expiry。

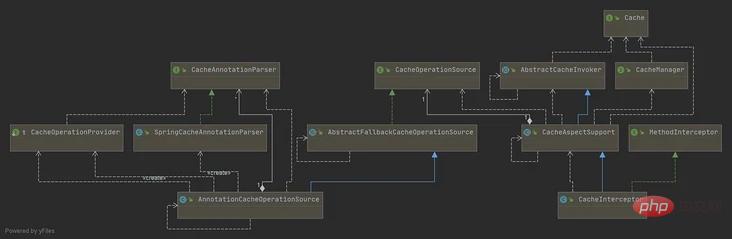

核心类图:

Cache:抽象了缓存的操作,比如,get()、put();

CacheManager:管理 Cache,可以理解成 Cache 的集合管理,之所以有多个 Cache,是因为可以根据不同场景使用不同的缓存失效时间和数量限制。

CacheInterceptor、CacheAspectSupport、AbstractCacheInvoker:CacheInterceptor 是一个AOP 方法拦截器,在方法前后做额外的逻辑,比如查询操作,先查缓存,找不到数据再执行方法,并把方法的结果写入缓存等,它继承了CacheAspectSupport(缓存操作的主体逻辑)、AbstractCacheInvoker(封装了对 Cache 的读写)。

CacheOperation、AnnotationCacheOperationSource、SpringCacheAnnotationParser:CacheOperation定义了缓存操作的缓存名字、缓存key、缓存条件condition、CacheManager等,AnnotationCacheOperationSource 是一个获取缓存注解对应 CacheOperation 的类,而SpringCacheAnnotationParser 是解析注解的类,解析后会封装成 CacheOperation 集合供AnnotationCacheOperationSource 查找。

CacheAspectSupport:缓存切面支持类,是CacheInterceptor 的父类,封装了所有的缓存操作的主体逻辑。

主要流程如下:

通过CacheOperationSource,获取所有的CacheOperation列表

如果有@CacheEvict注解、并且标记为在调用前执行,则做删除/清空缓存的操作

如果有@Cacheable注解,查询缓存

如果缓存未命中(查询结果为null),则新增到cachePutRequests,后续执行原始方法后会写入缓存

缓存命中时,使用缓存值作为结果;缓存未命中、或有@CachePut注解时,需要调用原始方法,使用原始方法的返回值作为结果

如果有@CachePut注解,则新增到cachePutRequests

如果缓存未命中,则把查询结果值写入缓存;如果有@CachePut注解,也把方法执行结果写入缓存

如果有@CacheEvict注解、并且标记为在调用后执行,则做删除/清空缓存的操作

以上是SpringBoot集成本地缓存性能之Caffeine实例分析的详细内容。更多信息请关注PHP中文网其他相关文章!

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

AI Hentai Generator

免费生成ai无尽的。

热门文章

热工具

记事本++7.3.1

好用且免费的代码编辑器

SublimeText3汉化版

中文版,非常好用

禅工作室 13.0.1

功能强大的PHP集成开发环境

Dreamweaver CS6

视觉化网页开发工具

SublimeText3 Mac版

神级代码编辑软件(SublimeText3)

Springboot怎么集成Jasypt实现配置文件加密

Jun 01, 2023 am 08:55 AM

Springboot怎么集成Jasypt实现配置文件加密

Jun 01, 2023 am 08:55 AM

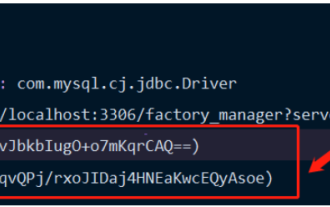

Jasypt介绍Jasypt是一个java库,它允许开发员以最少的努力为他/她的项目添加基本的加密功能,并且不需要对加密工作原理有深入的了解用于单向和双向加密的高安全性、基于标准的加密技术。加密密码,文本,数字,二进制文件...适合集成到基于Spring的应用程序中,开放API,用于任何JCE提供程序...添加如下依赖:com.github.ulisesbocchiojasypt-spring-boot-starter2.1.1Jasypt好处保护我们的系统安全,即使代码泄露,也可以保证数据源的

SpringBoot怎么集成Redisson实现延迟队列

May 30, 2023 pm 02:40 PM

SpringBoot怎么集成Redisson实现延迟队列

May 30, 2023 pm 02:40 PM

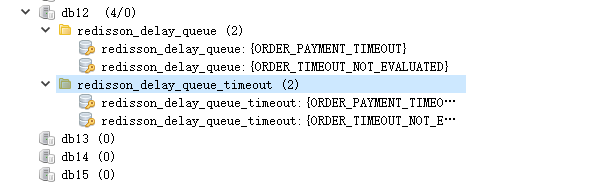

使用场景1、下单成功,30分钟未支付。支付超时,自动取消订单2、订单签收,签收后7天未进行评价。订单超时未评价,系统默认好评3、下单成功,商家5分钟未接单,订单取消4、配送超时,推送短信提醒……对于延时比较长的场景、实时性不高的场景,我们可以采用任务调度的方式定时轮询处理。如:xxl-job今天我们采

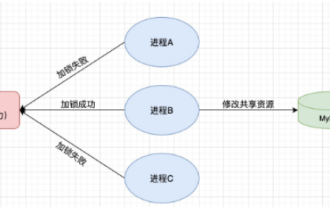

怎么在SpringBoot中使用Redis实现分布式锁

Jun 03, 2023 am 08:16 AM

怎么在SpringBoot中使用Redis实现分布式锁

Jun 03, 2023 am 08:16 AM

一、Redis实现分布式锁原理为什么需要分布式锁在聊分布式锁之前,有必要先解释一下,为什么需要分布式锁。与分布式锁相对就的是单机锁,我们在写多线程程序时,避免同时操作一个共享变量产生数据问题,通常会使用一把锁来互斥以保证共享变量的正确性,其使用范围是在同一个进程中。如果换做是多个进程,需要同时操作一个共享资源,如何互斥呢?现在的业务应用通常是微服务架构,这也意味着一个应用会部署多个进程,多个进程如果需要修改MySQL中的同一行记录,为了避免操作乱序导致脏数据,此时就需要引入分布式锁了。想要实现分

springboot读取文件打成jar包后访问不到怎么解决

Jun 03, 2023 pm 04:38 PM

springboot读取文件打成jar包后访问不到怎么解决

Jun 03, 2023 pm 04:38 PM

springboot读取文件,打成jar包后访问不到最新开发出现一种情况,springboot打成jar包后读取不到文件,原因是打包之后,文件的虚拟路径是无效的,只能通过流去读取。文件在resources下publicvoidtest(){Listnames=newArrayList();InputStreamReaderread=null;try{ClassPathResourceresource=newClassPathResource("name.txt");Input

SpringBoot与SpringMVC的比较及差别分析

Dec 29, 2023 am 11:02 AM

SpringBoot与SpringMVC的比较及差别分析

Dec 29, 2023 am 11:02 AM

SpringBoot和SpringMVC都是Java开发中常用的框架,但它们之间有一些明显的差异。本文将探究这两个框架的特点和用途,并对它们的差异进行比较。首先,我们来了解一下SpringBoot。SpringBoot是由Pivotal团队开发的,它旨在简化基于Spring框架的应用程序的创建和部署。它提供了一种快速、轻量级的方式来构建独立的、可执行

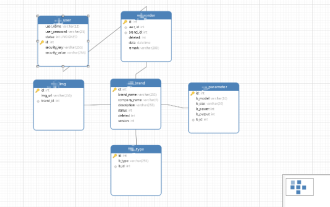

Springboot+Mybatis-plus不使用SQL语句进行多表添加怎么实现

Jun 02, 2023 am 11:07 AM

Springboot+Mybatis-plus不使用SQL语句进行多表添加怎么实现

Jun 02, 2023 am 11:07 AM

在Springboot+Mybatis-plus不使用SQL语句进行多表添加操作我所遇到的问题准备工作在测试环境下模拟思维分解一下:创建出一个带有参数的BrandDTO对象模拟对后台传递参数我所遇到的问题我们都知道,在我们使用Mybatis-plus中进行多表操作是极其困难的,如果你不使用Mybatis-plus-join这一类的工具,你只能去配置对应的Mapper.xml文件,配置又臭又长的ResultMap,然后再去写对应的sql语句,这种方法虽然看上去很麻烦,但具有很高的灵活性,可以让我们

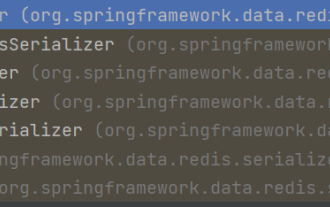

SpringBoot怎么自定义Redis实现缓存序列化

Jun 03, 2023 am 11:32 AM

SpringBoot怎么自定义Redis实现缓存序列化

Jun 03, 2023 am 11:32 AM

1、自定义RedisTemplate1.1、RedisAPI默认序列化机制基于API的Redis缓存实现是使用RedisTemplate模板进行数据缓存操作的,这里打开RedisTemplate类,查看该类的源码信息publicclassRedisTemplateextendsRedisAccessorimplementsRedisOperations,BeanClassLoaderAware{//声明了key、value的各种序列化方式,初始值为空@NullableprivateRedisSe

springboot怎么获取application.yml里值

Jun 03, 2023 pm 06:43 PM

springboot怎么获取application.yml里值

Jun 03, 2023 pm 06:43 PM

在项目中,很多时候需要用到一些配置信息,这些信息在测试环境和生产环境下可能会有不同的配置,后面根据实际业务情况有可能还需要再做修改。我们不能将这些配置在代码中写死,最好是写到配置文件中,比如可以把这些信息写到application.yml文件中。那么,怎么在代码里获取或者使用这个地址呢?有2个方法。方法一:我们可以通过@Value注解的${key}即可获取配置文件(application.yml)中和key对应的value值,这个方法适用于微服务比较少的情形方法二:在实际项目中,遇到业务繁琐,逻