OpenAI新生成模型开源炸场!比Diffusion更快更强,清华校友宋飏一作

图像生成领域,看来又要变天了。

就在刚刚,OpenAI开源了比扩散模型更快、性能更好的一致性模型:

无需对抗训练,就能生成高质量图片!

这个重磅消息一经发出,立刻引爆学术圈。

虽说论文本身在3月份就已低调发布,但当时大伙儿普遍认为它只是个OpenAI的前沿研究,并不会真正将细节公开。

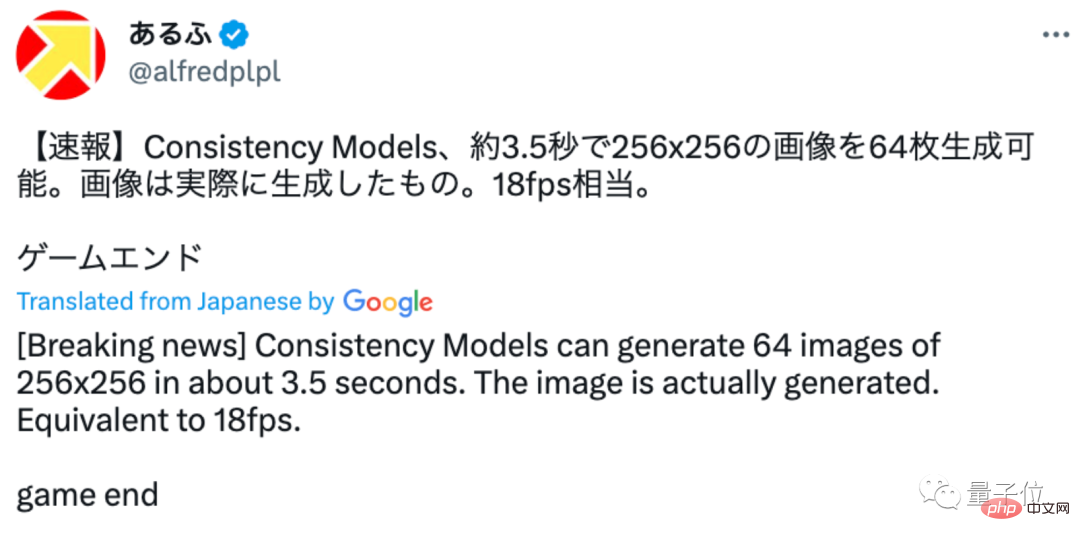

没想到这次直接来了个开源。有网友立刻上手实测了一波效果,发现只需要3.5秒左右就能生成64张左右256×256的图像:

游戏结束!

这是这位网友生成的图像效果,看起来还不错:

还有网友调侃称:这次OpenAI终于Open了!

值得一提的是,论文一作OpenAI科学家宋飏,是一位清华校友,16岁就通过领军计划进入清华数理基础科学班求学。

一起来看看这次OpenAI开源了一项怎样的研究。

开源了一个怎样的重磅研究?

作为一个图像生成AI,一致性模型(Consistency Model)最大的特点在于快又好。

相比扩散模型,它主要有两大优势:

其一,无需对抗训练(adversarial training),就能直接生成高质量的图像样本。

其二,相比扩散模型可能需要几百甚至上千次迭代,一致性模型只需要一两步就能搞定多种图像任务——

包括上色、去噪、超分等,都可以在几步之内搞定,而不需要对这些任务进行明确训练。(当然,如果进行少样本学习的话,生成效果也会更好)

所以一致性模型究竟是如何实现这种效果的?

从原理来看,一致性模型的诞生与ODE(常微分方程)式生成扩散模型有关。

图中可见,ODE会先一步步将图片数据转换成噪声,随后再进行一个逆向求解,从噪声中学习生成图像。

而就在这个过程中,作者们试图将ODE轨迹上的任何点(如Xt、Xt和Xr)映射到它的原点(如X0)进行生成建模。

随后,这个映射的模型被命名为一致性模型,因为它们的输出都是同一轨迹上的同一点:

基于这种思路,一致性模型不需要再经过漫长的迭代,才能生成一个相对质量比较高的图像,而是能做到一步生成。

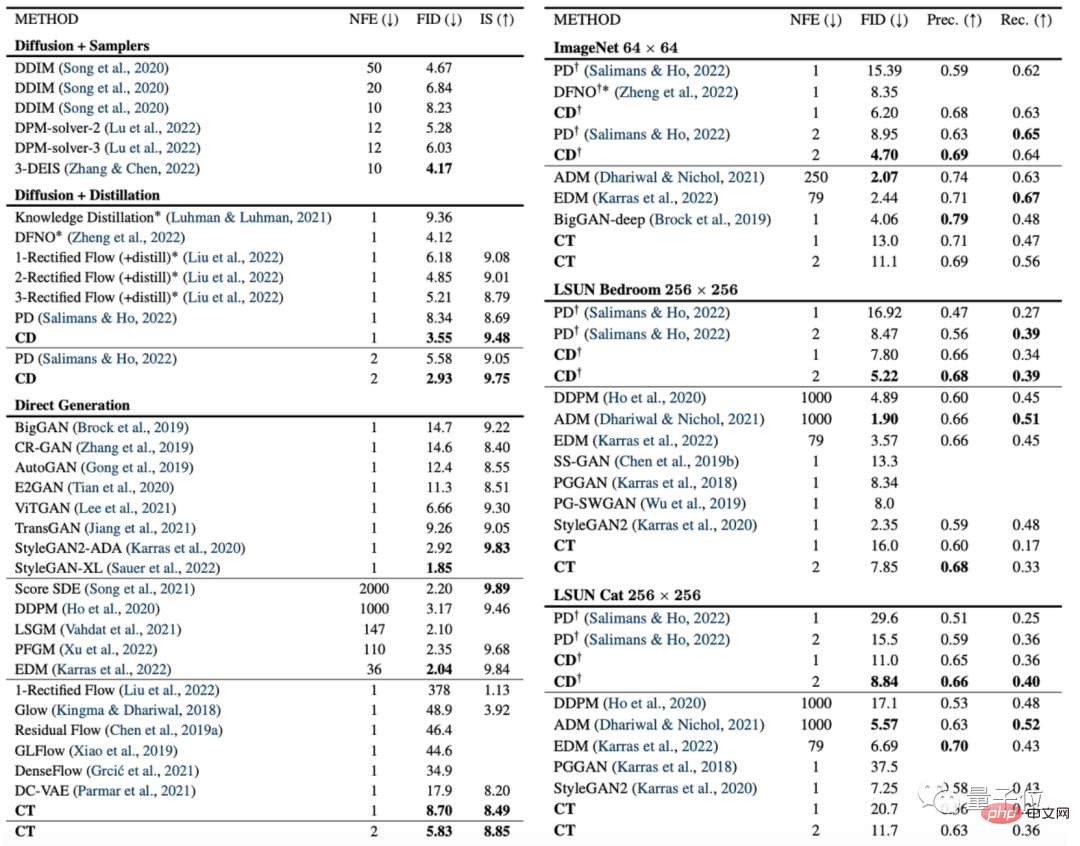

下图是一致性模型(CD)和扩散模型(PD)在图像生成指标FID上的对比。

其中,PD是去年斯坦福和谷歌大脑提出的一种最新扩散模型方法渐进式蒸馏(progressive distillation)的简称,CD(consistency distillation)则是一致性蒸馏方法。

可以看出,几乎在所有数据集上,一致性模型的图像生成效果都要比扩散模型更好,唯一的例外是256×256的房间数据集上:

除此之外,作者们也将扩散模型、一致性模型和GAN等模型在其他各种数据集上进行了对比:

不过也有网友提到,这次开源的AI一致性模型,能生成的图像还是太小:

很难过,这次开源的版本生成的图像还是太小了,要是能给出生成更大图像的开源版本,肯定会非常让人兴奋。

也有网友猜测,可能只是OpenAI还没训练出来。不过可能训练出来了我们也不一定能搞到代码(手动狗头)。

不过对于这项工作的意义,TechCrunch表示:

你若是有一堆GPU,那用扩散模型在一两分钟内迭代1500多次,生成图片的效果当然是极好的。

但如果你想在手机上或者聊天对话的时候实时生成图片,那显然扩散模型不是最好的选择。

一致性模型是OpenAI下一个重要动作。

期待OpenAI会开源一波分辨率更高的图像生成AI~

清华校友宋飏一作

论文一作宋飏,目前是OpenAI的研究科学家。

他14岁时,曾以17位评委全票通过的成绩,入选“清华大学新百年领军计划”。在次年高考中,他又成为连云港市理科状元,顺利考入清华。

2016年,宋飏从清华大学数理基础科学班毕业,此后赴斯坦福深造。2022年,宋飏获斯坦福计算机科学博士学位,而后加入OpenAI。

在博士期间,他的一作论文“Score-Based Generative Modeling through Stochastic Differential Equations”还获得过ICLR 2021的杰出论文奖。

根据其个人主页信息,从2024年1月开始,宋飏将正式加入加州理工学院电子系和计算数学科学系,担任助理教授。

项目地址:

https://www.php.cn/link/4845b84d63ea5fa8df6268b8d1616a8f

论文地址:

https://www.php.cn/link/5f25fbe144e4a81a1b0080b6c1032778

参考链接:

[1]https://twitter.com/alfredplpl/status/1646217811898011648

[2]https://twitter.com/_akhaliq/status/1646168119658831874

以上是OpenAI新生成模型开源炸场!比Diffusion更快更强,清华校友宋飏一作的详细内容。更多信息请关注PHP中文网其他相关文章!

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

AI Hentai Generator

免费生成ai无尽的。

热门文章

热工具

记事本++7.3.1

好用且免费的代码编辑器

SublimeText3汉化版

中文版,非常好用

禅工作室 13.0.1

功能强大的PHP集成开发环境

Dreamweaver CS6

视觉化网页开发工具

SublimeText3 Mac版

神级代码编辑软件(SublimeText3)

热门话题

全球最强开源 MoE 模型来了,中文能力比肩 GPT-4,价格仅为 GPT-4-Turbo 的近百分之一

May 07, 2024 pm 04:13 PM

全球最强开源 MoE 模型来了,中文能力比肩 GPT-4,价格仅为 GPT-4-Turbo 的近百分之一

May 07, 2024 pm 04:13 PM

想象一下,一个人工智能模型,不仅拥有超越传统计算的能力,还能以更低的成本实现更高效的性能。这不是科幻,DeepSeek-V2[1],全球最强开源MoE模型来了。DeepSeek-V2是一个强大的专家混合(MoE)语言模型,具有训练经济、推理高效的特点。它由236B个参数组成,其中21B个参数用于激活每个标记。与DeepSeek67B相比,DeepSeek-V2性能更强,同时节省了42.5%的训练成本,减少了93.3%的KV缓存,最大生成吞吐量提高到5.76倍。DeepSeek是一家探索通用人工智

替代MLP的KAN,被开源项目扩展到卷积了

Jun 01, 2024 pm 10:03 PM

替代MLP的KAN,被开源项目扩展到卷积了

Jun 01, 2024 pm 10:03 PM

本月初,来自MIT等机构的研究者提出了一种非常有潜力的MLP替代方法——KAN。KAN在准确性和可解释性方面表现优于MLP。而且它能以非常少的参数量胜过以更大参数量运行的MLP。比如,作者表示,他们用KAN以更小的网络和更高的自动化程度重现了DeepMind的结果。具体来说,DeepMind的MLP有大约300,000个参数,而KAN只有约200个参数。KAN与MLP一样具有强大的数学基础,MLP基于通用逼近定理,而KAN基于Kolmogorov-Arnold表示定理。如下图所示,KAN在边上具

FisheyeDetNet:首个基于鱼眼相机的目标检测算法

Apr 26, 2024 am 11:37 AM

FisheyeDetNet:首个基于鱼眼相机的目标检测算法

Apr 26, 2024 am 11:37 AM

目标检测在自动驾驶系统当中是一个比较成熟的问题,其中行人检测是最早得以部署算法之一。在多数论文当中已经进行了非常全面的研究。然而,利用鱼眼相机进行环视的距离感知相对来说研究较少。由于径向畸变大,标准的边界框表示在鱼眼相机当中很难实施。为了缓解上述描述,我们探索了扩展边界框、椭圆、通用多边形设计为极坐标/角度表示,并定义一个实例分割mIOU度量来分析这些表示。所提出的具有多边形形状的模型fisheyeDetNet优于其他模型,并同时在用于自动驾驶的Valeo鱼眼相机数据集上实现了49.5%的mAP

特斯拉机器人进厂打工,马斯克:手的自由度今年将达到22个!

May 06, 2024 pm 04:13 PM

特斯拉机器人进厂打工,马斯克:手的自由度今年将达到22个!

May 06, 2024 pm 04:13 PM

特斯拉机器人Optimus最新视频出炉,已经可以在厂子里打工了。正常速度下,它分拣电池(特斯拉的4680电池)是这样的:官方还放出了20倍速下的样子——在小小的“工位”上,拣啊拣啊拣:这次放出的视频亮点之一在于Optimus在厂子里完成这项工作,是完全自主的,全程没有人为的干预。并且在Optimus的视角之下,它还可以把放歪了的电池重新捡起来放置,主打一个自动纠错:对于Optimus的手,英伟达科学家JimFan给出了高度的评价:Optimus的手是全球五指机器人里最灵巧的之一。它的手不仅有触觉

OpenAI超级对齐团队遗作:两个大模型博弈一番,输出更好懂了

Jul 19, 2024 am 01:29 AM

OpenAI超级对齐团队遗作:两个大模型博弈一番,输出更好懂了

Jul 19, 2024 am 01:29 AM

如果AI模型给的答案一点也看不懂,你敢用吗?随着机器学习系统在更重要的领域得到应用,证明为什么我们可以信任它们的输出,并明确何时不应信任它们,变得越来越重要。获得对复杂系统输出结果信任的一个可行方法是,要求系统对其输出产生一种解释,这种解释对人类或另一个受信任的系统来说是可读的,即可以完全理解以至于任何可能的错误都可以被发现。例如,为了建立对司法系统的信任,我们要求法院提供清晰易读的书面意见,解释并支持其决策。对于大型语言模型来说,我们也可以采用类似的方法。不过,在采用这种方法时,确保语言模型生

单卡跑Llama 70B快过双卡,微软硬生生把FP6搞到了A100里 | 开源

Apr 29, 2024 pm 04:55 PM

单卡跑Llama 70B快过双卡,微软硬生生把FP6搞到了A100里 | 开源

Apr 29, 2024 pm 04:55 PM

FP8和更低的浮点数量化精度,不再是H100的“专利”了!老黄想让大家用INT8/INT4,微软DeepSpeed团队在没有英伟达官方支持的条件下,硬生生在A100上跑起FP6。测试结果表明,新方法TC-FPx在A100上的FP6量化,速度接近甚至偶尔超过INT4,而且拥有比后者更高的精度。在此基础之上,还有端到端的大模型支持,目前已经开源并集成到了DeepSpeed等深度学习推理框架中。这一成果对大模型的加速效果也是立竿见影——在这种框架下用单卡跑Llama,吞吐量比双卡还要高2.65倍。一名

牛津大学最新!Mickey:3D中的2D图像匹配SOTA!(CVPR\'24)

Apr 23, 2024 pm 01:20 PM

牛津大学最新!Mickey:3D中的2D图像匹配SOTA!(CVPR\'24)

Apr 23, 2024 pm 01:20 PM

写在前面项目链接:https://nianticlabs.github.io/mickey/给定两张图片,可以通过建立图片之间的对应关系来估计它们之间的相机姿态。通常,这些对应关系是二维到二维的,而我们估计的姿态在尺度上是不确定的。一些应用,例如随时随地实现即时增强现实,需要尺度度量的姿态估计,因此它们依赖于外部的深度估计器来恢复尺度。本文提出了MicKey,这是一个关键点匹配流程,能够够预测三维相机空间中的度量对应关系。通过学习跨图像的三维坐标匹配,我们能够在没有深度测试的情况下推断出度量相对

Docker三分钟搞定LLama3开源大模型本地部署

Apr 26, 2024 am 10:19 AM

Docker三分钟搞定LLama3开源大模型本地部署

Apr 26, 2024 am 10:19 AM

概述LLaMA-3(LargeLanguageModelMetaAI3)是由Meta公司开发的大型开源生成式人工智能模型。它在模型结构上与前一代LLaMA-2相比没有大的变动。LLaMA-3模型分为不同规模的版本,包括小型、中型和大型,以适应不同的应用需求和计算资源。小型模型参参数规模为8B,中型模型参参数规模为70B,而大型模型参参数规模则达到400B。然而在训练中,目标是实现多模态、多语言的功能,预计结果将与GPT4/GPT4V相当。安装OllamaOllama是一个开源的大型语言模型(LL