人们正日益建立起一个开源语言模型生态系统,它为个人提供了综合资源来创建用于研究和商业目的的语言应用程序。

本文深入研究GPT4ALL,它通过提供全面的搭建模块,使任何人都能开发类似ChatGPT的聊天机器人,从而超越了特定的使用案例。

GPT4ALL can provide all the support needed when using state-of-the-art open-source large language models.。它可以访问开源模型和数据集,使用提供的代码训练和运行它们,使用Web界面或桌面应用程序与它们交互,连接到Langchain后端进行分布式计算,并使用Python API进行轻松集成。

开发人员最近推出了Apache-2许可的GPT4All-J聊天机器人,该机器人在大量精心策划的助手交互语料库上进行了训练,包括单词问题、多轮对话、代码、诗歌、歌曲和故事。为了使其更易于访问,他们还发布了Python bindings和一个聊天UI,使几乎所有人都可以在CPU上运行该模型。

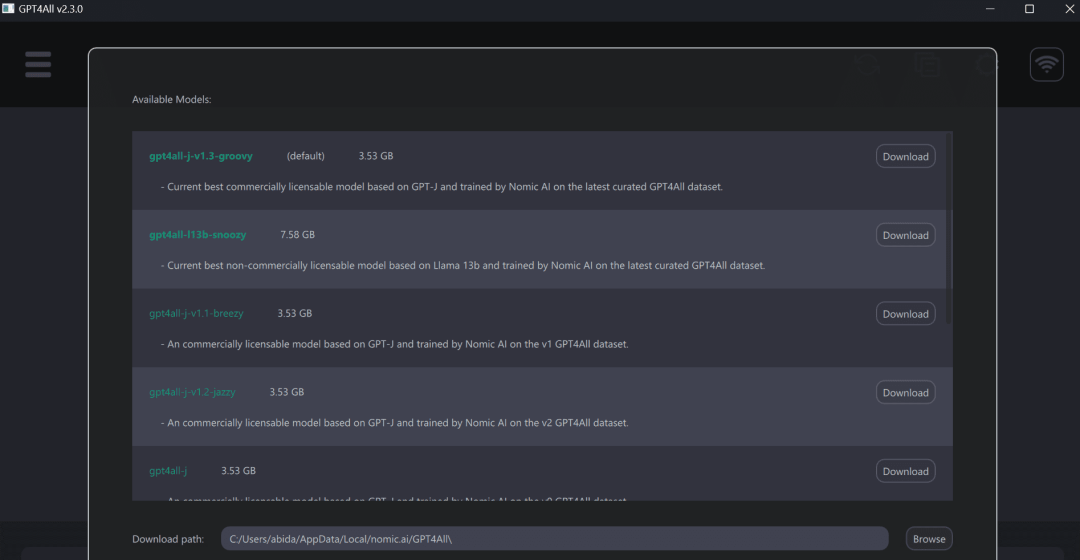

可以通过在桌面上安装本地的聊天客户端来自己尝试。

之后,运行GPT4ALL程序并下载自己选择的模型。也可以在这里(https://github.com/nomic-ai/gpt4all-chat#manual-download-of-models)手动下载模型,并将其安装在GUI中模型下载对话框所指示的位置。

使用GPT4ALL在笔记本电脑上的体验较佳,获得快速而准确的回应。即使非技术人员,也可以轻松使用GPT4ALL,因为它非常用户友好。

GPT4ALL有Python、TypeScript、Web Chat interface和Langchain后端。

在本节中,我们将研究使用nomic-ai/pygpt4all访问模型的Python API。

<code>pip install pygpt4all</code>

<code>from pygpt4all.models.gpt4all import GPT4Alldef new_text_callback(text):print(text, end="")model = GPT4All("./models/ggml-gpt4all-l13b-snoozy.bin")model.generate("Once upon a time, ", n_predict=55, new_text_callback=new_text_callback)</code>此外,可以使用转换器下载和运行推理。只需提供模型名称和版本。本文示例中正在访问最新且已改进的 v1.3-groovy 模型。

<code>from transformers import AutoModelForCausalLMmodel = AutoModelForCausalLM.from_pretrained("nomic-ai/gpt4all-j", revisinotallow="v1.3-groovy")</code>在nomic-ai/gpt4all资源库中,你可以获取源代码、模型权重、数据集和文档,用于训练和推理。你可以先尝试一些模型,然后再使用Python客户端或LangChain来将它们集成。

GPT4ALL为我们提供了一个CPU量化的GPT4All模型检查点。要访问它,我们必须:

Linux:cd chat;./gpt4all-lora-quantized-linux-x86

也可以前往Hugging Face Spaces,并试用Gpt4all的演示。

图片来自Gpt4all

以上是GPT4ALL:终极开源大语言模型解决方案的详细内容。更多信息请关注PHP中文网其他相关文章!