通过一组单词构建视觉语言模型可能性研究

译者 | 朱先忠

审校 | 重楼

当前,多模式人工智能已经成为一个街谈巷议的热门话题。随着GPT-4的最近发布,我们看到了无数可能出现的新应用和未来技术,而这在六个月前是不可想象的。事实上,视觉语言模型对许多不同的任务都普遍有用。例如,您可以使用CLIP(Contrastive Language-Image Pre-training,即“对比语言-图像预训练”,链接:https://www.php.cn/link/b02d46e8a3d8d9fd6028f3f2c2495864对看不到的数据集进行零样本图像分类;通常情况下,无需任何训练即可获得出色的表现。

同时,视觉语言模型也并不完美。在本文中,我们要探讨这些模型的局限性,强调它们可能失败的地方和原因。事实上,这篇文章是对我们最近将发表的论文的简短/高级描述,该论文计划将以ICLR 2023 Oral论文形式发表。如果您想查看本文有关完整的源代码,只需单击链接https://www.php.cn/link/afb992000fcf79ef7a53fffde9c8e044。

简介

什么是视觉语言模型?

视觉语言模型利用视觉和语言数据之间的协同作用来执行各种任务,从而彻底改变了该领域。虽然目前已有的文献中已经引入了许多视觉语言模型,但CLIP(对比语言-图像预训练)仍然是最知名和最广泛使用的模型。

通过在同一向量空间中嵌入图像和标题,CLIP模型允许进行跨模式推理,使用户能够以良好的准确性执行诸如零样本图像分类和文本到图像检索等任务。并且,CLIP模型使用对比学习方法来学习图像和标题的嵌入。

对比学习简介

对比学习使得CLIP模型可以通过在共享向量空间中最小化图像之间的距离来学习将图像与其相应的标题相关联。CLIP模型和其他基于对比的模型所取得的令人印象深刻的结果证明了这种方法是非常有效的。

对比度损失用于比较批次中的图像和标题对,并优化模型以最大化匹配图像-文本对的嵌入之间的相似性,并降低批次中其他图像-文本对之间的相似度。

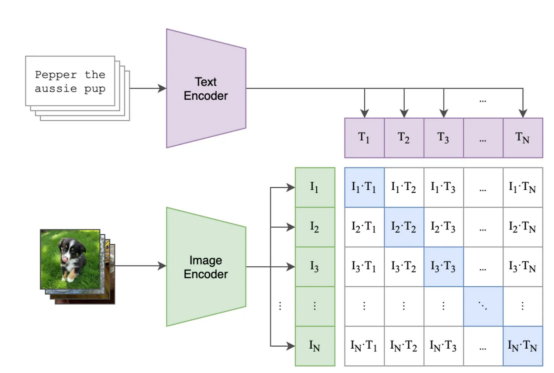

下图展示了可能的批处理和训练步骤示例,其中:

- 紫色方块包含所有标题的嵌入,绿色方块包含所有图像的嵌入。

- 矩阵的平方包含批次中所有图像嵌入和所有文本嵌入的点积(读作“余弦相似性”,因为嵌入是标准化的)。

- 蓝色正方形包含模型必须最大化相似性的图像-文本对之间的点积,其他白色正方形是我们希望最小化的相似性(因为这些正方形中的每一个都包含不匹配的图像-文本对的相似性,例如猫的图像和描述“my vintage chair”(我的复古椅子)。

CLIP模型中的对比预训练(其中,蓝色方块是我们想要优化相似性的图像-文本对)

经过训练后,你应该可以生成一个可以在其中对图像和标题进行编码的有意义的向量空间。一旦为每个图像和每个文本嵌入了内容,你就可以做很多任务,比如看哪些图像更符合标题(例如,在2017年暑假相册中找到“dogs on the beach”(海滩上的狗)),或者找到哪个文本标签更像给定图片(例如,你有一大堆你的狗和猫的图像,你希望能够识别哪个是哪个)。

CLIP等视觉语言模型已成为通过集成视觉和语言信息来解决复杂人工智能任务的强大工具。他们将这两种类型的数据嵌入共享向量空间的能力在广泛的应用中带来了前所未有的准确性和出众表现。

视觉语言模型能理解语言吗?

我们所做的工作正是试图采取一些手段来回答这个问题。关于深度模型能否或者说能在多大程度上理解语言这个问题,当前还存在着重大的争论。在这里,我们的目标是研究视觉语言模型及其合成能力。

我们首先提出了一个新的数据集用来测试成分理解;这个新的基准被称为ARO(Attribution,Relations,and Order:属性、关系和顺序)。接着,我们探讨为什么对比损失在这种情况下可能是有限的。最后,我们为这个问题提出了一个简单但有希望的解决方案。

新基准:ARO(属性、关系和顺序)

像CLIP(以及Salesforce最近推出的BLIP)这样的模型在理解语言方面做得怎么样呢?

我们收集了一组基于属性的合成标题(例如“the red door and the standing man”(红门和站着的人))和一组基于关系的合成标题(例如“the horse is eating the grass”(马在吃草))以及相匹配的图像。然后,我们生成替代后的虚假标题,比如“the grass is eating the horse”(草正在吃马)。模型们能找到正确的标题吗?我们还探讨了混排单词的效果:难道模型更喜欢非混排标题而不是混排标题吗?

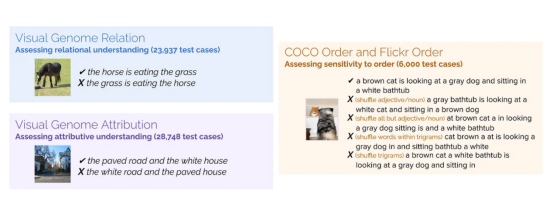

我们为属性、关系和顺序(ARO)基准创建的四个数据集如下图所示(请注意,顺序部分包含两个数据集):

我们创建的不同数据集包括Relation、Attribution和Order。对于每个数据集,我们显示一个图像示例和不同的标题。其中,只有一个标题是正确的,模型必须识别出这个正确的标题。

- 属性测试对属性的理解结果是:“the paved road and the white house”(铺好的路和白房子)与“the white road and the paved house”(白路和铺好的房子)。

- 关系测试对关系的理解结果是:“the horse is eating the grass”(马在吃草)和“the grass is eating the horse”(草在吃草)。

- 最后,Order测试了模型对顺序打乱后的弹性结果:我们随机打乱标准数据集(例如,MSCOCO)的标题。

视觉语言模型能找到与图像匹配的正确标题吗?这项任务似乎很容易,我们希望模型能够理解“马在吃草”和“草在吃草”之间的区别,对吧?我的意思是,谁见过草在吃东西?

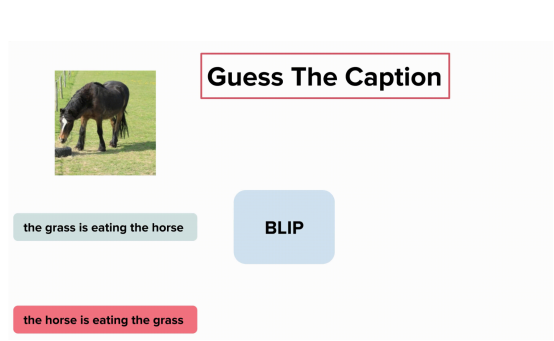

好吧,可能是BLIP模型,因为它无法理解“马在吃草”和“草在吃草”之间的区别:

BLIP模型不理解“草在吃草”和“马在吃草”之间的区别(其中包含来自视觉基因组数据集的元素,图片由作者提供)

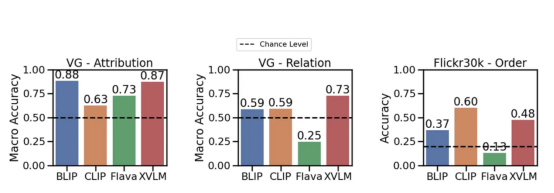

现在,让我们看看实验结果:很少有模型能在很大程度上超越理解关系的可能性(例如,eating——吃饭)。但是,CLIP模型在属性和关系的边缘方面略高于此可能性。这实际上表明视觉语言模型尚存在问题。

不同模型在属性、关系和顺序(Flick30k)基准上的性能。其中使用了CLIP、BLIP以及其他SoTA模型

检索与对比损失评判

这项工作的主要结果之一是,我们学习语言需要的可能不仅仅是标准的对比损失。这又是为什么呢?

让我们从头开始:视觉语言模型通常在检索任务中进行评估:取一个标题并找到它映射到的图像。如果你查看用于评估这些模型的数据集(例如,MSCOCO、Flickr30K),你会看到,它们通常包含用标题描述的图像,这些标题需要理解构图能力(例如,“the orange cat is on the red table”:橙色的猫在红色的桌子上)。那么,如果标题很复杂,为什么模型不能学习构图理解呢?

[说明]在这些数据集上进行检索并不一定需要对组成的理解。

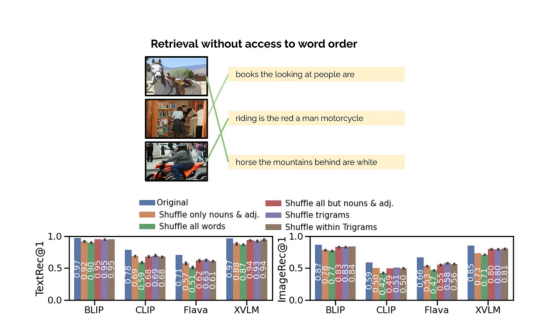

我们试图更好地理解这个问题,并在打乱标题中单词的顺序时测试了模型在检索方面的性能。我们能找到标题“books the looking at people are”的正确图像吗?如果答案是肯定的;这意味着,不需要指令信息来找到正确的图像。

我们测试模型的任务是使用打乱的标题进行检索。即使我们打乱标题,模型也可以正确地找到相应的图像(反之亦然)。这表明检索任务可能过于简单,图片由作者提供。

我们测试了不同的乱序过程,结果是肯定的:即使使用不同的乱序技术,检索性能也基本上不会受到影响。

让我们再说一次:视觉语言模型在这些数据集上实现了高性能的检索,即使指令信息无法访问。这些模型可能表现得像一堆单词,其中顺序并不重要:如果模型不需要理解单词顺序才能在检索中表现良好,那么我们在检索中实际衡量的是什么?

怎么办?

既然我们知道存在问题,我们可能想寻找解决方案。最简单的方法是:让CLIP模型明白“猫在桌子上”和“桌子在猫身上”是不同的。

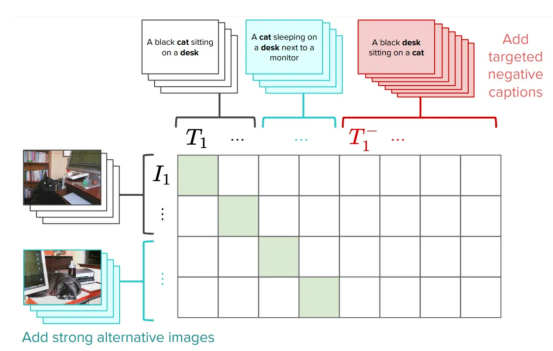

事实上,我们所建议的一种途径是通过添加专门为解决这个问题而制作的硬底片来改进CLIP训练。这是一个非常简单有效的解决方案:它需要对原始CLIP损失进行非常小的编辑,而不会影响总体性能(您可以在论文中阅读一些注意事项)。我们将此版本的CLIP称为NegCLIP。

在CLIP模型中引入硬底片(我们添加了图像和文本硬底片,图片由作者提供)

基本上,我们要求NegCLIP模型将黑猫的图像放在“a black cat sitting on a desk”(坐在桌子上的黑猫)这句话附近,但远离句子“a black desk sitting on a cat”(坐在猫身上的黑色桌子)。注意,后者是通过使用POS标签自动生成的。

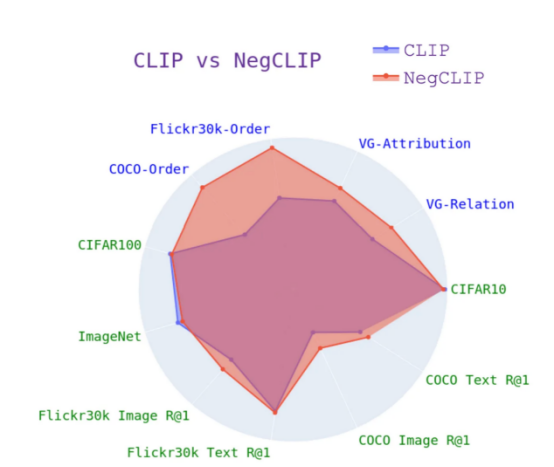

该修复的效果是,它实际上可以提高ARO基准的性能,而不会损害检索性能或检索和分类等下游任务的性能。有关不同基准的结果,请参见下图(有关详细信息,请参阅本文对应论文)。

不同基准上的NegCLIP模型与CLIP模型。其中,蓝色基准是我们介绍的基准,绿色基准来自网络文献(图片由作者提供)

您可以看到,这里与ARO基准相比有了巨大的改进,在其他下游任务上也有了边缘改进或类似的性能。

编程实现

Mert(论文的主要作者)在创建一个小型库来测试视觉语言模型方面做得很好。你可以使用他的代码来复制我们的结果,或者用新的模型进行实验。

下载数据集并开始运行只需要少数几行Python语言:

import clip

from dataset_zoo import VG_Relation, VG_Attribution

model, image_preprocess = clip.load("ViT-B/32", device="cuda")

root_dir="/path/to/aro/datasets"

#把 download设置为True将把数据集下载到路径`root_dir`——如果不存在的话

#对于VG-R和VG-A,这将是1GB大小的压缩zip文件——它是GQA的一个子集

vgr_dataset = VG_Relation(image_preprocess=preprocess,

download=True, root_dir=root_dir)

vga_dataset = VG_Attribution(image_preprocess=preprocess,

download=True, root_dir=root_dir)

#可以对数据集作任何处理。数据集中的每一项具有类似如下的形式:

# item = {"image_options": [image], "caption_options": [false_caption, true_caption]}此外,我们还实现了NegCLIP模型(其实际是OpenCLIP的一个更新副本),其完整代码下载地址是https://github.com/vinid/neg_clip。

结语

总之,视觉语言模型目前已经可以做很多事情了。接下来,我们迫不及待地想看看GPT4等未来的模型能做什么!

译者介绍

朱先忠,51CTO社区编辑,51CTO专家博客、讲师,潍坊一所高校计算机教师,自由编程界老兵一枚。

原文标题:Your Vision-Language Model Might Be a Bag of Words,作者:Federico Bianchi

以上是通过一组单词构建视觉语言模型可能性研究的详细内容。更多信息请关注PHP中文网其他相关文章!

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

Video Face Swap

使用我们完全免费的人工智能换脸工具轻松在任何视频中换脸!

热门文章

热工具

记事本++7.3.1

好用且免费的代码编辑器

SublimeText3汉化版

中文版,非常好用

禅工作室 13.0.1

功能强大的PHP集成开发环境

Dreamweaver CS6

视觉化网页开发工具

SublimeText3 Mac版

神级代码编辑软件(SublimeText3)

热门话题

字节跳动剪映推出 SVIP 超级会员:连续包年 499 元,提供多种 AI 功能

Jun 28, 2024 am 03:51 AM

字节跳动剪映推出 SVIP 超级会员:连续包年 499 元,提供多种 AI 功能

Jun 28, 2024 am 03:51 AM

本站6月27日消息,剪映是由字节跳动旗下脸萌科技开发的一款视频剪辑软件,依托于抖音平台且基本面向该平台用户制作短视频内容,并兼容iOS、安卓、Windows、MacOS等操作系统。剪映官方宣布会员体系升级,推出全新SVIP,包含多种AI黑科技,例如智能翻译、智能划重点、智能包装、数字人合成等。价格方面,剪映SVIP月费79元,年费599元(本站注:折合每月49.9元),连续包月则为59元每月,连续包年为499元每年(折合每月41.6元)。此外,剪映官方还表示,为提升用户体验,向已订阅了原版VIP

使用Rag和Sem-Rag提供上下文增强AI编码助手

Jun 10, 2024 am 11:08 AM

使用Rag和Sem-Rag提供上下文增强AI编码助手

Jun 10, 2024 am 11:08 AM

通过将检索增强生成和语义记忆纳入AI编码助手,提升开发人员的生产力、效率和准确性。译自EnhancingAICodingAssistantswithContextUsingRAGandSEM-RAG,作者JanakiramMSV。虽然基本AI编程助手自然有帮助,但由于依赖对软件语言和编写软件最常见模式的总体理解,因此常常无法提供最相关和正确的代码建议。这些编码助手生成的代码适合解决他们负责解决的问题,但通常不符合各个团队的编码标准、惯例和风格。这通常会导致需要修改或完善其建议,以便将代码接受到应

微调真的能让LLM学到新东西吗:引入新知识可能让模型产生更多的幻觉

Jun 11, 2024 pm 03:57 PM

微调真的能让LLM学到新东西吗:引入新知识可能让模型产生更多的幻觉

Jun 11, 2024 pm 03:57 PM

大型语言模型(LLM)是在巨大的文本数据库上训练的,在那里它们获得了大量的实际知识。这些知识嵌入到它们的参数中,然后可以在需要时使用。这些模型的知识在训练结束时被“具体化”。在预训练结束时,模型实际上停止学习。对模型进行对齐或进行指令调优,让模型学习如何充分利用这些知识,以及如何更自然地响应用户的问题。但是有时模型知识是不够的,尽管模型可以通过RAG访问外部内容,但通过微调使用模型适应新的领域被认为是有益的。这种微调是使用人工标注者或其他llm创建的输入进行的,模型会遇到额外的实际知识并将其整合

七个很酷的GenAI & LLM技术性面试问题

Jun 07, 2024 am 10:06 AM

七个很酷的GenAI & LLM技术性面试问题

Jun 07, 2024 am 10:06 AM

想了解更多AIGC的内容,请访问:51CTOAI.x社区https://www.51cto.com/aigc/译者|晶颜审校|重楼不同于互联网上随处可见的传统问题库,这些问题需要跳出常规思维。大语言模型(LLM)在数据科学、生成式人工智能(GenAI)和人工智能领域越来越重要。这些复杂的算法提升了人类的技能,并在诸多行业中推动了效率和创新性的提升,成为企业保持竞争力的关键。LLM的应用范围非常广泛,它可以用于自然语言处理、文本生成、语音识别和推荐系统等领域。通过学习大量的数据,LLM能够生成文本

你所不知道的机器学习五大学派

Jun 05, 2024 pm 08:51 PM

你所不知道的机器学习五大学派

Jun 05, 2024 pm 08:51 PM

机器学习是人工智能的重要分支,它赋予计算机从数据中学习的能力,并能够在无需明确编程的情况下改进自身能力。机器学习在各个领域都有着广泛的应用,从图像识别和自然语言处理到推荐系统和欺诈检测,它正在改变我们的生活方式。机器学习领域存在着多种不同的方法和理论,其中最具影响力的五种方法被称为“机器学习五大派”。这五大派分别为符号派、联结派、进化派、贝叶斯派和类推学派。1.符号学派符号学(Symbolism),又称为符号主义,强调利用符号进行逻辑推理和表达知识。该学派认为学习是一种逆向演绎的过程,通过已有的

为大模型提供全新科学复杂问答基准与测评体系,UNSW、阿贡、芝加哥大学等多家机构联合推出SciQAG框架

Jul 25, 2024 am 06:42 AM

为大模型提供全新科学复杂问答基准与测评体系,UNSW、阿贡、芝加哥大学等多家机构联合推出SciQAG框架

Jul 25, 2024 am 06:42 AM

编辑|ScienceAI问答(QA)数据集在推动自然语言处理(NLP)研究发挥着至关重要的作用。高质量QA数据集不仅可以用于微调模型,也可以有效评估大语言模型(LLM)的能力,尤其是针对科学知识的理解和推理能力。尽管当前已有许多科学QA数据集,涵盖了医学、化学、生物等领域,但这些数据集仍存在一些不足。其一,数据形式较为单一,大多数为多项选择题(multiple-choicequestions),它们易于进行评估,但限制了模型的答案选择范围,无法充分测试模型的科学问题解答能力。相比之下,开放式问答

SK 海力士 8 月 6 日将展示 AI 相关新品:12 层 HBM3E、321-high NAND 等

Aug 01, 2024 pm 09:40 PM

SK 海力士 8 月 6 日将展示 AI 相关新品:12 层 HBM3E、321-high NAND 等

Aug 01, 2024 pm 09:40 PM

本站8月1日消息,SK海力士今天(8月1日)发布博文,宣布将出席8月6日至8日,在美国加利福尼亚州圣克拉拉举行的全球半导体存储器峰会FMS2024,展示诸多新一代产品。未来存储器和存储峰会(FutureMemoryandStorage)简介前身是主要面向NAND供应商的闪存峰会(FlashMemorySummit),在人工智能技术日益受到关注的背景下,今年重新命名为未来存储器和存储峰会(FutureMemoryandStorage),以邀请DRAM和存储供应商等更多参与者。新产品SK海力士去年在

SOTA性能,厦大多模态蛋白质-配体亲和力预测AI方法,首次结合分子表面信息

Jul 17, 2024 pm 06:37 PM

SOTA性能,厦大多模态蛋白质-配体亲和力预测AI方法,首次结合分子表面信息

Jul 17, 2024 pm 06:37 PM

编辑|KX在药物研发领域,准确有效地预测蛋白质与配体的结合亲和力对于药物筛选和优化至关重要。然而,目前的研究没有考虑到分子表面信息在蛋白质-配体相互作用中的重要作用。基于此,来自厦门大学的研究人员提出了一种新颖的多模态特征提取(MFE)框架,该框架首次结合了蛋白质表面、3D结构和序列的信息,并使用交叉注意机制进行不同模态之间的特征对齐。实验结果表明,该方法在预测蛋白质-配体结合亲和力方面取得了最先进的性能。此外,消融研究证明了该框架内蛋白质表面信息和多模态特征对齐的有效性和必要性。相关研究以「S