使用PHP实现Web爬虫

Web爬虫是一种自动化工具,可以浏览互联网上的网页,收集信息并存储在一个数据库中。在今天的大数据时代,Web爬虫越来越重要,因为它可以查找大量信息并进行数据分析。在本文中,我们将学习如何使用PHP编写Web爬虫,并使用它进行文本挖掘和数据分析。

Web爬虫是一个不错的选择,可用于从网站中收集内容。需要注意的是,您应该始终严格遵守道德和法律准则。如果您想自己编写Web爬虫,请遵循以下步骤。

- 安装和配置PHP环境

首先,您需要安装PHP环境。从官方网站上“php.net”可以下载最新的PHP版本。下载后,您需要将PHP安装到您的计算机上。在大多数情况下,您可以在互联网上找到关于如何安装PHP的视频和文章。

- 设置Web爬虫的源代码

要开始编写Web爬虫,您需要打开源代码编辑器。您可以使用任何文本编辑器来编写Web爬虫,但是我们推荐使用专业的PHP开发工具,如“PHPStorm”或“Sublime Text”。

3.编写Web爬虫程序

下面是一个简单的Web爬虫代码,您可以按照程序说明创建一个Web爬虫和爬取数据。

<?php

// 定义URL

$startUrl = "https://www.example.com";

$depth = 2;

// 放置已经处理的URL和当前的深度

$processedUrls = [

$startUrl => 0

];

// 运行爬虫

getAllLinks($startUrl, $depth);

//获取给定URL的HTML

function getHTML($url) {

$curl = curl_init();

curl_setopt($curl, CURLOPT_URL, $url);

curl_setopt($curl, CURLOPT_RETURNTRANSFER, true);

$html = curl_exec($curl);

curl_close($curl);

return $html;

}

//获取所有链接

function getAllLinks($url, $depth) {

global $processedUrls;

if ($depth === 0) {

return;

}

$html = getHTML($url);

$dom = new DOMDocument();

@$dom->loadHTML($html);

$links = $dom->getElementsByTagName('a');

foreach ($links as $link) {

$href = $link->getAttribute('href');

if (strpos($href, $url) !== false && !array_key_exists($href, $processedUrls)) {

$processedUrls[$href] = $processedUrls[$url] + 1;

echo $href . " (Depth: " . $processedUrls[$href] . ")" . PHP_EOL;

getAllLinks($href, $depth - 1);

}

}

}该程序叫做“深度优先遍历方法(Depth-first search (DFS))”,它从起始URL开始,向下爬取其链接,同时记录它们的深度,直到目标深度。

4.存储数据

获得数据后,您需要将它们存储在数据库中,以便以后进行分析。您可以使用任何喜欢的MySQL,SQLite或MongoDB等数据库,具体取决于您的需求。

- 文本挖掘和数据分析

在存储数据后,您可以使用Python或R等编程语言来进行文本挖掘和数据分析。数据分析的目的是帮助您从收集的数据中获取有用的信息。

以下是一些您可以使用的数据分析技术:

- 文本分析: 文本分析可以帮助您从大量文本数据中提取有用的信息,例如情感分析、主题建模、实体识别等。

- 聚类分析: 聚类分析可以帮助您把数据分成不同的组,并查看它们之间的相似性和差异性。

- 预测分析: 使用预测分析技术,您可以为未来制定业务计划,并根据以前的历史情况预测趋势。

总结

Web爬虫是一种非常有用的工具,可以帮助您从互联网上搜集数据并使用它们来进行分析。在使用Web爬虫时,请务必遵守伦理和法律规定,以保持道德准则。希望这篇文章对您有所帮助,并鼓励您开始创建自己的Web爬虫和进行数据分析。

以上是使用PHP实现Web爬虫的详细内容。更多信息请关注PHP中文网其他相关文章!

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

AI Hentai Generator

免费生成ai无尽的。

热门文章

热工具

记事本++7.3.1

好用且免费的代码编辑器

SublimeText3汉化版

中文版,非常好用

禅工作室 13.0.1

功能强大的PHP集成开发环境

Dreamweaver CS6

视觉化网页开发工具

SublimeText3 Mac版

神级代码编辑软件(SublimeText3)

热门话题

适用于 Ubuntu 和 Debian 的 PHP 8.4 安装和升级指南

Dec 24, 2024 pm 04:42 PM

适用于 Ubuntu 和 Debian 的 PHP 8.4 安装和升级指南

Dec 24, 2024 pm 04:42 PM

PHP 8.4 带来了多项新功能、安全性改进和性能改进,同时弃用和删除了大量功能。 本指南介绍了如何在 Ubuntu、Debian 或其衍生版本上安装 PHP 8.4 或升级到 PHP 8.4

讨论 CakePHP

Sep 10, 2024 pm 05:28 PM

讨论 CakePHP

Sep 10, 2024 pm 05:28 PM

CakePHP 是 PHP 的开源框架。它的目的是使应用程序的开发、部署和维护变得更加容易。 CakePHP 基于类似 MVC 的架构,功能强大且易于掌握。模型、视图和控制器 gu

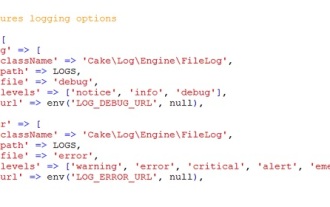

CakePHP 日志记录

Sep 10, 2024 pm 05:26 PM

CakePHP 日志记录

Sep 10, 2024 pm 05:26 PM

登录 CakePHP 是一项非常简单的任务。您只需使用一项功能即可。您可以记录任何后台进程(如 cronjob)的错误、异常、用户活动、用户采取的操作。在 CakePHP 中记录数据很容易。提供了 log() 函数

如何设置 Visual Studio Code (VS Code) 进行 PHP 开发

Dec 20, 2024 am 11:31 AM

如何设置 Visual Studio Code (VS Code) 进行 PHP 开发

Dec 20, 2024 am 11:31 AM

Visual Studio Code,也称为 VS Code,是一个免费的源代码编辑器 - 或集成开发环境 (IDE) - 可用于所有主要操作系统。 VS Code 拥有针对多种编程语言的大量扩展,可以轻松编写

CakePHP 快速指南

Sep 10, 2024 pm 05:27 PM

CakePHP 快速指南

Sep 10, 2024 pm 05:27 PM

CakePHP 是一个开源MVC 框架。它使开发、部署和维护应用程序变得更加容易。 CakePHP 有许多库可以减少大多数常见任务的过载。