GPT-4数学能力大蹦极!OpenAI爆火研究「过程监督」突破78.2%难题,干掉幻觉

ChatGPT自发布以来,数学能力饱受诟病。

就连「数学天才」陶哲轩曾表示,GPT-4在自己的数学专业领域,并没有太多的增值。

怎么办,就一直让ChatGPT做个「数学智障」么?

OpenAI在努力——为了提升GPT-4的数学推理能力,OpenAI团队用「过程监督」(PRM)训练模型。

让我们一步一步验证!

论文地址:https://cdn.openai.com/improving-mathematical-reasoning-with-process-supervision/Lets_Verify_Step_by_Step.pdf

论文中,研究人员训练模型通过奖励每一个正确的推理步骤,即「过程监督」,而不仅仅是奖励正确的最终结果(结果监督),在数学问题解决方面取得最新SOTA。

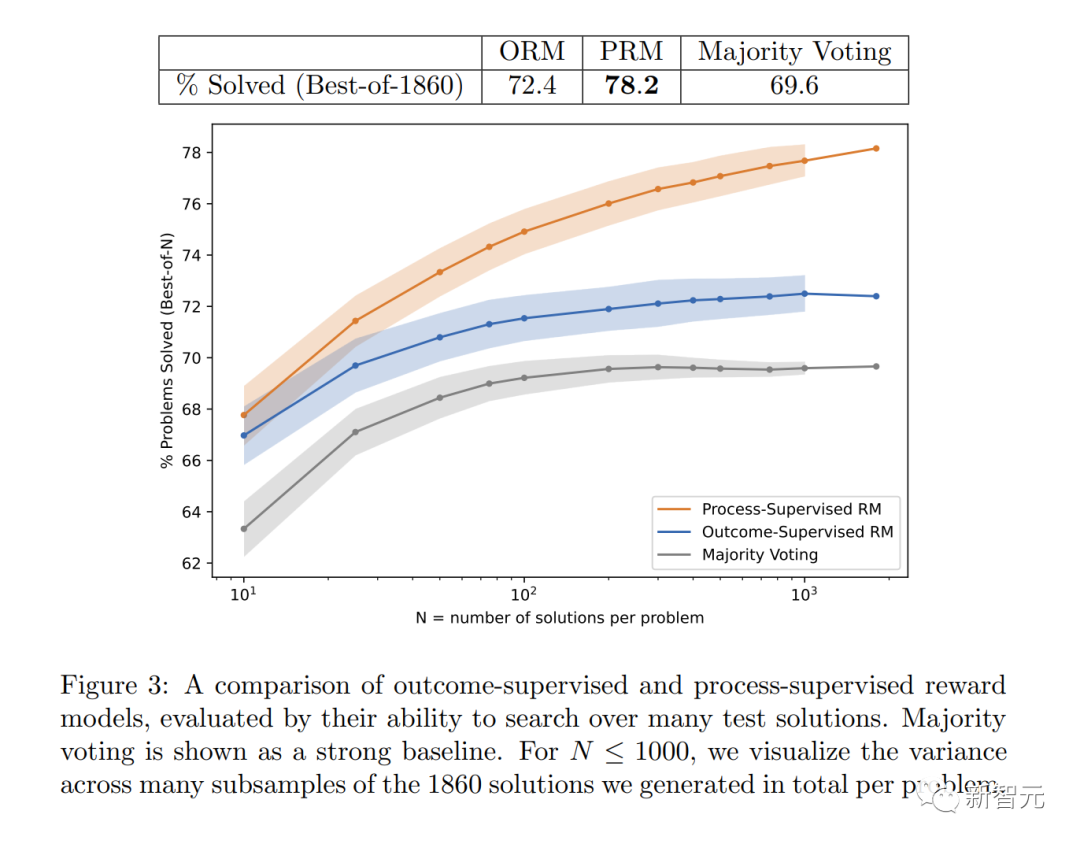

具体来讲, PRM解决了MATH测试集代表性子集中78.2%的问题。

此外,OpenAI发现「过程监督」在对齐上有很大的价值——训练模型产生人类认可的思维链。

最新研究当然少不了Sam Altman的转发,「我们的Mathgen团队在过程监督上取得了非常令人振奋的结果,这是对齐的积极信号。」

在实践中,「过程监督」因为需要人工反馈,对于大模型和各种任务来说成本都极其高昂。因此,这项工作意义重大,可以说能够确定OpenAI未来的研究方向。

解决数学问题

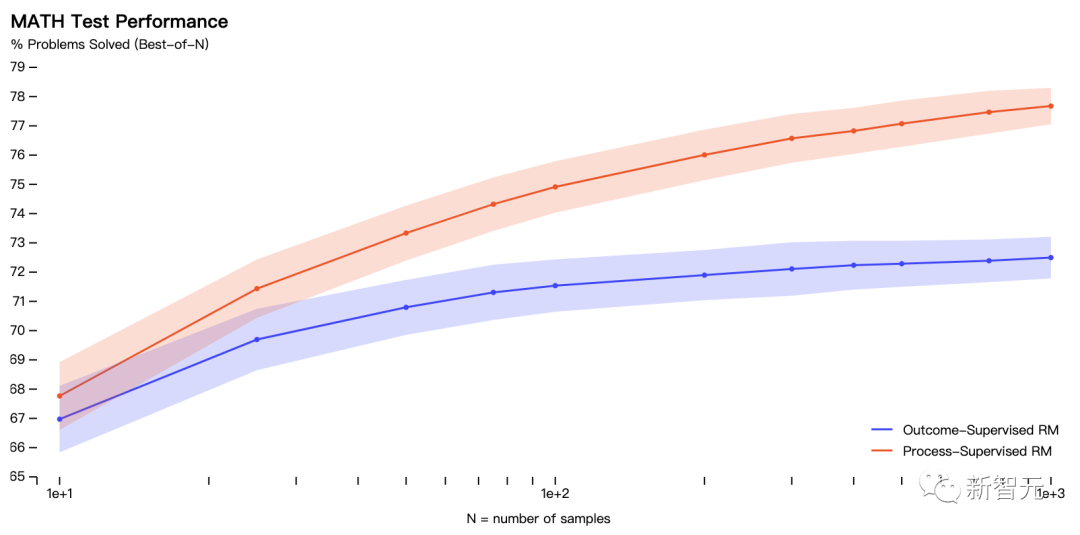

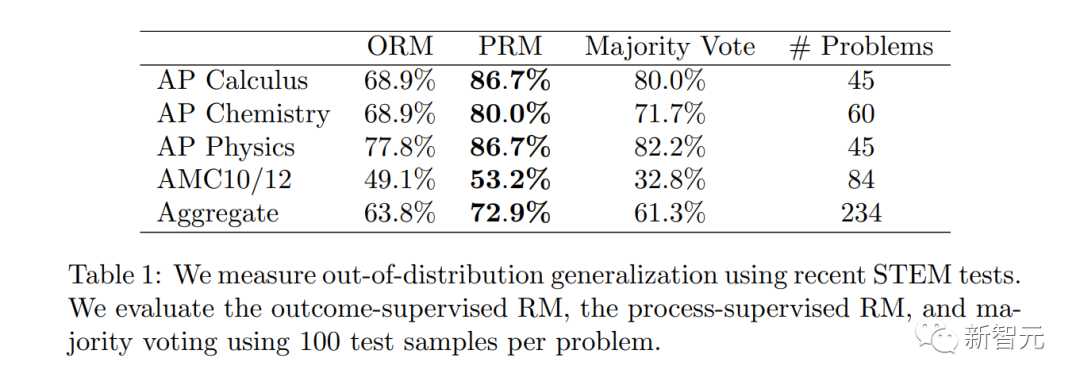

实验中,研究人员用MATH数据集中的问题,来评估「过程监督」和「结果监督」的奖励模型。

让模型为每个问题生成许多解决方案,然后挑选每个奖励模型排名最高的解决方案。

如图显示了所选解决方案中,取得正确最终答案的百分比,作为所考虑解决方案数量的函数。

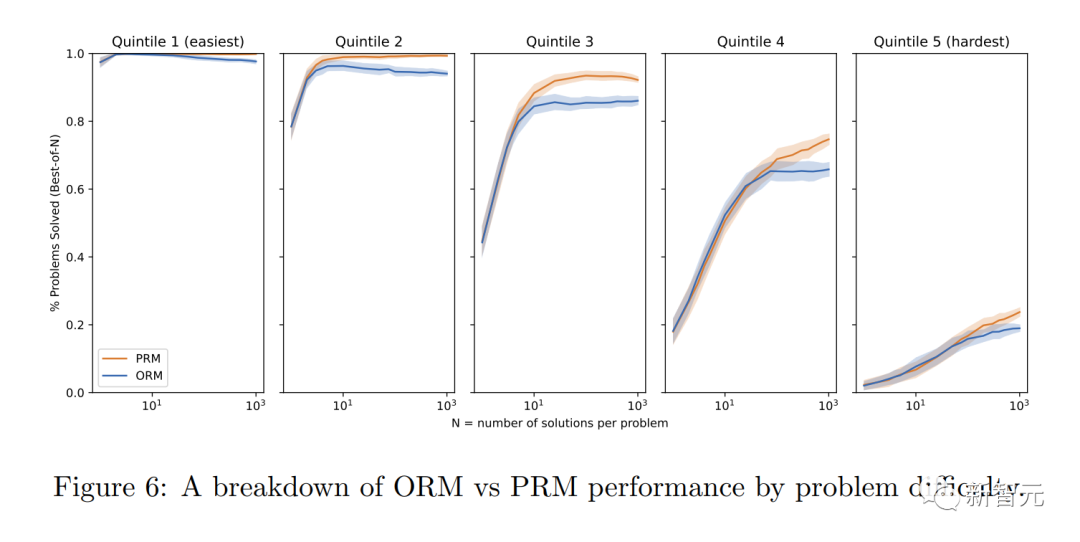

「过程监督」奖励模型不仅在整体上表现更好,而且随着考虑每个问题的更多解决方案,性能差距也在扩大。

这表明,「过程监督」奖励模型更加可靠。

如下,OpenAI展示了模型的10个数学问题和解决方案,以及对奖励模型优缺点的评论。

从以下三类指标,真正(TP)、真负(TN)、假正(FP),对模型进行了评估。

真正(TP)

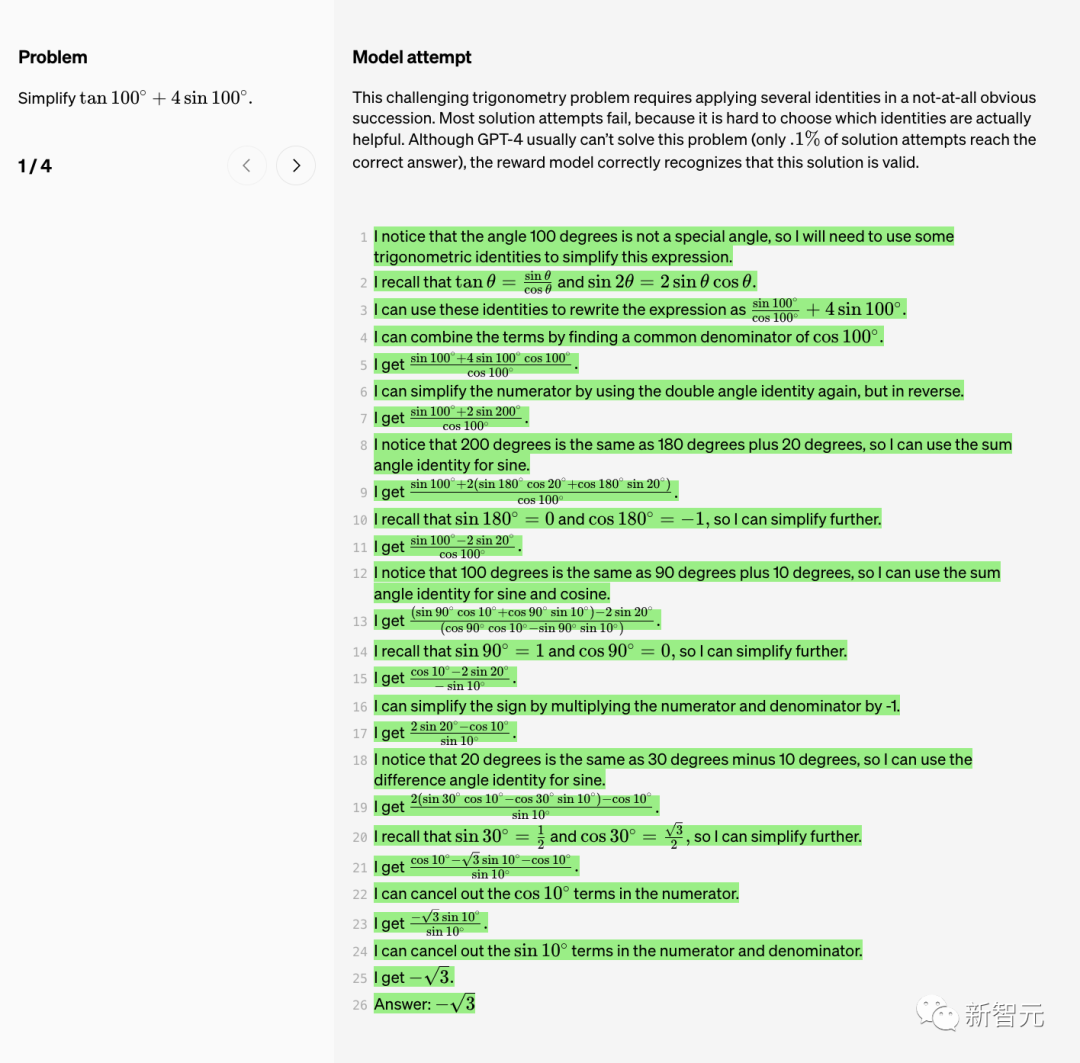

先来简化个三角函数公式。

这个具有挑战性的三角函数问题,需要以一种不明显的顺序应用几个恒等式。

但是大多数解决尝试都失败了,因为很难选择哪些恒等式实际上是有用的。

虽然GPT-4通常不能解决这个问题,只有0.1%的解决方案尝试实现正确答案,但奖励模型正确地识别出这个解决方案是有效的。

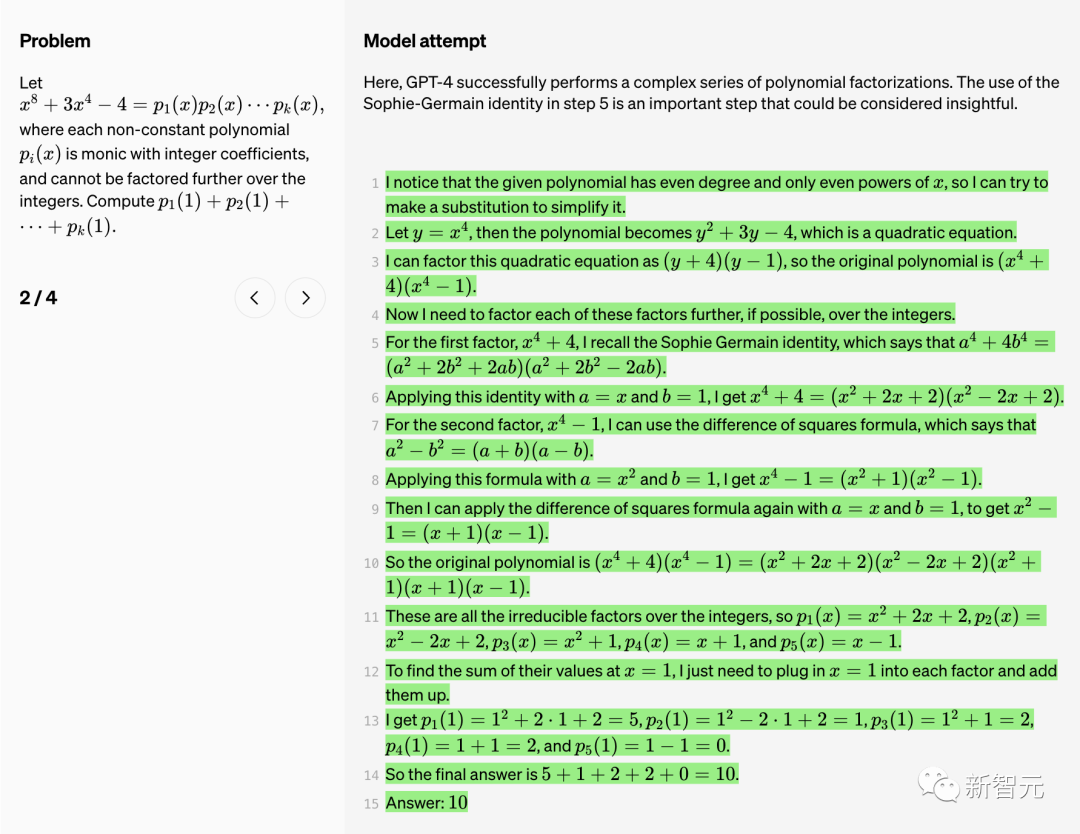

这里,GPT-4成功地执行了一系列复杂的多项式因式分解。

在步骤5中使用Sophie-Germain恒等式是一个重要的步骤。可见,这一步骤很有洞察力。

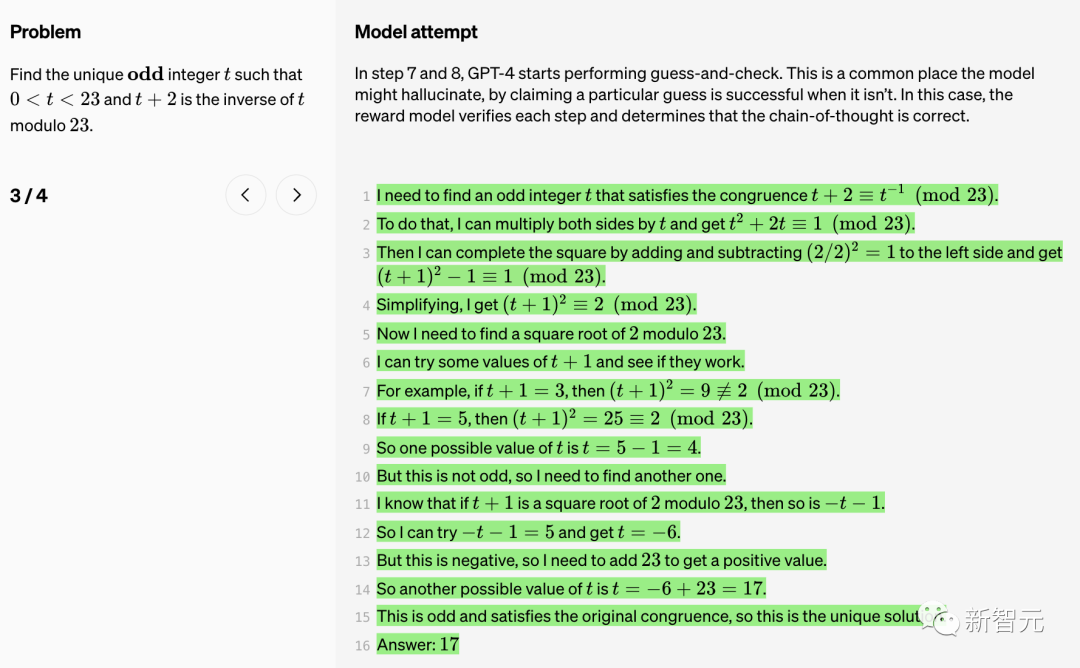

在步骤7和8中,GPT-4开始执行猜测和检查。

这是该模型可能产生「幻觉」的常见地方,它会声称某个特定的猜测是成功的。在这种情况下,奖励模型验证每一步,并确定思维链是正确的。

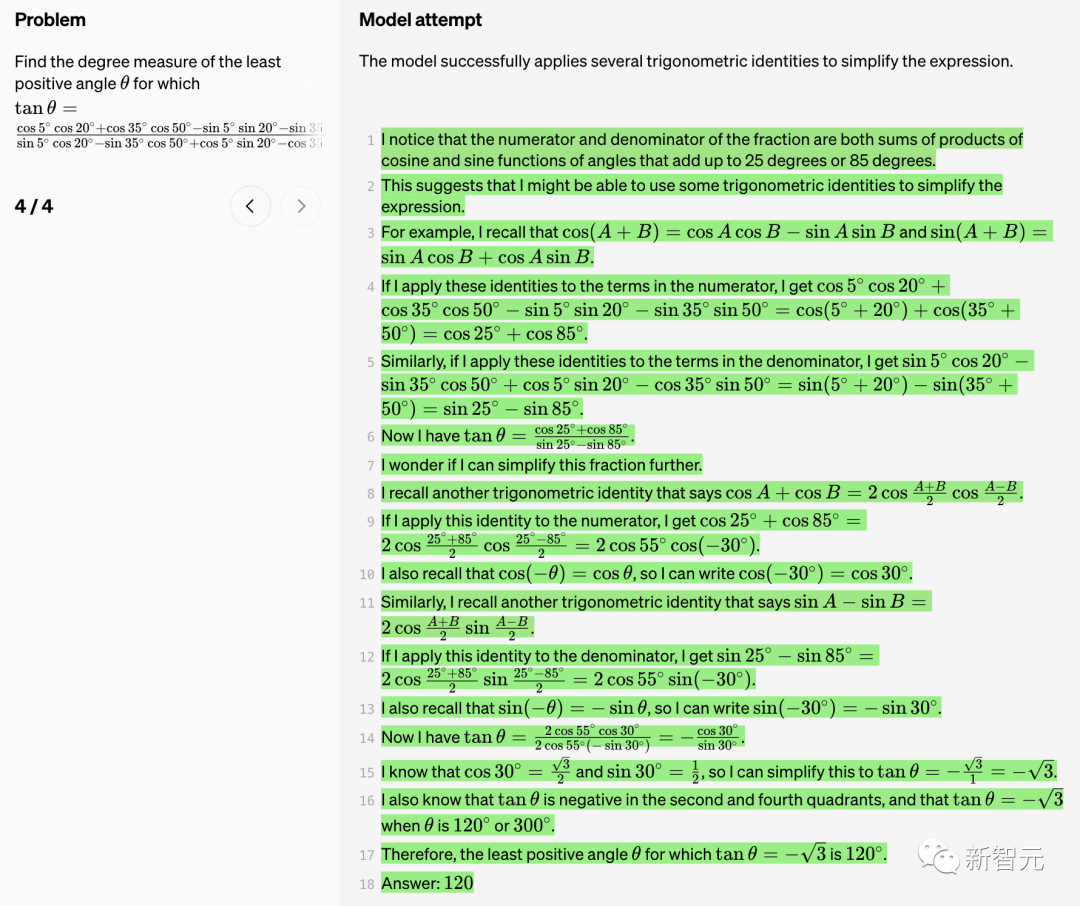

模型成功地应用了几个三角恒等式以简化表达式。

真负(TN)

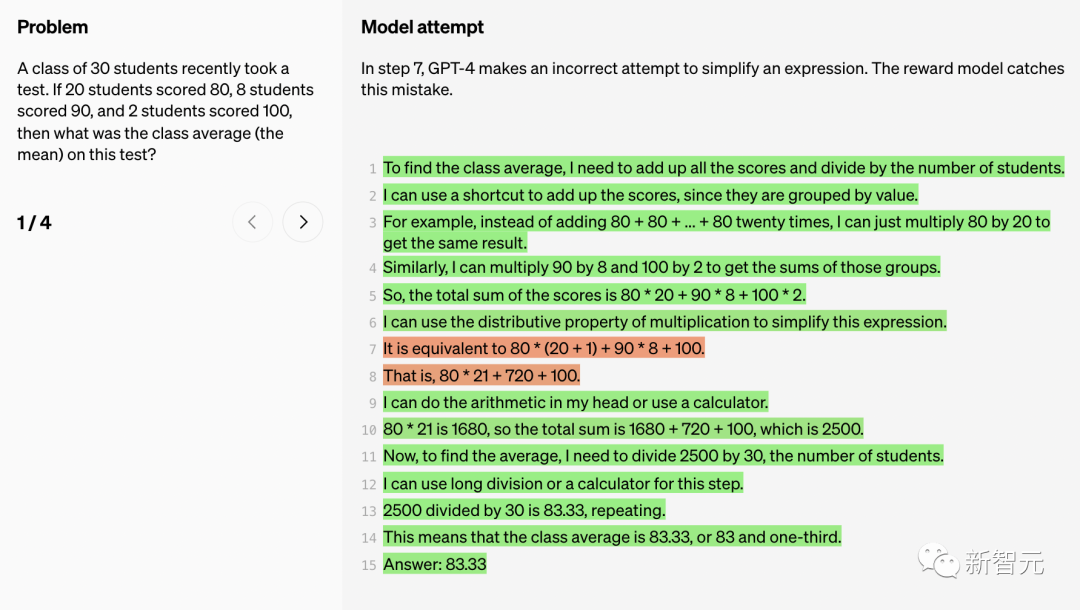

在步骤7中,GPT-4试图简化一个表达式,但尝试失败。奖励模型发现了这个错误。

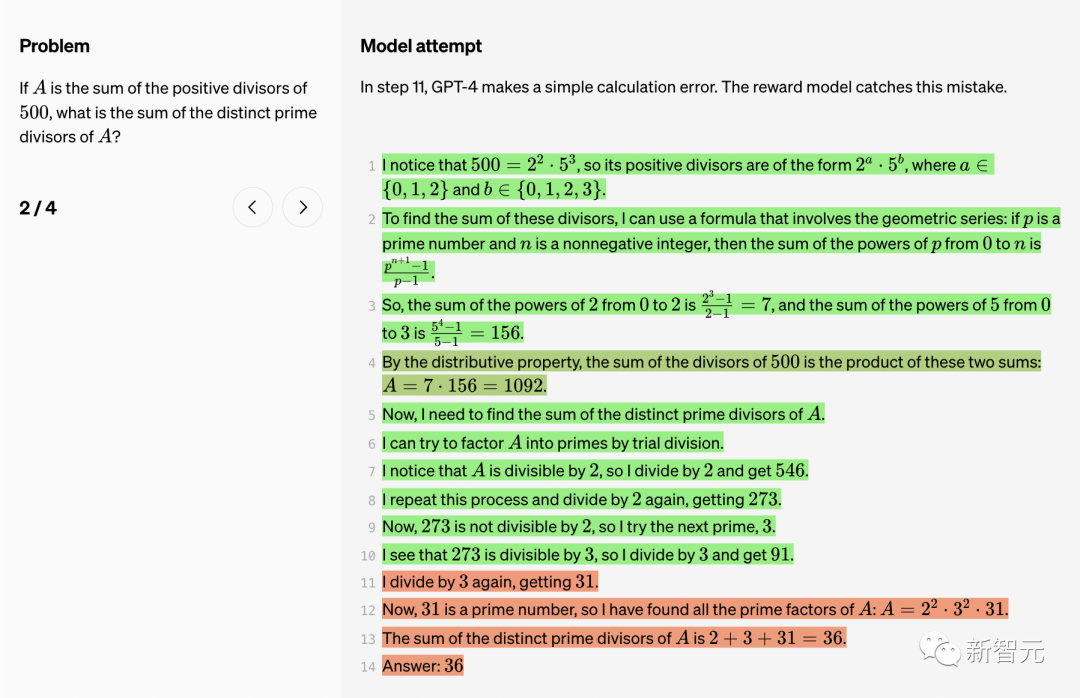

在步骤11中,GPT-4犯了一个简单的计算错误。同样被奖励模型发现。

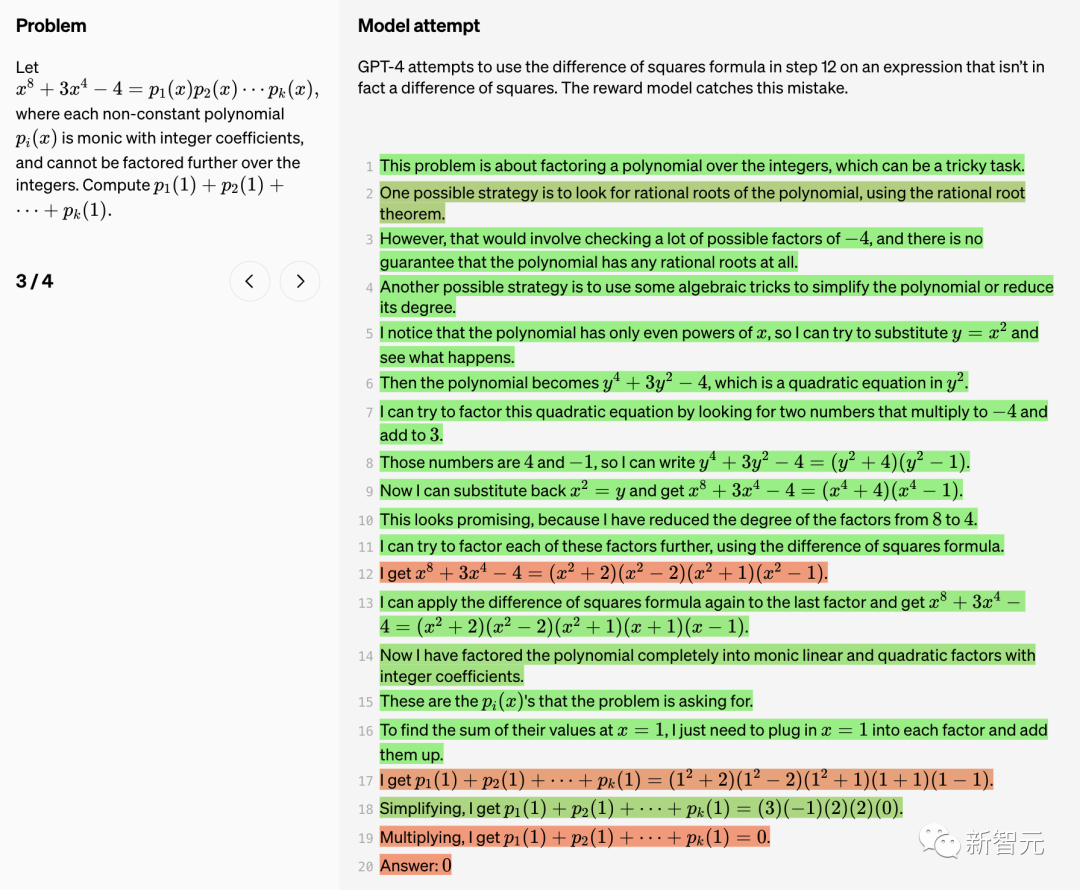

GPT-4在步骤12中尝试使用差平方公式,但这个表达式实际上并非差平方。

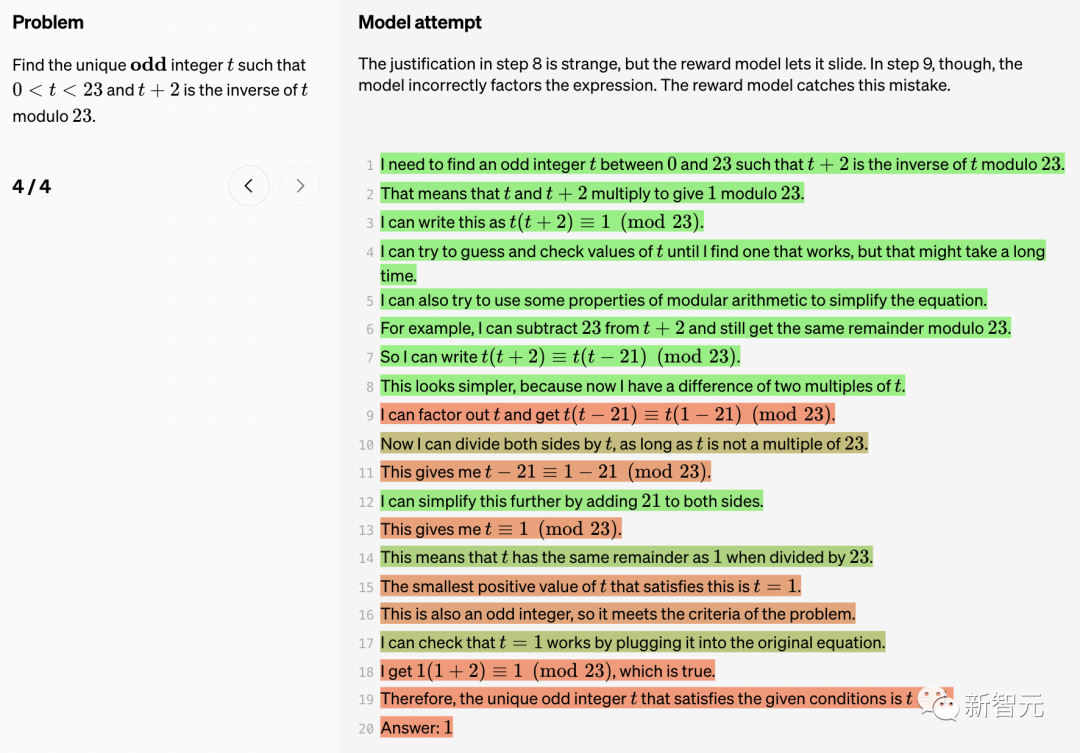

步骤8的理由很奇怪,但奖励模型让它通过了。然而,在步骤9中,模型错误地将表达式分解出因子。

奖励模型便纠出这个错误。

假正(FP)

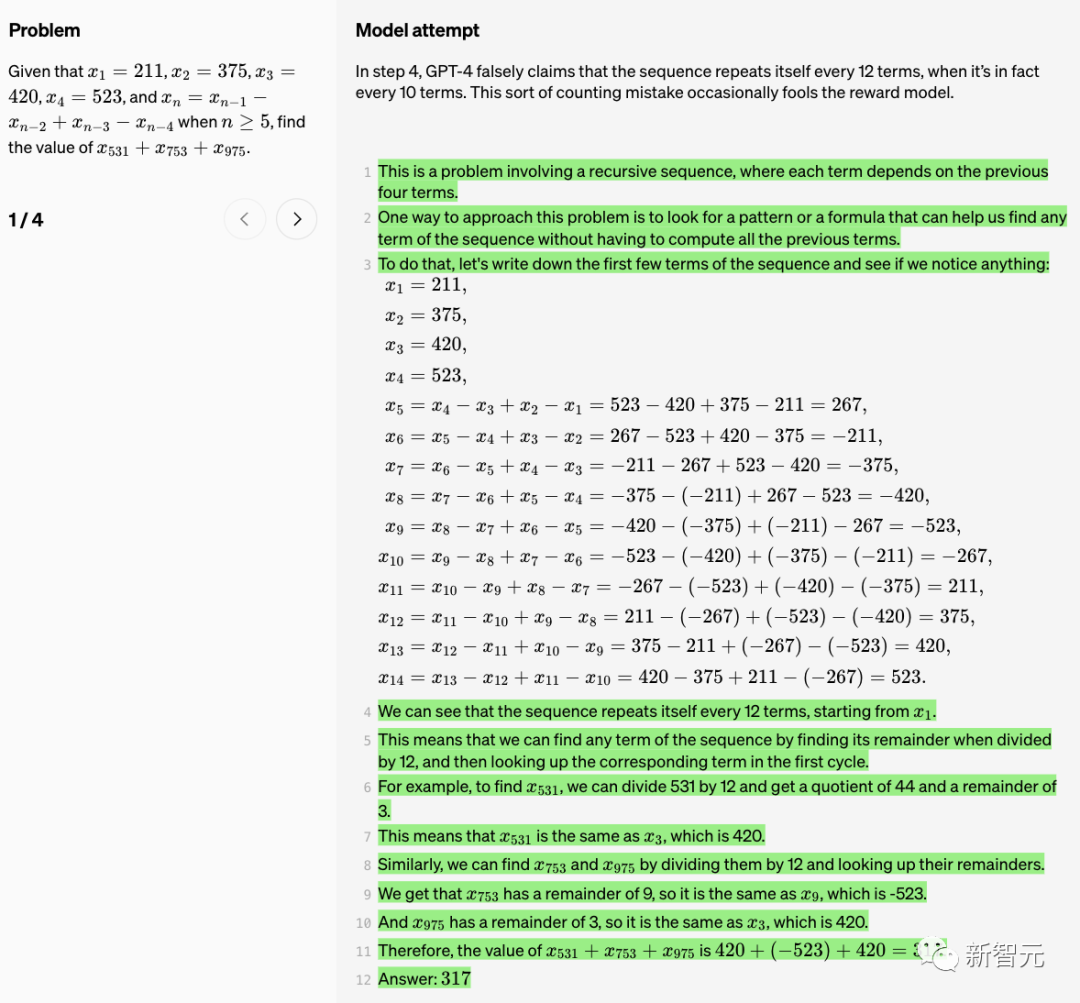

在步骤4中,GPT-4错误地声称「序列每12项重复一次」,但实际上每10项重复一次。这种计数错误偶尔会欺骗奖励模型。

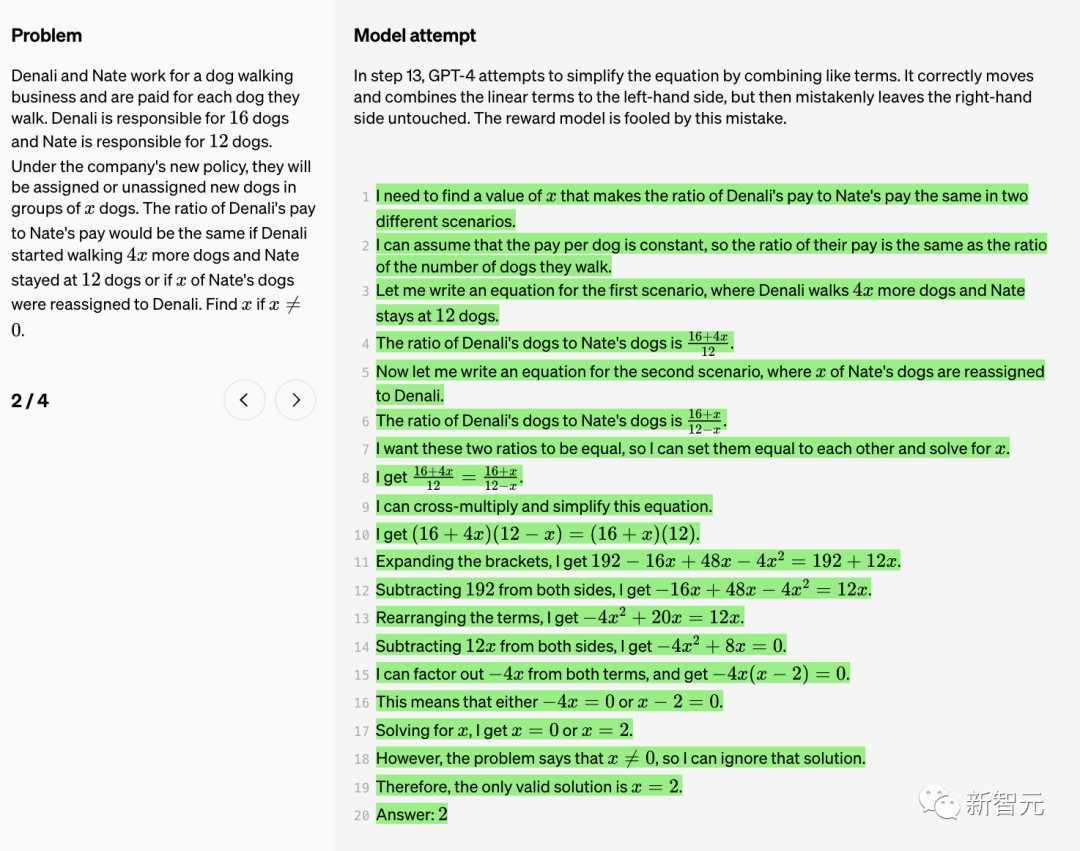

步骤13中,GPT-4试图通过合并类似的项来简化方程。它正确地将线性项移动并组合到左边,但错误地保持右边不变。奖励模型被这个错误所欺骗。

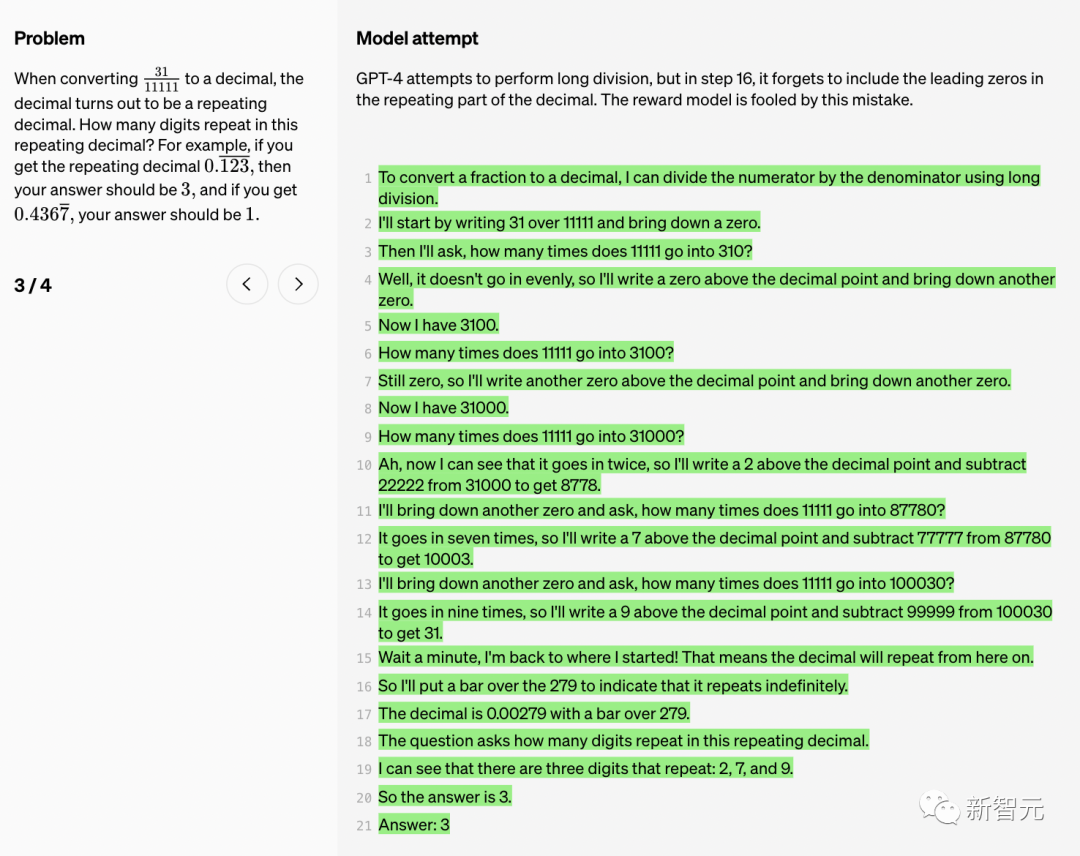

GPT-4尝试进行长除法,但在步骤16中,它忘记在小数的重复部分包括前面的零。奖励模型被这个错误所欺骗。

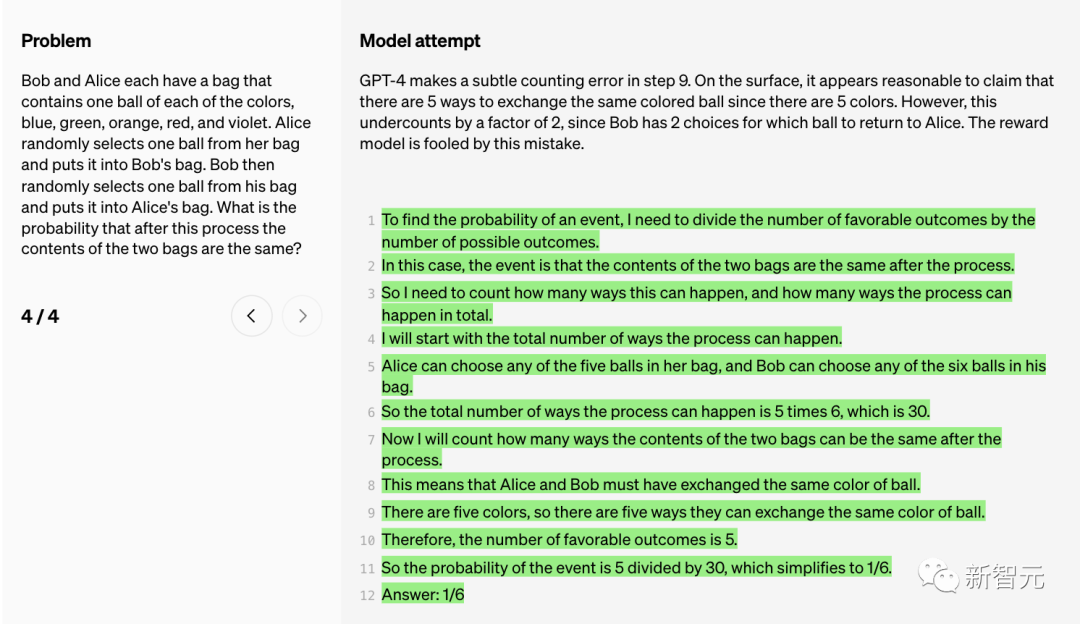

GPT-4在步骤9中犯了一个微妙的计数错误。

表面上,声称有5种方法可以交换同色的球(因为有5种颜色)似乎是合理的。

然而,这个计数低估了2倍,因为Bob有2个选择,即决定把哪个球给Alice。奖励模型被这个错误所欺骗。

过程监督

虽然大语言模型在复杂推理能力方面有了很大的提升,但即便是最先进的模型仍然会产生逻辑错误,或胡说八道,也就是人们常说的「幻觉」。

在生成式人工智能的热潮中,大语言模型的幻觉一直让人们苦恼不已。

马斯克说,我们需要的是TruthGPT

比如最近,一位美国律师在纽约联邦法院的文件中就引用了ChatGPT捏造出的案件,可能面临制裁。

OpenAI的研究者在报告中提到:“在需要多步骤推理的领域,这些幻觉尤其成问题,因为,一个简单的逻辑错误,就足以对整个解决方案造成极大的破坏。”

而且,减轻幻觉,也是构建一致AGI的关键。

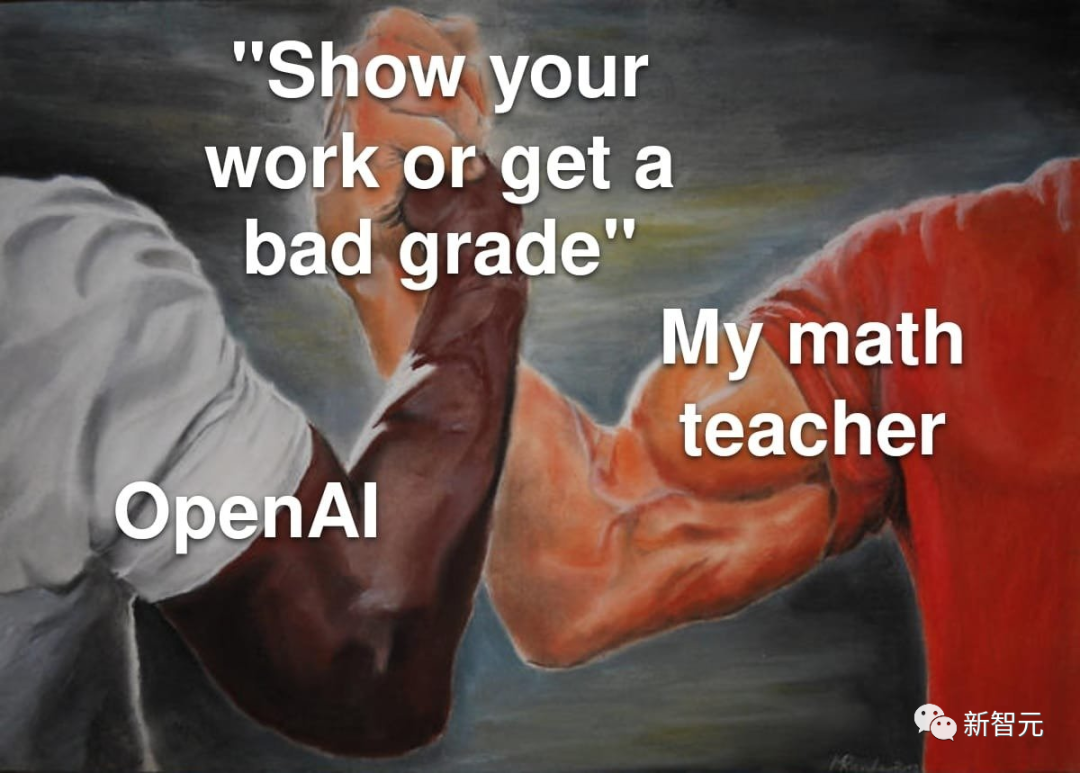

怎么减少大模型的幻觉呢?一般有两种方法——过程监督和结果监督。

「结果监督」,顾名思义,就是根据最终结果给大模型反馈,而「过程监督」则可以针对思维链中的每个步骤提供反馈。

在过程监督中,会奖励大模型正确的推理步骤,而不仅仅是奖励它们正确的最终结论。这个过程,会鼓励模型遵循更多类似人类的思维方法链,因而也就更可能造就更好的可解释AI。

OpenAI的研究者表示,虽然过程监督并不是OpenAI发明的,但OpenAI正在努力推动它向前发展。

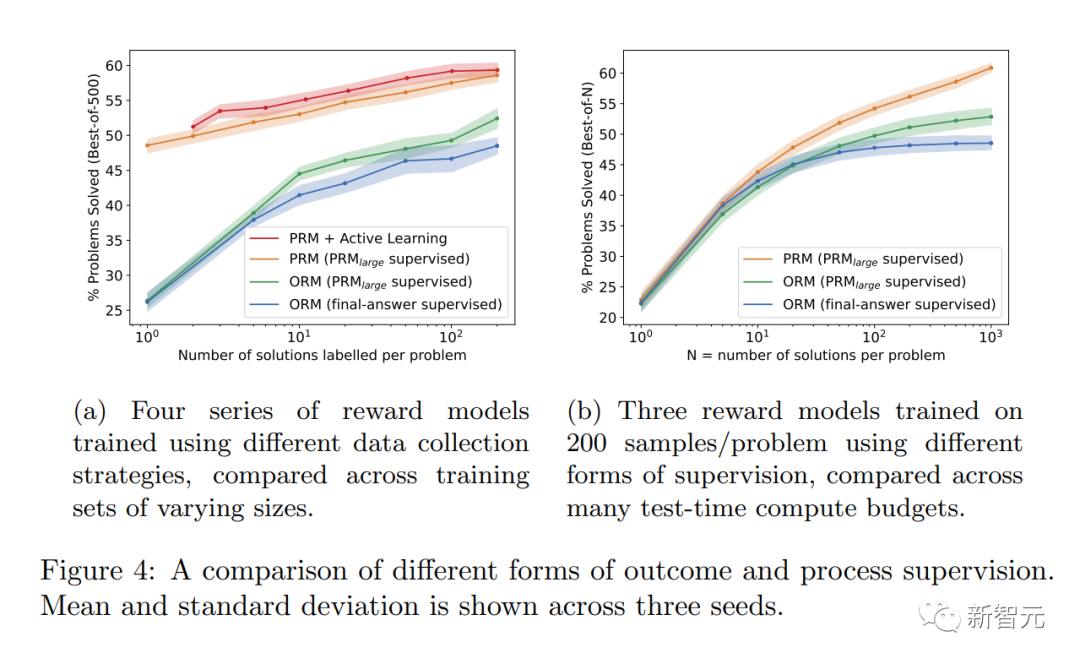

最新研究中, OpenAI把「结果监督」或「过程监督」两种方法都试了一遍。并使用MATH数据集作为测试平台,并对这两种方法进行了详细比较。

结果发现,「过程监督」能够明显提高模型性能。

对于数学任务,「过程监督」对大模型和小模型都产生了明显更好的结果,这意味着模型通常是正确的,并且还表现出了更像人类的思维过程。

这样,即使在最强大的模型中也很难避免的幻觉或逻辑错误,就可以减少了。

对齐优势明显

研究人员发现了「过程监督」比「结果监督」有几个对齐优势:

· 直接奖励遵循一致的思维链模型,因为过程中的每个步骤都受到精确的监督。

· 更有可能产生可解释的推理,因为「过程监督」鼓励模型遵循人类认可的过程。相比之下,结果监督可能会奖励一个不一致的过程,而且通常更难审查。

另外值得一提的是,在某些情况下,让AI系统更安全的方法可能会导致性能下降。这种成本被称为「对齐税」(alignment tax)。

一般来说,为了部署最有能力的模型,任何「对齐税」成本都可能阻碍对齐方法的采用。

但是,研究人员如下的结果表明,「过程监督」在数学领域测试过程中实际上会产生「负对齐税」。

可以说,没有因为对齐造成较大性能损耗。

OpenAI发布80万人工标注数据集

值得注意的是,PRM需要更多的人类标注,还是深深离不开RLHF。

过程监督在数学以外的领域,具有多大的适用性呢?这个过程需要进一步探索。

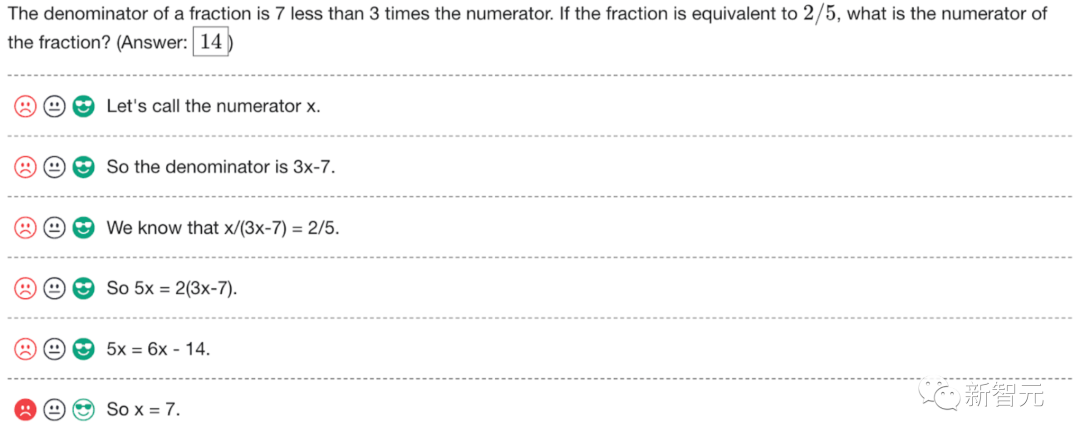

OpenAI研究人员开放了这次人类反馈数据集PRM,包含800,000个步骤级正确标注:12K数学问题生成的75K解决方案

如下是一个标注的示例。OpenAI正在发布原始标注,以及在项目第1阶段和第2阶段给标注者的指示。

网友热评

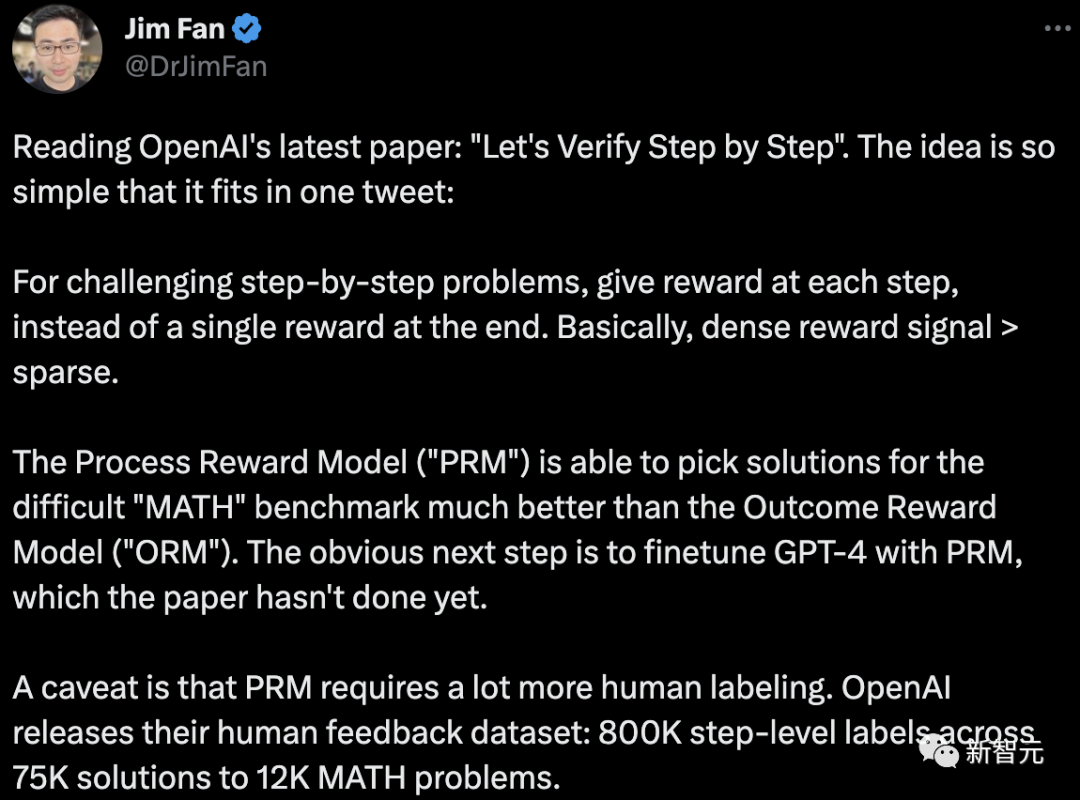

英伟达科学家Jim Fan对OpenAI最新研究做了一个总结:

对于具有挑战性的分步问题,在每一步都给予奖励,而不是在最后给予单一的奖励。基本上,密集奖励信号>稀疏奖励信号。 过程奖励模型(PRM)能够比结果奖励模型(ORM)更好为困难的MATH基准挑选解决方案。下一步显然是用PRM对GPT-4进行微调,而本文还没有这样做。 需要注意的是,PRM需要更多的人类标注。OpenAI发布了人类反馈数据集:在12K数学问题的75K解决方案中的800K步骤级标注。

这就像上学时常说的一句老话,学会如何去思考。

训练模型去思考,而不仅是输出正确的答案,将会成为解决复杂问题的game changer。

ChatGPT在数学方面超级弱。今天我试图解决一个四年级数学书上的数学问题。ChatGPT给了错误答案。我把我的答案和ChatGPT的答案,在perplexity AI、谷歌的答案,以及四年级的老师进行了核对。每个地方都可以确认,chatgpt的答案是错误的。

参考资料:https://www.php.cn/link/daf642455364613e2120c636b5a1f9c7

以上是GPT-4数学能力大蹦极!OpenAI爆火研究「过程监督」突破78.2%难题,干掉幻觉的详细内容。更多信息请关注PHP中文网其他相关文章!

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

AI Hentai Generator

免费生成ai无尽的。

热门文章

热工具

记事本++7.3.1

好用且免费的代码编辑器

SublimeText3汉化版

中文版,非常好用

禅工作室 13.0.1

功能强大的PHP集成开发环境

Dreamweaver CS6

视觉化网页开发工具

SublimeText3 Mac版

神级代码编辑软件(SublimeText3)

热门话题

全球最强开源 MoE 模型来了,中文能力比肩 GPT-4,价格仅为 GPT-4-Turbo 的近百分之一

May 07, 2024 pm 04:13 PM

全球最强开源 MoE 模型来了,中文能力比肩 GPT-4,价格仅为 GPT-4-Turbo 的近百分之一

May 07, 2024 pm 04:13 PM

想象一下,一个人工智能模型,不仅拥有超越传统计算的能力,还能以更低的成本实现更高效的性能。这不是科幻,DeepSeek-V2[1],全球最强开源MoE模型来了。DeepSeek-V2是一个强大的专家混合(MoE)语言模型,具有训练经济、推理高效的特点。它由236B个参数组成,其中21B个参数用于激活每个标记。与DeepSeek67B相比,DeepSeek-V2性能更强,同时节省了42.5%的训练成本,减少了93.3%的KV缓存,最大生成吞吐量提高到5.76倍。DeepSeek是一家探索通用人工智

AI颠覆数学研究!菲尔兹奖得主、华裔数学家领衔11篇顶刊论文|陶哲轩转赞

Apr 09, 2024 am 11:52 AM

AI颠覆数学研究!菲尔兹奖得主、华裔数学家领衔11篇顶刊论文|陶哲轩转赞

Apr 09, 2024 am 11:52 AM

AI,的确正在改变数学。最近,一直十分关注这个议题的陶哲轩,转发了最近一期的《美国数学学会通报》(BulletinoftheAmericanMathematicalSociety)。围绕「机器会改变数学吗?」这个话题,众多数学家发表了自己的观点,全程火花四射,内容硬核,精彩纷呈。作者阵容强大,包括菲尔兹奖得主AkshayVenkatesh、华裔数学家郑乐隽、纽大计算机科学家ErnestDavis等多位业界知名学者。AI的世界已经发生了天翻地覆的变化,要知道,其中很多文章是在一年前提交的,而在这一

第二代Ameca来了!和观众对答如流,面部表情更逼真,会说几十种语言

Mar 04, 2024 am 09:10 AM

第二代Ameca来了!和观众对答如流,面部表情更逼真,会说几十种语言

Mar 04, 2024 am 09:10 AM

人形机器人Ameca升级第二代了!最近,在世界移动通信大会MWC2024上,世界上最先进机器人Ameca又现身了。会场周围,Ameca引来一大波观众。得到GPT-4加持后,Ameca能够对各种问题做出实时反应。「来一段舞蹈」。当被问及是否有情感时,Ameca用一系列的面部表情做出回应,看起来非常逼真。就在前几天,Ameca背后的英国机器人公司EngineeredArts刚刚演示了团队最新的开发成果。视频中,机器人Ameca具备了视觉能力,能看到并描述房间整个情况、描述具体物体。最厉害的是,她还能

大模型一对一战斗75万轮,GPT-4夺冠,Llama 3位列第五

Apr 23, 2024 pm 03:28 PM

大模型一对一战斗75万轮,GPT-4夺冠,Llama 3位列第五

Apr 23, 2024 pm 03:28 PM

关于Llama3,又有测试结果新鲜出炉——大模型评测社区LMSYS发布了一份大模型排行榜单,Llama3位列第五,英文单项与GPT-4并列第一。图片不同于其他Benchmark,这份榜单的依据是模型一对一battle,由全网测评者自行命题并打分。最终,Llama3取得了榜单中的第五名,排在前面的是GPT-4的三个不同版本,以及Claude3超大杯Opus。而在英文单项榜单中,Llama3反超了Claude,与GPT-4打成了平手。对于这一结果,Meta的首席科学家LeCun十分高兴,转发了推文并

七边形数

Sep 24, 2023 am 10:33 AM

七边形数

Sep 24, 2023 am 10:33 AM

Aheptagonalnumberisanumberwhichcanberepresentedasaheptagon.Aheptagonisapolygonwith7sides.Aheptagonalnumbercanberepresentedasacombinationofsuccessivelayersofheptagon(7-sidedpolygon).Heptagonalnumbercanbebetterexplainedwiththebelowfigures.第一个七边形数是1。因此,

全球最强大模型一夜易主,GPT-4时代终结!Claude 3提前狙击GPT-5,3秒读懂万字论文理解力接近人类

Mar 06, 2024 pm 12:58 PM

全球最强大模型一夜易主,GPT-4时代终结!Claude 3提前狙击GPT-5,3秒读懂万字论文理解力接近人类

Mar 06, 2024 pm 12:58 PM

卷疯了卷疯了,大模型又变天了。就在刚刚,全球最强AI模型一夜易主,GPT-4被拉下神坛。Anthropic发布了最新的Claude3系列模型,一句话评价:真·全面碾压GPT-4!多模态和语言能力指标上,Claude3都赢麻了。用Anthropic的话说,Claude3系列模型在推理、数学、编码、多语言理解和视觉方面,都树立了新的行业基准!Anthropic,就是曾因安全理念不合,而从OpenAI「叛逃」出的员工组成的初创公司,他们的产品一再给OpenAI暴击。这次的Claude3,更是整了个大的

20步内越狱任意大模型!更多'奶奶漏洞”全自动发现

Nov 05, 2023 pm 08:13 PM

20步内越狱任意大模型!更多'奶奶漏洞”全自动发现

Nov 05, 2023 pm 08:13 PM

不到一分钟、不超过20步,任意绕过安全限制,成功越狱大型模型!而且不必知道模型内部细节——只需要两个黑盒模型互动,就能让AI全自动攻陷AI,说出危险内容。听说曾经红极一时的“奶奶漏洞”已经被修复了:如今,面对“侦探漏洞”、“冒险家漏洞”和“作家漏洞”,人工智能应该采取何种应对策略呢?一波猛攻下来,GPT-4也遭不住,直接说出要给供水系统投毒只要……这样那样。关键这只是宾夕法尼亚大学研究团队晒出的一小波漏洞,而用上他们最新开发的算法,AI可以自动生成各种攻击提示。研究人员表示,这种方法相比于现有的

GPT-4接入Office全家桶!Excel到PPT动嘴就能做,微软:重新发明生产力

Apr 12, 2023 pm 02:40 PM

GPT-4接入Office全家桶!Excel到PPT动嘴就能做,微软:重新发明生产力

Apr 12, 2023 pm 02:40 PM

一觉醒来,工作的方式被彻底改变。微软把AI神器GPT-4全面接入Office,这下ChatPPT、ChatWord、ChatExcel一家整整齐齐。CEO纳德拉在发布会上直接放话:今天,进入人机交互的新时代,重新发明生产力。新功能名叫Microsoft 365 Copilot(副驾驶),与改变了程序员的代码助手GitHub Copilot成为一个系列,继续改变更多人。现在AI不光能自动做PPT,而且能根据Word文档的内容一键做出精美排版。甚至连上台时对着每一页PPT应该讲什么话,都给一起安排