苹果Vision Pro结合大量AI技术用于用户状态检测

参与Vision Pro的前苹果AR工程师Sterling Crispin,发文分享了自己在苹果期间所做的工作。其中提到,苹果Vision Pro融合了大量机器学习技术,包括用AI模型预测你的身体、大脑状态,比如是否对当前事务好奇,是否走神,注意力是否被分散等等。

这一切是基于用户眼睛的动作数据、心率、肌肉活动、血压、大脑血液密度等等数据来衡量和判断。

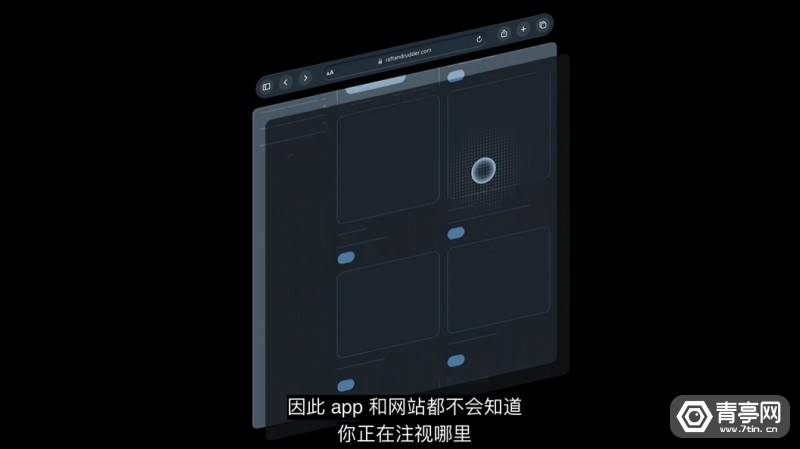

苹果Vision Pro项目团队负责人Mike Rockwell也表示:眼睛注视方向就是非常敏感的个人隐私数据,苹果在Vision Pro也做了隐私保护,第三方App无法获取你的眼睛注视方向,只有你通过“点击”之后,App才能获取你的操作行为,但也无法获取你的眼睛注视方向。

Apple Vision Pro隐私防护

以下是Sterling Crispin的原文:

当我在 Apple 担任技术开发组的神经技术原型研究员时,我花了 10% 的时间为#VisionPro的开发做出贡献。这是我做过的最长的一次努力。我为它终于宣布而感到自豪和欣慰。我在 AR 和 VR 领域工作了 10 年,在很多方面,这是整个行业在单一产品中的结晶。我很感激我帮助实现了它,如果你想进入这个领域或改进你的策略,我愿意接受咨询和接听电话。

我所做的工作支持了 Vision Pro 的基础开发、正念体验、 ▇▇▇▇▇▇产品,以及更雄心勃勃的神经技术登月研究。就像,预测你会在你点击某些东西之前点击,基本上是读心术。我在那里工作了 3.5 年,并于 2021 年底离开,所以我很高兴能体验过去两年是如何将一切融合在一起的。我真的很好奇是什么做了剪辑以及稍后将发布什么。

具体来说,我很自豪能够为 Vision Pro ▇▇▇▇▇▇计划的最初愿景、战略和方向做出贡献。我在一个小团队中所做的工作帮助为该产品类别开了绿灯,我认为它有一天可能会产生重大的全球影响。

我在 Apple 所做的大部分工作都在 NDA 之下,并且涉及广泛的主题和方法。但是有些事情已经通过专利公开,我可以在下面引用和解释。

总的来说,我做的很多工作都涉及到在沉浸式体验中,根据用户身体和大脑的数据来检测用户的心理状态。

因此,用户处于混合现实或虚拟现实体验中,人工智能模型试图预测你是否感到好奇、走神、害怕、注意力集中、回忆过去的经历或其他一些认知状态。这些可以通过眼动追踪、大脑电活动、心跳和节律、肌肉活动、大脑血液密度、血压、皮肤电导率等测量来推断。

要使特定预测成为可能,涉及很多技巧,我提到的少数专利对此进行了详细说明。最酷的结果之一是预测用户会在他们实际点击之前点击某些东西。这是一项艰巨的工作,也是我引以为豪的事情。你的瞳孔在你点击之前做出反应,部分原因是你预计在你点击之后会发生一些事情。因此,您可以通过监视用户的眼睛行为,并实时重新设计 UI 以创建更多这种预期的瞳孔反应,从而创建用户大脑的生物反馈。这是一个通过眼睛进行的粗糙的脑机接口,但非常酷。而且我会在任何一天接受侵入性脑部手术。

其他推断认知状态的技巧包括以用户可能察觉不到的方式向用户快速闪烁视觉效果或声音,然后测量他们对此的反应。

另一项专利详细介绍了如何使用机器学习以及来自身体和大脑的信号来预测您的注意力、放松程度或学习情况。然后更新虚拟环境以增强这些状态。因此,想象一个自适应沉浸式环境,它可以通过改变您在背景中看到和听到的内容来帮助您学习、工作或放松。

所有这些细节都可以在专利中公开获得,并且经过精心编写,不会泄露任何内容。我还参与了很多其他事情,希望最终能看到更多。

很多人对这个产品已经等了很长时间了。但这仍然是通往 VR 的道路上的一步。该行业要到本世纪末才能完全赶上这项技术的宏伟愿景。

同样,如果您的企业希望进入该领域或改进您的战略,我愿意接受咨询工作和接听电话。大多数情况下,我感到自豪和欣慰的是,这终于被宣布了。从我开始从事这项工作到现在已经五年多了,我的大部分时间都花在了上面,其他设计师和工程师也是如此。我希望整体大于部分之和,Vision Pro 让您大吃一惊。

来源:Sterling Crispin

以上是苹果Vision Pro结合大量AI技术用于用户状态检测的详细内容。更多信息请关注PHP中文网其他相关文章!

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

AI Hentai Generator

免费生成ai无尽的。

热门文章

热工具

记事本++7.3.1

好用且免费的代码编辑器

SublimeText3汉化版

中文版,非常好用

禅工作室 13.0.1

功能强大的PHP集成开发环境

Dreamweaver CS6

视觉化网页开发工具

SublimeText3 Mac版

神级代码编辑软件(SublimeText3)

热门话题

我尝试了使用光标AI编码的Vibe编码,这太神奇了!

Mar 20, 2025 pm 03:34 PM

我尝试了使用光标AI编码的Vibe编码,这太神奇了!

Mar 20, 2025 pm 03:34 PM

Vibe编码通过让我们使用自然语言而不是无尽的代码行创建应用程序来重塑软件开发的世界。受Andrej Karpathy等有远见的人的启发,这种创新的方法使Dev

2025年2月的Genai推出前5名:GPT-4.5,Grok-3等!

Mar 22, 2025 am 10:58 AM

2025年2月的Genai推出前5名:GPT-4.5,Grok-3等!

Mar 22, 2025 am 10:58 AM

2025年2月,Generative AI又是一个改变游戏规则的月份,为我们带来了一些最令人期待的模型升级和开创性的新功能。从Xai的Grok 3和Anthropic的Claude 3.7十四行诗到Openai的G

如何使用Yolo V12进行对象检测?

Mar 22, 2025 am 11:07 AM

如何使用Yolo V12进行对象检测?

Mar 22, 2025 am 11:07 AM

Yolo(您只看一次)一直是领先的实时对象检测框架,每次迭代都在以前的版本上改善。最新版本Yolo V12引入了进步,可显着提高准确性

最佳AI艺术生成器(免费付款)创意项目

Apr 02, 2025 pm 06:10 PM

最佳AI艺术生成器(免费付款)创意项目

Apr 02, 2025 pm 06:10 PM

本文回顾了AI最高的艺术生成器,讨论了他们的功能,对创意项目的适用性和价值。它重点介绍了Midjourney是专业人士的最佳价值,并建议使用Dall-E 2进行高质量的可定制艺术。

Chatgpt 4 o可用吗?

Mar 28, 2025 pm 05:29 PM

Chatgpt 4 o可用吗?

Mar 28, 2025 pm 05:29 PM

Chatgpt 4当前可用并广泛使用,与诸如ChatGpt 3.5(例如ChatGpt 3.5)相比,在理解上下文和产生连贯的响应方面取得了重大改进。未来的发展可能包括更多个性化的间

哪个AI比Chatgpt更好?

Mar 18, 2025 pm 06:05 PM

哪个AI比Chatgpt更好?

Mar 18, 2025 pm 06:05 PM

本文讨论了AI模型超过Chatgpt,例如Lamda,Llama和Grok,突出了它们在准确性,理解和行业影响方面的优势。(159个字符)

如何将Mistral OCR用于下一个抹布模型

Mar 21, 2025 am 11:11 AM

如何将Mistral OCR用于下一个抹布模型

Mar 21, 2025 am 11:11 AM

MISTRAL OCR:通过多模式文档理解彻底改变检索效果 检索增强的生成(RAG)系统具有明显高级的AI功能,从而可以访问大量的数据存储,以获得更明智的响应

顶级AI写作助理来增强您的内容创建

Apr 02, 2025 pm 06:11 PM

顶级AI写作助理来增强您的内容创建

Apr 02, 2025 pm 06:11 PM

文章讨论了Grammarly,Jasper,Copy.ai,Writesonic和Rytr等AI最高的写作助手,重点介绍了其独特的内容创建功能。它认为Jasper在SEO优化方面表现出色,而AI工具有助于保持音调的组成