500万token巨兽,一次读完全套「哈利波特」!比ChatGPT长1000多倍

记性差是目前主流大型语言模型的主要痛点,比如ChatGPT只能输入4096个token(约3000个词),经常聊着聊着就忘了之前说什么了,甚至都不够读一篇短篇小说的。

过短的输入窗口也限制了语言模型的应用场景,比如给一篇科技论文(约1万词)做摘要的时候,需要把文章手动切分后再输入到模型中,不同章节之间关联信息就丢失了。

虽然GPT-4最长支持32000个token、升级后的Claude最高支持10万token,但也只能缓解脑容量不足的问题。

最近一家创业团队Magic宣布即将发布LTM-1模型,最长支持500万token,大约是50万行代码或5000个文件,直接比Claude高50倍,基本可以覆盖大多数的存储需求,这可真就量变产生质变了!

LTM-1的主要应用场景在于代码补全,比如可以生成更长、更复杂的代码建议。

还可以跨越多个文件重用、合成信息。

坏消息是,LTM-1的开发商Magic并没有发布具体技术原理,只是说设计了一种全新的方法the Long-term Memory Network (LTM Net)。

但也有个好消息,2021年9月,DeepMind等机构的研究人员曾经提出一种名为 ∞-former 的模型,其中就包含了长期记忆(long-term memory,LTM)机制,理论上可以让Transformer模型具有无限长的记忆力,但目前并不清楚二者是否为同一技术,或是改良版。

论文链接:https://arxiv.org/pdf/2109.00301.pdf

开发团队表示,虽然LTM Nets可以比GPT看到更多的上下文,但LTM-1模型的参数量比当下的sota模型小的多,所以智能程度也更低,不过继续提升模型规模应该可以提升LTM Nets的性能。

目前LTM-1已经开放alpha测试申请。

申请链接:https://www.php.cn/link/bbfb937a66597d9646ad992009aee405

LTM-1的开发商Magic创立于2022年,主要开发类似GitHub Copilot的产品,可以帮助软件工程师编写、审查、调试和修改代码,目标是为程序员打造一个AI同事,其主要竞争优势就是模型可以读取更长的代码。

Magic致力于公众利益(public benefit),使命是构建和安全部署超过人类只能的AGI系统,目前还是一家只有10人的创业公司。

今年2月,Magic获得由Alphabet旗下CapitalG领投的2300万美元A轮融资,投资人还包括GitHub前首席执行官和Copilot的联合出品人Nat Friedman,目前公司总资金量已达2800万美元。

Magic的首席执行官兼联合创始人Eric Steinberger本科毕业于剑桥大学计算机科学专业,曾在FAIR做过机器学习研究。

在创立Magic前,Steinberger还曾创立过ClimateScience,以帮助全世界的儿童学习气候变化的影响。

无限记忆的Transformer

语言模型核心组件Transformer中注意力机制的设计,会导致每次增加输入序列的长度时,时间复杂度都会呈二次方增长。

虽然已经有一些注意力机制的变体,比如稀疏注意力等降低算法复杂度,不过其复杂度仍然与输入长度有关,不能无限扩展。

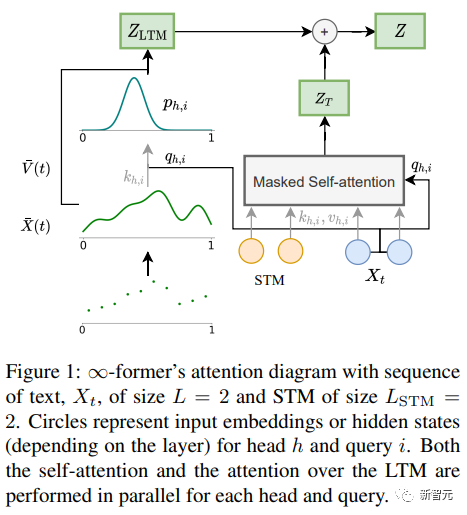

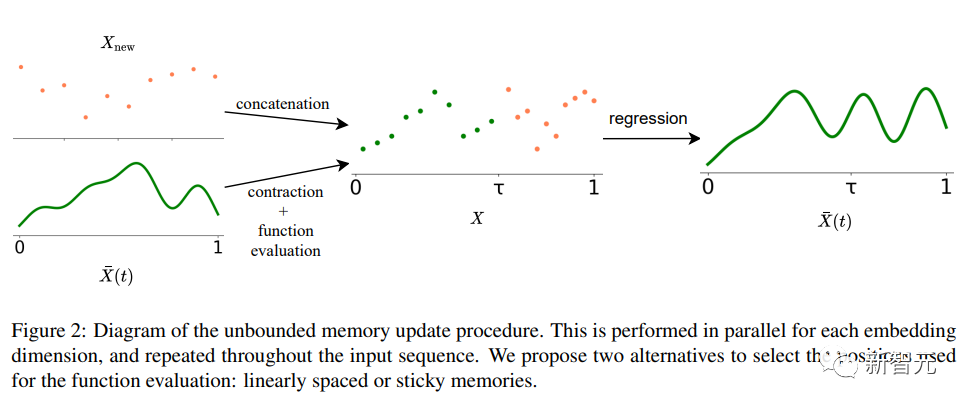

∞-former中长期记忆(LTM)的Transformer模型可以将输入序列扩展到无限的关键在是一个连续空间注意力框架,该框架用降低表征粒度的方式提升记忆信息单元的数量(基函数)。

在框架中,输入序列被表示为一个「连续信号」,代表N个径向基函数(RBF)的线性组合,这样一来,∞-former的注意复杂度就降为了O(L^2 + L × N),而原始Transformer的注意力复杂度为O(L×(L+L_LTM)),其中L和L_LTM分别对应于Transformer输入大小和长期记忆长度。

这种表示方法有两个主要优势:

1. 上下文可以用小于token数量的基函数N来表示,减少了注意力的计算成本;

2. N可以是固定的,从而能够在记忆中表示无限的上下文,并且不会增加注意力机制的复杂度。

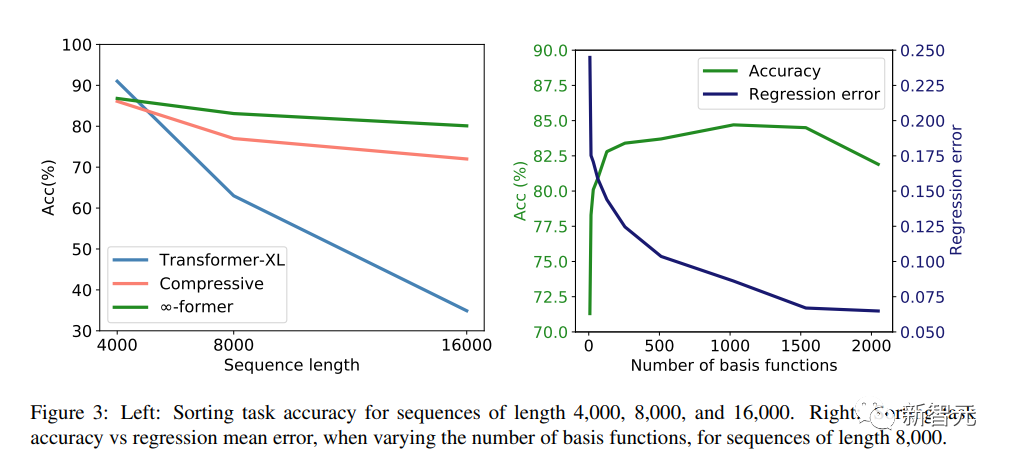

当然,天下没有免费的午餐,代价就是分辨率的降低:使用较少数量基函数时,会导致在将输入序列表示为连续信号时降低精度。

为了缓解分辨率降低问题,研究人员引入了「粘性记忆」(sticky memories)的概念,将LTM信号中的较大空间归结为更频繁访问的记忆区域,在LTM中创造了一个「永久性」的概念,使模型能够更好地捕捉长时间的背景而不丢失相关信息,也是从大脑的长期电位和可塑性中得到了启发。

实验部分

为了验证∞-former能否对长语境进行建模,研究人员首先对一个合成任务进行实验,即在一个长序列中按频率对token进行排序;然后通过微调预训练语言模型,对语言建模和基于文档的对话生成进行实验。

排序

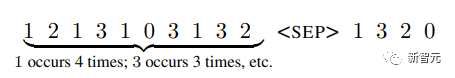

输入包括一个根据概率分布(系统未知)采样的token序列,目标是按照序列中频率递减顺序生成token

为了研究长期记忆是否被有效利用,以及Transformer是否只是通过对最近的标记进行建模来排序,研究人员将标记概率分布设计为随时间变化。

词表中有20个token,分别用长度为4,000、8,000和16,000的序列进行实验,Transformer-XL和compressive transformer作为对比基线模型。

实验结果可以看出,在短序列长度(4,000)的情况下,Transformer-XL实现了比其他模型略高的精度;但当序列长度增加时,其精度也迅速下降,不过对于∞-former来说,这种下降并不明显,表明其在对长序列进行建模时更有优势。

语言建模

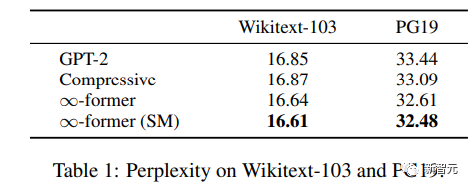

为了了解长期记忆是否可以用来扩展预训练的语言模型,研究人员在Wikitext103和PG-19的一个子集上对GPT-2 small进行了微调,包括大约2亿个token。

实验结果可以看到,∞-former可以降低Wikitext-103和PG19的困惑度,并且∞-former在PG19数据集上获得的改进更大,因为书籍比维基百科文章更依赖于长期记忆。

基于文档对话

在以文档为基础的对话生成中,除了对话历史之外,模型还可以获得关于对话主题的文档。

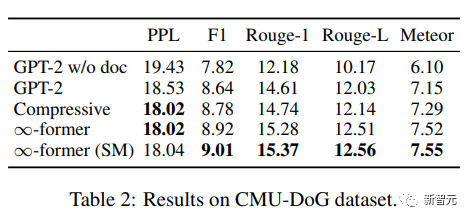

在CMU Document Grounded Conversation dataset(CMU-DoG)中,对话是关于电影的,并给出了电影的摘要作为辅助文档;考虑到对话包含多个不同的连续语篇,辅助文档被分为多个部分。

为了评估长期记忆的有用性,研究人员只让模型在对话开始前才能访问文件,使这项任务更具挑战性。

在对GPT-2 small进行微调后,为了让模型在记忆中保持整个文档,使用一个N=512个基函数的连续LTM(∞-former)扩展GPT-2。

为了评估模型效果,使用perplexity、F1 score、Rouge-1和Rouge-L,以及Meteor指标。

从结果来看,∞-former和compressive Transformer能够生成更好的语料,虽然二者的困惑度基本相同,但∞-former在其他指标上取得了更好的分数。

以上是500万token巨兽,一次读完全套「哈利波特」!比ChatGPT长1000多倍的详细内容。更多信息请关注PHP中文网其他相关文章!

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

AI Hentai Generator

免费生成ai无尽的。

热门文章

热工具

记事本++7.3.1

好用且免费的代码编辑器

SublimeText3汉化版

中文版,非常好用

禅工作室 13.0.1

功能强大的PHP集成开发环境

Dreamweaver CS6

视觉化网页开发工具

SublimeText3 Mac版

神级代码编辑软件(SublimeText3)

热门话题

centos关机命令行

Apr 14, 2025 pm 09:12 PM

centos关机命令行

Apr 14, 2025 pm 09:12 PM

CentOS 关机命令为 shutdown,语法为 shutdown [选项] 时间 [信息]。选项包括:-h 立即停止系统;-P 关机后关电源;-r 重新启动;-t 等待时间。时间可指定为立即 (now)、分钟数 ( minutes) 或特定时间 (hh:mm)。可添加信息在系统消息中显示。

CentOS上GitLab的备份方法有哪些

Apr 14, 2025 pm 05:33 PM

CentOS上GitLab的备份方法有哪些

Apr 14, 2025 pm 05:33 PM

CentOS系统下GitLab的备份与恢复策略为了保障数据安全和可恢复性,CentOS上的GitLab提供了多种备份方法。本文将详细介绍几种常见的备份方法、配置参数以及恢复流程,帮助您建立完善的GitLab备份与恢复策略。一、手动备份利用gitlab-rakegitlab:backup:create命令即可执行手动备份。此命令会备份GitLab仓库、数据库、用户、用户组、密钥和权限等关键信息。默认备份文件存储于/var/opt/gitlab/backups目录,您可通过修改/etc/gitlab

如何检查CentOS HDFS配置

Apr 14, 2025 pm 07:21 PM

如何检查CentOS HDFS配置

Apr 14, 2025 pm 07:21 PM

检查CentOS系统中HDFS配置的完整指南本文将指导您如何有效地检查CentOS系统上HDFS的配置和运行状态。以下步骤将帮助您全面了解HDFS的设置和运行情况。验证Hadoop环境变量:首先,确认Hadoop环境变量已正确设置。在终端执行以下命令,验证Hadoop是否已正确安装并配置:hadoopversion检查HDFS配置文件:HDFS的核心配置文件位于/etc/hadoop/conf/目录下,其中core-site.xml和hdfs-site.xml至关重要。使用

CentOS上Zookeeper性能调优有哪些方法

Apr 14, 2025 pm 03:18 PM

CentOS上Zookeeper性能调优有哪些方法

Apr 14, 2025 pm 03:18 PM

在CentOS上对Zookeeper进行性能调优,可以从多个方面入手,包括硬件配置、操作系统优化、配置参数调整以及监控与维护等。以下是一些具体的调优方法:硬件配置建议使用SSD硬盘:由于Zookeeper的数据写入磁盘,强烈建议使用SSD以提高I/O性能。足够的内存:为Zookeeper分配足够的内存资源,避免频繁的磁盘读写。多核CPU:使用多核CPU,确保Zookeeper可以并行处理请

CentOS上如何进行PyTorch模型训练

Apr 14, 2025 pm 03:03 PM

CentOS上如何进行PyTorch模型训练

Apr 14, 2025 pm 03:03 PM

在CentOS系统上高效训练PyTorch模型,需要分步骤进行,本文将提供详细指南。一、环境准备:Python及依赖项安装:CentOS系统通常预装Python,但版本可能较旧。建议使用yum或dnf安装Python3并升级pip:sudoyumupdatepython3(或sudodnfupdatepython3),pip3install--upgradepip。CUDA与cuDNN(GPU加速):如果使用NVIDIAGPU,需安装CUDATool

CentOS上PyTorch的GPU支持情况如何

Apr 14, 2025 pm 06:48 PM

CentOS上PyTorch的GPU支持情况如何

Apr 14, 2025 pm 06:48 PM

在CentOS系统上启用PyTorchGPU加速,需要安装CUDA、cuDNN以及PyTorch的GPU版本。以下步骤将引导您完成这一过程:CUDA和cuDNN安装确定CUDA版本兼容性:使用nvidia-smi命令查看您的NVIDIA显卡支持的CUDA版本。例如,您的MX450显卡可能支持CUDA11.1或更高版本。下载并安装CUDAToolkit:访问NVIDIACUDAToolkit官网,根据您显卡支持的最高CUDA版本下载并安装相应的版本。安装cuDNN库:前

docker原理详解

Apr 14, 2025 pm 11:57 PM

docker原理详解

Apr 14, 2025 pm 11:57 PM

Docker利用Linux内核特性,提供高效、隔离的应用运行环境。其工作原理如下:1. 镜像作为只读模板,包含运行应用所需的一切;2. 联合文件系统(UnionFS)层叠多个文件系统,只存储差异部分,节省空间并加快速度;3. 守护进程管理镜像和容器,客户端用于交互;4. Namespaces和cgroups实现容器隔离和资源限制;5. 多种网络模式支持容器互联。理解这些核心概念,才能更好地利用Docker。

CentOS下PyTorch版本怎么选

Apr 14, 2025 pm 02:51 PM

CentOS下PyTorch版本怎么选

Apr 14, 2025 pm 02:51 PM

在CentOS下选择PyTorch版本时,需要考虑以下几个关键因素:1.CUDA版本兼容性GPU支持:如果你有NVIDIAGPU并且希望利用GPU加速,需要选择支持相应CUDA版本的PyTorch。可以通过运行nvidia-smi命令查看你的显卡支持的CUDA版本。CPU版本:如果没有GPU或不想使用GPU,可以选择CPU版本的PyTorch。2.Python版本PyTorch