网络爬虫是什么

当谈到技术 SEO时,可能很难理解它是如何工作的。但重要的是要获得尽可能多的知识来优化我们的网站并吸引更多的受众。在搜索引擎优化中发挥重要作用的一种工具就是网络爬虫。

网络爬虫(也称为网络蜘蛛)是一种在互联网上搜索和索引内容的机器人。从本质上讲,网络爬虫负责理解网页上的内容,以便在进行查询时检索它。

您可能想知道,“谁运行这些网络爬虫?”

通常,网络爬虫由具有自己算法的搜索引擎操作。该算法将告诉网络爬虫如何找到相关信息以响应搜索查询。

网络蜘蛛将搜索(爬行)并分类互联网上它可以找到并被告知要索引的所有网页。因此,如果您不希望在搜索引擎上找到您的网页,您可以告诉网络爬虫不要抓取您的网页。

为此,您需要上传 robots.txt 文件。本质上,robots.txt 文件将告诉搜索引擎如何抓取和索引您网站上的页面。

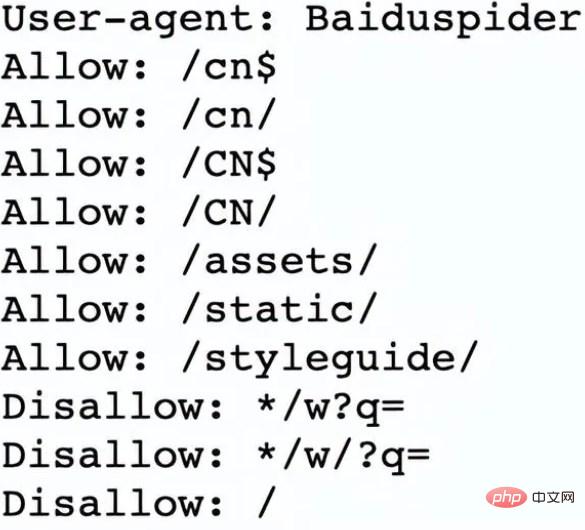

例如,让我们看一下 Nike.com/robots.txt

耐克使用其 robots.txt 文件来确定其网站中的哪些链接将被抓取和索引。

在文件的这一部分中,它确定:

网络爬虫Baiduspider被允许爬取前7个链接

网络爬虫Baiduspider被禁止爬取其余三个链接

这对耐克来说是有利的,因为该公司的某些页面不适合被搜索,并且不允许的链接不会影响其优化的页面,这些页面有助于他们在搜索引擎中排名。

那么现在我们知道什么是网络爬虫,它们是如何完成工作的呢?下面,让我们回顾一下网络爬虫的工作原理。

网络爬虫通过发现 URL 以及查看和分类网页来工作。在此过程中,他们会找到指向其他网页的超链接,并将它们添加到接下来要抓取的页面列表中。网络爬虫很聪明,可以确定每个网页的重要性。

搜索引擎的网络爬虫很可能不会爬取整个互联网。相反,它将根据包括多少其他页面链接到该页面、页面浏览量甚至品牌权威等因素来决定每个网页的重要性。因此,网络爬虫将确定要爬取的页面、爬取它们的顺序以及它们应该多久爬取一次更新。

例如,如果您有一个新网页,或者对现有网页进行了更改,那么网络爬虫将记录并更新索引。或者,如果您有一个新网页,您可以要求搜索引擎抓取您的网站。

当网络爬虫在您的页面上时,它会查看副本和元标记,存储该信息,并将其编入索引以供搜索引擎对关键字进行排序。

在整个过程开始之前,网络爬虫将查看您的 robots.txt 文件以查看要爬取哪些页面,这就是为什么它对技术 SEO 如此重要。

最终,当网络爬虫抓取您的页面时,它会决定您的页面是否会显示在查询的搜索结果页面上。请务必注意,某些网络爬虫的行为可能与其他爬虫不同。例如,有些人在决定哪些网页最需要抓取时可能会使用不同的因素。

既然我们已经了解了网络爬虫的工作原理,我们将讨论为什么它们应该爬取您的网站。

以上是网络爬虫是什么的详细内容。更多信息请关注PHP中文网其他相关文章!

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

AI Hentai Generator

免费生成ai无尽的。

热门文章

热工具

记事本++7.3.1

好用且免费的代码编辑器

SublimeText3汉化版

中文版,非常好用

禅工作室 13.0.1

功能强大的PHP集成开发环境

Dreamweaver CS6

视觉化网页开发工具

SublimeText3 Mac版

神级代码编辑软件(SublimeText3)

热门话题

如何利用React和Python构建强大的网络爬虫应用

Sep 26, 2023 pm 01:04 PM

如何利用React和Python构建强大的网络爬虫应用

Sep 26, 2023 pm 01:04 PM

如何利用React和Python构建强大的网络爬虫应用引言:网络爬虫是一种自动化程序,用于通过互联网抓取网页数据。随着互联网的不断发展和数据的爆炸式增长,网络爬虫越来越受欢迎。本文将介绍如何利用React和Python这两种流行的技术,构建一个强大的网络爬虫应用。我们将探讨React作为前端框架,Python作为爬虫引擎的优势,并提供具体的代码示例。一、为

使用Vue.js和Perl语言开发高效的网络爬虫和数据抓取工具

Jul 31, 2023 pm 06:43 PM

使用Vue.js和Perl语言开发高效的网络爬虫和数据抓取工具

Jul 31, 2023 pm 06:43 PM

使用Vue.js和Perl语言开发高效的网络爬虫和数据抓取工具近年来,随着互联网的迅猛发展和数据的日益重要,网络爬虫和数据抓取工具的需求也越来越大。在这个背景下,结合Vue.js和Perl语言开发高效的网络爬虫和数据抓取工具是一种不错的选择。本文将介绍如何使用Vue.js和Perl语言开发这样一个工具,并附上相应的代码示例。一、Vue.js和Perl语言的介

如何使用PHP编写一个简单的网络爬虫

Jun 14, 2023 am 08:21 AM

如何使用PHP编写一个简单的网络爬虫

Jun 14, 2023 am 08:21 AM

网络爬虫是一种自动化程序,能够自动访问网站并抓取其中的信息。这种技术在如今的互联网世界中越来越常见,被广泛应用于数据挖掘、搜索引擎、社交媒体分析等领域。如果你想了解如何使用PHP编写简单的网络爬虫,本文将会为你提供基本的指导和建议。首先,需要了解一些基本的概念和技术。爬取目标在编写爬虫之前,需要选择爬取的目标。这可以是一个特定的网站、一个特定的网页、或整个互

PHP 网络爬虫之 HTTP 请求方法详解

Jun 17, 2023 am 11:53 AM

PHP 网络爬虫之 HTTP 请求方法详解

Jun 17, 2023 am 11:53 AM

随着互联网的发展,各种各样的数据变得越来越容易获取。而网络爬虫作为一种获取数据的工具,越来越受到人们的关注和重视。在网络爬虫中,HTTP请求是一个重要的环节,本文将详细介绍PHP网络爬虫中常见的HTTP请求方法。一、HTTP请求方法HTTP请求方法是指客户端向服务器发送请求时,所使用的请求方法。常见的HTTP请求方法有GET、POST、PU

如何使用PHP和swoole进行大规模的网络爬虫开发?

Jul 21, 2023 am 09:09 AM

如何使用PHP和swoole进行大规模的网络爬虫开发?

Jul 21, 2023 am 09:09 AM

如何使用PHP和swoole进行大规模的网络爬虫开发?引言:随着互联网的迅速发展,大数据已经成为当今社会的重要资源之一。为了获取这些宝贵的数据,网络爬虫应运而生。网络爬虫可以自动化地访问互联网上的各种网站,并从中提取所需的信息。在本文中,我们将探讨如何使用PHP和swoole扩展来开发高效的、大规模的网络爬虫。一、了解网络爬虫的基本原理网络爬虫的基本原理很简

PHP 简单网络爬虫开发实例

Jun 13, 2023 pm 06:54 PM

PHP 简单网络爬虫开发实例

Jun 13, 2023 pm 06:54 PM

随着互联网的迅速发展,数据已成为了当今信息时代最为重要的资源之一。而网络爬虫作为一种自动化获取和处理网络数据的技术,正越来越受到人们的关注和应用。本文将介绍如何使用PHP开发一个简单的网络爬虫,并实现自动化获取网络数据的功能。一、网络爬虫概述网络爬虫是一种自动化获取和处理网络资源的技术,其主要工作过程是模拟浏览器行为,自动访问指定的URL地址并提取所

PHP学习笔记:网络爬虫与数据采集

Oct 08, 2023 pm 12:04 PM

PHP学习笔记:网络爬虫与数据采集

Oct 08, 2023 pm 12:04 PM

PHP学习笔记:网络爬虫与数据采集引言:网络爬虫是一种自动从互联网上抓取数据的工具,它可以模拟人的行为,浏览网页并收集所需的数据。PHP作为一种流行的服务器端脚本语言,在网络爬虫和数据采集领域也发挥了重要的作用。本文将介绍如何使用PHP编写网络爬虫,并提供实际的代码示例。一、网络爬虫的基本原理网络爬虫的基本原理是通过发送HTTP请求,接收并解析服务器响应的H