用Scrapy和MongoDB实现基于时间序列的数据记录和分析

随着大数据和数据挖掘技术的快速发展,人们越来越注重时间序列的数据的记录和分析。而在网络爬虫方面,Scrapy是一款非常优秀的爬虫框架,而MongoDB则是一款非常优秀的NoSQL数据库。本文将介绍如何使用Scrapy和MongoDB实现基于时间序列的数据记录和分析。

一、Scrapy的安装和使用

Scrapy是Python语言实现的Web爬虫框架。我们可以使用以下命令安装Scrapy:

pip install scrapy

安装完成后,我们就可以使用Scrapy来编写我们的爬虫了。下面我们将通过一个简单的爬虫例子来了解Scrapy的使用。

1、创建Scrapy项目

在命令行终端中,通过以下命令创建一个新的Scrapy项目:

scrapy startproject scrapy_example

项目创建完成后,我们可以通过以下命令进入到项目的根目录:

cd scrapy_example

2、编写爬虫

我们可以通过以下命令创建一个新的爬虫:

scrapy genspider example www.example.com

这里的example是自定义的爬虫名称,www.example.com是爬取的网站域名。Scrapy会生成一个默认的爬虫模板文件,我们可以编辑这个文件,来进行爬虫的编写。

在这个例子中,我们爬取一个简单的网页,并将网页上的文字内容保存到一个文本文件中。这个爬虫代码如下:

import scrapy

class ExampleSpider(scrapy.Spider):

name = "example"

start_urls = ["https://www.example.com/"]

def parse(self, response):

filename = "example.txt"

with open(filename, "w") as f:

f.write(response.text)

self.log(f"Saved file {filename}")3、运行爬虫

运行爬虫之前,我们先设置一下Scrapy的配置。在项目的根目录下,找到settings.py文件,将ROBOTSTXT_OBEY设置为False,这样我们的爬虫就可以爬取任何网站了。

ROBOTSTXT_OBEY = False

接下来,我们就可以通过以下命令运行这个爬虫了:

scrapy crawl example

运行结束后,我们就可以在项目的根目录下看到一个example.txt的文件,里面保存了我们爬取的网页文本内容。

二、MongoDB的安装和使用

MongoDB是一款非常优秀的NoSQL数据库。我们可以使用以下命令安装MongoDB:

sudo apt-get install mongodb

安装完成后,我们需要启动MongoDB服务。在命令行终端中输入以下命令:

sudo service mongodb start

成功启动MongoDB服务后,我们就可以通过MongoDB Shell来操作数据了。

1、创建数据库

在命令行终端中输入以下命令,连接到MongoDB数据库:

mongo

连接成功后,我们可以使用以下命令创建一个新的数据库:

use scrapytest

这里的scrapytest就是我们自定义的数据库名称。

2、创建集合

在MongoDB中,我们使用集合(Collection)来存储数据。我们可以使用以下命令创建一个新的集合:

db.createCollection("example")这里的example就是我们自定义的集合名称。

3、插入数据

在Python中,我们可以使用pymongo库来访问MongoDB数据库。我们可以使用以下命令安装pymongo库:

pip install pymongo

安装完成后,我们就可以使用以下代码插入数据:

import pymongo

client = pymongo.MongoClient(host="localhost", port=27017)

db = client["scrapytest"]

collection = db["example"]

data = {"title": "example", "content": "Hello World!"}

collection.insert_one(data)这里的data就是我们要插入的数据,包含了title和content两个字段。

4、查询数据

我们可以使用以下代码查询数据:

import pymongo

client = pymongo.MongoClient(host="localhost", port=27017)

db = client["scrapytest"]

collection = db["example"]

result = collection.find_one({"title": "example"})

print(result["content"])这里的查询条件是"title": "example",表示查询title字段等于example的数据。查询结果会包含整个数据文档,我们可以通过result["content"]来获取content字段的值。

三、Scrapy和MongoDB的结合使用

在实际的爬虫应用中,我们常常需要将爬取到的数据保存到数据库中,并对数据进行时间序列的记录和分析。Scrapy和MongoDB的结合使用,可以很好地满足这个需求。

在Scrapy中,我们可以使用pipelines来处理爬取到的数据,并将数据保存到MongoDB中。

1、创建pipeline

我们可以在Scrapy项目的根目录下创建一个名为pipelines.py的文件,在这个文件中定义我们的pipeline。在这个例子中,我们将爬取到的数据保存到MongoDB中,并加入一个timestamp字段,表示数据记录的时间戳。代码如下:

import pymongo

from datetime import datetime

class ScrapyExamplePipeline:

def open_spider(self, spider):

self.client = pymongo.MongoClient("localhost", 27017)

self.db = self.client["scrapytest"]

def close_spider(self, spider):

self.client.close()

def process_item(self, item, spider):

collection = self.db[spider.name]

item["timestamp"] = datetime.now()

collection.insert_one(dict(item))

return item这个pipeline会在爬虫每爬取到一个item时被调用。我们将爬取到的item转换为一个字典,并加入一个timestamp字段,然后将整个字典保存到MongoDB中。

2、配置pipeline

在Scrapy项目的根目录下找到settings.py文件,将ITEM_PIPELINES设置为我们刚刚定义的pipeline:

ITEM_PIPELINES = {

"scrapy_example.pipelines.ScrapyExamplePipeline": 300,

}这里的300是pipeline的优先级,表示该pipeline在所有的pipeline中的执行顺序。

3、修改爬虫代码

修改我们刚刚编写的爬虫代码,将item传递给pipeline。

import scrapy

class ExampleSpider(scrapy.Spider):

name = "example"

start_urls = ["https://www.example.com/"]

def parse(self, response):

for text in response.css("p::text"):

yield {"text": text.extract()}这里我们简单爬取了网页上的文字内容,并将内容保存到了一个text字段中。Scrapy会将这个item传递给定义好的pipeline进行处理。

4、查询数据

现在,我们已经可以将爬取到的数据保存到MongoDB中了。我们还需要实现时间序列的记录和分析。我们可以使用MongoDB的查询和聚合操作来实现。

查找指定时间段内的数据:

import pymongo

from datetime import datetime

client = pymongo.MongoClient("localhost", 27017)

db = client["scrapytest"]

collection = db["example"]

start_time = datetime(2021, 1, 1)

end_time = datetime(2021, 12, 31)

result = collection.find({"timestamp": {"$gte": start_time, "$lte": end_time}})

for item in result:

print(item["text"])这里我们查找了2021年的全部数据。

统计每个小时内的记录数:

import pymongo

client = pymongo.MongoClient("localhost", 27017)

db = client["scrapytest"]

collection = db["example"]

pipeline = [

{"$group": {"_id": {"$hour": "$timestamp"}, "count": {"$sum": 1}}},

{"$sort": {"_id": 1}},

]

result = collection.aggregate(pipeline)

for item in result:

print(f"{item['_id']}: {item['count']}")这里我们使用MongoDB的聚合操作来统计每个小时内的记录数。

通过Scrapy和MongoDB的结合使用,我们可以方便地实现时间序列的数据记录和分析。这种方案的优点是具有较强的扩展性和灵活性,可以适用于各种不同的应用场景。不过,由于本方案的实现可能涉及到一些较为复杂的数据结构和算法,所以在实际应用中需要进行一定程度的优化和调整。

以上是用Scrapy和MongoDB实现基于时间序列的数据记录和分析的详细内容。更多信息请关注PHP中文网其他相关文章!

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

AI Hentai Generator

免费生成ai无尽的。

热门文章

热工具

记事本++7.3.1

好用且免费的代码编辑器

SublimeText3汉化版

中文版,非常好用

禅工作室 13.0.1

功能强大的PHP集成开发环境

Dreamweaver CS6

视觉化网页开发工具

SublimeText3 Mac版

神级代码编辑软件(SublimeText3)

热门话题

用于时间序列概率预测的分位数回归

May 07, 2024 pm 05:04 PM

用于时间序列概率预测的分位数回归

May 07, 2024 pm 05:04 PM

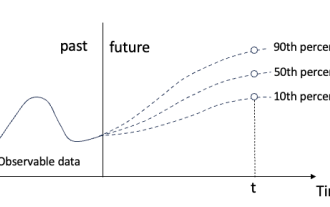

不要改变原内容的意思,微调内容,重写内容,不要续写。“分位数回归满足这一需求,提供具有量化机会的预测区间。它是一种统计技术,用于模拟预测变量与响应变量之间的关系,特别是当响应变量的条件分布命令人感兴趣时。与传统的回归方法不同,分位数回归侧重于估计响应变量变量的条件量值,而不是条件均值。”图(A):分位数回归分位数回归概念分位数回归是估计⼀组回归变量X与被解释变量Y的分位数之间线性关系的建模⽅法。现有的回归模型实际上是研究被解释变量与解释变量之间关系的一种方法。他们关注解释变量与被解释变量之间的关

navicat怎么连mongodb

Apr 24, 2024 am 11:27 AM

navicat怎么连mongodb

Apr 24, 2024 am 11:27 AM

要使用 Navicat 连接 MongoDB,您需要:安装 Navicat创建 MongoDB 连接:a. 输入连接名称、主机地址和端口b. 输入认证信息(如果需要)添加 SSL 证书(如果需要)验证连接保存连接

net4.0有什么用

May 10, 2024 am 01:09 AM

net4.0有什么用

May 10, 2024 am 01:09 AM

.NET 4.0 用于创建各种应用程序,它为应用程序开发人员提供了丰富的功能,包括:面向对象编程、灵活性、强大的架构、云计算集成、性能优化、广泛的库、安全性、可扩展性、数据访问和移动开发支持。

无服务器架构中Java函数与数据库的集成

Apr 28, 2024 am 08:57 AM

无服务器架构中Java函数与数据库的集成

Apr 28, 2024 am 08:57 AM

在无服务器架构中,Java函数可以与数据库集成,以访问和操作数据库中的数据。关键步骤包括:创建Java函数、配置环境变量、部署函数和测试函数。通过遵循这些步骤,开发人员可以构建复杂的应用程序,无缝访问存储在数据库中的数据。

如何在Debian上配置MongoDB自动扩容

Apr 02, 2025 am 07:36 AM

如何在Debian上配置MongoDB自动扩容

Apr 02, 2025 am 07:36 AM

本文介绍如何在Debian系统上配置MongoDB实现自动扩容,主要步骤包括MongoDB副本集的设置和磁盘空间监控。一、MongoDB安装首先,确保已在Debian系统上安装MongoDB。使用以下命令安装:sudoaptupdatesudoaptinstall-ymongodb-org二、配置MongoDB副本集MongoDB副本集确保高可用性和数据冗余,是实现自动扩容的基础。启动MongoDB服务:sudosystemctlstartmongodsudosys

MongoDB在Debian上的高可用性如何保障

Apr 02, 2025 am 07:21 AM

MongoDB在Debian上的高可用性如何保障

Apr 02, 2025 am 07:21 AM

本文介绍如何在Debian系统上构建高可用性的MongoDB数据库。我们将探讨多种方法,确保数据安全和服务持续运行。关键策略:副本集(ReplicaSet):利用副本集实现数据冗余和自动故障转移。当主节点出现故障时,副本集会自动选举新的主节点,保证服务的持续可用性。数据备份与恢复:定期使用mongodump命令进行数据库备份,并制定有效的恢复策略,以应对数据丢失风险。监控与报警:部署监控工具(如Prometheus、Grafana)实时监控MongoDB的运行状态,并

Navicat查看MongoDB数据库密码的方法

Apr 08, 2025 pm 09:39 PM

Navicat查看MongoDB数据库密码的方法

Apr 08, 2025 pm 09:39 PM

直接通过 Navicat 查看 MongoDB 密码是不可能的,因为它以哈希值形式存储。取回丢失密码的方法:1. 重置密码;2. 检查配置文件(可能包含哈希值);3. 检查代码(可能硬编码密码)。

Pi币重大更新:Pi Bank要来了!

Mar 03, 2025 pm 06:18 PM

Pi币重大更新:Pi Bank要来了!

Mar 03, 2025 pm 06:18 PM

PiNetwork即将推出革命性移动银行平台PiBank!PiNetwork今日发布重大更新Elmahrosa(Face)PIMISRBank,简称PiBank,它将传统银行服务与PiNetwork加密货币功能完美融合,实现法币与加密货币的原子交换(支持美元、欧元、印尼盾等法币与PiCoin、USDT、USDC等加密货币的互换)。究竟PiBank有何魅力?让我们一探究竟!PiBank主要功能:一站式管理银行账户和加密货币资产。支持实时交易,并采用生物特