Scrapy实战:爬取豆瓣电影数据和评分热度排名

Scrapy是一个开源的Python框架,用于快速高效地爬取数据。在本文中,我们将使用Scrapy爬取豆瓣电影的数据和评分热度排名。

- 准备工作

首先,我们需要安装Scrapy。您可以在命令行中输入以下命令来安装Scrapy:

pip install scrapy

接下来,我们将创建一个Scrapy项目。在命令行中,输入以下命令:

scrapy startproject doubanmovie

这将创建一个名为doubanmovie的Scrapy项目。然后,我们将进入项目目录并创建一个名为douban.py的Spider。在命令行中,输入以下命令:

cd doubanmovie scrapy genspider douban douban.com

现在,我们已经有了一个可以使用的Spider。接下来,我们将定义Spider的行为以获取所需的数据。

- 爬取电影数据

我们将使用Spider来爬取豆瓣电影的数据。具体来说,我们将获取以下信息:

- 电影名称

- 导演

- 演员

- 类型

- 国家

- 语言

- 上映日期

- 片长

- 评分

- 评价人数

打开douban.py文件,我们将添加以下代码:

import scrapy

class DoubanSpider(scrapy.Spider):

name = 'douban'

allowed_domains = ['douban.com']

start_urls = ['https://movie.douban.com/top250']

def parse(self, response):

movie_list = response.xpath('//div[@class="item"]')

for movie in movie_list:

yield {

'name': movie.xpath('.//span[@class="title"]/text()').get(),

'director': movie.xpath('.//div[@class="bd"]/p/text()[1]').get(),

'actors': movie.xpath('.//div[@class="bd"]/p/text()[2]').get(),

'genre': movie.xpath('.//div[@class="bd"]/p/text()[3]').get(),

'country': movie.xpath('.//div[@class="bd"]/p/text()[4]').get(),

'language': movie.xpath('.//div[@class="bd"]/p/text()[5]').get(),

'release_date': movie.xpath('.//div[@class="bd"]/p/text()[6]').get(),

'duration': movie.xpath('.//div[@class="bd"]/p/text()[7]').get(),

'rating': movie.xpath('.//span[@class="rating_num"]/text()').get(),

'num_reviews': movie.xpath('.//div[@class="star"]/span[@class="rating_num"]/text()').get(),

}在这个代码中,我们使用XPath来选取我们需要获取的信息。我们使用yield来生成这些信息,并使用return来将它们返回到用户。

如果我们现在运行我们的Spider(运行以下命令:scrapy crawl douban),它将爬取前250部电影的数据,并将它们返回到命令行中。

- 获取评分热度排名

现在,我们已经成功地获取了前250部电影的数据。接下来,我们将获取它们的评分热度排名。

我们需要先创建一个新的Spider,来爬取豆瓣电影的TOP250列表。我们将使用此列表来获取电影的排名。

在douban.py文件中,我们将添加以下代码:

import scrapy

class DoubanSpider(scrapy.Spider):

name = 'douban'

allowed_domains = ['douban.com']

start_urls = ['https://movie.douban.com/top250']

def parse(self, response):

movie_list = response.xpath('//div[@class="item"]')

for movie in movie_list:

yield {

'name': movie.xpath('.//span[@class="title"]/text()').get(),

'director': movie.xpath('.//div[@class="bd"]/p/text()[1]').get(),

'actors': movie.xpath('.//div[@class="bd"]/p/text()[2]').get(),

'genre': movie.xpath('.//div[@class="bd"]/p/text()[3]').get(),

'country': movie.xpath('.//div[@class="bd"]/p/text()[4]').get(),

'language': movie.xpath('.//div[@class="bd"]/p/text()[5]').get(),

'release_date': movie.xpath('.//div[@class="bd"]/p/text()[6]').get(),

'duration': movie.xpath('.//div[@class="bd"]/p/text()[7]').get(),

'rating': movie.xpath('.//span[@class="rating_num"]/text()').get(),

'num_reviews': movie.xpath('.//div[@class="star"]/span[@class="rating_num"]/text()').get(),

}

next_page = response.xpath('//span[@class="next"]/a/@href')

if next_page:

url = response.urljoin(next_page[0].get())

yield scrapy.Request(url, callback=self.parse)在代码中,我们使用了一个名为next_page的变量,来检查我们是否到达了最后一页。如果我们还没有到达最后一页,我们将继续爬取下一页。

接下来,我们需要更新parse方法,以获取电影的排名。我们将使用Python的enumerate函数来将排名与每部电影相关联。

在douban.py文件中,我们将替换原来的parse方法:

def parse(self, response):

movie_list = response.xpath('//div[@class="item"]')

for i, movie in enumerate(movie_list):

yield {

'rank': i + 1,

'name': movie.xpath('.//span[@class="title"]/text()').get(),

'director': movie.xpath('.//div[@class="bd"]/p/text()[1]').get(),

'actors': movie.xpath('.//div[@class="bd"]/p/text()[2]').get(),

'genre': movie.xpath('.//div[@class="bd"]/p/text()[3]').get(),

'country': movie.xpath('.//div[@class="bd"]/p/text()[4]').get(),

'language': movie.xpath('.//div[@class="bd"]/p/text()[5]').get(),

'release_date': movie.xpath('.//div[@class="bd"]/p/text()[6]').get(),

'duration': movie.xpath('.//div[@class="bd"]/p/text()[7]').get(),

'rating': movie.xpath('.//span[@class="rating_num"]/text()').get(),

'num_reviews': movie.xpath('.//div[@class="star"]/span[@class="rating_num"]/text()').get(),

}

next_page = response.xpath('//span[@class="next"]/a/@href')

if next_page:

url = response.urljoin(next_page[0].get())

yield scrapy.Request(url, callback=self.parse)现在,如果我们再次运行我们的Spider,它将获取前250部电影的数据,并将它们返回到命令行中。此时,我们将看到所有电影的排名。

- 结论

Scrapy是一种非常强大和灵活的工具,用于快速高效地爬取数据。在本文中,我们已经成功地使用Scrapy来爬取豆瓣电影的数据和评分热度排名。

我们使用Python代码和XPath来选择性获取网页上的信息,并使用yield语句来将其返回给用户。在整个过程中,Scrapy提供了一个简单而有效的方式来管理和爬取大量的数据,使我们能够快速地进行数据分析和处理。

以上是Scrapy实战:爬取豆瓣电影数据和评分热度排名的详细内容。更多信息请关注PHP中文网其他相关文章!

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

AI Hentai Generator

免费生成ai无尽的。

热门文章

热工具

记事本++7.3.1

好用且免费的代码编辑器

SublimeText3汉化版

中文版,非常好用

禅工作室 13.0.1

功能强大的PHP集成开发环境

Dreamweaver CS6

视觉化网页开发工具

SublimeText3 Mac版

神级代码编辑软件(SublimeText3)

热门话题

Scrapy实现微信公众号文章爬取和分析

Jun 22, 2023 am 09:41 AM

Scrapy实现微信公众号文章爬取和分析

Jun 22, 2023 am 09:41 AM

Scrapy实现微信公众号文章爬取和分析微信是近年来备受欢迎的社交媒体应用,在其中运营的公众号也扮演着非常重要的角色。众所周知,微信公众号是一个信息和知识的海洋,因为其中每个公众号都可以发布文章、图文消息等信息。这些信息可以被广泛地应用在很多领域中,比如媒体报道、学术研究等。那么,本篇文章将介绍如何使用Scrapy框架来实现微信公众号文章的爬取和分析。Scr

利用纽约时报API进行元数据爬取

Sep 02, 2023 pm 10:13 PM

利用纽约时报API进行元数据爬取

Sep 02, 2023 pm 10:13 PM

简介上周,我写了一篇关于抓取网页以收集元数据的介绍,并提到不可能抓取《纽约时报》网站。《纽约时报》付费墙会阻止您收集基本元数据的尝试。但有一种方法可以使用纽约时报API来解决这个问题。最近我开始在Yii平台上构建一个社区网站,我将在以后的教程中发布该网站。我希望能够轻松添加与网站内容相关的链接。虽然人们可以轻松地将URL粘贴到表单中,但提供标题和来源信息却非常耗时。因此,在今天的教程中,我将扩展我最近编写的抓取代码,以在添加《纽约时报》链接时利用《纽约时报》API来收集头条新闻。请记住,我参与了

Scrapy基于Ajax异步加载实现方法

Jun 22, 2023 pm 11:09 PM

Scrapy基于Ajax异步加载实现方法

Jun 22, 2023 pm 11:09 PM

Scrapy是一个开源的Python爬虫框架,它可以快速高效地从网站上获取数据。然而,很多网站采用了Ajax异步加载技术,使得Scrapy无法直接获取数据。本文将介绍基于Ajax异步加载的Scrapy实现方法。一、Ajax异步加载原理Ajax异步加载:在传统的页面加载方式中,浏览器发送请求到服务器后,必须等待服务器返回响应并将页面全部加载完毕才能进行下一步操

Scrapy案例解析:如何抓取LinkedIn上公司信息

Jun 23, 2023 am 10:04 AM

Scrapy案例解析:如何抓取LinkedIn上公司信息

Jun 23, 2023 am 10:04 AM

Scrapy是一个基于Python的爬虫框架,可以快速而方便地获取互联网上的相关信息。在本篇文章中,我们将通过一个Scrapy案例来详细解析如何抓取LinkedIn上的公司信息。确定目标URL首先,我们需要明确我们的目标是LinkedIn上的公司信息。因此,我们需要找到LinkedIn公司信息页面的URL。打开LinkedIn网站,在搜索框中输入公司名称,在

豆瓣app如何设置英文模式 豆瓣app设置英文模式的方法

Mar 12, 2024 pm 02:46 PM

豆瓣app如何设置英文模式 豆瓣app设置英文模式的方法

Mar 12, 2024 pm 02:46 PM

豆瓣app如何设置英文模式?豆瓣app是一款可以让大家在这上面查看各种资源评论的软件,这个软件上面有很多的功能,用户在首次使用这个软件的时候,是需要进行登录的,而且这个软件上面的语言默认就是中文模式,有些用户就喜欢用英文模式,但是又不知道要怎么在这个软件上面设置英文模式,下面小编就整理了设置英文模式的方法供大家参考。豆瓣app设置英文模式的方法 1、打开手机上的“豆瓣”app; 2、点击“我的”; 3、选择右上角的“设置”

如何在PHP项目中通过调用API接口来实现数据的爬取和处理?

Sep 05, 2023 am 08:41 AM

如何在PHP项目中通过调用API接口来实现数据的爬取和处理?

Sep 05, 2023 am 08:41 AM

如何在PHP项目中通过调用API接口来实现数据的爬取和处理?一、介绍在PHP项目中,我们经常需要爬取其他网站的数据,并对这些数据进行处理。而许多网站提供了API接口,我们可以通过调用这些接口来获取数据。本文将介绍如何使用PHP来调用API接口,实现数据的爬取和处理。二、获取API接口的URL和参数在开始之前,我们需要先获取目标API接口的URL以及所需的

Scrapy优化技巧:如何减少重复URL的爬取,提高效率

Jun 22, 2023 pm 01:57 PM

Scrapy优化技巧:如何减少重复URL的爬取,提高效率

Jun 22, 2023 pm 01:57 PM

Scrapy是一个功能强大的Python爬虫框架,可以用于从互联网上获取大量的数据。但是,在进行Scrapy开发时,经常会遇到重复URL的爬取问题,这会浪费大量的时间和资源,影响效率。本文将介绍一些Scrapy优化技巧,以减少重复URL的爬取,提高Scrapy爬虫的效率。一、使用start_urls和allowed_domains属性在Scrapy爬虫中,可

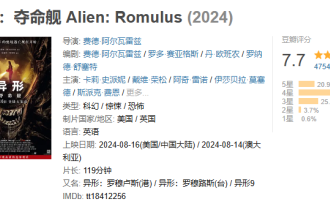

太空惊悚电影《异形:夺命舰》豆瓣开分 7.7,上映次日票房破亿

Aug 17, 2024 pm 10:50 PM

太空惊悚电影《异形:夺命舰》豆瓣开分 7.7,上映次日票房破亿

Aug 17, 2024 pm 10:50 PM

本站8月17日消息,20世纪影业旗下太空惊悚电影《异形:夺命舰》于昨日(8月16日)在内地上映,豆瓣评分今日公布为7.7。据灯塔专业版实时数据,截至8月17日20时5分,该影片票房已经突破1亿。本站附评分分布如下:5星占比20.9%4星占比49.5%3星占比25.4%2星占比3.7%1星占比0.6%《异形:夺命舰》由20世纪影业出品,《银翼杀手》《普罗米修斯》导演雷德利・斯科特担任制片人,费德・阿尔瓦雷执导,费德・阿尔瓦雷、罗多・赛亚格斯编剧,卡莉・史派妮、伊莎贝拉・默塞德、爱玲・吴、斯派克・费