Scrapy优化技巧:如何减少重复URL的爬取,提高效率

Scrapy是一个功能强大的Python爬虫框架,可以用于从互联网上获取大量的数据。但是,在进行Scrapy开发时,经常会遇到重复URL的爬取问题,这会浪费大量的时间和资源,影响效率。本文将介绍一些Scrapy优化技巧,以减少重复URL的爬取,提高Scrapy爬虫的效率。

一、使用start_urls和allowed_domains属性

在Scrapy爬虫中,可以使用start_urls属性指定需要爬取的网址。同时,还可以使用allowed_domains属性指定该爬虫可以爬取的域名。这两个属性的使用可以帮助Scrapy快速过滤掉不需要爬取的网址,在节省时间和资源的同时,提高效率。

二、使用Scrapy-Redis实现分布式爬取

当需要爬取大量URL时,单机爬取效率低下,因此可以考虑使用分布式爬取技术。Scrapy-Redis是Scrapy的一个插件,通过使用Redis数据库实现分布式爬取,提高Scrapy爬虫的效率。通过在settings.py文件中设置REDIS_HOST和REDIS_PORT参数,可以指定Scrapy-Redis连接的Redis数据库的地址和端口号,从而实现分布式爬取。

三、使用增量式爬取技术

在Scrapy爬虫开发中,经常会遇到需要重复爬取相同网址的情况,这会造成大量的时间和资源浪费。因此,可以使用增量式爬取技术来减少重复爬取。增量式爬取技术的基本思想是:记录爬取过的网址,在下一次爬取时,根据记录查询是否已经爬取过相同网址,如果已经爬取过,则跳过。通过这种方式可以减少重复URL的爬取,提高效率。

四、使用中间件过滤重复URL

除了增量式爬取技术外,还可以使用中间件过滤重复URL。Scrapy中的中间件是一种自定义的处理器,在Scrapy爬虫运行过程中,可以通过中间件对请求和响应进行处理。我们可以通过编写自定义中间件来实现URL去重。其中,最常用的去重方法是使用Redis数据库记录已经爬取的URL列表,通过查询该列表来判断URL是否已经被爬取过。

五、使用DupeFilter过滤重复URL

除了自定义中间件外,Scrapy还提供了一个内置的去重过滤器DupeFilter,可以有效地减少重复URL的爬取。DupeFilter会对每个URL进行哈希处理,并在内存中保存不重复的哈希值。因此,在爬取过程中,只有哈希值不同的URL才会被爬取。使用DupeFilter不需要额外的Redis服务器支持,是一种轻量级的重复URL过滤方式。

总结:

在Scrapy爬虫开发中,重复URL的爬取是一个常见的问题,需要通过各种优化技巧来减少重复URL的爬取,提高Scrapy爬虫的效率。本文介绍了一些常见的Scrapy优化技巧,包括使用start_urls和allowed_domains属性、使用Scrapy-Redis实现分布式爬取、使用增量式爬取技术、使用自定义中间件过滤重复URL以及使用内置的DupeFilter过滤重复URL。读者可以根据自己的需求选择适合的优化方式,提高Scrapy爬虫的效率。

以上是Scrapy优化技巧:如何减少重复URL的爬取,提高效率的详细内容。更多信息请关注PHP中文网其他相关文章!

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

AI Hentai Generator

免费生成ai无尽的。

热门文章

热工具

记事本++7.3.1

好用且免费的代码编辑器

SublimeText3汉化版

中文版,非常好用

禅工作室 13.0.1

功能强大的PHP集成开发环境

Dreamweaver CS6

视觉化网页开发工具

SublimeText3 Mac版

神级代码编辑软件(SublimeText3)

热门话题

html和url的区别是什么

Mar 06, 2024 pm 03:06 PM

html和url的区别是什么

Mar 06, 2024 pm 03:06 PM

区别:1、定义不同,url是是统一资源定位符,而html是超文本标记语言;2、一个html中可以有很多个url,而一个url中只能存在一个html页面;3、html指的是网页,而url指的是网站地址。

深度解读:为何Laravel速度慢如蜗牛?

Mar 07, 2024 am 09:54 AM

深度解读:为何Laravel速度慢如蜗牛?

Mar 07, 2024 am 09:54 AM

Laravel是一款广受欢迎的PHP开发框架,但有时候被人诟病的就是其速度慢如蜗牛。究竟是什么原因导致了Laravel的速度不尽如人意呢?本文将从多个方面深度解读Laravel速度慢如蜗牛的原因,并结合具体的代码示例,帮助读者更深入地了解此问题。1.ORM查询性能问题在Laravel中,ORM(对象关系映射)是一个非常强大的功能,可以让

Golang的gc优化策略探讨

Mar 06, 2024 pm 02:39 PM

Golang的gc优化策略探讨

Mar 06, 2024 pm 02:39 PM

Golang的垃圾回收(GC)一直是开发者们关注的一个热门话题。Golang作为一门快速的编程语言,其自带的垃圾回收器能够很好地管理内存,但随着程序规模的增大,有时候会出现一些性能问题。本文将探讨Golang的GC优化策略,并提供一些具体的代码示例。Golang中的垃圾回收Golang的垃圾回收器采用的是基于并发标记-清除(concurrentmark-s

C++ 程序优化:时间复杂度降低技巧

Jun 01, 2024 am 11:19 AM

C++ 程序优化:时间复杂度降低技巧

Jun 01, 2024 am 11:19 AM

时间复杂度衡量算法执行时间与输入规模的关系。降低C++程序时间复杂度的技巧包括:选择合适的容器(如vector、list)以优化数据存储和管理。利用高效算法(如快速排序)以减少计算时间。消除多重运算以减少重复计算。利用条件分支以避免不必要的计算。通过使用更快的算法(如二分搜索)来优化线性搜索。

解码Laravel性能瓶颈:优化技巧全面揭秘!

Mar 06, 2024 pm 02:33 PM

解码Laravel性能瓶颈:优化技巧全面揭秘!

Mar 06, 2024 pm 02:33 PM

解码Laravel性能瓶颈:优化技巧全面揭秘!Laravel作为一款流行的PHP框架,为开发者提供了丰富的功能和便捷的开发体验。然而,随着项目规模增大和访问量增加,我们可能会面临性能瓶颈的挑战。本文将深入探讨Laravel性能优化的技巧,帮助开发者发现并解决潜在的性能问题。一、数据库查询优化使用Eloquent延迟加载在使用Eloquent查询数据库时,避免

Laravel性能瓶颈揭秘:优化方案大揭秘!

Mar 07, 2024 pm 01:30 PM

Laravel性能瓶颈揭秘:优化方案大揭秘!

Mar 07, 2024 pm 01:30 PM

Laravel性能瓶颈揭秘:优化方案大揭秘!随着互联网技术的发展,网站和应用程序的性能优化变得愈发重要。作为一款流行的PHP框架,Laravel在开发过程中可能会面临性能瓶颈。本文将探讨Laravel应用程序可能遇到的性能问题,并提供一些优化方案和具体的代码示例,让开发者能够更好地解决这些问题。一、数据库查询优化数据库查询是Web应用中常见的性能瓶颈之一。在

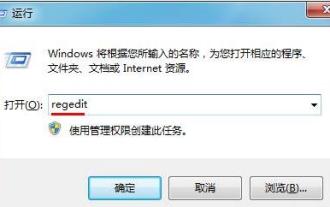

优化WIN7系统开机启动项的操作方法

Mar 26, 2024 pm 06:20 PM

优化WIN7系统开机启动项的操作方法

Mar 26, 2024 pm 06:20 PM

1、在桌面上按组合键(win键+R)打开运行窗口,接着输入【regedit】,回车确认。2、打开注册表编辑器后,我们依次点击展开【HKEY_CURRENT_USERSoftwareMicrosoftWindowsCurrentVersionExplorer】,然后看目录里有没有Serialize项,如果没有我们可以单击右键Explorer,新建项,并将其命名为Serialize。3、接着点击Serialize,然后在右边窗格空白处单击鼠标右键,新建一个DWORD(32)位值,并将其命名为Star

如何在 Golang 中用正则表达式检测 URL?

May 31, 2024 am 10:32 AM

如何在 Golang 中用正则表达式检测 URL?

May 31, 2024 am 10:32 AM

使用正则表达式在Golang中检测URL的步骤如下:使用regexp.MustCompile(pattern)编译正则表达式模式。模式需匹配协议、主机名、端口(可选)、路径(可选)和查询参数(可选)。使用regexp.MatchString(pattern,url)检测URL是否匹配模式。