Scrapy的强大功能:如何实现验证码的识别和处理?

Scrapy是一个强大的Python框架,可帮助我们轻松地爬取网站上的数据。但是,当我们要爬取的网站有验证码时,就会遇到问题。验证码的目的是防止自动化爬虫对网站进行攻击,所以它们往往是高度复杂而难以破解的。在这篇文章中,我们将介绍如何使用Scrapy框架来识别和处理验证码,以让我们的爬虫能够绕过这些防御措施。

什么是验证码?

验证码是用于证明用户是真实人类而不是机器的一种测试。它通常是一个混淆的文本字符串或一个难以辨别的图像,要求用户手动输入或选择所显示的内容。验证码旨在捕获自动机器人和脚本,以保护网站不受恶意攻击和滥用。

验证码通常有三种类型:

- 文本验证码:用户需要复制和粘贴一串文本,以证明他们是人类用户而不是机器人。

- 数字验证码:要求用户在输入框中输入显示的数字。

- 图片验证码:要求用户在输入框中输入显示的图像中的字符或数字,这通常是最难破解的类型,因为图像中的字符或数字可以是扭曲的、错位的或具有其他视觉噪音。

为什么需要处理验证码?

爬虫通常是大规模自动化执行的,因此它们很容易被识别为机器人并被网站禁止获取数据。验证码是为了防止这种情况发生而被引入的。一旦ep 进入到验证码阶段,Scrapy爬虫就会停下来等待用户输入,并因此无法继续爬取数据,导致爬虫的效率和完整性下降。

因此,我们需要一种方法来处理验证码,以便我们的爬虫可以自动通过并继续执行其任务。通常我们使用第三方工具或API来完成验证码的识别,这些工具和API使用机器学习和图像处理算法来识别图像和字符,并将结果返回给我们的程序。

如何在Scrapy中处理验证码?

打开Scrapy的settings.py文件,我们需要将DOWNLOADER_MIDDLEWARES的字段进行修改,加入以下的代理:

DOWNLOADER_MIDDLEWARES = {'scrapy.downloadermiddlewares.downloadtimeout.DownloadTimeoutMiddleware': 350,

'scrapy.contrib.downloadermiddleware.retry.RetryMiddleware': 350,'scrapy.contrib.downloadermiddleware.redirect.RedirectMiddleware': 400,

'scrapy.contrib.downloadermiddleware.cookies.CookiesMiddleware': 700,'scrapy.contrib.downloadermiddleware.httpproxy.HttpProxyMiddleware': 750,

'scrapy.contrib.downloadermiddleware.useragent.UserAgentMiddleware': 400,'scrapy.contrib.downloadermiddleware.defaultheaders.DefaultHeadersMiddleware': 550,

'scrapy.contrib.downloadermiddleware.ajaxcrawl.AjaxCrawlMiddleware': 900,'scrapy.contrib.downloadermiddleware.httpcompression.HttpCompressionMiddleware': 800,

'scrapy.contrib.downloadermiddleware.chunked.ChunkedTransferMiddleware': 830,'scrapy.contrib.downloadermiddleware.stats.DownloaderStats': 850,

'tutorial.middlewares.CaptchaMiddleware': 999}

在此示例中,我们使用CaptchaMiddleware来处理验证码。CaptchMiddleware是一个自定义的中间件类,它将处理下载请求并在需要时调用API来识别验证码,然后将验证码填入请求中并返回继续执行。

代码示例:

class CaptchaMiddleware(object):

def __init__(self):

self.client = CaptchaClient()

self.max_attempts = 5

def process_request(self, request, spider):

# 如果没有设置dont_filter则默认开启

if not request.meta.get('dont_filter', False):

request.meta['dont_filter'] = True

if 'captcha' in request.meta:

# 带有验证码信息

captcha = request.meta['captcha']

request.meta.pop('captcha')

else:

# 没有验证码则获取

captcha = self.get_captcha(request.url, logger=spider.logger)

if captcha:

# 如果有验证码则添加到请求头

request = request.replace(

headers={

'Captcha-Code': captcha,

'Captcha-Type': 'math',

}

)

spider.logger.debug(f'has captcha: {captcha}')

return request

def process_response(self, request, response, spider):

# 如果没有验证码或者验证码失败则不重试

need_retry = 'Captcha-Code' in request.headers.keys()

if not need_retry:

return response

# 如果已经尝试过,则不再重试

retry_times = request.meta.get('retry_times', 0)

if retry_times >= self.max_attempts:

return response

# 验证码校验失败则重试

result = self.client.check(request.url, request.headers['Captcha-Code'])

if not result:

spider.logger.warning(f'Captcha check fail: {request.url}')

return request.replace(

meta={

'captcha': self.get_captcha(request.url, logger=spider.logger),

'retry_times': retry_times + 1,

},

dont_filter=True,

)

# 验证码校验成功则继续执行

spider.logger.debug(f'Captcha check success: {request.url}')

return response

def get_captcha(self, url, logger=None):

captcha = self.client.solve(url)

if captcha:

if logger:

logger.debug(f'get captcha [0:4]: {captcha[0:4]}')

return captcha

return None

在此中间件中,我们使用了CaptchaClient对象作为captcha解决方案中间件,我们可以使用多个captcha解决方案中间件。

注意事项

在实现这个中间件时,请注意以下几点:

- 验证码的识别和处理需要使用第三方工具或API,我们需要确保我们有合法的许可证并按照厂商的要求使用它们。

- 添加了这样的中间件后,请求的流程会变得更加复杂,开发者需要仔细测试和调试以确保程序能够正常工作。

结论

通过使用Scrapy框架和验证码识别和处理的中间件,我们可以有效地绕过验证码防御策略,实现对目标网站的有效爬取。这种方式通常比手动输入验证码要省时省力,并具有更高的效率和准确性。但是,请务必注意在使用之前阅读并遵守第三方工具和API的许可协议和要求。

以上是Scrapy的强大功能:如何实现验证码的识别和处理?的详细内容。更多信息请关注PHP中文网其他相关文章!

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

AI Hentai Generator

免费生成ai无尽的。

热门文章

热工具

记事本++7.3.1

好用且免费的代码编辑器

SublimeText3汉化版

中文版,非常好用

禅工作室 13.0.1

功能强大的PHP集成开发环境

Dreamweaver CS6

视觉化网页开发工具

SublimeText3 Mac版

神级代码编辑软件(SublimeText3)

热门话题

WIN10服务主机太占cpu的处理操作过程

Mar 27, 2024 pm 02:41 PM

WIN10服务主机太占cpu的处理操作过程

Mar 27, 2024 pm 02:41 PM

1、首先我们右击任务栏空白处,选择【任务管理器】选项,或者右击开始徽标,然后再选择【任务管理器】选项。2、在打开的任务管理器界面,我们点击最右端的【服务】选项卡。3、在打开的【服务】选项卡,点击下方的【打开服务】选项。4、在打开的【服务】窗口,右击【InternetConnectionSharing(ICS)】服务,然后选择【属性】选项。5、在打开的属性窗口,将【打开方式】修改为【禁用】,点击【应用】后点击【确定】。6、点击开始徽标,然后点击关机按钮,选择【重启】,完成电脑重启就行了。

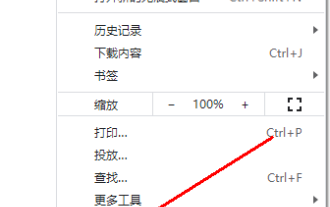

谷歌浏览器不显示验证码图片怎么办?chrome浏览器不显示验证码?

Mar 13, 2024 pm 08:55 PM

谷歌浏览器不显示验证码图片怎么办?chrome浏览器不显示验证码?

Mar 13, 2024 pm 08:55 PM

谷歌浏览器不显示验证码图片怎么办?在使用谷歌浏览器登录网页有时候需要验证码验证。部分用户在使用图片验证码的时候发现谷歌浏览器无法正常显示图片的内容。这应该怎么办呢?下面小编带来谷歌浏览器验证码不显示处理方法介绍,希望对大家有所帮助! 方法介绍 1、进入软件,点击右上角的“更多”按钮,选择下方选项列表中的“设置”进入。 2、进入新界面后,点击左侧的“隐私设置和安全性”选项。 3、接着点击右侧中的“网站设置&rdquo

虚拟号码可以接收验证码吗

Jan 02, 2024 am 10:22 AM

虚拟号码可以接收验证码吗

Jan 02, 2024 am 10:22 AM

虚拟号码可以接收验证码,只要注册时填写的手机号码符合规定,并且能够正常接通手机号,就可以收到短信验证码。不过,使用虚拟手机号需要注意,部分网站不支持虚拟手机号注册,因此需要选择正规的虚拟手机号服务商。

CSV文件操作速成指南

Dec 26, 2023 pm 02:23 PM

CSV文件操作速成指南

Dec 26, 2023 pm 02:23 PM

快速学会打开和处理CSV格式文件的方法指南随着数据分析和处理的不断发展,CSV格式成为了广泛使用的文件格式之一。CSV文件是一种简单且易于阅读的文本文件,其以逗号分隔不同的数据字段。无论是在学术研究、商业分析还是数据处理方面,都经常会遇到需要打开和处理CSV文件的情况。下面的指南将向您介绍如何快速学会打开和处理CSV格式文件。步骤一:了解CSV文件格式首先,

学习PHP中如何处理特殊字符转换单引号

Mar 27, 2024 pm 12:39 PM

学习PHP中如何处理特殊字符转换单引号

Mar 27, 2024 pm 12:39 PM

在PHP开发过程中,处理特殊字符是一个常见的问题,尤其是在字符串处理中经常会遇到特殊字符转义的情况。其中,将特殊字符转换单引号是一个比较常见的需求,因为在PHP中,单引号是一种常用的字符串包裹方式。在本文中,我们将介绍如何在PHP中处理特殊字符转换单引号,并提供具体的代码示例。在PHP中,特殊字符包括但不限于单引号(')、双引号(")、反斜杠()等。在字符串

C#开发中如何处理XML和JSON数据格式

Oct 09, 2023 pm 06:15 PM

C#开发中如何处理XML和JSON数据格式

Oct 09, 2023 pm 06:15 PM

C#开发中如何处理XML和JSON数据格式,需要具体代码示例在现代软件开发中,XML和JSON是广泛应用的两种数据格式。XML(可扩展标记语言)是一种用于存储和传输数据的标记语言,而JSON(JavaScript对象表示)是一种轻量级的数据交换格式。在C#开发中,我们经常需要处理和操作XML和JSON数据,本文将重点介绍如何使用C#处理这两种数据格式,并附上

win7升级至win10失败后,如何解决?

Dec 26, 2023 pm 07:49 PM

win7升级至win10失败后,如何解决?

Dec 26, 2023 pm 07:49 PM

如果我们使用的操作系统是win7的话,对于在升级的时候有的小伙伴们可能就会出现win7升win10失败的情况。小编觉得我们可以尝试重新升级看下能不能解决。详细内容就来看下小编是怎么做的吧~win7升win10失败怎么办方法一:1.建议下载个驱动人生先评估下你电脑是否可以升级到Win10,2.然后升级后用驱动人生检测下有没有驱动异常这些,然后一键修复。方法二:1.删除C:\Windows\SoftwareDistribution\Download下的所有文件。2.win+R运行“wuauclt.e

如何使用 JavaScript 实现验证码功能?

Oct 19, 2023 am 10:46 AM

如何使用 JavaScript 实现验证码功能?

Oct 19, 2023 am 10:46 AM

如何使用JavaScript实现验证码功能?随着网络的发展,验证码已经成为了网站和应用程序中不可或缺的安全机制之一。验证码(VerificationCode)是一种用于判断用户是否为人类而不是机器的技术。通过验证码,网站和应用程序可以防止垃圾信息提交、恶意攻击、机器人爬虫等问题。本文将介绍如何使用JavaScript实现验证码功能,并提供具体的代码