田渊栋团队新研究:微调<1000步,将LLaMA上下文扩展至32K

在大家不断升级迭代自家大模型的时候,LLM(大语言模型)对上下文窗口的处理能力,也成为一个重要评估指标。

比如 OpenAI 的 gpt-3.5-turbo 提供 16k token 的上下文窗口选项,AnthropicAI 的更是将 Claude 处理 token 能力提升到 100k。大模型处理上下文窗口是个什么概念,就拿 GPT-4 支持 32k token 来说,这相当于 50 页的文字,意味着在对话或生成文本时,GPT-4 最多可以记住 50 页左右内容。

一般来讲,大语言模型处理上下文窗口大小的能力是预定好的。例如,Meta AI 发布的 LLaMA 模型,其输入 token 大小必须少于 2048。

然而,在进行长对话、总结长文档或执行长期计划等应用程序中,经常会超过预先设置的上下文窗口限制,因而,能够处理更长上下文窗口的 LLM 更受欢迎。

但这又面临一个新的问题,从头开始训练具有较长上下文窗口的 LLM 需要很大的投入。这自然引出一个疑问:我们能否扩展现有的预训练 LLM 的上下文窗口?

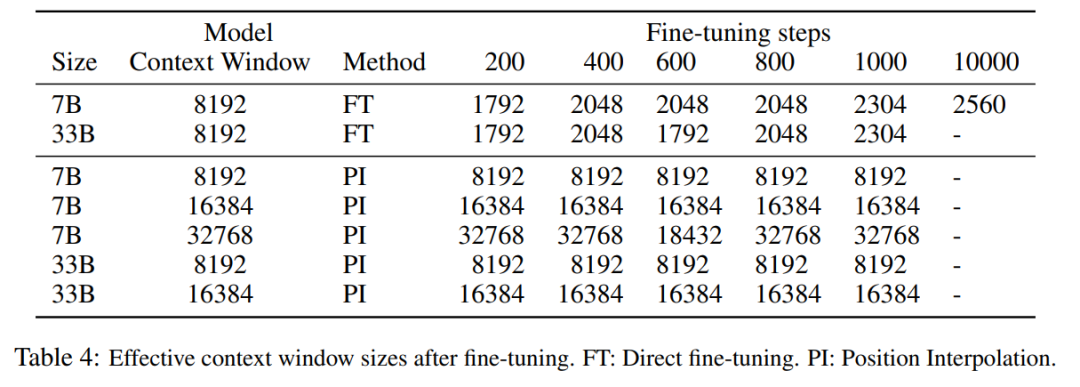

一种直接的方法是对现有的预训练 Transformer 进行微调,以获得更长的上下文窗口。然而,实证结果表明,使用这种方式训练的模型对长上下文窗口的适应速度非常慢。经过 10000 个批次的训练后,有效上下文窗口的增加仍然非常小,仅从 2048 增加到 2560(实验部分的表 4 可以看出)。这表明这种方法在扩展到更长的上下文窗口上效率低下。

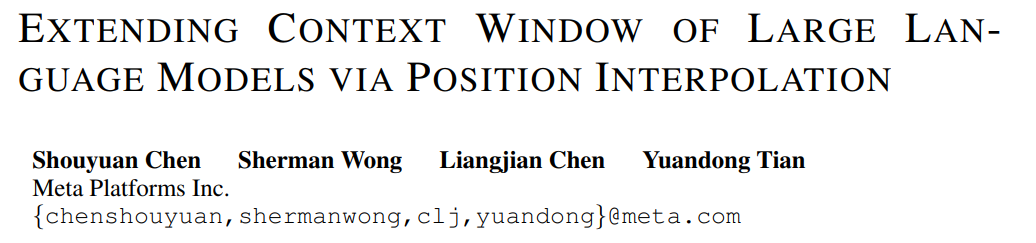

本文中,来自 Meta 的研究者引入了位置插值(Position Interpolation,PI)来对某些现有的预训练 LLM(包括 LLaMA)的上下文窗口进行扩展。结果表明,LLaMA 上下文窗口从 2k 扩展到 32k,只需要小于 1000 步的微调。

图片

图片

论文地址:https://arxiv.org/pdf/2306.15595.pdf

该研究的关键思想不是进行外推(extrapolation),而是直接缩小位置索引,使得最大位置索引与预训练阶段的上下文窗口限制相匹配。换句话说,为了容纳更多的输入 token,该研究在相邻的整数位置上插值位置编码,利用了位置编码可以应用于非整数位置的事实,与在训练过的位置之外进行外推相比,后者可能导致灾难性的数值。

PI 方法将基于 RoPE(旋转位置编码)的预训练 LLM(如 LLaMA)的上下文窗口大小扩展到最多 32768,只需进行最小的微调(在 1000 个步骤内),这一研究在需要长上下文的各种任务上性能较好,包括检索、语言建模以及从 LLaMA 7B 到 65B 的长文档摘要。与此同时,通过 PI 扩展的模型在其原始上下文窗口内相对保持了较好的质量。

方法

在我们比较熟悉的 LLaMA、ChatGLM-6B、PaLM 等大语言模型中,都有 RoPE 身影,该方法由追一科技苏剑林等人提出,RoPE 通过绝对编码的方式实现了相对位置编码。

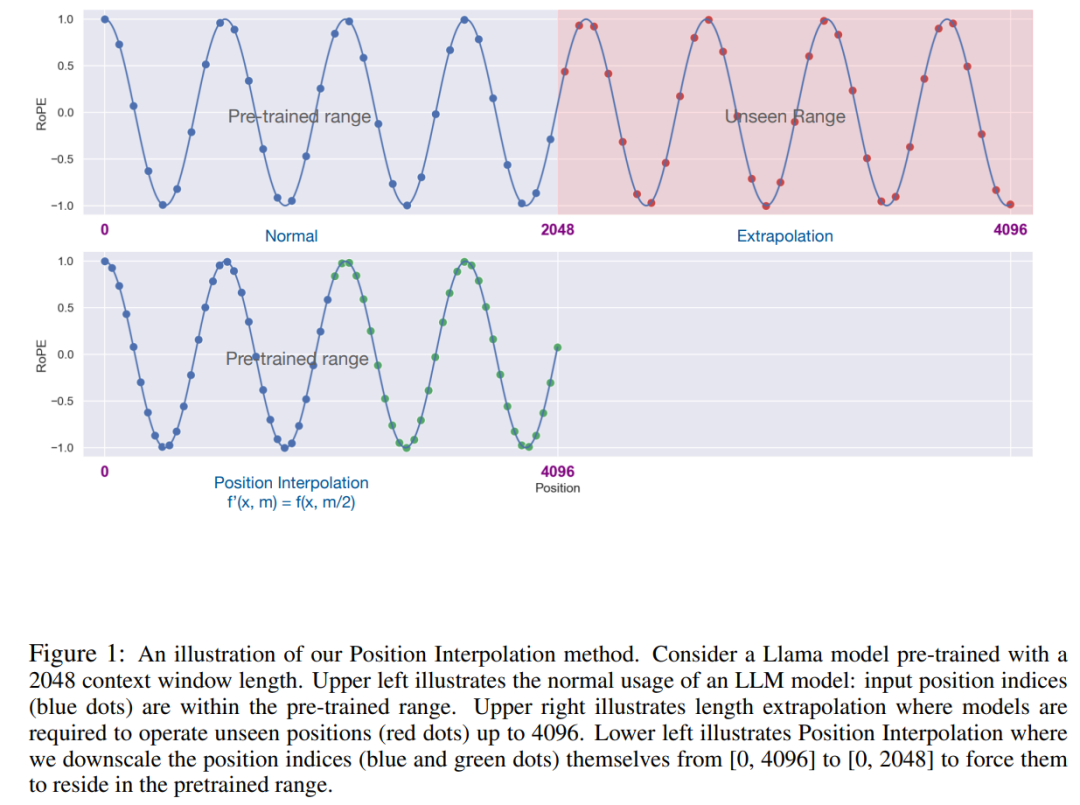

虽然 RoPE 中的注意力得分只取决于相对位置,但它的外推性能并不好。特别是,当直接扩展到更大的上下文窗口时,困惑度可能会飙升到非常高的数字 (即 > 10^3)。

本文采用位置插值的方法,其与外推方法的比较如下。由于基函数 ϕ_j 的平滑性,插值更加稳定,不会导致野值。

图片

图片

该研究将 RoPE f 替换为 f ′,得到如下公式

图片

图片

该研究将在位置编码上的转换称为位置插值。这一步将位置索引从 [0, L′ ) 缩减到 [0, L) ,以匹配计算 RoPE 前的原始索引范围。因此,作为 RoPE 的输入,任意两个 token 之间的最大相对距离已从 L ′ 缩减到 L。通过在扩展前后对位置索引和相对距离的范围进行对齐,减轻了由于上下文窗口扩展而对注意力分数计算产生的影响,这使得模型更容易适应。

值得注意的是,重新缩放位置索引方法不会引入额外的权重,也不会以任何方式修改模型架构。

实验

该研究展示了位置插值可以有效地将上下文窗口扩展到原始大小的 32 倍,并且这种扩展只需进行几百个训练步骤即可完成。

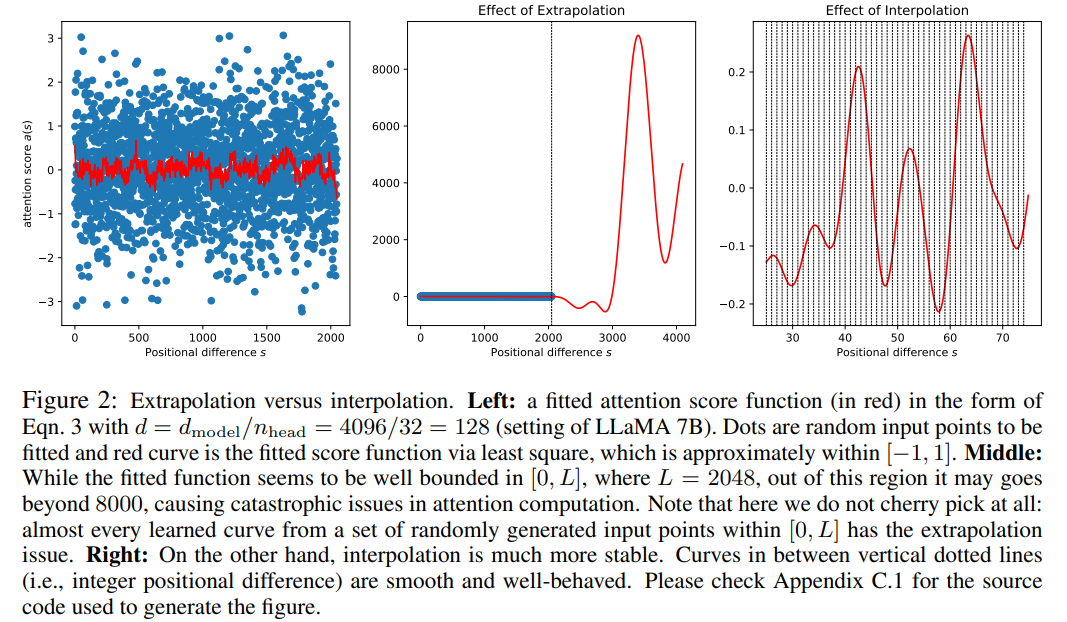

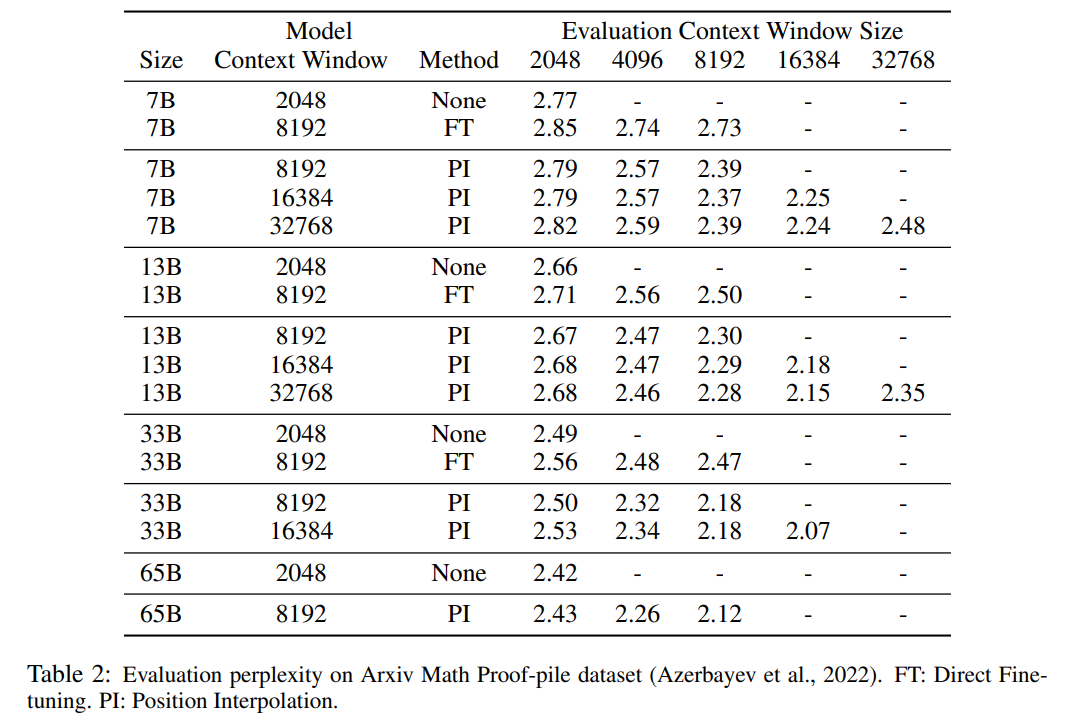

表 1 和表 2 报告了 PI 模型和基线模型在 PG-19 、 Arxiv Math Proof-pile 数据集上的困惑度。结果表明使用 PI 方法扩展的模型在较长的上下文窗口大小下显著改善了困惑度。

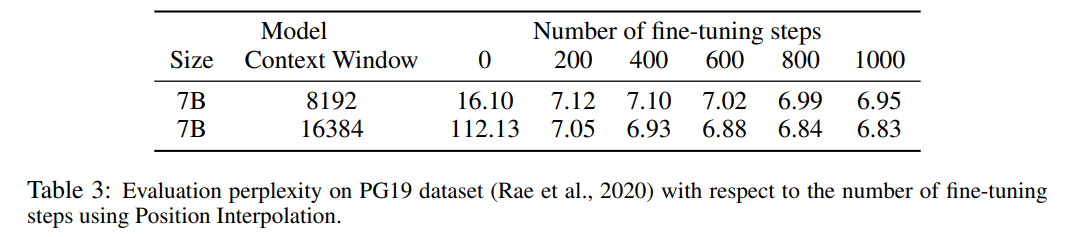

表 3 报告了在 PG19 数据集上使用 PI 方法,将 LLaMA 7B 模型扩展到 8192 和 16384 上下文窗口大小时的困惑度与微调步数之间的关系。

由结果可得,在没有微调的情况下(步数为 0),模型可以展现出一定的语言建模能力,如将上下文窗口扩展到 8192 时的困惑度小于 20(相比之下,直接外推方法的困惑度大于 10^3)。在 200 个步骤时,模型的困惑度超过了 2048 上下文窗口大小下原始模型的困惑度,表明模型能够有效利用比预训练设置更长的序列进行语言建模。在 1000 个步骤时可以看到模型稳步改进,并取得了更好的困惑度。

图片

图片

下表表明,通过 PI 扩展的模型在有效上下文窗口大小方面都成功地实现了扩展目标,即仅通过微调 200 个步骤后,有效上下文窗口大小达到最大值,在 7B 和 33B 模型大小以及最高 32768 上下文窗口的情况下保持一致。相比之下,仅通过直接微调扩展的 LLaMA 模型的有效上下文窗口大小仅从 2048 增加到 2560,即使经过 10000 多个步骤的微调,也没有明显加速窗口大小增加的迹象。

图片

图片

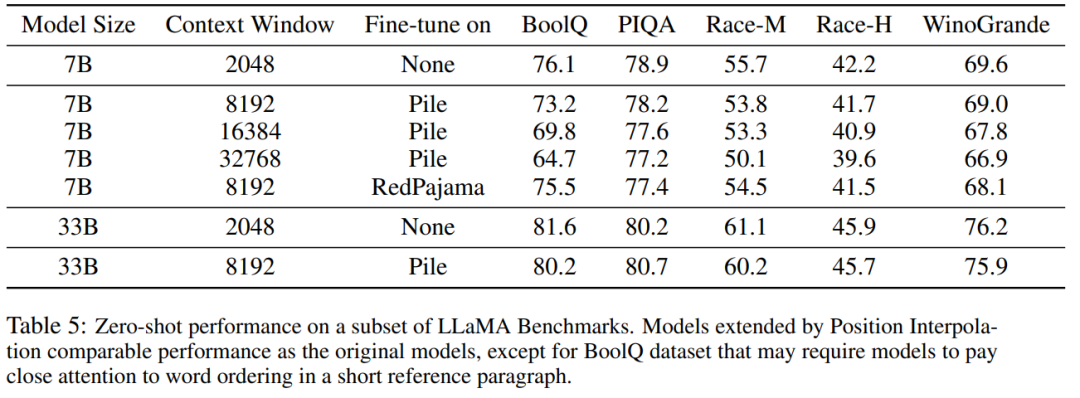

表 5 显示扩展到 8192 的模型在原始基准任务上产生了可比较的结果,而该基准任务是针对更小的上下文窗口设计的,对于 7B 和 33B 模型大小,在基准任务中的退化最多达到 2%。

图片

图片

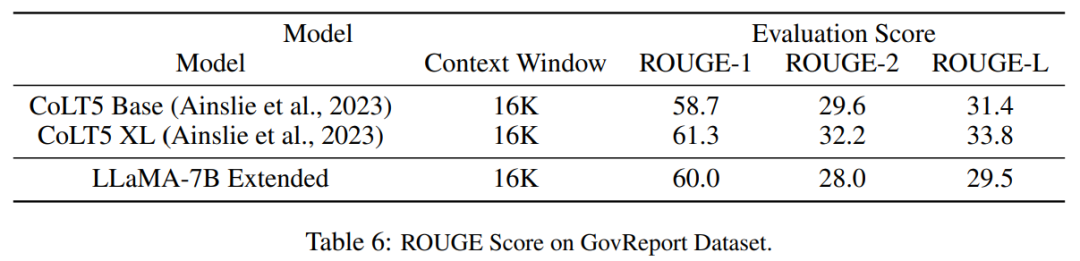

表 6 表明,具有 16384 上下文窗口的 PI 模型,可以有效地处理长文本摘要任务。

图片

图片

以上是田渊栋团队新研究:微调<1000步,将LLaMA上下文扩展至32K的详细内容。更多信息请关注PHP中文网其他相关文章!

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

AI Hentai Generator

免费生成ai无尽的。

热门文章

热工具

记事本++7.3.1

好用且免费的代码编辑器

SublimeText3汉化版

中文版,非常好用

禅工作室 13.0.1

功能强大的PHP集成开发环境

Dreamweaver CS6

视觉化网页开发工具

SublimeText3 Mac版

神级代码编辑软件(SublimeText3)

热门话题

全球最强开源 MoE 模型来了,中文能力比肩 GPT-4,价格仅为 GPT-4-Turbo 的近百分之一

May 07, 2024 pm 04:13 PM

全球最强开源 MoE 模型来了,中文能力比肩 GPT-4,价格仅为 GPT-4-Turbo 的近百分之一

May 07, 2024 pm 04:13 PM

想象一下,一个人工智能模型,不仅拥有超越传统计算的能力,还能以更低的成本实现更高效的性能。这不是科幻,DeepSeek-V2[1],全球最强开源MoE模型来了。DeepSeek-V2是一个强大的专家混合(MoE)语言模型,具有训练经济、推理高效的特点。它由236B个参数组成,其中21B个参数用于激活每个标记。与DeepSeek67B相比,DeepSeek-V2性能更强,同时节省了42.5%的训练成本,减少了93.3%的KV缓存,最大生成吞吐量提高到5.76倍。DeepSeek是一家探索通用人工智

你好,电动Atlas!波士顿动力机器人复活,180度诡异动作吓坏马斯克

Apr 18, 2024 pm 07:58 PM

你好,电动Atlas!波士顿动力机器人复活,180度诡异动作吓坏马斯克

Apr 18, 2024 pm 07:58 PM

波士顿动力Atlas,正式进入电动机器人时代!昨天,液压Atlas刚刚「含泪」退出历史舞台,今天波士顿动力就宣布:电动Atlas上岗。看来,在商用人形机器人领域,波士顿动力是下定决心要和特斯拉硬刚一把了。新视频放出后,短短十几小时内,就已经有一百多万观看。旧人离去,新角色登场,这是历史的必然。毫无疑问,今年是人形机器人的爆发年。网友锐评:机器人的进步,让今年看起来像人类的开幕式动作、自由度远超人类,但这真不是恐怖片?视频一开始,Atlas平静地躺在地上,看起来应该是仰面朝天。接下来,让人惊掉下巴

替代MLP的KAN,被开源项目扩展到卷积了

Jun 01, 2024 pm 10:03 PM

替代MLP的KAN,被开源项目扩展到卷积了

Jun 01, 2024 pm 10:03 PM

本月初,来自MIT等机构的研究者提出了一种非常有潜力的MLP替代方法——KAN。KAN在准确性和可解释性方面表现优于MLP。而且它能以非常少的参数量胜过以更大参数量运行的MLP。比如,作者表示,他们用KAN以更小的网络和更高的自动化程度重现了DeepMind的结果。具体来说,DeepMind的MLP有大约300,000个参数,而KAN只有约200个参数。KAN与MLP一样具有强大的数学基础,MLP基于通用逼近定理,而KAN基于Kolmogorov-Arnold表示定理。如下图所示,KAN在边上具

特斯拉机器人进厂打工,马斯克:手的自由度今年将达到22个!

May 06, 2024 pm 04:13 PM

特斯拉机器人进厂打工,马斯克:手的自由度今年将达到22个!

May 06, 2024 pm 04:13 PM

特斯拉机器人Optimus最新视频出炉,已经可以在厂子里打工了。正常速度下,它分拣电池(特斯拉的4680电池)是这样的:官方还放出了20倍速下的样子——在小小的“工位”上,拣啊拣啊拣:这次放出的视频亮点之一在于Optimus在厂子里完成这项工作,是完全自主的,全程没有人为的干预。并且在Optimus的视角之下,它还可以把放歪了的电池重新捡起来放置,主打一个自动纠错:对于Optimus的手,英伟达科学家JimFan给出了高度的评价:Optimus的手是全球五指机器人里最灵巧的之一。它的手不仅有触觉

FisheyeDetNet:首个基于鱼眼相机的目标检测算法

Apr 26, 2024 am 11:37 AM

FisheyeDetNet:首个基于鱼眼相机的目标检测算法

Apr 26, 2024 am 11:37 AM

目标检测在自动驾驶系统当中是一个比较成熟的问题,其中行人检测是最早得以部署算法之一。在多数论文当中已经进行了非常全面的研究。然而,利用鱼眼相机进行环视的距离感知相对来说研究较少。由于径向畸变大,标准的边界框表示在鱼眼相机当中很难实施。为了缓解上述描述,我们探索了扩展边界框、椭圆、通用多边形设计为极坐标/角度表示,并定义一个实例分割mIOU度量来分析这些表示。所提出的具有多边形形状的模型fisheyeDetNet优于其他模型,并同时在用于自动驾驶的Valeo鱼眼相机数据集上实现了49.5%的mAP

新款经济实惠的 Meta Quest 3S VR 耳机出现在 FCC 上,暗示即将推出

Sep 04, 2024 am 06:51 AM

新款经济实惠的 Meta Quest 3S VR 耳机出现在 FCC 上,暗示即将推出

Sep 04, 2024 am 06:51 AM

Meta Connect 2024 活动定于 9 月 25 日至 26 日举行,在本次活动中,该公司预计将推出一款价格实惠的新型虚拟现实耳机。据传这款 VR 耳机是 Meta Quest 3S,它似乎已经出现在 FCC 清单上。这个建议

牛津大学最新!Mickey:3D中的2D图像匹配SOTA!(CVPR\'24)

Apr 23, 2024 pm 01:20 PM

牛津大学最新!Mickey:3D中的2D图像匹配SOTA!(CVPR\'24)

Apr 23, 2024 pm 01:20 PM

写在前面项目链接:https://nianticlabs.github.io/mickey/给定两张图片,可以通过建立图片之间的对应关系来估计它们之间的相机姿态。通常,这些对应关系是二维到二维的,而我们估计的姿态在尺度上是不确定的。一些应用,例如随时随地实现即时增强现实,需要尺度度量的姿态估计,因此它们依赖于外部的深度估计器来恢复尺度。本文提出了MicKey,这是一个关键点匹配流程,能够够预测三维相机空间中的度量对应关系。通过学习跨图像的三维坐标匹配,我们能够在没有深度测试的情况下推断出度量相对

单卡跑Llama 70B快过双卡,微软硬生生把FP6搞到了A100里 | 开源

Apr 29, 2024 pm 04:55 PM

单卡跑Llama 70B快过双卡,微软硬生生把FP6搞到了A100里 | 开源

Apr 29, 2024 pm 04:55 PM

FP8和更低的浮点数量化精度,不再是H100的“专利”了!老黄想让大家用INT8/INT4,微软DeepSpeed团队在没有英伟达官方支持的条件下,硬生生在A100上跑起FP6。测试结果表明,新方法TC-FPx在A100上的FP6量化,速度接近甚至偶尔超过INT4,而且拥有比后者更高的精度。在此基础之上,还有端到端的大模型支持,目前已经开源并集成到了DeepSpeed等深度学习推理框架中。这一成果对大模型的加速效果也是立竿见影——在这种框架下用单卡跑Llama,吞吐量比双卡还要高2.65倍。一名