配置Linux系统以支持大数据处理和分析

配置Linux系统以支持大数据处理和分析

摘要:随着大数据时代的到来,对于大数据的处理和分析需求越来越大。本文将介绍如何在Linux系统上进行配置,以支持大数据处理和分析的应用程序和工具,并提供相应的代码示例。

关键词:Linux系统,大数据,处理,分析,配置,代码示例

引言:大数据作为一种新兴的数据管理和分析技术,已经广泛应用于各个领域。为了保证大数据处理和分析的效率和可靠性,正确地配置Linux系统是非常关键的。

一、安装Linux系统

首先,我们需要正确地安装一个Linux系统。常见的Linux发行版有Ubuntu、Fedora等,可以根据自己的需求选择适合的Linux发行版。在安装过程中,建议选择服务器版本,以便在系统安装完成后进行更详细的配置。

二、更新系统和安装必要的软件

完成系统安装后,需要更新系统并安装一些必要的软件。首先,在终端中运行以下命令更新系统:

sudo apt update sudo apt upgrade

接着,安装OpenJDK(Java Development Kit),因为大部分大数据处理和分析的应用程序都是基于Java开发的:

sudo apt install openjdk-8-jdk

安装完毕后,可以通过运行以下命令验证Java是否安装成功:

java -version

如果输出了Java的版本信息,则说明安装成功。

三、配置Hadoop

Hadoop是一个开源的大数据处理框架,可以处理超大规模的数据集。下面是配置Hadoop的步骤:

下载Hadoop并解压缩:

wget https://www.apache.org/dist/hadoop/common/hadoop-3.3.0.tar.gz tar -xzvf hadoop-3.3.0.tar.gz

登录后复制配置环境变量:

将下面的内容添加到~/.bashrc文件中:export HADOOP_HOME=/path/to/hadoop-3.3.0 export PATH=$PATH:$HADOOP_HOME/bin

登录后复制保存文件后,运行以下命令使配置生效:

source ~/.bashrc

登录后复制登录后复制配置Hadoop的核心文件:

进入Hadoop的解压目录,编辑etc/hadoop/core-site.xml文件,添加以下内容:<configuration> <property> <name>fs.defaultFS</name> <value>hdfs://localhost:9000</value> </property> </configuration>

登录后复制接着,编辑

etc/hadoop/hdfs-site.xml文件,添加以下内容:<configuration> <property> <name>dfs.replication</name> <value>1</value> </property> </configuration>

登录后复制保存文件后,执行以下命令格式化Hadoop的文件系统:

hdfs namenode -format

登录后复制最后,启动Hadoop:

start-dfs.sh

登录后复制四、配置Spark

Spark是一个快速、通用的大数据处理和分析引擎,可以与Hadoop一起使用。下面是配置Spark的步骤:下载Spark并解压缩:

wget https://www.apache.org/dist/spark/spark-3.1.2/spark-3.1.2-bin-hadoop3.2.tgz tar -xzvf spark-3.1.2-bin-hadoop3.2.tgz

登录后复制配置环境变量:

将下面的内容添加到~/.bashrc文件中:export SPARK_HOME=/path/to/spark-3.1.2-bin-hadoop3.2 export PATH=$PATH:$SPARK_HOME/bin

登录后复制保存文件后,运行以下命令使配置生效:

source ~/.bashrc

登录后复制登录后复制配置Spark的核心文件:

进入Spark的解压目录,将conf/spark-env.sh.template文件复制一份并重命名为conf/spark-env.sh。编辑conf/spark-env.sh文件,添加以下内容:export JAVA_HOME=/path/to/jdk1.8.0_* export HADOOP_HOME=/path/to/hadoop-3.3.0 export SPARK_MASTER_HOST=localhost export SPARK_MASTER_PORT=7077 export SPARK_WORKER_CORES=4 export SPARK_WORKER_MEMORY=4g

登录后复制其中,

JAVA_HOME需要设置为Java的安装路径,HADOOP_HOME需要设置为Hadoop的安装路径,SPARK_MASTER_HOST设置为当前机器的IP地址。

保存文件后,启动Spark:

start-master.sh

运行以下命令查看Spark的Master地址:

cat $SPARK_HOME/logs/spark-$USER-org.apache.spark.deploy.master*.out | grep 'Starting Spark master'

启动Spark Worker:

start-worker.sh spark://<master-ip>:<master-port>

其中,<master-ip>为Spark的Master地址中的IP地址,<master-port>为Spark的Master地址中的端口号。

总结:本文介绍了如何配置Linux系统以支持大数据处理和分析的应用程序和工具,包括Hadoop和Spark。通过正确地配置Linux系统,可以提升大数据处理和分析的效率和可靠性。读者可以根据本文的指引和示例代码,进行Linux系统的配置与应用的实践。

以上是配置Linux系统以支持大数据处理和分析的详细内容。更多信息请关注PHP中文网其他相关文章!

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

AI Hentai Generator

免费生成ai无尽的。

热门文章

热工具

记事本++7.3.1

好用且免费的代码编辑器

SublimeText3汉化版

中文版,非常好用

禅工作室 13.0.1

功能强大的PHP集成开发环境

Dreamweaver CS6

视觉化网页开发工具

SublimeText3 Mac版

神级代码编辑软件(SublimeText3)

热门话题

使用pandas读取CSV文件并进行数据分析

Jan 09, 2024 am 09:26 AM

使用pandas读取CSV文件并进行数据分析

Jan 09, 2024 am 09:26 AM

Pandas是一个强大的数据分析工具,可以方便地读取和处理各种类型的数据文件。其中,CSV文件是最常见和常用的数据文件格式之一。本文将介绍如何使用Pandas读取CSV文件并进行数据分析,同时提供具体的代码示例。一、导入必要的库首先,我们需要导入Pandas库和其他可能需要的相关库,如下所示:importpandasaspd二、读取CSV文件使用Pan

数据分析方法介绍

Jan 08, 2024 am 10:22 AM

数据分析方法介绍

Jan 08, 2024 am 10:22 AM

常见的数据分析方法:1、对比分析法;2、结构分析法;3、交叉分析法;4、趋势分析法;5、因果分析法;6、关联分析法;7、聚类分析法;8、主成分分析法;9、散点分析法;10、矩阵分析法。详细介绍:1、对比分析法:将两个或两个以上的数据进行对比分析,找出其中的差异和规律;2、结构分析法:对总体内各部分与总体之间进行对比分析的方法;3、交叉分析法等等。

C++技术中的大数据处理:如何使用图形数据库存储和查询大规模图数据?

Jun 03, 2024 pm 12:47 PM

C++技术中的大数据处理:如何使用图形数据库存储和查询大规模图数据?

Jun 03, 2024 pm 12:47 PM

C++技术可通过利用图形数据库处理大规模图数据。具体步骤包括:创建TinkerGraph实例,添加顶点和边,制定查询,获取结果值,并将结果转换为列表。

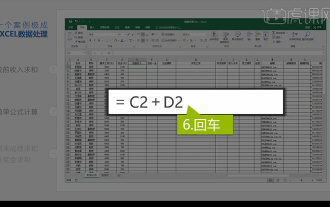

集成Excel数据分析

Mar 21, 2024 am 08:21 AM

集成Excel数据分析

Mar 21, 2024 am 08:21 AM

1.本节课我们进行讲解集成Excel数据分析,我们通过一个案例进行完成,打开课程素材单击E2单元格进行输入公式。2.我们再进行选中到单元格E53,就可以将下面的数据都计算出来。3.然后我们点击F2单元格,然后我们输入公式就可以计算出,同样向下拖拽都可以计算出我们要的数值。4.我们选中G2单元格点击数据选项卡点击数据验证,进行选择然后确定。5.我们再使用相同方式进行下拉自动填充到下面需要计算的单元格。6.接下来我们计算实发工资,选中H2单元格进行输入公式。7.然后我们点击数值下拉菜单进行点击其他数

C++技术中的大数据处理:如何采用流处理技术处理大数据流?

Jun 01, 2024 pm 10:34 PM

C++技术中的大数据处理:如何采用流处理技术处理大数据流?

Jun 01, 2024 pm 10:34 PM

流处理技术用于大数据处理流处理是一种即时处理数据流的技术。在C++中,ApacheKafka可用于流处理。流处理提供实时数据处理、可伸缩性和容错性。本例使用ApacheKafka从Kafka主题读取数据并计算平均值。

数据分析网站有哪些推荐

Mar 13, 2024 pm 05:44 PM

数据分析网站有哪些推荐

Mar 13, 2024 pm 05:44 PM

推荐:1、商业数据分析论坛;2、人大经济论坛-计量经济学与统计区;3、中国统计论坛;4、数据挖掘学习交流论坛;5、数据分析论坛;6、网站数据分析;7、数据分析;8、数据挖掘研究院;9、S-PLUS、R统计论坛。

学习如何使用numpy库进行数据分析和科学计算

Jan 19, 2024 am 08:05 AM

学习如何使用numpy库进行数据分析和科学计算

Jan 19, 2024 am 08:05 AM

随着信息时代的到来,数据分析和科学计算成为了越来越多领域的重要组成部分。在这个过程中,使用计算机进行数据处理和分析已经成为必不可少的工具。而在Python中,numpy库就是一个非常重要的工具,它可以让我们更加高效地进行数据处理和分析,更加快速地得出结果。本文将介绍numpy的常用功能和使用方法,并给出一些具体的代码示例,帮助大家深入学习。numpy库的安装

C++技术中的大数据处理:如何实现高效的文本挖掘和大数据分析?

Jun 02, 2024 am 10:39 AM

C++技术中的大数据处理:如何实现高效的文本挖掘和大数据分析?

Jun 02, 2024 am 10:39 AM

C++在文本挖掘和数据分析中发挥着至关重要的作用,提供高效的文本挖掘引擎和复杂分析任务的处理能力。文本挖掘方面:C++能够构建文本挖掘引擎,从文本数据中提取信息;大数据分析方面:C++适用于处理庞大数据集的复杂分析任务,可计算平均值和标准差等统计量。实战案例:一家零售公司使用C++开发的文本挖掘引擎分析客户评论,发现了产品质量、客户服务和送货时间等方面的见解。