视频会议系统首次商用化于50多年前,它使人们能够与千里之外的同事、朋友或家人进行视听交流。视频会议的最终目标是实现远程参与者之间的沉浸式通信,仿佛大家身处同一地点

现有的3D视频会议系统虽然展示了捕捉眼神交流和其他非语言线索的潜力,但却需要昂贵的3D采集设备

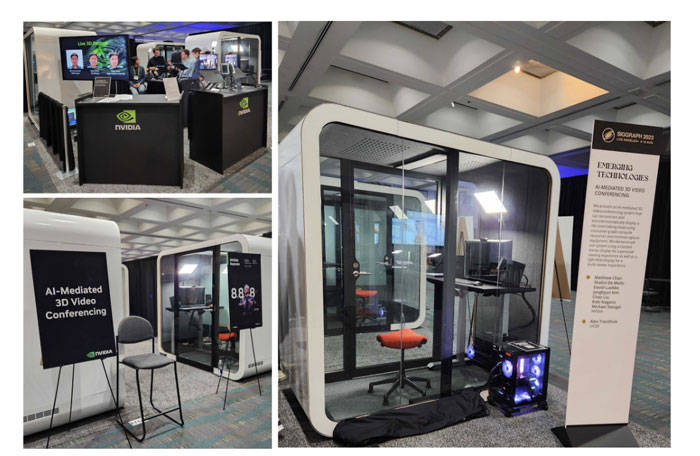

在名为“AI-Mediated 3D Video Conferencing”的项目中,英伟达、美国加利福尼亚大学圣迭戈分校和北卡罗来纳大学教堂山分校的团队通过AI人工智能技术成功开发了一种高保真度、低成本的3D远程呈现方法,并且提供了以3D扫描为基础无法实现的新功能

此外,团队的解决方案兼容多种现有的3D显示器,包括立体显示器和光场显示器

延伸阅读:利用AI缩小体积,谷歌展示光场通话项目Project Starline新迭代

值得注意的是,谷歌正在利用人工智能来改进他们的光场通话项目Project Starline。简单来说,Project Starline是一个3D视频聊天室,利用光场技术创造出一种仿佛对方真的坐在你对面的感觉。这一创新性的远程通信工具结合了谷歌在硬件和软件方面的进步,旨在提升朋友、家人和同事在远程交流时的身临其境感

英伟达团队回到了他们的“AI-Mediated 3D Video Conferencing”项目,并在SIGGRAPH大会上展示了该设置,并撰写了相关介绍

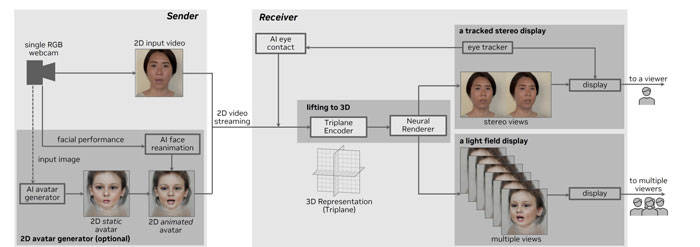

图示系统包括一个sender,用于记录和传输来自单个RGB网络摄像头的2D视频;以及一个receiver,用于接收并将2D视频转换为3D,并呈现出新颖的3D视图

通过使用one-shot方法,研究人员可以实时地从单一的unposed图像中推断和渲染出真实的3D表示,并在NVIDIA RTX A5000笔记本电脑上生成光场图像。使用instant AI super-resolution技术,参与者可以立即看到他们的3D自我影像。在实时情况下,参与者可以观察到2D网络摄像头图像被提升为具有头部追踪功能的立体3D视图

用户可以选择使用2D Avatar生成器模块来生成和自定义由用户驱动的2D Avatar,除了使用网络摄像头图片

研究人员提出了一种基于Vision Transformer的新编码器,用于将2D输入转换为有效的三平面隐式3D表示,从而在3D提升方面取得了重要进展。通过给定用户的单个RGB图像,该方法能够自动创建用户的正面3D表示,并通过体三维绘制从新视点进行高效的渲染

这个句子的重写如下:三平面编码器完全依赖于经过预训练的EG3D生成的合成数据进行训练,而3D提升模块使用生成的先验来确保生成的视图在多视图一致性和照片真实感方面,并且能够在没有个人特定训练的情况下以one shot方式适用于任何人

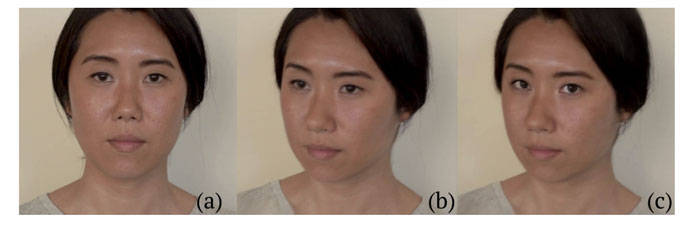

团队使用最先进的神经方法,通过合成给定用户图片的重定向眼睛注视,将2D图像经过注视校正提升为3D图像,实现了眼神交流,如图所示

系统支持多种现成的3D显示器,包括单人立体显示器和多人光场显示器

这张图展示了使用来自Dimenco的32英寸3D立体显示器的情况。它利用眼动追踪和透镜技术来呈现立体图像,准确显示用户眼睛的位置。其中a提供了一个概览,而b和c展示了系统能够以正确的视角记录参与者的立体图像。同时,d和e说明了通过给定单一的RGB图像,该方法可以生成逼真的远程呈现效果

此外,研究人员使用一台32英寸的Looking Glass显示器来评估AI系统。该显示器能够同时展示真实大小的说话人头,让多人能够清晰地观看。这种光场显示器为普通观众和等待演示的人员提供了清晰的技术展示

接下来,轮候排队的人员可以尝试不同展位的立体显示器,并体验多路人工智能引导的3D视频会议电话

延伸阅读:AI-Mediated 3D Video Conferencing

延伸阅读:Live 3D Portrait: Real-Time Radiance Fields for Single-Image Portrait View Synthesis

值得注意的是,团队通过使用NVIDIA TensorRT对编码器进行了优化,使其能够在NVIDIA A6000 Ada Generation GPU上进行实时推理。整个系统的运行时间不到100毫秒,包括捕获、流式传输和渲染

以上是英伟达为远程会议通话研发AI 3D视频聊天解决方案的详细内容。更多信息请关注PHP中文网其他相关文章!