使用Python进行回归分析和最佳拟合直线

在本教程中,我们将使用 Python 编程实现回归分析和最佳拟合线

简介

回归分析是预测分析的最基本形式。

在统计学中,线性回归是一种对标量值与一个或多个解释变量之间的关系进行建模的方法。

在机器学习中,线性回归是一种监督算法。这种算法根据自变量预测目标值。

有关线性回归和回归分析的更多信息

在线性回归/分析中,目标是真实的或连续的值,例如工资、BMI等。它通常用于预测因变量和一堆自变量之间的关系。这些模型通常拟合线性方程,但是,还有其他类型的回归,包括高阶多项式。

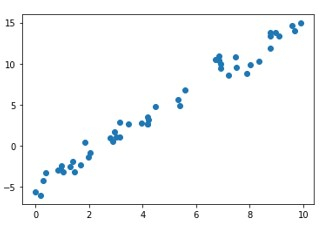

在对数据进行线性模型拟合之前,有必要检查数据点之间是否存在线性关系。这从他们的散点图中可以明显看出。算法/模型的目标是找到最佳拟合线。

在本文中,我们将探讨线性回归分析及其使用 C++ 的实现。

线性回归方程的形式为 Y = c + mx ,其中 Y 是目标变量,X 是自变量或解释参数/变量。 m 是回归线的斜率,c 是截距。由于这是一个二维回归任务,因此模型会在训练期间尝试找到最佳拟合线。不必所有点都精确地排在同一条线上。有些数据点可能位于线上,有些则分散在线上。直线和数据点之间的垂直距离是残差。根据该点是位于该线的下方还是上方,该值可以为负值,也可以为正值。残差是直线与数据拟合程度的度量。该算法是连续的,以最小化总残差。

每个观测值的残差是 y(因变量)的预测值与 y 的观测值之间的差

$$mathrm{残差: =: 实际: y: 值:−:预测: y: 值}$$

$$mathrm{ri:=:yi:−:y'i}$$

评估线性回归模型性能的最常见指标称为均方根误差或 RMSE。基本思想是衡量模型的预测与实际观测值相比有多糟糕/错误。

因此,高 RMSE 是“坏”,低 RMSE 是“好”

RMSE 误差为

$$mathrm{RMSE:=:sqrt{frac{sum_i^n=1:(这个:-:这个')^2}{n}}}$$ p>

RMSE 是所有残差平方均值的根。

使用Python实现

示例

# Import the libraries

import numpy as np

import math

import matplotlib.pyplot as plt

from sklearn.linear_model import LinearRegression

from sklearn.metrics import mean_squared_error

# Generate random data with numpy, and plot it with matplotlib:

ranstate = np.random.RandomState(1)

x = 10 * ranstate.rand(100)

y = 2 * x - 5 + ranstate.randn(100)

plt.scatter(x, y);

plt.show()

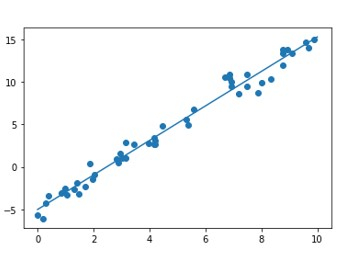

# Creating a linear regression model based on the positioning of the data and Intercepting, and predicting a Best Fit:

lr_model = LinearRegression(fit_intercept=True)

lr_model.fit(x[:70, np.newaxis], y[:70])

y_fit = lr_model.predict(x[70:, np.newaxis])

mse = mean_squared_error(y[70:], y_fit)

rmse = math.sqrt(mse)

print("Mean Square Error : ",mse)

print("Root Mean Square Error : ",rmse)

# Plot the estimated linear regression line using matplotlib:

plt.scatter(x, y)

plt.plot(x[70:], y_fit);

plt.show()

输出

Mean Square Error : 1.0859922470998231 Root Mean Square Error : 1.0421095178050257

结论

回归分析是一种非常简单但功能强大的技术,用于机器学习和统计中的预测分析。这个想法在于其简单性以及独立变量和目标变量之间的潜在线性关系。

以上是使用Python进行回归分析和最佳拟合直线的详细内容。更多信息请关注PHP中文网其他相关文章!

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

AI Hentai Generator

免费生成ai无尽的。

热门文章

热工具

记事本++7.3.1

好用且免费的代码编辑器

SublimeText3汉化版

中文版,非常好用

禅工作室 13.0.1

功能强大的PHP集成开发环境

Dreamweaver CS6

视觉化网页开发工具

SublimeText3 Mac版

神级代码编辑软件(SublimeText3)

热门话题

Python中的残差分析技巧

Jun 10, 2023 am 08:52 AM

Python中的残差分析技巧

Jun 10, 2023 am 08:52 AM

Python是一种广泛使用的编程语言,其强大的数据分析和可视化功能使其成为数据科学家和机器学习工程师的首选工具之一。在这些应用中,残差分析是一种常见的技术,用于评估模型的准确性和识别任何模型偏差。在本文中,我们将介绍Python中使用残差分析技巧的几种方法。理解残差在介绍Python中的残差分析技巧之前,让我们先了解什么是残差。在统计学中,残差是实际观测值与

AssertionError:如何解决Python断言错误?

Jun 25, 2023 pm 11:07 PM

AssertionError:如何解决Python断言错误?

Jun 25, 2023 pm 11:07 PM

Python中的断言(assert)是程序员用于调试代码的一种有用工具。它用于验证程序的内部状态是否满足预期,并在这些条件为假时引发一个断言错误(AssertionError)。在开发过程中,测试和调试阶段都使用断言来检查代码的状态和预期结果是否相符。本文将讨论AssertionError的原因、解决方法以及如何在代码中正确使用断言。断言错误的原因断言错误通

Python中的分层抽样技巧

Jun 10, 2023 pm 10:40 PM

Python中的分层抽样技巧

Jun 10, 2023 pm 10:40 PM

Python中的分层抽样技巧抽样是统计学中常用的一种数据采集方法,它可以从数据集中选择一部分样本进行分析,以此推断出整个数据集的特征。在大数据时代,数据量巨大,使用全样本进行分析既耗费时间又不够经济实际。因此,选择合适的抽样方法可以提高数据分析效率。本文主要介绍Python中的分层抽样技巧。什么是分层抽样?在抽样中,分层抽样(stratifiedsampl

Python开发漏洞扫描器的方法

Jul 01, 2023 am 08:10 AM

Python开发漏洞扫描器的方法

Jul 01, 2023 am 08:10 AM

如何通过Python开发漏洞扫描器概述在当今互联网安全威胁增加的环境下,漏洞扫描器成为了保护网络安全的重要工具。Python是一种流行的编程语言,简洁易读且功能强大,适合开发各种实用工具。本文将介绍如何使用Python开发漏洞扫描器,为您的网络提供实时保护。步骤一:确定扫描目标在开发漏洞扫描器之前,您需要确定要扫描的目标。这可以是您自己的网络或任何您有权限测

如何使用Python在Linux中进行脚本编写和执行

Oct 05, 2023 am 11:45 AM

如何使用Python在Linux中进行脚本编写和执行

Oct 05, 2023 am 11:45 AM

如何使用Python在Linux中进行脚本编写和执行在Linux操作系统中,我们可以使用Python编写并执行各种脚本。Python是一种简洁而强大的编程语言,它提供了丰富的库和工具,使得脚本编写变得更加简单和高效。下面我们将介绍在Linux中如何使用Python进行脚本编写和执行的基本步骤,同时提供一些具体的代码示例来帮助你更好地理解和运用。安装Pytho

Python中sqrt()函数用法

Feb 21, 2024 pm 03:09 PM

Python中sqrt()函数用法

Feb 21, 2024 pm 03:09 PM

Python中sqrt()函数用法及代码示例一、sqrt()函数的功能及介绍在Python编程中,sqrt()函数是math模块中的一个函数,其功能是计算一个数的平方根。平方根是指一个数与自己相乘等于这个数的平方,即x*x=n,那么x就是n的平方根。程序中可以使用sqrt()函数来实现对平方根的计算。二、sqrt()函数的使用方法在Python中,sq

教你使用Python编程实现百度图像识别接口的对接,实现图像识别功能

Aug 25, 2023 pm 03:10 PM

教你使用Python编程实现百度图像识别接口的对接,实现图像识别功能

Aug 25, 2023 pm 03:10 PM

教你使用Python编程实现百度图像识别接口的对接,实现图像识别功能在计算机视觉的领域中,图像识别技术是非常重要的一项技术。而百度提供了一套强大的图像识别接口,通过该接口,我们可以方便地实现图像的分类、标签、人脸识别等功能。本篇文章将教你使用Python编程语言,通过对接百度图像识别接口,实现图像识别的功能。首先,我们需要在百度开发者平台上创建一个应用,并获

Python编程实战:利用百度地图API生成静态地图功能的方法

Jul 30, 2023 pm 09:05 PM

Python编程实战:利用百度地图API生成静态地图功能的方法

Jul 30, 2023 pm 09:05 PM

Python编程实战:利用百度地图API生成静态地图功能的方法导语:在现代社会中,地图已经成为人们生活中不可缺少的一部分。在使用地图时,我们常常需要获取特定区域的静态地图,以便在网页、移动应用或报告中进行展示。本文将介绍如何利用Python编程语言和百度地图API来生成静态地图,并提供相关的代码示例。一、准备工作要实现利用百度地图API生成静态地图的功能,我