百川智能发布Baichuan2大模型:全面领先Llama2,训练切片也开源了

在业界都惊讶于百川智能平均 28 天发布一款大模型的时候,这家公司并没有停下脚步。

9 月 6 日下午的发布会上,百川智能宣布正式开源微调后的 Baichuan-2 大模型。

中国科学院院士、清华大学人工智能研究院名誉院长张钹在发布会上。

中国科学院院士、清华大学人工智能研究院名誉院长张钹在发布会上。

这是百川自 8 月发布 Baichuan-53B 大模型后的又一次新发布。本次开源的模型包括 Baichuan2-7B、Baichuan2-13B、Baichuan2-13B-Chat 与其 4bit 量化版本,并且均为免费可商用。

除了模型的全面公开之外,百川智能此次还开源了模型训练的 Check Point,并公开了 Baichuan 2 技术报告,详细介绍了新模型的训练细节。百川智能创始人兼 CEO 王小川表示,希望此举能够帮助大模型学术机构、开发者和企业用户深入了解大模型的训练过程,更好地推动大模型学术研究和社区的技术发展。

Baichuan 2 大模型开原链接:https://github.com/baichuan-inc/Baichuan2

技术报告:https://cdn.baichuan-ai.com/paper/Baichuan2-technical-report.pdf

今天开源的模型相对于大模型而言体量「较小」,其中 Baichuan2-7B-Base 和 Baichuan2-13B-Base 均基于 2.6 万亿高质量多语言数据进行训练,在保留了上一代开源模型良好的生成与创作能力,流畅的多轮对话能力以及部署门槛较低等众多特性的基础上,两个模型在数学、代码、安全、逻辑推理、语义理解等能力有显著提升。

「简单来说,Baichuan7B 70 亿参数模型在英文基准上已经能够与 LLaMA2 的 130 亿参数模型能力持平。因此,我们可以做到以小博大,小模型相当于大模型的能力,而在同体量上的模型可以得到更高的性能,全面超越了 LLaMA2 的性能,」王小川介绍道。

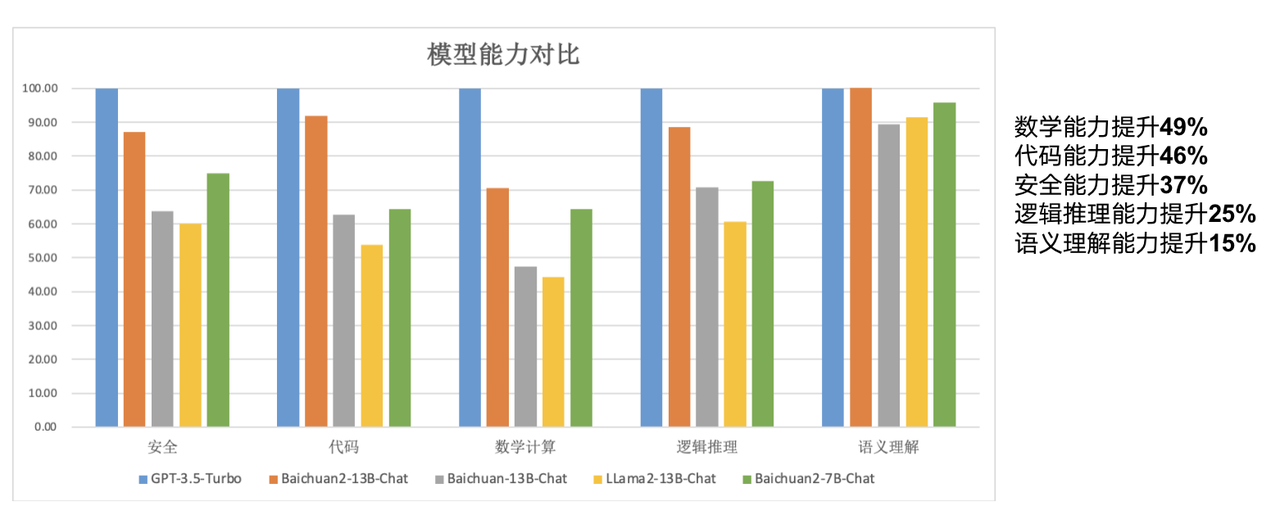

其中 Baichuan2-13B-Base 相比上一代 13B 模型,数学能力提升 49%,代码能力提升 46%,安全能力提升 37%,逻辑推理能力提升 25%,语义理解能力提升 15%。

据介绍,在新的模型上,百川智能的研究者们从数据获取到微调进行了很多优化。

「我们借鉴了之前做搜索时的更多经验,对大量模型训练数据进行了多粒度内容质量打分,使用了 2.6 亿 T 的语料级来训练 7B 与 13B 的模型,并且加入了多语言的支持,」王小川表示。「我们在千卡 A800 集群里可以达到 180TFLOPS 的训练性能,机器利用率超过 50%。在此之外,我们也完成了很多安全对齐的工作。」

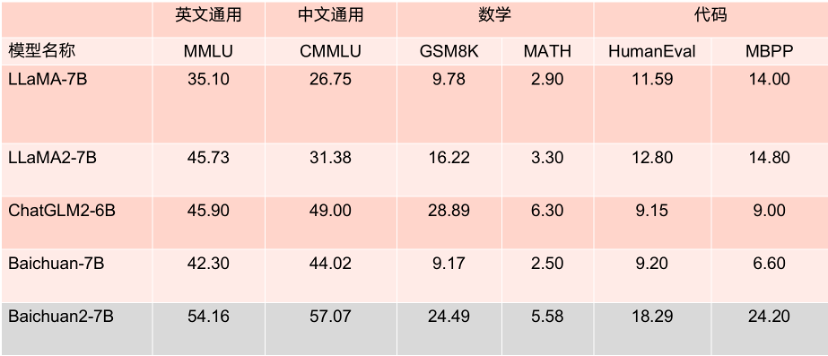

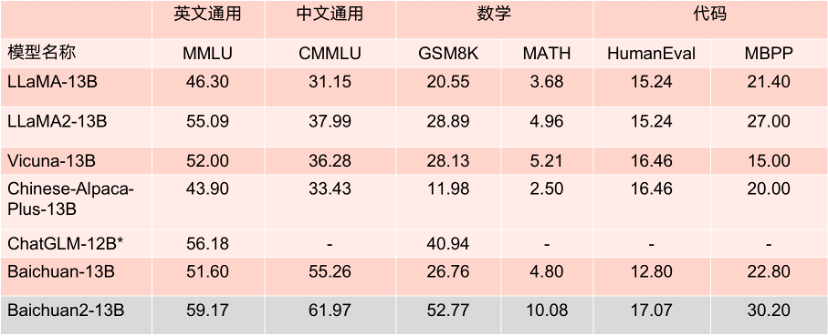

本次开源的两个模型在各大评测榜单上的表现优秀,在 MMLU、CMMLU、GSM8K 等几大权威评估基准中,以较大优势领先 LLaMA2,相比其他同等参数量大模型,表现也十分亮眼,性能大幅度优于 LLaMA2 等同尺寸模型竞品。

更值得一提的是,根据 MMLU 等多个权威英文评估基准评分 Baichuan2-7B 以 70 亿的参数在英文主流任务上与 130 亿参数量的 LLaMA2 持平。

7B 参数模型的 Benchmark 成绩。

13B 参数模型的 Benchmark 成绩。

Baichuan2-7B 和 Baichuan2-13B 不仅对学术研究完全开放,开发者也仅需邮件申请获得官方商用许可后,即可以免费商用。

「除了模型发布以外,我们也希望对学术领域做更多的支持,」王小川表示。「除了技术报告以外,我们也把 Baichuan2 大模型训练过程中的权重参数模型进行了开放。这对于大家理解预训练,或者进行微调强化能够带来帮助。这也是在国内首次有公司能开放这样的训练过程。」

大模型训练包含海量高质量数据获取、大规模训练集群稳定训练、模型算法调优等多个环节。每个环节都需要大量人才、算力等资源的投入,从零到一完整训练一个模型的高昂成本,阻碍了学术界对大模型训练的深入研究。

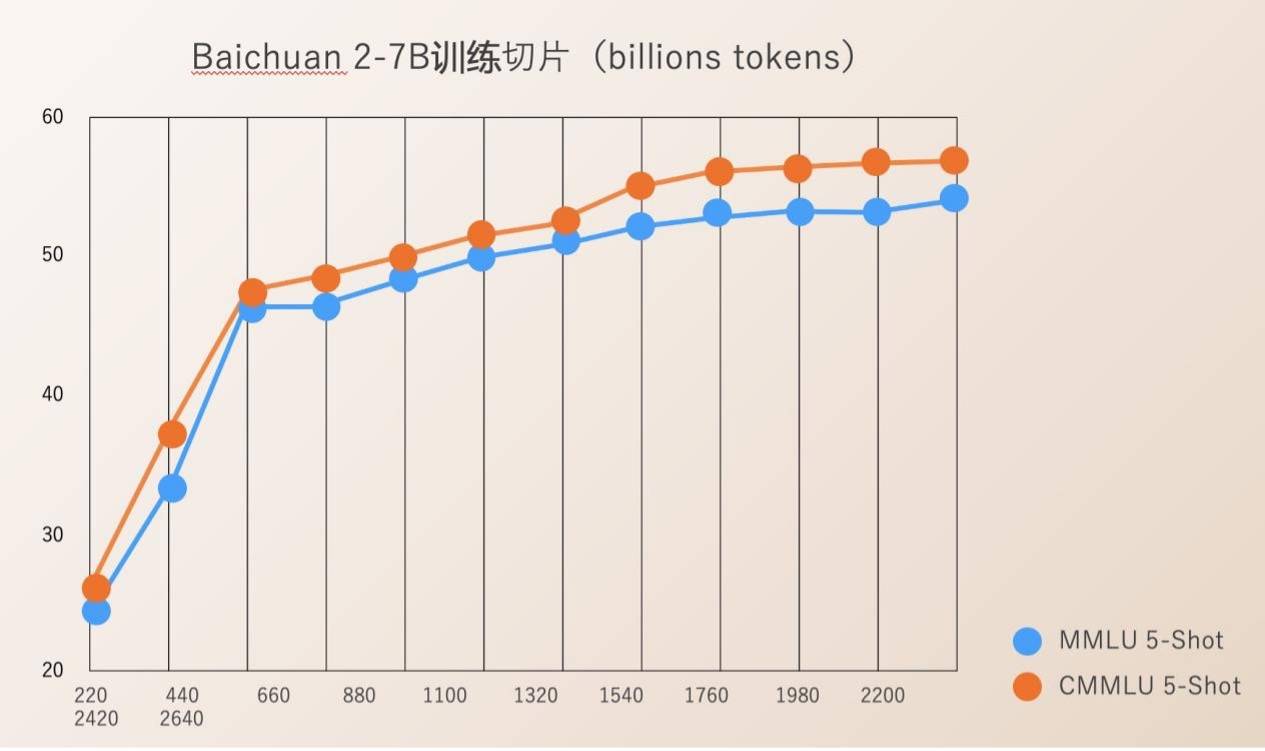

百川智能本次开源了模型训练从 220B 到 2640B 全过程的 Check Ponit。这对于科研机构研究大模型训练过程、模型继续训练和模型的价值观对齐等极具价值,可以推动国内大模型的科研进展。

此前,大部分开源模型只是对外公开自身的模型权重,很少提及训练细节,开发者们只能进行有限的微调,很难深入研究。

百川智能公开的 Baichuan 2 技术报告详细介绍了 Baichuan 2 训练的全过程,包括数据处理、模型结构优化、Scaling law、过程指标等。

百川智能自成立之初,就将通过开源方式助力中国大模型生态繁荣作为公司的重要发展方向。成立不到四个月,便相继发布了 Baichuan-7B、Baichuan-13B 两款开源免费可商用的中文大模型,以及一款搜索增强大模型 Baichuan-53B,两款开源大模型在多个权威评测榜单均名列前茅,目前下载量超过 500 万次。

上周,首批大模型公众服务拍照落地是科技领域的重要新闻。在今年创立的大模型公司中,百川智能是唯一一家通过《生成式人工智能服务管理暂行办法》备案,可以正式面向公众提供服务的企业。

凭借行业领先的基础大模型研发和创新能力,此次开源的两款 Baichuan 2 大模型,得到了上下游企业的积极响应,腾讯云、阿里云、火山方舟、华为、联发科等众多知名企业均参加了本次发布会并与百川智能达成了合作。据介绍,百川智能的大模型在 Hugging Face 上近一个月来的下载量已达到 337 万。

按照此前百川智能的计划,在今年他们还要发布千亿参数大模型,并在明年一季度推出 「超级应用」。

以上是百川智能发布Baichuan2大模型:全面领先Llama2,训练切片也开源了的详细内容。更多信息请关注PHP中文网其他相关文章!

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

AI Hentai Generator

免费生成ai无尽的。

热门文章

热工具

记事本++7.3.1

好用且免费的代码编辑器

SublimeText3汉化版

中文版,非常好用

禅工作室 13.0.1

功能强大的PHP集成开发环境

Dreamweaver CS6

视觉化网页开发工具

SublimeText3 Mac版

神级代码编辑软件(SublimeText3)

热门话题

ControlNet作者又出爆款!一张图生成绘画全过程,两天狂揽1.4k Star

Jul 17, 2024 am 01:56 AM

ControlNet作者又出爆款!一张图生成绘画全过程,两天狂揽1.4k Star

Jul 17, 2024 am 01:56 AM

同样是图生视频,PaintsUndo走出了不一样的路线。ControlNet作者LvminZhang又开始整活了!这次瞄准绘画领域。新项目PaintsUndo刚上线不久,就收获1.4kstar(还在疯狂涨)。项目地址:https://github.com/lllyasviel/Paints-UNDO通过该项目,用户输入一张静态图像,PaintsUndo就能自动帮你生成整个绘画的全过程视频,从线稿到成品都有迹可循。绘制过程,线条变化多端甚是神奇,最终视频结果和原图像非常相似:我们再来看一个完整的绘

登顶开源AI软件工程师榜首,UIUC无Agent方案轻松解决SWE-bench真实编程问题

Jul 17, 2024 pm 10:02 PM

登顶开源AI软件工程师榜首,UIUC无Agent方案轻松解决SWE-bench真实编程问题

Jul 17, 2024 pm 10:02 PM

AIxiv专栏是本站发布学术、技术内容的栏目。过去数年,本站AIxiv专栏接收报道了2000多篇内容,覆盖全球各大高校与企业的顶级实验室,有效促进了学术交流与传播。如果您有优秀的工作想要分享,欢迎投稿或者联系报道。投稿邮箱:liyazhou@jiqizhixin.com;zhaoyunfeng@jiqizhixin.com这篇论文的作者均来自伊利诺伊大学香槟分校(UIUC)张令明老师团队,包括:StevenXia,四年级博士生,研究方向是基于AI大模型的自动代码修复;邓茵琳,四年级博士生,研究方

OpenAI超级对齐团队遗作:两个大模型博弈一番,输出更好懂了

Jul 19, 2024 am 01:29 AM

OpenAI超级对齐团队遗作:两个大模型博弈一番,输出更好懂了

Jul 19, 2024 am 01:29 AM

如果AI模型给的答案一点也看不懂,你敢用吗?随着机器学习系统在更重要的领域得到应用,证明为什么我们可以信任它们的输出,并明确何时不应信任它们,变得越来越重要。获得对复杂系统输出结果信任的一个可行方法是,要求系统对其输出产生一种解释,这种解释对人类或另一个受信任的系统来说是可读的,即可以完全理解以至于任何可能的错误都可以被发现。例如,为了建立对司法系统的信任,我们要求法院提供清晰易读的书面意见,解释并支持其决策。对于大型语言模型来说,我们也可以采用类似的方法。不过,在采用这种方法时,确保语言模型生

公理训练让LLM学会因果推理:6700万参数模型比肩万亿参数级GPT-4

Jul 17, 2024 am 10:14 AM

公理训练让LLM学会因果推理:6700万参数模型比肩万亿参数级GPT-4

Jul 17, 2024 am 10:14 AM

把因果链展示给LLM,它就能学会公理。AI已经在帮助数学家和科学家做研究了,比如著名数学家陶哲轩就曾多次分享自己借助GPT等AI工具研究探索的经历。AI要在这些领域大战拳脚,强大可靠的因果推理能力是必不可少的。本文要介绍的这项研究发现:在小图谱的因果传递性公理演示上训练的Transformer模型可以泛化用于大图谱的传递性公理。也就是说,如果让Transformer学会执行简单的因果推理,就可能将其用于更为复杂的因果推理。该团队提出的公理训练框架是一种基于被动数据来学习因果推理的新范式,只有演示

arXiv论文可以发「弹幕」了,斯坦福alphaXiv讨论平台上线,LeCun点赞

Aug 01, 2024 pm 05:18 PM

arXiv论文可以发「弹幕」了,斯坦福alphaXiv讨论平台上线,LeCun点赞

Aug 01, 2024 pm 05:18 PM

干杯!当论文讨论细致到词句,是什么体验?最近,斯坦福大学的学生针对arXiv论文创建了一个开放讨论论坛——alphaXiv,可以直接在任何arXiv论文之上发布问题和评论。网站链接:https://alphaxiv.org/其实不需要专门访问这个网站,只需将任何URL中的arXiv更改为alphaXiv就可以直接在alphaXiv论坛上打开相应论文:可以精准定位到论文中的段落、句子:右侧讨论区,用户可以发表问题询问作者论文思路、细节,例如:也可以针对论文内容发表评论,例如:「给出至

黎曼猜想显着突破!陶哲轩强推MIT、牛津新论文,37岁菲尔兹奖得主参与

Aug 05, 2024 pm 03:32 PM

黎曼猜想显着突破!陶哲轩强推MIT、牛津新论文,37岁菲尔兹奖得主参与

Aug 05, 2024 pm 03:32 PM

最近,被称为千禧年七大难题之一的黎曼猜想迎来了新突破。黎曼猜想是数学中一个非常重要的未解决问题,与素数分布的精确性质有关(素数是那些只能被1和自身整除的数字,它们在数论中扮演着基础性的角色)。在当今的数学文献中,已有超过一千条数学命题以黎曼猜想(或其推广形式)的成立为前提。也就是说,黎曼猜想及其推广形式一旦被证明,这一千多个命题将被确立为定理,对数学领域产生深远的影响;而如果黎曼猜想被证明是错误的,那么这些命题中的一部分也将随之失去其有效性。新的突破来自MIT数学教授LarryGuth和牛津大学

为大模型提供全新科学复杂问答基准与测评体系,UNSW、阿贡、芝加哥大学等多家机构联合推出SciQAG框架

Jul 25, 2024 am 06:42 AM

为大模型提供全新科学复杂问答基准与测评体系,UNSW、阿贡、芝加哥大学等多家机构联合推出SciQAG框架

Jul 25, 2024 am 06:42 AM

编辑|ScienceAI问答(QA)数据集在推动自然语言处理(NLP)研究发挥着至关重要的作用。高质量QA数据集不仅可以用于微调模型,也可以有效评估大语言模型(LLM)的能力,尤其是针对科学知识的理解和推理能力。尽管当前已有许多科学QA数据集,涵盖了医学、化学、生物等领域,但这些数据集仍存在一些不足。其一,数据形式较为单一,大多数为多项选择题(multiple-choicequestions),它们易于进行评估,但限制了模型的答案选择范围,无法充分测试模型的科学问题解答能力。相比之下,开放式问答

AI硬件再添一员!不图取代手机,NotePin反而能活更久?

Sep 02, 2024 pm 01:40 PM

AI硬件再添一员!不图取代手机,NotePin反而能活更久?

Sep 02, 2024 pm 01:40 PM

目前为止,AI可穿戴设备赛道还没有任何一个产品取得特别好的成绩。今年年初在MWC24横空出世的AIPin,评测样机一经寄出,发布时被狂吹的“AI神话”也开始破灭,短短几个月就经历了大规模退货;同样开局卖爆的RabbitR1则相对好些,但也在大批交付时受到了类似“Android套壳”的不利评价。现在,又有一家公司进入了AI可穿戴设备赛道。科技媒体TheVerge昨日发布博文,称AI初创公司Plaud推出了一款名为NotePin产品。不同于仍在“画饼”阶段的AIFriend,NotePin目前已开始