百度商业多模态理解及 AIGC 创新实践

一、富媒体多模态理解

首先来介绍一下我们对多模态内容的感知。

1、多模态理解

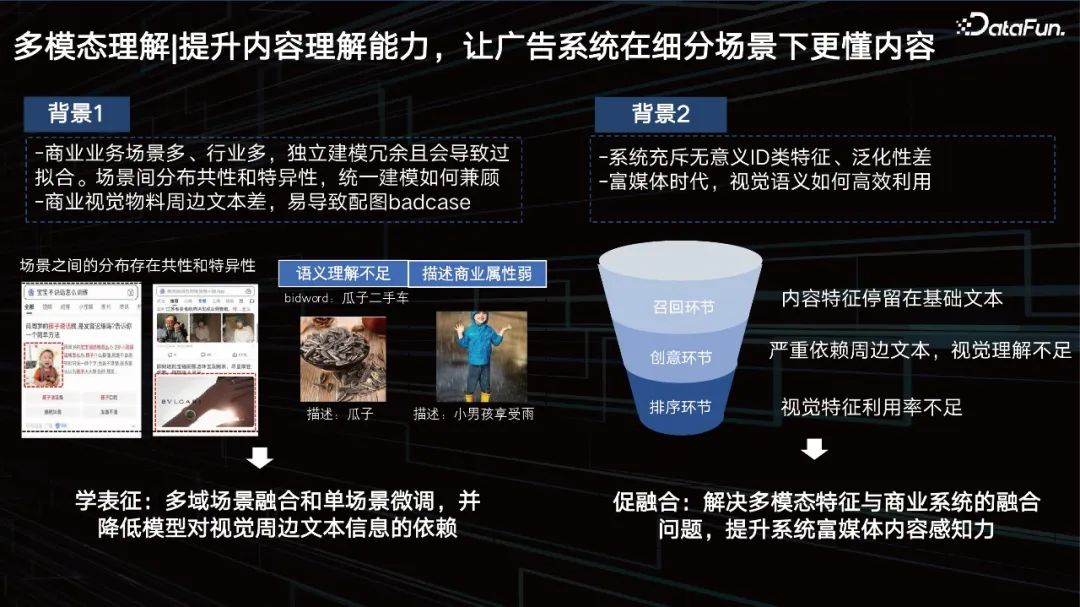

提升内容理解能力,让广告系统在细分场景下更懂内容。

在提升内容理解能力时,会遇到很多现实的问题:

- 商业业务场景多、行业多,独立建模冗余且会导致过拟合,场景间分布共性和特异性,统一建模如何兼顾。

- 商业视觉物料周边文本差,易导致配图badcase。

- 系统充斥无意义ID类特征、泛化性差。

- 富媒体时代,如何高效利用视觉语义,这些内容特征、视频特征和其他特征如何融合,是我们需要去解决的,用以提升系统内对富媒体内容的感知力度。

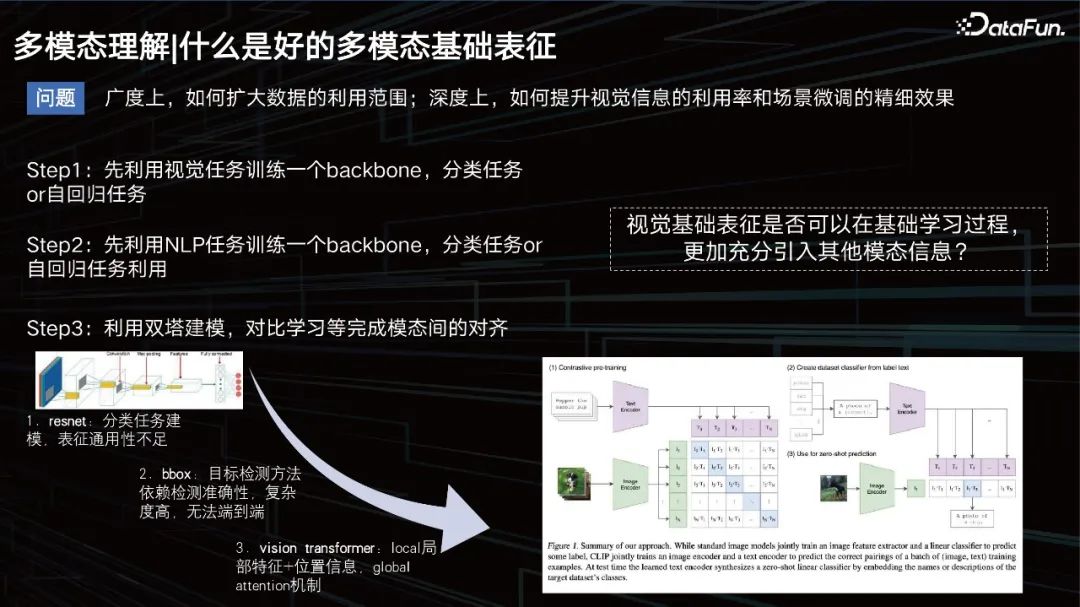

什么是好的多模态基础表征。

什么是一个好的多模态表征?

从广度上要扩大数据应用的范围,从深度上要提升视觉效果,同时保证场景的数据微调。

之前,常规的思路是,训练一个模型去学习图片的模态,一个自回归的任务,然后做文本的任务,再套用一些双塔的模式,去拉近二者的模态关系。那时的文本建模比较简单,大家更多的是在研究视觉怎么建模。最开始是CNN,后面包括一些基于目标检测的方式去提升视觉的表征,比如bbox方式,但这种方式的检测能力有限,并且太重了,并不利于大规模的数据训练。

到了2020年和2021年前后, VIT方式成为了主流。这里不得不提的一个比较有名的模型就是 OpenAI在20年发布的一个模型CLIP,基于双塔的架构分别去做文本和视觉的表征。再用cosine去拉进二者的距离。该模型在检索上面非常优秀,但在VQA任务等一些需要逻辑推理的任务上,就稍显能力不足了。

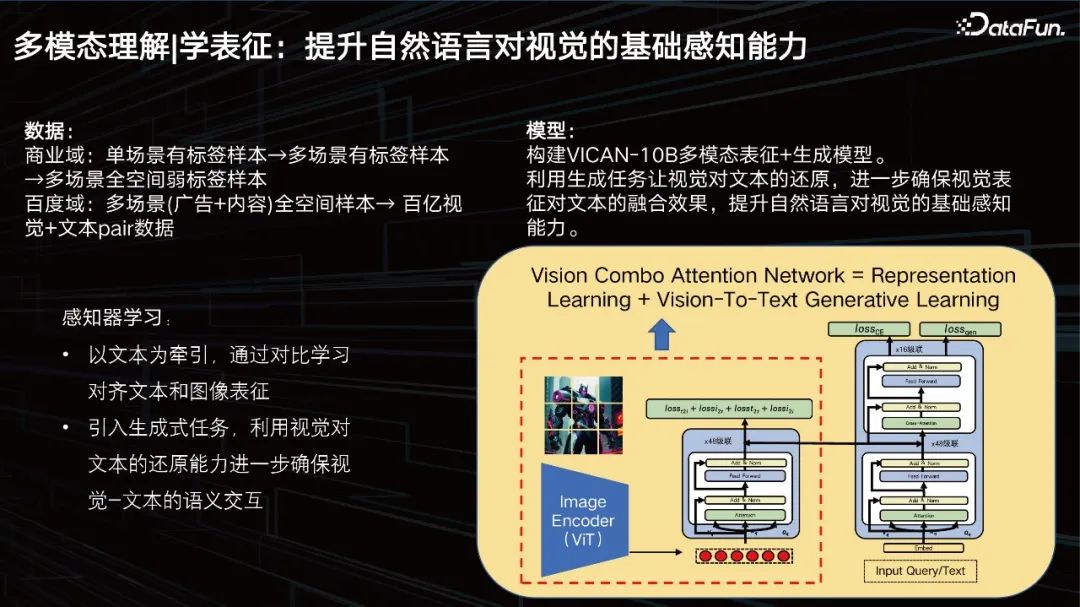

学表征:提升自然语言对视觉的基础感知能力。

我们的目标就是要提升自然语言对视觉的基础感知能力。数据方面,我们的商业域有着亿级的数据,但仍然不够,我们需要进一步扩展,引入商业域以往的数据,并进行清洗和梳理。构建了百亿级别的训练集。

我们构建了VICAN-12B多模态表征+生成模型,利用生成任务让视觉对文本的还原,进一步确保视觉表征对文本的融合效果,提升自然语言对视觉的基础感知能力。上图中展示了模型的整体结构,可以看到它还是一个双塔+单塔的复合结构。因为首先要解决的是一个大规模图片检索的任务。左边的框中的部分我们称之为视觉的感知器,是一个20亿参数规模的ViT结构。右边可以分两层看,下面为了做检索,是一个文本的transformer的堆叠,上面为了做生成。模型分为了三个任务,一个是生成任务,一个是分类任务,一个是图片对比任务,基于这三个不同目标去训练模型,所以达到了比较好的效果,但我们还会进一步去优化。

一套高效、统一、可迁移的多场景全域表征方案。

结合商业场景数据,引入了LLM模型提升模型理解能力。CV模型是感知器,LLM模型是理解器。我们的做法就是需要把视觉特征进行相应的迁移,因为刚才提到,表征是多模态的,大模型是基于文本的。我们只需要让它去适配我们的文心LLM的大模型就可以了,所以我们需要利用Combo attention的方式,去做相应的特征融合。我们需要保留大模型的逻辑推理能力,所以尽量不动大模型,只是加入商业场景反馈数据,去促进视觉特征到大模型的融合。我们可以用few shot的方式去支撑下任务。主要任务包括:

- 图片的描述,其实它不仅仅是个描述,而是一个Prompt逆向工程,优质的图文数据可以作为我们后面文生图的一个比较好的数据来源。

- 图文相关性控制,因为商业需要做配置,需要做对图片信息的理解,我们广告配图的搜索词和图片语义其实是需要做控制的,当然这是一个很通用的方式,就可以对图片和Prompt进行相关的判定。

- 图片风险&体验控制,我们已经能够对图片的内容进行比较好的描述了,那么我们只需要简单利用风控的小样本数据迁移就能够清楚地知道它是否涉及一些风险问题。

下面,重点分享下场景化精调。

2、场景化精调

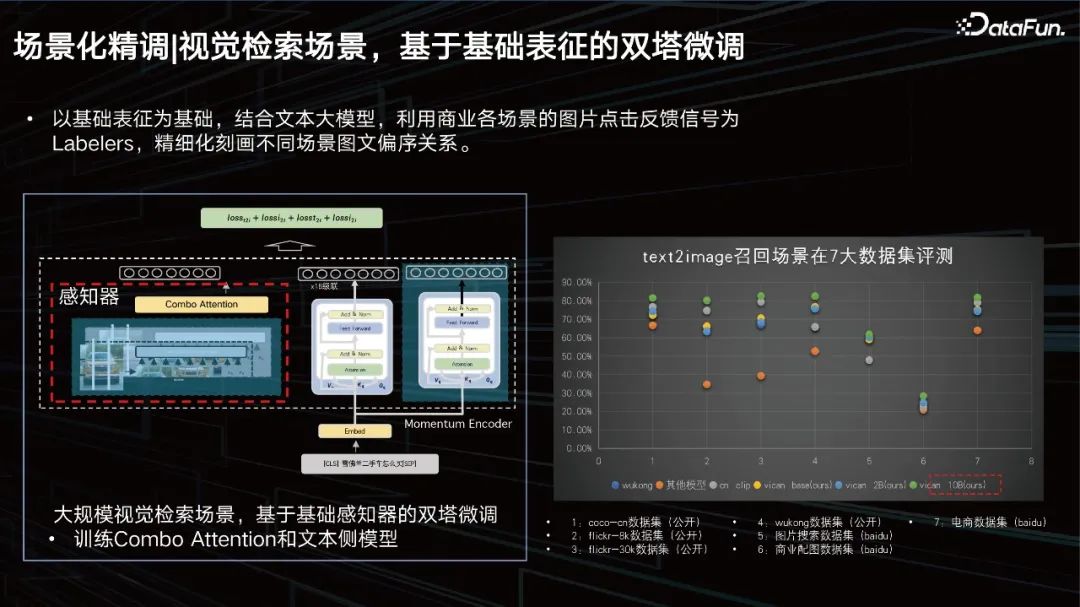

视觉检索场景,基于基础表征的双塔微调。

以基础表征为基础,结合文本大模型,利用商业各场景的图片点击反馈信号为Labelers,精细化刻画不同场景图文偏序关系。我们在7大数据集上进行了评测,均能达到SOTA的效果。

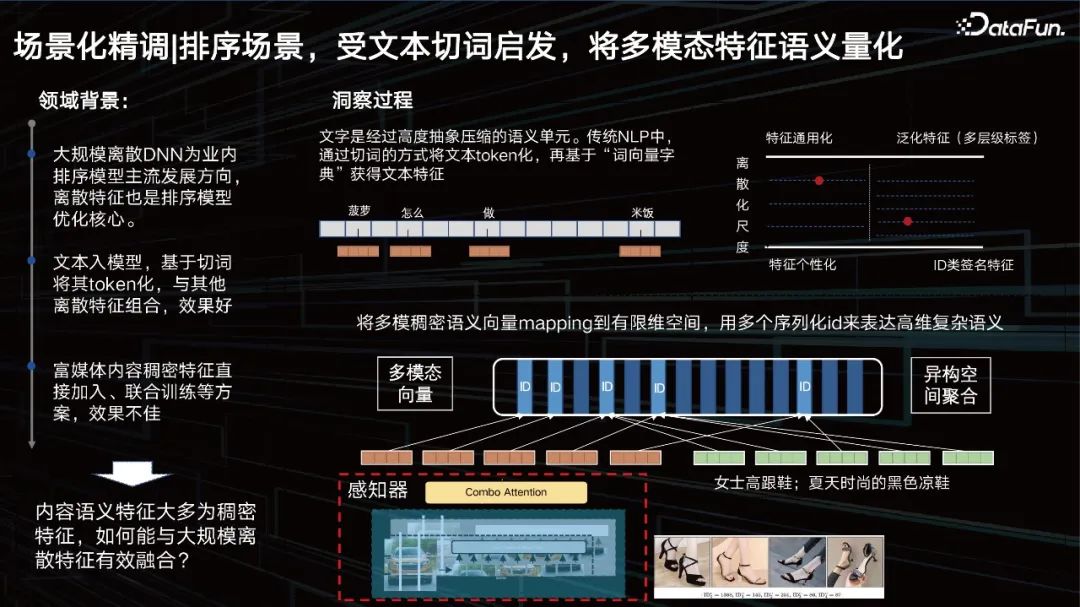

排序场景,受文本切词启发,将多模态特征语义量化。

表征以外,另一个问题是如何提升排序场景中视觉的效果。先来看一下领域背景,大规模离散DNN为业内排序模型主流发展方向,离散特征也是排序模型优化的核心。文本入模型,基于切词将其token化,与其他离散特征组合,效果好。而对于视觉,我们希望也能将其进行token化。

ID类特征其实是一个极具个性化的特征,但是泛化特征通用性好了,其刻画精度可能就变差了。我们需要通过数据和任务去动态调节这个平衡点在哪。也就是希望找到一个和数据最相关的尺度,去把特征进行相应的”切词”变成一个ID,像文本一样去切分多模态特征。所以我们提出了一个多尺度、多层级的内容量化学习方法,去解决这一问题。

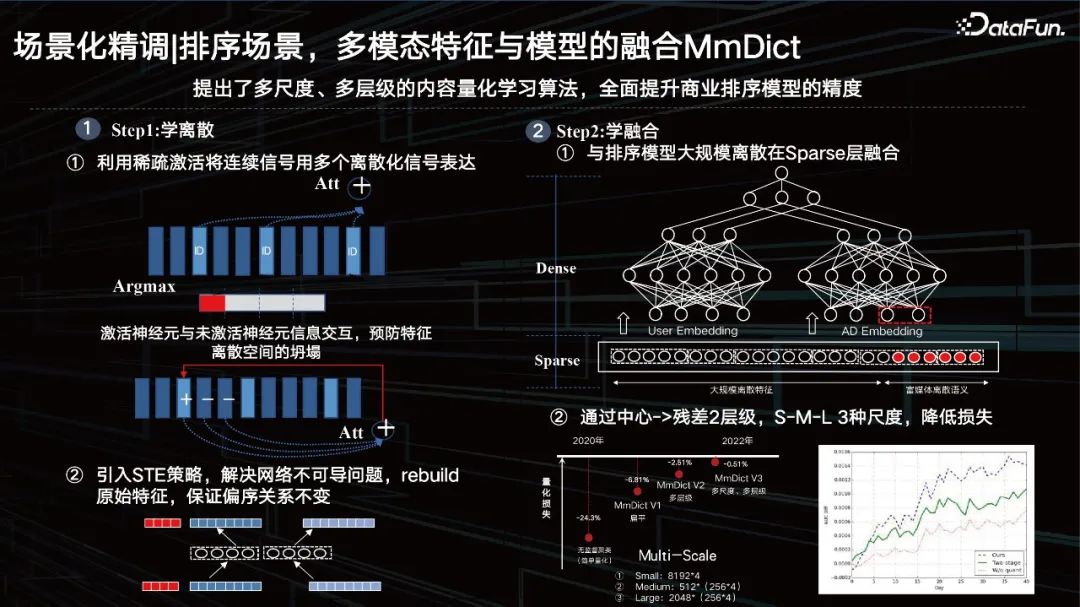

排序场景,多模态特征与模型的融合 MmDict。

主要分两步,第一步是学离散,第二步是学融合。

Step1:学离散

① 利用稀疏激活将连续信号用多个离散化信号表达;也就是通过稀疏激活的方式把稠密特征进行切分,然后去激活对应多模态codebook里面的ID,但这里面其实只有argmax操作,会引来不可导的问题,同时为了去防止特征空间的坍塌,加入了激活神经元与未激活神经元信息交互。

② 引入 STE 策略,解决网络不可导问题, rebuild原始特征,保证偏序关系不变。

通过encoder-decoder的方式,把稠密特征进行序列量化,再通过正确的方式把量化出来的特征进行还原。还原前后要保证它的偏序关系不变,几乎可以控制特征在具体任务上的量化损失小于1%,这样的ID具备了当下数据分布个性化的同时,还具有泛化特性。

Step2:学融合

① 与排序模型大规模离散在 Sparse层融合。

那么刚才提到的隐层复用直接放在上面去,其实效果一般。如果把它ID化,量化之后,到sparse特征层和其他类的特征进行融合,有着比较好的效果。

② 通过中心 -> 残差2层级, S-M-L 3种尺度,降低损失。

当然我们也采用了一些残差,以及多尺度的方式。从2020年开始,我们把量化的损失逐步压低,去年达到了一个点以下,这样就可以在大模型抽出来特征之后,我们用这种可学习量化的方式对视觉内容进行刻画,具备语义关联ID的特征其实非常适配我们现在的商业系统,包括推荐系统的ID的这样一个探索的研究方式。

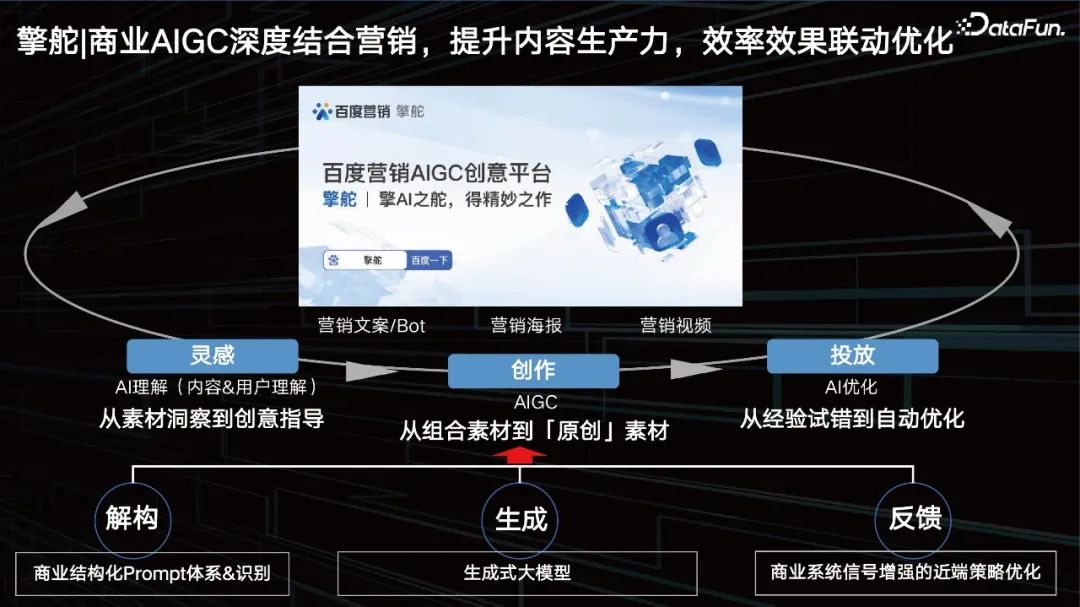

二、擎舵

1、商业AIGC 深度结合营销,提升内容生产力,效率效果联动优化

百度营销AIGC创意平台从灵感到创作,再到投放形成了一个完美的闭环。从解构、生成、反馈都在推进优化我们的AIGC。

- 灵感:AI理解(内容&用户理解)。AI能不能帮助我们去找到什么样的Prompt是好的。从素材洞察到创意指导。

- 创作:AIGC,如文本生成,图片生成,还有数字人、视频生成等等。

- 投放:AI优化。从经验试错到自动优化。

2、营销文案生成 = 商业 Prompt 体系+ 文心大模型

一个好的商业Prompt,具备以下一些要素:

- 知识图谱,比如说卖车,车到底需要包含哪些商业元素,仅有品牌是不够的,广告主更希望有一个完整的知识体系;

- 风格,例如现在『文艺范』的宣传体,其实是需要把它抽象成一些标签,去帮助我们判断主要是什么样的营销标题或营销的一些描述。

- 卖点,卖点其实就是产品属性的一个特征,即为最强有力的消费理由。

- 用户画像,是根据目标的行为观点的差异区分为不同类型,迅速组织在一起,然后把新得出的类型提炼出来,形成一个类型的用户画像。

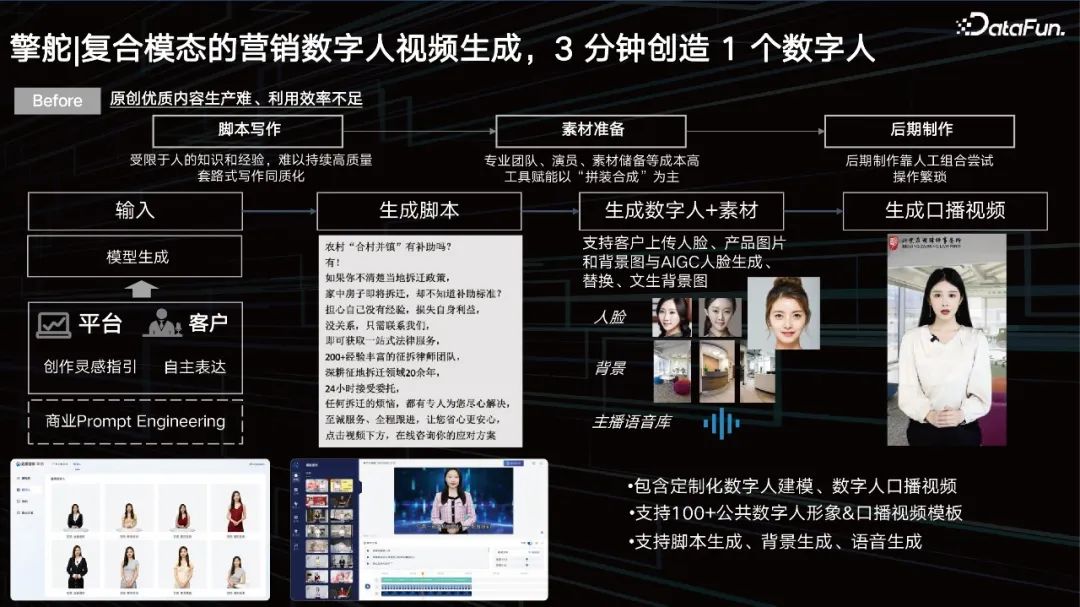

3、复合模态的营销数字人视频生成, 3 分钟创造 1 个数字人

视频生成目前已经比较成熟。但它其实依然存在着一些问题:

- 脚本写作:受限于人的知识和经验,难以持续高质量写作,同质化严重。

- 素材准备:专业团队、演员、素材储备等成本高工具赋能,以“拼装合成”为主。

- 后期制作:后期制作靠人工试错,操作繁琐。

前期通过prompt来输入,想生成一个什么样的视频,希望选择一个什么样的人,让他去说什么,都通过prompt来输入,然后我们根据其诉求,能够准确控制我们的大模型去生成相应的脚本。

接下来我们可以通过我们的数字人库去召回相应的数字人,但是可能利用AI技术进一步提升数字人的多样性,比如人脸替换、背景替换、口音语音替换去适配我们的prompt,最后脚本、数字人唇形替换、背景替换、人脸替换,视频压制之后,就可以得到一个口播视频。客户得以利用数字人的方式去介绍产品对应的一些营销卖点。这样3分钟即可做好一个数字人,极大地提升了广告主做数字人的能力。

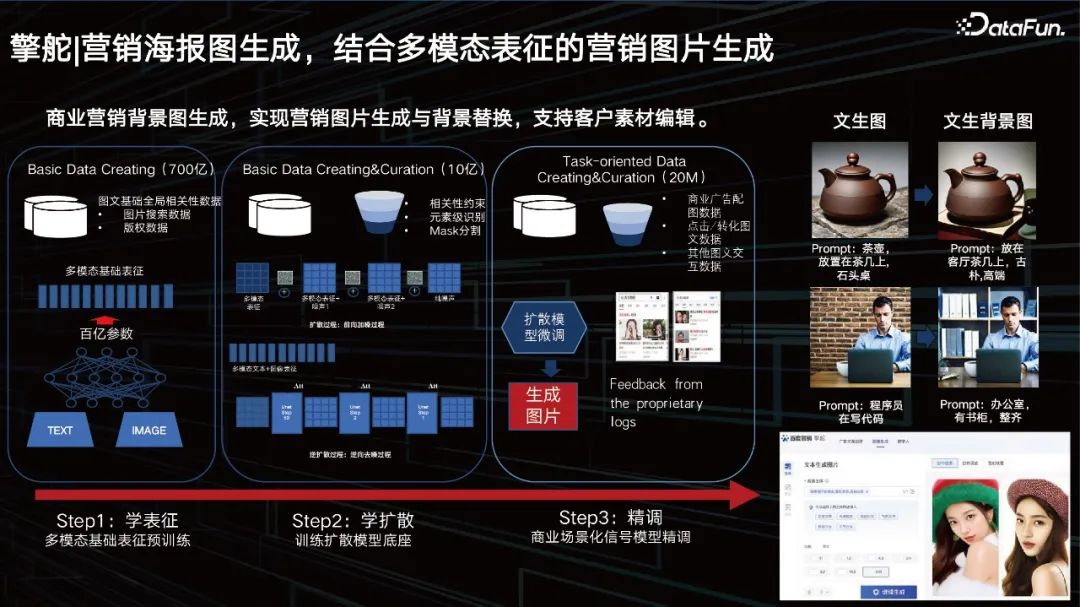

4、营销海报图生成,结合多模态表征的营销图片生成

大模型还可以帮助商业实现营销海报的生成和商品背景的替换。我们已有一个百亿规模的多模态表征,中间这一层是我们学的一个扩散,我们基于好的动态表征去学unet。通过大数据的训练之后,客户还希望有一些特别个性化的东西,所以我们还需要加入一些微调的方式。

我们提供了一个帮助客户微调的方案,一个大模型动态加载小参数的方案,这也是目前业界的一个通用的解决方案。

首先我们为客户提供一个生图能力,客户可以通过编辑或者Prompt去改变这个图片背后的背景。

以上是百度商业多模态理解及 AIGC 创新实践的详细内容。更多信息请关注PHP中文网其他相关文章!

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

Video Face Swap

使用我们完全免费的人工智能换脸工具轻松在任何视频中换脸!

热门文章

热工具

记事本++7.3.1

好用且免费的代码编辑器

SublimeText3汉化版

中文版,非常好用

禅工作室 13.0.1

功能强大的PHP集成开发环境

Dreamweaver CS6

视觉化网页开发工具

SublimeText3 Mac版

神级代码编辑软件(SublimeText3)

大模型App腾讯元宝上线!混元再升级,打造可随身携带的全能AI助理

Jun 09, 2024 pm 10:38 PM

大模型App腾讯元宝上线!混元再升级,打造可随身携带的全能AI助理

Jun 09, 2024 pm 10:38 PM

5月30日,腾讯宣布旗下混元大模型全面升级,基于混元大模型的App“腾讯元宝”正式上线,苹果及安卓应用商店均可下载。相比此前测试阶段的混元小程序版本,面向工作效率场景,腾讯元宝提供了AI搜索、AI总结、AI写作等核心能力;面向日常生活场景,元宝的玩法也更加丰富,提供了多个特色AI应用,并新增了创建个人智能体等玩法。“腾讯做大模型不争一时之先。”腾讯云副总裁、腾讯混元大模型负责人刘煜宏表示:“过去的一年,我们持续推进腾讯混元大模型的能力爬坡,在丰富、海量的业务场景中打磨技术,同时洞察用户的真实需求

字节跳动豆包大模型发布,火山引擎全栈 AI 服务助力企业智能化转型

Jun 05, 2024 pm 07:59 PM

字节跳动豆包大模型发布,火山引擎全栈 AI 服务助力企业智能化转型

Jun 05, 2024 pm 07:59 PM

火山引擎总裁谭待企业要做好大模型落地,面临模型效果、推理成本、落地难度的三大关键挑战:既要有好的基础大模型做支撑,解决复杂难题,也要有低成本的推理服务让大模型被广泛应用,还要更多工具、平台和应用帮助企业做好场景落地。——谭待火山引擎总裁01.豆包大模型首次亮相大使用量打磨好模型模型效果是AI落地最关键的挑战。谭待指出,只有大的使用量,才能打磨出好模型。目前,豆包大模型日均处理1,200亿tokens文本、生成3,000万张图片。为助力企业做好大模型场景落地,字节跳动自主研发的豆包大模型将通过火山

统一角色、百变场景,视频生成神器PixVerse被网友玩出了花,超强一致性成「杀招」

Apr 01, 2024 pm 02:11 PM

统一角色、百变场景,视频生成神器PixVerse被网友玩出了花,超强一致性成「杀招」

Apr 01, 2024 pm 02:11 PM

又双叒叕是一个新功能的亮相。你是否会遇见过想要给图片角色换个背景,但是AI总是搞出「物非人也非」的效果。即使在Midjourney、DALL・E这样成熟的生成工具中,保持角色一致性还得有些prompt技巧,不然人物就会变来变去,根本达不到你想要的结果。不过,这次算是让你遇着了。AIGC工具PixVerse的「角色-视频」新功能可以帮你实现这一切。不仅如此,它能生成动态视频,让你的角色更加生动。输入一张图,你就能够得到相应的动态视频结果,在保持角色一致性的基础上,丰富的背景元素和角色动态让生成结果

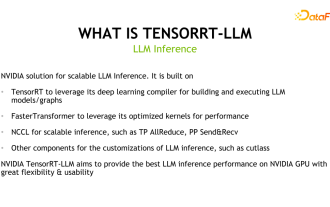

揭秘NVIDIA大模型推理框架:TensorRT-LLM

Feb 01, 2024 pm 05:24 PM

揭秘NVIDIA大模型推理框架:TensorRT-LLM

Feb 01, 2024 pm 05:24 PM

一、TensorRT-LLM的产品定位TensorRT-LLM是NVIDIA为大型语言模型(LLM)开发的可扩展推理方案。它基于TensorRT深度学习编译框架构建、编译和执行计算图,并借鉴了FastTransformer中高效的Kernels实现。此外,它还利用NCCL实现设备间的通信。开发者可以根据技术发展和需求差异,定制算子以满足特定需求,例如基于cutlass开发定制的GEMM。TensorRT-LLM是NVIDIA官方推理方案,致力于提供高性能并不断完善其实用性。TensorRT-LL

对标GPT-4!中国移动九天大模型通过双备案

Apr 04, 2024 am 09:31 AM

对标GPT-4!中国移动九天大模型通过双备案

Apr 04, 2024 am 09:31 AM

4月4日消息,日前,国家网信办公布已备案大模型清单,中国移动“九天自然语言交互大模型”名列其中,标志着中国移动九天AI大模型可正式对外提供生成式人工智能服务。中国移动表示,这是同时通过国家“生成式人工智能服务备案”和“境内深度合成服务算法备案”双备案的首个央企研发的大模型。据介绍,九天自然语言交互大模型具有行业能力增强、安全可信、支持全栈国产化等特点,已形成90亿、139亿、570亿、千亿等多种参数量版本,可灵活部署于云、边、端不同场

工业知识图谱进阶实战

Jun 13, 2024 am 11:59 AM

工业知识图谱进阶实战

Jun 13, 2024 am 11:59 AM

一、背景简介首先来介绍一下云问科技的发展历程。云问科技公...2023年,正是大模型盛行的时期,很多企业认为已经大模型之后图谱的重要性大大降低了,之前研究的预置的信息化系统也都不重要了。不过随着RAG的推广、数据治理的盛行,我们发现更高效的数据治理和高质量的数据是提升私有化大模型效果的重要前提,因此越来越多的企业开始重视知识建设的相关内容。这也推动了知识的构建和加工开始向更高水平发展,其中有很多技巧和方法可以挖掘。可见一个新技术的出现,并不是将所有的旧技术打败,也有可能将新技术和旧技术相互融合后

小米相册 AIGC 编辑功能正式上线:支持智能扩图、魔法消除 Pro

Mar 14, 2024 pm 10:22 PM

小米相册 AIGC 编辑功能正式上线:支持智能扩图、魔法消除 Pro

Mar 14, 2024 pm 10:22 PM

3月14日消息,小米官方今日宣布,小米相册AIGC编辑功能正式上线小米14Ultra手机,并将在本月内全量上线小米14、小米14Pro和RedmiK70系列手机。AI大模型为小米相册带来两个新功能:智能扩图与魔法消除Pro。AI智能扩图支持对构图不好的图片进行扩展和自动构图,操作方式为:打开相册编辑-进入裁切旋转-点击智能扩图。魔法消除Pro能够对游客照中的路人进行无痕消除,使用方式为:打开相册编辑-进入魔法消除-点击右上角的Pro。目前,小米14Ultra机器已经上线智能扩图与魔法消除Pro功

新测试基准发布,最强开源Llama 3尴尬了

Apr 23, 2024 pm 12:13 PM

新测试基准发布,最强开源Llama 3尴尬了

Apr 23, 2024 pm 12:13 PM

如果试题太简单,学霸和学渣都能考90分,拉不开差距……随着Claude3、Llama3甚至之后GPT-5等更强模型发布,业界急需一款更难、更有区分度的基准测试。大模型竞技场背后组织LMSYS推出下一代基准测试Arena-Hard,引起广泛关注。Llama3的两个指令微调版本实力到底如何,也有了最新参考。与之前大家分数都相近的MTBench相比,Arena-Hard区分度从22.6%提升到87.4%,孰强孰弱一目了然。Arena-Hard利用竞技场实时人类数据构建,与人类偏好一致率也高达89.1%