iPhone中隐藏的机器人:基于GPT-2架构,带有emoji分词器,由MIT校友开发

发烧友们已经揭开了苹果Transformer的“秘密”

在大型模型浪潮的影响下,即使是保守的苹果公司,在每次发布会上也必定会提及"Transformer"

比如,在今年的WWDC上,苹果就已宣布,船新版本的iOS和macOS将内置Transformer语言模型,以提供带文本预测功能的输入法。

虽然苹果官方没有透露更多信息,但技术爱好者们却迫不及待

一位名叫Jack Cook的小哥,成功地翻开了macOS Sonoma beta的新篇章,意外地发现了许多新的信息

- 模型架构上,Cook小哥认为苹果的语言模型更像是基于GPT-2打造的。

- 在分词器(tokenizer)方面,表情符号在其中十分突出。

更多细节,一起来看。

基于GPT-2架构

首先,让我们回顾一下苹果基于Transformer的语言模型在iPhone、MacBook等设备上能够实现的功能

需要重写的内容是:主要体现在输入法方面。在语言模型的支持下,苹果自带的输入法可以实现单词预测和纠错的功能

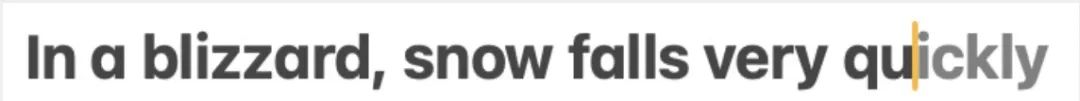

Jack Cook小哥具体测试了一下,发现这个功能主要实现的是针对单个单词的预测。

需要进行改写的内容是:△来源:Jack Cook的博客文章

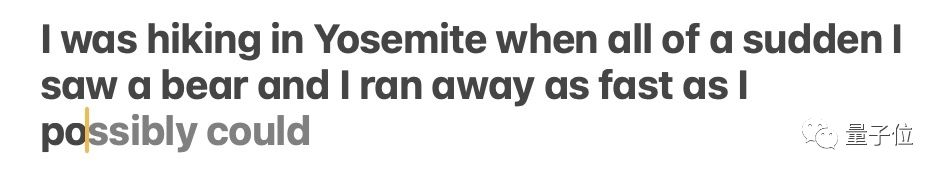

模型有时也会预测即将出现的多个单词,但这仅限于句子语义十分明显的情况,比较类似于Gmail里的自动完成功能。

需要进行改写的内容是:△来源:Jack Cook的博客文章

那么这个模型具体被装在了哪里?一通深入挖掘之后,Cook小哥确定:

我在 /System/Library/LinguisticData/RequiredAssets_en.bundle/AssetData/en.lm/unilm.bundle 中找到了预测文本模型。

原因是:

- unilm.bundle中的许多文件在macOS Ventura(13.5)里并不存在,仅出现在了新版本macOS Sonoma beta(14.0)里。

- unilm.bundle中存在一个sp.dat文件,这在Ventura和Sonoma beta里都能找到,但Sonoma beta的版本中更新了明显像是分词器的一组token。

- sp.dat中token的数量跟unilm.bundle中的两个文件——unilm_joint_cpu.espresso.shape和unilm_joint_ane.espresso.shape能匹配得上。这两个文件描述了Espresso/CoreML模型中各层的形状。

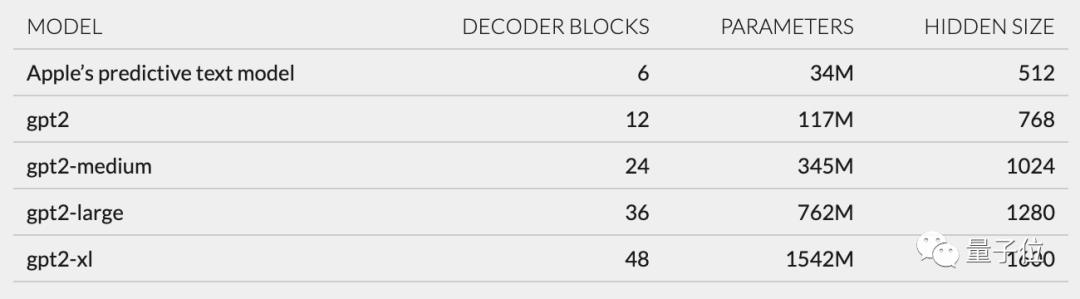

进一步推测,根据unilm_joint_cpu中描述的网络结构,小哥认为苹果模型是基于GPT-2架构构建的

主要的组成部分包括令牌嵌入、位置编码、解码器块和输出层,在每个解码器块中都会出现类似于"gpt2_transformer_layer_3d"这样的词汇

需要进行改写的内容是:△来源:Jack Cook的博客文章

根据每层大小,小哥还推测苹果模型约有3400万个参数,隐藏层大小为512。换句话说,它比GPT-2最小版本还要小

小哥认为,这主要是因为苹果想要一种不太耗电,但同时能够快速、频繁运行的模型。

而苹果官方在WWDC上的说法是,“每点击一个键,iPhone就会运行模型一次”。

然而,这也意味着这个文本预测模型无法很好地续写句子或段落

需要进行改写的内容是:△来源:Jack Cook的博客文章

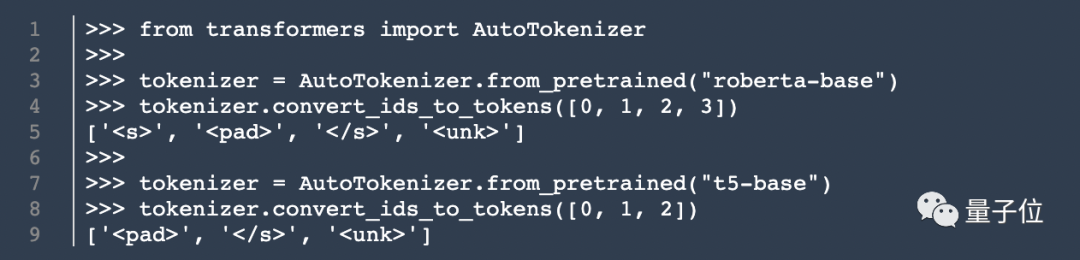

模型架构之外,Cook小哥还挖出了分词器(tokenizer)的相关信息。

他在unilm.bundle/sp.dat里发现了一组数量为15000的token,值得关注的是,其中包含100个emoji。

Cook揭秘库克

虽然这个Cook不是那个库克,但小哥的博客文章一发布,仍然吸引了很多关注

基于他的发现,网友们热烈地讨论起苹果在用户体验和前沿技术应用之间的平衡大法。

回到Jack Cook本人,他本科和硕士毕业于MIT的计算机专业,目前还在攻读牛津大学的互联网社会科学硕士学位。

他之前曾在英伟达实习,专注于研究BERT等语言模型。他还担任《纽约时报》的自然语言处理高级研发工程师

以上是iPhone中隐藏的机器人:基于GPT-2架构,带有emoji分词器,由MIT校友开发的详细内容。更多信息请关注PHP中文网其他相关文章!

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

AI Hentai Generator

免费生成ai无尽的。

热门文章

热工具

记事本++7.3.1

好用且免费的代码编辑器

SublimeText3汉化版

中文版,非常好用

禅工作室 13.0.1

功能强大的PHP集成开发环境

Dreamweaver CS6

视觉化网页开发工具

SublimeText3 Mac版

神级代码编辑软件(SublimeText3)

热门话题

centos关机命令行

Apr 14, 2025 pm 09:12 PM

centos关机命令行

Apr 14, 2025 pm 09:12 PM

CentOS 关机命令为 shutdown,语法为 shutdown [选项] 时间 [信息]。选项包括:-h 立即停止系统;-P 关机后关电源;-r 重新启动;-t 等待时间。时间可指定为立即 (now)、分钟数 ( minutes) 或特定时间 (hh:mm)。可添加信息在系统消息中显示。

如何检查CentOS HDFS配置

Apr 14, 2025 pm 07:21 PM

如何检查CentOS HDFS配置

Apr 14, 2025 pm 07:21 PM

检查CentOS系统中HDFS配置的完整指南本文将指导您如何有效地检查CentOS系统上HDFS的配置和运行状态。以下步骤将帮助您全面了解HDFS的设置和运行情况。验证Hadoop环境变量:首先,确认Hadoop环境变量已正确设置。在终端执行以下命令,验证Hadoop是否已正确安装并配置:hadoopversion检查HDFS配置文件:HDFS的核心配置文件位于/etc/hadoop/conf/目录下,其中core-site.xml和hdfs-site.xml至关重要。使用

CentOS上GitLab的备份方法有哪些

Apr 14, 2025 pm 05:33 PM

CentOS上GitLab的备份方法有哪些

Apr 14, 2025 pm 05:33 PM

CentOS系统下GitLab的备份与恢复策略为了保障数据安全和可恢复性,CentOS上的GitLab提供了多种备份方法。本文将详细介绍几种常见的备份方法、配置参数以及恢复流程,帮助您建立完善的GitLab备份与恢复策略。一、手动备份利用gitlab-rakegitlab:backup:create命令即可执行手动备份。此命令会备份GitLab仓库、数据库、用户、用户组、密钥和权限等关键信息。默认备份文件存储于/var/opt/gitlab/backups目录,您可通过修改/etc/gitlab

CentOS上PyTorch的GPU支持情况如何

Apr 14, 2025 pm 06:48 PM

CentOS上PyTorch的GPU支持情况如何

Apr 14, 2025 pm 06:48 PM

在CentOS系统上启用PyTorchGPU加速,需要安装CUDA、cuDNN以及PyTorch的GPU版本。以下步骤将引导您完成这一过程:CUDA和cuDNN安装确定CUDA版本兼容性:使用nvidia-smi命令查看您的NVIDIA显卡支持的CUDA版本。例如,您的MX450显卡可能支持CUDA11.1或更高版本。下载并安装CUDAToolkit:访问NVIDIACUDAToolkit官网,根据您显卡支持的最高CUDA版本下载并安装相应的版本。安装cuDNN库:前

docker原理详解

Apr 14, 2025 pm 11:57 PM

docker原理详解

Apr 14, 2025 pm 11:57 PM

Docker利用Linux内核特性,提供高效、隔离的应用运行环境。其工作原理如下:1. 镜像作为只读模板,包含运行应用所需的一切;2. 联合文件系统(UnionFS)层叠多个文件系统,只存储差异部分,节省空间并加快速度;3. 守护进程管理镜像和容器,客户端用于交互;4. Namespaces和cgroups实现容器隔离和资源限制;5. 多种网络模式支持容器互联。理解这些核心概念,才能更好地利用Docker。

centos安装mysql

Apr 14, 2025 pm 08:09 PM

centos安装mysql

Apr 14, 2025 pm 08:09 PM

在 CentOS 上安装 MySQL 涉及以下步骤:添加合适的 MySQL yum 源。执行 yum install mysql-server 命令以安装 MySQL 服务器。使用 mysql_secure_installation 命令进行安全设置,例如设置 root 用户密码。根据需要自定义 MySQL 配置文件。调整 MySQL 参数和优化数据库以提升性能。

CentOS下GitLab的日志如何查看

Apr 14, 2025 pm 06:18 PM

CentOS下GitLab的日志如何查看

Apr 14, 2025 pm 06:18 PM

CentOS系统下查看GitLab日志的完整指南本文将指导您如何查看CentOS系统中GitLab的各种日志,包括主要日志、异常日志以及其他相关日志。请注意,日志文件路径可能因GitLab版本和安装方式而异,若以下路径不存在,请检查GitLab安装目录及配置文件。一、查看GitLab主要日志使用以下命令查看GitLabRails应用程序的主要日志文件:命令:sudocat/var/log/gitlab/gitlab-rails/production.log此命令会显示produc

CentOS上PyTorch的分布式训练如何操作

Apr 14, 2025 pm 06:36 PM

CentOS上PyTorch的分布式训练如何操作

Apr 14, 2025 pm 06:36 PM

在CentOS系统上进行PyTorch分布式训练,需要按照以下步骤操作:PyTorch安装:前提是CentOS系统已安装Python和pip。根据您的CUDA版本,从PyTorch官网获取合适的安装命令。对于仅需CPU的训练,可以使用以下命令:pipinstalltorchtorchvisiontorchaudio如需GPU支持,请确保已安装对应版本的CUDA和cuDNN,并使用相应的PyTorch版本进行安装。分布式环境配置:分布式训练通常需要多台机器或单机多GPU。所