10万美元+26天,一个低成本千亿参数LLM就诞生了

论文:https://arxiv.org/pdf/2309.03852.pdf

需要重写的内容是:模型链接:https://huggingface.co/CofeAI/FLM-101B

语言本质上是符号的。已经有一些研究在使用符号而非类别标签来评估 LLM 的智能水平。类似地,该团队使用了一种符号映射方法来测试 LLM 在未曾见过的上下文上的泛化能力。

人类智能的一大重要能力是理解给定的规则并采取相应的行动。这种测试方法已被广泛用在各种等级的测验中。因此,规则理解成为这里的第二项测试。

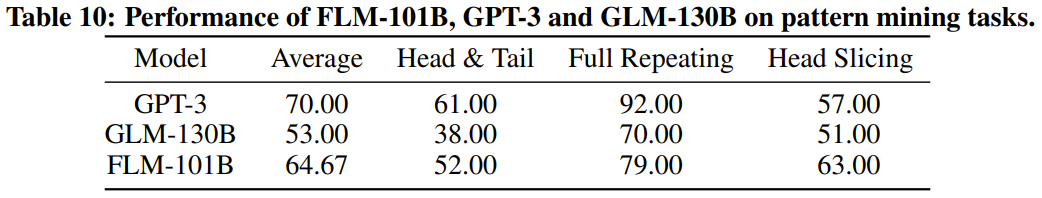

重写后的内容:模式挖掘是智能的重要组成部分,它涉及到归纳和演绎。在科学发展历史中,这种方法起着至关重要的作用。此外,各种竞赛的测试题也常常需要这种能力才能解答。出于这些原因,我们选择了模式挖掘作为第三个评估指标

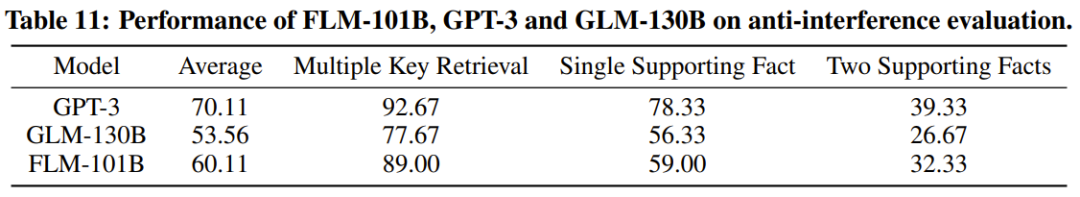

最后一个也很重要的指标是抗干扰能力,这也是智能的核心能力之一。已有研究指出,语言和图像都很容易被噪声干扰。考虑到这一点,该团队把抗干扰用作了最后一个评估指标。

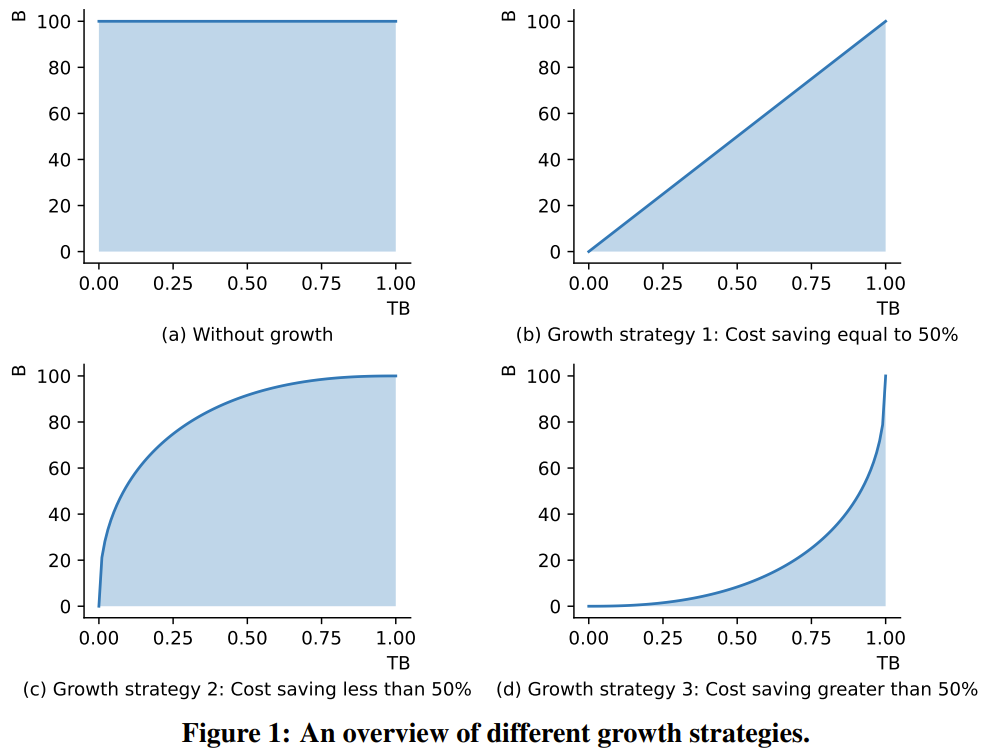

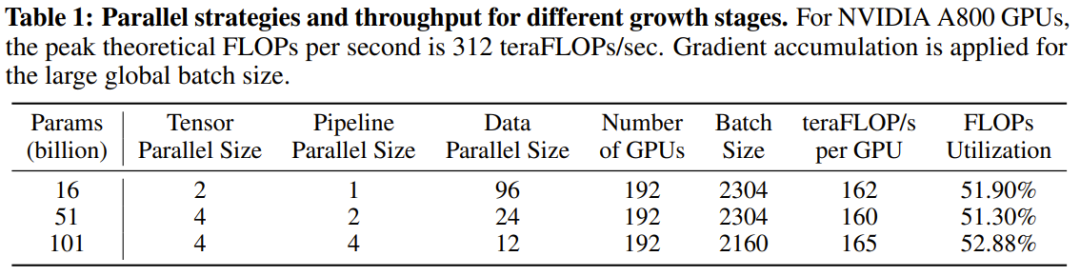

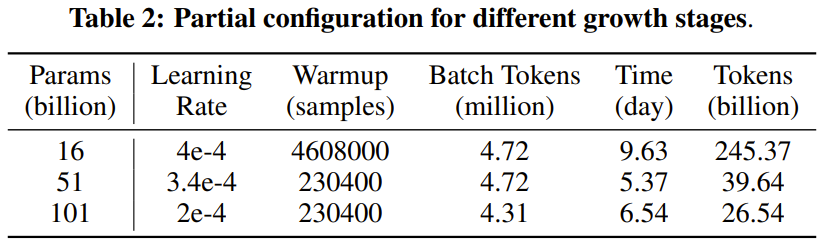

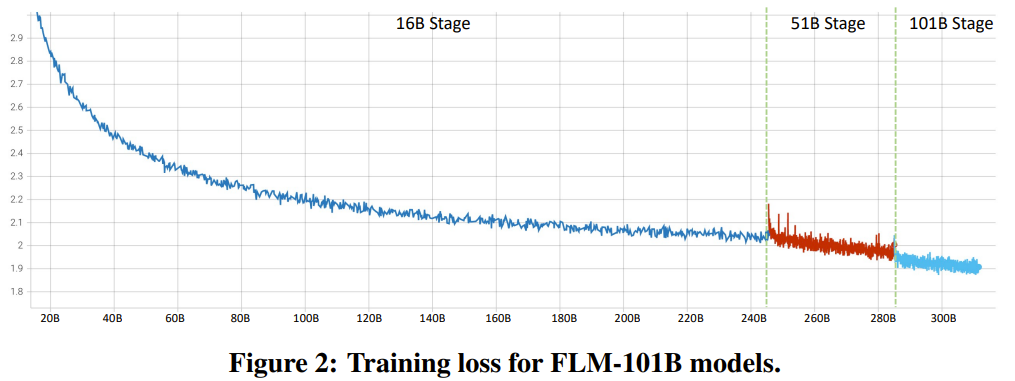

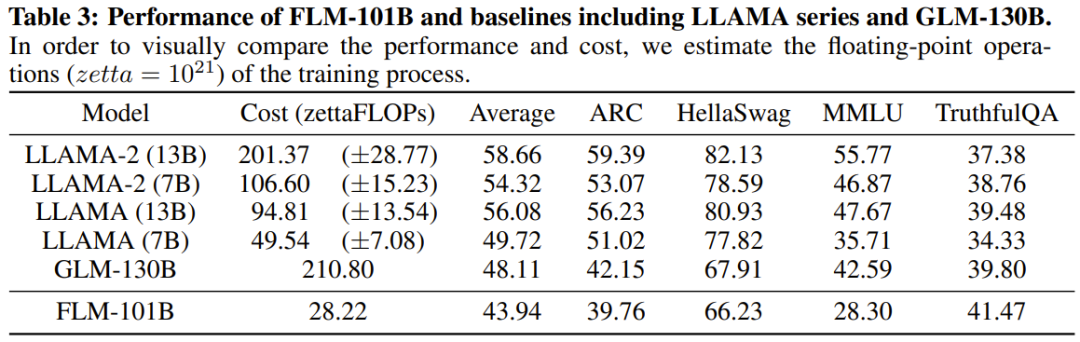

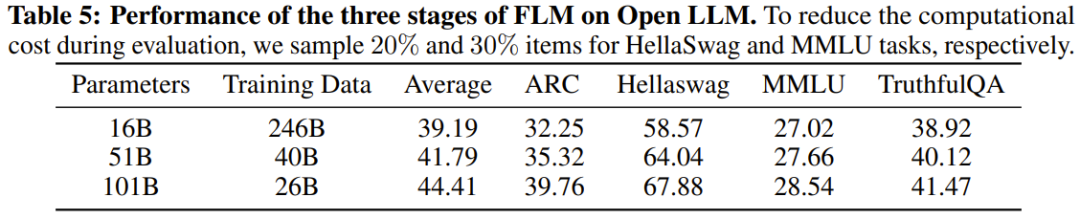

研究者表示,这是一个使用增长策略从头开始训练超过千亿参数的LLM研究尝试。同时,这也是目前成本最低的千亿参数模型,仅需10万美元成本

通过改进 FreeLM 训练目标、有潜力的超参数搜索方法和功能保留型增长,这项研究解决了不稳定问题。研究者相信该方法也能为更广大的科研社区提供助力。

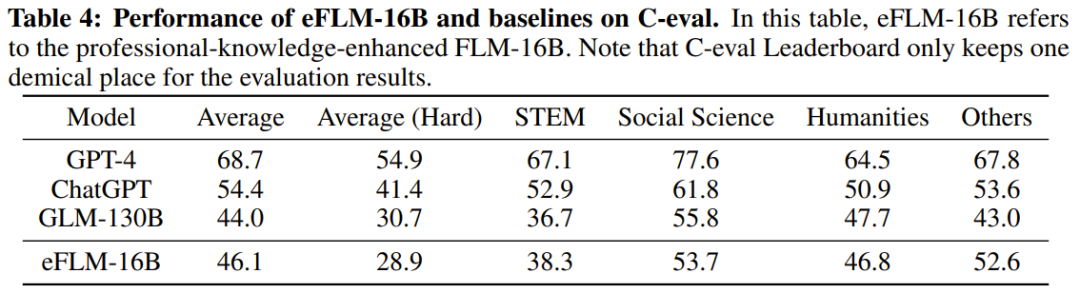

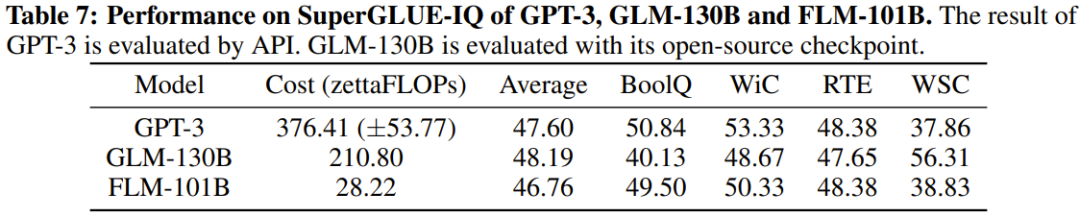

研究人员还对新模型与之前的强大模型进行了实验比较,包括使用面向知识的基准和新提出的系统性IQ评估基准。实验结果显示,FLM-101B模型具有竞争力且稳健

该团队会发布模型检查点、代码、相关工具等,以推进千亿参数规模的汉语和英语双语 LLM 的研究开发。

以上是10万美元+26天,一个低成本千亿参数LLM就诞生了的详细内容。更多信息请关注PHP中文网其他相关文章!

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

Video Face Swap

使用我们完全免费的人工智能换脸工具轻松在任何视频中换脸!

热门文章

热工具

记事本++7.3.1

好用且免费的代码编辑器

SublimeText3汉化版

中文版,非常好用

禅工作室 13.0.1

功能强大的PHP集成开发环境

Dreamweaver CS6

视觉化网页开发工具

SublimeText3 Mac版

神级代码编辑软件(SublimeText3)

大模型App腾讯元宝上线!混元再升级,打造可随身携带的全能AI助理

Jun 09, 2024 pm 10:38 PM

大模型App腾讯元宝上线!混元再升级,打造可随身携带的全能AI助理

Jun 09, 2024 pm 10:38 PM

5月30日,腾讯宣布旗下混元大模型全面升级,基于混元大模型的App“腾讯元宝”正式上线,苹果及安卓应用商店均可下载。相比此前测试阶段的混元小程序版本,面向工作效率场景,腾讯元宝提供了AI搜索、AI总结、AI写作等核心能力;面向日常生活场景,元宝的玩法也更加丰富,提供了多个特色AI应用,并新增了创建个人智能体等玩法。“腾讯做大模型不争一时之先。”腾讯云副总裁、腾讯混元大模型负责人刘煜宏表示:“过去的一年,我们持续推进腾讯混元大模型的能力爬坡,在丰富、海量的业务场景中打磨技术,同时洞察用户的真实需求

字节跳动豆包大模型发布,火山引擎全栈 AI 服务助力企业智能化转型

Jun 05, 2024 pm 07:59 PM

字节跳动豆包大模型发布,火山引擎全栈 AI 服务助力企业智能化转型

Jun 05, 2024 pm 07:59 PM

火山引擎总裁谭待企业要做好大模型落地,面临模型效果、推理成本、落地难度的三大关键挑战:既要有好的基础大模型做支撑,解决复杂难题,也要有低成本的推理服务让大模型被广泛应用,还要更多工具、平台和应用帮助企业做好场景落地。——谭待火山引擎总裁01.豆包大模型首次亮相大使用量打磨好模型模型效果是AI落地最关键的挑战。谭待指出,只有大的使用量,才能打磨出好模型。目前,豆包大模型日均处理1,200亿tokens文本、生成3,000万张图片。为助力企业做好大模型场景落地,字节跳动自主研发的豆包大模型将通过火山

突破传统缺陷检测的界限,\'Defect Spectrum\'首次实现超高精度丰富语义的工业缺陷检测。

Jul 26, 2024 pm 05:38 PM

突破传统缺陷检测的界限,\'Defect Spectrum\'首次实现超高精度丰富语义的工业缺陷检测。

Jul 26, 2024 pm 05:38 PM

在现代制造业中,精准的缺陷检测不仅是保证产品质量的关键,更是提升生产效率的核心。然而,现有的缺陷检测数据集常常缺乏实际应用所需的精确度和语义丰富性,导致模型无法识别具体的缺陷类别或位置。为了解决这一难题,由香港科技大学广州和思谋科技组成的顶尖研究团队,创新性地开发出了“DefectSpectrum”数据集,为工业缺陷提供了详尽、语义丰富的大规模标注。如表一所示,相比其他工业数据集,“DefectSpectrum”数据集提供了最多的缺陷标注(5438张缺陷样本),最细致的缺陷分类(125种缺陷类别

数百万晶体数据训练,解决晶体学相位问题,深度学习方法PhAI登Science

Aug 08, 2024 pm 09:22 PM

数百万晶体数据训练,解决晶体学相位问题,深度学习方法PhAI登Science

Aug 08, 2024 pm 09:22 PM

编辑|KX时至今日,晶体学所测定的结构细节和精度,从简单的金属到大型膜蛋白,是任何其他方法都无法比拟的。然而,最大的挑战——所谓的相位问题,仍然是从实验确定的振幅中检索相位信息。丹麦哥本哈根大学研究人员,开发了一种解决晶体相问题的深度学习方法PhAI,利用数百万人工晶体结构及其相应的合成衍射数据训练的深度学习神经网络,可以生成准确的电子密度图。研究表明,这种基于深度学习的从头算结构解决方案方法,可以以仅2埃的分辨率解决相位问题,该分辨率仅相当于原子分辨率可用数据的10%到20%,而传统的从头算方

英伟达对话模型ChatQA进化到2.0版本,上下文长度提到128K

Jul 26, 2024 am 08:40 AM

英伟达对话模型ChatQA进化到2.0版本,上下文长度提到128K

Jul 26, 2024 am 08:40 AM

开放LLM社区正是百花齐放、竞相争鸣的时代,你能看到Llama-3-70B-Instruct、QWen2-72B-Instruct、Nemotron-4-340B-Instruct、Mixtral-8x22BInstruct-v0.1等许多表现优良的模型。但是,相比于以GPT-4-Turbo为代表的专有大模型,开放模型在很多领域依然还有明显差距。在通用模型之外,也有一些专精关键领域的开放模型已被开发出来,比如用于编程和数学的DeepSeek-Coder-V2、用于视觉-语言任务的InternVL

谷歌AI拿下IMO奥数银牌,数学推理模型AlphaProof面世,强化学习 is so back

Jul 26, 2024 pm 02:40 PM

谷歌AI拿下IMO奥数银牌,数学推理模型AlphaProof面世,强化学习 is so back

Jul 26, 2024 pm 02:40 PM

对于AI来说,奥数不再是问题了。本周四,谷歌DeepMind的人工智能完成了一项壮举:用AI做出了今年国际数学奥林匹克竞赛IMO的真题,并且距拿金牌仅一步之遥。上周刚刚结束的IMO竞赛共有六道赛题,涉及代数、组合学、几何和数论。谷歌提出的混合AI系统做对了四道,获得28分,达到了银牌水平。本月初,UCLA终身教授陶哲轩刚刚宣传了百万美元奖金的AI数学奥林匹克竞赛(AIMO进步奖),没想到7月还没过,AI的做题水平就进步到了这种水平。IMO上同步做题,做对了最难题IMO是历史最悠久、规模最大、最负

工业知识图谱进阶实战

Jun 13, 2024 am 11:59 AM

工业知识图谱进阶实战

Jun 13, 2024 am 11:59 AM

一、背景简介首先来介绍一下云问科技的发展历程。云问科技公...2023年,正是大模型盛行的时期,很多企业认为已经大模型之后图谱的重要性大大降低了,之前研究的预置的信息化系统也都不重要了。不过随着RAG的推广、数据治理的盛行,我们发现更高效的数据治理和高质量的数据是提升私有化大模型效果的重要前提,因此越来越多的企业开始重视知识建设的相关内容。这也推动了知识的构建和加工开始向更高水平发展,其中有很多技巧和方法可以挖掘。可见一个新技术的出现,并不是将所有的旧技术打败,也有可能将新技术和旧技术相互融合后

PRO | 为什么基于 MoE 的大模型更值得关注?

Aug 07, 2024 pm 07:08 PM

PRO | 为什么基于 MoE 的大模型更值得关注?

Aug 07, 2024 pm 07:08 PM

2023年,几乎AI的每个领域都在以前所未有的速度进化,同时,AI也在不断地推动着具身智能、自动驾驶等关键赛道的技术边界。多模态趋势下,Transformer作为AI大模型主流架构的局面是否会撼动?为何探索基于MoE(专家混合)架构的大模型成为业内新趋势?大型视觉模型(LVM)能否成为通用视觉的新突破?...我们从过去的半年发布的2023年本站PRO会员通讯中,挑选了10份针对以上领域技术趋势、产业变革进行深入剖析的专题解读,助您在新的一年里为大展宏图做好准备。本篇解读来自2023年Week50