智源开放3亿条语义向量模型训练数据,BGE模型持续进行迭代更新

随着大型模型的开发和应用火热发展,作为大型模型核心基础组件的Embedding的重要性变得越来越突出。智源公司在一个月前发布的开源可商用的中英文语义向量模型BGE(BAAI General Embedding)在社区中引起了广泛的关注,Hugging Face平台上的下载量已经达到了数十万次。目前,BGE已经快速迭代推出了1.5版本,并公布了多项更新。其中,BGE首次开源了三亿条大规模训练数据,为社区提供了训练类似模型的帮助,推动了该领域技术的发展

- MTP数据集链接:https://data.baai.ac.cn/details/BAAI-MTP

- BGE 模型链接:https://huggingface.co/BAAI

- BGE 代码仓库:https://www.php.cn/link/8944871f1c9865a77a3d9c92cadf124d

3 亿中英向量模型训练数据开放

首次开源的业界语义向量模型训练数据达到了3亿条中英文数据

BGE 的出色能力很大程度上源于其大规模、多样化的训练数据。此前,业界同行鲜有发布同类数据集。在本次更新中,智源首次将 BGE 的训练数据向社区予以开放,为推动此类技术进一步发展打下了基础。

此次发布的数据集 MTP 由总计 3 亿条中英文关联文本对构成。其中,中文记录达 1 亿条,英文数据达 2 亿条。数据的来源包括 Wudao Corpora、Pile、DuReader、Sentence Transformer 等语料。经过必要的采样、抽取和清洗后获得

详细细节请参考 Data Hub:https://data.baai.ac.cn

MTP 为迄今开源的最大规模中英文关联文本对数据集,为训练中英文语义向量模型提供重要基础。

响应开发者社区,BGE 功能升级

根据社区反馈,BGE 在其 1.0 版本的基础上进行了进一步优化,使其表现更加稳定和出色。具体的升级内容如下:

- 模型更新。BGE-*-zh-v1.5 缓解了相似度分布问题,通过对训练数据进行过滤,删除低质量数据,提高训练时温度系数 temperature 至 0.02,使得相似度数值更加平稳 。

- 新增模型。开源 BGE-reranker 交叉编码器模型,可更加精准找到相关文本,支持中英双语。不同于向量模型需要输出向量,BGE-reranker 直接文本对输出相似度,排序准确度更高,可用于对向量召回结果的重新排序,提升最终结果的相关性。

- 新增功能。BGE1.1 增加难负样本挖掘脚本,难负样本可有效提升微调后检索的效果;在微调代码中增加在微调中增加指令的功能;模型保存也将自动转成 sentence transformer 格式,更方便模型加载。

值得一提的是,日前,智源联合 Hugging Face 发布了一篇技术报告,报告提出用 C-Pack 增强中文通用语义向量模型。

《C-Pack: Packaged Resources To Advance General Chinese Embedding》

链接:https://arxiv.org/pdf/2309.07597.pdf

在开发者社区收获高热度

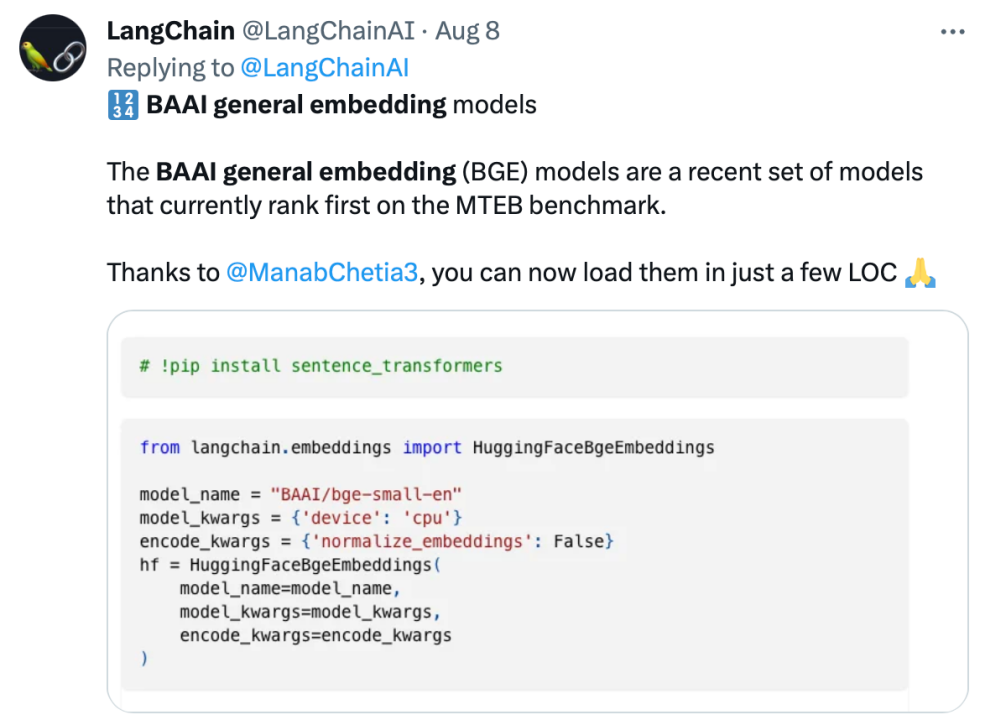

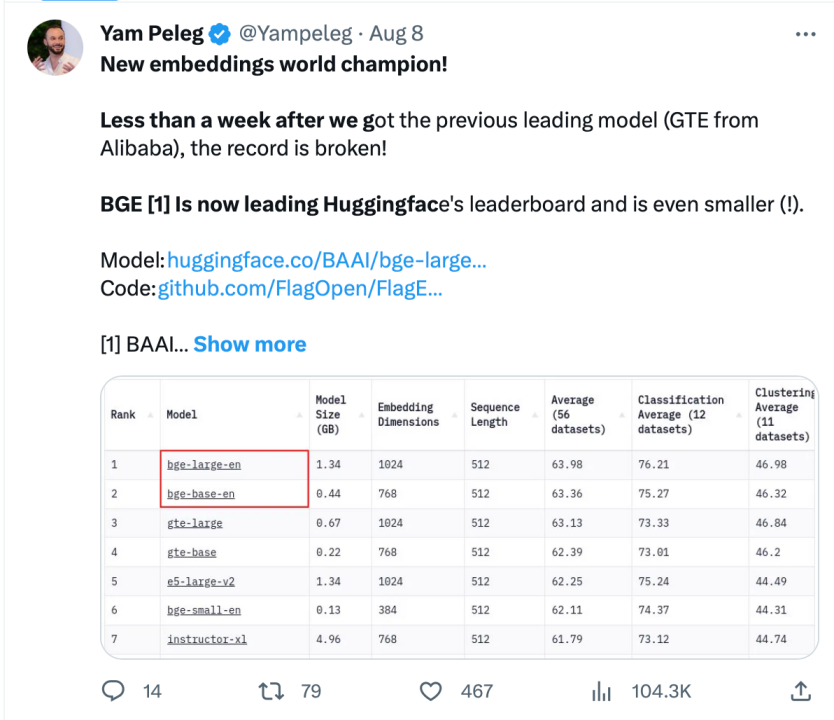

BGE 自发布以来受到了大型模型开发者社区的关注,目前 Hugging Face 的下载量已经达到了数十万次,并且已经被知名的开源项目 LangChain、LangChain-Chatchat、llama_index 等集成使用

Langchain 官方、LangChain 联合创始人兼首席执行官 Harrison Chase、Deep trading 创始人 Yam Peleg 等社区大 V 对 BGE 表示关注。

坚持开源开放,促进协同创新,智源大模型技术开体系 FlagOpen BGE 新增 FlagEmbedding 新版块,专注于 Embedding 技术和模型,BGE 是其中备受瞩目的开源项目之一。FlagOpen 致力于构建大模型时代的人工智能技术基础设施,未来将继续向学术界和产业界开放更完整的大模型全栈技术

以上是智源开放3亿条语义向量模型训练数据,BGE模型持续进行迭代更新的详细内容。更多信息请关注PHP中文网其他相关文章!

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

Video Face Swap

使用我们完全免费的人工智能换脸工具轻松在任何视频中换脸!

热门文章

热工具

记事本++7.3.1

好用且免费的代码编辑器

SublimeText3汉化版

中文版,非常好用

禅工作室 13.0.1

功能强大的PHP集成开发环境

Dreamweaver CS6

视觉化网页开发工具

SublimeText3 Mac版

神级代码编辑软件(SublimeText3)

热门话题

7647

7647

15

15

1392

1392

52

52

91

91

11

11

73

73

19

19

36

36

110

110

web3交易平台排行榜_web3全球交易所前十名汇总

Apr 21, 2025 am 10:45 AM

web3交易平台排行榜_web3全球交易所前十名汇总

Apr 21, 2025 am 10:45 AM

币安是全球数字资产交易生态的霸主,其特点包括:1. 日均交易量突破$1500亿,支持500 交易对,覆盖98%主流币种;2. 创新矩阵涵盖衍生品市场、Web3布局和教育体系;3. 技术优势为毫秒级撮合引擎,峰值处理量达140万笔/秒;4. 合规进展持有15国牌照,并在欧美设立合规实体。

对于加密货币行业来说,'黑色星期一抛售”是艰难的一天

Apr 21, 2025 pm 02:48 PM

对于加密货币行业来说,'黑色星期一抛售”是艰难的一天

Apr 21, 2025 pm 02:48 PM

加密货币市场暴跌引发投资者恐慌,Dogecoin(Doge)成为重灾区之一。其价格大幅下挫,去中心化金融(DeFi)总价值锁定(TVL)也出现显着下降。 “黑色星期一”的抛售潮席卷加密货币市场,Dogecoin首当其冲。其DeFiTVL跌至2023年水平,币价在过去一个月内下跌23.78%。 Dogecoin的DeFiTVL降至272万美元的低点,主要原因是SOSO价值指数下跌26.37%。其他主要DeFi平台,如无聊的Dao和Thorchain,TVL也分别下降了24.04%和20.

十大加密货币交易所平台 世界最大的数字货币交易所榜单

Apr 21, 2025 pm 07:15 PM

十大加密货币交易所平台 世界最大的数字货币交易所榜单

Apr 21, 2025 pm 07:15 PM

在当今的加密货币市场中,交易所扮演着至关重要的角色,它们不仅是投资者进行买卖交易的平台,更是市场流动性和价格发现的重要来源。全球最大的虚拟货币交易所排行前十,这些交易所不仅在交易量上遥遥领先,而且在用户体验、安全性和创新服务方面也各有千秋。排行榜首的交易所通常拥有庞大的用户基础和广泛的市场影响力,它们的交易量和资产种类往往是其他交易所难以企及的。

币圈杠杆交易所排名 币圈十大杠杆交易所APP最新推荐

Apr 21, 2025 pm 11:24 PM

币圈杠杆交易所排名 币圈十大杠杆交易所APP最新推荐

Apr 21, 2025 pm 11:24 PM

2025年在杠杆交易、安全性和用户体验方面表现突出的平台有:1. OKX,适合高频交易者,提供最高100倍杠杆;2. Binance,适用于全球多币种交易者,提供125倍高杠杆;3. Gate.io,适合衍生品专业玩家,提供100倍杠杆;4. Bitget,适用于新手及社交化交易者,提供最高100倍杠杆;5. Kraken,适合稳健型投资者,提供5倍杠杆;6. Bybit,适用于山寨币探索者,提供20倍杠杆;7. KuCoin,适合低成本交易者,提供10倍杠杆;8. Bitfinex,适合资深玩

跨链交易什么意思?跨链交易所有哪些?

Apr 21, 2025 pm 11:39 PM

跨链交易什么意思?跨链交易所有哪些?

Apr 21, 2025 pm 11:39 PM

支持跨链交易的交易所有:1. Binance,2. Uniswap,3. SushiSwap,4. Curve Finance,5. Thorchain,6. 1inch Exchange,7. DLN Trade,这些平台通过各种技术支持多链资产交易。

ETH 升级后新手如何规避亏损

Apr 21, 2025 am 10:03 AM

ETH 升级后新手如何规避亏损

Apr 21, 2025 am 10:03 AM

新手在ETH升级后应采取以下策略规避亏损:1.做好功课,了解ETH基本知识和升级内容;2.控制仓位,小额试水并分散投资;3.制定交易计划,明确目标并设定止损点;4.理性分析,避免情绪化决策;5.选择正规可靠的交易平台;6.考虑长期持有,避免短期波动影响。

紧跟币界网步伐:加密金融与 AaaS 业务投资前景如何

Apr 21, 2025 am 10:42 AM

紧跟币界网步伐:加密金融与 AaaS 业务投资前景如何

Apr 21, 2025 am 10:42 AM

加密金融与AaaS业务的投资前景分析如下:1. 加密金融的机遇包括市场规模增长、监管逐渐明晰和应用场景拓展,但面临市场波动性和技术安全性挑战。2. AaaS业务的机遇在于技术创新推动、数据价值挖掘和应用场景丰富,但挑战包括技术复杂性和市场接受度问题。

币圈交易所前十的平台是哪些?

Apr 21, 2025 pm 12:21 PM

币圈交易所前十的平台是哪些?

Apr 21, 2025 pm 12:21 PM

头部交易所包括:1. 币安(Binance),全球最大交易量,支持600 币种,现货手续费0.1%;2. OKX,均衡型平台,支持708交易对,永续合约手续费0.05%;3. Gate.io,覆盖2700 小币种,现货手续费0.1%-0.3%;4. Coinbase,美国合规标杆,现货手续费0.5%;5. Kraken,安全性顶尖,定期储备审计。