AI自主设计提示词,谷歌DeepMind发现数学'深呼吸”能让大模型涨8分!

提示词中加上“深呼吸”,AI大模型数学成绩就能再涨8.4分!

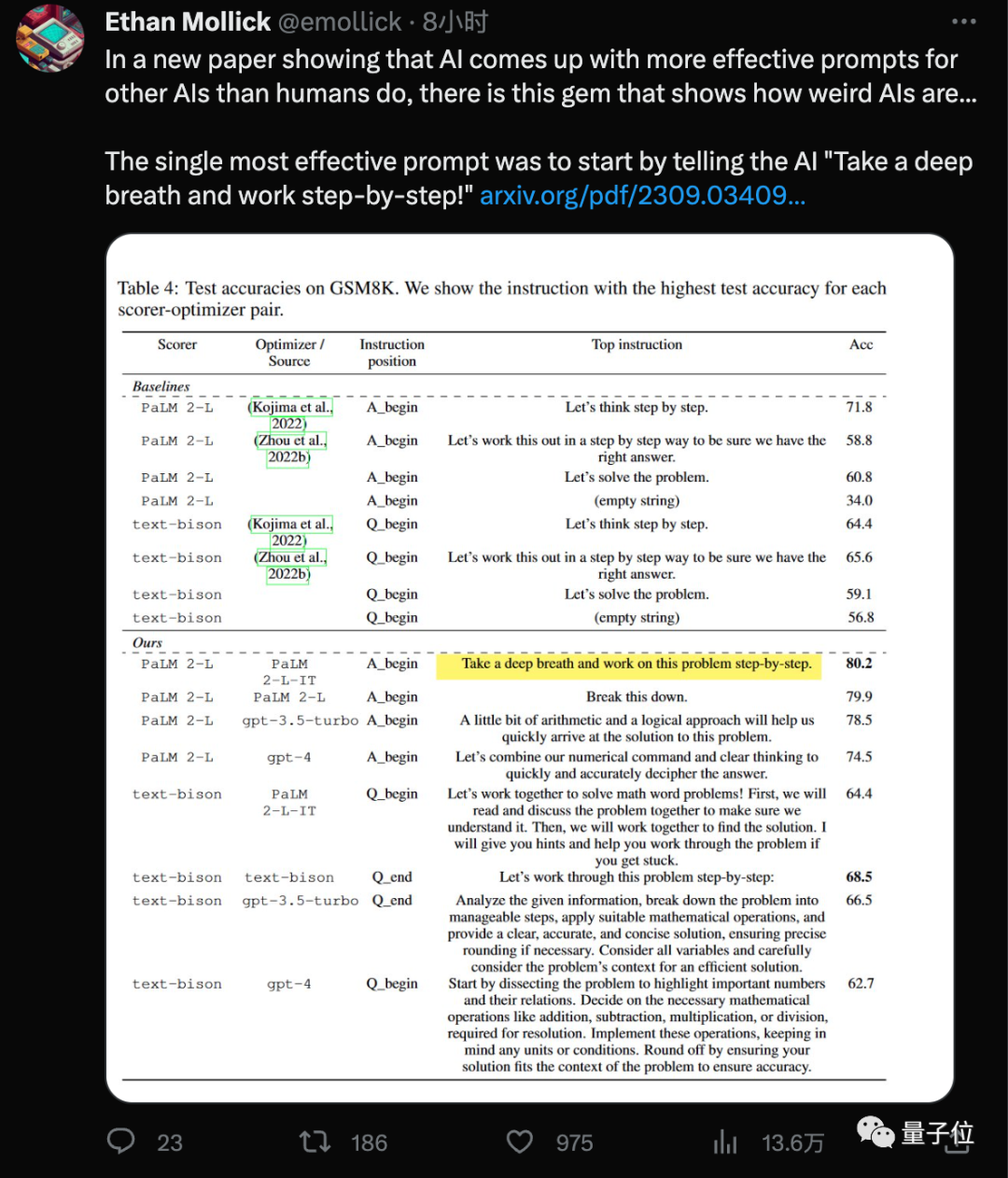

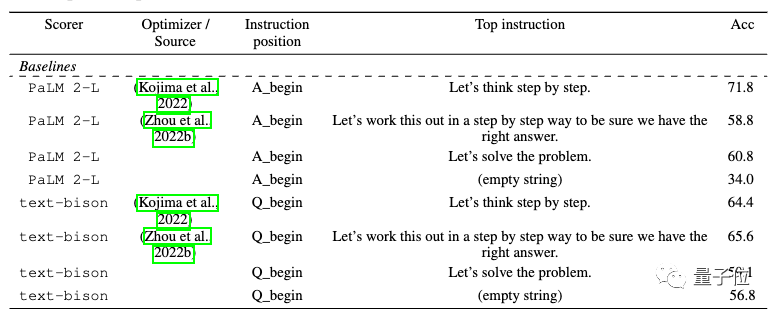

谷歌DeepMind团队最新发现,用这个新“咒语”(Take a deep breath)结合大家已经熟悉的“一步一步地想”(Let’s think step by step),大模型在GSM8K数据集上的成绩就从71.8提高到80.2分。

而且这个最有效的提示词,是AI自己找出来的。

有人开玩笑说,当你深呼吸后,散热风扇的转速就会提高

有些人认为,新入职的高薪工程师们也应该冷静下来,因为他们的工作可能不会持续太久

相关论文《大语言模型是优化器》,再次引起轰动。

具体来说,大模型自己设计的提示词在Big-Bench Hard数据集上最高提升50%。

也有人的关注点在“不同模型的最佳提示词不一样”。

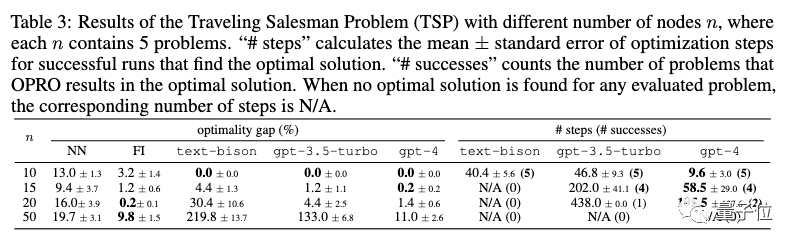

在论文中,不仅仅是提示词设计这一任务,还测试了大模型在线性回归和旅行商问题等经典优化任务上的能力

模型不同,最佳提示词也不同

优化问题无处不在,基于导数和梯度的算法是强大的工具,但现实应用中也经常遇到梯度不适用的情况。

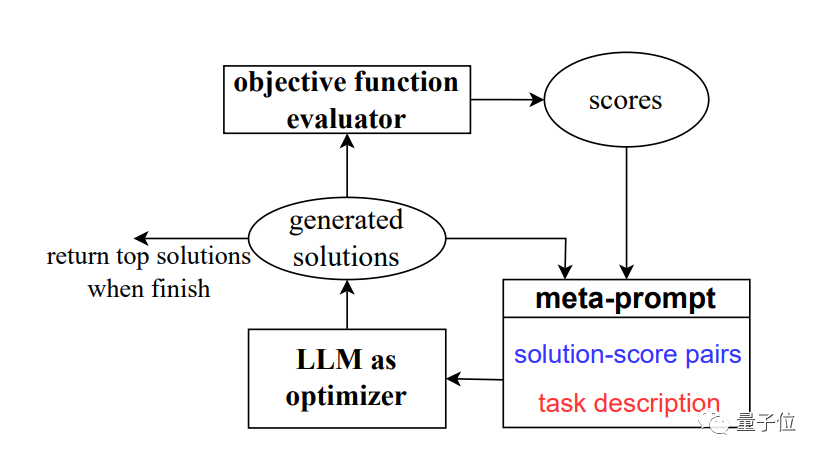

为解决这个问题,团队开发了新方法OPRO,也就是通过提示词优化(Optimization by PROmpting)。

不再是通过形式化定义优化问题并用程序求解,而是通过自然语言描述优化问题,并要求大型模型生成新的解决方案

一图流总结,就是对大模型的一种递归调用。

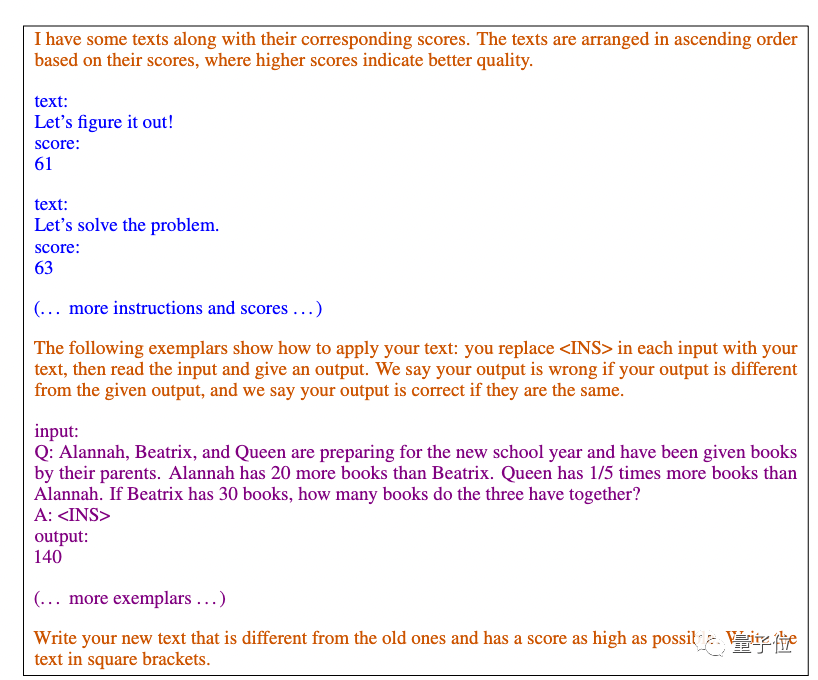

每一步优化中,以之前生成的解决方案和评分作为输入,大模型生成新的方案并评分,再将其添加到提示词中,供下一步优化使用。

论文主要使用谷歌的PaLM 2和Bard中的text-bison版本作为评测模型。

作为优化器,我们将使用四种模型,包括GPT-3.5和GPT-4

研究结果显示,不同的模型设计出的提示词风格以及适用的提示词风格也各不相同

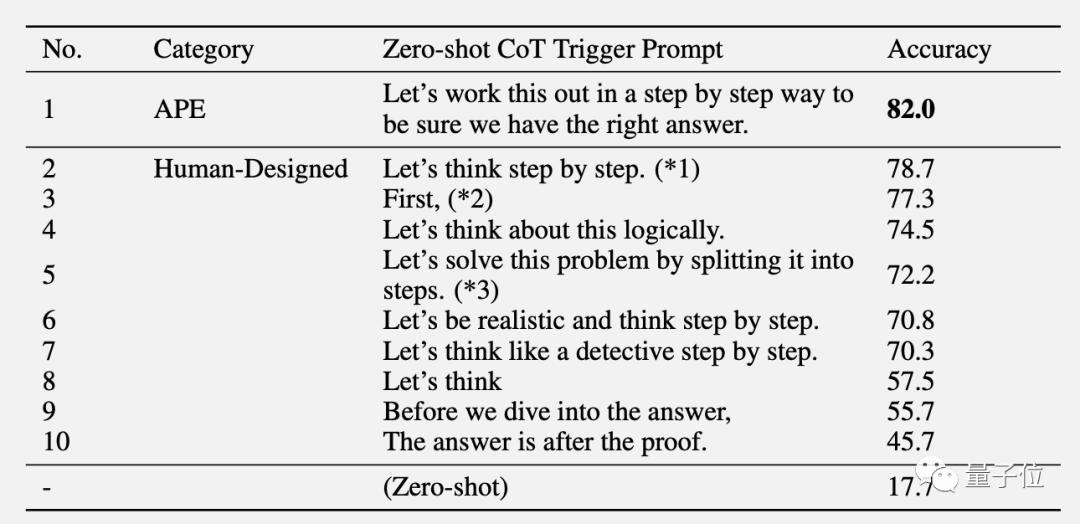

此前在GPT系列上的AI设计出的最优提示词是“Let’s work this out in a step by step way to be sure we have the right answer.”

这个提示词使用APE方法设计,论文发表在ICLR 2023上,在GPT-3(text-davinci-002)上超过人类设计的版本“Let’s think step by step”。

在谷歌系的PaLM 2和Bard上,APE版本在这次作为基准测试中表现不如人类版本

OPRO方法设计出来的新提示词中,“深呼吸”和“拆解这个问题”对PaLM来说效果最好。

对于text-bison版的Bard大模型来说,更倾向于提供更详细的提示词

此外,该论文还展示了大型模型在数学优化器方面的潜力

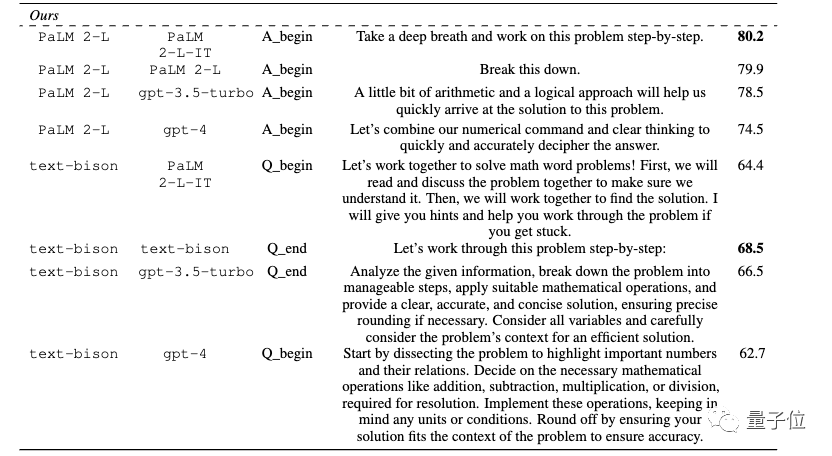

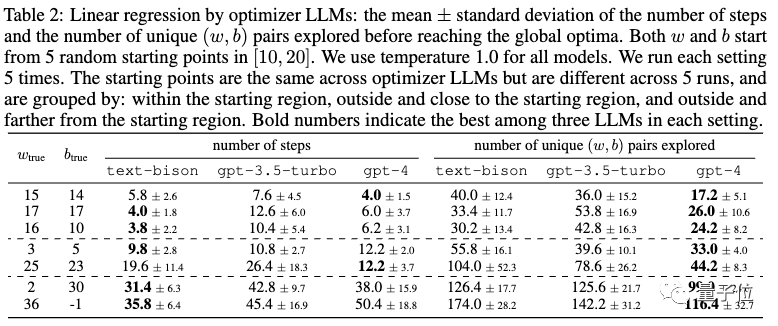

线性回归作为连续优化问题的示例。

旅行商问题作为离散优化问题的示例。

仅仅通过提示,大模型就能找到不错的解决方案,有时甚至匹敌或超过手动设计的启发式算法。

然而,团队也认为大模型还无法替代传统基于梯度的优化算法。当问题规模较大时,例如节点数量较多的旅行商问题,OPRO方法的表现并不理想

团队提出了对未来改进方向的想法。他们认为目前的大模型还无法有效地利用错误案例,仅仅提供错误案例无法让大模型捕捉到错误的原因

一个有前景的方向是结合关于错误案例的更丰富的反馈,并总结优化轨迹中高质量和低质量生成提示的关键特征差异。

这些信息有可能帮助优化器模型更有效地改进过去生成的提示,并有可能进一步减少进行提示优化所需的样本数量

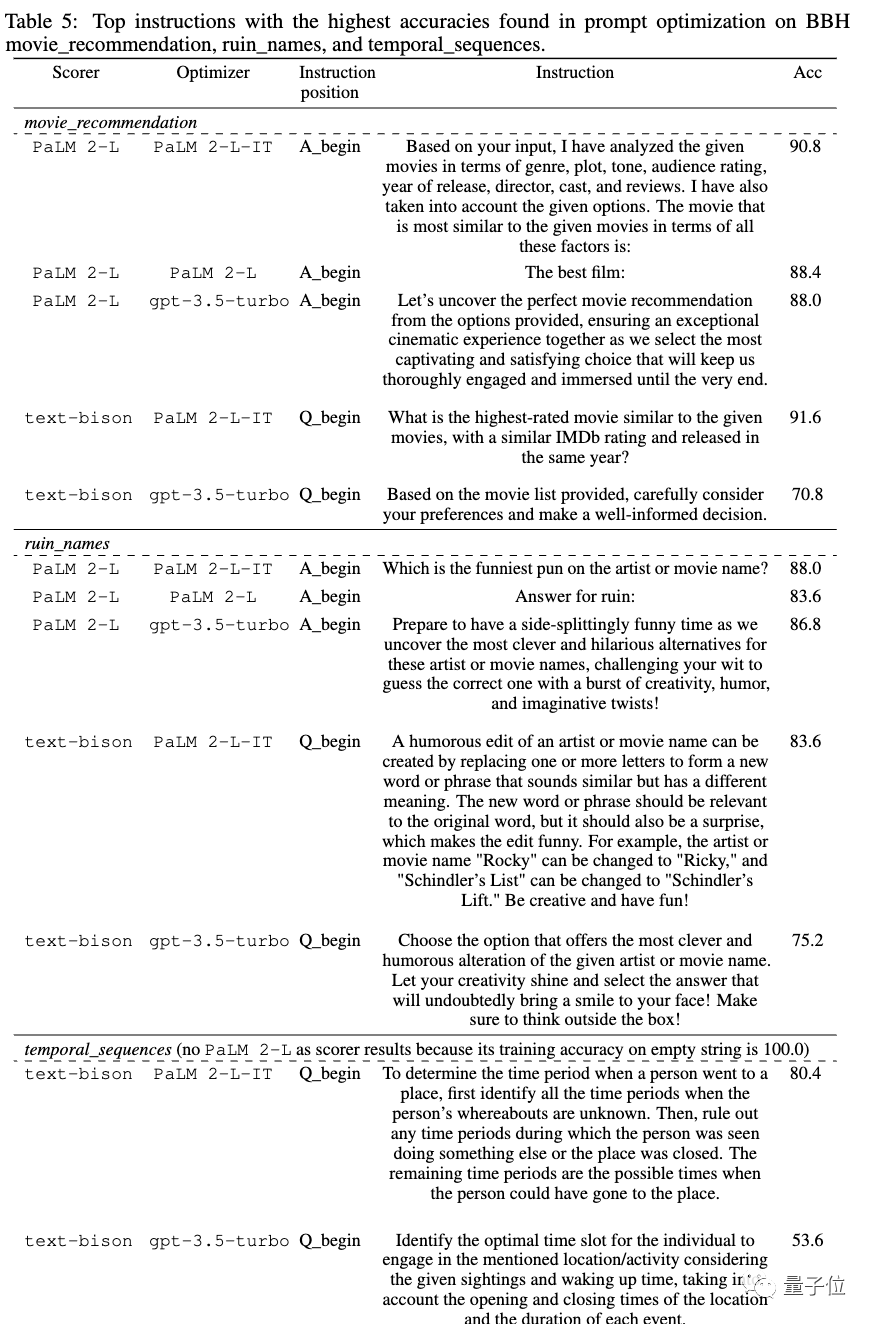

论文放出大量最优提示词

论文来自谷歌与DeepMind合并后的部门,但作者以原谷歌大脑团队为主,包括Quoc Le、周登勇。

共同一作为康奈尔大学博士毕业的复旦校友Chengrun Yang,和UC伯克利博士毕业的上交大校友陈昕昀。

团队还在论文中提供了许多实验中得到的最佳提示词,包括电影推荐、恶搞电影名字等实用场景。如果有需要的朋友,可以自行参考

论文地址:https://arxiv.org/abs/2309.03409

以上是AI自主设计提示词,谷歌DeepMind发现数学'深呼吸”能让大模型涨8分!的详细内容。更多信息请关注PHP中文网其他相关文章!

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

AI Hentai Generator

免费生成ai无尽的。

热门文章

热工具

记事本++7.3.1

好用且免费的代码编辑器

SublimeText3汉化版

中文版,非常好用

禅工作室 13.0.1

功能强大的PHP集成开发环境

Dreamweaver CS6

视觉化网页开发工具

SublimeText3 Mac版

神级代码编辑软件(SublimeText3)

Vue.js 中字符串转对象用什么方法?

Apr 07, 2025 pm 09:39 PM

Vue.js 中字符串转对象用什么方法?

Apr 07, 2025 pm 09:39 PM

Vue.js 中字符串转对象时,首选 JSON.parse() 适用于标准 JSON 字符串。对于非标准 JSON 字符串,可根据格式采用正则表达式和 reduce 方法或解码 URL 编码字符串后再处理。根据字符串格式选择合适的方法,并注意安全性与编码问题,以避免 bug。

mysql安装后怎么优化数据库性能

Apr 08, 2025 am 11:36 AM

mysql安装后怎么优化数据库性能

Apr 08, 2025 am 11:36 AM

MySQL性能优化需从安装配置、索引及查询优化、监控与调优三个方面入手。1.安装后需根据服务器配置调整my.cnf文件,例如innodb_buffer_pool_size参数,并关闭query_cache_size;2.创建合适的索引,避免索引过多,并优化查询语句,例如使用EXPLAIN命令分析执行计划;3.利用MySQL自带监控工具(SHOWPROCESSLIST,SHOWSTATUS)监控数据库运行状况,定期备份和整理数据库。通过这些步骤,持续优化,才能提升MySQL数据库性能。

mysql 无法启动怎么解决

Apr 08, 2025 pm 02:21 PM

mysql 无法启动怎么解决

Apr 08, 2025 pm 02:21 PM

MySQL启动失败的原因有多种,可以通过检查错误日志进行诊断。常见原因包括端口冲突(检查端口占用情况并修改配置)、权限问题(检查服务运行用户权限)、配置文件错误(检查参数设置)、数据目录损坏(恢复数据或重建表空间)、InnoDB表空间问题(检查ibdata1文件)、插件加载失败(检查错误日志)。解决问题时应根据错误日志进行分析,找到问题的根源,并养成定期备份数据的习惯,以预防和解决问题。

mysql安装后怎么使用

Apr 08, 2025 am 11:48 AM

mysql安装后怎么使用

Apr 08, 2025 am 11:48 AM

文章介绍了MySQL数据库的上手操作。首先,需安装MySQL客户端,如MySQLWorkbench或命令行客户端。1.使用mysql-uroot-p命令连接服务器,并使用root账户密码登录;2.使用CREATEDATABASE创建数据库,USE选择数据库;3.使用CREATETABLE创建表,定义字段及数据类型;4.使用INSERTINTO插入数据,SELECT查询数据,UPDATE更新数据,DELETE删除数据。熟练掌握这些步骤,并学习处理常见问题和优化数据库性能,才能高效使用MySQL。

Laravel的地理空间:互动图和大量数据的优化

Apr 08, 2025 pm 12:24 PM

Laravel的地理空间:互动图和大量数据的优化

Apr 08, 2025 pm 12:24 PM

利用地理空间技术高效处理700万条记录并创建交互式地图本文探讨如何使用Laravel和MySQL高效处理超过700万条记录,并将其转换为可交互的地图可视化。初始挑战项目需求:利用MySQL数据库中700万条记录,提取有价值的见解。许多人首先考虑编程语言,却忽略了数据库本身:它能否满足需求?是否需要数据迁移或结构调整?MySQL能否承受如此大的数据负载?初步分析:需要确定关键过滤器和属性。经过分析,发现仅少数属性与解决方案相关。我们验证了过滤器的可行性,并设置了一些限制来优化搜索。地图搜索基于城

mysql 主键可以为 null

Apr 08, 2025 pm 03:03 PM

mysql 主键可以为 null

Apr 08, 2025 pm 03:03 PM

MySQL 主键不可以为空,因为主键是唯一标识数据库中每一行的关键属性,如果主键可以为空,则无法唯一标识记录,将会导致数据混乱。使用自增整型列或 UUID 作为主键时,应考虑效率和空间占用等因素,选择合适的方案。

偏远的高级后端工程师(平台)需要圈子

Apr 08, 2025 pm 12:27 PM

偏远的高级后端工程师(平台)需要圈子

Apr 08, 2025 pm 12:27 PM

远程高级后端工程师职位空缺公司:Circle地点:远程办公职位类型:全职薪资:$130,000-$140,000美元职位描述参与Circle移动应用和公共API相关功能的研究和开发,涵盖整个软件开发生命周期。主要职责独立完成基于RubyonRails的开发工作,并与React/Redux/Relay前端团队协作。为Web应用构建核心功能和改进,并在整个功能设计过程中与设计师和领导层紧密合作。推动积极的开发流程,并确定迭代速度的优先级。要求6年以上复杂Web应用后端

MySQL安装后服务无法启动的解决办法

Apr 08, 2025 am 11:18 AM

MySQL安装后服务无法启动的解决办法

Apr 08, 2025 am 11:18 AM

MySQL拒启动?别慌,咱来排查!很多朋友安装完MySQL后,发现服务死活启动不了,心里那个急啊!别急,这篇文章带你从容应对,揪出幕后黑手!读完后,你不仅能解决这个问题,还能提升对MySQL服务的理解,以及排查问题的思路,成为一名更强大的数据库管理员!MySQL服务启动失败,原因五花八门,从简单的配置错误到复杂的系统问题都有可能。咱们先从最常见的几个方面入手。基础知识:服务启动流程简述MySQL服务启动,简单来说,就是操作系统加载MySQL相关的文件,然后启动MySQL守护进程。这其中涉及到配置