准备图像AI项目数据集的七个步骤

译者 | 陈峻

重楼 | 审校

不知你是否注意到,数据集可能是机器学习项目中最容易被忽视的部分。在大多数人看来,数据集不过是一些快速拼凑、或已下载的预制图像的集合。而实际上,数据集是任何基于图像的人工智能(AI)项目的基石。对于任何旨在实现高准确性的机器学习项目来说,创建和管理一个平衡且结构合理的数据集,都是至关重要的。

不过,创建一个数据集并不像收集几百张图片那么简单。我们在尝试启动某个AI项目时,很可能会遇到各种隐患。下面,我将和您讨论可用来创建自己的数据集的七个典型步骤,以便您深入了解数据集大小的重要性、可能出现的数据遗漏、以及将数据集转化为数据库等要素。

注意:这些步骤将主要适用于,那些针对包含了图像数据集的对象检测和分类项目。而诸如 NLP 或图形项目等其他项目类型,则需要采用不同的方法。

步骤 1:图像大小

通常情况下,神经网络只能处理特定尺寸的图像,超过阈值的图像会被强制缩小。这意味着在使用数据集之前,我们需要选择适合的神经网络,并相应地调整图像的尺寸

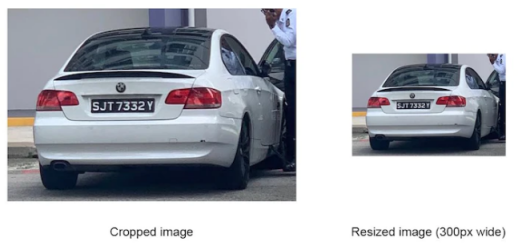

正如您所知,如果将图像尺寸缩小,可能会导致精确度大幅下降,甚至使图像上的小物体消失,从而对整个识别过程造成损害。如下所示,您需要在监控摄像头所拍摄的图像中检测出车牌号码,而车牌只占整个图像的一小部分。因此,当神经网络对图像进行缩小处理时,车牌号码可能会变得非常小,无法被识别到

如下图所示,如果能够了解网络可使用的图像尺寸,将有助于您裁剪出适当的数据集图像。

虽然大多数神经网络可处理的图像尺寸都比较小,但是诸如 Yolo v5x6之类的最新神经网络,则能够处理更大分辨率的图像。例如,Yolo v5xs6就能够处理宽达 1280 像素的图像。

步骤 2:了解您的环境

为了确保数据集能够准确反映神经网络在运行过程中所需识别的真实图像,我们在收集数据集时需要注意以下因素:

- 摄像头的类型,是智能手机摄像头,还是安全摄像头

- 图像的大小

- 摄像头的位置,是在室内,还是室外

- 天气条件,如光照、雨、雾、雪等。

在清楚了解了神经网络待处理的真实图像后,我们就能够创建一个数据集,来准确地反映那些感兴趣的对象、及其所处的环境。

收集谷歌上的普通图片可能被认为是组建大型数据集最简单、最快捷的方法。然而,这种方法实际上很难达到较高的精确度要求。如下图所示,与真实相机拍摄的图像相比,谷歌或照片数据库中的图像通常经过“美颜”处理

而一个过于“漂亮”的数据集,很可能会导致较高的测试准确率。这意味着,神经网络将仅能在测试数据(从数据集中提纯过的图像集合)上良好运行,但在真实条件下运行不佳,并导致准确率低下。

步骤 3:格式和注释

我们需要注意的另一个重要方面是:图片的格式。在开始项目之前,请检查您选择的框架能够支持哪些格式,而您的图片是否能够符合此类要求。虽然当前的框架已能够支持多种图片格式,但是对于 .jfif等格式仍存在问题。

注释数据可以被用来详细地说明边界框、文件名、以及可以采用的不同结构。通常,不同的神经网络和框架,需要不同的注释方法。有些需要包含边界框位置的绝对坐标,有些则需要相对坐标;有些要求每幅图像都附带有一个单独的、包含了注释的.txt 文件,而另一些仅需要一个包含了所有注释的文件。可见,即使您的数据集拥有良好的图像,如果您的框架无法处理注释的话,也将无济于事。

步骤 4:训练和验证子集

为了训练的目的,通常将数据集分为两个子集:

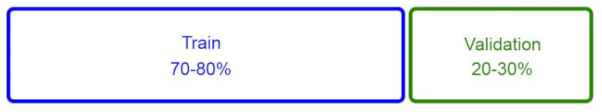

- 训练子集- 它是一组图像。神经网络将会在这组图像上进行训练。其占比为图像总数的 70% 至 80%。

- 验证子集- 是用于检查神经网络在训练过程中学习效果的较小图像集。其占比为图像总数的 20% 到 30% 之间。

通常,神经网络会使用从训练子集中提取到的物体特征,来“学习”物体的外观。也就是说,在一个训练周期结束(历时,epoch)后,神经网络会查看验证子集的数据,并尝试猜测它能够 “看 ”到那些物体。无论是正确的、还是错误的猜测,其结构都能够让神经网络进一步去深入学习。

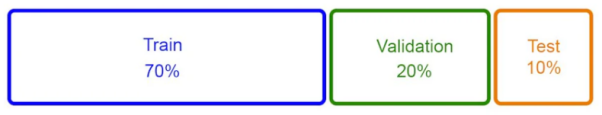

虽然这种方法已被广泛使用,并被证明能够取得良好的效果,但我们更倾向于采用一种不同的方法,将数据集划分为如下子集:

- 训练子集 - 占图像总数的 70%

- 验证子集 - 占图像总数的 20%

- 测试数据集 - 约占图像总数的10%

由于测试子集包含了神经网络从未见过的数据集中的图像,因此开发人员可以通过该子集来测试模型,以了解其手动运行的效果,以及在处理哪些图像时会遇到困难。换句话说,该子集将有助于在项目启动前,找出神经网络可能犯错的地方,进而避免在项目启动之后,进行过多的重新训练

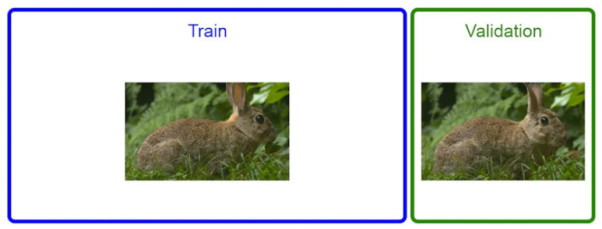

步骤 5:数据遗漏

如果您用来训练机器学习算法的数据中,恰好包含了您试图预测的信息,那么就可能发生数据泄露。如下图所示,从图像识别的角度来看,当训练子集和验证子集中的同一对象的照片非常相似时,就会发生数据泄露。显然,数据遗漏对于神经网络的质量来说是极为不利的。

从本质上说,模型在训练数据集中看到了一幅图像后,会先提取其特征,然后进入验证数据集,进而发现看到的完全相同(或非常相似)的图像。因此,与其说模型在真实学习,不如说它只是在记忆各种信息。有时,这会导致验证数据集上的准确率,高得离谱(例如,可高达 98%),但是在生产实际中的准确率却非常低。

目前最常用的一种数据集分割方法是:将数据随机打乱,然后选取前 70% 的图像放入训练子集,剩下的 30% 则放入验证子集。这种方法就容易导致数据遗漏的产生。如下图所示,我们的当务之急是从数据集中删除所有“重复”的照片,并检查两个子集中是否存在相似的照片。

对此,我们可以使用简单的脚本来自动执行重复删除。当然,您可以调整重复阈值,比如:只删除完全重复的图片、或相似度高达到 90% 的图片等。总的说来,只要删除的重复内容越多,神经网络的生产精度就会越高。

步骤 6:大型数据集数据库

如果您的数据集相当大,例如:超过 10万 幅图像、以及具有几十个对象类与子类的话,我们建议您创建一个简单的数据库,来存储数据集信息。这背后的原因其实非常简单:对于大型数据集而言,我们很难跟踪所有的数据。因此,如果不对数据进行某种结构化的处理,我们将无法对其进行准确分析。

通过数据库,您可以快速地诊断数据集,进而发现诸如:特定类别的图片数量过少,会导致神经网络难以识别出对象;类别之间的图片分布不够均匀;特定类别中的谷歌图片数量过多,导致该类别的准确率得分过低等情况。

通过简单的数据库,我们可以包含如下信息:

- 文件名

- 文件路径

- 注释数据

- 类数据

- 数据源(源自生产环境、还是谷歌等)

- 对象类型、名称等对象相关信息

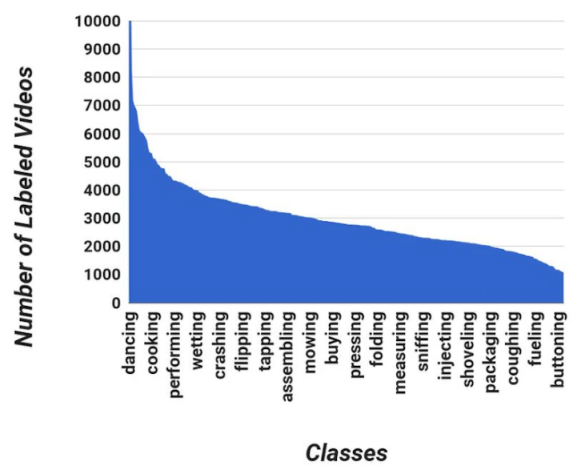

数据库是收集数据集、统计数据不可或缺的工具。它能够帮助我们快速、轻松地查看数据集的平衡程度,以及每个类别中高质量图像的数量(从神经网络的角度来看)。通过类似下面直观呈现的数据,我们可以更快地进行分析,并将其与识别结果进行比较,从而找出准确率低下的根本原因

需要重新写作的内容是:一个值得注意的问题是,准确率低的原因可能是因为图片数量较少或某一类别中谷歌照片的比例较高。通过创建这样的数据库,可以大大减少生产、测试和模型再训练的时间

步骤 7:数据集增强

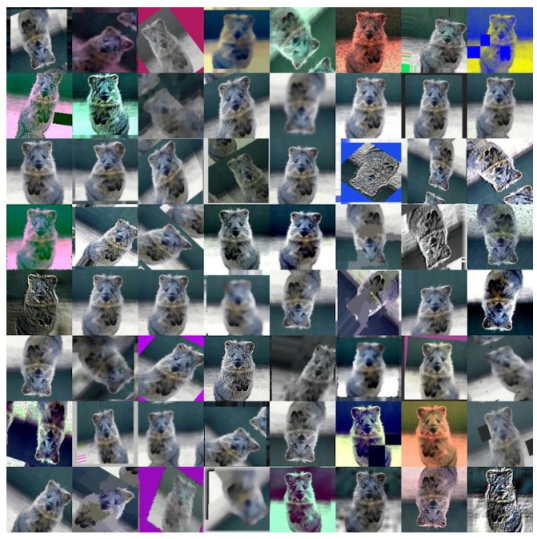

作为一种用于增加图像数量的技术,数据增强是对数据进行简单或复杂转换的过程,例如通过翻转或样式转化,我们可以提高数据的有效性。而据此获得的有效数据集,则无需经历过多的训练。如下图所示,此类数据转换既可以是简单到仅将图像旋转 90 度,也可以复杂到在图像中添加太阳耀斑、以模仿背光照片或镜头耀斑。

通常,此类增强转化都是自动执行的。例如,我们可以准备一个专门用于数据增强的 Python 库。目前,数据增强有两种类型:

- 训练前增强- 在训练过程开始之前,对数据进行扩增,并将其添加到训练子集中。当然,只有在数据集被划分为训练子集和验证子集之后,我们才能进行此类增加,以避免出现前文提到的数据遗漏。

- 训练内增强- 采用类似 PyTorch的框架内置图像变换技术。

值得注意的是,将数据集的大小增加十倍,并不会使得神经网络的效率提高十倍。事实上,这反而可能会使网络的性能比以前更差。因此,我们应当只使用与生产环境相关的增强功能。例如,对于被安装在建筑物内的摄像机,在其正常运行的情况下,是不会出现雨淋的。因此我们完全没有必要在图像中添加针对“雨景”的增强。

小结

尽管对于那些希望将AI应用到业务中的人们来说,数据集是最不令人兴奋的部分。但不可否认的是,数据集是任何图像识别项目中的重要部分。而且在大多数图像识别项目中,数据集的管理和整理,往往会花费团队大量的时间。最后,让我们小结一下,该如何通过恰当地处置数据集,以便从AI项目中获得最佳结果:

- 裁剪或调整图像的大小,以满足神经网络的要求

- 根据天气和照明条件,采集真实图像

- 根据神经网络的要求,构建注释

- 避免使用所有的图像来训练网络。而需留一部分用于测试

- 删除验证数据集中的重复图像,以避免数据遗漏

- 创建数据库,以快速诊断数据集

- 尽量少用数据增强,来增加图像数量

译者介绍

陈峻(Julian Chen),51CTO社区编辑,具有十多年的IT项目实施经验,善于对内外部资源与风险实施管控,专注传播网络与信息安全知识与经验。

原文标题:7 Steps To Prepare A Dataset For An Image-Based AI Project,作者:Oleg Kokorin

以上是准备图像AI项目数据集的七个步骤的详细内容。更多信息请关注PHP中文网其他相关文章!

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

Video Face Swap

使用我们完全免费的人工智能换脸工具轻松在任何视频中换脸!

热门文章

热工具

记事本++7.3.1

好用且免费的代码编辑器

SublimeText3汉化版

中文版,非常好用

禅工作室 13.0.1

功能强大的PHP集成开发环境

Dreamweaver CS6

视觉化网页开发工具

SublimeText3 Mac版

神级代码编辑软件(SublimeText3)

字节跳动剪映推出 SVIP 超级会员:连续包年 499 元,提供多种 AI 功能

Jun 28, 2024 am 03:51 AM

字节跳动剪映推出 SVIP 超级会员:连续包年 499 元,提供多种 AI 功能

Jun 28, 2024 am 03:51 AM

本站6月27日消息,剪映是由字节跳动旗下脸萌科技开发的一款视频剪辑软件,依托于抖音平台且基本面向该平台用户制作短视频内容,并兼容iOS、安卓、Windows、MacOS等操作系统。剪映官方宣布会员体系升级,推出全新SVIP,包含多种AI黑科技,例如智能翻译、智能划重点、智能包装、数字人合成等。价格方面,剪映SVIP月费79元,年费599元(本站注:折合每月49.9元),连续包月则为59元每月,连续包年为499元每年(折合每月41.6元)。此外,剪映官方还表示,为提升用户体验,向已订阅了原版VIP

使用Rag和Sem-Rag提供上下文增强AI编码助手

Jun 10, 2024 am 11:08 AM

使用Rag和Sem-Rag提供上下文增强AI编码助手

Jun 10, 2024 am 11:08 AM

通过将检索增强生成和语义记忆纳入AI编码助手,提升开发人员的生产力、效率和准确性。译自EnhancingAICodingAssistantswithContextUsingRAGandSEM-RAG,作者JanakiramMSV。虽然基本AI编程助手自然有帮助,但由于依赖对软件语言和编写软件最常见模式的总体理解,因此常常无法提供最相关和正确的代码建议。这些编码助手生成的代码适合解决他们负责解决的问题,但通常不符合各个团队的编码标准、惯例和风格。这通常会导致需要修改或完善其建议,以便将代码接受到应

七个很酷的GenAI & LLM技术性面试问题

Jun 07, 2024 am 10:06 AM

七个很酷的GenAI & LLM技术性面试问题

Jun 07, 2024 am 10:06 AM

想了解更多AIGC的内容,请访问:51CTOAI.x社区https://www.51cto.com/aigc/译者|晶颜审校|重楼不同于互联网上随处可见的传统问题库,这些问题需要跳出常规思维。大语言模型(LLM)在数据科学、生成式人工智能(GenAI)和人工智能领域越来越重要。这些复杂的算法提升了人类的技能,并在诸多行业中推动了效率和创新性的提升,成为企业保持竞争力的关键。LLM的应用范围非常广泛,它可以用于自然语言处理、文本生成、语音识别和推荐系统等领域。通过学习大量的数据,LLM能够生成文本

微调真的能让LLM学到新东西吗:引入新知识可能让模型产生更多的幻觉

Jun 11, 2024 pm 03:57 PM

微调真的能让LLM学到新东西吗:引入新知识可能让模型产生更多的幻觉

Jun 11, 2024 pm 03:57 PM

大型语言模型(LLM)是在巨大的文本数据库上训练的,在那里它们获得了大量的实际知识。这些知识嵌入到它们的参数中,然后可以在需要时使用。这些模型的知识在训练结束时被“具体化”。在预训练结束时,模型实际上停止学习。对模型进行对齐或进行指令调优,让模型学习如何充分利用这些知识,以及如何更自然地响应用户的问题。但是有时模型知识是不够的,尽管模型可以通过RAG访问外部内容,但通过微调使用模型适应新的领域被认为是有益的。这种微调是使用人工标注者或其他llm创建的输入进行的,模型会遇到额外的实际知识并将其整合

你所不知道的机器学习五大学派

Jun 05, 2024 pm 08:51 PM

你所不知道的机器学习五大学派

Jun 05, 2024 pm 08:51 PM

机器学习是人工智能的重要分支,它赋予计算机从数据中学习的能力,并能够在无需明确编程的情况下改进自身能力。机器学习在各个领域都有着广泛的应用,从图像识别和自然语言处理到推荐系统和欺诈检测,它正在改变我们的生活方式。机器学习领域存在着多种不同的方法和理论,其中最具影响力的五种方法被称为“机器学习五大派”。这五大派分别为符号派、联结派、进化派、贝叶斯派和类推学派。1.符号学派符号学(Symbolism),又称为符号主义,强调利用符号进行逻辑推理和表达知识。该学派认为学习是一种逆向演绎的过程,通过已有的

为大模型提供全新科学复杂问答基准与测评体系,UNSW、阿贡、芝加哥大学等多家机构联合推出SciQAG框架

Jul 25, 2024 am 06:42 AM

为大模型提供全新科学复杂问答基准与测评体系,UNSW、阿贡、芝加哥大学等多家机构联合推出SciQAG框架

Jul 25, 2024 am 06:42 AM

编辑|ScienceAI问答(QA)数据集在推动自然语言处理(NLP)研究发挥着至关重要的作用。高质量QA数据集不仅可以用于微调模型,也可以有效评估大语言模型(LLM)的能力,尤其是针对科学知识的理解和推理能力。尽管当前已有许多科学QA数据集,涵盖了医学、化学、生物等领域,但这些数据集仍存在一些不足。其一,数据形式较为单一,大多数为多项选择题(multiple-choicequestions),它们易于进行评估,但限制了模型的答案选择范围,无法充分测试模型的科学问题解答能力。相比之下,开放式问答

SK 海力士 8 月 6 日将展示 AI 相关新品:12 层 HBM3E、321-high NAND 等

Aug 01, 2024 pm 09:40 PM

SK 海力士 8 月 6 日将展示 AI 相关新品:12 层 HBM3E、321-high NAND 等

Aug 01, 2024 pm 09:40 PM

本站8月1日消息,SK海力士今天(8月1日)发布博文,宣布将出席8月6日至8日,在美国加利福尼亚州圣克拉拉举行的全球半导体存储器峰会FMS2024,展示诸多新一代产品。未来存储器和存储峰会(FutureMemoryandStorage)简介前身是主要面向NAND供应商的闪存峰会(FlashMemorySummit),在人工智能技术日益受到关注的背景下,今年重新命名为未来存储器和存储峰会(FutureMemoryandStorage),以邀请DRAM和存储供应商等更多参与者。新产品SK海力士去年在

SOTA性能,厦大多模态蛋白质-配体亲和力预测AI方法,首次结合分子表面信息

Jul 17, 2024 pm 06:37 PM

SOTA性能,厦大多模态蛋白质-配体亲和力预测AI方法,首次结合分子表面信息

Jul 17, 2024 pm 06:37 PM

编辑|KX在药物研发领域,准确有效地预测蛋白质与配体的结合亲和力对于药物筛选和优化至关重要。然而,目前的研究没有考虑到分子表面信息在蛋白质-配体相互作用中的重要作用。基于此,来自厦门大学的研究人员提出了一种新颖的多模态特征提取(MFE)框架,该框架首次结合了蛋白质表面、3D结构和序列的信息,并使用交叉注意机制进行不同模态之间的特征对齐。实验结果表明,该方法在预测蛋白质-配体结合亲和力方面取得了最先进的性能。此外,消融研究证明了该框架内蛋白质表面信息和多模态特征对齐的有效性和必要性。相关研究以「S