新标题:TextDiffuser:无惧图像中的文字,提供更高质量的文本渲染

在过去几年中,Text-to-Image 领域取得了巨大的进展,特别是在人工智能生成内容(AIGC)的时代。随着DALL-E模型的兴起,学术界涌现出越来越多的Text-to-Image模型,比如Imagen、Stable Diffusion、ControlNet等模型。然而,尽管Text-to-Image领域发展迅速,现有模型在稳定地生成包含文本的图像方面仍然面临一些挑战

尝试过现有 sota 文生图模型可以发现,模型生成的文字部分基本上是不可读的,类似于乱码,这非常影响图像的整体美观度。

现有的sota文本生成模型生成的文本信息可读性较差

经过调研,学术界在这方面的研究较少。事实上,包含文本的图像在日常生活中十分常见,例如海报、书籍封面和路牌等。如果 AI 能够有效地生成这类图像,将有助于辅助设计师的工作,激发设计灵感,减轻设计负担。除此之外,用户可能只希望修改文生图模型结果的文字部分,保留其他非文本区域的结果。

为了不改变原始意思,需要将内容改写成中文。不需要出现原句

- 论文地址:https://arxiv.org/abs/2305.10855

- 项目地址:https://jingyechen.github.io/textdiffuser/

- 代码地址:https://github.com/microsoft/unilm/tree/master/textdiffuser

- Demo地址:https://huggingface.co/spaces/microsoft/TextDiffuser

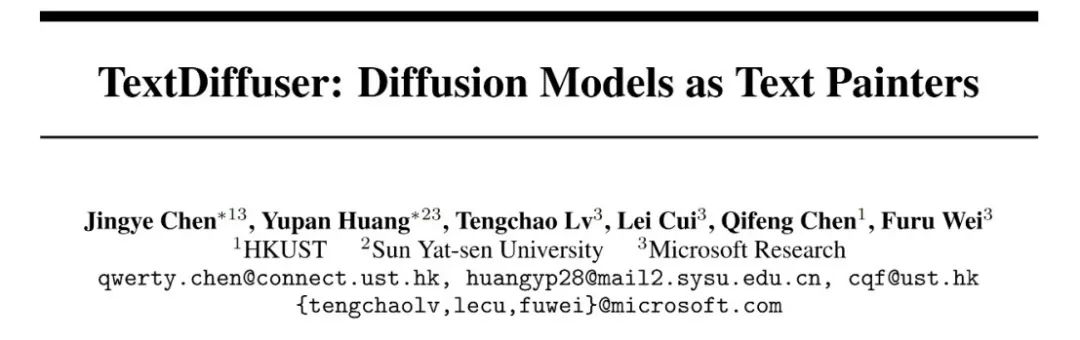

TextDiffuser 的三个功能

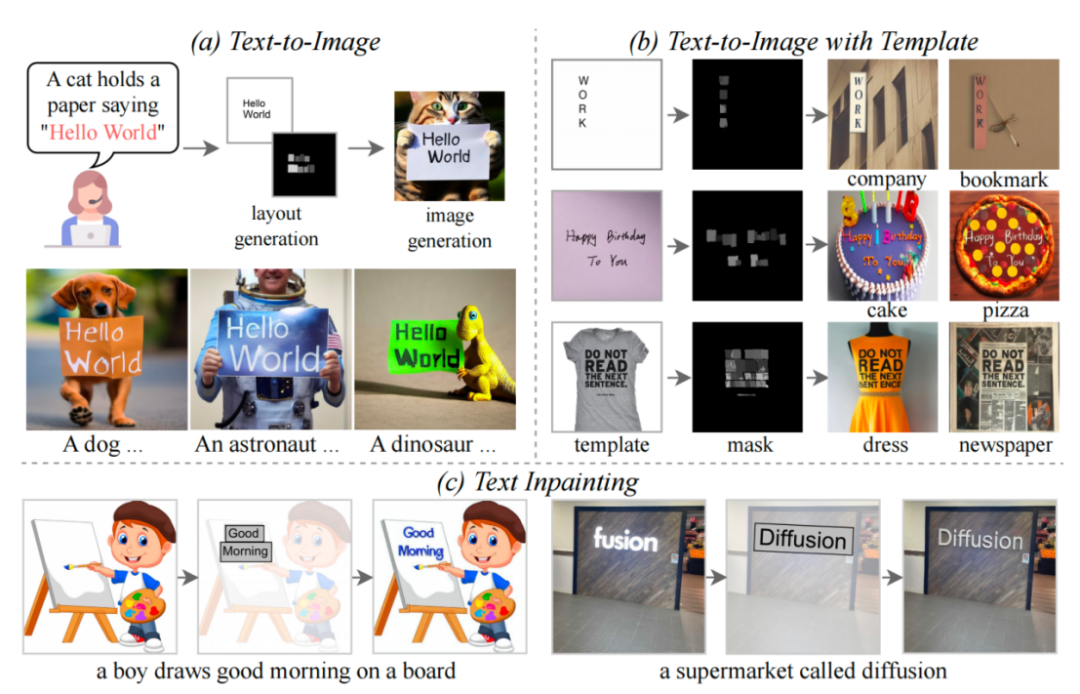

本文提出了 TextDiffuser 模型,该模型包含两个阶段,第一阶段生成 Layout,第二阶段生成图像。

需要重新编写的是:TextDiffuser框架图

模型接受一段文本 Prompt,然后根据 Prompt 中的关键词确定每个关键词的 Layout(也就是坐标框)。研究者采用了 Layout Transformer,使用编码器-解码器的形式自回归地输出关键词的坐标框,并用 Python 的 PILLOW 库渲染出文本。在这个过程中,还可以利用 Pillow 现成的 API 得到每个字符的坐标框,相当于得到了字符级别的 Box-level segmentation mask。基于此信息,研究者尝试微调 Stable Diffusion。

他们考虑了两种情况,一种是用户想直接生成整张图片(称为 Whole-Image Generation)。另一种情况是 Part-Image Generation,在论文中也称之为 Text-inpainting,指的是用户给定一张图像,需要修改图里的某些文本区域。

为了实现上述两个目标,研究人员重新设计了输入特征,将维度从原来的4维增加到了17维。其中包括4维加噪图像特征、8维字符信息、1维图像掩码以及4维未被掩码的图像特征。如果是整体图像生成,研究人员将掩码区域设为整个图像;反之,如果是部分图像生成,只需对图像的一部分进行掩码。扩散模型的训练过程类似于LDM,对此感兴趣的同伴可以参考原文中的方法部分描述

在推理阶段,TextDiffuser具有非常灵活的使用方式,可以分为三种:

- 根据用户给定的指令生成图像。并且,如果用户不大满意第一步 Layout Generation 生成的布局,用户可以更改坐标也可以更改文本的内容,这增加了模型的可控性。

- 直接从第二个阶段开始。根据模板图像生成最终结果,其中模板图像可以是印刷文本图像,手写文本图像,场景文本图像。研究者专门训练了一个字符集分割网络用于从模板图像中提取 Layout。

- 同样也是从第二个阶段开始,用户给定图像并指定需要修改的区域与文本内容。并且,这个操作可以多次进行,直到用户对生成的结果感到满意为止。

构造的 MARIO 数据

为了训练TextDiffuser,研究人员收集了一千万张文本图像,如上图所示,包括三个子集:MARIO-LAION,MARIO-TMDB和MARIO-OpenLibrary

研究者在筛选数据时考虑了若干方面:例如在图像经过 OCR 后,只保留文本数量为 [1,8] 的图像。他们筛掉了文本数量超过 8 的文本,因为这些文本往往包含大量密集文本,OCR 的结果一般不太准确,例如报纸或者复杂的设计图纸。除此之外,他们设置文本的区域大于 10%,设置这个规则是为了让文本区域在图像的比重不要太小。

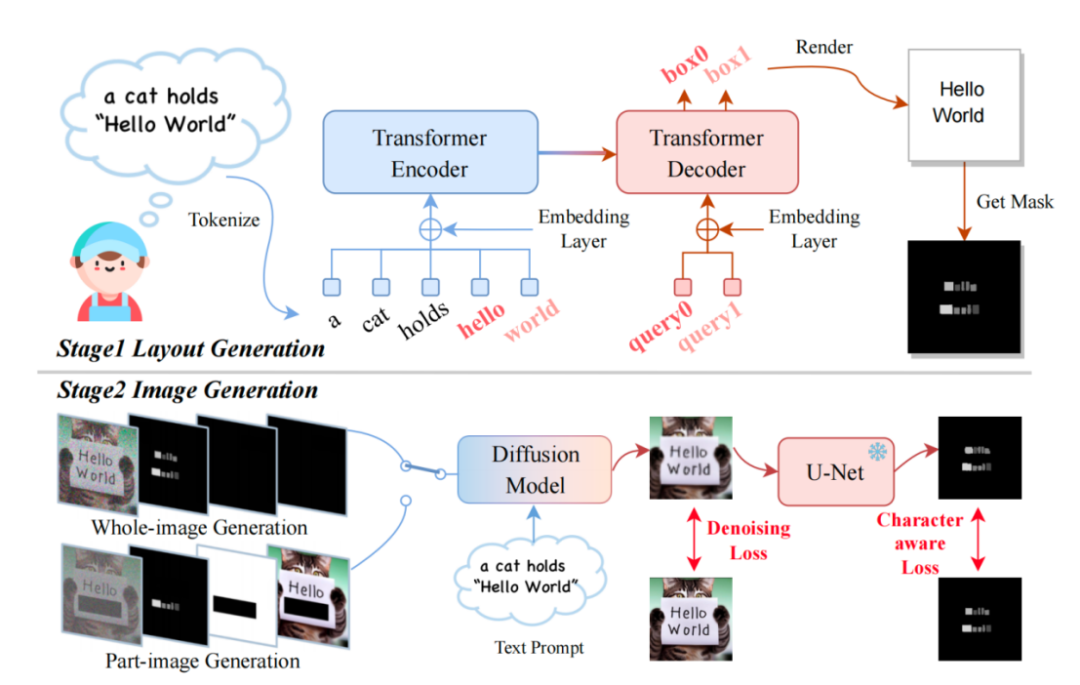

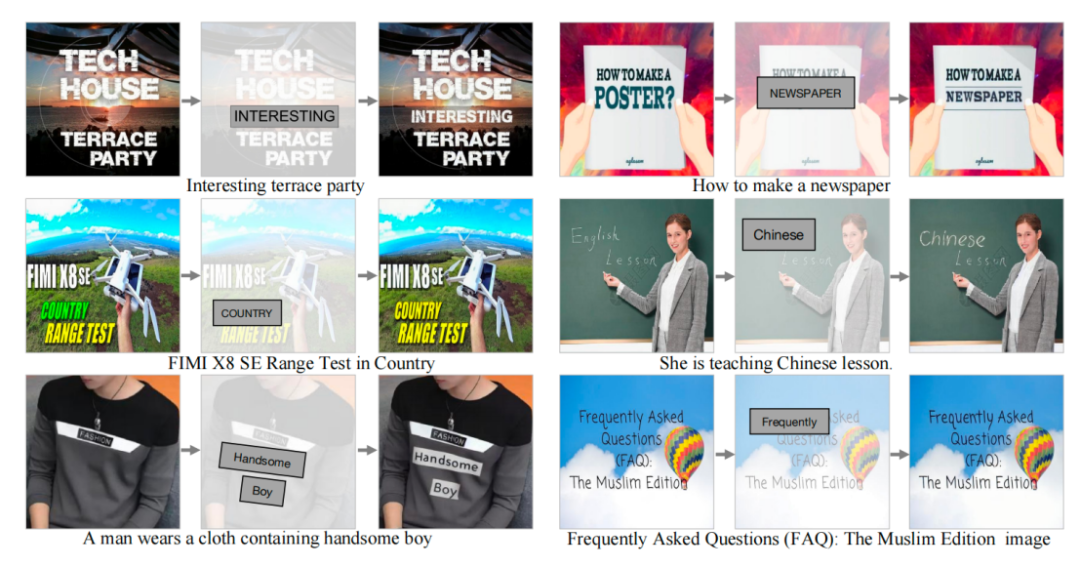

在对 MARIO-10M 数据集进行训练后,研究人员对 TextDiffuser 进行了定量和定性的比较,与现有方法进行了对比。例如,在整体图像生成任务中,本文方法生成的图像具有更清晰可读的文本,并且文本区域与背景区域的融合更好,如下图所示

与现有工作比较文本渲染性能

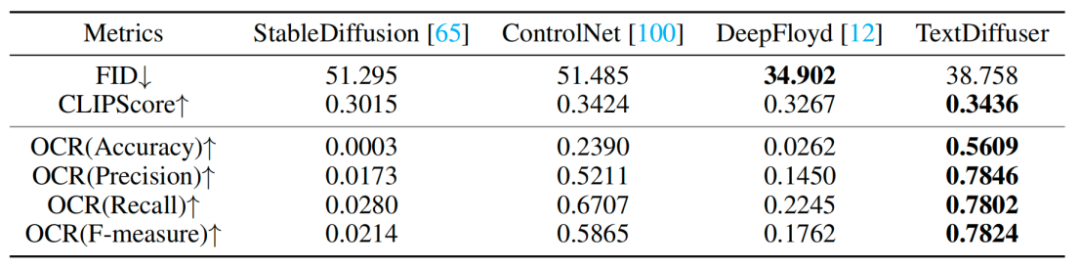

研究人员还进行了一系列定性实验,结果如表1所示。评估指标包括FID、CLIPScore和OCR。特别是OCR指标,本研究方法相对于对比方法有显著的提升

重写后的内容:实验结果见表1:定性实验

对于 Part-Image Generation 任务,研究者尝试着在给定的图像上增加或修改字符,实验结果表明 TextDiffuser 生成的结果很自然。

文本修复功能可视化

总的来说,本文提出的 TextDiffuser 模型在文本渲染领域取得了显著的进展,能够生成包含易读文本的高质量图像。未来,研究者将进一步提升 TextDiffuser 的效果。

以上是新标题:TextDiffuser:无惧图像中的文字,提供更高质量的文本渲染的详细内容。更多信息请关注PHP中文网其他相关文章!

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

Video Face Swap

使用我们完全免费的人工智能换脸工具轻松在任何视频中换脸!

热门文章

热工具

记事本++7.3.1

好用且免费的代码编辑器

SublimeText3汉化版

中文版,非常好用

禅工作室 13.0.1

功能强大的PHP集成开发环境

Dreamweaver CS6

视觉化网页开发工具

SublimeText3 Mac版

神级代码编辑软件(SublimeText3)

值得购买以获得短期收益的九种加密货币盘点

May 14, 2025 pm 09:54 PM

值得购买以获得短期收益的九种加密货币盘点

May 14, 2025 pm 09:54 PM

目录如何选择加密货币进行短期交易?短期交易最佳加密货币列表比特币雪崩索拉纳狗狗币多边形世界币Chainlink新兴企业如何选择加密货币进行短期交易?短期交易是指购买加密货币并持有一段时间,从几分钟到几天不等。这种方法前景光明,但也存在风险,耗时较长,因为你需要持续关注市场行情。但这还不是全部;在选择合适的加密货币资产时,你还应该注意以下几点:波动性:短期交易成功的主要指标之一是高挥发性加密货币的价值;价值越高,价格波动越大,从而创造更

一文搞清楚经济波动期间稳定币的作用

May 14, 2025 pm 09:15 PM

一文搞清楚经济波动期间稳定币的作用

May 14, 2025 pm 09:15 PM

你不需要是经济学家也能感受到经济的动荡。物价下跌,工作稳定性下降,每个人似乎都对自己的财务未来感到焦虑。什么是稳定币?稳定币就像加密世界中的救生衣:一种设计用来保持价值稳定的数字货币,通常与美元或黄金等稳定资产挂钩。与比特币或以太坊等价格波动剧烈的加密货币不同,稳定币追求稳定性。当经济风暴来袭时,投资者自然会寻求稳定,而稳定币恰好提供了这种避险资产——免受波动的影响。为什么稳定币在经济不稳定时蓬勃发展在

VINU币未来如何?2025年VINU币价格分析与投资策略

May 14, 2025 pm 09:30 PM

VINU币未来如何?2025年VINU币价格分析与投资策略

May 14, 2025 pm 09:30 PM

目录 什么是VitaInu(VINU)?什么是VINU代币?2025年VINU币价格预测VitaInu(VINU)价格预测2025-2030至2030年VitaInu(VINU)价格预测2025年VitaInu价格预测2026年VitaInu价格预测2027年VitaInu价格预测2028年VitaInu价格预测2029年VitaInu价格预测2030年VitaInu价格预测解读VINU的市场表现

Solayer(LAYER)是什么?Solayer代币经济学和价格预测

May 14, 2025 pm 10:06 PM

Solayer(LAYER)是什么?Solayer代币经济学和价格预测

May 14, 2025 pm 10:06 PM

介绍去中心化金融(DeFi)正在改变用户与区块链技术的交互方式,为交易、借贷和收益创造创造无缝灵活的途径。Solayer(LAYER)正是这一变革的核心,它构建了一个跨多条区块链连接流动性和实用性的协议。随着DeFi的普及以及对高效跨链基础设施需求的增长,Solayer正吸引着交易员、开发者和投资者的关注,他们正在寻找下一个重大机遇。本文将解释Solayer的概念,详细介绍其创新功能和代币经济学,并展望其2030年

Zebec Network(ZBCN)是什么?ZBCN代币经济学和价格预测

May 14, 2025 pm 09:48 PM

Zebec Network(ZBCN)是什么?ZBCN代币经济学和价格预测

May 14, 2025 pm 09:48 PM

在当今的数字经济中,传统金融与区块链技术之间的界限开始变得模糊。人们渴望更快的支付、无边界的交易以及对自身资金的更多掌控——而且他们渴望立即实现。ZebecNetwork是众多旨在通过构建可编程资金流基础设施来满足这一需求的项目之一。Zebec专注于实时工资单、加密支付和去中心化系统,将自己定位为连接成熟金融实践与新兴区块链解决方案的桥梁。本文概述了ZebecNetwork——它

什么是 Sign Protocol (SIGN)?跨链验证网络入门指南

May 14, 2025 pm 10:48 PM

什么是 Sign Protocol (SIGN)?跨链验证网络入门指南

May 14, 2025 pm 10:48 PM

区块链技术持续改变着人们在线上交换价值、验证信息和建立信任的方式。随着去中心化应用在各行各业的蓬勃发展,跨多个区块链确认声明和身份的能力变得越来越重要,也越来越复杂。传统的、依赖于中心化权威的信任模型往往不足以支撑去中心化的生态系统,因此对区块链原生验证解决方案的需求也日益增长。SignProtocol(SIGN)通过提供一个用于跨多个区块链网络创建、验证和管理证明的框架来应对这一挑战。SignProtocol旨在打造一个全链

Solana链上Meme币MOODENG、GOAT登陆币安Alpha!币价齐暴涨

May 14, 2025 pm 10:24 PM

Solana链上Meme币MOODENG、GOAT登陆币安Alpha!币价齐暴涨

May 14, 2025 pm 10:24 PM

Solana链上两大Meme币——MooDeng(MOODENG)、GoatseusMaximus(GOAT)昨(11)日登陆币安「Alpha」平台后迅速翻红,重燃投资人热情,其中MOODENG币价单日狂飙逾123%,一举刷新今年以来新高。币安Alpha主要聚焦于早期潜力币种,通常会上架社群热度高、有成长潜力的币种,如今正式上线MOODENG、GOAT,不仅为这两款Meme币注入资金活水,更让Solana生态再

SWCH是什么币种?值得投资吗?SWCH币详细购买教程

May 14, 2025 pm 10:30 PM

SWCH是什么币种?值得投资吗?SWCH币详细购买教程

May 14, 2025 pm 10:30 PM

加密货币市场项目随着区块链发展而不断涌现,目的就是改变传统金融实践,SwissCheese就是其中一个项目。据了解,SwissCheese是一个让用户能够交易通证化股票的去中心化平台,旨在增强市场的可及性并降低交易成本,为更具包容性的金融环境铺平道路。平台的原生代币为SWCH,主要作用就是交易、治理等。该项目上线后立即引起了投资者的关注,但仅仅了解SWCH是什么币种?还不能分析出SWCH值得投资吗?结合当前数据来看,SWCH具有一定的