刚刚,2023诺贝尔物理学奖颁给阿秒量级光脉冲!史上第五位女性得主诞生

刚刚宣布了2023年诺贝尔物理学奖的获得者

获奖者为Pierre Agostini、费伦茨·克劳斯和Anne L‘Huillier,他们因研发出一种产生极短光脉冲的方法而获奖。这种方法可以用于测量电子运动或能量变化的快速过程

他们的实验对人类来说具有重要意义,因为它为我们提供了一种全新的工具,可以探索原子和分子内部的电子世界

奖金金额为1100万瑞典克朗( 约合715万人民币),将由三位获奖者平均分配。

光实验,捕捉最短的瞬间

当人类感知到快速移动的物质时,它们会相互流动,这个原理就好像静止图像组成的电影看起来像连续运动一样。

如果我们想要调查真正短暂的事件,我们需要使用特殊的技术

在数字化的世界中,变化发生的速度之快可以在几个亚秒内完成——亚秒的时间非常短暂,以至于一秒钟内的变化量与宇宙诞生以来的几秒钟内的变化量相当

阿秒是国际单位制中的时间单位,等于1×10^(−18) 秒。

电子的运动

而Pierre Agostini,费伦茨·克劳斯和Anne L‘Huillier的实验产生了如此短的光脉冲,以至于这些光脉冲可以以阿秒为单位进行测量,从而证明这些脉冲可用于提供原子和分子内部过程的图像。

1987年,Anne L'Huillier发现,当她将红外激光穿过惰性气体时,会产生许多不同的泛音。

每个泛音都是一个光波,激光中的每个周期都有一定数量的循环

它们是由激光与气体中的原子相互作用引起的。其中,激光给一些电子额外的能量,然后这些电子就会以光的形式发射出来。

泛音

Anne L'Huillier一直在探索这一现象,为随后的突破奠定了基础。

2001年,Pierre Agostini成功地产生了一系列连续的光脉冲,其中每个脉冲仅持续250阿秒。

激光与气体中的原子相互作用

与此同时,费伦茨·克劳斯正在研究另一种类型的实验,该实验可以分离出持续650阿秒的单个光脉冲。

实验设置示例

获奖者的贡献使得能够对以前无法遵循的快速过程进行调查。

他们的贡献使得我们的实验速度达到了以前无法想象的程度

诺贝尔物理学委员会主席Eva Olsson表示——

我们现在可以打开通往电子世界的大门。阿秒物理学让我们有机会理解由电子控制的机制。下一步,我们就可以利用它们。

三位的发现,具有在不同领域中潜在的应用空间

在电子学领域,我们可以通过这一技术来了解和控制电子在材料中的行为。在医学诊断中,我们可以利用阿秒脉冲来识别不同的分子

获奖人介绍

Pierre Agostini

1968年获法国艾克斯-马赛大学博士学位,现任美国俄亥俄州立大学教授。

Pierre Agostini在艾克斯-马赛大学完成学业后,成为了法国原子能委员会萨克雷分会的一名研究员,并一直工作到2002年。

在此期间,他曾在南加州大学、阿姆斯特丹 FOM 和 BNL 担任访问学者。在担任了一系列其他访问学者职位后,他于 2005 年来到俄亥俄州立大学,担任物理学教授。

他曾获得荷兰OM颁发的Joop Los奖,2007年获得OSA的William F. Meggers奖。

2008年,他当选为OSA会员,理由是他领导的实验为研究原子和分子在强红外激光脉冲下的非线性响应动力学提供了重要见解。

费伦茨·克劳斯

他出生于1962年,出生地是匈牙利莫尔。他在1991年获得了维也纳工业大学的博士学位,现在担任德国马克斯-普朗克量子光学研究所的所长和慕尼黑大学的教授

2001年,费伦茨·克劳斯和他的团队首次成功地通过实验产生并测量了长度仅为阿秒的单个极紫外光闪光。

这一成果标志着阿秒物理学的开端,并树立了科学界的一个里程碑。

阿秒级闪光首次使电子的超快运动变得清晰可见,可以说是拍摄到了电子的超快运动

凭借着对阿秒物理学的贡献,费伦茨·克劳斯于2022年荣获沃尔夫奖。

需要重写的内容是:Anne L’Huillier

安妮·吕伊耶是现任瑞典隆德大学的教授,她的研究领域是短脉冲激光场与原子之间的相互作用

1958年,安妮·吕伊耶(Anne L'Huillier)出生在法国巴黎。1986年,她在法国皮埃尔和玛丽·居里大学获得博士学位,并同年获得法国原子能委员会的长期研究员职位

她分别于1986年和1988年,在瑞典查尔姆斯理工大学和美国南加州大学做博士后研究。

1993年,她来到劳伦斯利弗莫尔国家实验室,担任访问科学家的职务

1995年,她加入了隆德大学,并担任副教授一职。两年后的1997年,她又被提升为物理学教授

自2004年起,她成为瑞典皇家科学院院士。

2022年,Anne L'Huillier与费伦茨·克劳斯、Paul Corkum一起,获得了沃尔夫奖。

以上是刚刚,2023诺贝尔物理学奖颁给阿秒量级光脉冲!史上第五位女性得主诞生的详细内容。更多信息请关注PHP中文网其他相关文章!

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

Video Face Swap

使用我们完全免费的人工智能换脸工具轻松在任何视频中换脸!

热门文章

热工具

记事本++7.3.1

好用且免费的代码编辑器

SublimeText3汉化版

中文版,非常好用

禅工作室 13.0.1

功能强大的PHP集成开发环境

Dreamweaver CS6

视觉化网页开发工具

SublimeText3 Mac版

神级代码编辑软件(SublimeText3)

深入探讨模型、数据和框架:一份详尽的54页高效大语言模型综述

Jan 14, 2024 pm 07:48 PM

深入探讨模型、数据和框架:一份详尽的54页高效大语言模型综述

Jan 14, 2024 pm 07:48 PM

大规模语言模型(LLMs)在许多重要任务中展现出了引人注目的能力,包括自然语言理解、语言生成和复杂推理,并对社会产生了深远的影响。然而,这些出色的能力却需要大量的训练资源(如左图所示)和较长的推理时间(如右图所示)。因此,研究人员需要开发有效的技术手段来解决它们的效率问题。此外,从图的右侧还可以看出,一些高效的LLMs(LanguageModels)如Mistral-7B,已经成功应用于LLMs的设计和部署中。这些高效的LLMs在保持与LLaMA1-33B相近的准确性的同时,能够大大减少推理内存

扩散+超分辨率模型强强联合,谷歌图像生成器Imagen背后的技术

Apr 10, 2023 am 10:21 AM

扩散+超分辨率模型强强联合,谷歌图像生成器Imagen背后的技术

Apr 10, 2023 am 10:21 AM

近年来,多模态学习受到重视,特别是文本 - 图像合成和图像 - 文本对比学习两个方向。一些 AI 模型因在创意图像生成、编辑方面的应用引起了公众的广泛关注,例如 OpenAI 先后推出的文本图像模型 DALL・E 和 DALL-E 2,以及英伟达的 GauGAN 和 GauGAN2。谷歌也不甘落后,在 5 月底发布了自己的文本到图像模型 Imagen,看起来进一步拓展了字幕条件(caption-conditional)图像生成的边界。仅仅给出一个场景的描述,Imagen 就能生成高质量、高分辨率

碾压H100,英伟达下一代GPU曝光!首个3nm多芯片模块设计,2024年亮相

Sep 30, 2023 pm 12:49 PM

碾压H100,英伟达下一代GPU曝光!首个3nm多芯片模块设计,2024年亮相

Sep 30, 2023 pm 12:49 PM

3纳米制程,性能超越H100!最近,据外媒DigiTimes爆料,英伟达正在开发下一代GPU,代号为「Blackwell」的B100据称,作为面向人工智能(AI)和高性能计算(HPC)应用的产品,B100将采用台积电的3nm工艺制程,以及更为复杂的多芯片模块(MCM)设计,并将于2024年第四季度现身。对于垄断了人工智能GPU市场80%以上份额的英伟达来说,则可以借着B100趁热打铁,在这波AI部署的热潮中进一步狙击AMD、英特尔等挑战者。根据英伟达的估计,到2027年,该领域的产值预计将达到约

多模态大模型最全综述来了!7位微软研究员大力合作,5大主题,成文119页

Sep 25, 2023 pm 04:49 PM

多模态大模型最全综述来了!7位微软研究员大力合作,5大主题,成文119页

Sep 25, 2023 pm 04:49 PM

多模态大模型最全综述来了!由微软7位华人研究员撰写,足足119页——它从目前已经完善的和还处于最前沿的两类多模态大模型研究方向出发,全面总结了五个具体研究主题:视觉理解视觉生成统一视觉模型LLM加持的多模态大模型多模态agent并重点关注到一个现象:多模态基础模型已经从专用走向通用。Ps.这也是为什么论文开头作者就直接画了一个哆啦A梦的形象。谁适合阅读这份综述(报告)?用微软的原话来说:只要你有兴趣学习多模态基础模型的基础知识和最新进展,无论你是专业研究员还是在校学生,这个内容都非常适合你一起来

三位科学家因'探索和合成量子点”荣获2023年诺贝尔化学奖

Oct 04, 2023 pm 06:41 PM

三位科学家因'探索和合成量子点”荣获2023年诺贝尔化学奖

Oct 04, 2023 pm 06:41 PM

本站10月4日消息,自10月2日起,一年一度的诺贝尔奖“开奖周”正式拉开帷幕,六大奖项将逐次揭晓。今日,瑞典皇家科学院决定将2023年诺贝尔化学奖授予MoungiG.Bawendi、LouisE.Brus和AlexeiI.Ekimov,以表彰他们在“量子点的发现和合成”方面的贡献。2023年诺贝尔化学奖表彰了量子点的发现和发展。量子点是如此之小,以至于其尺寸决定了它们的性质。这些粒子具有独特的特性,现在从电视屏幕和LED灯中发出它们的光。它们能够催化化学反应,而它们明亮的光线可以为外科医生照亮肿

揭晓2022年玻尔兹曼奖:Hopfield网络创始人荣获奖项

Aug 13, 2023 pm 08:49 PM

揭晓2022年玻尔兹曼奖:Hopfield网络创始人荣获奖项

Aug 13, 2023 pm 08:49 PM

两位获得2022年玻尔兹曼奖的科学家已经公布,这个奖项由IUPAP统计物理委员会(C3)设立,旨在表彰在统计物理学领域取得杰出成就的研究者。获奖者必须是之前没有获得过玻尔兹曼奖或诺贝尔奖的科学家。这个奖项始于1975年,每三年颁发一次,以纪念统计物理学的奠基人路德维希·玻尔兹曼DeepakDharistheoriginalstatement.获奖理由:表彰DeepakDharistheoriginalstatement.对统计物理学领域作出的开创性贡献,包括自组织临界模型的精确解、界面生长、无序

SD社区的I2V-Adapter:无需配置,即插即用,完美兼容图生视频插件

Jan 15, 2024 pm 07:48 PM

SD社区的I2V-Adapter:无需配置,即插即用,完美兼容图生视频插件

Jan 15, 2024 pm 07:48 PM

图像到视频生成(I2V)任务是计算机视觉领域的一项挑战,旨在将静态图像转化为动态视频。这个任务的难点在于从单张图像中提取并生成时间维度的动态信息,同时保持图像内容的真实性和视觉上的连贯性。现有的I2V方法通常需要复杂的模型架构和大量的训练数据来实现这一目标。近期,快手主导的一项新研究成果《I2V-Adapter:AGeneralImage-to-VideoAdapterforVideoDiffusionModels》发布。该研究引入了一种创新的图像到视频转换方法,提出了一种轻量级适配器模块,即I

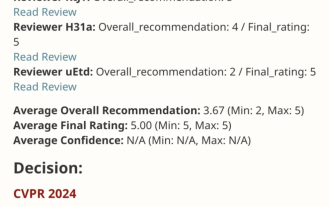

VPR 2024 满分论文!Meta提出EfficientSAM:快速分割一切!

Mar 02, 2024 am 10:10 AM

VPR 2024 满分论文!Meta提出EfficientSAM:快速分割一切!

Mar 02, 2024 am 10:10 AM

EfficientSAM这篇工作以5/5/5满分收录于CVPR2024!作者在某社交媒体上分享了该结果,如下图所示:LeCun图灵奖得主也强烈推荐了该工作!在近期的研究中,Meta研究者提出了一种新的改进方法,即使用SAM的掩码图像预训练(SAMI)。这一方法结合了MAE预训练技术和SAM模型,旨在实现高质量的预训练ViT编码器。通过SAMI,研究者试图提高模型的性能和效率,为视觉任务提供更好的解决方案。这一方法的提出为进一步探索和发展计算机视觉和深度学习领域带来了新的思路和机遇。通过结合不同的