ICCV'23论文颁奖'神仙打架”!Meta分割一切和ControlNet共同入选,还有一篇让评委们很惊讶

在法国巴黎举行的计算机视觉顶峰大会ICCV 2023刚刚结束!

今年的最佳论文奖,简直是“神仙打架”。

例如,获得最佳论文奖的两篇论文中,就包括颠覆文生图AI领域的著作——ControlNet。

自从开源以来,ControlNet在GitHub上已经获得了24k个星。无论是对于扩散模型还是整个计算机视觉领域来说,这篇论文的获奖都是实至名归的

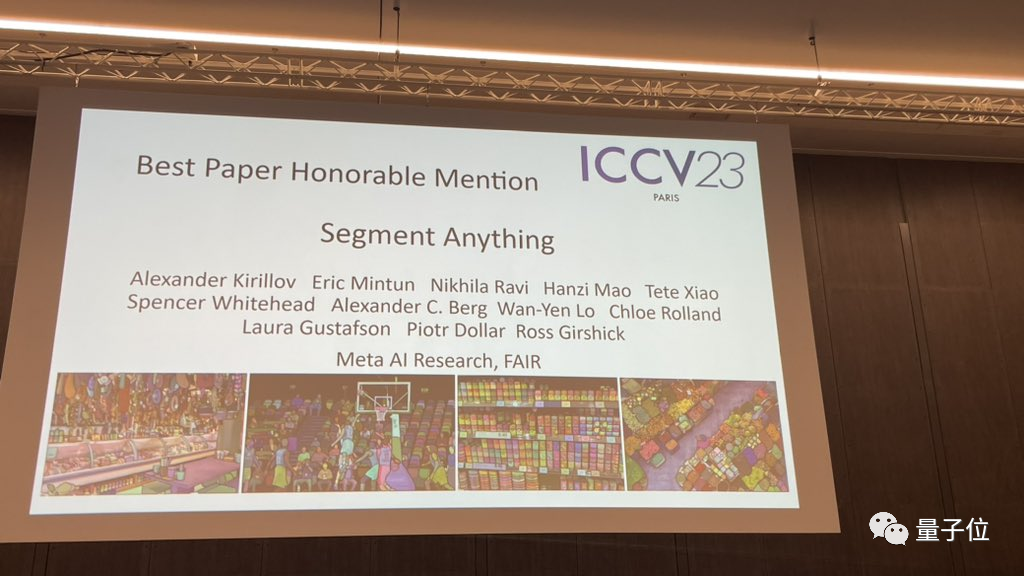

而最佳论文奖荣誉提名,则颁给了另一篇同样出名的论文,Meta的「分割一切」模型SAM。

自推出以来,「分割一切」已经成为了各种图像分割AI模型的“标杆”,包括后来居上的不少FastSAM、LISA、SegGPT,全部都是以它为参考基准进行效果测试。

论文提名都如此重量级,这届ICCV 2023竞争有多激烈?

ICCV 2023共提交了8068篇论文,但只有约四分之一,即2160篇论文被录用

其中近10%的论文来自中国,除了高校以外也有不少产业机构的身影,像商汤科技及联合实验室有49篇论文入选ICCV 2023,旷视有14篇论文入选。

一起来看看哪些论文获得了ICCV 2023的奖项

ControlNet获ICCV最佳论文

让我们先来看看今年获得最佳论文奖(马尔奖)的两篇论文

ICCV最佳论文又名马尔奖(Marr Prize),每两年评选一次,被誉为计算机视觉领域的最高荣誉之一。

这个奖项以计算机视觉领域的先驱、计算神经科学的创始人大卫·马尔命名

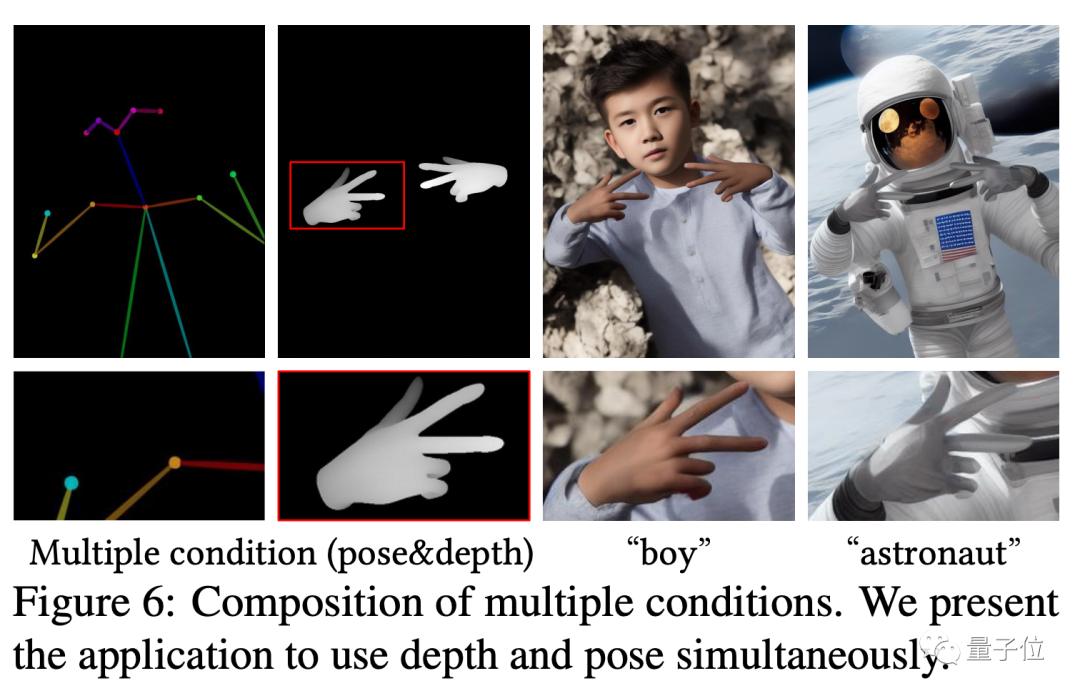

第一篇最佳论文奖得主是来自斯坦福的《为文本到图像扩散模型添加条件控制》

这篇论文提出了一种名叫ControlNet的模型,只需给预训练扩散模型增加一个额外的输入,就能控制它生成的细节。

这里的输入可以是各种类型,包括草图、边缘图像、语义分割图像、人体关键点特征、霍夫变换检测直线、深度图、人体骨骼等,所谓的“AI会画手”了,核心技术正是来自于这篇文章。

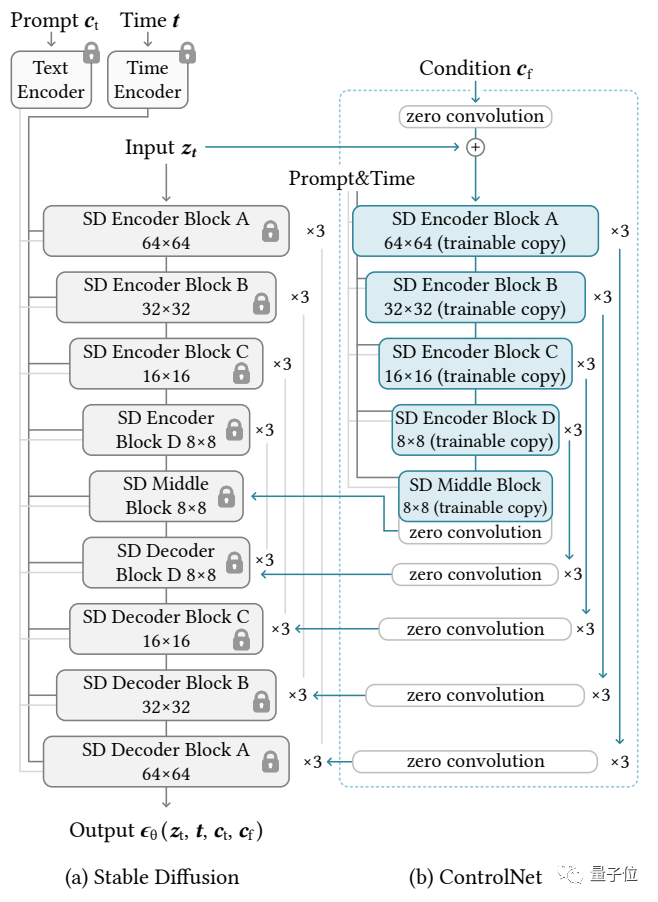

它的思路和架构如下:

控制网络首先复制扩散模型的权重,以获得一个“可训练副本”

相比之下,原扩散模型经过几十亿张图片的预训练,因此参数是被“锁定”的。而这个“可训练副本”只需要在特定任务的小数据集上训练,就能学会条件控制。

即使数据量很少(不超过5万张图片),模型经过训练后条件控制生成的效果也很好。

通过一个1×1的卷积层连接,"锁定模型"和"可训练副本"形成了一个名为"0卷积层"的结构。这个0卷积层的权重和偏置被初始化为0,这样在训练过程中可以获得非常快的速度,接近于微调扩散模型的速度,甚至可以在个人设备上进行训练

比如说,如果用20万张图像数据来训练一块英伟达RTX 3090TI,只需要不到一个星期的时间

张旅民是ControlNet论文的第一作者,目前是斯坦福大学的博士生。除了ControlNet,他还创作了著名作品如Style2Paints和Fooocus

论文地址:https://arxiv.org/abs/2302.05543

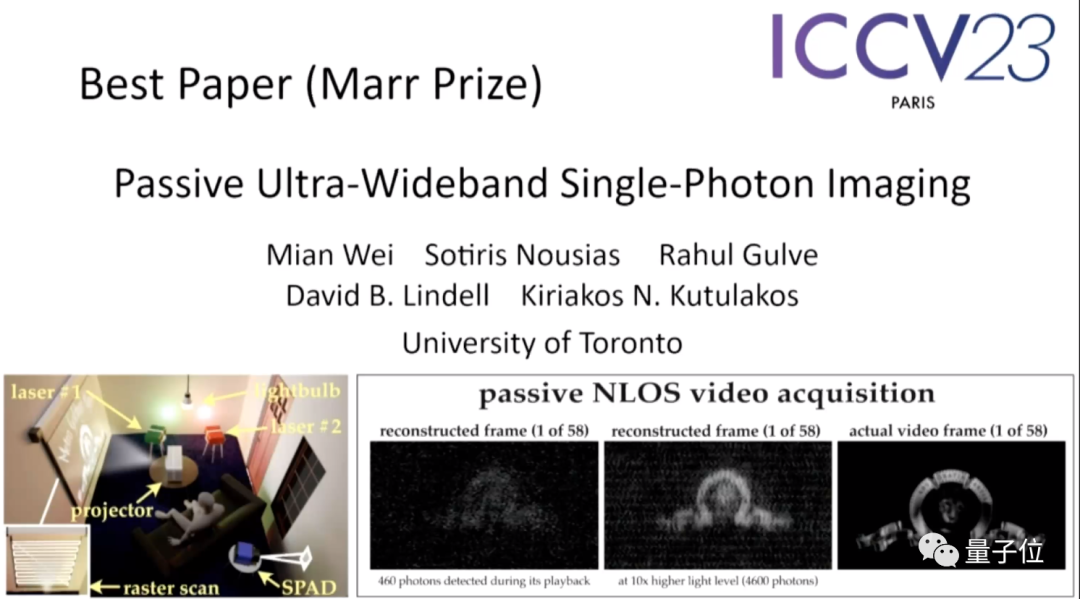

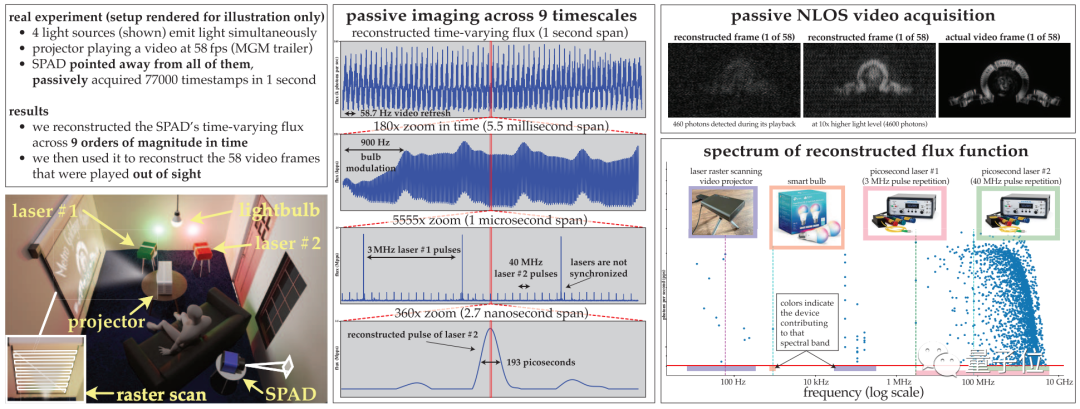

第二篇论文「Passive Ultra-Wideband Single-Photon lmaging」,来自多伦多大学。

这篇论文被评选委员会称之为“在主题(topic)上最令人惊讶的论文”,以至于其中一位评委表示“他几乎不可能想到去尝试这样的事情”。

论文的摘要如下:

这篇文章讨论了如何同时在极端时间尺度范围内(从秒到皮秒)对动态场景进行成像,同时要求成像passively(无需主动发送大量光信号)并在光线非常稀少的情况下进行,而且不依赖于来自光源的任何定时信号。

由于现有的单光子相机的光流估计技术在这个范围内失效,因此,这篇论文开发了一种光流探测理论,借鉴了随机微积分的思想,以从单调递增的光子检测时间戳流中重建像素的时间变化光流。

基于这一理论,论文主要做了三件事:

(1)表明在低光流条件下,被动自由运行的单光子波长探测器相机具有可达到的频率带宽,跨越从直流到31 GHz范围的整个频谱;

(2)推导出一种新颖的傅立叶域光流重建算法,用于扫描时间戳数据中具有统计学显着支持的频率;

(3)确保算法的噪声模型即使在非常低的光子计数或非可忽略的死区时间(dead times)情况下仍然有效。

作者通过实验证明了这种异步成像方式的潜力,包括一些前所未见的能力:

(1)在没有同步(如灯泡、投影仪、多脉冲激光器)的情况下,对以不同速度运行的光源同时照明的场景进行成像;

(2)被动的非视域(non-line-of-sight)视频采集;

(3)记录超宽带视频,可以在30 Hz的频率下回放,展示日常运动,但也可以以每秒十亿分之一的速度播放,以展示光的传播过程。

论文一作Mian Wei,多伦多大学博士生,研究方向是计算摄影,目前的研究兴趣在于基于主动照明成像技术改进计算机视觉算法。

请点击以下链接查看论文:https://openaccess.thecvf.com/content/ICCV2023/papers/Wei_Passive_Ultra-Wideband_Single-Photon_Imaging_ICCV_2023_paper.pdf

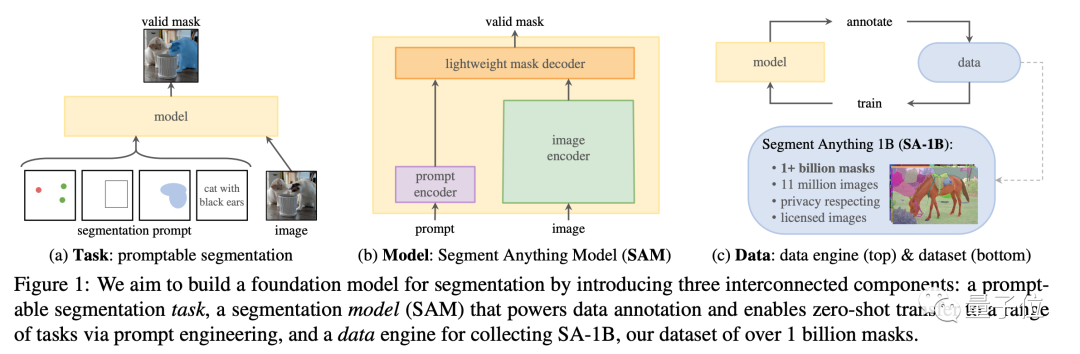

「分割一切」获荣誉提名

在这次大会上,除了备受关注的ControNet之外,Meta的「分割一切」模型也获得了最佳论文奖的荣誉提名,成为了当时备受瞩目的话题

这篇论文不仅提出了一个当前最大的图像分割数据集,在11M图像上拥有超过10亿个遮罩(mask),而且为此训练出了一个SAM模型,可以快速分割没见过的图像。

相比于之前比较零散的图像分割模型,SAM可以说是对这一系列模型功能进行了“大一统”,而且在各项任务中都表现出了不错的性能。

这个开源模型目前在GitHub上已经获得了38.8k颗星,可以说是语义分割领域的"标杆"了

论文地址:https://arxiv.org/abs/2304.02643

项目主页:https://segment-anything.com/

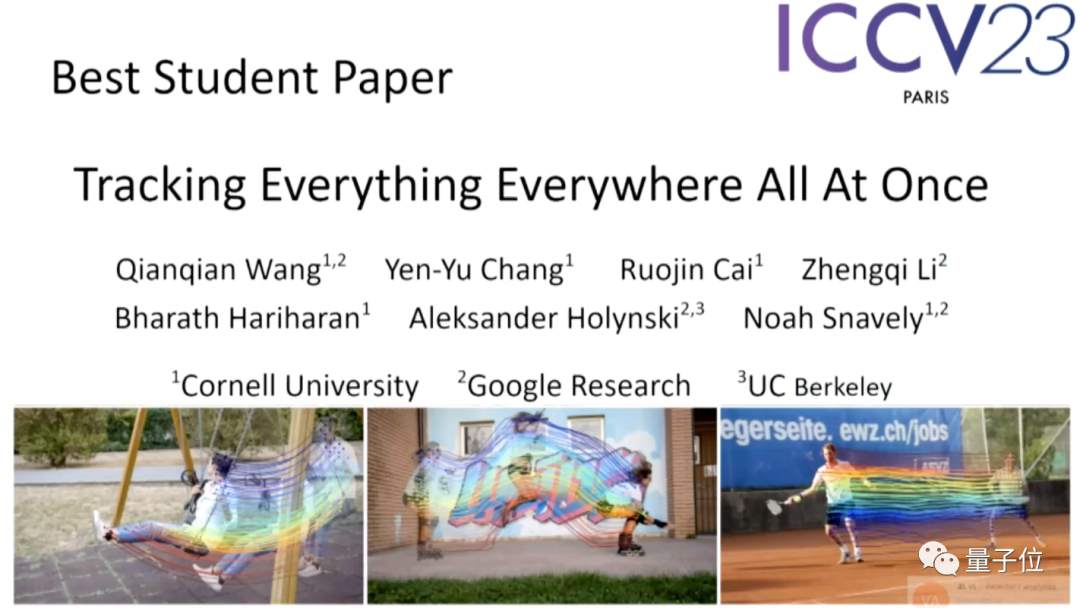

在学生作品中,Google的「追踪一切」模型脱颖而出

就像文章的标题一样,这个模型可以在任何地点同时对图像中的任意(多个)物体进行像素级追踪。

该项目的第一作者是康奈尔大学的华人博士Qianqian Wang,目前正在UCB进行博士后研究。

论文地址:https://arxiv.org/abs/2306.05422

项目主页:https://omnimotion.github.io/

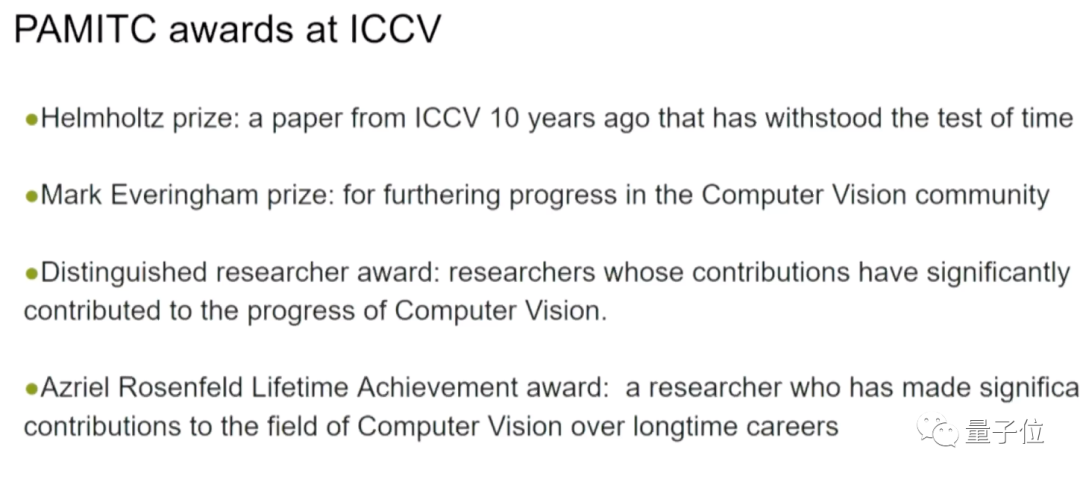

在开幕式上,还宣布了由PAMITC委员会成员捐赠的特别奖项,该委员会还同时捐赠了CVPR和WACV两个计算机视觉领域会议的奖项

以下四个奖项被包括在内:

- 亥姆赫兹奖:十年前对计算机视觉研究产生重大影响的ICCV论文

- Everingham奖:计算机视觉领域的进步

- 杰出研究者:对计算机视觉的进步做出重大贡献的研究人员

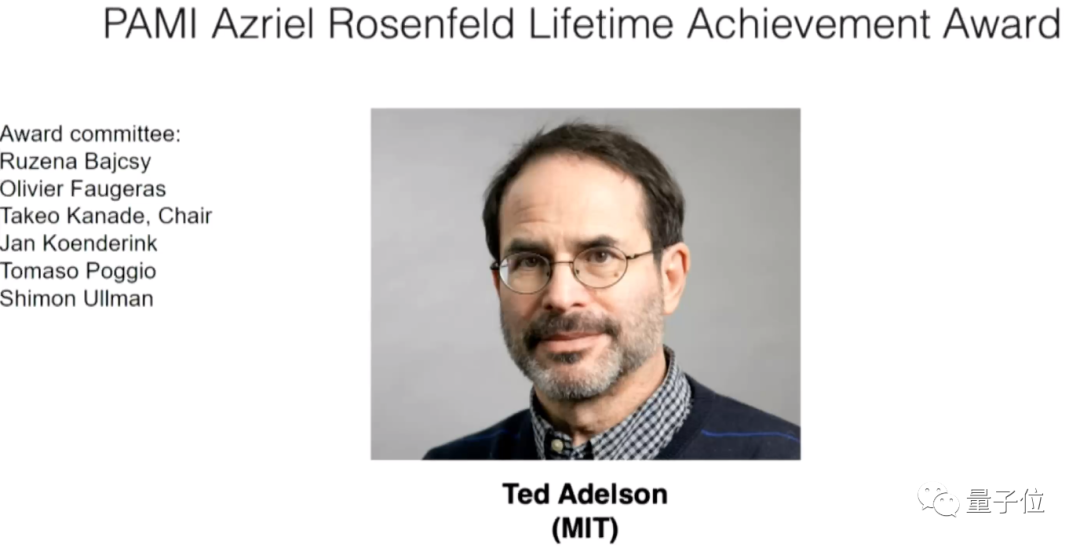

- Rosenfeld终身成就奖:在长期职业生涯中对计算机视觉领域做出重大贡献的研究人员

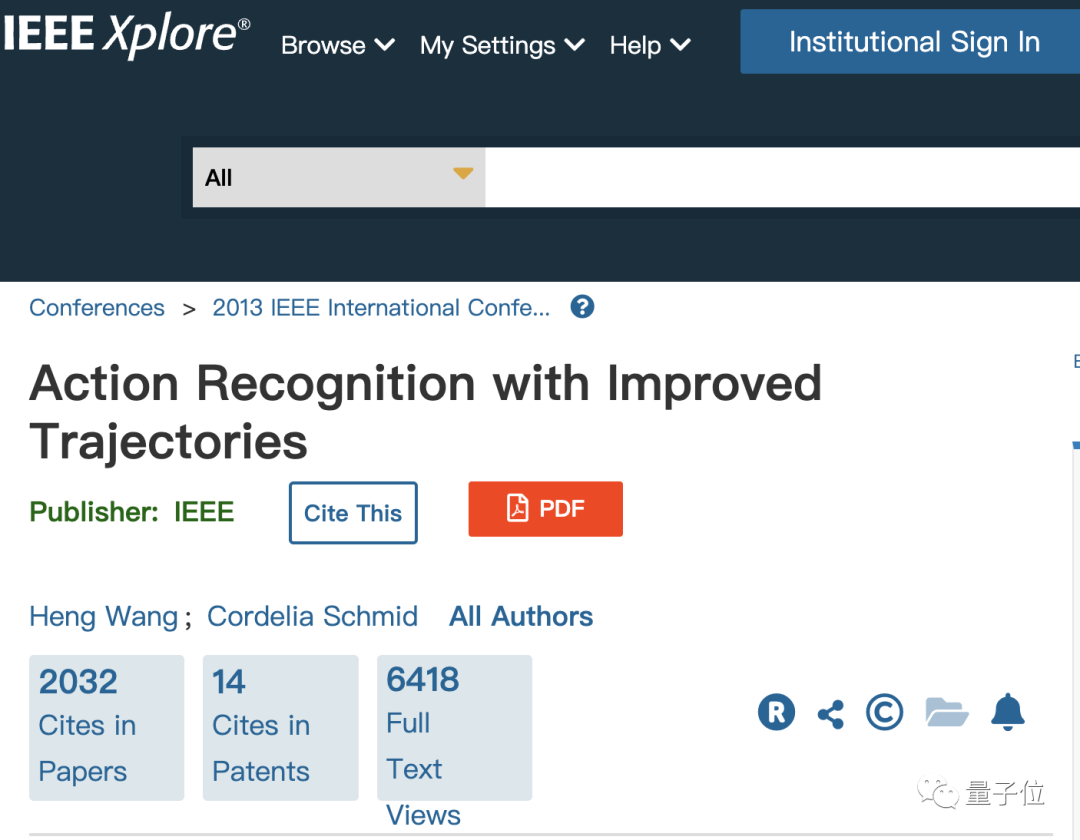

获得亥姆赫兹奖的科学家是华裔科学家Heng Wang和Google的Cordelia Schmid,他们是Meta AI的成员

他们凭借2013年发表的一篇有关动作识别的论文获得了这一奖项。

当时两人都在法国国立计算机及自动化研究院(法语缩写:INRIA)下属的Lear实验室工作,Schmid是当时该实验室的领导者。

请点击以下链接查看论文:https://ieeexplore.ieee.org/document/6751553

Everingham奖被授予了两个团队

第一组的获奖者是来自Google的Samer Agarwal、Keir Mierle以及他们的团队

两位获奖者分别毕业于华盛顿大学和多伦多大学,他们的成就是开发了一款在计算机视觉领域广泛应用的开源C++库Ceres Solver

项目主页链接:http://ceres-solver.org/

另一项获奖成果是COCO数据集,它包含了大量的图像和注释,有丰富的内容和任务,是测试计算机视觉模型的重要数据集。

该数据集由微软提出,相关论文第一作者是华裔科学家Tsung-Yi Lin,博士毕业于康奈尔大学,现在英伟达实验室担任研究人员。

论文地址:https://arxiv.org/abs/1405.0312

项目主页:https://cocodataset.org/

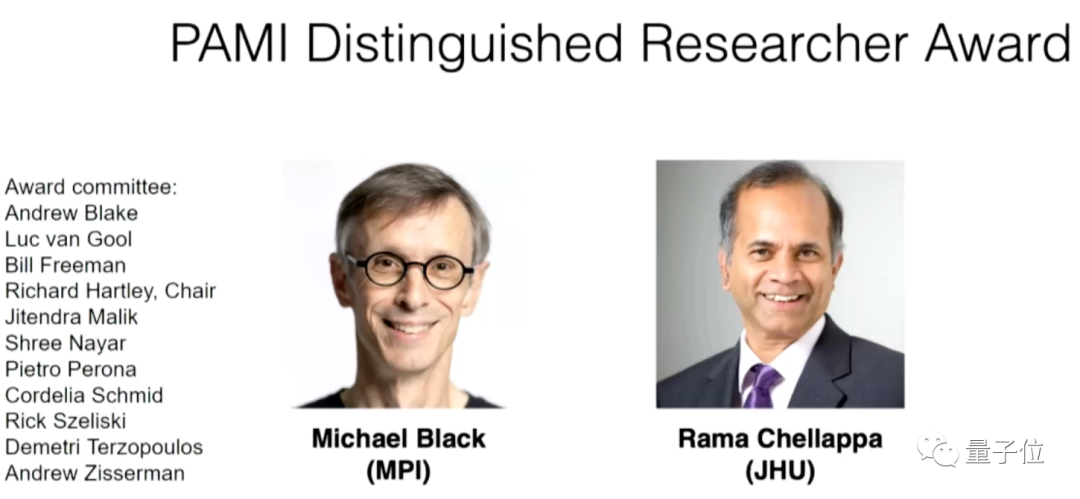

获得杰出研究者荣誉的则是德国马普所的Michael Black和约翰森霍普金斯大学的Rama Chellappa两位教授。

麻省理工学院的Ted Adelson教授荣获终身成就奖

请问你的论文被ICCV 2023录用了吗?你觉得今年的奖项评选怎么样?

以上是ICCV'23论文颁奖'神仙打架”!Meta分割一切和ControlNet共同入选,还有一篇让评委们很惊讶的详细内容。更多信息请关注PHP中文网其他相关文章!

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

AI Hentai Generator

免费生成ai无尽的。

热门文章

热工具

记事本++7.3.1

好用且免费的代码编辑器

SublimeText3汉化版

中文版,非常好用

禅工作室 13.0.1

功能强大的PHP集成开发环境

Dreamweaver CS6

视觉化网页开发工具

SublimeText3 Mac版

神级代码编辑软件(SublimeText3)

热门话题

全球最强开源 MoE 模型来了,中文能力比肩 GPT-4,价格仅为 GPT-4-Turbo 的近百分之一

May 07, 2024 pm 04:13 PM

全球最强开源 MoE 模型来了,中文能力比肩 GPT-4,价格仅为 GPT-4-Turbo 的近百分之一

May 07, 2024 pm 04:13 PM

想象一下,一个人工智能模型,不仅拥有超越传统计算的能力,还能以更低的成本实现更高效的性能。这不是科幻,DeepSeek-V2[1],全球最强开源MoE模型来了。DeepSeek-V2是一个强大的专家混合(MoE)语言模型,具有训练经济、推理高效的特点。它由236B个参数组成,其中21B个参数用于激活每个标记。与DeepSeek67B相比,DeepSeek-V2性能更强,同时节省了42.5%的训练成本,减少了93.3%的KV缓存,最大生成吞吐量提高到5.76倍。DeepSeek是一家探索通用人工智

AI颠覆数学研究!菲尔兹奖得主、华裔数学家领衔11篇顶刊论文|陶哲轩转赞

Apr 09, 2024 am 11:52 AM

AI颠覆数学研究!菲尔兹奖得主、华裔数学家领衔11篇顶刊论文|陶哲轩转赞

Apr 09, 2024 am 11:52 AM

AI,的确正在改变数学。最近,一直十分关注这个议题的陶哲轩,转发了最近一期的《美国数学学会通报》(BulletinoftheAmericanMathematicalSociety)。围绕「机器会改变数学吗?」这个话题,众多数学家发表了自己的观点,全程火花四射,内容硬核,精彩纷呈。作者阵容强大,包括菲尔兹奖得主AkshayVenkatesh、华裔数学家郑乐隽、纽大计算机科学家ErnestDavis等多位业界知名学者。AI的世界已经发生了天翻地覆的变化,要知道,其中很多文章是在一年前提交的,而在这一

你好,电动Atlas!波士顿动力机器人复活,180度诡异动作吓坏马斯克

Apr 18, 2024 pm 07:58 PM

你好,电动Atlas!波士顿动力机器人复活,180度诡异动作吓坏马斯克

Apr 18, 2024 pm 07:58 PM

波士顿动力Atlas,正式进入电动机器人时代!昨天,液压Atlas刚刚「含泪」退出历史舞台,今天波士顿动力就宣布:电动Atlas上岗。看来,在商用人形机器人领域,波士顿动力是下定决心要和特斯拉硬刚一把了。新视频放出后,短短十几小时内,就已经有一百多万观看。旧人离去,新角色登场,这是历史的必然。毫无疑问,今年是人形机器人的爆发年。网友锐评:机器人的进步,让今年看起来像人类的开幕式动作、自由度远超人类,但这真不是恐怖片?视频一开始,Atlas平静地躺在地上,看起来应该是仰面朝天。接下来,让人惊掉下巴

替代MLP的KAN,被开源项目扩展到卷积了

Jun 01, 2024 pm 10:03 PM

替代MLP的KAN,被开源项目扩展到卷积了

Jun 01, 2024 pm 10:03 PM

本月初,来自MIT等机构的研究者提出了一种非常有潜力的MLP替代方法——KAN。KAN在准确性和可解释性方面表现优于MLP。而且它能以非常少的参数量胜过以更大参数量运行的MLP。比如,作者表示,他们用KAN以更小的网络和更高的自动化程度重现了DeepMind的结果。具体来说,DeepMind的MLP有大约300,000个参数,而KAN只有约200个参数。KAN与MLP一样具有强大的数学基础,MLP基于通用逼近定理,而KAN基于Kolmogorov-Arnold表示定理。如下图所示,KAN在边上具

谷歌狂喜:JAX性能超越Pytorch、TensorFlow!或成GPU推理训练最快选择

Apr 01, 2024 pm 07:46 PM

谷歌狂喜:JAX性能超越Pytorch、TensorFlow!或成GPU推理训练最快选择

Apr 01, 2024 pm 07:46 PM

谷歌力推的JAX在最近的基准测试中性能已经超过Pytorch和TensorFlow,7项指标排名第一。而且测试并不是在JAX性能表现最好的TPU上完成的。虽然现在在开发者中,Pytorch依然比Tensorflow更受欢迎。但未来,也许有更多的大模型会基于JAX平台进行训练和运行。模型最近,Keras团队为三个后端(TensorFlow、JAX、PyTorch)与原生PyTorch实现以及搭配TensorFlow的Keras2进行了基准测试。首先,他们为生成式和非生成式人工智能任务选择了一组主流

特斯拉机器人进厂打工,马斯克:手的自由度今年将达到22个!

May 06, 2024 pm 04:13 PM

特斯拉机器人进厂打工,马斯克:手的自由度今年将达到22个!

May 06, 2024 pm 04:13 PM

特斯拉机器人Optimus最新视频出炉,已经可以在厂子里打工了。正常速度下,它分拣电池(特斯拉的4680电池)是这样的:官方还放出了20倍速下的样子——在小小的“工位”上,拣啊拣啊拣:这次放出的视频亮点之一在于Optimus在厂子里完成这项工作,是完全自主的,全程没有人为的干预。并且在Optimus的视角之下,它还可以把放歪了的电池重新捡起来放置,主打一个自动纠错:对于Optimus的手,英伟达科学家JimFan给出了高度的评价:Optimus的手是全球五指机器人里最灵巧的之一。它的手不仅有触觉

FisheyeDetNet:首个基于鱼眼相机的目标检测算法

Apr 26, 2024 am 11:37 AM

FisheyeDetNet:首个基于鱼眼相机的目标检测算法

Apr 26, 2024 am 11:37 AM

目标检测在自动驾驶系统当中是一个比较成熟的问题,其中行人检测是最早得以部署算法之一。在多数论文当中已经进行了非常全面的研究。然而,利用鱼眼相机进行环视的距离感知相对来说研究较少。由于径向畸变大,标准的边界框表示在鱼眼相机当中很难实施。为了缓解上述描述,我们探索了扩展边界框、椭圆、通用多边形设计为极坐标/角度表示,并定义一个实例分割mIOU度量来分析这些表示。所提出的具有多边形形状的模型fisheyeDetNet优于其他模型,并同时在用于自动驾驶的Valeo鱼眼相机数据集上实现了49.5%的mAP

DualBEV:大幅超越BEVFormer、BEVDet4D,开卷!

Mar 21, 2024 pm 05:21 PM

DualBEV:大幅超越BEVFormer、BEVDet4D,开卷!

Mar 21, 2024 pm 05:21 PM

这篇论文探讨了在自动驾驶中,从不同视角(如透视图和鸟瞰图)准确检测物体的问题,特别是如何有效地从透视图(PV)到鸟瞰图(BEV)空间转换特征,这一转换是通过视觉转换(VT)模块实施的。现有的方法大致分为两种策略:2D到3D和3D到2D转换。2D到3D的方法通过预测深度概率来提升密集的2D特征,但深度预测的固有不确定性,尤其是在远处区域,可能会引入不准确性。而3D到2D的方法通常使用3D查询来采样2D特征,并通过Transformer学习3D和2D特征之间对应关系的注意力权重,这增加了计算和部署的