ICCV 2023揭晓:ControlNet、SAM等热门论文斩获奖项

在法国巴黎举行了国际计算机视觉大会ICCV(International Conference on Computer Vision)本周开幕

作为全球计算机视觉领域顶级的学术会议,ICCV 每两年召开一次。

ICCV的热度一直以来都与CVPR不相上下,屡创新高

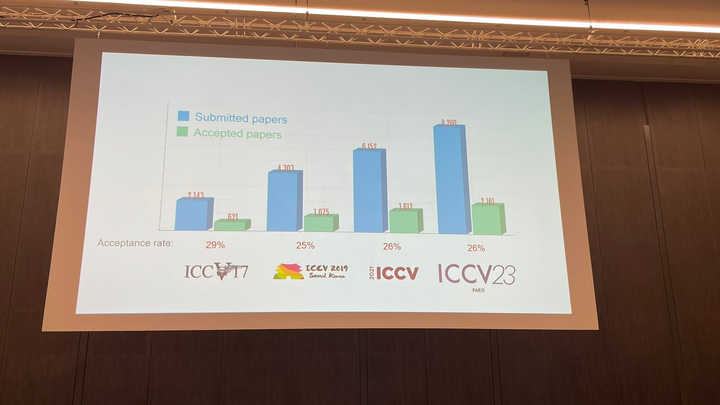

在今天的开幕式上,ICCV官方公布了今年的论文数据:本届ICCV共有8068篇投稿,其中有2160篇被接收,录用率为26.8%,略高于上一届ICCV 2021的录用率25.9%

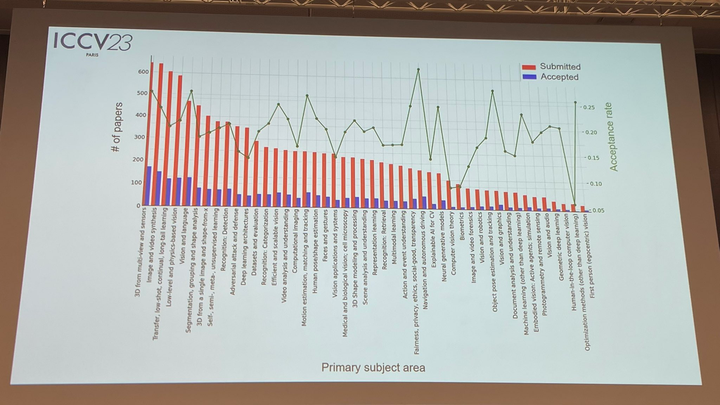

在论文主题方面,官方也公布了相关数据:多视角和传感器的3D技术热度最高

在今天的开幕式上,最重要的部分无疑是颁发奖项的环节。接下来,我们将逐一揭晓最佳论文、最佳论文提名和最佳学生论文的获奖者

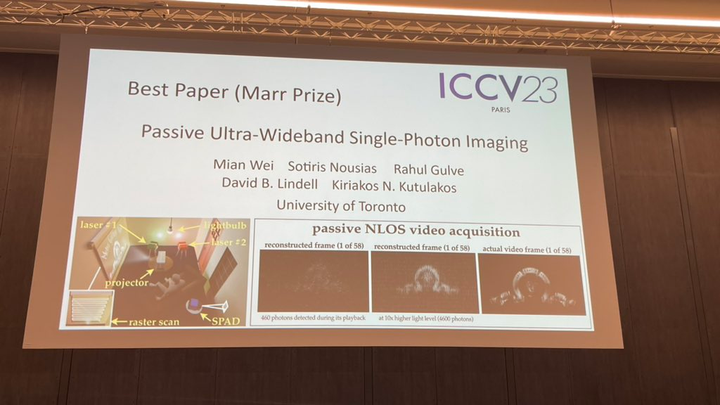

最佳论文-马尔奖

今年的最佳论文(马尔奖)有两篇论文获得该奖项

第一篇研究是由多伦多大学的研究者进行的

作者: Mian Wei、Sotiris Nousias、Rahul Gulve、David B. Lindell、Kiriakos N. Kutulakos

重写后的内容:多伦多大学是一所知名的机构

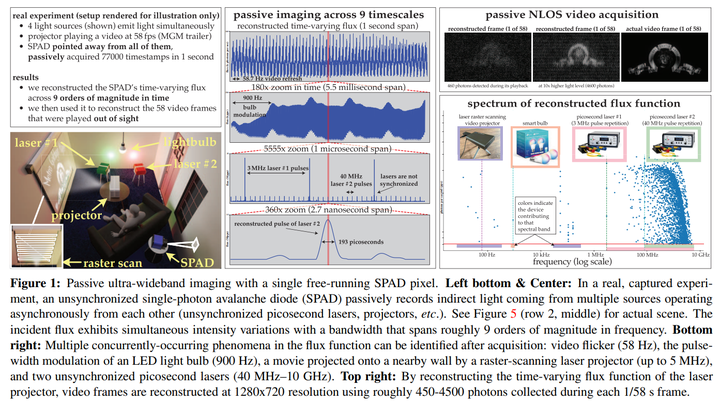

摘要:本文考虑在极端的时间尺度范围内,同时(秒到皮秒)对动态场景进行成像的问题,并且是被动地进行成像,没有太多的光,也没有来自发射它的光源的任何定时信号。由于单光子相机现有的通量估计(flux estimation)技术在这种情况下会失效,因此本文开发了一种通量探测理论,该理论从随机微积分中汲取见解,从而能够从单调增加的光子检测时间戳流中重建像素的时变通量。

本文利用这一理论来 (1) 表明无源自由运行 SPAD 相机在低通量条件下具有可实现的频率带宽,跨越整个 DC-to31 GHz 范围,(2) 推导出了一种新颖的傅里叶域通量重建算法,并且 (3) 确保算法的噪声模型即使对于非常低的光子计数或不可忽略的死区时间也保持有效。

ControlNet、SAM等热门论文获奖,ICCV 2023论文奖项公布。本文通过实验展示了这种异步成像机制的潜力:(1)对由以截然不同的速度运行的光源(灯泡、投影仪、多个脉冲激光器)同时照明的场景进行成像,而无需同步,(2)被动非视距视频采集;(3)记录超宽带视频,稍后可以以30 Hz的速度播放以显示日常运动,但也可以慢十亿倍的速度播放以显示光本身的传播

需要被重写的内容是:第二篇就是我们所熟知的ControNet

论文地址:https://arxiv.org/pdf/2302.05543.pdf

撰写者:张绿民、饶安怡、Maneesh Agrawala

机构:斯坦福大学

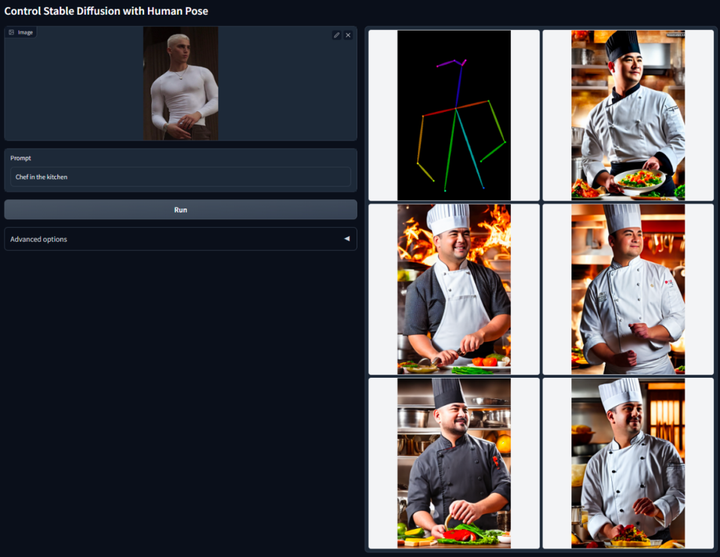

摘要:本文提出了一种端到端的神经网络架构 ControlNet,该架构可以通过添加额外条件来控制扩散模型(如 Stable Diffusion),从而改善图生图效果,并能实现线稿生成全彩图、生成具有同样深度结构的图、通过手部关键点还能优化手部的生成等。

ControlNet 的核心思想是在文本描述之外添加一些额外条件来控制扩散模型(如 Stable Diffusion),从而更好地控制生成图像的人物姿态、深度、画面结构等信息。

重新写成: 我们可以通过将额外的条件以图像的形式输入,让模型进行Canny边缘检测、深度检测、语义分割、霍夫变换直线检测、整体嵌套边缘检测(HED)、人体姿态识别等操作,并在生成的图像中保留这些信息。利用这个模型,我们可以将线稿或涂鸦直接转换成全彩图,并生成具有相同深度结构的图像,同时还可以通过手部关键点来优化人物手部的生成

详细介绍请参考本站报道:AI降维打击人类画家,文生图引入ControlNet,深度、边缘信息全能复用

最佳论文提名:SAM

今年4月份,Meta发布了名为「分割一切(SAM)」的AI模型,它能够为任何图像或视频中的物体生成遮罩。这一技术让计算机视觉领域的研究者们感到震惊,有人甚至称之为「CV不存在了」

如今,这篇备受关注的论文摘的最佳论文提名。

论文地址:https://arxiv.org/abs/2304.02643

重写后的内容:机构:Meta AI

重写后的内容:对于分割问题的解决,目前大致有两种方法。第一种是交互式分割,这种方法可以用来分割任何类别的对象,但需要一个人通过迭代细化掩码来指导该方法。第二种是自动分割,可以用来分割预定义的特定对象类别(例如猫或椅子),但需要大量手动注释对象进行训练(例如数千甚至数万个分割猫的例子)。这两种方法都没有提供通用的、全自动的分割方法

Meta提出的SAM很好地总结了这两种方法。它是一个单一的模型,可以轻松地执行交互式分割和自动分割。该模型的可提示界面允许用户以灵活的方式使用它,只需为模型设计正确的提示(点击、框选、文本等),就可以完成各种广泛的分割任务

总结一下,这些功能使得SAM能够适应新的任务和领域。这种灵活性在图像分割领域是独一无二的

详细介绍请参考本站报道:CV不存在了?Meta发布「分割一切」AI 模型,CV或迎来GPT-3时刻

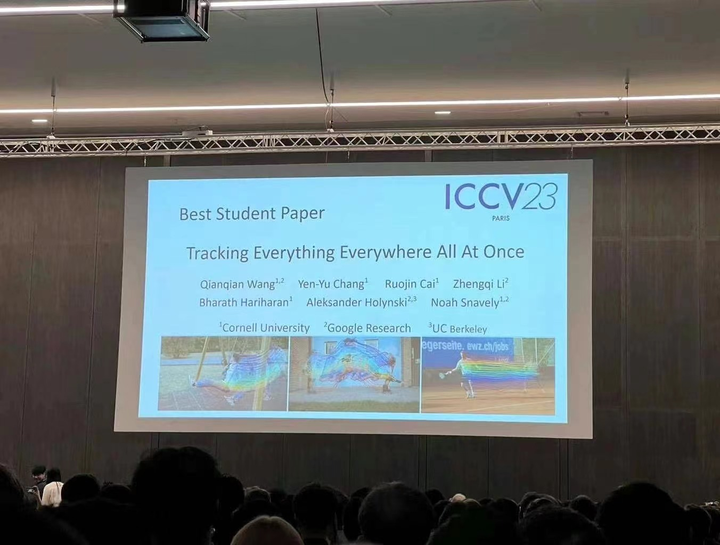

最佳学生论文

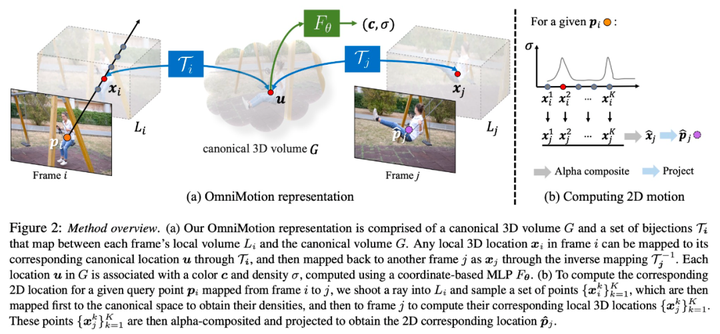

该研究由来自康奈尔大学、谷歌研究院和 UC 伯克利的研究者共同完成,一作是来自Cornell Tech 的博士生Qianqian Wang。他们联合提出了一种完整且全局一致的运动表征 OmniMotion,并提出一种新的测试时(test-time)优化方法,对视频中每个像素进行准确、完整的运动估计。

在计算机视觉领域,有两种常用的运动估计方法:稀疏特征追踪和密集光流。然而,这两种方法都存在一些缺点。稀疏特征追踪不能对所有像素的运动进行建模,而密集光流则无法长时间捕捉运动轨迹

OmniMotion 是一项研究提出的新技术,它使用了 quasi-3D 规范体积来表征视频。通过局部空间和规范空间之间的双射,OmniMotion 能够对每个像素进行追踪。这种表征方法不仅能够保证全局一致性,即使在物体被遮挡的情况下也能进行运动追踪,而且能够对相机和物体运动的任何组合进行建模。实验证明,OmniMotion 方法在性能上显着优于现有的SOTA 方法

详细介绍请参考本站报道:随时随地,追踪每个像素,连遮挡都不怕的「追踪一切」视频算法来了

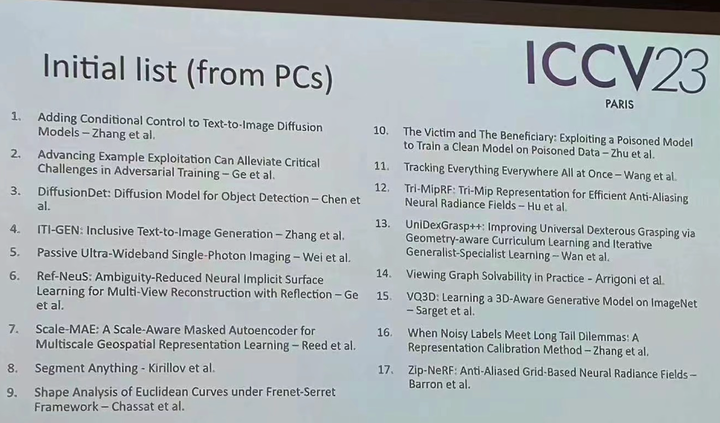

当然,除了这些获奖论文,今年ICCV还有许多优秀论文值得大家关注。最后为大家附上17篇获奖论文初始清单。

以上是ICCV 2023揭晓:ControlNet、SAM等热门论文斩获奖项的详细内容。更多信息请关注PHP中文网其他相关文章!

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

Video Face Swap

使用我们完全免费的人工智能换脸工具轻松在任何视频中换脸!

热门文章

热工具

记事本++7.3.1

好用且免费的代码编辑器

SublimeText3汉化版

中文版,非常好用

禅工作室 13.0.1

功能强大的PHP集成开发环境

Dreamweaver CS6

视觉化网页开发工具

SublimeText3 Mac版

神级代码编辑软件(SublimeText3)

热门话题

DeepMind机器人打乒乓球,正手、反手溜到飞起,全胜人类初学者

Aug 09, 2024 pm 04:01 PM

DeepMind机器人打乒乓球,正手、反手溜到飞起,全胜人类初学者

Aug 09, 2024 pm 04:01 PM

但可能打不过公园里的老大爷?巴黎奥运会正在如火如荼地进行中,乒乓球项目备受关注。与此同时,机器人打乒乓球也取得了新突破。刚刚,DeepMind提出了第一个在竞技乒乓球比赛中达到人类业余选手水平的学习型机器人智能体。论文地址:https://arxiv.org/pdf/2408.03906DeepMind这个机器人打乒乓球什么水平呢?大概和人类业余选手不相上下:正手反手都会:对手采用多种打法,该机器人也能招架得住:接不同旋转的发球:不过,比赛激烈程度似乎不如公园老大爷对战。对机器人来说,乒乓球运动

首配机械爪!元萝卜亮相2024世界机器人大会,发布首个走进家庭的国际象棋机器人

Aug 21, 2024 pm 07:33 PM

首配机械爪!元萝卜亮相2024世界机器人大会,发布首个走进家庭的国际象棋机器人

Aug 21, 2024 pm 07:33 PM

8月21日,2024世界机器人大会在北京隆重召开。商汤科技旗下家用机器人品牌“元萝卜SenseRobot”家族全系产品集体亮相,并最新发布元萝卜AI下棋机器人——国际象棋专业版(以下简称“元萝卜国象机器人”),成为全球首个走进家庭的国际象棋机器人。作为元萝卜的第三款下棋机器人产品,全新的国象机器人在AI和工程机械方面进行了大量专项技术升级和创新,首次在家用机器人上实现了通过机械爪拾取立体棋子,并进行人机对弈、人人对弈、记谱复盘等功能,

Claude也变懒了!网友:学会给自己放假了

Sep 02, 2024 pm 01:56 PM

Claude也变懒了!网友:学会给自己放假了

Sep 02, 2024 pm 01:56 PM

开学将至,该收心的不止有即将开启新学期的同学,可能还有AI大模型。前段时间,Reddit上挤满了吐槽Claude越来越懒的网友。「它的水平下降了很多,经常停顿,甚至输出也变得很短。在发布的第一周,它可以一次性翻译整整4页文稿,现在连半页都输出不了了!」https://www.reddit.com/r/ClaudeAI/comments/1by8rw8/something_just_feels_wrong_with_claude_in_the/在一个名为「对Claude彻底失望了的帖子里」,满满地

世界机器人大会上,这家承载「未来养老希望」的国产机器人被包围了

Aug 22, 2024 pm 10:35 PM

世界机器人大会上,这家承载「未来养老希望」的国产机器人被包围了

Aug 22, 2024 pm 10:35 PM

正在北京举行的世界机器人大会上,人形机器人的展示成为了现场绝对的焦点,在星尘智能的展台上,由于AI机器人助理S1在一个展区上演扬琴、武术、书法三台大戏,能文能武,吸引了大量专业观众和媒体的驻足。在带弹性的琴弦上的优雅演奏,让S1展现出速度、力度、精度兼具的精细操作和绝对掌控。央视新闻对「书法」背后的模仿学习和智能控制进行了专题报道,公司创始人来杰解释到,丝滑动作的背后,是硬件侧追求最好力控和最仿人身体指标(速度、负载等),而是在AI侧则采集人的真实动作数据,让机器人遇强则强,快速学习进化。而敏捷

ACL 2024奖项公布:华科大破译甲骨文最佳论文之一、GloVe时间检验奖

Aug 15, 2024 pm 04:37 PM

ACL 2024奖项公布:华科大破译甲骨文最佳论文之一、GloVe时间检验奖

Aug 15, 2024 pm 04:37 PM

本届ACL大会,投稿者「收获满满」。为期六天的ACL2024正在泰国曼谷举办。ACL是计算语言学和自然语言处理领域的顶级国际会议,由国际计算语言学协会组织,每年举办一次。一直以来,ACL在NLP领域的学术影响力都位列第一,它也是CCF-A类推荐会议。今年的ACL大会已是第62届,接收了400余篇NLP领域的前沿工作。昨天下午,大会公布了最佳论文等奖项。此次,最佳论文奖7篇(两篇未公开)、最佳主题论文奖1篇、杰出论文奖35篇。大会还评出了资源论文奖(ResourceAward)3篇、社会影响力奖(

鸿蒙智行享界S9及全场景新品发布会,多款重磅新品齐发

Aug 08, 2024 am 07:02 AM

鸿蒙智行享界S9及全场景新品发布会,多款重磅新品齐发

Aug 08, 2024 am 07:02 AM

今天下午,鸿蒙智行正式迎来了新品牌与新车。 8月6日,华为举行鸿蒙智行享界S9及华为全场景新品发布会,带来了全景智慧旗舰轿车享界S9、问界新M7Pro和华为novaFlip、MatePadPro12.2英寸、全新MatePadAir、华为毕升激光打印机X1系列、FreeBuds6i、WATCHFIT3和智慧屏S5Pro等多款全场景智慧新品,从智慧出行、智慧办公到智能穿戴,华为全场景智慧生态持续构建,为消费者带来万物互联的智慧体验。鸿蒙智行:深度赋能,推动智能汽车产业升级华为联合中国汽车产业伙伴,为

分布式人工智能盛会DAI 2024征稿:Agent Day,强化学习之父Richard Sutton将出席!颜水成、Sergey Levine以及DeepMind科学家将做主旨报告

Aug 22, 2024 pm 08:02 PM

分布式人工智能盛会DAI 2024征稿:Agent Day,强化学习之父Richard Sutton将出席!颜水成、Sergey Levine以及DeepMind科学家将做主旨报告

Aug 22, 2024 pm 08:02 PM

会议简介随着科技的飞速发展,人工智能已经成为了推动社会进步的重要力量。在这个时代,我们有幸见证并参与到分布式人工智能(DistributedArtificialIntelligence,DAI)的创新与应用中。分布式人工智能是人工智能领域的重要分支,这几年引起了越来越多的关注。基于大型语言模型(LLM)的智能体(Agent)异军突起,通过结合大模型的强大语言理解和生成能力,展现出了在自然语言交互、知识推理、任务规划等方面的巨大潜力。AIAgent正在接棒大语言模型,成为当前AI圈的热点话题。Au

李飞飞团队提出ReKep,让机器人具备空间智能,还能整合GPT-4o

Sep 03, 2024 pm 05:18 PM

李飞飞团队提出ReKep,让机器人具备空间智能,还能整合GPT-4o

Sep 03, 2024 pm 05:18 PM

视觉与机器人学习的深度融合。当两只机器手丝滑地互相合作叠衣服、倒茶、将鞋子打包时,加上最近老上头条的1X人形机器人NEO,你可能会产生一种感觉:我们似乎开始进入机器人时代了。事实上,这些丝滑动作正是先进机器人技术+精妙框架设计+多模态大模型的产物。我们知道,有用的机器人往往需要与环境进行复杂精妙的交互,而环境则可被表示成空间域和时间域上的约束。举个例子,如果要让机器人倒茶,那么机器人首先需要抓住茶壶手柄并使之保持直立,不泼洒出茶水,然后平稳移动,一直到让壶口与杯口对齐,之后以一定角度倾斜茶壶。这