打破大模型黑盒,彻底分解神经元!OpenAI对头Anthropic击破AI不可解释性障碍

多年来,我们一直无法理解人工智能是如何做出决策和产生输出的

模型开发人员只能决定算法、数据,最后得到模型的输出结果,而中间部分——模型是怎么根据这些算法和数据输出结果,就成为了不可见的「黑箱」。

所以就出现了「模型的训练就像炼丹」这样的戏言。

但现在,模型黑箱终于有了可解释性!

来自Anthropic的研究团队提取了模型的神经网络中最基本的单位神经元的可解释特征。

这将是人类揭开AI黑箱的里程碑式的一步。

Anthropic充满激动地表示:

「如果我们能够理解模型中的神经网络是如何工作的,那么诊断模型的故障模式、设计修复程序,并让模型安全地被企业和社会采用就将成为触手可及的现实!」

在Anthropic的最新研究报告《走向单语义性:用字典学习分解语言模型》中,研究人员使用字典学习的方法,成功地将包含512个神经元的层分解成了4000多个可解释的特征

研究报告地址:https://transformer-circuits.pub/2023/monosemantic-features/index.html

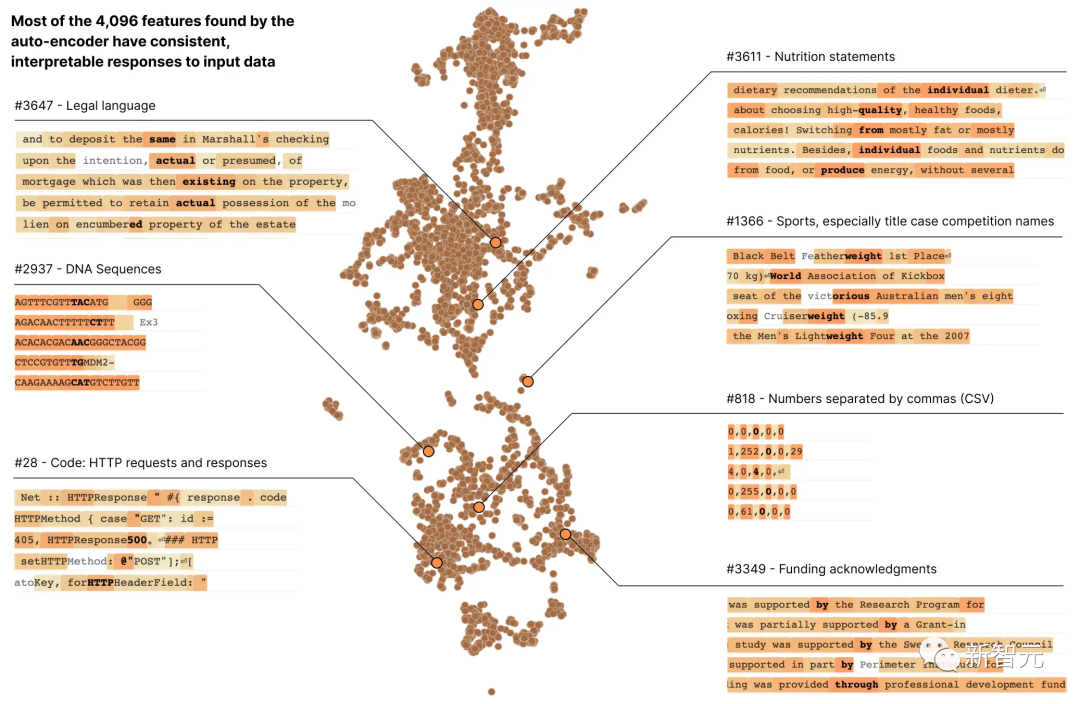

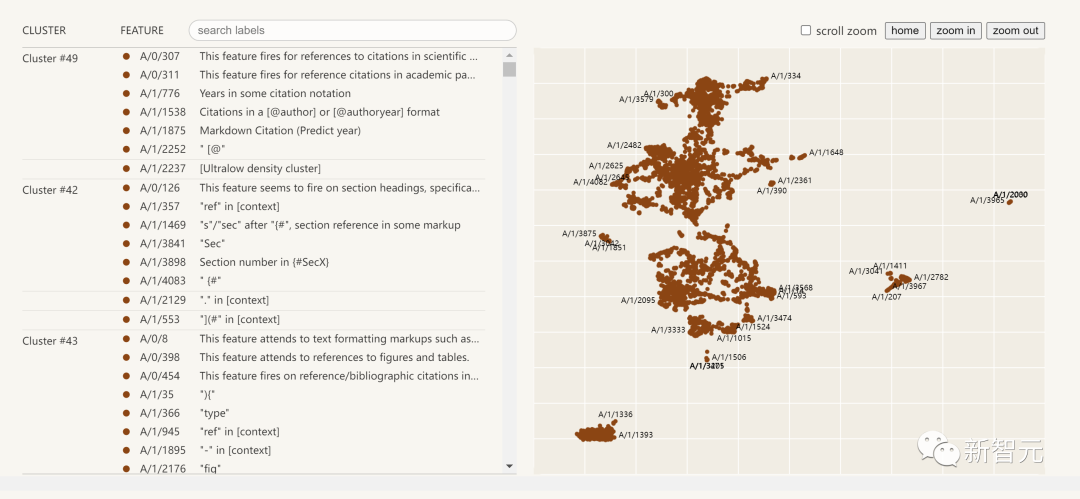

这些特征分别代表了DNA序列、法律语言、HTTP请求、希伯来文本和营养成分说明等

当我们孤立地观察单个神经元的激活时,我们无法看到这些模型属性中的大部分

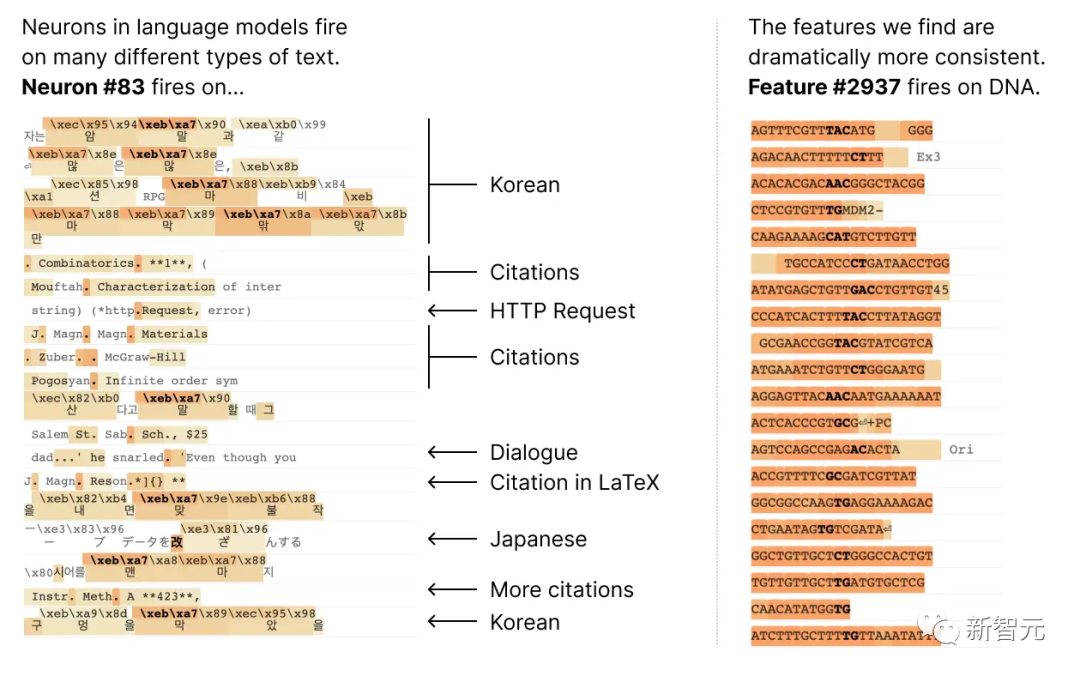

大多数神经元都是「多语义」的,这意味着单个神经元与网络行为之间没有一致的对应关系

例如,在一个小型语言模型中,单个神经元在许多不相关的上下文中都很活跃,包括:学术引文、英语对话、HTTP 请求和韩语文本。

而在经典视觉模型中,单个神经元会对猫的脸和汽车的前脸做出反应。

在不同的语境中,许多研究都证明了一个神经元的激活可能具有不同的含义

一个潜在的原因是神经元的多语义性是由于叠加效应。这是一种假设的现象,即神经网络通过为每个特征分配自己的神经元线性组合来表示数据的独立特征,而这种特征的数量超过了神经元的数量

如果将每个特征视为神经元上的一个向量,那么特征集就构成了网络神经元激活的一个过完备线性基础。

在Anthropic之前的Toy Models of Superposition(《叠加玩具模型》)论文中,证明了稀疏性在神经网络训练中可以消除歧义,帮助模型更好地理解特征之间的关系,从而减少激活向量的来源特征的不确定性,使模型的预测和决策更可靠。

这一概念类似于压缩感知中的思想,其中信号的稀疏性允许从有限的观测中还原出完整的信号。

但在Toy Models of Superposition中提出的三种策略中:

(1)创建没有叠加的模型,或许可以鼓励激活稀疏性;

(2)在展现出叠加态的模型中,采用字典学习来寻找过完备特征

(3)依赖于两者结合的混合方法。

需要进行改写的内容是:方法(1)无法解决多义性问题,而方法(2)则容易出现严重的过拟合情况

因此,这次Anthropic的研究人员使用了一种称为稀疏自动编码器的弱字典学习算法,从经过训练的模型中生成学习到的特征,这些特征提供了比模型神经元本身更单一的语义分析单位。

具体来说,研究人员采用了具有512个神经元的MLP单层transformer,并通过从80亿个数据点的MLP激活上训练稀疏自动编码器,最终将MLP激活分解为相对可解释的特征,扩展因子范围从1×(512个特征)到256×(131,072个特征)。

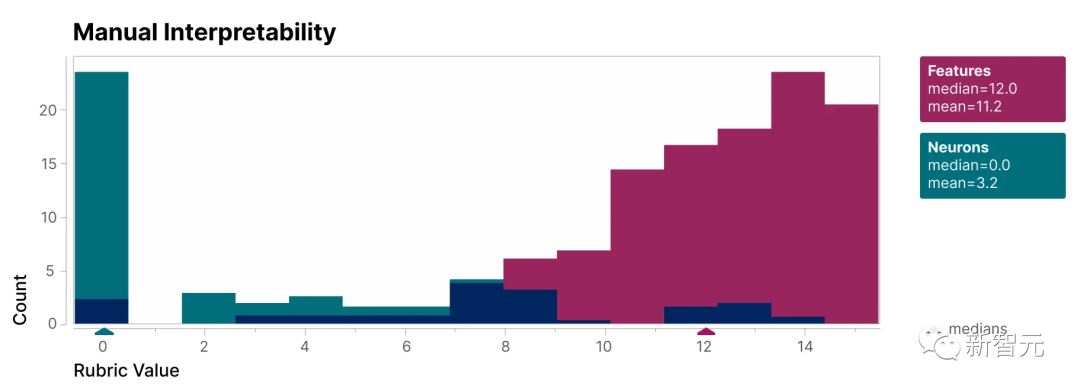

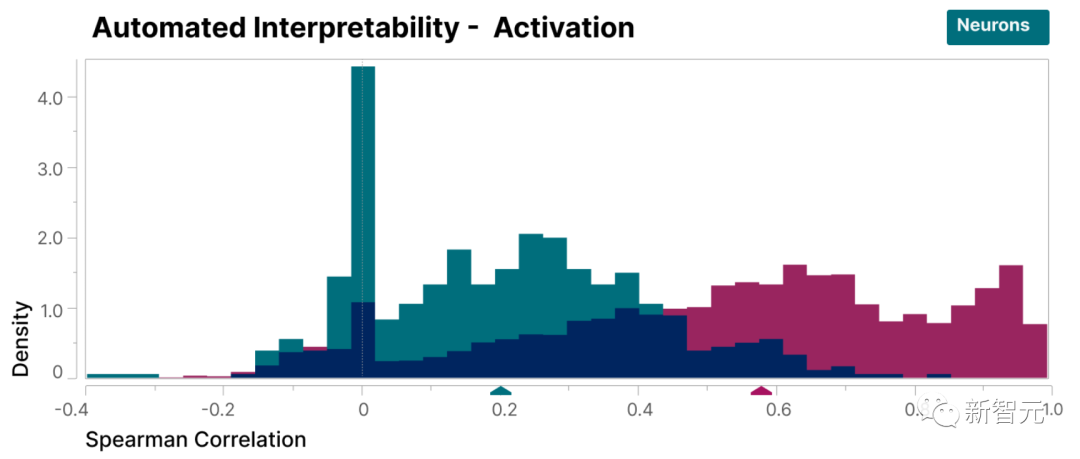

为了验证本研究发现的特征比模型的神经元更具可解释性,我们进行了盲审评估,让一位人类评估员对它们的可解释性进行评分

可以看到,特征(红色)的得分比神经元(青色)高得多。

研究人员发现的特征相对于模型内部的神经元来说更易于理解,这一点已经得到证明

此外,研究人员还采用了「自动解释性」方法,通过使用大型语言模型生成小型模型特征的简短描述,并让另一个模型根据该描述预测特征激活的能力对其进行评分。

同样,特征得分高于神经元,证明了特征的激活及其对模型行为的下游影响具有一致的解释。

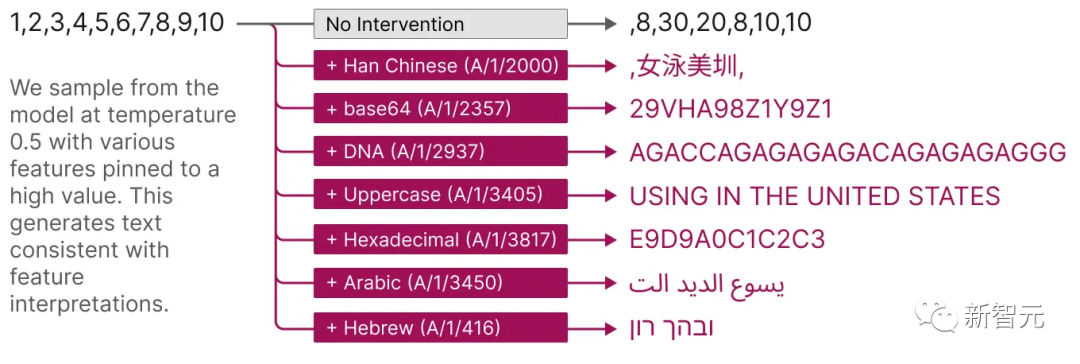

并且,这些提取出的特征还提供了一种有针对性的方法来引导模型。

如下图所示,人为激活特征会导致模型行为以可预测的方式更改。

以下是提取出的可解释性特征的可视化图:

点击左侧的特征列表,您可以与神经网络中的特征空间进行互动式探索

研究报告概要

这份来自Anthropic的研究报告,Towards Monosemanticity: Decomposing Language Models With Dictionary Learning,主要可以分为四个部分。

问题设置,研究人员介绍了研究动机,并阐述训练的transfomer和稀疏自动编码器。

单个特征详细调查,证明了研究发现的几个特征是功能上特定的因果单元。

通过全局分析,我们得出结论,典型特征是可以解释的,并且它们能够解释MLP层的重要组成部分

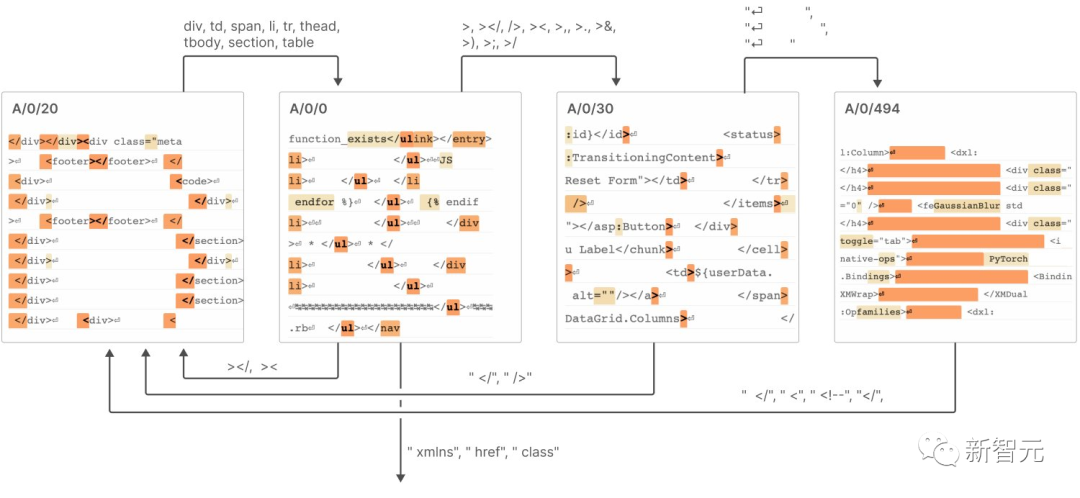

现象分析,描述了特征的几个属性,包括特征分割、普遍性,以及它们如何形成类似于「有限状态自动机」的系统来实现复杂的行为。

结论包括以下7个:

稀疏自动编码器具有提取相对单一的语义特征的能力

稀疏自编码器能够生成可解释的特征,而这些特征在神经元的基础中实际上是不可见的

3. 稀疏自动编码器特征可用于干预和引导变压器的生成。

4. 稀疏自编码器能生成相对通用的特征。

随着自动编码器大小的增加,特征有「分裂」的倾向。 重写后:随着自动编码器尺寸的增加,特征呈现出「分裂」的趋势

6. 只需512个神经元即可表示成千上万个特征

7. 这些特征通过连接在一起,类似于「有限状态自动机」的系统,实现了复杂的行为,如下图所示

具体详细内容可见报告。

Anthropic认为,要将本研究报告中小模型的成功复制到更大的模型上,我们今后面临的挑战将不再是科学问题,而是工程问题

为了在大型模型上实现解释性,需要在工程领域投入更多的努力和资源,以克服模型复杂性和规模带来的挑战

包括开发新的工具、技术和方法,以应对模型复杂性和数据规模的挑战;也包括构建可扩展的解释性框架和工具,以适应大规模模型的需求。

这将成为解释性人工智能和大规模深度学习研究领域的最新趋势

以上是打破大模型黑盒,彻底分解神经元!OpenAI对头Anthropic击破AI不可解释性障碍的详细内容。更多信息请关注PHP中文网其他相关文章!

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

AI Hentai Generator

免费生成ai无尽的。

热门文章

热工具

记事本++7.3.1

好用且免费的代码编辑器

SublimeText3汉化版

中文版,非常好用

禅工作室 13.0.1

功能强大的PHP集成开发环境

Dreamweaver CS6

视觉化网页开发工具

SublimeText3 Mac版

神级代码编辑软件(SublimeText3)

热门话题

使用ddrescue在Linux上恢复数据

Mar 20, 2024 pm 01:37 PM

使用ddrescue在Linux上恢复数据

Mar 20, 2024 pm 01:37 PM

DDREASE是一种用于从文件或块设备(如硬盘、SSD、RAM磁盘、CD、DVD和USB存储设备)恢复数据的工具。它将数据从一个块设备复制到另一个块设备,留下损坏的数据块,只移动好的数据块。ddreasue是一种强大的恢复工具,完全自动化,因为它在恢复操作期间不需要任何干扰。此外,由于有了ddasue地图文件,它可以随时停止和恢复。DDREASE的其他主要功能如下:它不会覆盖恢复的数据,但会在迭代恢复的情况下填补空白。但是,如果指示工具显式执行此操作,则可以将其截断。将数据从多个文件或块恢复到单

开源!超越ZoeDepth! DepthFM:快速且精确的单目深度估计!

Apr 03, 2024 pm 12:04 PM

开源!超越ZoeDepth! DepthFM:快速且精确的单目深度估计!

Apr 03, 2024 pm 12:04 PM

0.这篇文章干了啥?提出了DepthFM:一个多功能且快速的最先进的生成式单目深度估计模型。除了传统的深度估计任务外,DepthFM还展示了在深度修复等下游任务中的最先进能力。DepthFM效率高,可以在少数推理步骤内合成深度图。下面一起来阅读一下这项工作~1.论文信息标题:DepthFM:FastMonocularDepthEstimationwithFlowMatching作者:MingGui,JohannesS.Fischer,UlrichPrestel,PingchuanMa,Dmytr

如何多条件使用Excel过滤功能

Feb 26, 2024 am 10:19 AM

如何多条件使用Excel过滤功能

Feb 26, 2024 am 10:19 AM

如果您需要了解如何在Excel中使用具有多个条件的筛选功能,以下教程将指导您完成相应步骤,确保您可以有效地对数据进行筛选和排序。Excel的筛选功能是非常强大的,能够帮助您从大量数据中提取所需的信息。这个功能可以根据您设定的条件,过滤数据并只显示符合条件的部分,让数据的管理变得更加高效。通过使用筛选功能,您可以快速找到目标数据,节省了查找和整理数据的时间。这个功能不仅可以应用在简单的数据列表上,还可以根据多个条件进行筛选,帮助您更精准地定位所需信息。总的来说,Excel的筛选功能是一个非常实用的

谷歌狂喜:JAX性能超越Pytorch、TensorFlow!或成GPU推理训练最快选择

Apr 01, 2024 pm 07:46 PM

谷歌狂喜:JAX性能超越Pytorch、TensorFlow!或成GPU推理训练最快选择

Apr 01, 2024 pm 07:46 PM

谷歌力推的JAX在最近的基准测试中性能已经超过Pytorch和TensorFlow,7项指标排名第一。而且测试并不是在JAX性能表现最好的TPU上完成的。虽然现在在开发者中,Pytorch依然比Tensorflow更受欢迎。但未来,也许有更多的大模型会基于JAX平台进行训练和运行。模型最近,Keras团队为三个后端(TensorFlow、JAX、PyTorch)与原生PyTorch实现以及搭配TensorFlow的Keras2进行了基准测试。首先,他们为生成式和非生成式人工智能任务选择了一组主流

iPhone上的蜂窝数据互联网速度慢:修复

May 03, 2024 pm 09:01 PM

iPhone上的蜂窝数据互联网速度慢:修复

May 03, 2024 pm 09:01 PM

在iPhone上面临滞后,缓慢的移动数据连接?通常,手机上蜂窝互联网的强度取决于几个因素,例如区域、蜂窝网络类型、漫游类型等。您可以采取一些措施来获得更快、更可靠的蜂窝互联网连接。修复1–强制重启iPhone有时,强制重启设备只会重置许多内容,包括蜂窝网络连接。步骤1–只需按一次音量调高键并松开即可。接下来,按降低音量键并再次释放它。步骤2–该过程的下一部分是按住右侧的按钮。让iPhone完成重启。启用蜂窝数据并检查网络速度。再次检查修复2–更改数据模式虽然5G提供了更好的网络速度,但在信号较弱

超级智能体生命力觉醒!可自我更新的AI来了,妈妈再也不用担心数据瓶颈难题

Apr 29, 2024 pm 06:55 PM

超级智能体生命力觉醒!可自我更新的AI来了,妈妈再也不用担心数据瓶颈难题

Apr 29, 2024 pm 06:55 PM

哭死啊,全球狂炼大模型,一互联网的数据不够用,根本不够用。训练模型搞得跟《饥饿游戏》似的,全球AI研究者,都在苦恼怎么才能喂饱这群数据大胃王。尤其在多模态任务中,这一问题尤为突出。一筹莫展之际,来自人大系的初创团队,用自家的新模型,率先在国内把“模型生成数据自己喂自己”变成了现实。而且还是理解侧和生成侧双管齐下,两侧都能生成高质量、多模态的新数据,对模型本身进行数据反哺。模型是啥?中关村论坛上刚刚露面的多模态大模型Awaker1.0。团队是谁?智子引擎。由人大高瓴人工智能学院博士生高一钊创立,高

美国空军高调展示首个AI战斗机!部长亲自试驾全程未干预,10万行代码试飞21次

May 07, 2024 pm 05:00 PM

美国空军高调展示首个AI战斗机!部长亲自试驾全程未干预,10万行代码试飞21次

May 07, 2024 pm 05:00 PM

最近,军事圈被这个消息刷屏了:美军的战斗机,已经能由AI完成全自动空战了。是的,就在最近,美军的AI战斗机首次公开,揭开了神秘面纱。这架战斗机的全名是可变稳定性飞行模拟器测试飞机(VISTA),由美空军部长亲自搭乘,模拟了一对一的空战。5月2日,美国空军部长FrankKendall在Edwards空军基地驾驶X-62AVISTA升空注意,在一小时的飞行中,所有飞行动作都由AI自主完成!Kendall表示——在过去的几十年中,我们一直在思考自主空对空作战的无限潜力,但它始终显得遥不可及。然而如今,

首个自主完成人类任务机器人出现,五指灵活速度超人,大模型加持虚拟空间训练

Mar 11, 2024 pm 12:10 PM

首个自主完成人类任务机器人出现,五指灵活速度超人,大模型加持虚拟空间训练

Mar 11, 2024 pm 12:10 PM

这周,由OpenAI、微软、贝佐斯和英伟达投资的机器人公司FigureAI宣布获得接近7亿美元的融资,计划在未来一年内研发出可独立行走的人形机器人。而特斯拉的擎天柱也屡屡传出好消息。没人怀疑,今年会是人形机器人爆发的一年。一家位于加拿大的机器人公司SanctuaryAI最近发布了一款全新的人形机器人Phoenix。官方号称它能以和人类一样的速率自主完成很多工作。世界上第一台能以人类速度自主完成任务的机器人Pheonix可以轻轻地抓取、移动并优雅地将每个对象放置在它的左右两侧。它能够自主识别物体的