SEO关于robots.txt_PHP

SEO

robots.txt和Robots META标签平文胜 2003-10-29

我们知道,搜索引擎都有自己的“搜索机器人”(ROBOTS),并通过这些ROBOTS在网络上沿着网页上的链接(一般是http和src链接)不断抓取资料建立自己的数据库。 对于网站管理者和内容提供者来说,有时候会有一些站点内容,不希望被ROBOTS抓取而公开。为了解决这个问题,ROBOTS开发界提供了两个办法:一个是robots.txt,另一个是The Robots META标签。

一、 robots.txt

1、 什么是robots.txt? robots.txt是一个纯文本文件,通过在这个文件中声明该网站中不想被robots访问的部分,这样,该网站的部分或全部内容就可以不被搜索引擎收录了,或者指定搜索引擎只收录指定的内容。 当一个搜索机器人访问一个站点时,它会首先检查该站点根目录下是否存在robots.txt,如果找到,搜索机器人就会按照该文件中的内容来确定访问的范围,如果该文件不存在,那么搜索机器人就沿着链接抓取。 robots.txt必须放置在一个站点的根目录下,而且文件名必须全部小写。 网站 URL

相应的 robots.txt的 URL

http://www.w3.org/

http://www.w3.org/robots.txt

http://www.w3.org:80/

http://www.w3.org:80/robots.txt

http://www.w3.org:1234/

http://www.w3.org:1234/robots.txt

http://w3.org/

http://w3.org/robots.txt

2、 robots.txt的语法

"robots.txt"文件包含一条或更多的记录,这些记录通过空行分开(以CR,CR/NL, or NL作为结束符),每一条记录的格式如下所示:

"

User-agent:

该项的值用于描述搜索引擎robot的名字,在"robots.txt"文件中,如果有多条User-agent记录说明有多个robot会受到该协议的限制,对该文件来说,至少要有一条User-agent记录。如果该项的值设为*,则该协议对任何机器人均有效,在"robots.txt"文件中, "User-agent:*"这样的记录只能有一条。

Disallow :

该项的值用于描述不希望被访问到的一个URL,这个URL可以是一条完整的路径,也可以是部分的,任何以Disallow 开头的URL均不会被robot访问到。例如"Disallow: /help"对/help.phpl 和/help/index.phpl都不允许搜索引擎访问,而"Disallow: /help/"则允许robot访问/help.phpl,而不能访问/help/index.phpl。

任何一条Disallow记录为空,说明该网站的所有部分都允许被访问,在"/robots.txt"文件中,至少要有一条Disallow记录。如果 "/robots.txt"是一个空文件,则对于所有的搜索引擎robot,该网站都是开放的。

下面是一些robots.txt基本的用法:

l 禁止所有搜索引擎访问网站的任何部分:

User-agent: *

Disallow: / l 允许所有的robot访问

User-agent: *

Disallow:

或者也可以建一个空文件 "/robots.txt" file l 禁止所有搜索引擎访问网站的几个部分(下例中的cgi-bin、tmp、private目录)

User-agent: *

Disallow: /cgi-bin/

Disallow: /tmp/

Disallow: /private/ l 禁止某个搜索引擎的访问(下例中的BadBot)

User-agent: BadBot

Disallow: / l 只允许某个搜索引擎的访问(下例中的WebCrawler)

User-agent: WebCrawler

Disallow: User-agent: *

Disallow: /

3、 常见搜索引擎机器人Robots名字

名称 搜索引擎

Baiduspider http://www.baidu.com Scooter http://www.altavista.com ia_archiver http://www.alexa.com Googlebot http://www.google.com FAST-WebCrawler http://www.alltheweb.com Slurp http://www.inktomi.com MSNBOT http://search.msn.com

4、 robots.txt举例

下面是一些著名站点的robots.txt:

http://www.cnn.com/robots.txt

http://www.google.com/robots.txt

http://www.ibm.com/robots.txt

http://www.sun.com/robots.txt

http://www.eachnet.com/robots.txt

5、 常见robots.txt错误

l 颠倒了顺序:

错误写成

User-agent: *

Disallow: GoogleBot

正确的应该是:

User-agent: GoogleBot

Disallow: *

l 把多个禁止命令放在一行中:

例如,错误地写成

Disallow: /css/ /cgi-bin/ /../images/

正确的应该是

Disallow: /css/

Disallow: /cgi-bin/

Disallow: /../images/

l 行前有大量空格

例如写成

Disallow: /cgi-bin/

尽管在标准没有谈到这个,但是这种方式很容易出问题。

l 404重定向到另外一个页面:

当Robot访问很多没有设置robots.txt文件的站点时,会被自动404重定向到另外一个Html页面。这时Robot常常会以处理robots.txt文件的方式处理这个Html页面文件。虽然一般这样没有什么问题,但是最好能放一个空白的robots.txt文件在站点根目录下。

l 采用大写。例如

USER-AGENT: EXCITE

DISALLOW:

虽然标准是没有大小写的,但是目录和文件名应该小写:

user-agent:GoogleBot

disallow:

l 语法中只有Disallow,没有Allow!

错误的写法是:

User-agent: Baiduspider

Disallow: /john/

allow: /jane/

l 忘记了斜杠/

错误的写做:

User-agent: Baiduspider

Disallow: css

正确的应该是

User-agent: Baiduspider

Disallow: /css/

下面一个小工具专门检查robots.txt文件的有效性:http://www.searchengineworld.com/cgi-bin/robotcheck.cgi

二、 Robots META标签

1、什么是Robots META标签

Robots.txt文件主要是限制整个站点或者目录的搜索引擎访问情况,而Robots META标签则主要是针对一个个具体的页面。和其他的META标签(如使用的语言、页面的描述、关键词等)一样,Robots META标签也是放在页面的

中,专门用来告诉搜索引擎ROBOTS如何抓取该页的内容。具体的形式类似(见黑体部分):

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

Video Face Swap

使用我们完全免费的人工智能换脸工具轻松在任何视频中换脸!

热门文章

热工具

记事本++7.3.1

好用且免费的代码编辑器

SublimeText3汉化版

中文版,非常好用

禅工作室 13.0.1

功能强大的PHP集成开发环境

Dreamweaver CS6

视觉化网页开发工具

SublimeText3 Mac版

神级代码编辑软件(SublimeText3)

热门话题

微信文件过期怎么恢复 微信的过期文件能恢复吗

Feb 22, 2024 pm 02:46 PM

微信文件过期怎么恢复 微信的过期文件能恢复吗

Feb 22, 2024 pm 02:46 PM

打开微信,在我中选择设置,选择通用后选择存储空间,在存储空间选择管理,选择要恢复文件的对话选择感叹号图标。教程适用型号:iPhone13系统:iOS15.3版本:微信8.0.24解析1首先打开微信,在我的页面中点击设置选项。2接着在设置页面中找到并点击通用选项。3然后在通用页面中点击存储空间。4接下来在存储空间页面中点击管理。5最后选择要恢复文件的对话,点击右侧的感叹号图标。补充:微信文件一般几天过期1要是微信接收的文件并没有点开过的情况下,那在七十二钟头之后微信系统会清除掉,要是己经查看了微信

照片无法打开此文件,因为格式不受支持或文件已损坏

Feb 22, 2024 am 09:49 AM

照片无法打开此文件,因为格式不受支持或文件已损坏

Feb 22, 2024 am 09:49 AM

在Windows系统中,照片应用是一个便捷的方式来查看和管理照片和视频。通过这个应用程序,用户可以轻松访问他们的多媒体文件,而无需安装额外的软件。然而,有时候用户可能会碰到一些问题,比如在使用照片应用时遇到“无法打开此文件,因为不支持该格式”的错误提示,或者在尝试打开照片或视频时出现文件损坏的问题。这种情况可能会让用户感到困惑和不便,需要进行一些调查和修复来解决这些问题。当用户尝试在Photos应用程序上打开照片或视频时,会看到以下错误。抱歉,照片无法打开此文件,因为当前不支持该格式,或者该文件

可以删除Tmp格式文件吗?

Feb 24, 2024 pm 04:33 PM

可以删除Tmp格式文件吗?

Feb 24, 2024 pm 04:33 PM

Tmp格式文件是一种临时文件格式,通常由计算机系统或程序在执行过程中生成。这些文件的目的是存储临时数据,以帮助程序正常运行或提高性能。一旦程序执行完成或计算机重启,这些tmp文件往往就没有了存在的必要性。所以,对于Tmp格式文件来说,它们本质上是可以删除的。而且,删除这些tmp文件能够释放硬盘空间,确保计算机的正常运行。但是,在删除Tmp格式文件之前,我们需

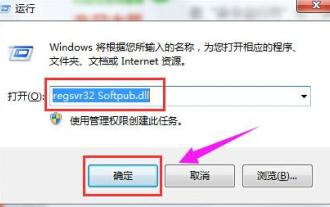

出现0x80004005错误代码怎么办 小编教你0x80004005错误代码解决方法

Mar 21, 2024 pm 09:17 PM

出现0x80004005错误代码怎么办 小编教你0x80004005错误代码解决方法

Mar 21, 2024 pm 09:17 PM

在电脑中删除或解压缩文件夹,时有时候会弹出提示对话框“错误0x80004005:未指定错误”,如果遇到这中情况应该怎么解决呢?提示错误代码0x80004005的原因其实有很多,但大部分因为病毒导致,我们可以重新注册dll来解决问题,下面,小编给大伙讲解0x80004005错误代码处理经验。有用户在使用电脑时出现错误代码0X80004005的提示,0x80004005错误主要是由于计算机没有正确注册某些动态链接库文件,或者计算机与Internet之间存在不允许的HTTPS连接防火墙所引起。那么如何

如何安装GHO文件

Feb 19, 2024 pm 10:06 PM

如何安装GHO文件

Feb 19, 2024 pm 10:06 PM

gho文件是一种GhostImage影像文件,它通常用于将整个硬盘或分区的数据备份成一个文件。在一些特定的情况下,我们需要将这种gho文件重新安装回硬盘上,以还原硬盘或分区到先前的状态。下面将介绍gho文件的安装方法。首先,在安装之前,我们需要准备以下工具和材料:实体的gho文件:确保你拥有一份完整的gho文件,它通常以.gho为后缀名,并且包含有备份

夸克网盘的文件怎么转移到百度网盘?

Mar 14, 2024 pm 02:07 PM

夸克网盘的文件怎么转移到百度网盘?

Mar 14, 2024 pm 02:07 PM

夸克网盘和百度网盘都是现在最常用的储存文件的网盘软件,如果想要将夸克网盘内的文件保存到百度网盘,要怎么操作呢?本期小编整理了夸克网盘电脑端的文件转移到百度网盘的教程步骤,一起来看看是怎么操作吧。 夸克网盘的文件怎么保存到百度网盘?要将夸克网盘的文件转移到百度网盘,首先需在夸克网盘下载所需文件,然后在百度网盘客户端中选择目标文件夹并打开。接着,将夸克网盘中下载的文件拖放到百度网盘客户端打开的文件夹中,或者使用上传功能将文件添加至百度网盘。确保上传完成后在百度网盘中查看文件是否成功转移。这样就

斜杠和反斜杠在文件路径中的不同使用

Feb 26, 2024 pm 04:36 PM

斜杠和反斜杠在文件路径中的不同使用

Feb 26, 2024 pm 04:36 PM

文件路径是操作系统中用于识别和定位文件或文件夹的字符串。在文件路径中,常见的有两种符号分隔路径,即正斜杠(/)和反斜杠()。这两个符号在不同的操作系统中有不同的使用方式和含义。正斜杠(/)是Unix和Linux系统中常用的路径分隔符。在这些系统中,文件路径是以根目录(/)为起始点,每个目录之间使用正斜杠进行分隔。例如,路径/home/user/Docume

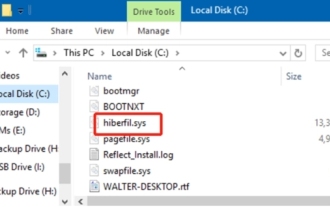

hiberfil.sys是什么文件?hiberfil.sys可以删除吗?

Mar 15, 2024 am 09:49 AM

hiberfil.sys是什么文件?hiberfil.sys可以删除吗?

Mar 15, 2024 am 09:49 AM

最近有很多网友问小编,hiberfil.sys是什么文件?hiberfil.sys占用了大量的C盘空间可以删除吗?小编可以告诉大家hiberfil.sys文件是可以删除的。下面就来看看详细的内容。hiberfil.sys是Windows系统中的一个隐藏文件,也是系统休眠文件。通常存储在C盘根目录下,其大小与系统安装内存大小相当。这个文件在计算机休眠时被使用,其中包含了当前系统的内存数据,以便在恢复时快速恢复到之前的状态。由于其大小与内存容量相等,因此它可能会占用较大的硬盘空间。 hiber