使用Panda-Gym的机器臂模拟实现Deep Q-learning强化学习

强化学习(RL)是一种机器学习方法,它允许代理通过试错来学习如何在环境中表现。行为主体会因为采取行动导致预期结果而获得奖励或受到惩罚。随着时间的推移,代理会学会采取行动,以使得其预期回报最大化

RL代理通常使用马尔可夫决策过程(MDP)进行训练,MDP是为顺序决策问题建模的数学框架。MDP由四个部分组成:

- 状态:环境的可能状态的集合。

- 动作:代理可以采取的一组动作。

- 转换函数:在给定当前状态和动作的情况下,预测转换到新状态的概率的函数。

- 奖励函数:为每次转换分配奖励给代理的函数。

代理的目标是学习策略函数,将状态映射到动作。通过策略函数来最大化代理随着时间的预期回报。

Deep Q-learning是一种使用深度神经网络学习策略函数的强化学习算法。深度神经网络以当前状态作为输入,并输出一个值向量,其中每个值代表一个可能的动作。然后代理根据具有最高值的操作进行采取

Deep Q-learning是一种基于值的强化学习算法,这意味着它学习每个状态-动作对的值。状态-动作对的值是agent在该状态下采取该动作所获得的预期奖励。

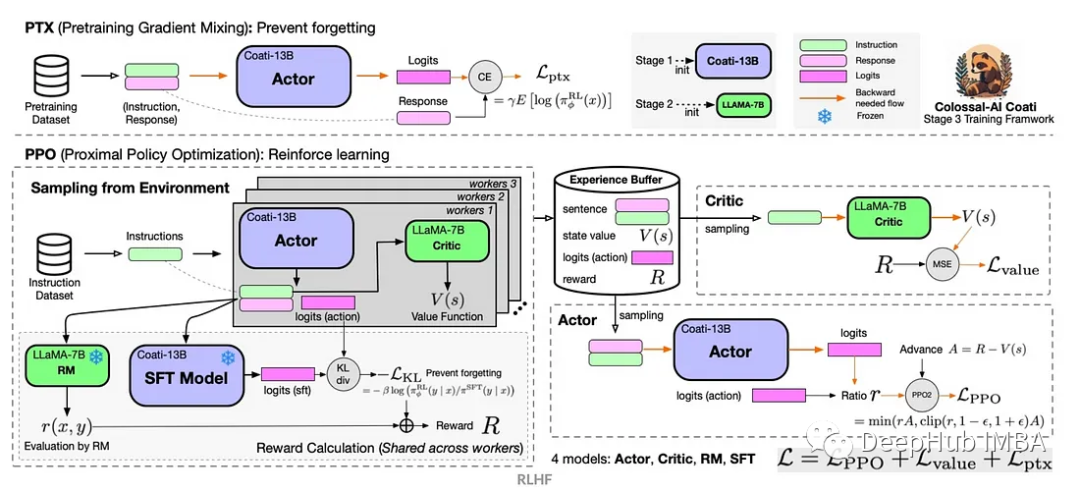

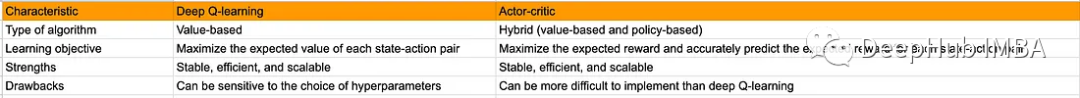

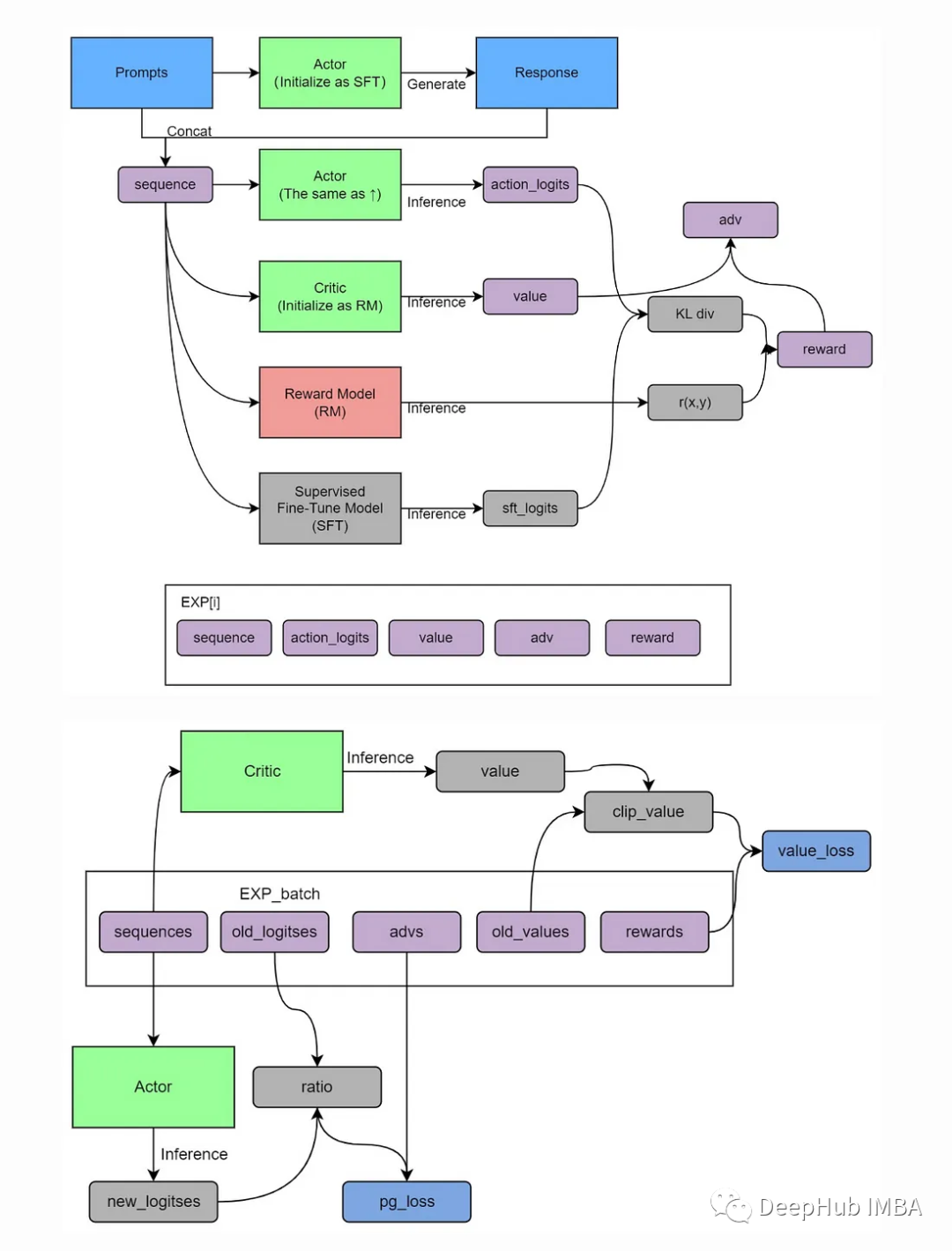

Actor-Critic是一种结合了基于值和基于策略的RL算法。有两个组成部分:

Actor:参与者负责选择操作。

Critic:负责评价Actor的行为。

演员和评论家同时接受培训。演员接受培训以最大化预期奖励,评论家接受培训以准确预测每个状态-动作对的预期奖励

Actor-Critic算法相对于其他强化学习算法有几个优点。首先,它更加稳定,这意味着在训练过程中不太可能出现偏差。其次,它更加高效,这意味着它可以更快地学习。第三,它具有更好的可扩展性,可以应用于具有大型状态和操作空间的问题

下面的表格总结了Deep Q-learning和Actor-Critic之间的主要区别:

Actor-Critic (A2C)的优势

演员-评论家是一种受欢迎的强化学习体系结构,它结合了基于策略和基于价值的方法。它有许多优点,使其成为解决各种强化学习任务的强有力的选择:

1、低方差

相较于传统的策略梯度方法,A2C 在训练过程中通常具有较低的方差。这是因为 A2C 同时使用了策略梯度和值函数,在梯度的计算中利用值函数来降低方差。低方差表示训练过程更加稳定,能够更快地收敛到更优的策略

2、更快的学习速度

由于低方差的特性,A2C 通常能够以更快的速度学习到一个良好的策略。这对于那些需要进行大量模拟的任务来说尤为重要,因为较快的学习速度可以节省宝贵的时间和计算资源。

3、结合策略和值函数

A2C 的一个显著特点是它同时学习策略和值函数。这种结合使得代理能够更好地理解环境和动作的关联,从而更好地指导策略改进。值函数的存在还有助于减小策略优化中的误差,提高训练的效率。

4、支持连续和离散动作空间

A2C 可以适应不同类型的动作空间,包括连续和离散动作,而且非常通用。这就使得 A2C 成为一个广泛适用的强化学习算法,可以应用于各种任务,从机器人控制到游戏玩法优化

5、并行训练

A2C 可以轻松地并行化,充分利用多核处理器和分布式计算资源。这意味着可以在更短的时间内收集更多的经验数据,从而提高训练效率。

尽管Actor-Critic方法具有一些优势,但是它们也面临着一些挑战,比如超参数调优和训练中的潜在不稳定性。然而,通过适当的调整以及经验回放和目标网络等技术,这些挑战可以在很大程度上得到缓解,使得Actor-Critic成为强化学习中有价值的方法

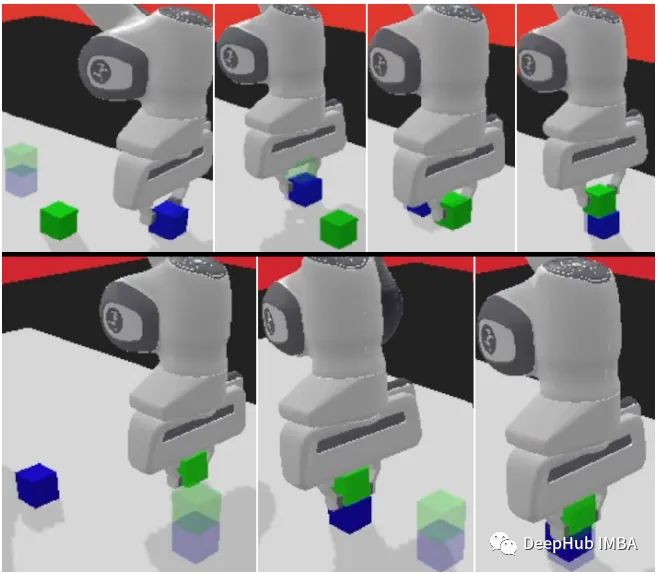

panda-gym

panda-gym 基于 PyBullet 引擎开发,围绕 panda 机械臂封装了 reach、push、slide、pick&place、stack、flip 等 6 个任务,主要也是受 OpenAI Fetch 启发。

我们将使用panda-gym作为示例来展示下面的代码

1、安装库

首先,我们需要初始化强化学习环境的代码:

!apt-get install -y \libgl1-mesa-dev \libgl1-mesa-glx \libglew-dev \xvfb \libosmesa6-dev \software-properties-common \patchelf !pip install \free-mujoco-py \pytorch-lightning \optuna \pyvirtualdisplay \PyOpenGL \PyOpenGL-accelerate\stable-baselines3[extra] \gymnasium \huggingface_sb3 \huggingface_hub \ panda_gym

2、导入库

import os import gymnasium as gym import panda_gym from huggingface_sb3 import load_from_hub, package_to_hub from stable_baselines3 import A2C from stable_baselines3.common.evaluation import evaluate_policy from stable_baselines3.common.vec_env import DummyVecEnv, VecNormalize from stable_baselines3.common.env_util import make_vec_env

3、创建运行环境

env_id = "PandaReachDense-v3" # Create the env env = gym.make(env_id) # Get the state space and action space s_size = env.observation_space.shape a_size = env.action_space print("\n _____ACTION SPACE_____ \n") print("The Action Space is: ", a_size) print("Action Space Sample", env.action_space.sample()) # Take a random action4、观察和奖励的规范化

强化学习优化的一个好方法是对输入特征进行归一化。我们通过包装器计算输入特征的运行平均值和标准偏差。同时还通过添加norm_reward = True来规范化奖励

env = make_vec_env(env_id, n_envs=4) env = VecNormalize(env, norm_obs=True, norm_reward=True, clip_obs=10.)

5、创建A2C模型

我们使用Stable-Baselines3团队训练过的官方代理

model = A2C(policy = "MultiInputPolicy",env = env,verbose=1)

6、训练A2C

model.learn(1_000_000) # Save the model and VecNormalize statistics when saving the agent model.save("a2c-PandaReachDense-v3") env.save("vec_normalize.pkl")7、评估代理

from stable_baselines3.common.vec_env import DummyVecEnv, VecNormalize # Load the saved statistics eval_env = DummyVecEnv([lambda: gym.make("PandaReachDense-v3")]) eval_env = VecNormalize.load("vec_normalize.pkl", eval_env) # We need to override the render_mode eval_env.render_mode = "rgb_array" # do not update them at test time eval_env.training = False # reward normalization is not needed at test time eval_env.norm_reward = False # Load the agent model = A2C.load("a2c-PandaReachDense-v3") mean_reward, std_reward = evaluate_policy(model, eval_env) print(f"Mean reward = {mean_reward:.2f} +/- {std_reward:.2f}")总结

在“panda-gym”将Panda机械臂和GYM环境有效的结合使得我们可以轻松的在本地进行机械臂的强化学习,

Actor-Critic架构中代理会学会在每个时间步骤中进行渐进式改进,这与稀疏的奖励函数形成对比(在稀疏的奖励函数中结果是二元的),这使得Actor-Critic方法特别适合于此类任务。

通过无缝结合策略学习和值估计,机器人代理能够熟练地操纵机械臂末端执行器,准确到达指定的目标位置。这不仅为机器人控制等任务提供了实用的解决方案,还具有改变各种需要敏捷和明智决策的领域的潜力

以上是使用Panda-Gym的机器臂模拟实现Deep Q-learning强化学习的详细内容。更多信息请关注PHP中文网其他相关文章!

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

AI Hentai Generator

免费生成ai无尽的。

热门文章

热工具

记事本++7.3.1

好用且免费的代码编辑器

SublimeText3汉化版

中文版,非常好用

禅工作室 13.0.1

功能强大的PHP集成开发环境

Dreamweaver CS6

视觉化网页开发工具

SublimeText3 Mac版

神级代码编辑软件(SublimeText3)

热门话题

15个值得推荐的开源免费图像标注工具

Mar 28, 2024 pm 01:21 PM

15个值得推荐的开源免费图像标注工具

Mar 28, 2024 pm 01:21 PM

图像标注是将标签或描述性信息与图像相关联的过程,以赋予图像内容更深层次的含义和解释。这一过程对于机器学习至关重要,它有助于训练视觉模型以更准确地识别图像中的各个元素。通过为图像添加标注,使得计算机能够理解图像背后的语义和上下文,从而提高对图像内容的理解和分析能力。图像标注的应用范围广泛,涵盖了许多领域,如计算机视觉、自然语言处理和图视觉模型具有广泛的应用领域,例如,辅助车辆识别道路上的障碍物,帮助疾病的检测和诊断通过医学图像识别。本文主要推荐一些较好的开源免费的图像标注工具。1.Makesens

一文带您了解SHAP:机器学习的模型解释

Jun 01, 2024 am 10:58 AM

一文带您了解SHAP:机器学习的模型解释

Jun 01, 2024 am 10:58 AM

在机器学习和数据科学领域,模型的可解释性一直是研究者和实践者关注的焦点。随着深度学习和集成方法等复杂模型的广泛应用,理解模型的决策过程变得尤为重要。可解释人工智能(ExplainableAI|XAI)通过提高模型的透明度,帮助建立对机器学习模型的信任和信心。提高模型的透明度可以通过多种复杂模型的广泛应用等方法来实现,以及用于解释模型的决策过程。这些方法包括特征重要性分析、模型预测区间估计、局部可解释性算法等。特征重要性分析可以通过评估模型对输入特征的影响程度来解释模型的决策过程。模型预测区间估计

通过学习曲线识别过拟合和欠拟合

Apr 29, 2024 pm 06:50 PM

通过学习曲线识别过拟合和欠拟合

Apr 29, 2024 pm 06:50 PM

本文将介绍如何通过学习曲线来有效识别机器学习模型中的过拟合和欠拟合。欠拟合和过拟合1、过拟合如果一个模型对数据进行了过度训练,以至于它从中学习了噪声,那么这个模型就被称为过拟合。过拟合模型非常完美地学习了每一个例子,所以它会错误地分类一个看不见的/新的例子。对于一个过拟合的模型,我们会得到一个完美/接近完美的训练集分数和一个糟糕的验证集/测试分数。略有修改:"过拟合的原因:用一个复杂的模型来解决一个简单的问题,从数据中提取噪声。因为小数据集作为训练集可能无法代表所有数据的正确表示。"2、欠拟合如

通透!机器学习各大模型原理的深度剖析!

Apr 12, 2024 pm 05:55 PM

通透!机器学习各大模型原理的深度剖析!

Apr 12, 2024 pm 05:55 PM

通俗来说,机器学习模型是一种数学函数,它能够将输入数据映射到预测输出。更具体地说,机器学习模型就是一种通过学习训练数据,来调整模型参数,以最小化预测输出与真实标签之间的误差的数学函数。在机器学习中存在多种模型,例如逻辑回归模型、决策树模型、支持向量机模型等,每一种模型都有其适用的数据类型和问题类型。同时,不同模型之间存在着许多共性,或者说有一条隐藏的模型演化的路径。将联结主义的感知机为例,通过增加感知机的隐藏层数量,我们可以将其转化为深度神经网络。而对感知机加入核函数的话就可以转化为SVM。这一

人工智能在太空探索和人居工程中的演变

Apr 29, 2024 pm 03:25 PM

人工智能在太空探索和人居工程中的演变

Apr 29, 2024 pm 03:25 PM

20世纪50年代,人工智能(AI)诞生。当时研究人员发现机器可以执行类似人类的任务,例如思考。后来,在20世纪60年代,美国国防部资助了人工智能,并建立了实验室进行进一步开发。研究人员发现人工智能在许多领域都有用武之地,例如太空探索和极端环境中的生存。太空探索是对宇宙的研究,宇宙涵盖了地球以外的整个宇宙空间。太空被归类为极端环境,因为它的条件与地球不同。要在太空中生存,必须考虑许多因素,并采取预防措施。科学家和研究人员认为,探索太空并了解一切事物的现状有助于理解宇宙的运作方式,并为潜在的环境危机

使用C++实现机器学习算法:常见挑战及解决方案

Jun 03, 2024 pm 01:25 PM

使用C++实现机器学习算法:常见挑战及解决方案

Jun 03, 2024 pm 01:25 PM

C++中机器学习算法面临的常见挑战包括内存管理、多线程、性能优化和可维护性。解决方案包括使用智能指针、现代线程库、SIMD指令和第三方库,并遵循代码风格指南和使用自动化工具。实践案例展示了如何利用Eigen库实现线性回归算法,有效地管理内存和使用高性能矩阵操作。

可解释性人工智能:解释复杂的AI/ML模型

Jun 03, 2024 pm 10:08 PM

可解释性人工智能:解释复杂的AI/ML模型

Jun 03, 2024 pm 10:08 PM

译者|李睿审校|重楼人工智能(AI)和机器学习(ML)模型如今变得越来越复杂,这些模型产生的输出是黑盒——无法向利益相关方解释。可解释性人工智能(XAI)致力于通过让利益相关方理解这些模型的工作方式来解决这一问题,确保他们理解这些模型实际上是如何做出决策的,并确保人工智能系统中的透明度、信任度和问责制来解决这个问题。本文探讨了各种可解释性人工智能(XAI)技术,以阐明它们的基本原理。可解释性人工智能至关重要的几个原因信任度和透明度:为了让人工智能系统被广泛接受和信任,用户需要了解决策是如何做出的

你所不知道的机器学习五大学派

Jun 05, 2024 pm 08:51 PM

你所不知道的机器学习五大学派

Jun 05, 2024 pm 08:51 PM

机器学习是人工智能的重要分支,它赋予计算机从数据中学习的能力,并能够在无需明确编程的情况下改进自身能力。机器学习在各个领域都有着广泛的应用,从图像识别和自然语言处理到推荐系统和欺诈检测,它正在改变我们的生活方式。机器学习领域存在着多种不同的方法和理论,其中最具影响力的五种方法被称为“机器学习五大派”。这五大派分别为符号派、联结派、进化派、贝叶斯派和类推学派。1.符号学派符号学(Symbolism),又称为符号主义,强调利用符号进行逻辑推理和表达知识。该学派认为学习是一种逆向演绎的过程,通过已有的