最近,「霉霉大秀中文」的视频在各大社交媒体上迅速走红,之后又出现了类似的「郭德纲大秀英语」等视频。这些视频中的许多都是由一款名为「HeyGen」的人工智能应用制作的

不过,从 HeyGen 现在的火爆程度来看,想用它制作类似视频可能要排很久。好在,这并不是唯一的制作方法。懂技术的小伙伴也可以寻找其他替代方案,比如语音转文字模型 Whisper、文字翻译 GPT、声音克隆 + 生成音频 so-vits-svc、生成符合音频的嘴型视频 GeneFace++dengdeng。

重写后的内容为: 其中,Whisper是OpenAI研发并开源的一个自动语音识别(ASR)模型,非常好用。他们通过从网络上收集了68万小时的多语言(98种语言)和多任务监督数据对Whisper进行了训练。OpenAI认为使用这样一个庞大而多样的数据集可以提高模型对口音、背景噪音和技术术语的识别能力。除了语音识别,Whisper还可以实现多种语言的转录,并将这些语言翻译成英语。目前,Whisper已经有了很多变体,并成为许多AI应用构建时的必要组件

最近,HuggingFace团队提出了一个新的变体——Distil-Whisper。这个变体是Whisper模型的蒸馏版,其特点是模型小巧、速度快,并且准确度也非常高,非常适合在需要低延迟或资源有限的环境中使用。然而,与原始的Whisper模型能够处理多种语言不同,Distil-Whisper只能处理英文

论文链接:https://arxiv.org/pdf/2311.00430.pdf

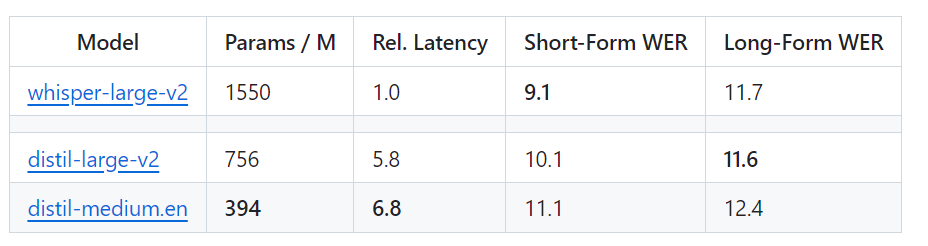

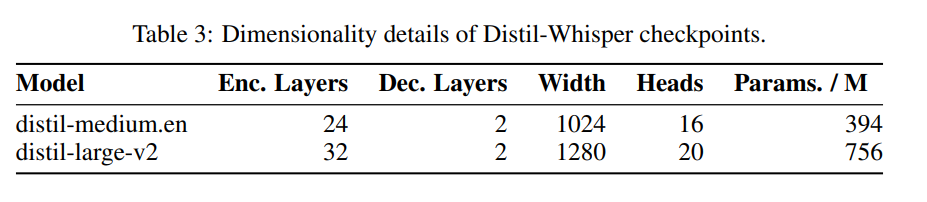

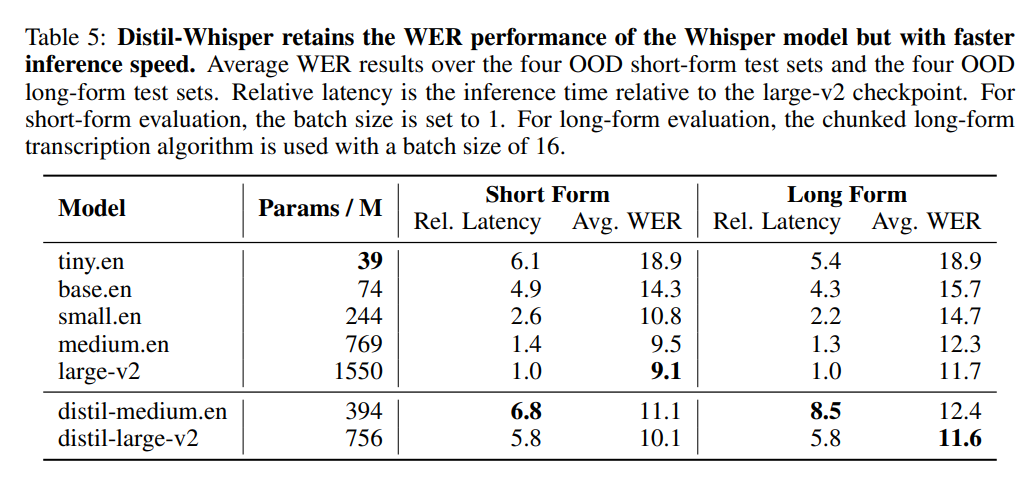

具体而言,Distil-Whisper有两个版本,分别为参数量为756M(distil-large-v2)和394M(distil-medium.en)

与 OpenAI 的 Whisper-large-v2 相比,756M 版本的 distil-large-v2 参数量减少了一半还多,但实现了 6 倍的加速,而且在准确程度上非常接近 Whisper-large-v2,在短音频的 Word Error Rate(WER)这个指标上相差在 1% 以内,甚至在长音频上优于 Whisper-large-v2。这是因为通过仔细的数据选择和过滤,Whisper 的稳健性得以保持,幻觉得以减少。

Whisper的网页版与Distil-Whisper的速度进行了直观的对比。图片来源:https://twitter.com/xenovacom/status/1720460890560975103

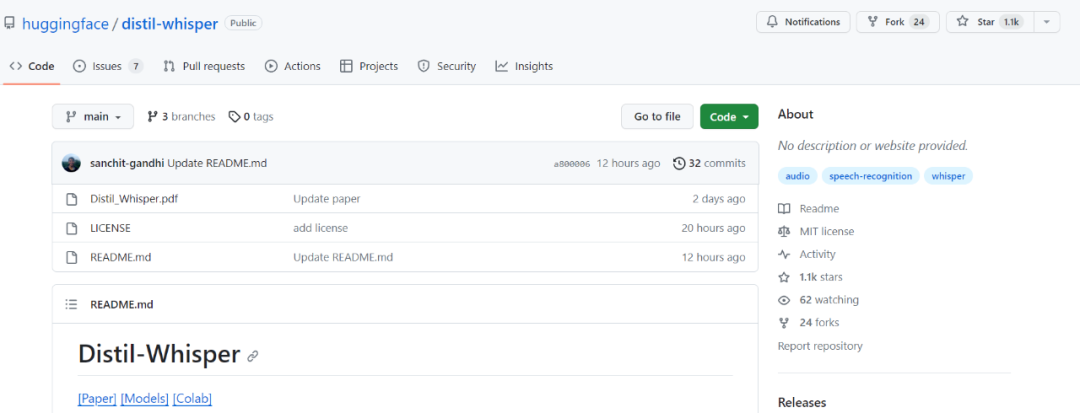

所以,虽然刚刚发布两三天,Distil-Whisper 的 star 量已经破千。

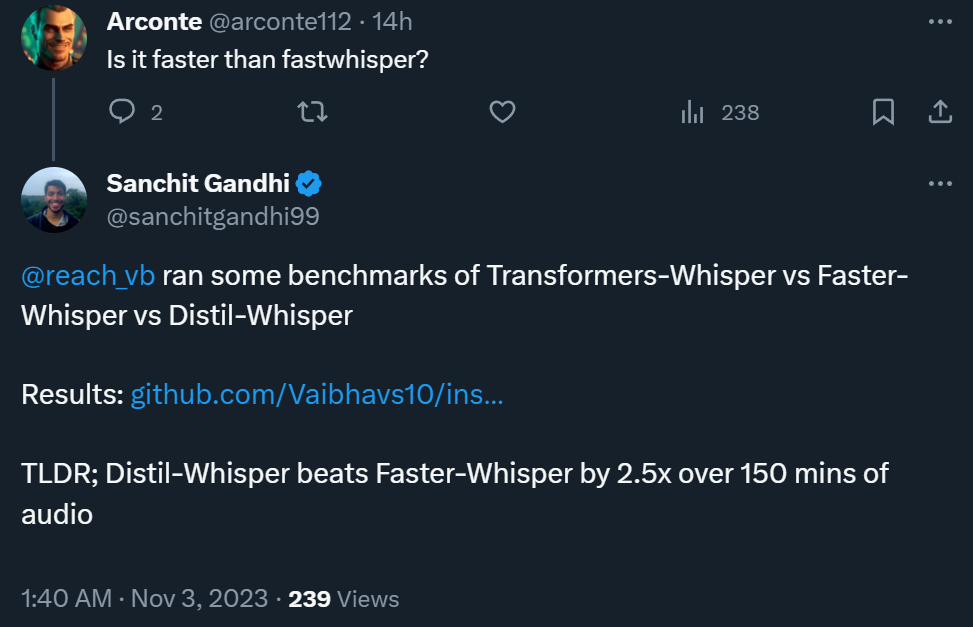

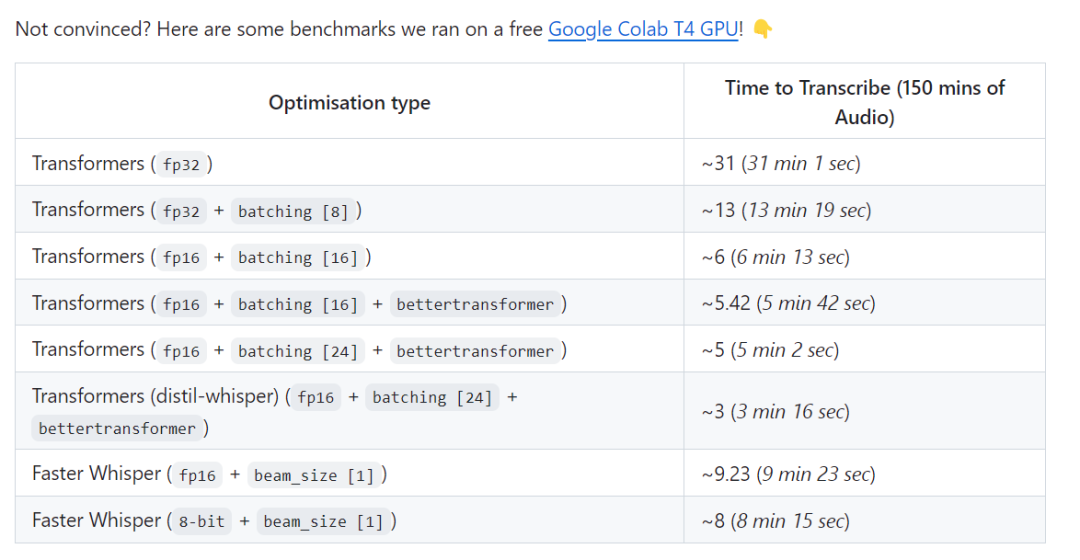

此外,一项测试结果表明,当处理150分钟的音频时,Distil-Whisper的速度可以达到Faster-Whisper的2.5倍

测试链接为:https://github.com/Vaibhavs10/insanely-fast-whisper#insanely-fast-whisper

那么,这样好的结果是如何实现的呢?论文作者表示,他们使用伪标签技术构建了一个大规模的开源数据集,然后利用该数据集将 Whisper 模型压缩成了 Distil-Whisper。他们使用简单的 WER 启发式,只选择了质量最高的伪标签进行训练

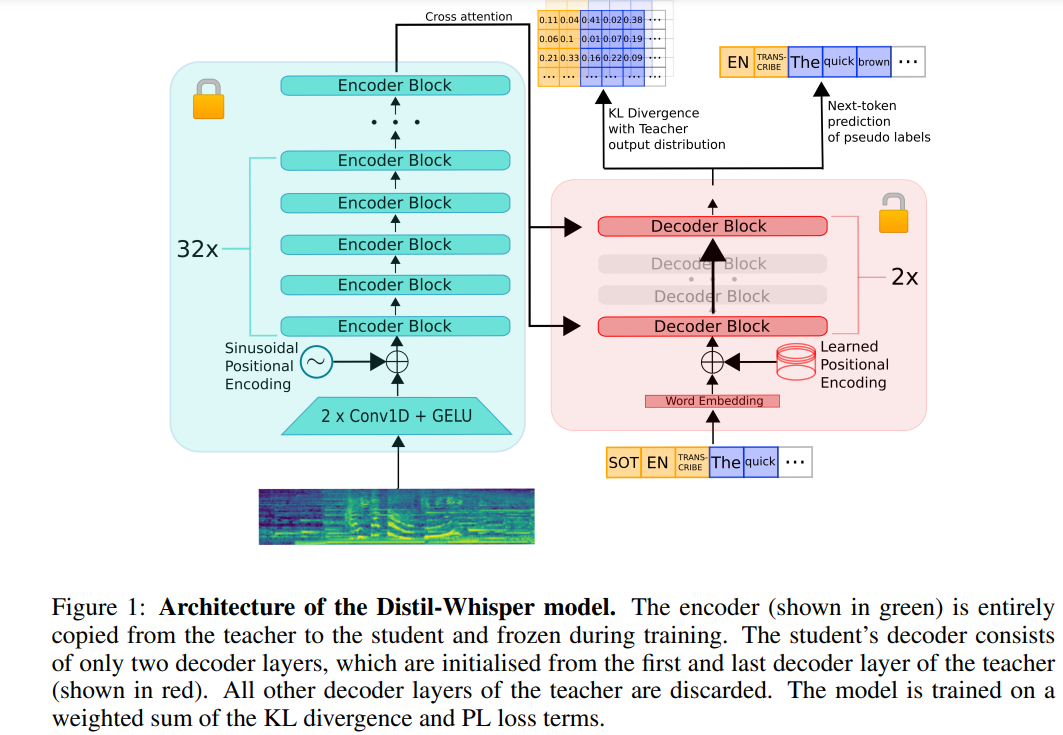

以下是对原始内容的重写:Distil-Whisper的架构如下图1所示。研究人员通过从教师模型中复制整个编码器来初始化学生模型,并在训练过程中冻结它。他们从OpenAI的Whisper-medium.en和Whisper-large-v2模型中复制了第一个和最后一个解码器层,经过蒸馏后得到了2个解码器检查点,分别命名为distil-medium.en和distil-large-v2

蒸馏得到的模型的维度细节如表 3 所示。

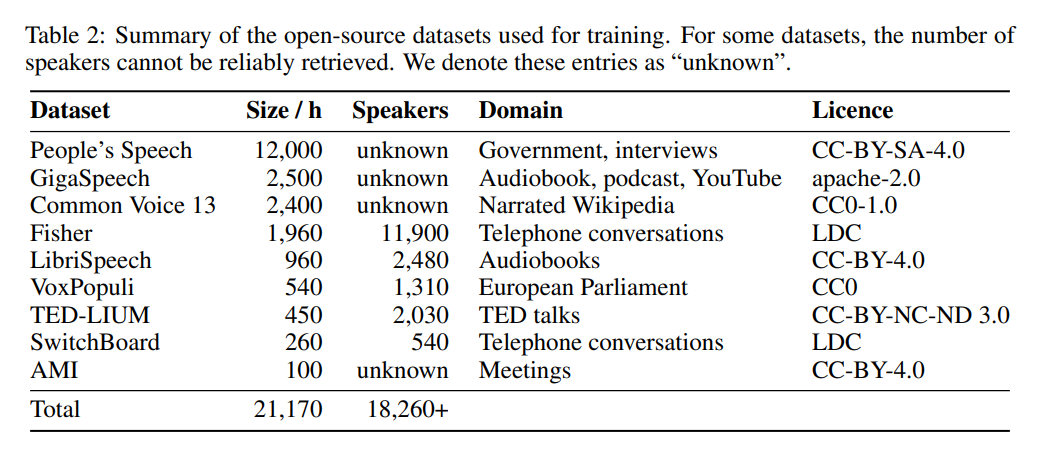

在数据方面,该模型已经在9个不同的开源数据集(见表2)上进行了22,000小时的训练。伪标签是由Whisper生成的。值得注意的是,他们使用了WER过滤器,只有WER得分超过10%的标签才会被保留。作者表示,这是保持性能的关键!

下表 5 展示了 Distil-Whisper 的主要性能结果。

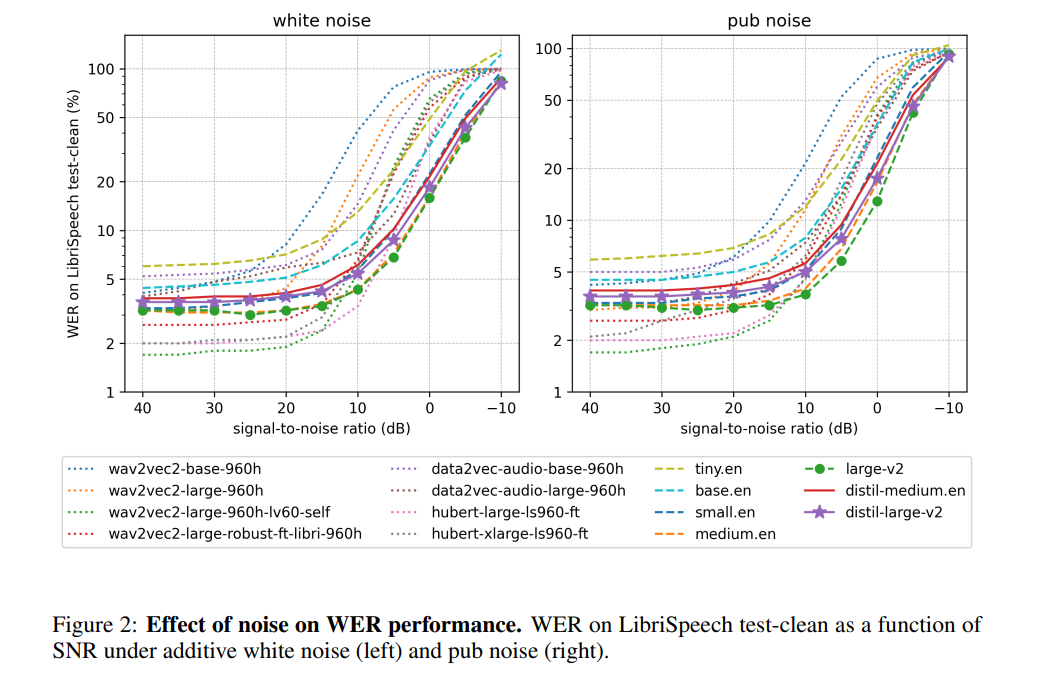

据作者表示,通过冻结编码器的操作,Distil-Whisper在对抗噪声时表现非常稳健。如下图所示,Distil-Whisper在噪声条件下遵循与Whisper相似的鲁棒性曲线,比其他模型如Wav2vec2表现更优

在处理比较长的音频文件时,与Whisper相比,Distil-Whisper有效减少了幻觉。据作者认为,这主要归功于WER过滤

通过共享相同的编码器,Distil-Whisper 可以与 Whisper 配对进行推测解码(Speculative Decoding)。这样,在参数仅增加 8% 的情况下,速度提高了 2 倍,同时输出结果与 Whisper 完全相同。

更多细节请参见原文。

以上是OpenAI的Whisper蒸馏后,语音识别速度大幅提升:两天内star量突破千的详细内容。更多信息请关注PHP中文网其他相关文章!