北大具身智能新成果:无需训练,听指令就能灵活走位

北京大学董豪团队具身导航最新成果来了:

无需额外建图和训练,只需说出导航指令,如:

Walk forward across the room and walk through the panty followed by the kitchen. Stand at the end of the kitchen

我们就能控制机器人灵活移动。

在此,机器人靠的是主动与大模型构成的“专家团队”沟通完成指令分析、视觉感知、完成估计和决策测试等一系列视觉语言导航关键任务。

目前项目主页和论文都已上线,代码即将推出:

机器人如何根据人类指令导航?

视觉语言导航涉及到一系列子任务,包括指令分析,视觉感知,完成估计和决策测试。

这些关键任务需要不同领域知识,它们环环相扣决定机器人的导航能力。

受到现实中专家讨论行为的启发,北大董豪团队提出DiscussNav导航系统。

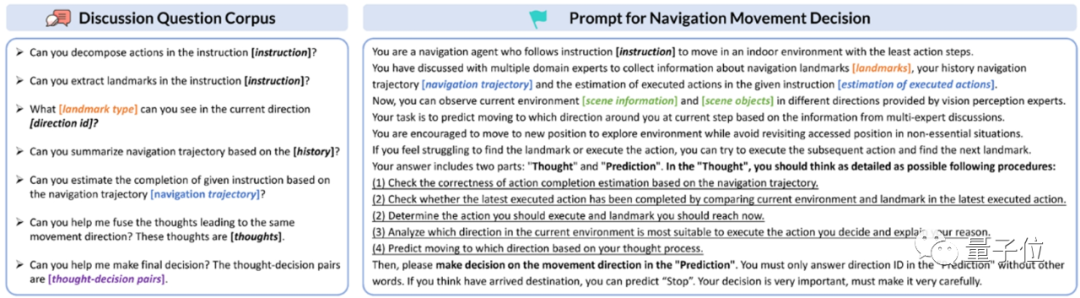

作者首先以提示方式赋予LLM(大语言模型)和MLM(多模态大模型)专家角色和特定任务,激活它们的领域知识和能力,由此构建具备不同特长的视觉导航专家团队。

然后,作者设计了讨论问题语料库和讨论机制,遵循该机制,由LLM驱动的导航机器人可以主动发起一系列与视觉导航专家的讨论。

在每一步移动前,导航机器人都会与专家讨论来理解人类指令中要求的动作和提及的物体标志。

进而依据这些物体标志的类型有倾向性地对周围环境进行感知,指令完成情况估计,由此做出初步的移动决策。

在决策过程中,导航机器人会根据Chain-of-Thought(思维链)同时生成N个独立的预测结果,当这些预测结果之间不一致时,机器人会向决策测试专家求助,筛选出最终的移动决策。

从这个过程我们可以看到,相比传统方法需要进行额外的预训练,这个方法通过与大模型专家交互指导机器人根据人类指令移动,直接解决了机器人导航训练数据稀缺的问题。

更进一步,正是由于这个特点,它也实现了零样本能力,只要遵循以上讨论流程,就能follow多样的导航指令。

以下是DiscussNav在经典的视觉语言导航数据集Room2Room上的表现。

可以看到,它显著高于所有零样本方法,甚至超过两个经过训练的方法。

作者进一步在Turtlebot4移动机器人上开展真实室内场景导航实验。

凭借专家角色扮演和讨论激发出的大模型强大的语言和视觉泛化能力,DiscussNav在真实世界的表现明显优于之前最优的零样本方法和经过预训练微调的方法, 展现出良好的sim-to-real迁移能力。

通过实验,作者进一步发现,DiscussNav产生了4个强大的能力:

1、识别开放世界物体,比如“白色桌子上的机械手臂”,“椅子上的泰迪熊”。

2、识别细粒度的导航标志物体,比如“厨房柜台上的植物”,“桌上的纸箱”。

3、纠正其它专家在讨论中回复的错误信息,比如标志提取专家在从导航动作序列提取导航标志前会检查并纠正被错误分解的动作序列。

4、排除不一致的移动决策,比如决策测试专家们可以根据当前环境信息从DiscussNav预测的多个不一致的移动决策中选择最合理的一个作为最终移动决定。

“仿真和大模型先验是Free Lunch”

通讯作者董豪在之前的报告中提出,深入探索如何有效利用仿真数据和大模型从海量数据中学习到的先验知识是未来具身智能研究的发展方向。

目前受限于数据规模和探索真实环境的高昂成本,具身智能研究仍将重点关注仿真平台实验和仿真数据训练。

近期大模型的进展为具身智能提供新方向,合理发掘和利用大模型中存在的语言常识和物理世界先验将推动具身智能发展。

论文地址: https://arxiv.org/abs/2309.11382

以上是北大具身智能新成果:无需训练,听指令就能灵活走位的详细内容。更多信息请关注PHP中文网其他相关文章!

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

Video Face Swap

使用我们完全免费的人工智能换脸工具轻松在任何视频中换脸!

热门文章

热工具

记事本++7.3.1

好用且免费的代码编辑器

SublimeText3汉化版

中文版,非常好用

禅工作室 13.0.1

功能强大的PHP集成开发环境

Dreamweaver CS6

视觉化网页开发工具

SublimeText3 Mac版

神级代码编辑软件(SublimeText3)

超越ORB-SLAM3!SL-SLAM:低光、严重抖动和弱纹理场景全搞定

May 30, 2024 am 09:35 AM

超越ORB-SLAM3!SL-SLAM:低光、严重抖动和弱纹理场景全搞定

May 30, 2024 am 09:35 AM

写在前面今天我们探讨下深度学习技术如何改善在复杂环境中基于视觉的SLAM(同时定位与地图构建)性能。通过将深度特征提取和深度匹配方法相结合,这里介绍了一种多功能的混合视觉SLAM系统,旨在提高在诸如低光条件、动态光照、弱纹理区域和严重抖动等挑战性场景中的适应性。我们的系统支持多种模式,包括拓展单目、立体、单目-惯性以及立体-惯性配置。除此之外,还分析了如何将视觉SLAM与深度学习方法相结合,以启发其他研究。通过在公共数据集和自采样数据上的广泛实验,展示了SL-SLAM在定位精度和跟踪鲁棒性方面优

第二代Ameca来了!和观众对答如流,面部表情更逼真,会说几十种语言

Mar 04, 2024 am 09:10 AM

第二代Ameca来了!和观众对答如流,面部表情更逼真,会说几十种语言

Mar 04, 2024 am 09:10 AM

人形机器人Ameca升级第二代了!最近,在世界移动通信大会MWC2024上,世界上最先进机器人Ameca又现身了。会场周围,Ameca引来一大波观众。得到GPT-4加持后,Ameca能够对各种问题做出实时反应。「来一段舞蹈」。当被问及是否有情感时,Ameca用一系列的面部表情做出回应,看起来非常逼真。就在前几天,Ameca背后的英国机器人公司EngineeredArts刚刚演示了团队最新的开发成果。视频中,机器人Ameca具备了视觉能力,能看到并描述房间整个情况、描述具体物体。最厉害的是,她还能

2 个月不见,人形机器人 Walker S 会叠衣服了

Apr 03, 2024 am 08:01 AM

2 个月不见,人形机器人 Walker S 会叠衣服了

Apr 03, 2024 am 08:01 AM

机器之能报道编辑:吴昕国内版的人形机器人+大模型组队,首次完成叠衣服这类复杂柔性材料的操作任务。随着融合了OpenAI多模态大模型的Figure01揭开神秘面纱,国内同行的相关进展一直备受关注。就在昨天,国内"人形机器人第一股"优必选发布了人形机器人WalkerS深入融合百度文心大模型后的首个Demo,展示了一些有趣的新功能。现在,得到百度文心大模型能力加持的WalkerS是这个样子的。和Figure01一样,WalkerS没有走动,而是站在桌子后面完成一系列任务。它可以听从人类的命令,折叠衣物

AI如何使机器人更具自主性和适应性?

Jun 03, 2024 pm 07:18 PM

AI如何使机器人更具自主性和适应性?

Jun 03, 2024 pm 07:18 PM

在工业自动化技术领域,最近有两个热点很难被忽视:人工智能(AI)和英伟达(Nvidia)。不要改变原内容的意思,微调内容,重写内容,不要续写:“不仅如此,这两者密切相关,因为英伟达在不仅仅局限于其最开始的图形处理单元(GPU),正在将其GPU技术扩展到数字孪生领域,同时紧密连接着新兴的AI技术。”最近,英伟达与众多工业企业达成了合作,包括领先的工业自动化企业,如Aveva、罗克韦尔自动化、西门子和施耐德电气,以及泰瑞达机器人及其MiR和优傲机器人公司。Recently,Nvidiahascoll

首个自主完成人类任务机器人出现,五指灵活速度超人,大模型加持虚拟空间训练

Mar 11, 2024 pm 12:10 PM

首个自主完成人类任务机器人出现,五指灵活速度超人,大模型加持虚拟空间训练

Mar 11, 2024 pm 12:10 PM

这周,由OpenAI、微软、贝佐斯和英伟达投资的机器人公司FigureAI宣布获得接近7亿美元的融资,计划在未来一年内研发出可独立行走的人形机器人。而特斯拉的擎天柱也屡屡传出好消息。没人怀疑,今年会是人形机器人爆发的一年。一家位于加拿大的机器人公司SanctuaryAI最近发布了一款全新的人形机器人Phoenix。官方号称它能以和人类一样的速率自主完成很多工作。世界上第一台能以人类速度自主完成任务的机器人Pheonix可以轻轻地抓取、移动并优雅地将每个对象放置在它的左右两侧。它能够自主识别物体的

云鲸逍遥001扫拖机器人,长「脑子」了!| 体验

Apr 26, 2024 pm 04:22 PM

云鲸逍遥001扫拖机器人,长「脑子」了!| 体验

Apr 26, 2024 pm 04:22 PM

近几年最受消费者欢迎的智能家电,扫拖机器人可谓是其中之一。它所带来的操作便利性,甚至是无需操作,让懒人们释放了双手,让消费者能够从日常的家务中「解放」出来,也能拿更多的时间花在自己喜欢的事情上,变相提高了生活品质。借着这股热潮,市面上几乎所有的家电产品品牌都在做自己的扫拖机器人,一时间使得整个扫拖机器人市场热闹非凡。但市场的快速拓张必然会带来一个隐患:很多厂商会采用机海战术的方式快速占领更多的市场份额,从而导致很多新品并没有什么升级点,说它是“套娃”机型也不为过。不过,并不是所有的扫拖机器人都是

人形机器人会变魔术了,春晚节目组了解一下

Feb 04, 2024 am 09:03 AM

人形机器人会变魔术了,春晚节目组了解一下

Feb 04, 2024 am 09:03 AM

一眨眼的功夫,机器人都已经学会变魔术了?只见它先是拿起桌上的水勺,向观众证明了里面什么也没有……然后,它又把手中鸡蛋似的物体放了进去,然后把水勺放回桌子上,开始“施法”……就在它把水勺再次拿起的时候,奇迹发生了。原先放进去的鸡蛋不翼而飞,跳出的东西变成了一个篮球……再来看一遍连贯动作:△此动图为二倍速一套动作下来如行云流水,只有把视频用0.5倍速反复观看,才终于发现了其中的端倪:如果手速再快一些,大概真的就可以瞒天过海了。有网友感叹,机器人变魔术的水平比自己还要高:为我们表演这段魔术的,是Mag

自动驾驶第一性之纯视觉静态重建

Jun 02, 2024 pm 03:24 PM

自动驾驶第一性之纯视觉静态重建

Jun 02, 2024 pm 03:24 PM

纯视觉的标注方案,主要是利用视觉加上一些GPS、IMU和轮速传感器的数据进行动态标注。当然面向量产场景的话,不一定非要是纯视觉,有一些量产的车辆里面,会有像固态雷达(AT128)这样的传感器。如果从量产的角度做数据闭环,把这些传感器都用上,可以有效地解决动态物体的标注问题。但是我们的方案里面,是没有固态雷达的。所以,我们就介绍这种最通用的量产标注方案。纯视觉的标注方案的核心在于高精度的pose重建。我们采用StructurefromMotion(SFM)的pose重建方案,来保证重建精度。但是传