图像涂哪就动哪!Gen-2新功能'神笔马良”爆火,网友:急急急

AI能够生成视频,已经发展到了这个阶段了?!

对着一张照片随手一刷,就能让被选中的目标动起来!

明明是一辆静止的卡车,但一经刷过,它立刻飞速启动,连光影都完美地再现

这张照片本来只是一张火灾照片,但现在只需随手一刷,火焰就能冲天而起,热度扑面而来

如果继续这样下去,就很难区分照片和实拍视频了!

这是Runway为AI视频软件Gen-2打造的全新功能,通过一涂一刷的操作,可以使图像中的物体动起来,其逼真程度不亚于神笔马良

虽然只是个功能预热,不过效果一出就在网上爆火:

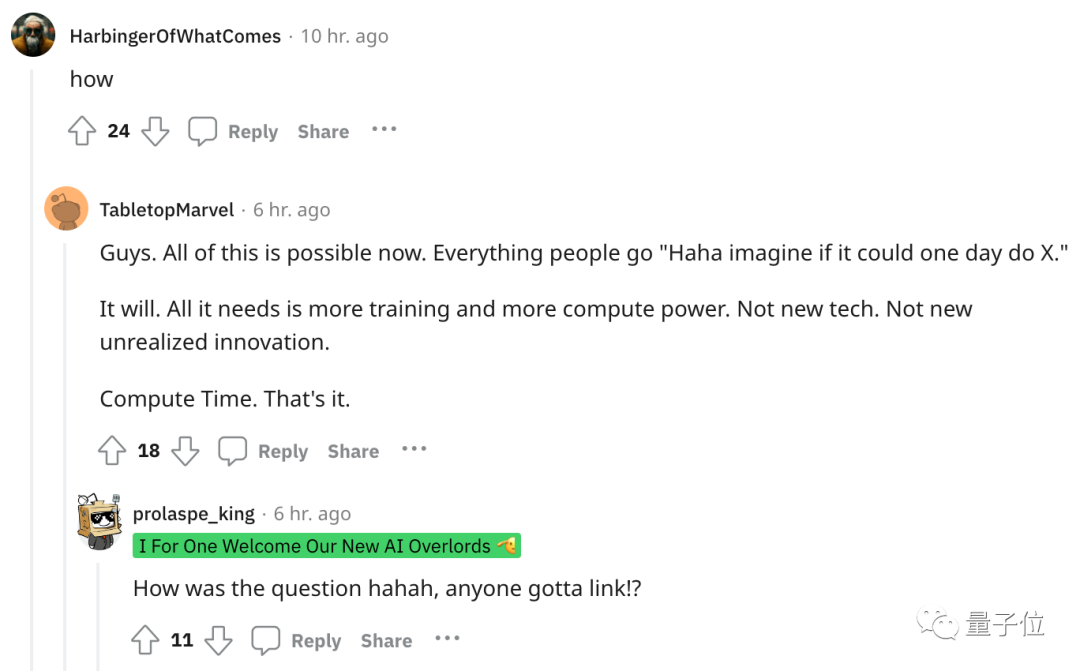

看得网友一个个变身急急国王,直呼“等不及想要尝试一波”:

Runway同时也发布了更多功能预热效果,我们一起来看看吧

照片变视频,指哪就动哪

这个Runway新出的功能,叫做运动笔刷(Motion Brush)。

顾名思义,只需要用这个笔刷对着画面中的任意对象“涂”一下,就能让他们动起来。

不仅可以是静止的人,连裙摆和头部的动作都表现得非常自然

还可以是流动的液体如瀑布,连雾气都能还原:

或者是一根还没熄灭的烟:

一团正在众人面前燃烧的篝火:

更大块的背景也能做成动态的,甚至改变画面的光影效果,例如正在飞速移动的乌云:

当然,以上所述只是Runway的明确声明,他们主动告诉你他们对照片进行了某些处理

下面这些没有涂抹痕迹的视频,更是几乎完全看不出有AI修饰的成分在里面:

一连串效果炸出,也导致功能还没正式放出来,网友已经迫不及待了。

有很多人试图弄清楚这个功能是如何实现的。还有一些网友更关注这个功能什么时候发布,希望能直接在321上找到链接(手动狗头)

可以期待一下了,确实有不少好消息

除此之外,Runway还推出了其他新功能

最近一连串的AI生成进展似乎都在表明,视频生成领域似乎真要迎来技术大爆发了。

AI生成视频真要崛起了?

在这几天内,有一些网友发现了文生动画软件Animatediff的一种新的热门玩法

只需要结合最新的研究LCM-LORA,生成16帧的动画视频只需要7秒钟的时间。

LCM-LORA是华大和Hugging Face最新推出的AI图片生成技术,能够显着提高Stable Diffusion的图片生成速度

其中,LCM(Latent Consistency Models)是基于今年早些时候OpenAI的“一致性模型”提出来的一种图像生成新方法,能快速生成768×768的高分辨率图片。

但LCM不兼容现有模型,因此清华和抱抱脸的成员又新出了一版LCM-LORA模型,可以兼容所有Stable Diffusion模型,加速出图速度。

结合Animatediff软件,生成一个这样的动画只需要7秒钟左右:

目前LCM-LORA已经在抱抱脸上开源。

你感觉最近的AI视频生成进展如何,距离可用上还有多远?

参考链接:

[1]https://twitter.com/runwayml/status/1723033256067489937。

[2]https://twitter.com/op7418/status/1723016460220735748。

以上是图像涂哪就动哪!Gen-2新功能'神笔马良”爆火,网友:急急急的详细内容。更多信息请关注PHP中文网其他相关文章!

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

Video Face Swap

使用我们完全免费的人工智能换脸工具轻松在任何视频中换脸!

热门文章

热工具

记事本++7.3.1

好用且免费的代码编辑器

SublimeText3汉化版

中文版,非常好用

禅工作室 13.0.1

功能强大的PHP集成开发环境

Dreamweaver CS6

视觉化网页开发工具

SublimeText3 Mac版

神级代码编辑软件(SublimeText3)

最佳AI艺术生成器(免费付款)创意项目

Apr 02, 2025 pm 06:10 PM

最佳AI艺术生成器(免费付款)创意项目

Apr 02, 2025 pm 06:10 PM

本文回顾了AI最高的艺术生成器,讨论了他们的功能,对创意项目的适用性和价值。它重点介绍了Midjourney是专业人士的最佳价值,并建议使用Dall-E 2进行高质量的可定制艺术。

Chatgpt 4 o可用吗?

Mar 28, 2025 pm 05:29 PM

Chatgpt 4 o可用吗?

Mar 28, 2025 pm 05:29 PM

Chatgpt 4当前可用并广泛使用,与诸如ChatGpt 3.5(例如ChatGpt 3.5)相比,在理解上下文和产生连贯的响应方面取得了重大改进。未来的发展可能包括更多个性化的间

开始使用Meta Llama 3.2 -Analytics Vidhya

Apr 11, 2025 pm 12:04 PM

开始使用Meta Llama 3.2 -Analytics Vidhya

Apr 11, 2025 pm 12:04 PM

Meta的Llama 3.2:多模式和移动AI的飞跃 Meta最近公布了Llama 3.2,这是AI的重大进步,具有强大的视觉功能和针对移动设备优化的轻量级文本模型。 以成功为基础

最佳AI聊天机器人比较(Chatgpt,Gemini,Claude&更多)

Apr 02, 2025 pm 06:09 PM

最佳AI聊天机器人比较(Chatgpt,Gemini,Claude&更多)

Apr 02, 2025 pm 06:09 PM

本文比较了诸如Chatgpt,Gemini和Claude之类的顶级AI聊天机器人,重点介绍了其独特功能,自定义选项以及自然语言处理和可靠性的性能。

顶级AI写作助理来增强您的内容创建

Apr 02, 2025 pm 06:11 PM

顶级AI写作助理来增强您的内容创建

Apr 02, 2025 pm 06:11 PM

文章讨论了Grammarly,Jasper,Copy.ai,Writesonic和Rytr等AI最高的写作助手,重点介绍了其独特的内容创建功能。它认为Jasper在SEO优化方面表现出色,而AI工具有助于保持音调的组成

构建AI代理的前7个代理抹布系统

Mar 31, 2025 pm 04:25 PM

构建AI代理的前7个代理抹布系统

Mar 31, 2025 pm 04:25 PM

2024年见证了从简单地使用LLM进行内容生成的转变,转变为了解其内部工作。 这种探索导致了AI代理的发现 - 自主系统处理任务和最少人工干预的决策。 Buildin

如何访问猎鹰3? - 分析Vidhya

Mar 31, 2025 pm 04:41 PM

如何访问猎鹰3? - 分析Vidhya

Mar 31, 2025 pm 04:41 PM

猎鹰3:革命性的开源大语模型 Falcon 3是著名的猎鹰系列LLMS系列中的最新迭代,代表了AI技术的重大进步。由技术创新研究所(TII)开发

选择最佳的AI语音生成器:评论的顶级选项

Apr 02, 2025 pm 06:12 PM

选择最佳的AI语音生成器:评论的顶级选项

Apr 02, 2025 pm 06:12 PM

本文评论了Google Cloud,Amazon Polly,Microsoft Azure,IBM Watson和Discript等高级AI语音生成器,重点介绍其功能,语音质量和满足不同需求的适用性。